近年來,人工智能尤其是在機器學習領域中,取得了非常巨大的成就,看似其未來更加光明。然而這些系統仍舊不夠完美,尤其是被應用到一些因為些許錯誤就能夠導致人命傷害或億萬財產損失的行業中時,這將會存在巨大的風險。

這需要我們人為對這些系統進行保障,其中包括可驗證性、可靠性、魯棒性、可審計性、可解釋性和無偏性,對此,斯坦福 AI 實驗室對近年來關于 AI 安全、可靠性的研究進展進行了總結,并以文章的形式發布在博客上。

概述

為了能在一些關鍵應用中使用先進的 AI 系統,比如:商用飛機防撞、金融交易或大規模發電廠、化工廠控制等應用;我們必須保證這些系統具有可驗證性(以正確的方式對一系列輸入進行驗證)、可靠性(即使是新的未見過的輸入,表現能夠與預期相符)、魯棒性(在應用時不易受噪音或特定輸入干擾)、可審計性(當做出任何給定的決定時,可檢查其內部狀態)、可解釋性(有條理的,可以確保產生決策的數據、場景和假設都是能夠被解釋清楚的)以及無偏性(不會對某類行為表現出無意識的偏好)。

毫無疑問,這對 AI 系統提出了一系列極為嚴苛的要求。不過可喜的是,世界上已經有一批來自斯坦福人工智能實驗室和斯坦福研究社區的優秀 AI 研究人員(其中包括 Clark Barrett, David Dill, Chelsea Finn, Mykel Kochenderfer, Anshul Kundaje, Percy Liang, Tengyu Ma, Subhasish Mitra, Marco Pavone, Omer Reingold, Dorsa Sadigh 以及 James Zou)正在努力解決這個問題。

本文將介紹一些致力于實現安全可靠的 AI 技術的研究案例。我們將從中看到新技術如何理解神經網絡的黑盒子、如何找到和消除偏見,以及如何確保自動化系統的安全性。

理解神經網絡的黑盒子:可驗證性和可解釋性

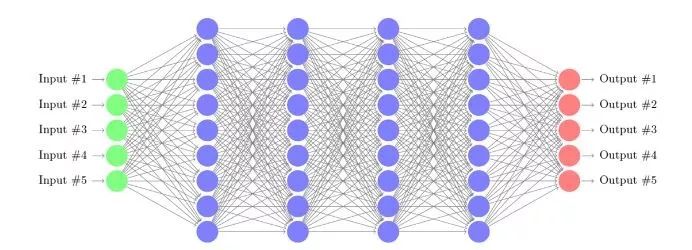

雖然神經網絡在近年來 AI 領域取得的成就中發揮了關鍵作用,但它們依舊只是有限可解釋性的黑盒函數近似器。即便是試圖將有限訓練數據泛化到未見過的輸入,它們在小的干擾下也可能失敗,更何況這種做法還會導致難以驗證算法的魯棒性。

讓我們看看當前研究工作的兩個案例,它們讓研究者可以檢驗神經網絡的內部運作。第一個是關于可驗證性,第二個則是關于可解釋性。

深度神經網絡的可驗證性

我們希望確保神經網絡能夠適用于所有可能的情況,但可驗證性在實驗方面超出了現有工具力所能及的范圍。目前,專用工具只能處理非常小的網絡,例如具有 10-20 個隱藏節點的單個隱藏層。Katz 等人在論文「Reluplex: An efficient SMT solver for verifying deep neural networks」(論文地址:https://arxiv.org/abs/1702.01135)中提出了 Reluplex,一種用于神經網絡錯誤檢測的新算法。Reluplex 將線性編程技術與 SMT(可滿足性模塊理論)求解技術相結合,其中神經網絡被編碼為線性算術約束。核心觀點就是避免數學邏輯永遠不會發生的測試路徑,這允許測試比以前更大的數量級的神經網絡,例如,每個具有 8 層和 300 個節點的全連接神經網絡。

Reluplex 可以在一系列輸入上證明神經網絡的屬性。它可以測量對抗魯棒性,換言之,即測量可以產生虛假結果的最小或閾值對抗性信號。見 Raghunathan 等人的《針對對抗性實例的認證防御》(https://openreview.net/pdf?id=Bys4ob-Rb),這是另一個評估對抗魯棒性的案例。

Reluplex 案例研究:無人機防撞

Reluplex 曾被用來測試 ACAS Xu (https://arxiv.org/abs/1810.04240)早期原型的神經網絡,是一種用于無人機的機載防撞系統。如圖所示,該系統考慮了兩架無人機:一架是由 ACAS Xu 軟件控制的你自己的無人機「Ownship」,另一架是我們進行觀察的無人機「Intruder」。其目標是引導「Ownship」避免與「Intruder」發生碰撞。

在第一種情況下,要求研究人員展示,如果「Intruder」從左側接近,那么系統將建議「Ownship」向右急轉彎。研究人員使用一定的計算資源在 1.5 小時內證明了該網絡在每種情況下都能正常運行。另一個更為復雜的情況是 「Intruder」 和 「Ownship」 處于不同海拔高度的情況,此外 「Ownship」 在這之前還接收到了關于緩慢左轉的建議。這說明了在這種系統中可能出現的復雜性。在這種情況下,網絡應該建議 COC(沒有沖突,即保持當前路線)或緩慢左轉。研究人員使用適度的計算資源在 11 個小時內找到了一個反例,后來又在不同的網絡中糾正了該反例。

理解模型預測

我們能解釋為什么神經網絡會做出具體的預測嗎?這是 Koh 和 Liang 在論文「 Understanding black-box predictions via influence functions」(https://arxiv.org/pdf/1703.04730.pdf)中提出的問題。當深度學習模型用于決定獲得金融貸款或健康保險的對象以及一些其他應用程序時,這一點非常重要。當人工智能系統易于理解時,他們可能會做出更好的決策,從而改進模型的開發,得出更重大的發現,深化我們對 AI 的信任,以及實現更好的發展。因此,研究人員的方法是對給定預測結果最相關訓練節點的確定。他們的關鍵點是使用「影響函數」,通過數學來回答這個問題:「如果我們沒有訓練節點,模型的預測會如何變化?」

在上圖中,如果這只白狗的像素點正是使得該神經網絡將其識別為狗,那么系統就非常合理。換句話說,如果海浪的像素點被識別輸出為「狗」,則該系統易錯率就很高 ——僅具有海浪的其他圖像可能被錯誤地歸類為「狗」。通過正確識別白狗的像素影響比海浪像素更高,我們的系統在處理噪聲時就會表現得更可靠。

尋找和消除偏差

人工智能系統反映出社會偏差一點都不讓人驚訝。Zou 和 Schiebinger 在論文「Design AI so that it’s fair 」(https://www.nature.com/articles/d41586-018-05707-8)中指出偏差可能有兩個來源,即訓練數據和算法。訓練數據中的偏差可能是由于某些群體在數據庫中占比過高或過低,解決方案是調查如何策劃訓練數據。而算法可以放大偏差,因為典型的機器學習程序是試圖最大化整個訓練數據的整體預測精度,因此解決方案是研究偏差的傳播和放大方式。

幾何捕獲語義

Bolukbasi 等人在論文「Man is to Computer Programmer as Woman is to Homemaker? Debiasing Word Embeddings」(https://arxiv.org/pdf/1607.06520.pdf)中,使用單詞配對來檢查偏差。例如,考慮這個問題,男人對應王,那么女人對應什么?任何五歲的孩子都可以回答這個問題,男人是王,那么女人就是女王。研究人員使用 Google 新聞語料庫的 Word2Vec 模型回答了單詞配對問題。每個單詞都映射到高維空間中的一個點。單詞之間的關系由連接這些單詞的向量表示。

單詞嵌入高維空間的二維投影,其中連接女人與女王的向量

與連接男人與王的向量的長度和方向相同

谷歌新聞語料庫很龐大,其中許多文章的作者都是專業記者,因此我們理想的期望是使用這些數據訓練的模型沒有偏差。然而經過片刻的反思,我們意識到這個模型可能會反映社會的偏差,因為它畢竟是對我們社會產生的數據進行的訓練,這正是我們接下來討論的。

讓我們來看看另一個詞配對:「他」對應的是「兄弟」,那「她」對應著的是什么?同樣,任何五歲的孩子都可以回答說「他」對應「兄弟」,那么「她」對應「姐妹」。我們有一個良好的開端,但正如你在下圖中看到的那樣,事情開始急速轉折。一些單詞配對表現出偏差(「他」對應的是「醫生」,那「她」則對應「護士」;「他」對應的是「計算機程序員」,那「她」則對應「家庭主婦」),另外有一些更是奇怪得徹頭徹尾(「她」對應著「懷孕」,而「他」竟然對應著「腎結石」)。

研究人員發現,通過消除性別刻板印象,例如接待員和女性之間的聯系,同時保留所期望的聯系,比如女王和女性之間的關聯,可以減少性別偏差。為了做到這一點,他們根據定義區分了與性別相關的性別特定詞,如兄弟,姐妹,商人和女商人,以及其余的性別中性詞。在幾何學上,他們確定了兩個正交維度,即性別特定詞與性別中性詞間的差別。他們的消除偏差算法通過折疊性別中立的方向去除性別中性詞和性別的關聯。谷歌,推特,臉書,微軟和其他公司都在使用這種消除方式。

在沒有人群統計的情況下實現公平

Hashimoto 等人在論文「Fairness without demographics in repeated loss minimization」(https://arxiv.org/pdf/1806.08010.pdf)中想搞清楚是否即使我們沒有人群統計信息也有可能開發公平的系統。其主要問題是少數群體在最小化平均訓練損失方面的代表性較低。由于成本或隱私原因,分組標簽可能不可用,或者受保護的群體可能無法被識別或被知道。當前的方法,即經驗風險最小化,會隨著時間的推移進一步縮小輸入數據中的少數群體,而使問題變得更糟。這些研究人員的目標是即使在沒有人口統計標簽的情況下,保護所有群體,甚至是少數群體。所以他們的解決方案是一種基于「分布式穩健優化」的方法,可以最大限度地減少所有群體的損失。

分布式穩健優化的目的是控制所有組的最壞情況風險。直觀地說,這種方法是加大高損失樣本的比重。相對于整個樣本而言,加大高損失的樣本比重能對具有較少高損失樣本的模型做相應的調整,使得某些分組就不再有不成比例的高誤差了。即少數群體相關的數據點將默認為遭受高損失的數據點,因此這種方法可以幫助避免這種情況。

確保安全的自治系統

機器人,無人機和自動駕駛車輛需要算法來進行安全學習、規劃和操控。當系統探索周圍環境時,他們必須處理它們的行為所造成的結果、動態環境和未知人類交互所存在的不確定性。在以下兩個例子中,研究人員將自主機器人和人類建模為一個系統。

人機交互的數據驅動概率建模

Marco Pavone 教授的研究(論文:「Multimodal Probabilistic Model-Based Planning for Human-Robot Interaction」,https://arxiv.org/pdf/1710.09483.pdf),旨在開發一個決策和控制堆棧,用于在有多種不同行動方案的環境中進行安全的人機交互。在這案例中,研究人員考慮在進出高速公路的匝道上進行交織區交通流測試。他們的方法是首先從車輛交互樣本的數據集中學習未來人類行為的多模態概率分布,然后通過從人類對指定機器人動作序列的回應中進行大規模并行采樣來構建實時的機器人策略。該框架不對人類動機做出任何假設,這使得它可以對各種人類駕駛行為進行建模。

值得注意的是,該模型包括高級別隨機決策和低級別安全保護控制。考慮到人類有時可能會無視機器人預測,該框架增加了一個低級別的跟蹤控制器,當安全受到威脅時,該控制器將隨機規劃者所需軌跡轉化為安全保護控制模式。

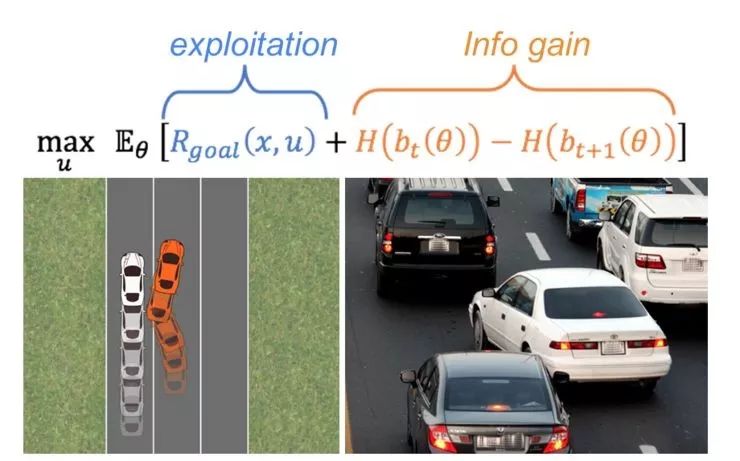

安全學習人的內在狀態

Dorsa Sadigh (相關工作論文:「Planning for cars that coordinate with people: leveraging effects on human actions for planning and active information gathering over human internal state」,http://iliad.stanford.edu/pdfs/publications/sadigh2018planning.pdf)和 Mykel Kochenderfer 正在研究通過訓練自動駕駛汽車來了解人類駕駛員的內在狀態。他們將自主車輛和人類之間的相互作用建模為動力系統來實現這一點。當然,這項研究中,自動駕駛汽車的動作采用直接控制的方式,但這些動作會影響人類的行為,因此也可以間接控制人類的行為。

想象一下,你正試圖在擁擠的高速公路上變道。在觀察其他駕駛員的反應時,你可能會從當前車道緩慢進入新車道。如果另一個駕駛員減速并打開一個間隙,那么你繼續換道,但如果另一個駕駛員加速并阻擋你,那么你將返回你的車道并稍后再試。曾經常用的方法大體是通過讓機器人最大化其自身獎勵函數,但現在這個獎勵函數可以直接取決于人類做出的響應。由于司機對其他司機的行為做出回應,我們有機會進行積極的信息收集。

未來

在不久的將來,我們將享受安全可靠的人工智能系統,這些系統具有可驗證性、可審計性、可解釋性、無偏差性和魯棒性。正如斯坦福大學人工智能實驗室以及其他實驗室的研究正在提供創新的技術解決方案,使得這些美好的期愿成為可能。

但光靠技術解決方案還不夠,成功還需要對這些解決方案謹慎的實施,并引入社會意識,以確定我們希望在這些系統中加入哪些參數。最近,我們看到以人為本的人工智能方法的興起,考慮了人為因素和社會影響,這讓我們看到:即使對于文化迥異的用戶和各種意外情況,這些方法都將賦予人工智能系統以安全、可靠和合理的工作方式!

-

神經網絡

+關注

關注

42文章

4772瀏覽量

100828 -

黑盒子

+關注

關注

0文章

5瀏覽量

8790

原文標題:AI 在安全、可靠性方面到底取得了哪些進展?斯坦福 AI 實驗室進行了總結

文章出處:【微信號:AItists,微信公眾號:人工智能學家】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

相關推薦

數據智能系列講座第3期—交流式學習:神經網絡的精細與或邏輯與人類認知的對齊

深度理解神經網絡黑盒子:可驗證性和可解釋性

深度理解神經網絡黑盒子:可驗證性和可解釋性

評論