面積42225 平方毫米,擁有1.2 萬億個晶體管,400000 個核心,片上內存18 Gigabytes,內存帶寬19 PByte/s,fabric帶寬100 Pbit/s。這就是有史以來最大的芯片——Cerebras Wafer Scale Engine!

這顆巨型芯片由Cerebras Systems公司推出,芯片發布后,三位中國芯片領域專家在朋友圈立即做出評價:

芯片專家唐杉:“膜拜一下Cerebras的巨型芯片,每邊大約9英寸,22cm。我記得我之前寫文章還畫過一個類似的對比圖。[機智]Wired的文章,看來Cerebras要走到前臺了。”

深鑒科技聯合創始人姚頌:“Cerebras的Wafer-scale chip確實壯觀,有一種獨特的美感,就好像看到大炮巨艦的那種壯麗之情。希望Andrew Feldman一切順利。”

獵戶星空首席戰略官王兵:“一萬兩千億晶體管的巨大芯片,300mm wafer能做出的最大芯片,挑戰芯片行業極限之作。如果能成功必然會顛覆整個AI芯片行業。不過即便是用了多種錯誤冗余技術,量產良品率還將會是個巨大的挑戰。”

Cerebras Wafer Scale Engine擁有1.2萬億個晶體管。1971年英特爾首款4004處理器的晶體管數量為2,300個,最近的AMD處理器擁有320億個晶體管。

大多數芯片實際上是在12英寸硅晶片上創建的芯片集合,并在芯片工廠中批量生產。但Cerebras Systems芯片是在單個晶圓上互連的單芯片。這些互連設計使這些芯片全部保持高速運行狀態,萬億個晶體管可以全部一起工作。

通過這種方式,Cerebras Wafer Scale Engine成為有史以來最大的處理器,它專門設計用于處理AI應用問題。該公司在本周在斯坦福大學舉行的Hot Chips會議上討論這款“世界最大”的芯片的設計。

此前,三星實際上已制造出了一個閃存芯片eUFS,擁有2萬億個晶體管。但Cerebras芯片專為流程加工而設計,擁有400,000個核心,芯片面積42,225平方毫米。它比最大的Nvidia GPU大56.7倍,后者尺寸為815平方毫米,含211億個晶體管。

史上最大芯片跟棒球的對比

WSE還包含3,000倍的高速片上存儲器,并且具有10,000倍的存儲器帶寬。

該芯片來自Andrew Feldman領導的團隊,后者曾創建微型服務器公司SeaMicro,并以3.34億美元的價格賣給了AMD。Cerebras Systems的聯合創始人兼首席硬件架構師Sean Lie將將在Hot Chips大會上展示Cerebras Wafer Scale Engine。這家位于加州Los Altos的公司擁有194名員工。

Cerebras CEOFieldman與SeaMicro box最初版本合影

芯片尺寸在AI任務中非常重要,因為大尺寸芯片可以更快地處理信息,在更短的時間內給出答案。這能夠減少“訓練時間”,使研究人員能夠測試更多想法,使用更多數據并解決新問題。谷歌、Facebook、OpenAI、騰訊、百度和許多企業都認為,今天制約AI發展的基本限制是訓練模型需要的時間太長。因此,縮短訓練時間有望消除整個行業取得進步的主要瓶頸。

當然,芯片制造商通常不會制造這么大的芯片。在單個晶片的制造過程中通常會出現一些雜質。如果一種雜質會導致一塊芯片發生故障,那么晶圓上的多種雜質就會導致多塊芯片出問題。實際制造出的芯片產量僅占實際工作芯片的一小部分。如果晶圓上只有一個芯片,它有雜質的幾率是100%,雜質會使芯片失效。但Cerebras設計的芯片留有冗余,一種雜質不會導致整個芯片都不能用。

單晶圓提供超級計算機級的計算能力

“Cerebras WSE”專為人工智能設計而設計,其中包含了不少基礎創新,解決了限制芯片尺寸的長達數十年的技術挑戰 - 如良品率,功率傳送、封裝等,推動了最先進技術的發展。和包裝,每個架構決策都是為了優化AI工作的性能。結果是,Cerebras WSE根據工作量提供了數百或數千倍的現有解決方案的性能,只需很小的功耗和空間。”Cerebras Systems首席執行官的Fieldman說。

通過加速神經網絡訓練的所有元素來實現這些性能提升。神經網絡是一種多級計算反饋回路。輸入在循環中移動速度越快,循環學習的速度越快,即訓練時間越短。可以通過加速循環內的計算和通信來加速輸入的循環速度。

Cerebras WSE芯片面積比目前最大的GPU大56.7倍, 并提供更多核心進行計算,有更多核心靠近內存,因此內核可以高效運行。由于這些大量的內核和內存位于單個芯片上,因此所有通信都在芯片上進行,通信帶寬高、延遲低,因此核心組可以以最高效率進行協作。

Cerebras WSE中的46,225平方毫米的芯片面積上包含40萬個AI優化核心,無緩存、無開銷的計算內核,以及和18千兆字節的本地化分布式超高速SRAM內存。內存帶寬為每秒9 PB。這些核心通過細粒度、全硬件、片上網狀連接通信網絡連接在一起,可提供每秒100 petabits的總帶寬。更多核心、更多本地內存和低延遲高帶寬結構,共同構成了面向AI加速任務的最佳架構。

“雖然AI在一般意義上被使用,但沒有兩個數據集或兩個AI任務是相同的。新的AI工作負載不斷涌現,數據集也在不斷變大,”Tirias Research首席分析師兼創始人Jim McGregor在一份聲明中表示。

“隨著AI的發展,芯片和平臺解決方案也在不斷發展。Cerebras WSE是半導體和平臺設計方面的一項驚人的工程成就,它在單個晶圓級的解決方案中提供了超級計算機級的計算能力、高性能內存和帶寬。”

Cerebras 表示,如果沒有多年來與臺積電(TSMC)的密切合作,他們不可能取得這個創紀錄的成就。臺積電是全球最大的半導體代工廠,在先進工藝技術方面處于領先地位。WSE芯片由臺積電采用先進的16nm制程技術制造。

400000個AI優化的內核

WSE包含40萬個AI優化的計算內核(compute cores)。這種計算內核被稱為稀疏線性代數核(Sparse Linear Algebra Cores, SLAC),具有靈活性、可編程性,并針對支持所有神經網絡計算的稀疏線性代數進行了優化。SLAC的可編程性保證了內核能夠在不斷變化的機器學習領域運行所有的神經網絡算法。

由于稀疏線性代數內核是為神經網絡計算進行優化的,因此它們可實現業界最佳利用率——通常是GPU的3倍或4倍。此外,WSE核心還包括Cerebras發明的稀疏捕獲技術,以加速在稀疏工作負載(包含0的工作負載)上的計算性能,比如深度學習。

零在深度學習計算中很普遍。通常,要相乘的向量和矩陣中的大多數元素都是0。然而,乘以0是浪費硅,功率和時間的行為,因為沒有新的信息。

因為GPU和TPU是密集的執行引擎——引擎的設計永遠不會遇到0——所以它們即使在0時也會乘以每一個元素。當50-98%的數據為零時,如深度學習中經常出現的情況一樣,大多數乘法都被浪費了。由于Cerebras的稀疏線性代數核心永遠不會乘以零,所有的零數據都被過濾掉,可以在硬件中跳過,從而可以在其位置上完成有用的工作。

比GPU大3000倍的片上內存

內存是每一種計算機體系結構的關鍵組成部分。靠近計算的內存意味著更快的計算、更低的延遲和更好的數據移動效率。高性能的深度學習需要大量的計算和頻繁的數據訪問。這就要求計算核心和內存之間要非常接近,而在GPU中卻不是這樣,GPU中絕大多數內存都很慢,而且離計算核心很遠。

Cerebras Wafer Scale Engine包含了比迄今為止任何芯片都要多的內核和本地內存,并且在一個時鐘周期內擁有18 GB的片上內存。WSE上的核心本地內存的集合提供了每秒9 PB的內存帶寬——比最好的GPU大3000倍的片上內存和10000倍的內存帶寬。

低延遲、高帶寬的獨特通信結構

Swarm通信結構是WSE上使用的處理器間通信結構,它以傳統通信技術功耗的一小部分實現了帶寬的突破和低延遲。Swarm提供了一個低延遲、高帶寬的2D網格,它將WSE上的所有400,000個核連接起來,每秒的帶寬總計達100 petabits。

路由、可靠的消息傳遞和同步都在硬件中處理。消息會自動激活每個到達消息的應用程序處理程序。Swarm為每個神經網絡提供了一個獨特的、優化的通信路徑。軟件根據正在運行的特定用戶定義的神經網絡的結構,配置通過400,000個核心的最優通信路徑,以連接處理器。

典型的消息遍歷一個具有納秒延遲的硬件鏈接。一個Cerebras WSE的總帶寬是每秒100 PB。不需要TCP/IP和MPI等通信軟件,因此可以避免性能損失。這種結構的通信能量成本遠低于遠低于每比特 1 焦耳,比GPU低了近兩個數量級。結合了巨大的帶寬和極低的延遲,Swarm通信結構使 Cerebras WSE比任何當前可用的解決方案學習得更快。

-

芯片

+關注

關注

455文章

50817瀏覽量

423680 -

AI

+關注

關注

87文章

30897瀏覽量

269111

原文標題:史上最大芯片誕生!1.2萬億晶體管超級巨無霸,專為AI設計

文章出處:【微信號:AI_shequ,微信公眾號:人工智能愛好者社區】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

相關推薦

iPhone XS創八項紀錄發布!最貴、最大、最強AI芯片,雙卡特供中國

2007年10大芯片廠商排名全新出爐

Github發布史上最大更新

AI發展對芯片技術有什么影響?

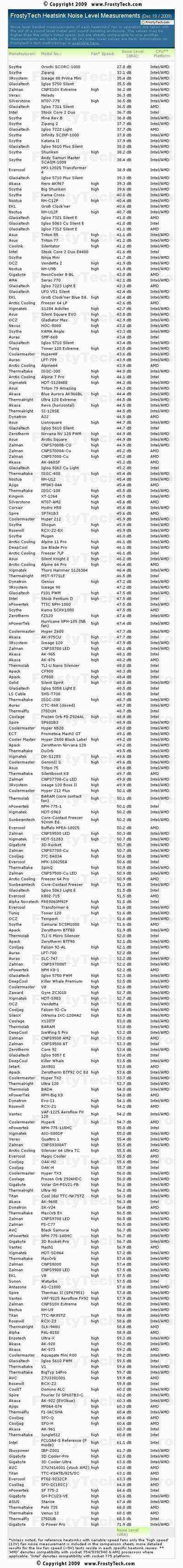

史上規模最大 252款CPU散熱器排排坐

WAPI終端芯片模塊出爐與WiFi兼容

賽靈思發布史上最大容量FPGA芯片VU19P

史上最大芯片將用于這兩個項目

WWDC亮點:史上最大MacBook Air 游戲制作人小島秀夫亮相蘋果春晚

史上最大芯片出爐,專為AI設計

史上最大芯片出爐,專為AI設計

評論