不到現(xiàn)場,照樣看最干貨的學(xué)術(shù)報告!嗨,大家好。這里是學(xué)術(shù)報告專欄,讀芯術(shù)小編不定期挑選并親自跑會,為大家奉獻科技領(lǐng)域最優(yōu)秀的學(xué)術(shù)報告,為同學(xué)們記錄報告干貨,并想方設(shè)法搞到一手的PPT和現(xiàn)場視頻——足夠干貨,足夠新鮮!話不多說,快快看過來,希望這些優(yōu)秀的青年學(xué)者、專家杰青的學(xué)術(shù)報告 ,能讓您在業(yè)余時間的知識閱讀更有價值。

人工智能論壇如今浩如煙海,有硬貨、有干貨的講座卻百里挑一。“AI未來說·青年學(xué)術(shù)論壇”系列講座由中國科學(xué)院大學(xué)主辦,承辦單位為中國科學(xué)院大學(xué)學(xué)生會,協(xié)辦單位為中國科學(xué)院計算所研究生會、網(wǎng)絡(luò)中心研究生會、人工智能學(xué)院學(xué)生會、化學(xué)工程學(xué)院學(xué)生會、公共政策與管理學(xué)院學(xué)生會、微電子學(xué)院學(xué)生會,百度為支持單位,讀芯術(shù)、PaperWeekly為合作自媒體。“AI未來說·青年學(xué)術(shù)論壇”第八期“深度學(xué)習(xí)”專場已于2019年8月25日下午在中科院舉行。中科院付鵬為大家?guī)韴蟾妗渡疃葘W(xué)習(xí)與機器閱讀》。

付鵬,男,中國科學(xué)院信息工程研究所博士,現(xiàn)為中國科學(xué)院信息工程研究所助理研究員,主要從事自然語言處理、機器學(xué)習(xí),具體包括情感/情緒分析、語義理解、機器閱讀、文本生成等,在2018全國“軍事智能-機器閱讀”挑戰(zhàn)賽中,獲得決賽總成績第一(1/267,獎金20萬),并且包攬了所有單項第一名,主持和參與了國家自然科學(xué)基金、國家重點研發(fā)計劃等課題,近幾年在AAAI、EMNLP、CIKM等國內(nèi)外學(xué)術(shù)會議與期刊上發(fā)表學(xué)術(shù)論文10余篇。

報告內(nèi)容:本次報告主要包括機器閱讀概述、傳統(tǒng)機器閱讀方法、深度學(xué)習(xí)方法和競賽分享四個部分。

深度學(xué)習(xí)與機器閱讀

付鵬老師先介紹了自然語言處理的概念,即研究實現(xiàn)人與計算機之間用自然語言進行有效通信的各種理論和方法。自然語言處理技術(shù)的發(fā)展經(jīng)歷了基于規(guī)則(1990年以前)、基于統(tǒng)計學(xué)習(xí)(1990年~2012年)和基于深度學(xué)習(xí)(2012年至今)的方法三個階段,涉及由淺入深的四個層面,分別為形式、語義、推理和語用,當前正處于由語義向推理的發(fā)展階段。

然后引出了自然語言處理技術(shù)所面臨的難題:1)中文分詞(segmentation)困難,如“一行行行行行,一行不行行行不行”和“一位友好/的哥/譚市民”;

2)歧義(ambiguity)現(xiàn)象:一是結(jié)構(gòu)歧義,如“今天中午吃饅頭”和“今天中午吃食堂”;二是指代歧義,如“他快抱不起兒子了,因為他太胖了”;三是語義歧義,如“她這個人真有意思(funny)”,“人們以為他們有了意思(wish)”,“我根本沒有那個意思(thought)”和“真沒意思(nonsense)”;

3)未知語言現(xiàn)象:一是新詞,如不明覺厲、累覺不愛和十動然拒;二是舊詞新義,如母雞、白骨精和潛水;三是新用法新結(jié)構(gòu),在口語中或部分網(wǎng)絡(luò)語言中,不斷出現(xiàn)一些“非規(guī)范的”新的語句結(jié)構(gòu),如c位出道、ORZ和熱skr人了;

4)不同語系的差異:一是屈折語,用詞的形態(tài)變化表示語法關(guān)系,如英語、法語等;二是黏著語,詞內(nèi)有專門表示語法意義的附加成分,詞根或詞干與附加成分的結(jié)合不緊密,如日語、韓語、土耳其語等;三是孤立語,形態(tài)變化少,語法關(guān)系靠詞序和虛詞表示,如漢語。

接著介紹了自然語言處理的技術(shù)概覽,主要包括:1)NLP基礎(chǔ)技術(shù),如詞匯表示和語義分析、短語表示和語義分析、句子表示和語義分析以及篇章表示和語義分析;2)NLP核心技術(shù),如情感分析、信息檢索、機器翻譯、機器閱讀、問答系統(tǒng)、語言生成、推薦系統(tǒng)以及聊天和對話;3)NLP+,如智能分析、搜索引擎、商業(yè)智能和輿情分析。

進而引出了機器閱讀的主題,機器閱讀是自然語言處理領(lǐng)域“皇冠上的明珠”,涉及到語義理解、知識推理等多項復(fù)雜技術(shù),極具挑戰(zhàn)性,該技術(shù)旨在讓AI代替人類,自動閱讀新聞報道等信息并根據(jù)問題給出答案,可應(yīng)用于輿情分析和情報挖掘領(lǐng)域等多個場景。機器閱讀的難點挑戰(zhàn)主要包括:1)語義推理難,語言博大精深,如“作為失敗的典型,你真的太成功了”;2)語義關(guān)聯(lián)難,字同意不同,如“誰是特朗普的兒子”和“誰的兒子是特朗普”;3)語義表示難,分詞歧義,如“昨天/下午”和“作/天下/午”,一詞有多義,如“我愛吃蘋果”和“蘋果發(fā)布會”。

在介紹完機器閱讀的難點挑戰(zhàn)之后,又介紹了機器閱讀的發(fā)展歷程:TeachingMachines to Read and Comprehend(Karl Moritz Hermann et al.) → Attention-Sum Reader(Kadlec et al.) →SQuAD(Rajpurkar et al.) → Match-LSTM(Wang et al.) → R-Net(Wang et al.) →BiDAF(Minjoon Seo et al.) → QA-Net(Yu et al.) → BiDAF+self-attention + BERT。

緊接著介紹了傳統(tǒng)機器閱讀方法,主要包括早期系統(tǒng)和機器學(xué)習(xí)時代的方法。其中,在介紹早期系統(tǒng)時,介紹了QUALM系統(tǒng)(Lehnert,1977)、早期數(shù)據(jù)集(Hirschman, 1999)、Deep Read系統(tǒng)(Hirschman, 1999)和QUARC系統(tǒng)(Riloff andThelen, 2000)。在機器學(xué)習(xí)時代,機器閱讀的數(shù)據(jù)被轉(zhuǎn)化為 《文章,問題,答案》 的三元組形式,有兩個重要的數(shù)據(jù)集:1)MCTest,四選一數(shù)據(jù)集,包含660篇科幻小說;2)ProcessBank,二分類數(shù)據(jù)集,包含585個問題和200個段落,是生物類型文章,需要理解實體關(guān)系和事件。基于傳統(tǒng)規(guī)則方法的特點包括:1)不使用訓(xùn)練數(shù)據(jù)集;2)啟發(fā)式的滑動窗口方法,計算word overlap、distance information;3)文本蘊含方法,用現(xiàn)有的文本蘊含系統(tǒng),把(問題,答案)對轉(zhuǎn)化為一個statement;4)max-margin學(xué)習(xí)框架,使用了很多語言特征,如句法依存、semantic frames、指代消解、discourse relation和詞向量等。

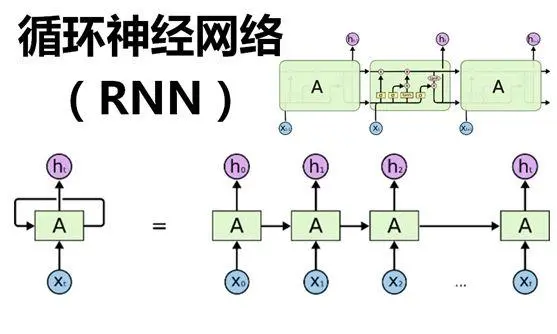

隨后,以傳統(tǒng)機器閱讀的方法作為引入,引出了深度學(xué)習(xí)的方法。先介紹了機器閱讀的主要步驟:文本表示(將文本表示成機器能理解的符號)→ 語義匹配(尋找問題和原文句子的語義關(guān)聯(lián)) → 理解推理(對語義關(guān)聯(lián)進行加工和推理) → 結(jié)果推薦(對候選答案進行排序和輸出)。

在介紹完機器閱讀的主要步驟之后,又介紹了機器閱讀的主要數(shù)據(jù)集:1)MCTest數(shù)據(jù)集,給定一篇文章、一個問題以及四個選項,預(yù)測哪個選項是問題的答案;2)CNN/Daily Mail 數(shù)據(jù)集,給定一篇文章和一個問題,預(yù)測問題中被X替代的實體是文章中的哪個實體;3)SQuAD數(shù)據(jù)集,給定一篇文章、一個問題,預(yù)測文章中的一個區(qū)間(一個或幾個詞)作為答案;4)Quasar-T數(shù)據(jù)集,給定幾篇文章、一個問題,預(yù)測文章中的一個區(qū)間(一個或幾個詞)作為答案。

然后又講到了注意力機制,Seq2Seq模型存在兩個問題,一是定長的中間向量 c 限制了模型性能,二是輸入序列的不同部分對于輸出序列的重要性不同。對于Seq2Seq存在的問題,提出了相應(yīng)的解決方案:解碼器中的每個時刻不是輸入固定的c,而是輸入不同的 ci,每個時刻的 c 自動選取與當前輸出最相關(guān)的上下文。其中,ci 為編碼器中隱狀態(tài)的加權(quán)和。

在介紹完注意力機制之后,又詳細介紹了機器閱讀模型BiDAF (ICLR 2017),該模型包括輸入部分、雙向注意力和輸出部分,其中,輸入為一篇文章X和一個問題Y,輸出為文章中每一個詞作為答案開始的概率和答案結(jié)束的概率。雙向注意力是上下文(context)和檢索(query)之間相互指導(dǎo)的注意力機制。

接著又進一步介紹了機器閱讀的最新進展,重點講解了兩篇文章,分別為Improving Machine Reading Comprehension with Reading Strategies (NAACL 2019) 和Adversarial Examples for Evaluating Reading Comprehension Systems (EMNLP 2017)。其中,前者是基于已有模型的改進,受閱讀策略被證明可以提高閱讀理解的水平的啟發(fā),提出了三種閱讀策略:Backand Forth Reading,Highlighting 和 Self-Assessment,并且模型中用到了GPT (GenerativePre-trained Transformer)。后者介紹了機器閱讀的新問題-對抗閱讀,文本針對斯坦福問答數(shù)據(jù)集(SQuAD)提出一個對抗評估方案,自動生成并在段落中插入對抗語句,然后測試系統(tǒng)能否圍繞這一段落回答問題。這些對抗語句的目的在于干擾計算機回答系統(tǒng),但并不會改變問題的正確答案,也不會對人類造成干擾。在這種對抗方案中,16個已發(fā)表模型的精確度從75%(F1數(shù))降到了36%。當對抗系統(tǒng)被允許加入不符合語法的短語串,有四個模型的平均精度下降到了7%。

在介紹完最新的研究進展之后,又介紹了多文檔閱讀,多文檔閱讀的過程:問題文檔集合→ 文檔檢索模塊 → 答案抽取模塊 → 最終答案。多文檔閱讀主要存在三個難點:1)需要基于多個段落預(yù)測答案;2)與問題相似的段落干擾問題;3)遠程監(jiān)督假設(shè)帶來噪音問題。然后又介紹了國內(nèi)外的研究現(xiàn)狀,開放域問答包括單段落方案和多段落方案,其中多段落的方案又包括基于答案重排序和基于答案置信度。

接著,付鵬老師又介紹了他所在團隊提出的模型Ranking and Sampling in Open-Domain Question Answering (EMNLP 2019),該模型的特點:1)在段落選擇部分充分利用段落和問題以及段落和段落之間的信息,采用層級注意力機制和自注意力機制進行降噪;2)在訓(xùn)練時采用隨機采樣→ 帶權(quán)采樣段落選擇方案,提升模型泛化能力,避免干擾;3)解決開放域問答中的噪音和干擾問題,提升系統(tǒng)準確率。

最后,付鵬老師介紹了他們在全國“軍事智能-機器閱讀”競賽中的參賽經(jīng)歷,他所在的團隊獲得了決賽總成績第一名,并且包攬了所有單項第一名(軍事新聞、防務(wù)快訊、非密情報三個單項比賽),RougeL值高達91.39%。并介紹了競賽的任務(wù)、問題實例、數(shù)據(jù)特點以及總體的框架。

其中競賽任務(wù)的問題包括6種類型:1)事實型問題(第X艦隊指揮官是誰?)2)列表型問題(X國艦載機機型?)3)數(shù)值型問題(XX艦的排水量?)4)定義型問題(“XX一體站”的定義?)5)觀點型問題(XX對軍事智能化的指示?)6)篇章型問題(X國與X國領(lǐng)土爭端的進展?)。

數(shù)據(jù)的特點包括:1)文章的長度較長,經(jīng)典的SQUAD數(shù)據(jù)集的最長文章的單詞數(shù)在700以下。但是該數(shù)據(jù)集文章中字符的個數(shù)普遍在幾千甚至上萬,最長的一篇還有10萬多的字符;2)標注的問答可能在文章中出現(xiàn)多次或者不出現(xiàn),訓(xùn)練數(shù)據(jù)標注存在噪音問題;3)一部分問題的答案由文中不相鄰的多句話組成,比如,列表型問題和篇章型問題可能出現(xiàn)答案由文中不相鄰的多句話組成,但是數(shù)目比較少。

模型的總體框架分為兩步:1)利用問題去篩選答案候選集;2)利用模型預(yù)測最終答案。總體框架的流程:數(shù)據(jù)預(yù)處理→ 答案候選集篩選 → 模型預(yù)測答案 → 后處理 → 最終答案。更多精彩內(nèi)容請關(guān)注微信公眾號中的視頻分享。

-

人工智能

+關(guān)注

關(guān)注

1793文章

47566瀏覽量

239412 -

深度學(xué)習(xí)

+關(guān)注

關(guān)注

73文章

5511瀏覽量

121375 -

nlp

+關(guān)注

關(guān)注

1文章

489瀏覽量

22066

發(fā)布評論請先 登錄

相關(guān)推薦

【「具身智能機器人系統(tǒng)」閱讀體驗】+兩本互為支持的書

傳統(tǒng)機器學(xué)習(xí)方法和應(yīng)用指導(dǎo)

AI干貨補給站 | 深度學(xué)習(xí)與機器視覺的融合探索

激光雷達技術(shù)的基于深度學(xué)習(xí)的進步

AI大模型與深度學(xué)習(xí)的關(guān)系

【「時間序列與機器學(xué)習(xí)」閱讀體驗】+ 簡單建議

深度學(xué)習(xí)中的時間序列分類方法

深度學(xué)習(xí)中的無監(jiān)督學(xué)習(xí)方法綜述

深度學(xué)習(xí)在工業(yè)機器視覺檢測中的應(yīng)用

深度學(xué)習(xí)在視覺檢測中的應(yīng)用

深度學(xué)習(xí)與nlp的區(qū)別在哪

人工智能、機器學(xué)習(xí)和深度學(xué)習(xí)是什么

深度學(xué)習(xí)與傳統(tǒng)機器學(xué)習(xí)的對比

為什么深度學(xué)習(xí)的效果更好?

【技術(shù)科普】主流的深度學(xué)習(xí)模型有哪些?AI開發(fā)工程師必備!

深度學(xué)習(xí)與機器閱讀

深度學(xué)習(xí)與機器閱讀

評論