編者按:深度學(xué)習(xí)和人類智能存在一個(gè)顯著差異,即人類擅長通過極少量的樣本識別新類別物體,而深度學(xué)習(xí)在此情況下很容易產(chǎn)生過擬合。因此,小樣本問題成為了機(jī)器學(xué)習(xí)領(lǐng)域中重要的研究方向之一。目前已有基于度量學(xué)習(xí)、語義信息以及數(shù)據(jù)增強(qiáng)等多種方法,而至于大小樣本的邊界、小樣本學(xué)習(xí)的方法論等問題還備受關(guān)注。在本文中,復(fù)旦大學(xué)付彥偉、上海科技大學(xué)何旭明、北京郵電大學(xué)馬占宇、中科院計(jì)算所王瑞平(按發(fā)言順序整理),將答疑解惑探討小樣本學(xué)習(xí)的最新進(jìn)展。本文整理自VALSE Webinar 2019第29 期Panel。

議題1

小樣本 vs 大樣本,多“小”才算小,多“大”才算大?什么樣的情況下,需要專門設(shè)計(jì)“小樣本”學(xué)習(xí)算法?小樣本學(xué)習(xí)在智能體學(xué)習(xí)過程中如何和不同大小樣本的數(shù)據(jù)融合?如何在數(shù)據(jù)積累中過渡到大樣本學(xué)習(xí)?

付彥偉:這個(gè)問題很基礎(chǔ)也很有意思,我們其實(shí)做小樣本,一般都考慮每個(gè)類只有一個(gè)三個(gè)五個(gè)、或者十來個(gè)樣本,這種one-shot 、three-shot、five-shot情況。此外在深度學(xué)習(xí)之前,從partical learning這個(gè)角度來看其實(shí)有些問題可以借鑒,在統(tǒng)計(jì)學(xué),小樣本學(xué)習(xí)不叫one-shot learning,而叫做smoothing probability,也就是小樣本可能還和特征維度有關(guān)系。假設(shè)你的特征維度是D的話,當(dāng)樣本量小于logD,就算一個(gè)比較小的樣本。當(dāng)然現(xiàn)在有深度學(xué)習(xí)了,我們可能并不會從這個(gè)角度去看。

至于什么樣的情況需要專門設(shè)計(jì)小 樣本學(xué)習(xí)算法,其實(shí)這是一個(gè)很實(shí)際或者很工業(yè)的問題,比如在醫(yī)療圖像處理中解決很罕見的病變,樣本量確實(shí)不夠,我們想去學(xué)一個(gè)分類器就只能根據(jù)這個(gè)數(shù)據(jù)去設(shè)計(jì)小樣本學(xué)習(xí)算法。

小樣本學(xué)習(xí)在智能體學(xué)習(xí)過程如何和不同大小樣本的數(shù)據(jù)融合,這其實(shí)有很多角度。比如李飛飛老師在 ICCV2003年的一篇文章,通過貝葉斯這條思路去融合;我們也可以和專家系統(tǒng),或者通過一些專家知識融合,甚至可以和不同的領(lǐng)域,比如vocabulary inference learning領(lǐng)域,通過NLP去學(xué)習(xí)一些語義字典幫助小樣本學(xué)習(xí);如何在數(shù)據(jù)積累中過渡到大樣本學(xué)習(xí),這有一個(gè)很典型的增量學(xué)習(xí)問題。

何旭明:從視覺概念的認(rèn)知角度來看,小樣本的“大小”也體現(xiàn)在它與其他類別之間區(qū)分度的大小。即使有些類別樣本數(shù)量比較小,如果它和其他類別相似度較高,可以用很多先驗(yàn)知識來幫助學(xué)習(xí)這些小樣本,因此也可以不算“小樣本”。如果碰到一個(gè)和其他類區(qū)別很大的類別,可能通常的學(xué)習(xí)就會變得非常困難,需要當(dāng)作小樣本看待。

如果利用一些先驗(yàn)知識能夠幫助學(xué)習(xí)小樣本類別,我覺得這種情況是可以設(shè)計(jì)相關(guān)算法的。但如果很難得到先驗(yàn)知識,那無論什么設(shè)計(jì)也學(xué)不到有用信息。

針對如何從不同大小樣本中的數(shù)據(jù)融合問題,我認(rèn)為可以從大樣本入手開始學(xué)習(xí),然后擴(kuò)展到小樣本。即使類別不同,如果有相關(guān)性的話,依然可以去借鑒大樣本統(tǒng)計(jì)上的一些規(guī)律來幫助小樣本學(xué)習(xí)。

最后,借鑒人類的學(xué)習(xí)過程來說,一開始可能是小樣本,然后不斷在數(shù)據(jù)積累和反饋機(jī)制下,可以獲得更新的數(shù)據(jù)。這樣可以把視覺概念的表征不斷地細(xì)化,最后能夠自然而然地就能過渡到大樣本。

馬占宇:關(guān)于如何與不同規(guī)模大小樣本的數(shù)據(jù)融合,我覺得還有一個(gè)不平衡的學(xué)習(xí)問題。即首先分清哪些類別樣本是小的,哪些類別是大的。這種情況下,不是簡簡單單真地把小樣本變大,或者是說把大樣本增強(qiáng),理想的狀況是能夠在數(shù)據(jù)分布不平衡的情況下,去做一個(gè)比較好的分類器。

議題2

引入知識來彌補(bǔ)小樣本的數(shù)據(jù)不足是一個(gè)較為公認(rèn)的趨勢,到底什么算是“知識”,有哪些形式?目前真正管用/好用的“知識”是什么,來自哪里?

王瑞平:現(xiàn)在模型能夠取得成功,基本上都是依賴數(shù)據(jù)驅(qū)動。在數(shù)據(jù)不足的情況下,尤其在零樣本學(xué)習(xí)(極端情況)里面,一定要利用語義的知識去輔助。到底什么算是“知識”,現(xiàn)在零樣本里面可能會用一些屬性的標(biāo)注,包括一些類別在語義層面的相似性關(guān)系,都算比較底層的知識。從人類的認(rèn)知角度來看,相關(guān)的知識庫和應(yīng)用也可稱之為“知識”,這可能是一種更自然的方式。

那么目前真正管用或者是好用的“知識”有哪些?在零樣本和小樣本學(xué)習(xí)里面,大部分還是屬性、詞向量這種人類手工標(biāo)注的語義描述,其實(shí)這種知識可擴(kuò)展性比較差。我們不可能對所有類別標(biāo)注它所需要的全部知識,將來更有實(shí)踐意義的,應(yīng)該是從大量原始文本數(shù)據(jù)中進(jìn)行類別相關(guān)的語義挖掘和提純,然后結(jié)合手工標(biāo)注的屬性。這方面目前很大程度上仍受限于自然語言處理技術(shù)的發(fā)展,所以真正地用知識去彌補(bǔ)數(shù)據(jù)不足應(yīng)該是可努力的方向。

何旭明:在一些特定專業(yè)領(lǐng)域里面標(biāo)注是很困難的,比如醫(yī)學(xué)圖像分析。但是很多醫(yī)學(xué)學(xué)科已經(jīng)建立了比較完整的知識體系,因此充分利用這些專業(yè)的知識體系,可以幫助彌補(bǔ)數(shù)據(jù)匱乏的弱點(diǎn)。

付彥偉:從貝葉斯的角度,我們可以把知識當(dāng)做一個(gè)先驗(yàn)信息,把小樣本或者這些知識建模成一個(gè)分布,來幫助小樣本學(xué)習(xí)。甚至可能從圖形學(xué)模型的角度去思考,比如把一些領(lǐng)域的知識建模成一個(gè)ontology或者是一個(gè)圖形學(xué)模型。目前這方面還沒有探索得特別清楚,掌握知識其實(shí)是一個(gè)很基礎(chǔ)的問題。

議題3

在小樣本學(xué)習(xí)的實(shí)際場景中,數(shù)據(jù)量缺乏會帶來domain gap(域漂移)問題,怎么看待域漂移給小樣本學(xué)習(xí)帶來的挑戰(zhàn)?

馬占宇:我覺得域漂移和知識遷移都屬于跨域問題,從不同域之間這個(gè)層面上來定義比較好。所以說域漂移給小樣本學(xué)習(xí)帶來了挑戰(zhàn),也帶來了一些好處和機(jī)會,比如我們前面提到的跨模態(tài)、多模態(tài),可以把不同域之間的知識融合起來,最終進(jìn)行小樣本學(xué)習(xí)。

議題4

什么樣的小樣本訓(xùn)練數(shù)據(jù)集能夠產(chǎn)生較好的模型?

付彥偉:源數(shù)據(jù)和目標(biāo)數(shù)據(jù)比較相近或者相似的時(shí)候,源數(shù)據(jù)上訓(xùn)練的模型用于目標(biāo)數(shù)據(jù)的小樣本學(xué)習(xí),效果還是比較好的,如果差得比較大的話,其實(shí)還是有很大影響的,這個(gè)其實(shí)直接就和域漂移有很大關(guān)系。我們在做一些缺陷檢測時(shí)也會遇到很多類似的問題。

何旭明:在實(shí)用場景里面可以依據(jù)情況來考慮樣本選擇,依據(jù)問題賦予的靈活性分兩種情況:第一類問題,如果類別是可以選的,那就選擇和源數(shù)據(jù)比較近的樣本;第二類,如果類別是預(yù)規(guī)定好的,可以在每個(gè)類別通過數(shù)據(jù)選擇產(chǎn)生一些比較好的數(shù)據(jù)幫助訓(xùn)練。

議題5

one-shot learning要解決的是僅有少量訓(xùn)練數(shù)據(jù)時(shí)模型的過擬合問題么?那傳統(tǒng)解決過擬合的方法(如特征選取,正則化,提高訓(xùn)練樣本多樣性等)如何體現(xiàn)在現(xiàn)有的one-shot方法中呢?

付彥偉:之前基本就是以上的傳統(tǒng)策略。但是有了深度學(xué)習(xí)之后,我們?nèi)绻挥眠w移學(xué)習(xí),每個(gè)類5個(gè)訓(xùn)練樣本來訓(xùn)練一個(gè)學(xué)習(xí)器,可能就要考慮特征選擇、正則化這些問題。用深度學(xué)習(xí)的話,這個(gè)問題應(yīng)該還是存在的,可能只是形式變了,我們采用batch normalization 或者instance normalization來進(jìn)行正則化,特征選取可能也能對應(yīng)得上。因?yàn)槲覀冊谏疃葘W(xué)習(xí)中會隱含去做這些事情,比如說注意力機(jī)制本身也是一種特征選取。

何旭明:注意力機(jī)制實(shí)際上其實(shí)是在動態(tài)地特征選取。正則化的作用,除了BN,其實(shí)你的網(wǎng)絡(luò)模型設(shè)計(jì)就體現(xiàn)了對模型的約束;還有模型訓(xùn)練的損失函數(shù)設(shè)計(jì)也體現(xiàn)了這點(diǎn),比如添加額外的約束項(xiàng)。提高訓(xùn)練樣本的多樣性的話,現(xiàn)在很多的趨勢,就是做feature augmentation(特征增廣)。

議題6

機(jī)器學(xué)習(xí)(深度學(xué)習(xí))如今依賴海量數(shù)據(jù),樣本量過小容易過擬合,模型表達(dá)能力不足。但某些實(shí)際場景下樣本很難收集,應(yīng)該如何處理這些問題,如何防止過擬合?

王瑞平:這應(yīng)該就是小樣本學(xué)習(xí)的背景,小樣本和數(shù)據(jù)不平衡問題其實(shí)是共生的,實(shí)際生活當(dāng)中這兩個(gè)問題是普遍存在的。從企業(yè)界的項(xiàng)目經(jīng)驗(yàn)來看,通過數(shù)據(jù)增廣、相似類別之間的知識遷移、數(shù)據(jù)合成和domain adaptation(域自適應(yīng)學(xué)習(xí))。針對樣本類別之間的不平衡問題,可以做數(shù)據(jù)的合成或者分類器的合成。

馬占宇:樣本量過小導(dǎo)致的過擬合不僅是小樣本學(xué)習(xí)中面臨的問題。傳統(tǒng)機(jī)器學(xué)習(xí)里也同樣面臨這個(gè)問題,需要結(jié)合不同場景具體分析。

議題7

在小樣本學(xué)習(xí)中如何考慮任務(wù)之間的相關(guān)程度?如何在新領(lǐng)域的任務(wù)中應(yīng)用小樣本學(xué)習(xí)方法?

何旭明:現(xiàn)在的很多假設(shè)任務(wù)是獨(dú)立同分布的,也就是從一個(gè)分布中采樣出獨(dú)立的任務(wù)。在這個(gè)假設(shè)下,很難去探索任務(wù)之間的相關(guān)度。在實(shí)際應(yīng)用中,這個(gè)假設(shè)是比較強(qiáng)的,很多時(shí)候任務(wù)之間的確是有相關(guān)度的。那么或許最后會變成一個(gè)類似于多任務(wù)學(xué)習(xí)的問題設(shè)定。

議題8

零樣本學(xué)習(xí)中,輔助信息(屬性,詞向量,文本描述等)未來的發(fā)展趨勢是怎樣的?

付彥偉:無論圖像識別、自然語言處理還是其他領(lǐng)域,都可能會存在零樣本學(xué)習(xí)的問題。屬性和詞向量也有很多缺點(diǎn),比如多義性,你說apple是apple公司還水果apple,這本身就有歧義性。

何旭明:如果利用這些輔助信息其中的內(nèi)在關(guān)聯(lián)建立起信息之間的聯(lián)系,就可能是一種有結(jié)構(gòu)的知識圖譜。換個(gè)角度,因?yàn)檫@些屬性詞向量,就是知識表達(dá)的一個(gè)具體體現(xiàn),而背后的應(yīng)該是整個(gè)的一個(gè)知識體系。

議題9

可解釋性學(xué)習(xí)能否促進(jìn)零樣本學(xué)習(xí)的發(fā)展?

馬占宇:我先打一個(gè)比方,可能不太恰當(dāng)。在信號處理領(lǐng)域里,我們接受到的是信號,然后從中獲取信息,最后又把信息提煉成知識,這個(gè)是不同層次,不同內(nèi)涵的事情。當(dāng)然對于我們做視覺任務(wù)來說,也許就是圖像中尋找一些顯著區(qū)域,然后在該區(qū)域搜集某些特征、目標(biāo)。因此,從這個(gè)角度講,可解釋性學(xué)習(xí)對零樣本的發(fā)展是有幫助的,但是目前如何促進(jìn)以及結(jié)合知識,我覺得還是一個(gè)比較有挑戰(zhàn)或者開放的問題。

王瑞平:模型的可解釋性肯定能促進(jìn)零樣本學(xué)習(xí)的發(fā)展,零樣本學(xué)習(xí)之所以能做,就是因?yàn)槟軌蛉ソ㈩悇e之間的關(guān)聯(lián),把所謂的已知類的語義信息遷移到未知類別上面。

類別通過什么關(guān)聯(lián)的呢?其實(shí)類別背后的根本是一些概念的組合,比如有沒有四條腿、皮毛、何種顏色等概念。那么如果能夠從已有分類模型中學(xué)習(xí)出來樣本和類別間的因果關(guān)系,并知道類別之間的差異何在,以及模型與概念的對應(yīng)關(guān)系,試圖去解決零樣本和小樣本之間的問題,就能追溯到可遷移的根本所在。

付彥偉:深度學(xué)習(xí)的可解釋性可能更側(cè)重于特征的描述,零樣本學(xué)習(xí)最開始的一些工作,其實(shí)一直都是以可解釋性這個(gè)思路去做,就是把X映射到一個(gè)Y,Y是H的空間,后來我們又通過這種語義的可解釋性來做零樣本學(xué)習(xí)。如果單純地只是深度學(xué)習(xí)特征的可解釋性,就相當(dāng)于怎么去更好地提取X,由X去構(gòu)造零樣本學(xué)習(xí).。

小結(jié)

正所謂“巧婦難為無米之炊”,在使用深度學(xué)習(xí)這一工具解決實(shí)際問題時(shí),難免會遇到樣本不足的情況。而受人類快速學(xué)習(xí)能力的啟發(fā),研究人員希望機(jī)器學(xué)習(xí)模型能夠在習(xí)得一定類別數(shù)據(jù)后,只需少量樣本就可以學(xué)習(xí)新的類別,這就是小樣本學(xué)習(xí)(Few-shot Learning)要解決的問題。

“樣本量與特征維度的大小關(guān)系“、”樣本與其他類別的區(qū)分度”等因素,可能和大小樣本的界定有緊密關(guān)聯(lián)。小樣本學(xué)習(xí)可以同專家系統(tǒng)、自然語言處理等領(lǐng)域融合,并借助大樣本上的數(shù)據(jù)積累和一些反饋機(jī)制自然過渡到大樣本學(xué)習(xí)。雖然小樣本學(xué)習(xí)是人類學(xué)習(xí)的一個(gè)特長,但即便是人類,其本質(zhì)上的學(xué)習(xí)也是基于大樣本的,它包括漫長的進(jìn)化過程和多模態(tài)共生信息的影響,人類的“舉一反三”依舊是基于大數(shù)據(jù)和知識的轉(zhuǎn)化問題。因此,通過引入知識來彌補(bǔ)小樣本的數(shù)據(jù)不足是一個(gè)較為公認(rèn)的趨勢。人類手工標(biāo)注或者提取自大數(shù)據(jù)的語義描述、特定領(lǐng)域的知識體系都是可利用的“知識”。在實(shí)際應(yīng)用中,小樣本和數(shù)據(jù)不平衡往往是共生的,通過數(shù)據(jù)增廣、相似類別之間的知識遷移、數(shù)據(jù)合成、結(jié)構(gòu)化的知識圖譜、域自適應(yīng)學(xué)習(xí)、借助模型的可解性等策略可提升小樣本學(xué)習(xí)性能。

-

算法

+關(guān)注

關(guān)注

23文章

4612瀏覽量

92901 -

小樣本

+關(guān)注

關(guān)注

0文章

7瀏覽量

6823 -

深度學(xué)習(xí)

+關(guān)注

關(guān)注

73文章

5503瀏覽量

121170

原文標(biāo)題:小樣本學(xué)習(xí),路在何方?【VALSE Webinar】

文章出處:【微信號:deeplearningclass,微信公眾號:深度學(xué)習(xí)大講堂】歡迎添加關(guān)注!文章轉(zhuǎn)載請注明出處。

發(fā)布評論請先 登錄

相關(guān)推薦

NVIDIA探討自動駕駛汽車安全問題

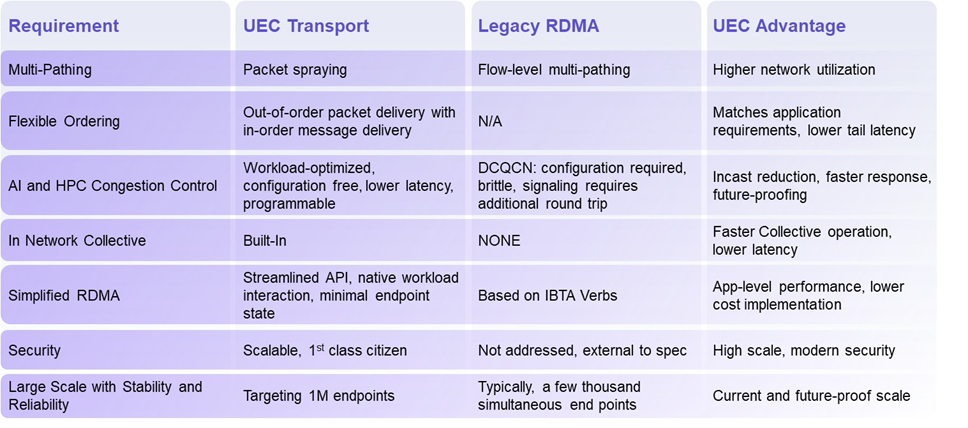

揭秘超以太網(wǎng)聯(lián)盟(UEC)1.0 規(guī)范最新進(jìn)展(2024Q4)

Qorvo在射頻和電源管理領(lǐng)域的最新進(jìn)展

小鵬汽車圖靈芯片及L4自動駕駛新進(jìn)展

芯片和封裝級互連技術(shù)的最新進(jìn)展

高燃回顧|第三屆OpenHarmony技術(shù)大會精彩瞬間

5G新通話技術(shù)取得新進(jìn)展

神經(jīng)網(wǎng)絡(luò)優(yōu)化算法有哪些

廣東的5G-A、信號升格和低空經(jīng)濟(jì),又有新進(jìn)展!

百度首席技術(shù)官王海峰解讀文心大模型的關(guān)鍵技術(shù)和最新進(jìn)展

四個(gè)50億+,多個(gè)半導(dǎo)體項(xiàng)目最新進(jìn)展!

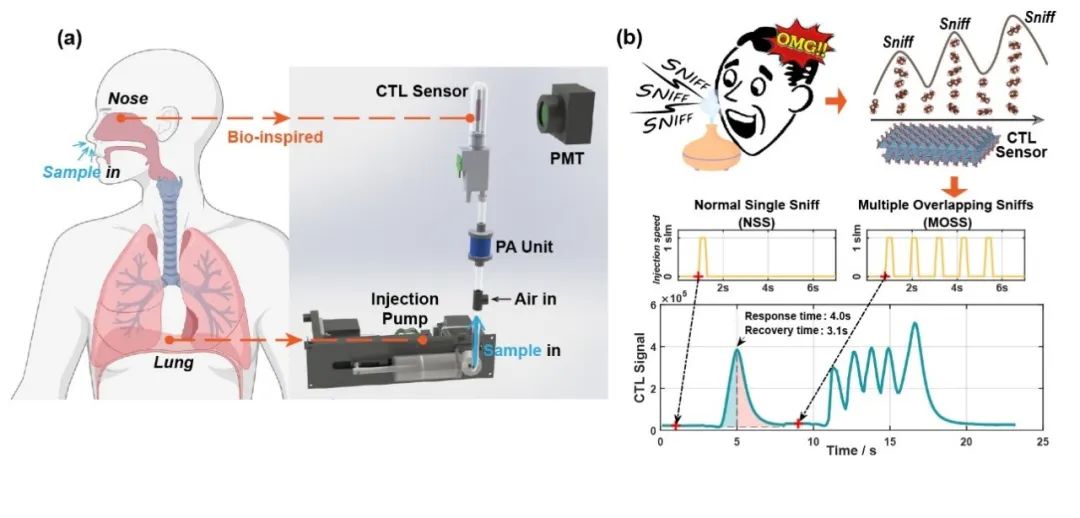

清華大學(xué)在電子鼻傳感器仿生嗅聞方向取得新進(jìn)展

答疑解惑探討小樣本學(xué)習(xí)的最新進(jìn)展

答疑解惑探討小樣本學(xué)習(xí)的最新進(jìn)展

評論