商湯科技CVPR 2020錄用論文在多個領(lǐng)域?qū)崿F(xiàn)突破,包括:對抗式生成模型、三維點(diǎn)云理解與分析、訓(xùn)練加速與模型量化、視頻理解與分析、網(wǎng)絡(luò)結(jié)構(gòu)搜索等。以下為商湯及商湯聯(lián)合實(shí)驗(yàn)室入選CVPR 2020的代表性論文。

▎研究方向:對抗式生成模型

代表性論文:《對人臉生成模型的隱空間可解釋性分析》鏈接:https://arxiv.org/abs/1907.10786

近年來,對抗生成網(wǎng)絡(luò)(GAN)的快速發(fā)展極大地增強(qiáng)了圖像生成的質(zhì)量,也因此得到了越來越廣泛的應(yīng)用。越來越多基于GAN的模型被提出來提高生成質(zhì)量以及訓(xùn)練穩(wěn)定性,但是對于生成模型的可解釋性還鮮有研究。

本文以人臉生成模型為例,對GAN的隱空間進(jìn)行了深入分析,目標(biāo)在于理解GAN是如何將一個隨機(jī)噪聲轉(zhuǎn)化為一張高質(zhì)量圖片的。本文提出了一種簡單而通用的技術(shù)InterFaceGAN,用于在潛在空間中進(jìn)行語義人臉編輯,可控制姿勢以及其他面部屬性,例如性別、年齡、眼鏡等,還能夠糾正GAN造成的偽影。

代表性論文:《ACGPN:基于圖像的自適應(yīng)生成保留虛擬換裝》鏈接:https://arxiv.org/abs/2003.05863

本文關(guān)注基于圖像的虛擬換裝任務(wù)。現(xiàn)有方法取得了很多突破但仍然存在很大問題:(1)人物的肢體仍然是模糊的;(2)對于下裝很難做到清楚的保留;(3)衣服的紋理容易產(chǎn)生過度形變。

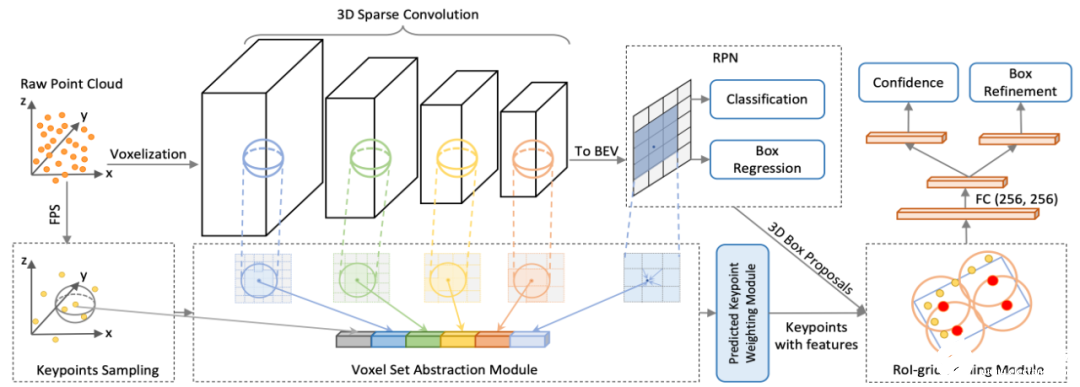

為此本文利用一種語義敏感的方法,自適應(yīng)的判斷哪部分圖像是應(yīng)該保留的,解決了現(xiàn)有方法中無法對人物肢體與衣服有遮擋的情況的建模,極大程度地降低了生成結(jié)果中的偽影以及模糊細(xì)節(jié);并通過引入仿射變換的共線性等性質(zhì),對變形衣服中的薄板樣條插值變換起到約束,使得Logo和花紋不易扭曲變形。 ▎研究方向:三維點(diǎn)云理解與分析 代表性論文:《PV-RCNN: 基于Point-Voxel點(diǎn)云特征深度融合的3D物體檢測算法》鏈接:https://arxiv.org/abs/1912.13192

本文關(guān)注基于點(diǎn)云數(shù)據(jù)的三維物體檢測任務(wù)。文章提出了一個高性能的3D物體檢測框架PV-RCNN,其通過構(gòu)造Set Abstraction特征抽象操作將基于Point與Voxel的點(diǎn)云特征提取算法分別在Voxel-to-Keypoint階段和Keypoint-to-RoIGrid 階段深度融合,使其同時擁有可變感受野、精確的點(diǎn)云位置信息以及高召回率,從而有效提升3D物體檢測的性能。

實(shí)驗(yàn)部分,PV-RCNN分別在競爭激烈的自動駕駛數(shù)據(jù)集KITTI以及更大規(guī)模的Waymo數(shù)據(jù)集上得到了驗(yàn)證。在KITTI數(shù)據(jù)集的3D物體檢測榜Car類別上,PV-RCNN大幅領(lǐng)先其他所有算法,在三個難度上均取得了第一名。在更大規(guī)模的Waymo數(shù)據(jù)集上,PV-RCNN同樣在所有難度以及不同距離上超越了現(xiàn)有算法,最高mAP增幅達(dá)近7個點(diǎn)。

▎研究方向:訓(xùn)練加速與模型量化

代表性論文:《用于加速卷積神經(jīng)網(wǎng)絡(luò)訓(xùn)練過程INT8訓(xùn)練技術(shù)》鏈接//arxiv.org/abs/1912.12607

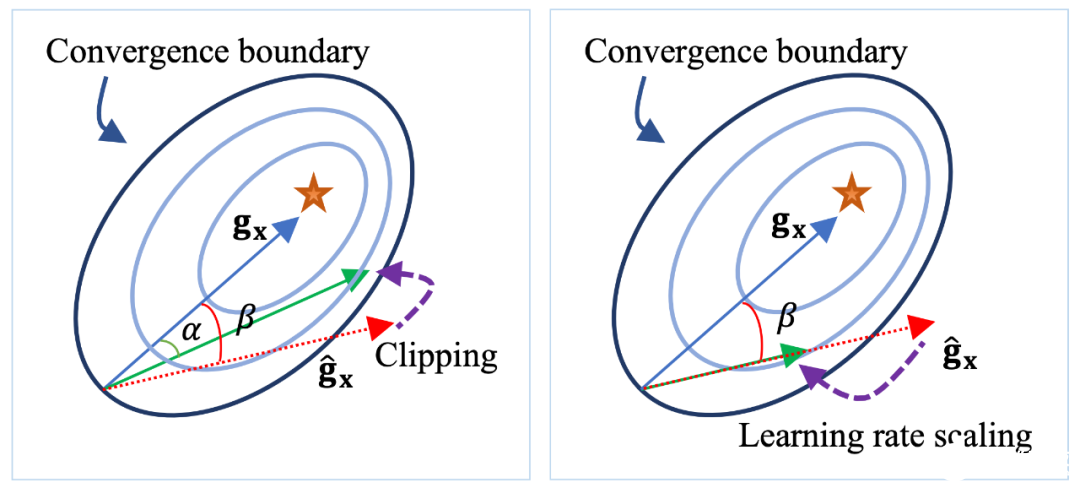

卷積神經(jīng)網(wǎng)絡(luò)訓(xùn)練過程需要耗費(fèi)大量的計(jì)算資源和時間,而各種深度學(xué)習(xí)硬件都提供非常高效的INT8計(jì)算支持。當(dāng)把INT8計(jì)算應(yīng)用到訓(xùn)練中同時加速網(wǎng)絡(luò)的前傳和反傳過程時,梯度的獨(dú)特分布給量化訓(xùn)練帶來了極大挑戰(zhàn)。

為了解決梯度量化帶來的精度損失,論文進(jìn)行了量化訓(xùn)練收斂穩(wěn)定性的理論分析并基于此提出了“誤差敏感的學(xué)習(xí)率調(diào)節(jié)”和“基于方向自適應(yīng)的梯度截?cái)唷狈椒ǎ瑢蓚€方法在圖像分類數(shù)據(jù)集ImageNet、CIFAR和目標(biāo)檢測數(shù)據(jù)集PASCAL VOC、COCO上進(jìn)行實(shí)驗(yàn),均取得了極少的精度損失。

實(shí)驗(yàn)中也驗(yàn)證了該方法對Inception、MobileNet等不同網(wǎng)絡(luò)結(jié)構(gòu)的通用性。為了保證更高的加速比,論文還提出使用周期更新、量化卷積融合等技術(shù)來減少量化操作帶來的時間開銷。通過在GTX1080TI上實(shí)測,可以提升22%的訓(xùn)練過程。

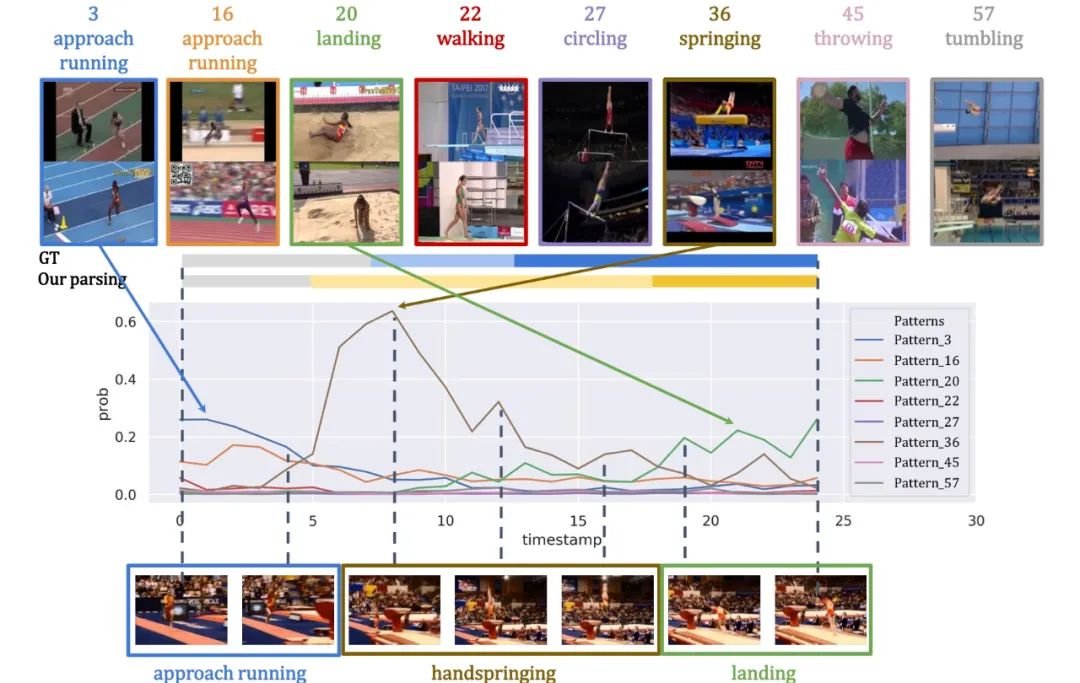

研究方向:視頻理解與分析 代表性論文:《TAPOS: 基于時序動作解析理解動作內(nèi)部和不同動作間的語義》

動作理解是計(jì)算機(jī)視覺領(lǐng)域的核心問題之一,也是許多其他任務(wù)的基石,如智能視頻檢索,基于視覺的機(jī)器人學(xué)等。本文發(fā)現(xiàn),人本身對于動作序列中子動作模式的轉(zhuǎn)換是比較敏感的。

在這篇工作中,本文提出了一種時域解析器,可以挖掘人體動作中的子動作模式,并根據(jù)挖掘出的子動作模式對較復(fù)雜的動作序列進(jìn)行時域上的解析。這種時域解析器不但能對一個給定的動作序列進(jìn)行子動作邊界劃分,還可以找尋大量不同動作序列中相同的子動作模式。本文發(fā)現(xiàn),對較復(fù)雜動作序列良好的時域解析可以幫助提升一些較為高層的任務(wù)的準(zhǔn)確率,如動作識別等。

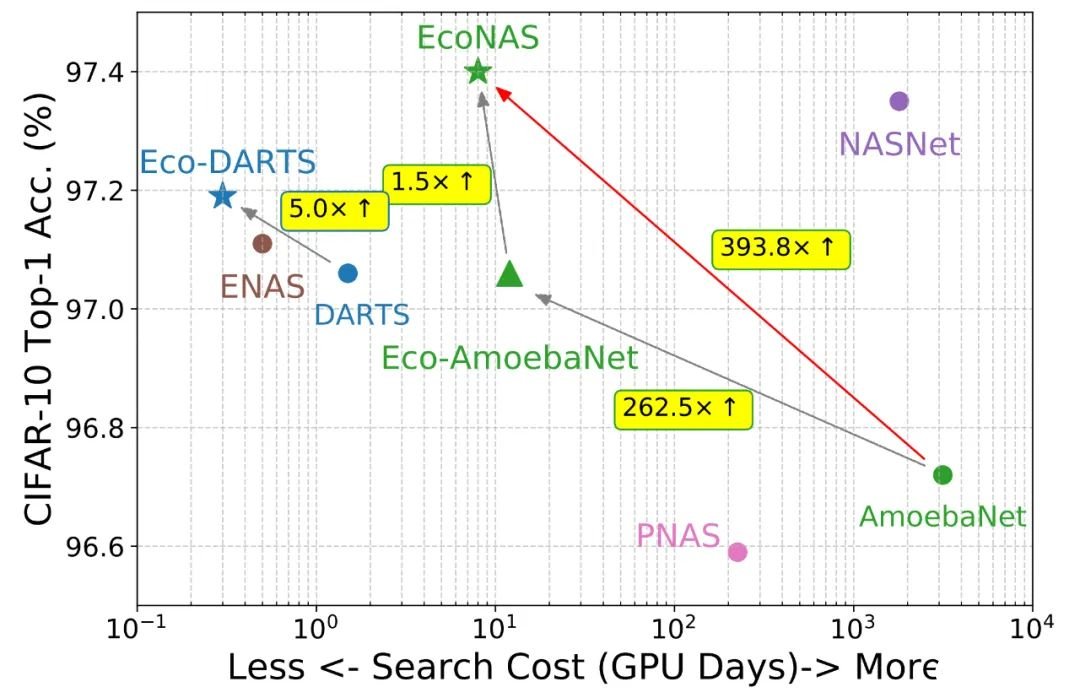

▎研究方向:網(wǎng)絡(luò)結(jié)構(gòu)搜索 代表性論文:《最高加速400倍,探索更好的網(wǎng)絡(luò)評價方法EcoNas》鏈接:https://arxiv.org/abs/2001.01233 許多網(wǎng)絡(luò)搜索算法需要耗費(fèi)大量的算力,而這些算力絕大多數(shù)集中在候選網(wǎng)絡(luò)(Candidate)的評估上。同樣地,由于算力的限制,候選網(wǎng)絡(luò)的評估往往需要在代理環(huán)境(Proxy)下進(jìn)行,如較短的訓(xùn)練周期數(shù)。雖然每個NAS算法都要用到代理環(huán)境,但是代理環(huán)境對子網(wǎng)絡(luò)評估的影響仍然是未知的。 本文的工作首次系統(tǒng)研究了不同代理參數(shù)對網(wǎng)絡(luò)評估的影響。作者發(fā)現(xiàn),使用更可靠的代理環(huán)境不僅可以極大壓縮計(jì)算量,也有助于搜到更好的模型。基于對代理環(huán)境的研究,作者提出了一個層次化的搜索方法,EcoNAS在將進(jìn)化算法加速400倍的同時,得到了更好的網(wǎng)絡(luò)結(jié)構(gòu)。

同樣地,作者發(fā)現(xiàn)可靠的代理環(huán)境也可以被用于其他搜索算法中,例如權(quán)重共享算法,在不影響精度的同時,使得搜索效率進(jìn)一步提升。

責(zé)任編輯:pj

-

3D

+關(guān)注

關(guān)注

9文章

2910瀏覽量

107876 -

GaN

+關(guān)注

關(guān)注

19文章

1964瀏覽量

74069 -

商湯科技

+關(guān)注

關(guān)注

8文章

518瀏覽量

36144

發(fā)布評論請先 登錄

相關(guān)推薦

基于梯度下降算法的三元鋰電池循環(huán)壽命預(yù)測

AI模型部署邊緣設(shè)備的奇妙之旅:如何實(shí)現(xiàn)手寫數(shù)字識別

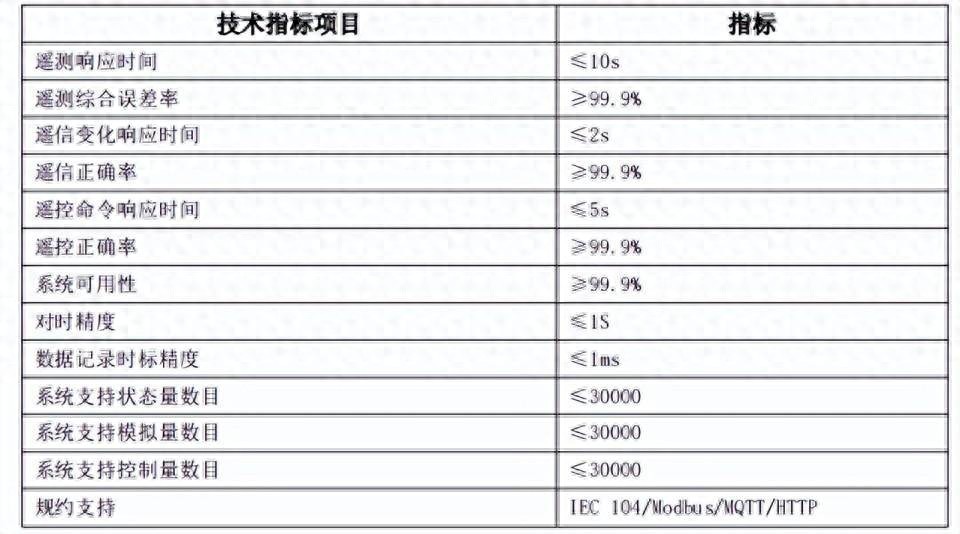

協(xié)調(diào)控制器在分布式光伏領(lǐng)域如何發(fā)揮最優(yōu)控制策略進(jìn)行調(diào)節(jié)控制?

AI給客戶服務(wù)帶來了哪些好處

訓(xùn)練RNN時如何避免梯度消失

激光打靶射擊訓(xùn)練系統(tǒng) DW-S602提供軍事訓(xùn)練效率

AI普及給嵌入式設(shè)計(jì)人員帶來新挑戰(zhàn)

存內(nèi)計(jì)算技術(shù)工具鏈——量化篇

大語言模型:原理與工程時間+小白初識大語言模型

【大語言模型:原理與工程實(shí)踐】大語言模型的基礎(chǔ)技術(shù)

JPEG LS算法局部梯度值計(jì)算原理

梯度的獨(dú)特分布給量化訓(xùn)練帶來了極大挑戰(zhàn)

梯度的獨(dú)特分布給量化訓(xùn)練帶來了極大挑戰(zhàn)

評論