程序員當(dāng)前解決與人工智能(AI)和自動駕駛汽車(AV)有關(guān)的道德問題的方式中存在一個很大的缺陷。也就是說,現(xiàn)有方法無法說明人們可能會嘗試使用AV來做一些不好的事情。

例如,假設(shè)有一輛無人駕駛的自動駕駛汽車,它即將撞上一輛載有五個人的汽車。它可以通過轉(zhuǎn)出道路來避免碰撞,但隨后會撞到行人。

在這種情況下,關(guān)于道德的大多數(shù)討論都集中在自動駕駛汽車的AI是自私的(保護(hù)車輛及其貨物)還是功利的(選擇傷害最少的人的行動)。但是,這種或/或道德方法會引發(fā)自身的問題。

北卡羅萊納州立大學(xué)科學(xué),技術(shù)與社會(STS)計劃的助理教授VeljkoDubljevi?說:“目前的道德和自動駕駛方法過于危險,過于簡單,道德判斷比這更為復(fù)雜。”概述了這個問題以及可能的前進(jìn)方向。“例如,如果車上的五個人是恐怖分子呢?又如果他們故意利用AI的程序殺死附近的行人或傷害他人呢?那么您可能希望自動駕駛汽車撞上五個人?乘客。

“換句話說,當(dāng)前用于解決AI和自動駕駛汽車道德問題的簡單方法不能說明惡意意圖。它應(yīng)該這樣做。”

作為替代方案,Dubljevi?建議使用所謂的Agent-Deed-Consequence(ADC)模型作為AI可以用來做出道德判斷的框架。ADC模型基于三個變量來判斷決策的道德性。

首先,代理人的意圖是好是壞?第二,行為或行動本身是好是壞?最后,結(jié)果或后果是好是壞?這種方法允許細(xì)微差別。

例如,大多數(shù)人會同意開紅燈是不好的。但是,如果您闖紅燈以避開急速的救護(hù)車怎么辦?如果開紅燈意味著您避免與那輛救護(hù)車相撞怎么辦?

Dubljevi?說:“ ADC模型將使我們更接近人類道德判斷中看到的靈活性和穩(wěn)定性,但AI中尚不存在這種靈活性和穩(wěn)定性。”“這就是我所說的穩(wěn)定和靈活。人類的道德判斷是穩(wěn)定的,因為大多數(shù)人會同意撒謊在道德上是有害的。但是,這是靈活的,因為大多數(shù)人也會同意為保護(hù)猶太人而撒謊來納粹的人在做道德上的事情。好。

“但是,盡管ADC模型為我們提供了一條前進(jìn)的道路,但仍需要進(jìn)行更多的研究,”Dubljevi?說。“我領(lǐng)導(dǎo)了有關(guān)哲學(xué)家和外行人如何進(jìn)行道德判斷的實驗性工作,其結(jié)果是有價值的。但是,該工作以書面形式給了人們信息。需要更多的人類道德判斷研究,而這需要更直接的交流手段,例如虛擬現(xiàn)實,如果我們想確認(rèn)我們先前的發(fā)現(xiàn)并在自動駕駛汽車中應(yīng)用它們,那么,在任何公認(rèn)的“道德”自動駕駛汽車開始與人定期分享道路之前,應(yīng)進(jìn)行駕駛模擬研究的嚴(yán)格測試。不幸的是,攻擊已變得越來越普遍,我們需要確保不會將AV技術(shù)濫用于邪惡目的。”

論文“致力于在自動駕駛汽車中實現(xiàn)道德判斷的ADC模型”已發(fā)表在《科學(xué)與工程倫理學(xué)》雜志上。

-

人工智能

+關(guān)注

關(guān)注

1791文章

47353瀏覽量

238791 -

自動駕駛

+關(guān)注

關(guān)注

784文章

13838瀏覽量

166548

發(fā)布評論請先 登錄

相關(guān)推薦

什么是具身智能?自動駕駛是具身智能嗎?

MEMS技術(shù)在自動駕駛汽車中的應(yīng)用

智能駕駛與自動駕駛的關(guān)系

人工智能的應(yīng)用領(lǐng)域有自動駕駛嗎

自動駕駛技術(shù)的典型應(yīng)用 自動駕駛技術(shù)涉及到哪些技術(shù)

Autobrains推出自動駕駛定位技術(shù)

《AI for Science:人工智能驅(qū)動科學(xué)創(chuàng)新》第一章人工智能驅(qū)動的科學(xué)創(chuàng)新學(xué)習(xí)心得

FPGA在自動駕駛領(lǐng)域有哪些優(yōu)勢?

FPGA在自動駕駛領(lǐng)域有哪些應(yīng)用?

人工智能駕駛技術(shù)包括哪些技術(shù)

深度學(xué)習(xí)在自動駕駛中的關(guān)鍵技術(shù)

未來已來,多傳感器融合感知是自動駕駛破局的關(guān)鍵

上海人工智能實驗室發(fā)布自動駕駛視頻生成模型GenAD

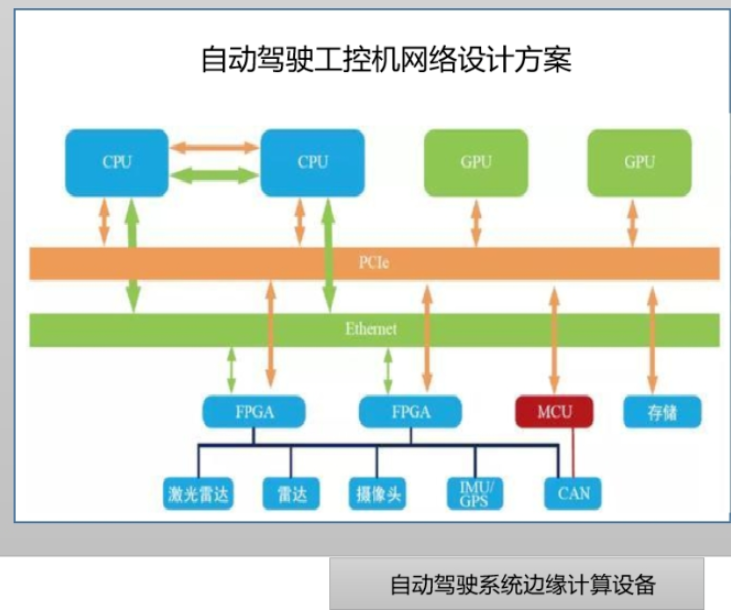

邊緣計算與自動駕駛系統(tǒng)如何結(jié)合

人工智能和自動駕駛汽車有關(guān)的道德問題的方式中存在一個很大的缺陷

人工智能和自動駕駛汽車有關(guān)的道德問題的方式中存在一個很大的缺陷

評論