周末在家無(wú)聊閑逛github,發(fā)現(xiàn)一個(gè)很有趣的開(kāi)源項(xiàng)目,作者用手繪圖的方式講解了機(jī)器學(xué)習(xí)模型構(gòu)建的全流程,邏輯清晰、生動(dòng)形象。同時(shí),作者也對(duì)幾張圖進(jìn)行了詳細(xì)的講解,學(xué)習(xí)之后,收獲很多,于是將其翻譯下來(lái),和大家一起學(xué)習(xí)。

地址:https://github.com/dataprofessor/infographic

全文如下:

感覺(jué)學(xué)習(xí)數(shù)據(jù)科學(xué)枯燥無(wú)味,那如何能讓學(xué)習(xí)數(shù)據(jù)科學(xué)變得有趣而簡(jiǎn)單呢?帶著這個(gè)目標(biāo),我開(kāi)始在iPad上涂鴉建立機(jī)器學(xué)習(xí)模型所需的流程。經(jīng)過(guò)幾天的努力,上圖所示的信息圖就是我的成果,內(nèi)容已經(jīng)被發(fā)布在GitHub上。

1. 數(shù)據(jù)集

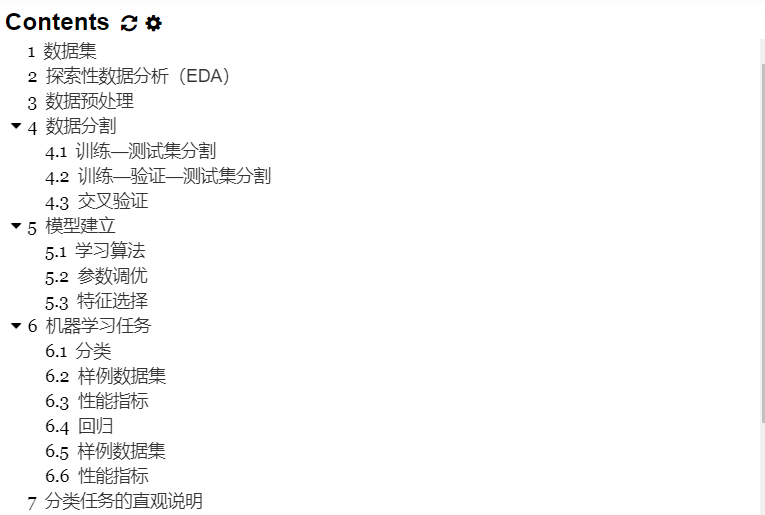

數(shù)據(jù)集是你構(gòu)建機(jī)器學(xué)習(xí)模型歷程中的起點(diǎn)。簡(jiǎn)單來(lái)說(shuō),數(shù)據(jù)集本質(zhì)上是一個(gè)M×N矩陣,其中M代表列(特征),N代表行(樣本)。

列可以分解為X和Y,首先,X是幾個(gè)類似術(shù)語(yǔ)的同義詞,如特征、獨(dú)立變量和輸入變量。其次,Y也是幾個(gè)術(shù)語(yǔ)的同義詞,即類別標(biāo)簽、因變量和輸出變量。

圖1. 數(shù)據(jù)集的卡通插圖

應(yīng)該注意的是,一個(gè)可以用于監(jiān)督學(xué)習(xí)的數(shù)據(jù)集(可以執(zhí)行回歸或分類)將同時(shí)包含X和Y,而一個(gè)可以用于無(wú)監(jiān)督學(xué)習(xí)的數(shù)據(jù)集將只有X。

此外,如果Y包含定量值,那么數(shù)據(jù)集(由X和Y組成)可以用于回歸任務(wù),而如果Y包含定性值,那么數(shù)據(jù)集(由X和Y組成)可以用于分類任務(wù)。

2. 探索性數(shù)據(jù)分析(EDA)

進(jìn)行探索性數(shù)據(jù)分析(EDA)是為了獲得對(duì)數(shù)據(jù)的初步了解。在一個(gè)典型的數(shù)據(jù)科學(xué)項(xiàng)目中,我會(huì)做的第一件事就是通過(guò)執(zhí)行EDA來(lái) "盯住數(shù)據(jù)",以便更好地了解數(shù)據(jù)。

我通常使用的三大EDA方法包括:

描述性統(tǒng)計(jì):平均數(shù)、中位數(shù)、模式、標(biāo)準(zhǔn)差。

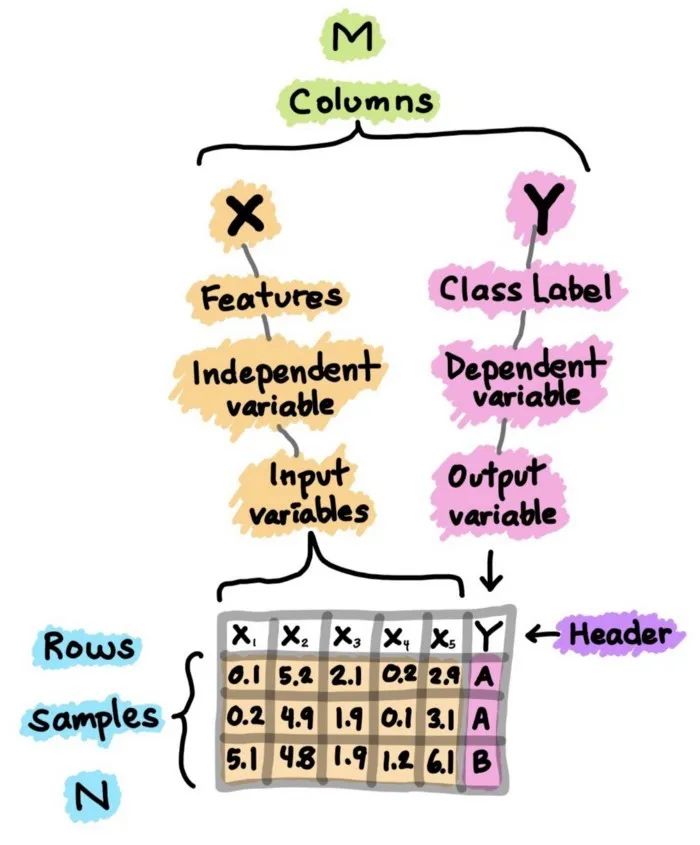

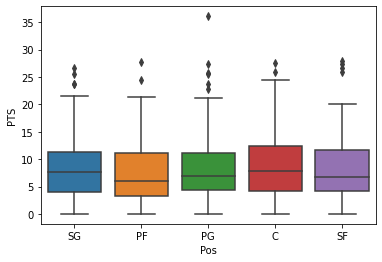

數(shù)據(jù)可視化:熱力圖(辨別特征內(nèi)部相關(guān)性)、箱形圖(可視化群體差異)、散點(diǎn)圖(可視化特征之間的相關(guān)性)、主成分分析(可視化數(shù)據(jù)集中呈現(xiàn)的聚類分布)等。

數(shù)據(jù)整形:對(duì)數(shù)據(jù)進(jìn)行透視、分組、過(guò)濾等。

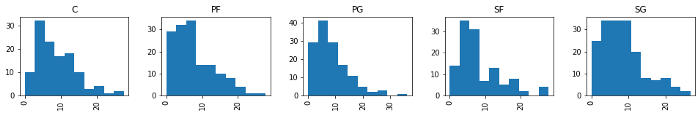

圖2. NBA球員統(tǒng)計(jì)數(shù)據(jù)的箱形圖示例

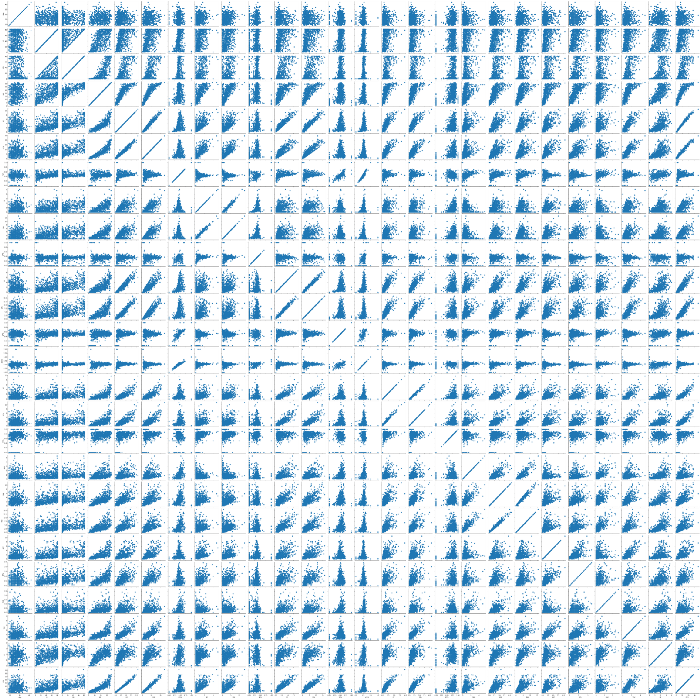

圖3. NBA球員統(tǒng)計(jì)數(shù)據(jù)的相關(guān)熱力圖示例

圖4. NBA球員統(tǒng)計(jì)數(shù)據(jù)的直方圖示例

圖5. NBA球員統(tǒng)計(jì)數(shù)據(jù)的散布圖示例

3. 數(shù)據(jù)預(yù)處理

數(shù)據(jù)預(yù)處理(又稱數(shù)據(jù)清理、數(shù)據(jù)整理或數(shù)據(jù)處理)是指對(duì)數(shù)據(jù)進(jìn)行各種檢查和審查的過(guò)程,以糾正缺失值、拼寫(xiě)錯(cuò)誤、使數(shù)值正常化/標(biāo)準(zhǔn)化以使其具有可比性、轉(zhuǎn)換數(shù)據(jù)(如對(duì)數(shù)轉(zhuǎn)換)等問(wèn)題。

"Garbage in, Garbage out."

正如上面的引言所說(shuō),數(shù)據(jù)的質(zhì)量將對(duì)生成模型的質(zhì)量產(chǎn)生很大的影響。因此,為了達(dá)到最高的模型質(zhì)量,應(yīng)該在數(shù)據(jù)預(yù)處理階段花費(fèi)大量精力。一般來(lái)說(shuō),數(shù)據(jù)預(yù)處理可以輕松地占到數(shù)據(jù)科學(xué)項(xiàng)目所花費(fèi)時(shí)間的80%,而實(shí)際的模型建立階段和后續(xù)的模型分析僅占到剩余的20%。

4. 數(shù)據(jù)分割

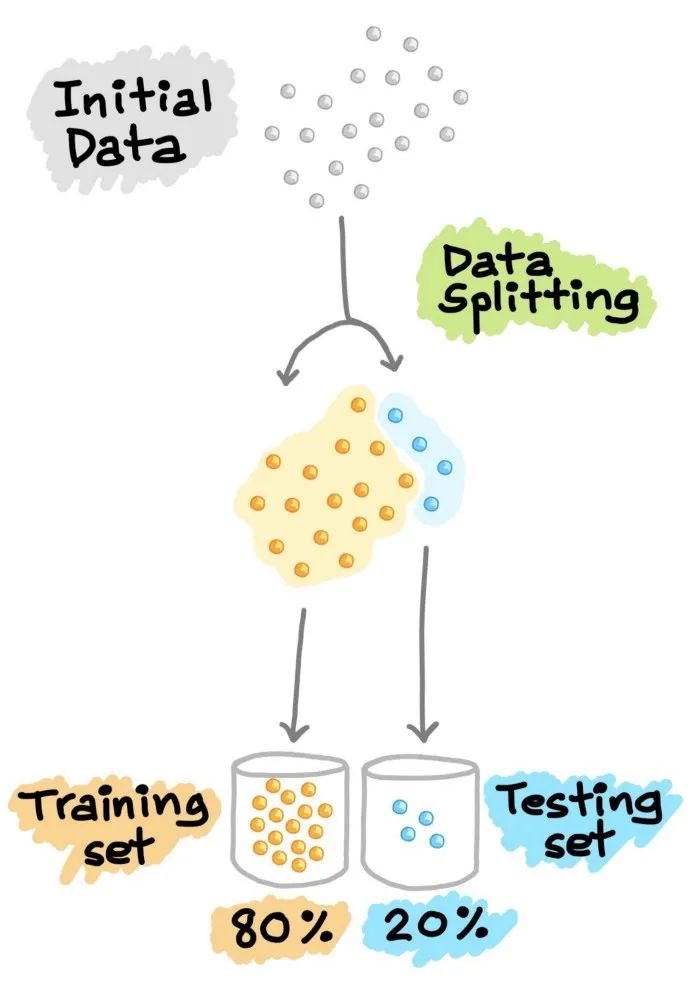

4.1 訓(xùn)練--測(cè)試集分割

在機(jī)器學(xué)習(xí)模型的開(kāi)發(fā)過(guò)程中,希望訓(xùn)練好的模型能在新的、未見(jiàn)過(guò)的數(shù)據(jù)上表現(xiàn)良好。為了模擬新的、未見(jiàn)過(guò)的數(shù)據(jù),對(duì)可用數(shù)據(jù)進(jìn)行數(shù)據(jù)分割,從而將其分割成2部分(有時(shí)稱為訓(xùn)練—測(cè)試分割)。特別是,第一部分是較大的數(shù)據(jù)子集,用作訓(xùn)練集(如占原始數(shù)據(jù)的80%),第二部分通常是較小的子集,用作測(cè)試集(其余20%的數(shù)據(jù))。需要注意的是,這種數(shù)據(jù)拆分只進(jìn)行一次。

接下來(lái),利用訓(xùn)練集建立預(yù)測(cè)模型,然后將這種訓(xùn)練好的模型應(yīng)用于測(cè)試集(即作為新的、未見(jiàn)過(guò)的數(shù)據(jù))上進(jìn)行預(yù)測(cè)。根據(jù)模型在測(cè)試集上的表現(xiàn)來(lái)選擇最佳模型,為了獲得最佳模型,還可以進(jìn)行超參數(shù)優(yōu)化。

圖6. 訓(xùn)練—測(cè)試集分割示意圖

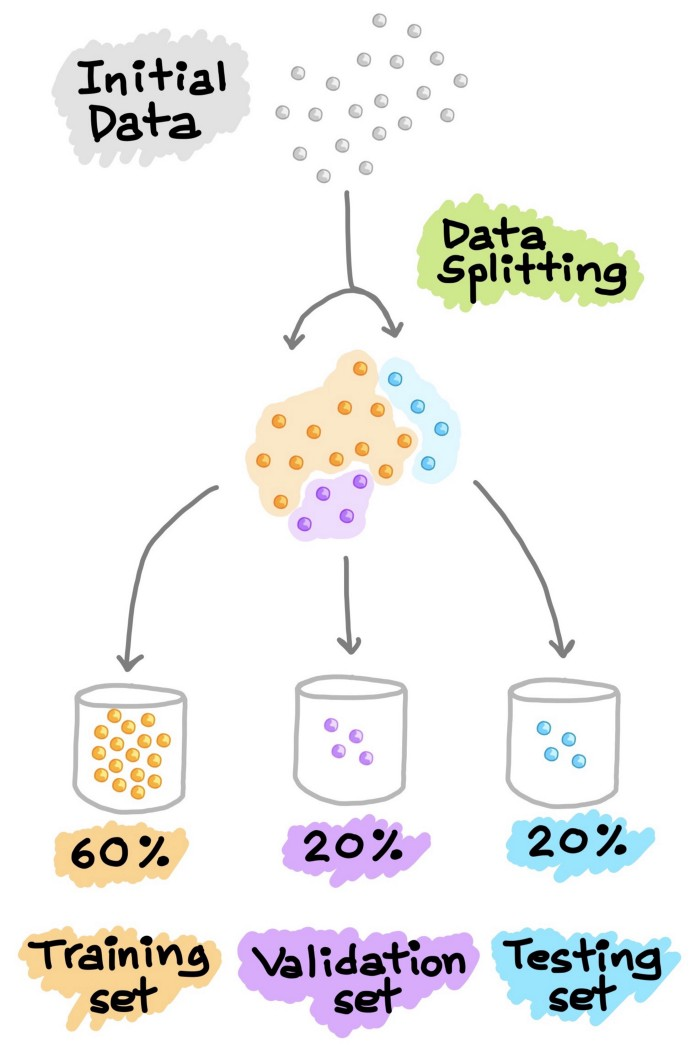

4.2 訓(xùn)練--驗(yàn)證--測(cè)試集分割

另一種常見(jiàn)的數(shù)據(jù)分割方法是將數(shù)據(jù)分割成3部分。(1) 訓(xùn)練集,(2) 驗(yàn)證集和(3) 測(cè)試集。與上面解釋的類似,訓(xùn)練集用于建立預(yù)測(cè)模型,同時(shí)對(duì)驗(yàn)證集進(jìn)行評(píng)估,據(jù)此進(jìn)行預(yù)測(cè),可以進(jìn)行模型調(diào)優(yōu)(如超參數(shù)優(yōu)化),并根據(jù)驗(yàn)證集的結(jié)果選擇性能最好的模型。正如我們所看到的,類似于上面對(duì)測(cè)試集進(jìn)行的操作,這里我們?cè)隍?yàn)證集上做同樣的操作。請(qǐng)注意,測(cè)試集不參與任何模型的建立和準(zhǔn)備。因此,測(cè)試集可以真正充當(dāng)新的、未知的數(shù)據(jù)。Google的《機(jī)器學(xué)習(xí)速成班》對(duì)這個(gè)話題進(jìn)行了更深入的處理。

圖7. 訓(xùn)練—驗(yàn)證—測(cè)試集分割示意圖

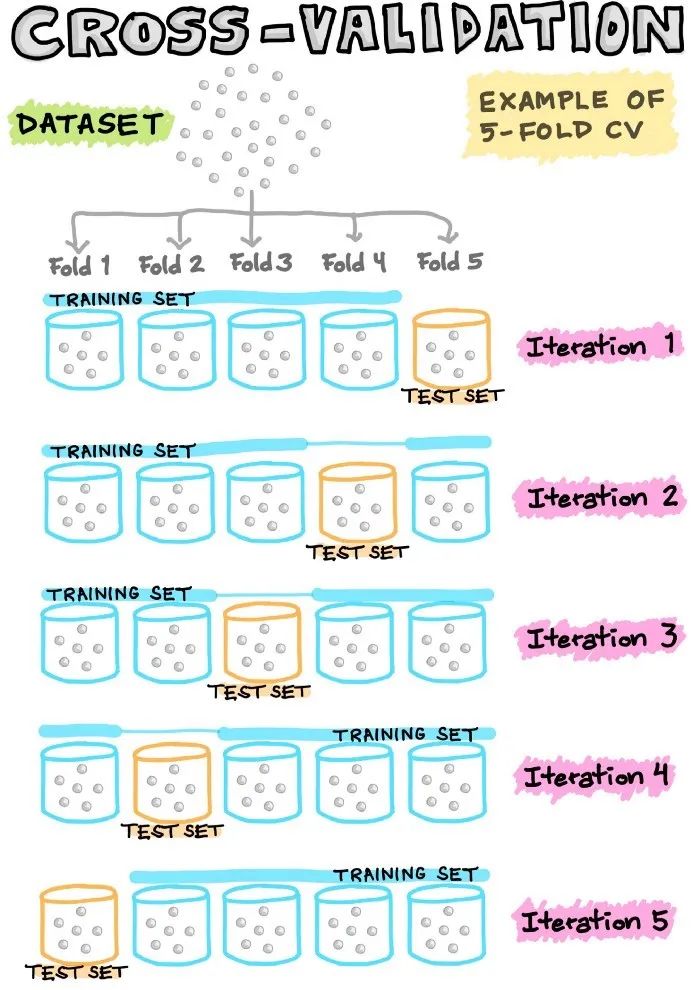

4.3 交叉驗(yàn)證

為了最經(jīng)濟(jì)地利用現(xiàn)有數(shù)據(jù),通常使用N倍交叉驗(yàn)證(CV),將數(shù)據(jù)集分割成N個(gè)折(即通常使用5倍或10倍CV)。在這樣的N倍CV中,其中一個(gè)折被留作測(cè)試數(shù)據(jù),而其余的折則被用作建立模型的訓(xùn)練數(shù)據(jù)。

例如,在5倍CV中,有1個(gè)折被省略,作為測(cè)試數(shù)據(jù),而剩下的4個(gè)被集中起來(lái),作為建立模型的訓(xùn)練數(shù)據(jù)。然后,將訓(xùn)練好的模型應(yīng)用于上述遺漏的折(即測(cè)試數(shù)據(jù))。這個(gè)過(guò)程反復(fù)進(jìn)行,直到所有的折都有機(jī)會(huì)被留出作為測(cè)試數(shù)據(jù)。因此,我們將建立5個(gè)模型(即5個(gè)折中的每個(gè)折都被留出作為測(cè)試集),其中5個(gè)模型中的每個(gè)模型都包含相關(guān)的性能指標(biāo)(我們將在接下來(lái)的部分討論)。最后,度量(指標(biāo))值是基于5個(gè)模型計(jì)算出的平均性能。

圖8. 交叉驗(yàn)證示意圖

在N等于數(shù)據(jù)樣本數(shù)的情況下,我們稱這種留一的交叉驗(yàn)證。在這種類型的CV中,每個(gè)數(shù)據(jù)樣本代表一個(gè)折。例如,如果N等于30,那么就有30個(gè)折(每個(gè)折有1個(gè)樣本)。在任何其他N折CV中,1個(gè)折點(diǎn)被留出作為測(cè)試集,而剩下的29個(gè)折點(diǎn)被用來(lái)建立模型。接下來(lái),將建立的模型應(yīng)用于對(duì)留出的折進(jìn)行預(yù)測(cè)。與之前一樣,這個(gè)過(guò)程反復(fù)進(jìn)行,共30次;計(jì)算30個(gè)模型的平均性能,并將其作為CV性能指標(biāo)。

5. 模型建立

現(xiàn)在,有趣的部分來(lái)了,我們終于可以使用精心準(zhǔn)備的數(shù)據(jù)來(lái)建立模型了。根據(jù)目標(biāo)變量(通常稱為Y變量)的數(shù)據(jù)類型(定性或定量),我們要建立一個(gè)分類(如果Y是定性的)或回歸(如果Y是定量的)模型。

5.1 學(xué)習(xí)算法

機(jī)器學(xué)習(xí)算法可以大致分為以下三種類型之一:

監(jiān)督學(xué)習(xí):是一種機(jī)器學(xué)習(xí)任務(wù),建立輸入X和輸出Y變量之間的數(shù)學(xué)(映射)關(guān)系。這樣的X、Y對(duì)構(gòu)成了用于建立模型的標(biāo)簽數(shù)據(jù),以便學(xué)習(xí)如何從輸入中預(yù)測(cè)輸出。

無(wú)監(jiān)督學(xué)習(xí):是一種只利用輸入X變量的機(jī)器學(xué)習(xí)任務(wù)。這種 X 變量是未標(biāo)記的數(shù)據(jù),學(xué)習(xí)算法在建模時(shí)使用的是數(shù)據(jù)的固有結(jié)構(gòu)。

強(qiáng)化學(xué)習(xí):是一種決定下一步行動(dòng)方案的機(jī)器學(xué)習(xí)任務(wù),它通過(guò)試錯(cuò)學(xué)習(xí)來(lái)實(shí)現(xiàn)這一目標(biāo),努力使回報(bào)最大化。

5.2 參數(shù)調(diào)優(yōu)

超參數(shù)本質(zhì)上是機(jī)器學(xué)習(xí)算法的參數(shù),直接影響學(xué)習(xí)過(guò)程和預(yù)測(cè)性能。由于沒(méi)有 "一刀切 "的超參數(shù)設(shè)置,可以普遍適用于所有數(shù)據(jù)集,因此需要進(jìn)行超參數(shù)優(yōu)化(也稱為超參數(shù)調(diào)整或模型調(diào)整)。

我們以隨機(jī)森林為例。在使用randomForest R包時(shí),通常會(huì)對(duì)兩個(gè)常見(jiàn)的超參數(shù)進(jìn)行優(yōu)化,其中包括mtry和ntree參數(shù)(這對(duì)應(yīng)于scikit-learnPython庫(kù)中RandomForestClassifier()和RandomForestRegressor()函數(shù)中的nestimators和maxfeatures)。mtry(maxfeatures)代表在每次分裂時(shí)作為候選變量隨機(jī)采樣的變量數(shù)量,而ntree(nestimators)代表要生長(zhǎng)的樹(shù)的數(shù)量。 另一種流行的機(jī)器學(xué)習(xí)算法是支持向量機(jī)。需要優(yōu)化的超參數(shù)是徑向基函數(shù)(RBF)內(nèi)核的C參數(shù)和gamma參數(shù)(即線性內(nèi)核只有C參數(shù);多項(xiàng)式內(nèi)核的C和指數(shù))。C參數(shù)是一個(gè)限制過(guò)擬合的懲罰項(xiàng),而gamma參數(shù)則控制RBF核的寬度。如上所述,調(diào)優(yōu)通常是為了得出超參數(shù)的最佳值集,盡管如此,也有一些研究旨在為C參數(shù)和gamma參數(shù)找到良好的起始值(Alvarsson等人,2014)。

地址:https://pubs.acs.org/doi/10.1021/ci500344v

5.3 特征選擇

顧名思義,特征選擇從字面上看就是從最初的大量特征中選擇一個(gè)特征子集的過(guò)程。除了實(shí)現(xiàn)高精度的模型外,機(jī)器學(xué)習(xí)模型構(gòu)建最重要的一個(gè)方面是獲得可操作的見(jiàn)解,為了實(shí)現(xiàn)這一目標(biāo),能夠從大量的特征中選擇出重要的特征子集非常重要。

特征選擇的任務(wù)本身就可以構(gòu)成一個(gè)全新的研究領(lǐng)域,在這個(gè)領(lǐng)域中,大量的努力都是為了設(shè)計(jì)新穎的算法和方法。從眾多可用的特征選擇算法中,一些經(jīng)典的方法是基于模擬退火和遺傳算法。除此之外,還有大量基于進(jìn)化算法(如粒子群優(yōu)化、蟻群優(yōu)化等)和隨機(jī)方法(如蒙特卡洛)的方法。

我們自己的研究小組也在對(duì)醛糖還原酶抑制劑的定量結(jié)構(gòu)—活性關(guān)系建模的研究中,探索了利用蒙特卡洛模擬進(jìn)行特征選擇的方法(Nantasenamat等,2014)。

地址:https://doi.org/10.1016/j.ejmech.2014.02.043

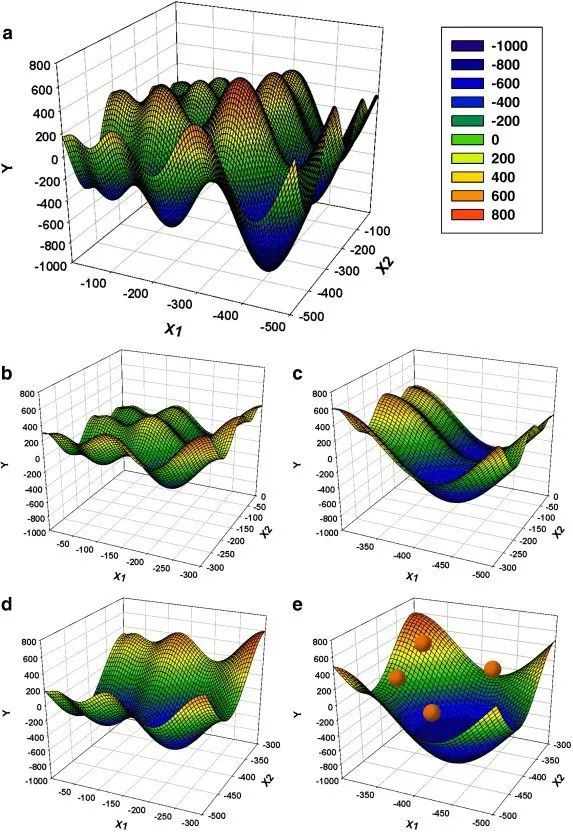

在《遺傳算法搜索空間拼接粒子群優(yōu)化作為通用優(yōu)化器》的工作中,我們還設(shè)計(jì)了一種基于結(jié)合兩種流行的進(jìn)化算法即遺傳算法和粒子群算法的新型特征選擇方法(Li等,2013)。

地址:https://doi.org/10.1016/j.chemolab.2013.08.009

圖9. 遺傳算法搜索空間拼接粒子群優(yōu)化(GA-SSS-PSO)方法的原理示意圖,用Schwefel函數(shù)在2維度上進(jìn)行說(shuō)明

"原搜索空間(a)x∈[-500,0]在每個(gè)維度上以2的固定間隔拼接成子空間(圖中一個(gè)維度等于一個(gè)橫軸)。這樣就得到了4個(gè)子空間(b-e),其中x在每個(gè)維度上的范圍是原始空間的一半。GA的每一個(gè)字符串都會(huì)編碼一個(gè)子空間的索引。然后,GA啟發(fā)式地選擇一個(gè)子空間(e),并在那里啟動(dòng)PSO(粒子顯示為紅點(diǎn))。PSO搜索子空間的全局最小值,最好的粒子適應(yīng)性作為編碼該子空間索引的GA字符串的適應(yīng)性。最后,GA進(jìn)行進(jìn)化,選擇一個(gè)新的子空間進(jìn)行探索。整個(gè)過(guò)程重復(fù)進(jìn)行,直到達(dá)到滿意的誤差水平。"

6. 機(jī)器學(xué)習(xí)任務(wù)

在監(jiān)督學(xué)習(xí)中,兩個(gè)常見(jiàn)的機(jī)器學(xué)習(xí)任務(wù)包括分類和回歸。

6.1 分類

一個(gè)訓(xùn)練有素的分類模型將一組變量(定量或定性)作為輸入,并預(yù)測(cè)輸出的類標(biāo)簽(定性)。下圖是由不同顏色和標(biāo)簽表示的三個(gè)類。每一個(gè)小的彩色球體代表一個(gè)數(shù)據(jù)樣本。

圖10. 多類別分類問(wèn)題的示意圖

三類數(shù)據(jù)樣本在二維中的顯示。上圖顯示的是數(shù)據(jù)樣本的假設(shè)分布。這種可視化圖可以通過(guò)執(zhí)行PCA分析并顯示前兩個(gè)主成分(PC)來(lái)創(chuàng)建;或者也可以選擇兩個(gè)變量的簡(jiǎn)單散點(diǎn)圖可視化。

6.1.1 樣例數(shù)據(jù)集

以企鵝數(shù)據(jù)集(Penguins Dataset)為例(最近提出作為大量使用的Iris數(shù)據(jù)集的替代數(shù)據(jù)集),我們將定量(喙長(zhǎng)、喙深、鰭長(zhǎng)和身體質(zhì)量)和定性(性別和島嶼)特征作為輸入,這些特征唯一地描述了企鵝的特征,并將其歸入三個(gè)物種類別標(biāo)簽(Adelie、Chinstrap或Gentoo)之一。該數(shù)據(jù)集由344行和8列組成。之前的分析顯示,該數(shù)據(jù)集包含333個(gè)完整的案例,其中11個(gè)不完整的案例中出現(xiàn)了19個(gè)缺失值。

圖11. 三個(gè)企鵝物種的類別標(biāo)簽(Chinstrap、Gentoo和Adelie)

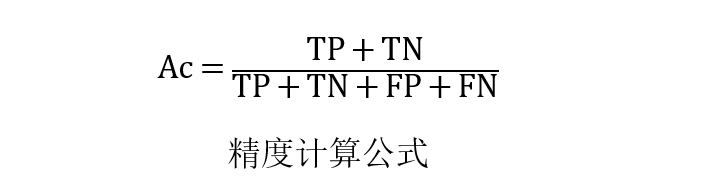

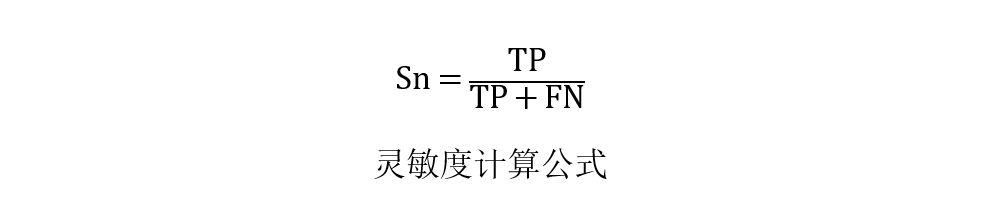

6.1.2 性能指標(biāo)

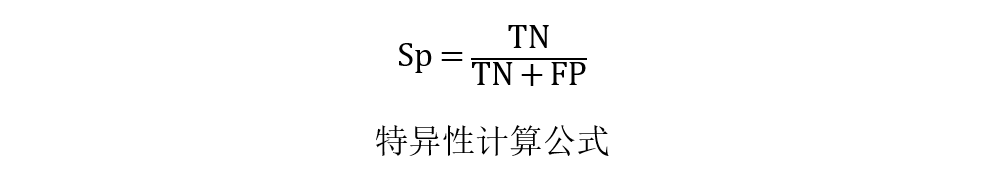

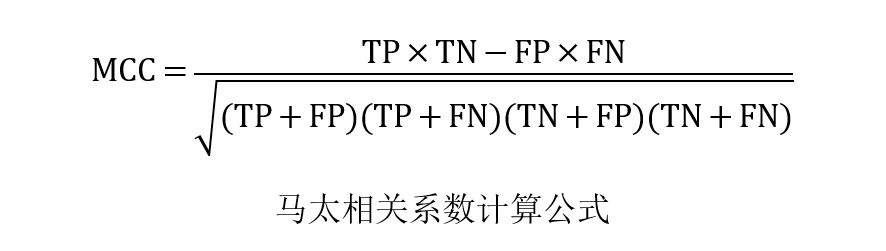

如何知道我們的模型表現(xiàn)好或壞?答案是使用性能指標(biāo),一些常見(jiàn)的評(píng)估分類性能的指標(biāo)包括準(zhǔn)確率(Ac)、靈敏度(Sn)、特異性(Sp)和馬太相關(guān)系數(shù)(MCC)。

其中TP、TN、FP和FN分別表示真陽(yáng)性、真陰性、假陽(yáng)性和假陰性的實(shí)例。應(yīng)該注意的是,MCC的范圍從-1到1,其中MCC為-1表示最壞的可能預(yù)測(cè),而值為1表示最好的可能預(yù)測(cè)方案。此外,MCC為0表示隨機(jī)預(yù)測(cè)。

6.2 回歸

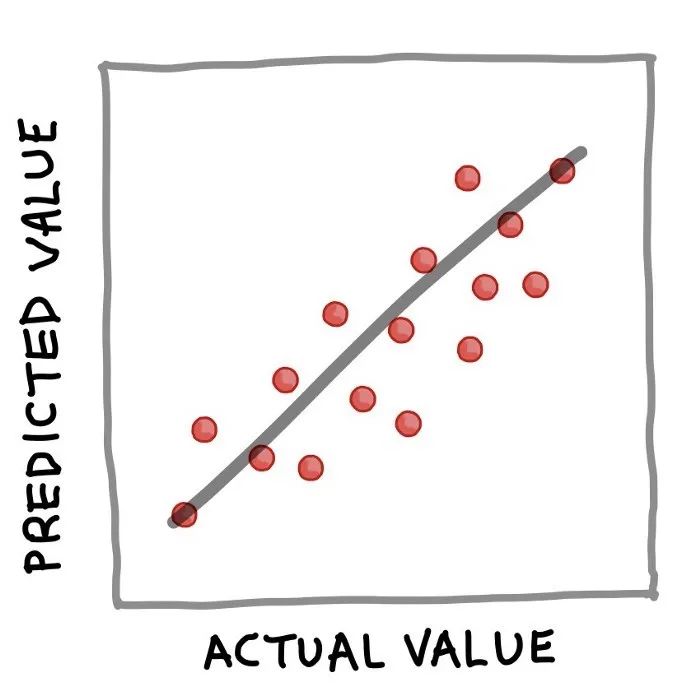

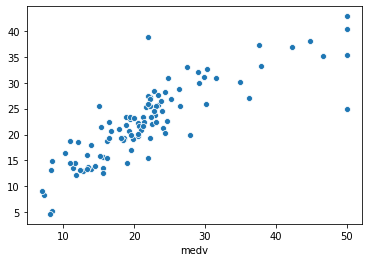

簡(jiǎn)而言之,可以通過(guò)以下簡(jiǎn)單等式很好地總結(jié)訓(xùn)練有素的回歸模型:Y = f(X)。其中,Y對(duì)應(yīng)量化輸出變量,X指輸入變量,f指計(jì)算輸出值作為輸入特征的映射函數(shù)(從訓(xùn)練模型中得到)。上面的回歸例子公式的實(shí)質(zhì)是,如果X已知,就可以推導(dǎo)出Y。一旦Y被計(jì)算出來(lái)(我們也可以說(shuō)是 "預(yù)測(cè)"),一個(gè)流行的可視化方式是將實(shí)際值與預(yù)測(cè)值做一個(gè)簡(jiǎn)單的散點(diǎn)圖,如下圖所示。

圖12. 實(shí)際值與預(yù)測(cè)值的簡(jiǎn)單散點(diǎn)圖

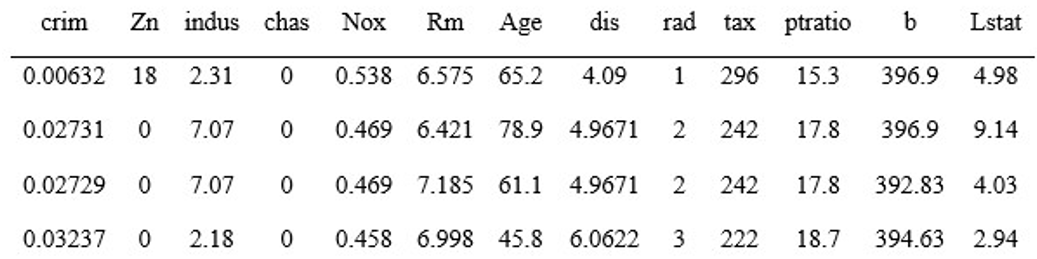

6.2.1 樣例數(shù)據(jù)集

波士頓住房數(shù)據(jù)集(Boston Housing Dataset)是數(shù)據(jù)科學(xué)教程中通常使用的一個(gè)熱門(mén)示例數(shù)據(jù)集。該數(shù)據(jù)集由506行和14列組成。為了簡(jiǎn)潔起見(jiàn),下面顯示的是標(biāo)題(顯示變量名稱)加上數(shù)據(jù)集的前4行。

在14列中,前13個(gè)變量被用作輸入變量,而房?jī)r(jià)中位數(shù)(medv)被用作輸出變量。可以看出,所有14個(gè)變量都包含了量化的數(shù)值,因此適合進(jìn)行回歸分析。我還在YouTube上做了一個(gè)逐步演示如何用Python建立線性回歸模型的視頻。

地址:https://youtu.be/R15LjD8aCzc

在視頻中,我首先向大家展示了如何讀取波士頓房屋數(shù)據(jù)集,將數(shù)據(jù)分離為X和Y矩陣,進(jìn)行80/20的數(shù)據(jù)拆分,利用80%的子集建立線性回歸模型,并應(yīng)用訓(xùn)練好的模型對(duì)20%的子集進(jìn)行預(yù)測(cè)。最后顯示了實(shí)際與預(yù)測(cè)medv值的性能指標(biāo)和散點(diǎn)圖。

圖13. 測(cè)試集的實(shí)際medv值與預(yù)測(cè)medv值(20%子集)的散點(diǎn)圖。

6.2.2 性能指標(biāo)

對(duì)回歸模型的性能進(jìn)行評(píng)估,以評(píng)估擬合模型可以準(zhǔn)確預(yù)測(cè)輸入數(shù)據(jù)值的程度。

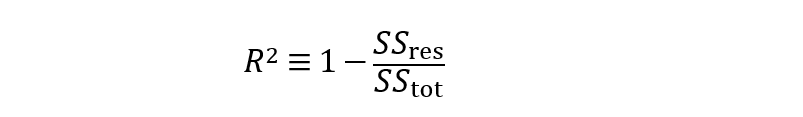

評(píng)估回歸模型性能的常用指標(biāo)是確定系數(shù)(R2)。

從公式中可以看出,R2實(shí)質(zhì)上是1減去殘差平方和(SSres)與總平方和(SStot)的比值。簡(jiǎn)單來(lái)說(shuō),可以說(shuō)它代表了解釋方差的相對(duì)量度。例如,如果R2=0.6,那么意味著該模型可以解釋60%的方差(即60%的數(shù)據(jù)符合回歸模型),而未解釋的方差占剩余的40%。

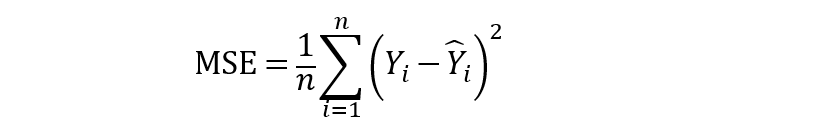

此外,均方誤差(MSE)以及均方根誤差(RMSE)也是衡量殘差或預(yù)測(cè)誤差的常用指標(biāo)。

從上面的公式可以看出,MSE顧名思義是很容易計(jì)算的,取平方誤差的平均值。此外,MSE的簡(jiǎn)單平方根可以得到RMSE。

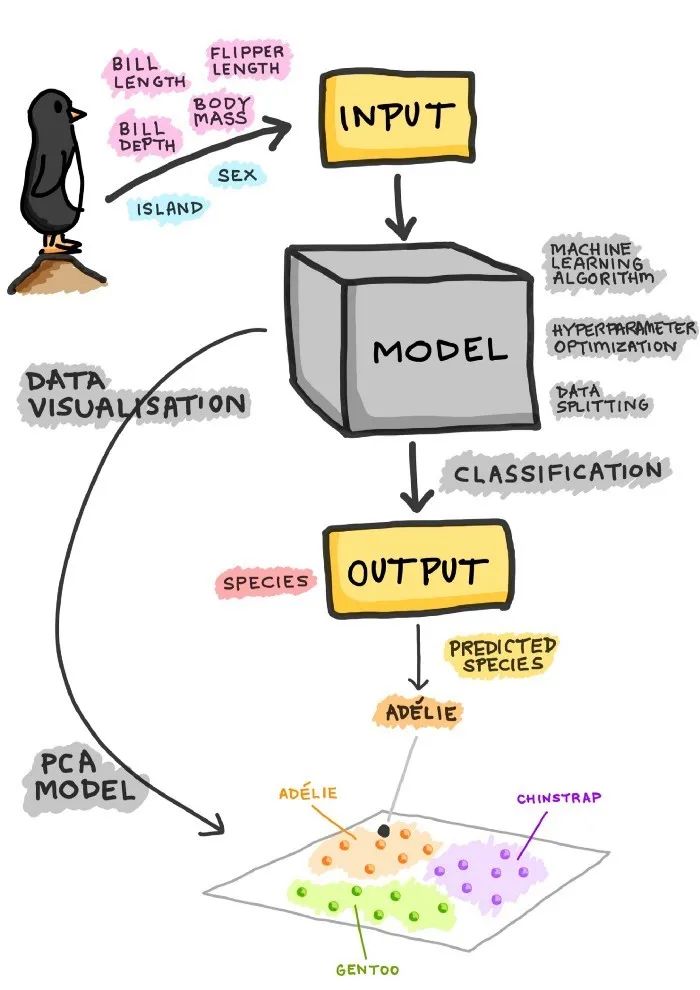

7. 分類任務(wù)的直觀說(shuō)明

現(xiàn)在我們?cè)賮?lái)看看分類模型的整個(gè)過(guò)程。以企鵝數(shù)據(jù)集為例,我們可以看到,企鵝可以通過(guò)4個(gè)定量特征和2個(gè)定性特征來(lái)描述,然后將這些特征作為訓(xùn)練分類模型的輸入。在訓(xùn)練模型的過(guò)程中,需要考慮的問(wèn)題包括以下幾點(diǎn)。

使用什么機(jī)器學(xué)習(xí)算法?

應(yīng)該探索什么樣的搜索空間進(jìn)行超參數(shù)優(yōu)化?

使用哪種數(shù)據(jù)分割方案?80/20分割還是60/20/20分割?還是10倍CV?

一旦模型被訓(xùn)練,得到的模型就可以用來(lái)對(duì)類別標(biāo)簽(即在我們的案例中企鵝種類)進(jìn)行預(yù)測(cè),可以是三種企鵝種類中的一種:Adelie、Chinstrap或Gentoo。

除了只進(jìn)行分類建模,我們還可以進(jìn)行主成分分析(PCA),這將只利用X(獨(dú)立)變量來(lái)辨別數(shù)據(jù)的底層結(jié)構(gòu),并在這樣做的過(guò)程中允許將固有的數(shù)據(jù)簇可視化(如下圖所示為一個(gè)假設(shè)圖,其中簇根據(jù)3種企鵝物種進(jìn)行了顏色編碼)。

圖14. 建立一個(gè)分類模型的過(guò)程示意圖

責(zé)任編輯:xj

原文標(biāo)題:機(jī)器學(xué)習(xí)模型訓(xùn)練全流程!

文章出處:【微信公眾號(hào):人工智能與大數(shù)據(jù)技術(shù)】歡迎添加關(guān)注!文章轉(zhuǎn)載請(qǐng)注明出處。

-

數(shù)據(jù)

+關(guān)注

關(guān)注

8文章

7122瀏覽量

89355 -

機(jī)器學(xué)習(xí)

+關(guān)注

關(guān)注

66文章

8435瀏覽量

132885

原文標(biāo)題:機(jī)器學(xué)習(xí)模型訓(xùn)練全流程!

文章出處:【微信號(hào):TheBigData1024,微信公眾號(hào):人工智能與大數(shù)據(jù)技術(shù)】歡迎添加關(guān)注!文章轉(zhuǎn)載請(qǐng)注明出處。

發(fā)布評(píng)論請(qǐng)先 登錄

相關(guān)推薦

《具身智能機(jī)器人系統(tǒng)》第7-9章閱讀心得之具身智能機(jī)器人與大模型

構(gòu)建云原生機(jī)器學(xué)習(xí)平臺(tái)流程

如何使用Python構(gòu)建LSTM神經(jīng)網(wǎng)絡(luò)模型

AI大模型與深度學(xué)習(xí)的關(guān)系

AI大模型與傳統(tǒng)機(jī)器學(xué)習(xí)的區(qū)別

構(gòu)建語(yǔ)音控制機(jī)器人 - 線性模型和機(jī)器學(xué)習(xí)

手繪圖的方式帶你了解機(jī)器學(xué)習(xí)模型構(gòu)建的全流程

手繪圖的方式帶你了解機(jī)器學(xué)習(xí)模型構(gòu)建的全流程

評(píng)論