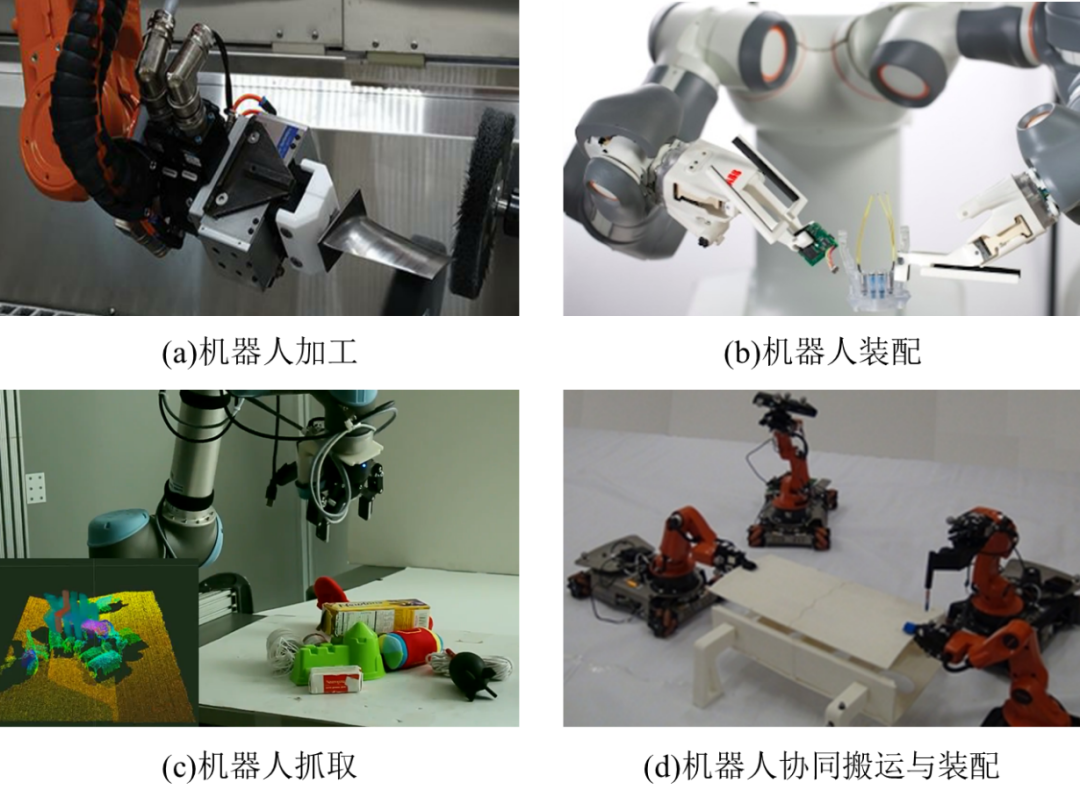

機器人作為面向未來的智能制造重點技術(shù),其具有可控性強、靈活性高以及配置柔性等優(yōu)勢,被廣泛的應(yīng)用于零件加工、協(xié)同搬運、物體抓取與部件裝配等領(lǐng)域,如圖1-1所示。然而,傳統(tǒng)機器人系統(tǒng)大多都是在結(jié)構(gòu)化環(huán)境中,通過離線編程的方式進行單一重復(fù)作業(yè),已經(jīng)無法滿足人們在生產(chǎn)與生活中日益提升的智能化需求。隨著計算機技術(shù)與傳感器技術(shù)的不斷發(fā)展,我們期望構(gòu)建出擁有更加靈敏的感知系統(tǒng)與更加智慧的決策能力的智能化機器人系統(tǒng)。

圖1-1 機器人的應(yīng)用領(lǐng)域

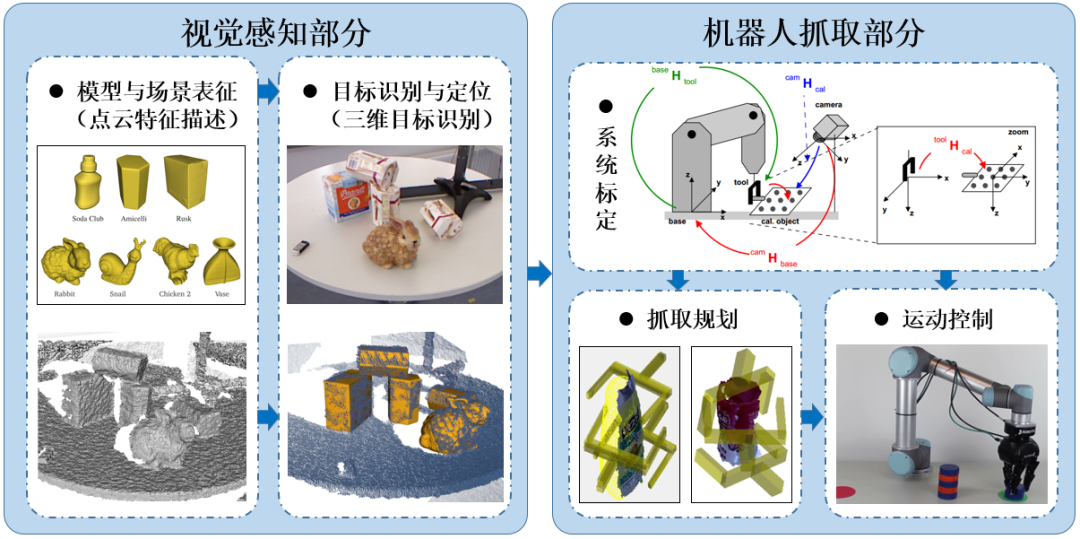

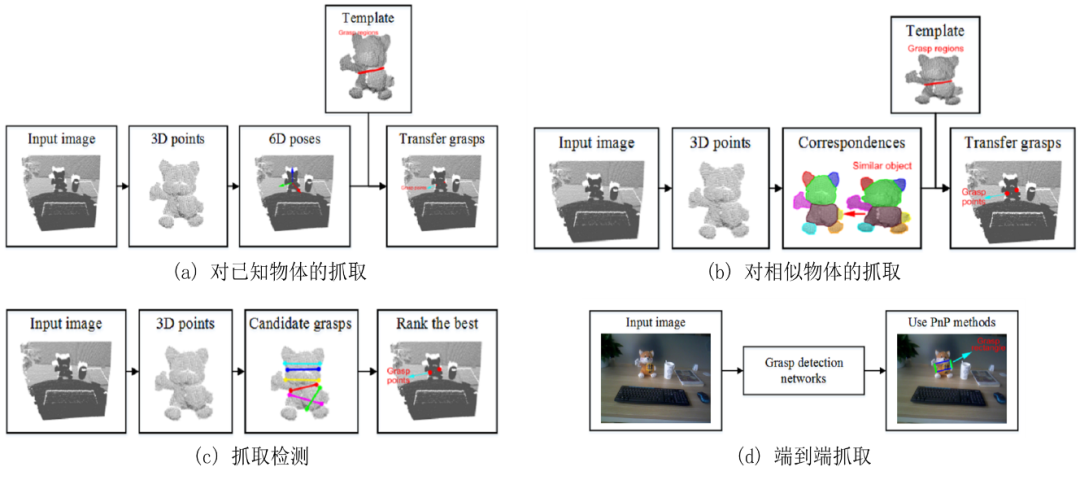

圖1-2 機器人抓取的操作流程與步驟

機器人抓取與放置是智能化機器人系統(tǒng)的集中體現(xiàn),也是生產(chǎn)與生活中十分重要的環(huán)節(jié),近幾年來在工業(yè)界與學(xué)術(shù)界得到了深入而廣泛的研究。具體的機器人抓取可以分為視覺感知部分與機器人抓取操作部分。視覺感知部分又包含:模型與場景表征、目標(biāo)識別與定位這兩個步驟;而機器人抓取操作部分則包含:系統(tǒng)標(biāo)定、運動控制與抓取規(guī)劃等步驟,如圖1-2所示。這其中,機器人通過視覺傳感器感知環(huán)境并實現(xiàn)對目標(biāo)物體的識別與定位,也就是視覺感知部分,是十分重要的環(huán)節(jié),其直接決定了后續(xù)機器人的抓取精度。

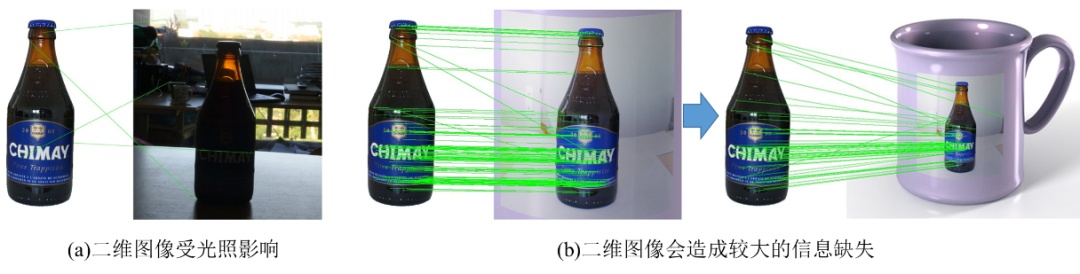

圖1-3 二維圖像的部分缺陷

受益于計算機算力的不斷提高以及傳感器成像水平的高速發(fā)展,目前針對結(jié)構(gòu)化環(huán)境或者半結(jié)構(gòu)化環(huán)境中,基于二維圖像的機器人平面單目標(biāo)物體的抓取技術(shù)已經(jīng)趨于成熟,并取得了豐富的研究成果[1][2][3]。然而,對于現(xiàn)實復(fù)雜環(huán)境中的三維物體,僅使用二維信息對三維目標(biāo)進行表征,會不可避免的造成信息損失,如圖1-3所示,從而難以實現(xiàn)非結(jié)構(gòu)化環(huán)境中機器人對于多目標(biāo)物體的高精度抓取操作。因此,如何提升機器人的視覺感知能力,并基于此在復(fù)雜環(huán)境中自主完成對目標(biāo)物體的識別、定位、抓取等操作是一個很有價值的研究問題。

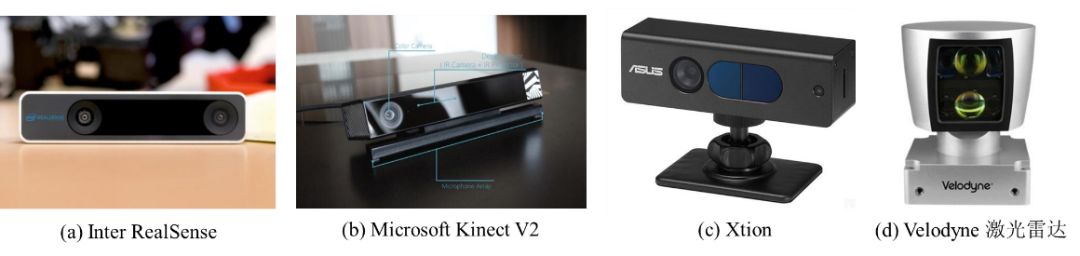

近年來,隨著低成本深度傳感器(如Intel RealSense、Xtion以及Microsoft Kinect等)與激光雷達的飛速發(fā)展,如圖1-4所示,三維點云的獲取越來越方便。這里的點云實際上就是在相機坐標(biāo)系下,對所拍攝的物體或者場景表面進行點采樣。物體對應(yīng)的點云數(shù)據(jù)在在數(shù)學(xué)上可以簡單的理解為三維坐標(biāo)的無序集合。三維點云數(shù)據(jù)相對于平面二維圖像具有如下優(yōu)勢:(1)可以更加真實準(zhǔn)確的表達物體的幾何形狀信息與空間位置姿態(tài);(2)受光照強度變化、成像距離以及視點變化的影響較小;(3)不存在二維圖像中的投影變換等問題。三維點云數(shù)據(jù)具有的以上優(yōu)勢使得其有望克服平面二維圖像在機器人目標(biāo)識別與抓取中存在的諸多不足,所以其具有很重要的研究意義以及廣泛的應(yīng)用前景。因此,近年來針對點云的視覺研究以及基于點云的機器人抓取成為了機器人領(lǐng)域新的研究熱點。

圖1-4 點云獲取設(shè)備示意圖

對應(yīng)前文的,在基于點云的機器人抓取可以分為點云特征描述(模型與場景表征)、三維目標(biāo)識別(目標(biāo)識別與定位)與機器人抓取操作這三個部分[39][40]。進一步的,點云特征描述指的是,將模型與場景對應(yīng)的無序點集通過特定的算法編碼為低維的特征向量,用此來表征對象的局部或者全局信息,其應(yīng)當(dāng)具有足夠的描述力與穩(wěn)定性。三維目標(biāo)識別則主要是指,利用模型與場景的表征結(jié)果,在場景中識別出目標(biāo)物體,并估計出其對應(yīng)的位置與姿態(tài)。對于特征描述與目標(biāo)識別,盡管現(xiàn)有文獻提出了不少算法,并且在特定的環(huán)境中取得了不錯的效果,然而如何在包含噪聲、干擾、遮擋與密度變化的復(fù)雜非結(jié)構(gòu)化環(huán)境中提取有效而穩(wěn)定的特征,實現(xiàn)對多目標(biāo)物體的準(zhǔn)確識別定位以及高精度抓取,仍然是極富挑戰(zhàn)性的一個問題[4]。

綜上所述,基于點云的機器人抓取作為智能化機器人系統(tǒng)的集中體現(xiàn),近幾年來得到了工業(yè)界和學(xué)術(shù)界的廣泛關(guān)注,并圍繞點云特征描述、三維目標(biāo)識別與機器人抓取操作這三個方面展開了深入研究。具體的,在點云特征描述部分,主要關(guān)注描述子的鑒別力、魯棒性、計算效率與緊湊性等性能;在三維目標(biāo)識別部分,主要關(guān)注目標(biāo)的識別準(zhǔn)確率與定位精度問題;而在機器人抓取操作部分,抓取系統(tǒng)的參數(shù)標(biāo)定與多目標(biāo)物體的數(shù)據(jù)分析都是很重要的環(huán)節(jié)。

1.1國內(nèi)外研究現(xiàn)狀

受益于點云數(shù)據(jù)自身的優(yōu)勢、計算機算力的不斷提高與傳感技術(shù)的不斷發(fā)展,基于點云的機器人抓取成為了機器人領(lǐng)域新的研究熱點,具有十分誘人的研究價值與應(yīng)用前景。近年來,學(xué)術(shù)界與工業(yè)界圍繞基于點云的機器人抓取,在點云特征描述、三維目標(biāo)識別與機器人抓取操作這三個方面展開了廣泛而深入的研究,取得了顯著進展,下面分別從上述三個方面進行文獻綜述。

1.1.1點云特征描述

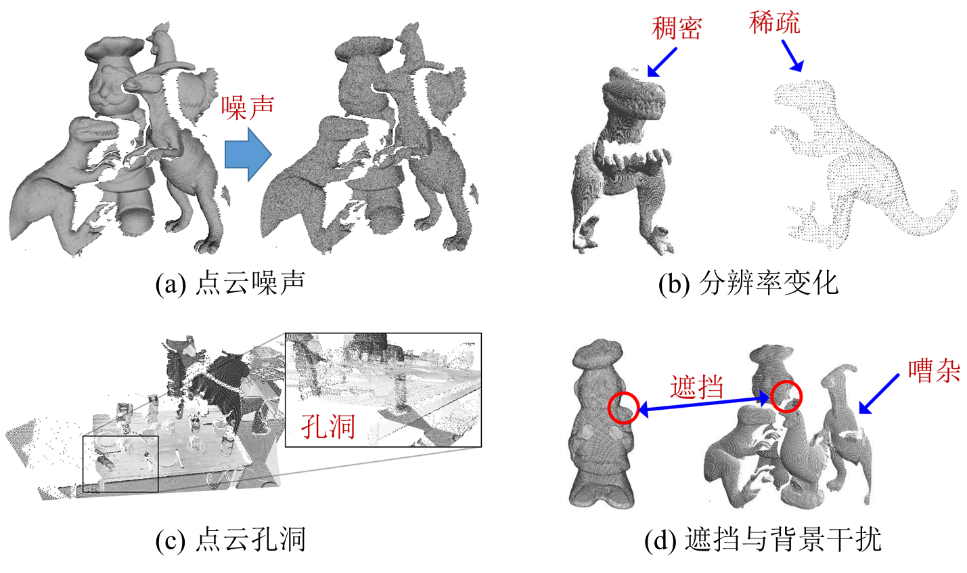

點云特征描述在機器人抓取中主要是應(yīng)用于視覺感知部分的模型與場景表征。一種合格的特征描述算法應(yīng)該有較高的描述力來表征對應(yīng)的局部點云表面。此外,此外其還應(yīng)該對于點云噪聲、表面孔洞、部分遮擋、視點改變以及分辨率變化等穩(wěn)健[4],如圖1-5所示。

圖1-5 點云場景存在的挑戰(zhàn)

現(xiàn)有的特征描述算法可以分為全局特征和局部特征兩大類[5]。全局特征采用模型的整體幾何信息構(gòu)建得到,典型代表有Osada等[6]提出來的Shape distribution描述子,Wahl等[7]提出來的SPR(Surflet-pair-relation)描述子以及Funkhouser等[8]提出來的Spherical harmonics描述子。全局描述子擁有較高的計算效率和分類能力,但是其對于遮擋比較敏感,很難用于目標(biāo)識別和精確定位[9]。鑒于此,局部點云的概念被提出,局部特征描述算法得到了深入的研究和廣泛的關(guān)注。其首先提取關(guān)鍵點建立局部鄰域,根據(jù)鄰域內(nèi)各點的空間分布信息和幾何特征構(gòu)建描述矩陣。局部描述子對于背景干擾和遮擋魯棒,相比于全局描述子更適合用于非結(jié)構(gòu)化環(huán)境中的目標(biāo)識別[4][10]。

圖1-6 部分局部描述算法示意圖

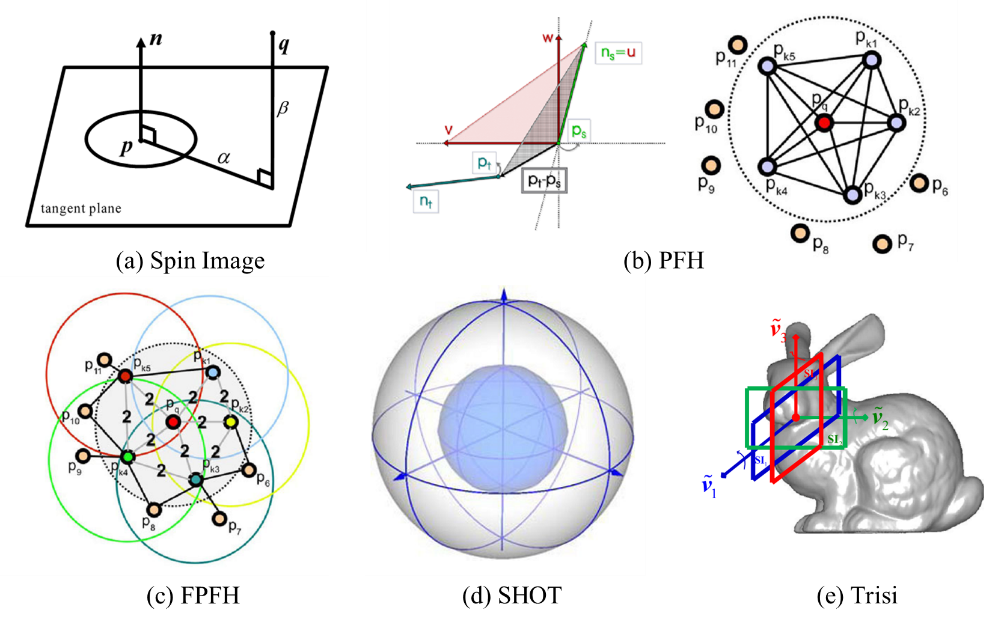

局部描述算法又可以根據(jù)有無建立局部參考坐標(biāo)系(Local Reference Frame, LRF)進行分類[11]。不依賴LRF的特征描述子都是使用局部幾何信息的統(tǒng)計直方圖或者信息量來構(gòu)成特征矩陣[12]。例如,Johnson等[13]提出了Spin image描述算法,如圖1-6(a),它首先以關(guān)鍵點的法線作為參考軸,用兩個參數(shù)對關(guān)鍵點的每個鄰域點進行編碼,然后根據(jù)這兩個參數(shù)將局部鄰域點進行分箱,進而生成一個二維直方圖。Spin image描述子已經(jīng)成為了三維特征描述子評估體系的實驗基準(zhǔn)[4][14]。但是,其存在諸如對數(shù)據(jù)分辨率變化和非均勻采樣敏感等缺陷[15]。Rusu等[16]提出了PFH(Point Feature Histogram)描述算法:其對于關(guān)鍵點鄰域內(nèi)的每一個點對,首先建立Darboux框架,然后采用[7]中的方法計算由法向量和距離向量得到的四個測量值,最后將所有點對的測量值進行累加生成一個長度為16的直方圖,如圖1-6(b)。為了降低計算復(fù)雜度,Rusu[17]等僅將關(guān)鍵點與其鄰域點之間的測量值進行累加,隨后進行加權(quán)求和得到FPFH(Fast-PFH),如圖1-6(c)。FPFH保留了PFH的絕大部分鑒別信息,但是其對于噪聲敏感[5]。目前絕大多不依賴于LRF的描述子僅利用了點云的部分幾何特征,而很難編碼局部空間分布信息,因而其都鑒別力不強或者魯棒性較弱[15]。

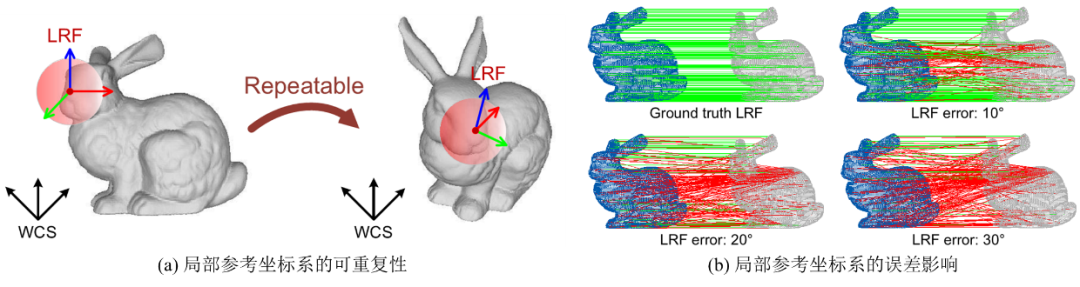

對于建立了局部參考坐標(biāo)系的描述子,則利用定義的LRF來同時對空間分布信息和幾何特征進行編碼以提高其鑒別力和魯棒性[18]。例如,Tombari等人[19]首先利用加權(quán)主成分分析(PCA)的方法為關(guān)鍵點構(gòu)建了一個局部參考坐標(biāo)系,進而在該LRF下將關(guān)鍵點對應(yīng)的球形R-近鄰空間進行柵格化處理,然后依據(jù)關(guān)鍵點法線與落入每一個子單元的點法線間的夾角將這些點累積到一個數(shù)據(jù)統(tǒng)計直方圖中,最后串聯(lián)各個直方圖便獲得SHOT(Signatures of Histograms of Orientation)特征,如圖1-6(d)。SHOT計算效率高,但是對于分辨率變化敏感[5]。Guo等[18]通過計算局部表面對應(yīng)散布矩陣的特征向量來建立LRF,然后利用旋轉(zhuǎn)投影的方法對三維點集進行降維并建立分布矩陣,之后提取分布矩陣的信息量生成最后的RoPS(Rotational Projection Statistics)描述子。RoPS有著優(yōu)越的綜合性能[5],但是其只能用于mesh網(wǎng)格文件,也就是說其無法作用于原始的xyz點云數(shù)據(jù)[20]。并且,其將數(shù)據(jù)投影到了二維平面會造成較大的信息損失[21]。之后,Guo[15]在RoPS的LRF算法基礎(chǔ)上進行改進,提高了穩(wěn)定性,然后在坐標(biāo)系的每一個參考坐標(biāo)軸上求取局部鄰域的Spin Image特征,串聯(lián)組成Trisi(Triple-Spin Image)局部特征描述子,如圖1-6(e)。基于LRF的局部描述算法的鑒別力和魯棒性很依賴于所建立的局部參考坐標(biāo)系的可重復(fù)性與穩(wěn)定性,如果坐標(biāo)系存在輕微的偏差,會對最終的描述向量造成嚴(yán)重的影響[22],如圖1-7。然而,目前已有的局部坐標(biāo)系算法存在可重復(fù)性差或者方向歧義的問題[23]。

綜上所述,對于不建立局部參考坐標(biāo)系的特征描述子,由于不能融入空間分布信息,普遍存在鑒別力不高、對于噪聲比較敏感等問題;而擁有局部參考坐標(biāo)系的特征描述子的描述力和魯棒性則主要依賴于所對應(yīng)的坐標(biāo)系建立算法,然而目前已有的坐標(biāo)系建立方法均存在可重復(fù)性差或者方向歧義的問題[22],相應(yīng)的特征提取算法在鑒別力、魯棒性與計算效率方面依然有提升的可能[5]。

圖1-7 LRF的誤差影響

1.1.2三維目標(biāo)識別

在基于點云的機器人抓取領(lǐng)域,完成了模型與場景的表征,下一步則是進行目標(biāo)識別與定位,也就是在點云場景中對待抓取模型進行三維目標(biāo)識別以及對應(yīng)的姿態(tài)估計。現(xiàn)有的三維目標(biāo)識別算法主要包括基于局部特征的算法、基于投票的算法、基于模板匹配的算法以及基于學(xué)習(xí)的方法[24][25]。

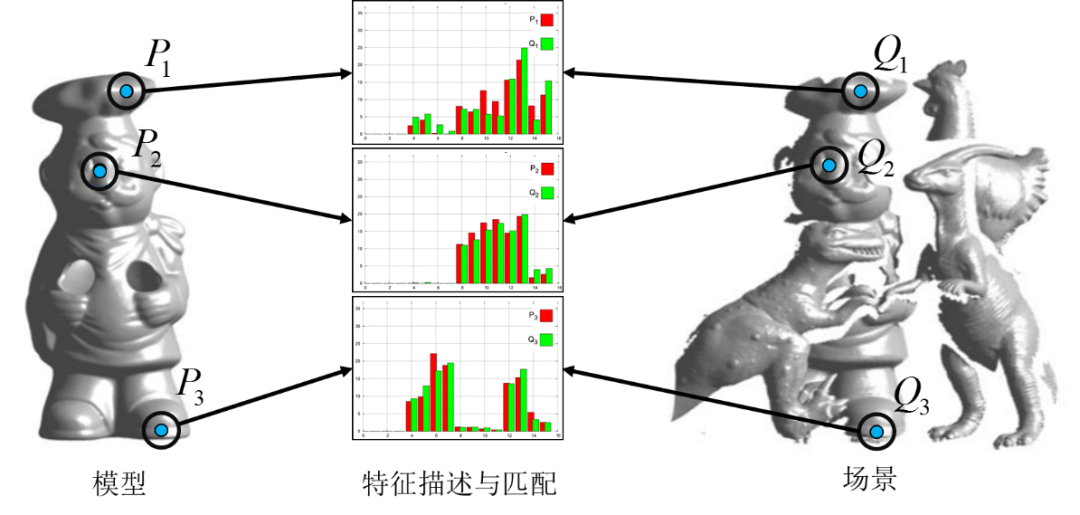

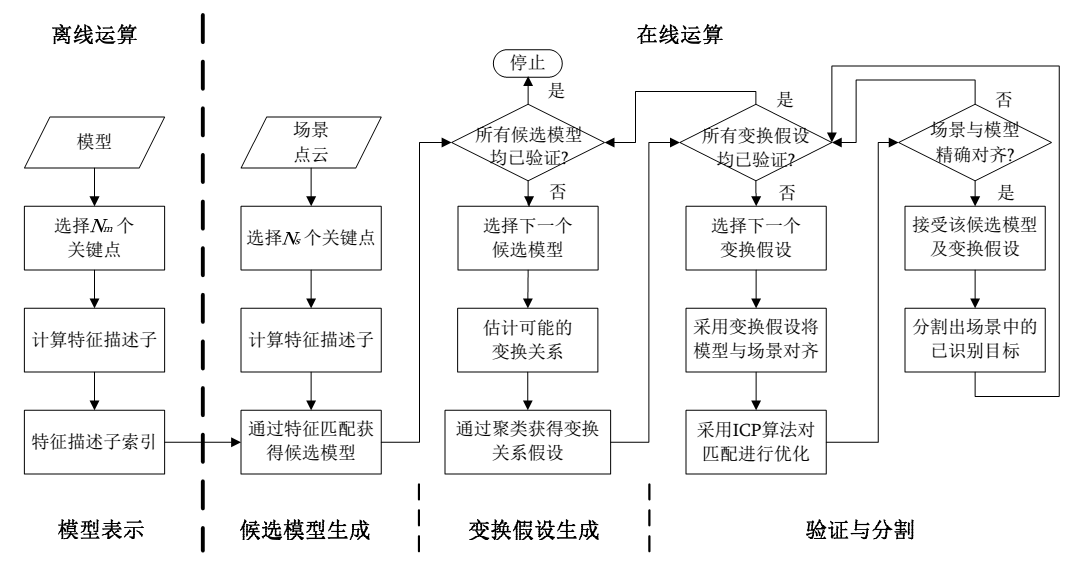

基于局部特征的目標(biāo)識別算法則主要分成五個部分:關(guān)鍵點檢測、特征提取、特征匹配、假設(shè)生成、假設(shè)檢驗[26][27]。在這里關(guān)鍵點檢測與特征提取組合對應(yīng)的就是進行模型與場景表征。由于點云的點集數(shù)量巨大,如果對每個點都進行特征提取則會造成計算機算力不足的情況,因此會在原點云中提取稀疏而區(qū)分度高的點集作為關(guān)鍵點。關(guān)鍵點應(yīng)當(dāng)滿足可重復(fù)性和獨特性這兩個重要屬性[28]。前者涉及的是在各種干擾下(噪聲、分辨率變化、遮擋與背景干擾等)可以精確提取相同關(guān)鍵點的能力;而后者則是指提取的關(guān)鍵點應(yīng)當(dāng)易于描述、匹配與分類[29]。在點云領(lǐng)域,經(jīng)典的關(guān)鍵點提取算法包括Harries 3D[30],ISS(Intrinsic Shape Signature)算法[31],NARF(Normal Aligned Radial Feature)算法[32]。特征提取部分則主要是在物體表面提取穩(wěn)固的局部特征,詳見本章1.3.1部分的討論。

特征匹配的作用則是建立一系列的關(guān)鍵點特征對應(yīng)關(guān)系,如圖1-8所示。經(jīng)典的特征匹配算法有最近鄰距離比值(NNDR)、閾值法、最近鄰策略(NN)等[33]。論文[33]則表明NNDR與NN的匹配算法優(yōu)于閾值法的匹配效果,NNDR亦是目前使用最多的匹配策略[34]。為了降低計算復(fù)雜度,一般都會使用高效的搜索算法來優(yōu)化特征匹配,使其快速地找到場景特征庫中與當(dāng)前特征對應(yīng)的k近鄰特征。常用搜索算法包括k-d樹[35]、局部敏感樹[31]、哈希表[36]與二維索引表[37]等。

圖1-8 局部特征匹配過程示意圖

假設(shè)生成部分則主要是利用匹配上的特征對集合找出在場景中可能的模型位置,并建立對應(yīng)的姿態(tài)估計(即計算變換假設(shè))[38]。值得注意的是,在匹配上的特征對集合中,既會存在正確的特征對,也會有大量有誤差的特征對。因此在計算變換假設(shè)的時候,需要使用有效的算法策略盡可能的剔除錯誤特征對,從而得到較為準(zhǔn)確的模型與場景間的變換關(guān)系。這一部分的方法主要包括隨機一致性采樣(RANSAC)、姿態(tài)聚類、幾何一致性以及擴展霍夫變換等。RANSAC算法首先隨機選取k組特征對來計算模型到場景間的變換矩陣(這里k為生成一個變換矩陣所需要的最少特征對數(shù)量),并統(tǒng)計滿足這個變換矩陣的點對數(shù)量。使用這個算法的論文包括[38][39][40]。姿態(tài)聚類算法則認(rèn)為當(dāng)模型在場景中被正確識別后,大多數(shù)模型與場景對齊的假設(shè)生成變換矩陣都應(yīng)當(dāng)在真實的位姿矩陣(ground truth)附近。使用這個算法的論文包括[31][41][42]。幾何一致性技術(shù)則認(rèn)為如果特征對不滿足幾何約束關(guān)系則會使得估計出來的變換矩陣有較大的誤差,所以希望使用幾何約束來剔除誤差較大的匹配點對,進而提高生成的變換矩陣的準(zhǔn)確性。使用該算法的論文包括[13][43][44]。擴展霍夫變換則是利用特征對間的平移和旋轉(zhuǎn)等參數(shù)構(gòu)成廣義的霍夫空間,然后進行投票統(tǒng)計。這個廣義的參數(shù)化霍夫空間中的每一個點都對應(yīng)模型與場景間的一組變換關(guān)系,空間中的峰值點被認(rèn)為是模型到場景變換矩陣估計的最優(yōu)解。采用這種算法的論文包括[45][46][47]。

圖1-9 基于特征提取的目標(biāo)識別流程圖

假設(shè)檢驗部分則是為了得到假設(shè)生成部分所計算出來的潛在變換關(guān)系中真正正確的變換矩陣。Hebert與Johnson[13][48]采用模型與場景的對應(yīng)點數(shù)和模型總點數(shù)的比值作為相似度參數(shù)。當(dāng)相似度大于設(shè)定的閾值時,則認(rèn)為當(dāng)前的變換矩陣是正確的。Main[49]則采用特征相似度與點云匹配精度作為綜合評價指標(biāo)。Bariya[43]首先計算出模型與場景的交疊面積,并將模型可見面積和重疊面積的比值作為相似度度量。Papazov[40]則提出了一個包含懲罰項和支持項的接收函數(shù)用于評估建設(shè)生成的姿態(tài)變換質(zhì)量。Aldoma[44][26]則建立了場景到模型的擬合、模型到場景的擬合、遮擋關(guān)系以及不同模型間的關(guān)聯(lián)這幾個條件建立了一個代價函數(shù),然后通過求取這個函數(shù)的極小值來獲得理論上最優(yōu)的變換姿態(tài)。

圖1-10 PPF投票算法示意圖

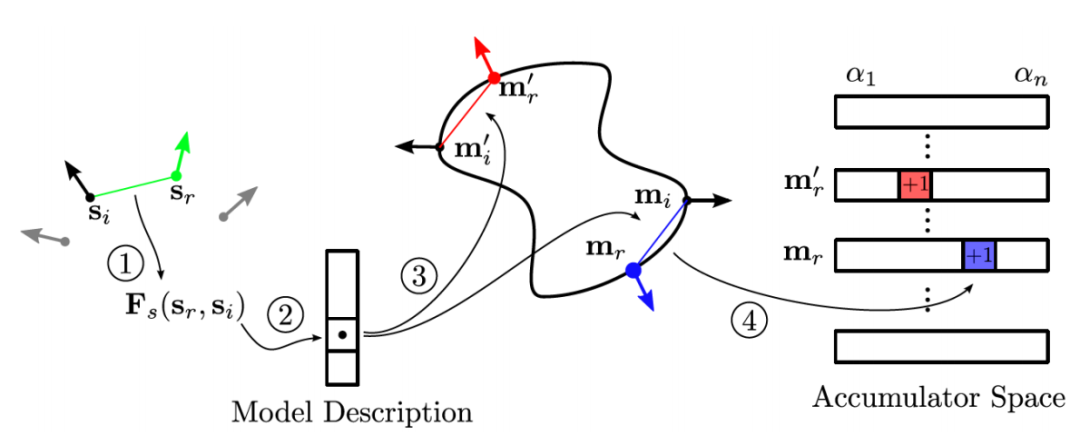

基于投票的三維目標(biāo)識別算法則是直接匹配模型與場景間的固有特性,生成有限的候選姿態(tài)集后,利用先驗條件構(gòu)造支持函數(shù)與罰函數(shù)并對每一個姿態(tài)進行投票,進而得出最優(yōu)的變換矩陣。Drost等人[41]提出了用于目標(biāo)識別的點對特征(Point Pair Features, PPF),這也是三維目標(biāo)識別領(lǐng)域的經(jīng)典算法,算法原理如圖1-10所示。其利用了點對間最為樸素的特征:距離與法線夾角,構(gòu)造出有四個參數(shù)的特征數(shù)組;然后結(jié)合哈希表進行窮舉匹配,利用高效的投票方案得出最優(yōu)的姿態(tài)估計。Kim等人[50]則在原始PPF特征中加入了可見性特征(空間、表面與不可見表面),增強了PPF的匹配能力。Choi等人[51]在此基礎(chǔ)上提出了對點對特征進行分類的策略,如邊界上的點對或者是由邊緣點組成的點對等。利用這種分類方法可以減少訓(xùn)練和匹配的特征數(shù)量,加快了匹配速度以及投票效率。此外,Choi等人[52]還在PPF的點對特征上加入了顏色分量,創(chuàng)建了Color-PPF,實驗結(jié)果表明其識別率明顯提高。隨后,Drost等人[53]又提出了利用幾何邊緣(邊界和輪廓)來計算PPF,這種算法顯著改進了在高度遮擋場景中的識別率。Birdal等人[54]則提出了先對場景進行分割,在進行PPF匹配的識別策略。更進一步的,Hinterstoisser等人[55]針對PPF提出了一種新的采樣方法以及一種新的姿態(tài)投票方案,使得這種算法對噪聲和背景干擾更加穩(wěn)健。Tejan等人[56]則從RGB-D圖像中訓(xùn)練了一個霍夫森林,在樹中的葉子上存儲著目標(biāo)識別6D姿態(tài)的投票。

圖1-11 基于模板匹配的目標(biāo)識別流程

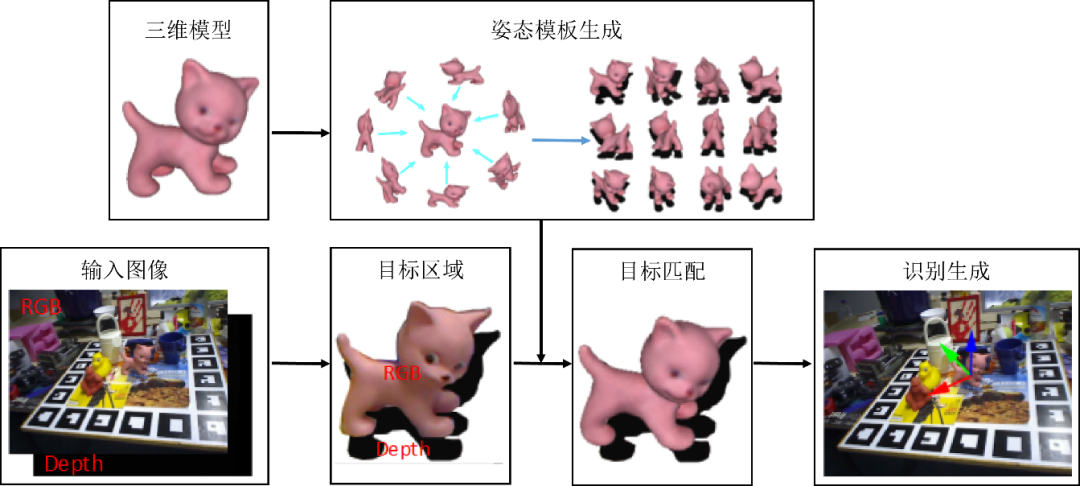

基于模板匹配的目標(biāo)識別算法則主要是針對無紋理物體的檢測。其利用已有的三維模型從不同的角度進行投影,生成二維RGB-D圖像后再生成模板;然后將所有的模板與場景匹配,進而得出最優(yōu)的模型位姿,算法原理如圖1-11。Hinterstoisser等人[57]提出了經(jīng)典的Linemod算法,其結(jié)合了彩色圖像中的梯度信息再結(jié)合深度圖像中的表面法線信息生成圖像模板,在場景圖像中利用滑窗搜索的方式進行模板匹配。Hodan等人[58]提出了一種實用的無紋理目標(biāo)檢測方法,也是實用滑動窗口的模式,對于每個窗口進行有效的級聯(lián)評估。首先通過簡單的預(yù)處理過濾掉大部分位置;然后對于每一個位置,一組候選模板(即經(jīng)過訓(xùn)練的對象視圖)通過哈希投票進行識別;最后通過匹配不同模式下的特征點來驗證候選模板進而生成目標(biāo)的三維位姿。

基于學(xué)習(xí)的方法,Brachmann等人[59]提出的基于學(xué)習(xí)的目標(biāo)識別算法,對于輸入圖像的每一個像素,利用其提出的回歸森林預(yù)測待識別對象的身份和其在對象模型坐標(biāo)系中的位置,建立所謂的“對象坐標(biāo)”。采用基于隨機一致性采樣算法的優(yōu)化模式對三元對應(yīng)點對集進行采樣,以此創(chuàng)建一個位姿假設(shè)池。選擇使得預(yù)測一致性最大化的假設(shè)位姿作為最終的位姿估計結(jié)果。這個學(xué)習(xí)模型在論文[60]中得到了多種擴展。首先,利用auto-context算法對于隨機森林進行改進,支持只是用RGB信息的位姿估計;其次,該模型不僅考慮已知對象的位姿,同時還考慮了沒有先驗?zāi)P蛶斓哪繕?biāo)識別;更多的,其使用隨機森林預(yù)測每一個像素坐標(biāo)在目標(biāo)坐標(biāo)系上的完整三維分布,捕捉不確定性信息。自從深度卷積神經(jīng)網(wǎng)絡(luò)(DCBB)[61]提出以來,基于深度學(xué)習(xí)的方法近年來變得十分流行,例如RCNN[62],Mask-RCNN[63],YOLO[64]與SSD[65]等。最近的綜述論文[66]對于這些算法進行了詳細(xì)的闡述和比較。

綜上所述,在目前已有的目標(biāo)識別算法中,基于幾何一致性與隨機一致性采樣的管道方法存在組合爆炸的問題,其對應(yīng)的計算復(fù)雜度為O(n3);而基于點對特征的目標(biāo)識別方案則會由于法線方向的二義性問題造成識別的準(zhǔn)確率下降,并且其對應(yīng)的計算復(fù)雜度為O(n2);基于模板匹配的目標(biāo)識別算法(Linemod)則存在對于遮擋敏感等問題。雖然各種算法在特定的數(shù)據(jù)集上都取得了不錯的效果,但是在非結(jié)構(gòu)化環(huán)境中的目標(biāo)識別準(zhǔn)確率依然有較大的提升空間。

1.1.3機器人抓取操作

基于點云的機器人抓取主要包含視覺感知部分與機器人抓取操作部分。機器人抓取操作部分則又包括系統(tǒng)標(biāo)定、抓取規(guī)劃與運動控制。

系統(tǒng)標(biāo)定包括主要是指對相機與機器人的標(biāo)定。由于對于視覺感知部分求出的待抓取目標(biāo)物體的位置與姿態(tài)均處于相機坐標(biāo)系下,為了進行機器人準(zhǔn)確抓取,需要將其坐標(biāo)與姿態(tài)變換到機器人坐標(biāo)系下。這里便需要將相機與機器人進行手眼標(biāo)定。手眼標(biāo)定主要求取相機坐標(biāo)系與機器人基坐標(biāo)系間的變換關(guān)系[67],主要可以分為相機在手上的標(biāo)定與相機在手外的標(biāo)定。此外,對于相機,使用時需要進行內(nèi)參的校準(zhǔn),畸變系數(shù)的求取等[68][69];如果是雙目立體視覺,則還包含對于雙目相機的參數(shù)標(biāo)定[70];如果是結(jié)構(gòu)光或ToF(Time of Flight)成像的點云相機,則還要進行深度校準(zhǔn),以及彩色圖與深度圖的匹配對齊等操作[71][72][73]。對于機器人,如果是多機器人協(xié)同抓取,則組要進行多機器人基坐標(biāo)系間的標(biāo)定[74]。

而對于抓取規(guī)劃部分,其主要作用是可以實現(xiàn)對于場景中目標(biāo)物體的抓取點的提取[75]。如論文[76]所述,抓取策略應(yīng)當(dāng)確保穩(wěn)定性,任務(wù)的兼容性和對于新物體的適應(yīng)性等;此外,抓取質(zhì)量可以通過對物體接觸點的位置和末端夾爪的配置來進行評價[77]。對于物體的抓取,目前主要有基于經(jīng)驗的方法與基于端到端的方法。

基于經(jīng)驗的方法則是根據(jù)特定的任務(wù)和抓取對象的幾何形狀,使用與之相對應(yīng)的算法來進行抓取。更具體的又可以分為對已知物體的抓取和對相似物體的抓取[78]。如果抓取對象是已知的物體,那么則可以通過學(xué)習(xí)已有的成功抓取實例,再結(jié)合具體環(huán)境進行機器人抓取。事實上,如果目標(biāo)對象已知,則意味著對象的三維模型和抓取點位置在數(shù)據(jù)庫中也是先驗已知的。這種情況下,只需要從局部視圖估計目標(biāo)對象的6D位姿,并通過ICP等算法進行姿態(tài)細(xì)化與精確微調(diào),進一步便可以得到目標(biāo)物體的抓取位置。這是目前已知的抓取系統(tǒng)中最流行的方法,也是在亞馬遜抓取挑戰(zhàn)賽[79]中普遍使用的算法。Zeng等人[79]提出了一種利用全卷積神經(jīng)網(wǎng)絡(luò)對一個場景的多個視圖進行分割和標(biāo)注,然后將預(yù)掃描的三維目標(biāo)模型與分割結(jié)果進行匹配,得到6D目標(biāo)位姿。他們的方法在2016年APC抓取挑戰(zhàn)任務(wù)中獲得了第三名和第四名。Billings和Johnson-Roberson[80]提出了一種利用卷積神經(jīng)網(wǎng)絡(luò)的管道算法,其可以同時完成目標(biāo)姿態(tài)估計和抓取點選擇。該管道算法作用于感興趣區(qū)域(ROI),預(yù)測出一個中間輪廓來估計目標(biāo)位姿;然后從先驗的數(shù)據(jù)庫中生成抓取點。對于這種方法,當(dāng)有準(zhǔn)確的三維模型是,可以通過估計出6D姿態(tài)后進行準(zhǔn)確的抓取,由于擁有較高的抓取精度,是目前比較流行的抓取方法。然而,當(dāng)三維模型不太準(zhǔn)確時,如物體不可測量或者易變形等情況,則會導(dǎo)致有較大的抓取偏差。

圖1-12 局部抓取規(guī)劃方法

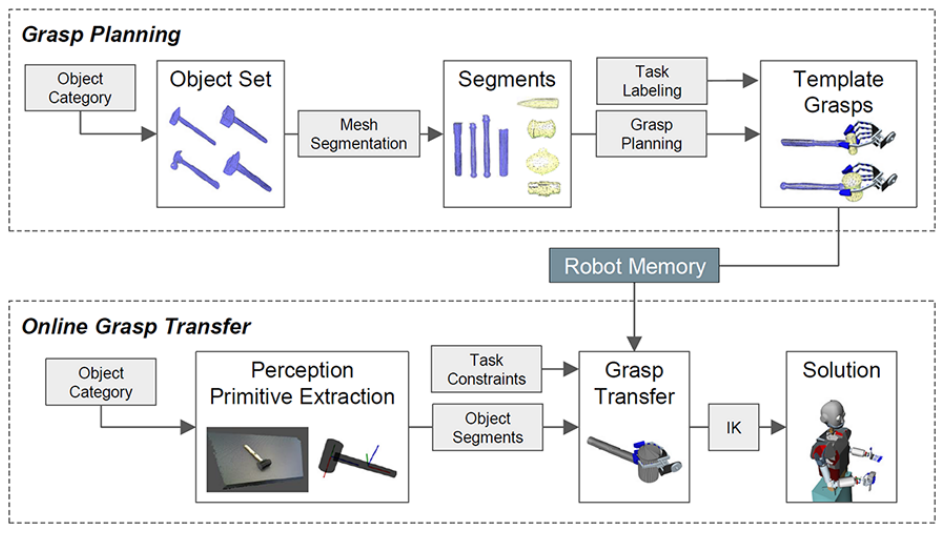

事實上,很多情況下,抓取的目標(biāo)對象與現(xiàn)有數(shù)據(jù)庫的模型并不完全相同,但是在模型庫中相似的同一類的物體,這便涉及到對相近物體的抓取。在目標(biāo)對象被定位以后,利用基于關(guān)鍵點對應(yīng)算法便可以將抓取點從模型庫中存在的相似三維模型上轉(zhuǎn)移到當(dāng)前的局部對象中。由于當(dāng)前的目標(biāo)對象與數(shù)據(jù)庫中的對象不完全相同,所以這類型的抓取算法是不需要進行六維姿態(tài)估計的。Andrew等人[81]提出了一種基于分類法的方法,該方法將對象劃分為各個類別,每個類別均存在對應(yīng)的抓取規(guī)范。Vahrenkamp等人[82]提出了一種基于局部的抓取規(guī)劃方法,用于生成適用于多個已知目標(biāo)對象的抓取,根據(jù)物體的形狀和體積信息對物體模型進行分割,并對目標(biāo)零件標(biāo)記語義信息和抓取信息。其還提出了一種抓取可轉(zhuǎn)移性的度量方法,用于評估在同一對象類別中的新物體的抓取成功率,如圖1-12所示。Tian等人[83]提出了一種將抓取構(gòu)型從先前的示例對象轉(zhuǎn)移到新目標(biāo)上的方法,該方法假設(shè)新對象和示例對象具有相同的拓?fù)浣Y(jié)構(gòu)和相似的形狀。他們考慮幾何形狀和語義形狀特征對對象進行三維分割,利用主動學(xué)習(xí)算法為示例對象的每個部分計算一個抓取空間,并為新對象在模型部分和相應(yīng)的抓取之間建立雙射接觸映射。這一類型的方法依賴于目標(biāo)分割的準(zhǔn)確性。然而,訓(xùn)練一個能識別出廣泛對象的網(wǎng)絡(luò)并不容易。同時,這些方法要求待抓取的三維物體與標(biāo)注模型相似,以便找到相應(yīng)的抓取模型。在經(jīng)常發(fā)生遮擋的雜亂環(huán)境中,計算高質(zhì)量的物體抓取點也是一個挑戰(zhàn)。

圖1-13 不同的抓取方案示意圖

端到端的抓取檢測則直接跳過了對于抓取目標(biāo)的定位,直接從輸入的圖像中提取抓取點位置。在這類方法中,滑動窗口策略是比較常用的方法。Lenz等人[84]提出了一個兩步級聯(lián)系統(tǒng),該系統(tǒng)具有兩個深度網(wǎng)絡(luò),第一步的頂部檢測結(jié)果由第二步重新評估。第一個網(wǎng)絡(luò)具有更少的特性,運行速度更快,并且可以有效地剔除不可能的候選項。第二個具有更多的特性,速度較慢,但只能在少數(shù)幾個檢測到的信號上運行。盡管他們達到了很高的精度,但是迭代掃描使過程非常緩慢。Ten Pas等人[85]提出了一種無需對目標(biāo)物體進行精確分割即可在任何可見表面生成抓取假設(shè)的方法。他們還提出了一種新的包含表面法線和多個視圖的抓取描述符。但是,由于沒有執(zhí)行實例級分段,因此這種算法會將多個對象視為同類物體。由于均勻網(wǎng)絡(luò)的性能優(yōu)于雙級聯(lián)系統(tǒng)[84],越來越多的單級方法被提出。Guo等人[86]提出了一種共享卷積神經(jīng)網(wǎng)絡(luò)來進行對象發(fā)現(xiàn)和抓取檢測。Pinto和Gupta[87]提出了一種通過試錯預(yù)測抓取位置的方法,他們訓(xùn)練了一個基于CNN的分類器來估計給定一個輸入圖像塊的不同抓取方向的抓取可能性。Chu等人[88]提出了一個由抓取區(qū)域建議組件和機器人抓取檢測組件組成的網(wǎng)絡(luò)。對于端到端抓取檢測方法,計算出的抓取點可能不是全局最優(yōu)的抓取點,因為在圖像中只有部分對象是可見的。

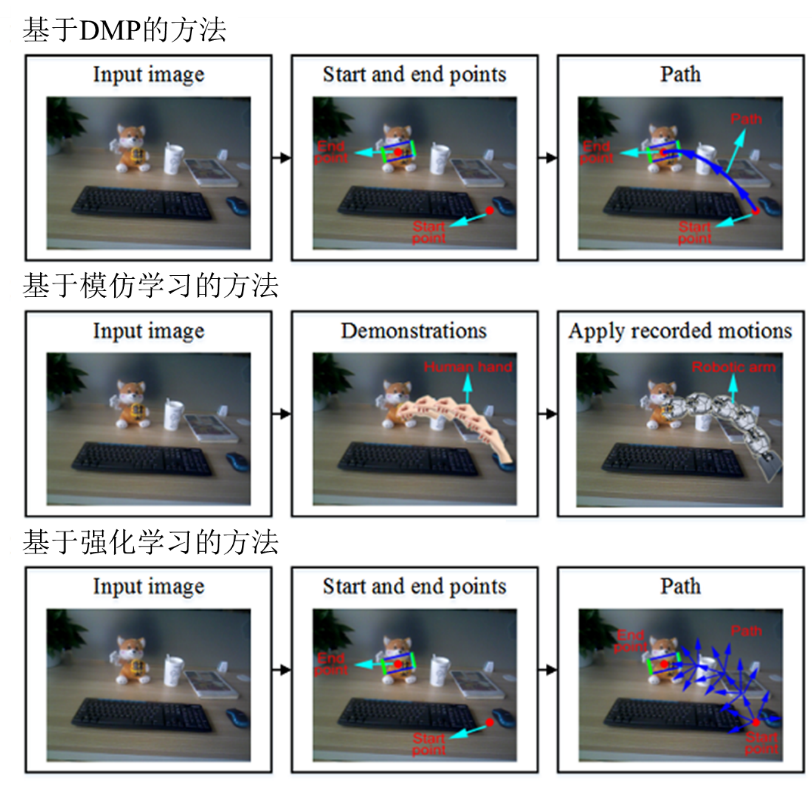

對于機器人抓取中的運動控制這一部分,其主要是設(shè)計從機械手目標(biāo)物體抓取點的路徑,這里面的關(guān)鍵問題就是運動表征。雖然從機械手到目標(biāo)抓取點的軌跡是無限多的,但是由于機械臂的局限性,很多地方都無法達到。因此,軌跡需要規(guī)劃。

軌跡規(guī)劃主要有有三種方法,分別是傳統(tǒng)的基于DMP的方法、基于模仿學(xué)習(xí)的方法和基于強化學(xué)習(xí)的方法,如圖1-14所示。傳統(tǒng)的方法考慮運動的動態(tài)性,生成運動原語。動態(tài)運動原語(Dynamic Movement Primitives, DMPs)[89]是最流行的運動表示形式之一,可以作為反饋控制器。DMPs對應(yīng)的原語是行為單位,或者說是魯棒的吸引子系統(tǒng),其實非線性的。在算法中將運動學(xué)對應(yīng)的控制策略按照規(guī)則編碼為非線性微分方程組,方程組的目標(biāo)就是吸引子[90]。DMPs已成功地應(yīng)用于強化學(xué)習(xí)、模仿學(xué)習(xí)、以及動作識別等領(lǐng)域。Colome等人[91]的論文則是通過降維(線性)在學(xué)習(xí)潛在關(guān)節(jié)耦合過程的同時也進行擁有DMP特征的機器人運動,這實際上是很有價值的研究,因為這樣就直接提供了這種運動的最直觀的數(shù)學(xué)描述。Pervez和Lee[92]的論文提出了一個將DMP中的強迫項對應(yīng)的任務(wù)參數(shù)化進行建模的數(shù)學(xué)模型。Li等[93]對應(yīng)的論文則給出了一種基于高斯混合模型(GMM)和DMP的機器人強化版教學(xué)界面模型。所采集的這些動作是通過使用深度攝像頭Kinect v2傳感器從對應(yīng)的人體演示者身上采集,采用高斯混合模型(GMM)算法進行DMPs的計算,然后對運動進行建模和泛化。Amor等[94]的論文則描述了一種基于人體動作演示的模仿學(xué)習(xí)算法,主要是用于機器人學(xué)習(xí)和運用人體的抓取技能。他們將人類的抓取動作分解為三個部分:從人的教學(xué)演示中提取有效的物體抓取策略方法,將抓取策略對應(yīng)的抓取點遷移到新的待抓取物體上,對抓取動作進行優(yōu)化。使用他們的方法可以很容易的在機器人中加入新的抓取類型,因為用該算法使用者只需給出一組抓取實例。

在抓取過程中,由于空間有限以及障礙物等原因,會阻礙機器人接近目標(biāo)物體。這需要機器人與環(huán)境進行交互。在這種需要進行避障的抓取任務(wù)中,最常見的軌跡規(guī)劃方法是以抓取對象為中心建模的算法[95],它將目標(biāo)和環(huán)境分離開來。這種方法在結(jié)構(gòu)化或半結(jié)構(gòu)化的環(huán)境中工作得很好,因為對象被很好地分隔開了。還有一種以障礙物為中心的方法[96],它利用動作原語與多個對象進行同步聯(lián)系。通過這種方法,機器人可以在接觸和移動目標(biāo)的同時抓住目標(biāo),以清除所需的路徑。進一步的,Zeng等人[97]提出了一種更為優(yōu)越的方法,其采用了無模型的深度強化學(xué)習(xí)策略來提取抓與推之間的關(guān)系。他們的方法中包含了兩個卷積神經(jīng)網(wǎng)絡(luò),行為動作與視覺感知。這兩個網(wǎng)絡(luò)是在Q-learning框架下聯(lián)合訓(xùn)練的,完全是通過嘗試和錯誤的自我監(jiān)督,成功掌握后會獲得獎勵。通過仿真和真實場景下的抓取實驗,他們的系統(tǒng)可以快速地學(xué)習(xí)復(fù)雜的行為,在存在障礙物的情況獲得更高的抓取成功率和效率。

圖1-14 典型的軌跡規(guī)劃方法

從國內(nèi)外研究現(xiàn)狀可知,對于機器人領(lǐng)域中的特征提取、目標(biāo)識別與機器人抓取等方面均有一些熱點問題需要解決。具體的,在特征提取算法方面,鑒別力、魯棒性與計算效率方面依然有提升的可能;在目標(biāo)識別與機器人抓取方面,在具有噪聲、背景干擾與分辨率變化的非結(jié)構(gòu)化環(huán)境中的識別率與抓取的精度不夠理想。各個具體問題雖然均由大量的算法被提出,但是不少問題依然沒有被很好的處理。每一個問題都是三維視覺領(lǐng)域中亟待解決的熱點,期望大家可以給出新的方法進行解決。

責(zé)任編輯人:CC

-

機器人

+關(guān)注

關(guān)注

211文章

28632瀏覽量

208184

原文標(biāo)題:基于點云的機器人抓取識別綜述

文章出處:【微信號:vision263com,微信公眾號:新機器視覺】歡迎添加關(guān)注!文章轉(zhuǎn)載請注明出處。

發(fā)布評論請先 登錄

相關(guān)推薦

基于點云的機器人抓取過程詳解

基于點云的機器人抓取過程詳解

評論