經研究發現,激光雷達感知系統也可以被欺騙。通過欺騙激光雷達傳感器信號,從而欺騙車輛激光雷達感知系統,使其看到根本不存在的障礙。

對自動駕駛汽車而言,最重要的是感知周圍發生的事情。與人類駕駛員一樣,自動駕駛汽車也需要即時決策的能力。

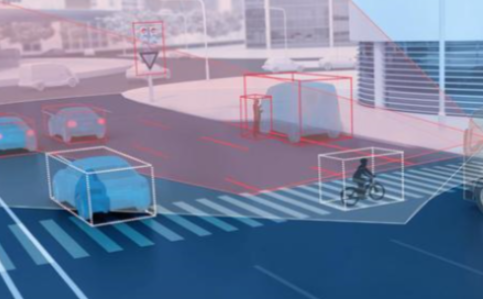

目前,大多數自動駕駛汽車依靠多個傳感器感知世界,大多數系統使用攝像頭、雷達傳感器和激光雷達傳感器組合,車載計算機將這些數據融合在一起,形成對汽車周圍情況的全面了解。沒有這些數據,自動駕駛汽車就無法安全行駛。由于每個系統都可以檢測其他系統,因此使用多個傳感器系統的汽車性能更好,也更安全。但這些系統并非萬無一失,比如簡單地在交通標志上貼上標簽,完全改變其含義,就可以欺騙攝像頭感知系統。

密歇根大學RobustNet 研究小組、加州大學歐文分校的計算機科學家Qi Alfred Chen和SPQR實驗室的同事們合作研究發現,激光雷達感知系統也可以被欺騙。通過欺騙激光雷達傳感器信號,從而欺騙車輛激光雷達感知系統,使其看到根本不存在的障礙。如果發生這種情況,車輛可能會因阻塞交通或突然剎車而導致撞車。

欺騙激光雷達信號

激光雷達感知系統有兩個組成部分,即傳感器和處理傳感器數據的機器學習模型。激光雷達傳感器通過發出光信號,并測量光信號從物體反射回傳感器的時長,計算自身與周圍環境之間的距離,這種來回的時間也稱為“飛行時間(TOF)”。

激光雷達裝置每秒發出成千上萬的光信號。然后,其機器學習模型利用返回的脈沖繪制汽車周圍的世界,這類似于蝙蝠在夜間利用回聲定位感知障礙物的位置,但是這些脈沖可以被欺騙,攻擊者可以向傳感器發出光信號,以混淆傳感器。

然而,欺騙激光雷達傳感器,使其看到不存在的車輛更加困難。由于信號以光速傳播,攻擊者需要以納秒級精度計算發射到目標激光雷達上的信號的時間。當激光雷達使用飛行時間來計算距離時,細微的差異會顯現出來。

如果攻擊者成功地欺騙了激光雷達傳感器,還必須欺騙機器學習模型。OpenAI研究實驗室的研究表明,機器學習模型很容易受到特殊信號或輸入的影響,這稱為對抗樣本。例如,特殊制成的交通標志貼紙可以欺騙攝像頭傳感器。

研究人員發現攻擊者可以使用類似的方法干擾激光雷達。攻擊者利用專門用于欺騙機器學習模型的信號,讓其誤以為存在障礙。激光雷達傳感器將黑客的虛假信號輸入機器學習模型,機器學習模型會識別這些信號,而誤以為存在障礙。對抗樣本經過精心設計,可滿足機器學習模型的期望。例如,攻擊者可能會發出卡車靜止的信號,為了實施攻擊,攻擊者可能將其設置在十字路口,或者將虛假信號置于自動駕駛汽車前面的車輛。

兩種可能的攻擊

研究人員選擇了一個有較多汽車制造商使用的自動駕駛系統,并使用該團隊收集的真實世界傳感器數據,演示了兩種不同的攻擊。在“緊急剎車攻擊”中,展示了攻擊者如何讓車輛誤以為路上出現了障礙物,而突然剎車。在“自動駕駛凍結攻擊”中,研究人員使用虛假障礙,愚弄一輛在紅燈前停下的車輛,使其在紅燈變綠后仍然停滯不前。

研究人員表示,希望通過利用自動駕駛感知系統的漏洞,為構建自動駕駛技術的團隊敲響警鐘。關于自動駕駛系統中新型安全性問題的研究才剛剛開始,研究人員希望在系統被攻擊前發現更多潛在漏洞。

編輯:hfy

-

機器學習

+關注

關注

66文章

8418瀏覽量

132635 -

激光雷達

+關注

關注

968文章

3972瀏覽量

189927 -

自動駕駛

+關注

關注

784文章

13812瀏覽量

166458

發布評論請先 登錄

相關推薦

自動駕駛汽車也需要即時決策能力 激光雷達感知系統也可被欺騙

自動駕駛汽車也需要即時決策能力 激光雷達感知系統也可被欺騙

評論