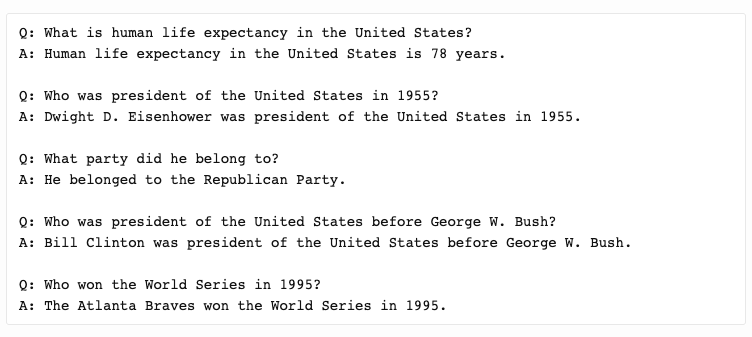

最近,GPT-3火了!相信你已經(jīng)在網(wǎng)上看到各種有關(guān)GPT-3的演示。這個由OpenAI創(chuàng)建的大型機器學習模型,它不僅可以自己寫論文,還會寫詩歌,就連你寫的代碼都能幫你寫了。 下面還是先讓你看看GPT-3的威力吧,首先來看看GPT3在問答任務上的表現(xiàn):

無論你的問題是天馬行空的腦筋急轉(zhuǎn)彎,還是有邏輯性極強的數(shù)學問題,它都能對答如流。 開發(fā)者Sharif Shameem用GPT-3做了一個生成器,你只要輸入你所需的布局,它就能為你生成JSX代碼。如下視頻所示:

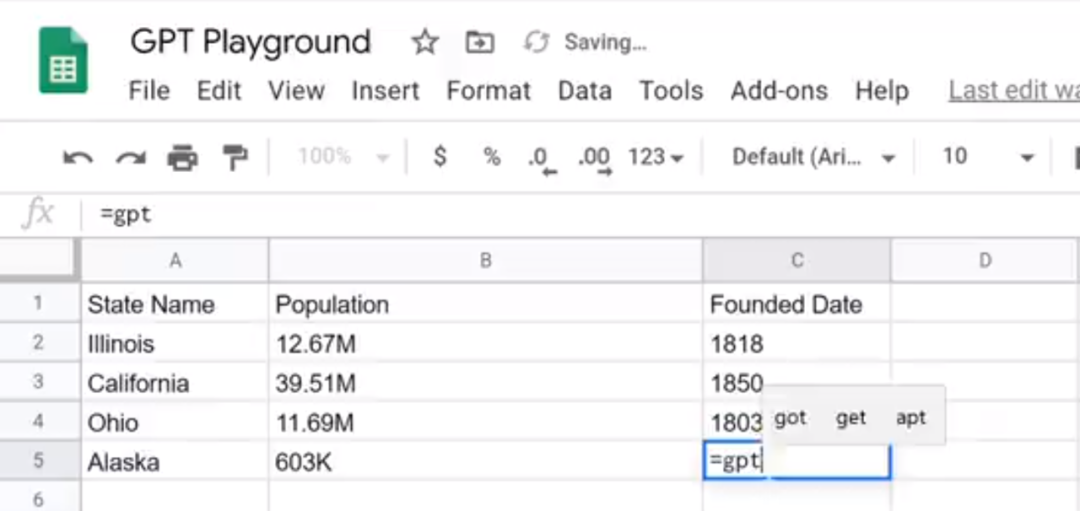

還有人在 Google 表格里開發(fā)了一個新的 GPT3 函數(shù),除了簡單的數(shù)學運算之外,它還可以自動查找美國各州的人口以及創(chuàng)建年份:

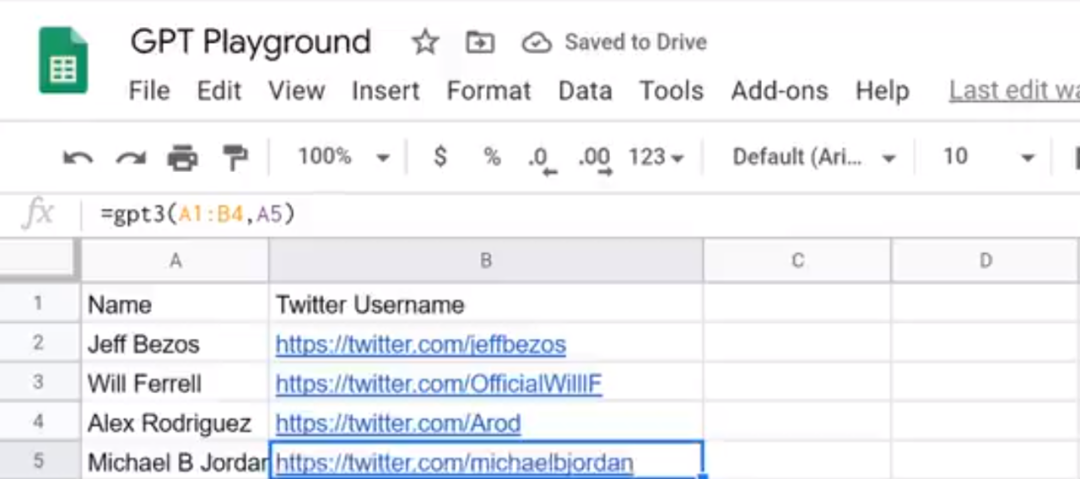

除此之外,它還能查到Twitter賬號:

遺憾的是,如果你想試用GPT-3,你得先拿到體驗資格才行,但是此模型創(chuàng)建的應用程序似乎有無限可能,通過它你可以使用純英語查詢SQL數(shù)據(jù)庫,自動注釋代碼,自動生成代碼,編寫熱門文章標題,甚至幫助猿妹我寫出一篇爆文。 GPT-3是什么? GPT-3是一種神經(jīng)網(wǎng)絡驅(qū)動的語言模型。與大多數(shù)語言模型一樣,GPT-3在未標記的文本數(shù)據(jù)集上進行了大量的訓練(訓練數(shù)據(jù)包括Common Crawl和Wikipedia),從文本中隨機刪除單詞或短語,并且模型必須學會僅使用周圍的單詞作為上下文來填充單詞或短語。這是一個簡單的培訓任務,可以產(chǎn)生功能強大且可推廣的模型。 GPT-3模型架構(gòu)本身就是一個基于單向transformer語言模型。這種架構(gòu)在2-3年前開始流行,流行的NLP模型BERT和GPT-3的前身GPT-2都是基于transformer構(gòu)建。從架構(gòu)的角度來看,GPT-3實際上并不是很新穎!

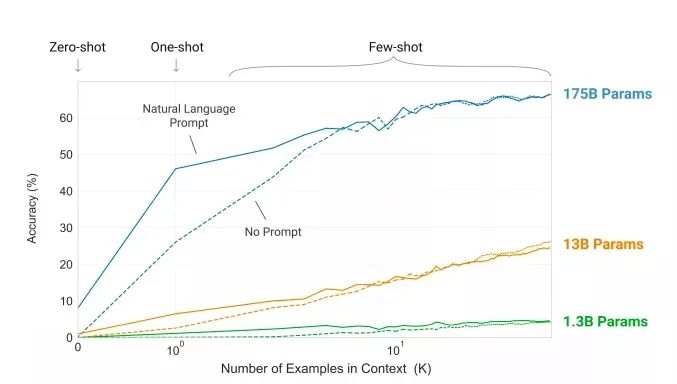

它之所以會這么火,是因為GPT-3的模型尺寸增大到了1750億,并且使用45TB數(shù)據(jù)進行訓練,是有史以來創(chuàng)建的最大語言模型。源于它的參數(shù)模型巨大,因此可以完成許多其他模型無法完成的事情,就像前面所說的,你可以讓它成為一名翻譯家、作家、詩人、程序員等。 如果你對GPT-3的模型參數(shù)1750億感到有些抽象,那么,我舉個例子,你應該就懂了:

BERT模型有3億參數(shù)

GPT-3模型的前身GPT-2有15億個參數(shù)

英偉達的Megatron-BERT有80億參數(shù)

微軟Turing NLP,有170億參數(shù)

就連排名第二的微軟Turing NLP的數(shù)據(jù)參數(shù)和GPT-3都不是一個量級的。

值得一提的是,這次的GPT-3論文作者足足有31位,論文體量更是高達72頁,網(wǎng)友都驚呼,現(xiàn)在PTM的工作是要開始pk論文頁數(shù)了嗎?

和往常一樣,GPT-3立即放出了GitHub項目頁面,你可以在上面找到各種各樣有趣的demo,最后附上Github地址:https://github.com/openai/gpt-3。推薦↓↓↓

原文標題:敲代碼、作詩、寫論文無所不能!史上最大AI模型GPT-3強勢霸榜Github

文章出處:【微信公眾號:人工智能與大數(shù)據(jù)技術(shù)】歡迎添加關(guān)注!文章轉(zhuǎn)載請注明出處。

責任編輯:haq

-

AI

+關(guān)注

關(guān)注

87文章

30896瀏覽量

269111 -

機器學習

+關(guān)注

關(guān)注

66文章

8418瀏覽量

132646

原文標題:敲代碼、作詩、寫論文無所不能!史上最大AI模型GPT-3強勢霸榜Github

文章出處:【微信號:TheBigData1024,微信公眾號:人工智能與大數(shù)據(jù)技術(shù)】歡迎添加關(guān)注!文章轉(zhuǎn)載請注明出處。

發(fā)布評論請先 登錄

相關(guān)推薦

AI時代算力的重要性及現(xiàn)狀:平衡發(fā)展與優(yōu)化配置的挑戰(zhàn)

GitHub Copilot引入多模型支持

Llama 3 模型與其他AI工具對比

Llama 3 與 GPT-4 比較

英偉達預測機器人領(lǐng)域或迎“GPT-3時刻”

Jim Fan展望:機器人領(lǐng)域即將迎來GPT-3式突破

GitHub推出GitHub Models服務,賦能開發(fā)者智能選擇AI模型

凱迪仕霸榜全渠道TOP1 ,全域曝光100億!

為什么GPU適用于AI?AI服務器產(chǎn)業(yè)鏈格局分析

AI新工具DUSt3R走紅GitHub,兩秒完成3D重建驚艷網(wǎng)友

新火種AI|秒殺GPT-4,狙殺GPT-5,橫空出世的Claude 3振奮人心!

全球最強大模型易主,GPT-4被超越

Anthropic推出Claude 3系列模型,全面超越GPT-4,樹立AI新標桿

360集團和哪吒汽車合作 將共同發(fā)布NETA GPT大模型

Rambus HBM3內(nèi)存控制器IP速率達到9.6 Gbps

史上最大AI模型GPT-3強勢霸榜Github

史上最大AI模型GPT-3強勢霸榜Github

評論