EC改進方案選型

接上篇,介紹一下整個容災方案在性能和可靠性方面如何做驗證。

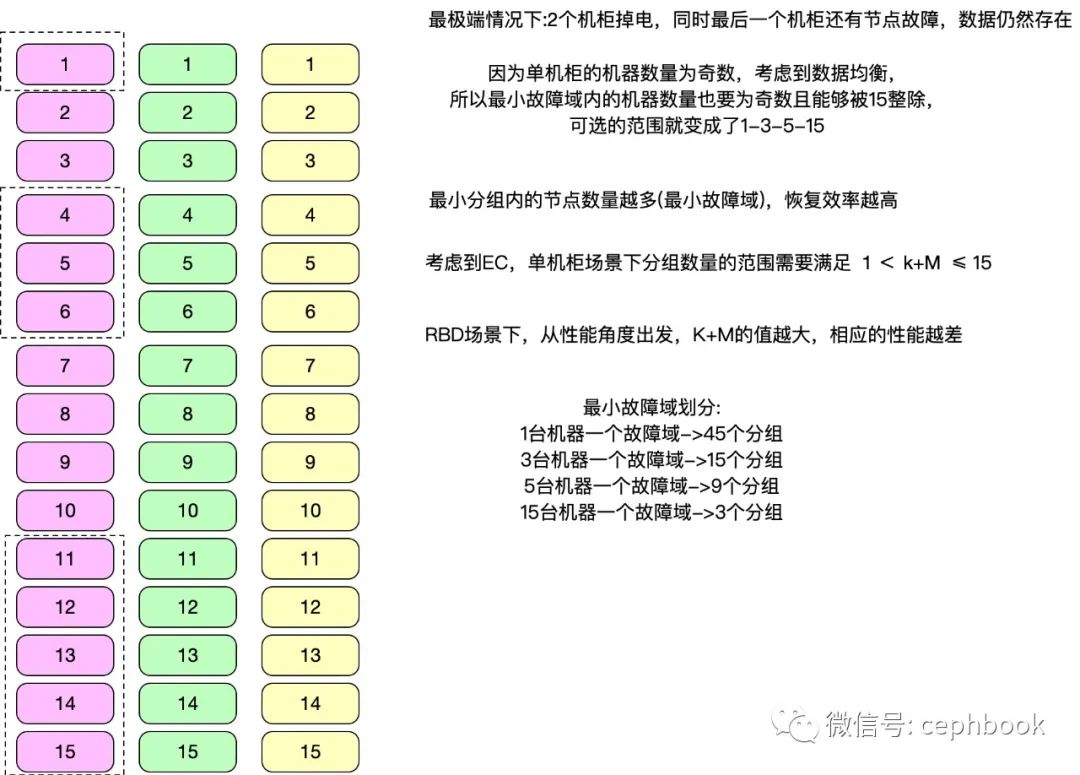

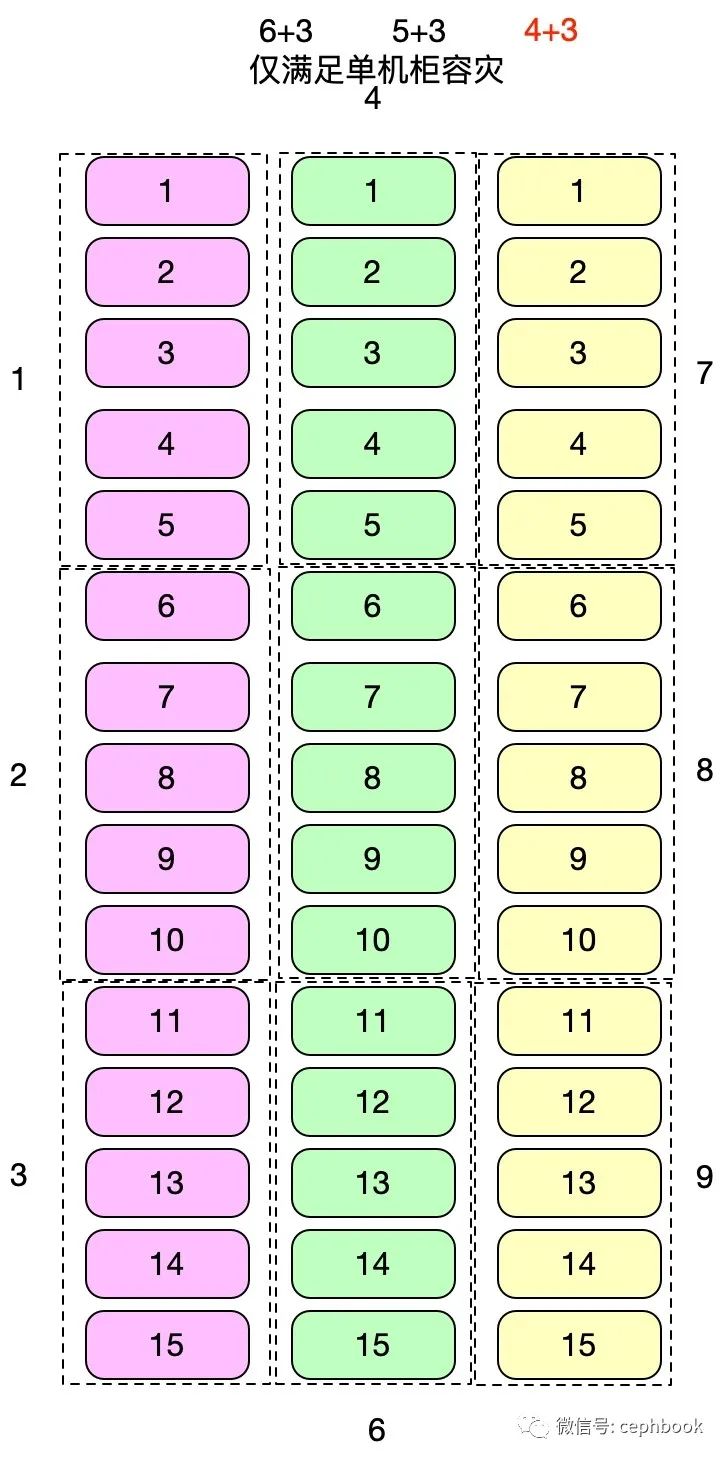

3個機柜,每個機柜15臺機器,總共45臺,需要在RBD場景下,找到成本、性能、數據可靠性的三者平衡點。

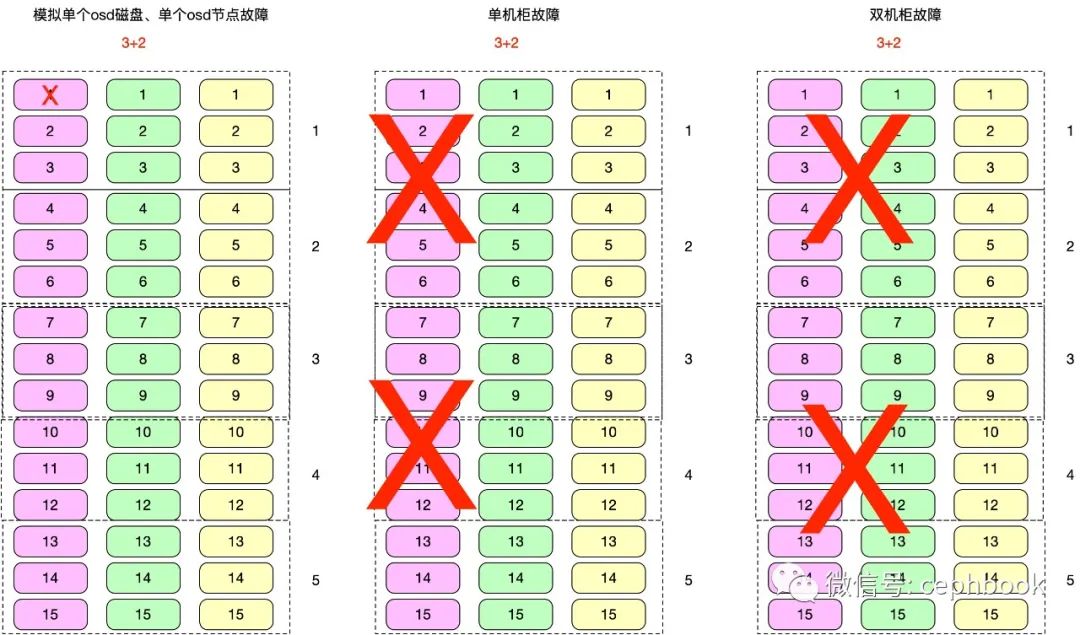

跨機柜容災方案1

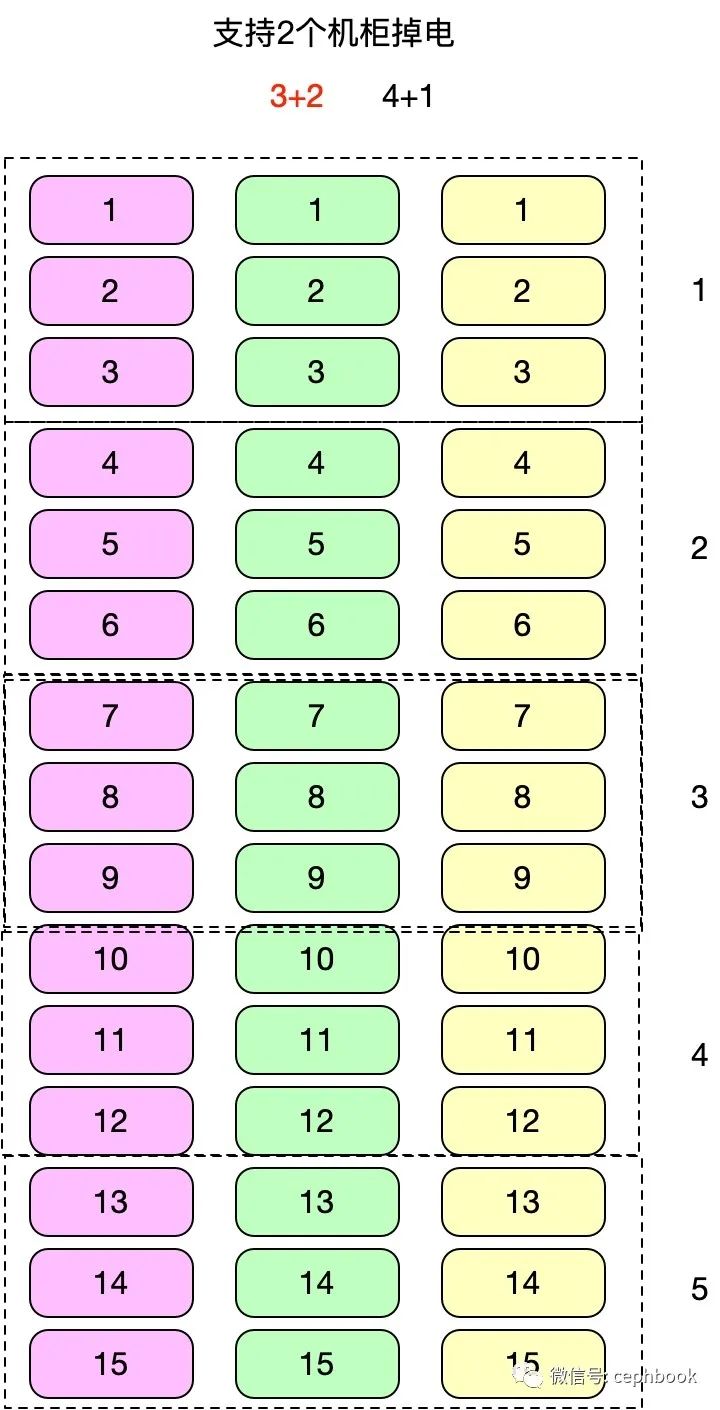

支持2個機柜級別的容災,跨3個機柜單個分組共9個節點,共5個分組,對應的理論收益情況如下

| 名稱 | K | M | D | 3副本得盤率 | EC得盤率 | 硬件成本節約比率 | 磁盤數據遷移量(ISA) | 磁盤數據遷移量(CLAY) | 數據恢復負載降低比率 |

|---|---|---|---|---|---|---|---|---|---|

| 3+2 | 3 | 2 | 4 | 33.33333333 | 60 | 180 | 3 | 2 | 33.33333333 |

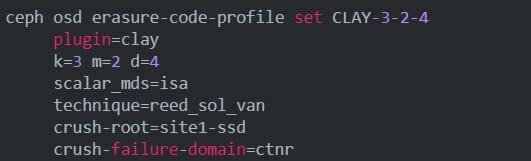

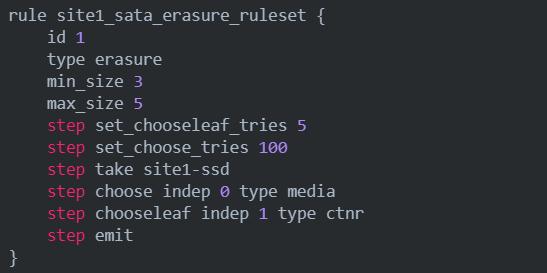

對應的crush rule如下

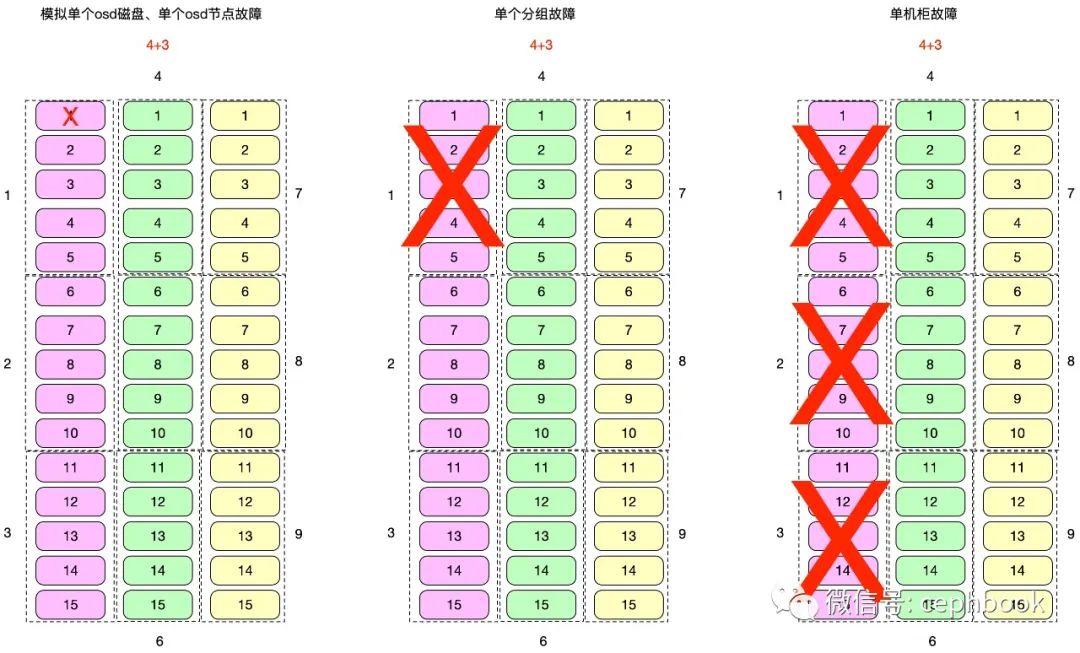

單機柜容災方案2

支持1個機柜級別的容災,單個分組共5個節點,共9個分組,對應的理論收益情況如下

| 名稱 | K | M | D | 3副本得盤率 | EC得盤率 | 硬件成本節約比率 | 磁盤數據遷移量(ISA) | 磁盤數據遷移量(CLAY) | 數據恢復負載降低比率 |

|---|---|---|---|---|---|---|---|---|---|

| 4+3 | 4 | 3 | 6 | 33.33333333 | 57.14285714 | 171.4285714 | 4 | 2 | 50 |

| 5+3 | 5 | 3 | 7 | 33.33333333 | 62.5 | 187.5 | 5 | 2.333333333 | 53.33333333 |

| 6+3 | 6 | 3 | 8 | 33.33333333 | 66.66666667 | 200 | 6 | 2.666666667 | 55.55555556 |

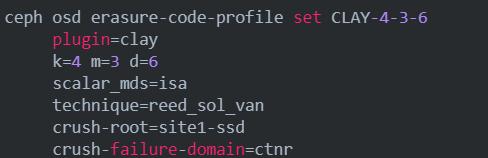

從性能最優原則,K+M總和最小則對應的理論性能最優,所以單機柜容災模型下,4+3成為最優方案。

對應的ec配置如下

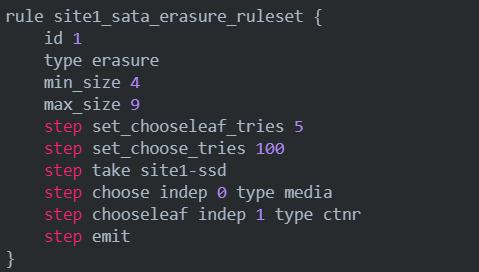

對應的crush rule如下

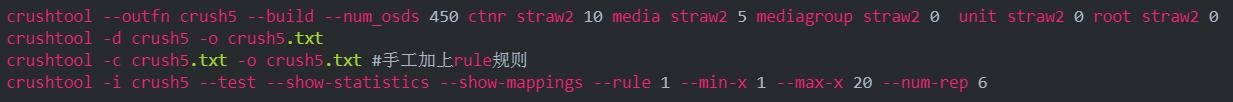

crush rule的生成與rule的驗證模擬

容災能力測試場景

性能測試

RBD場景,模擬大、小文件,順序/隨機讀寫,獲取對應的fio性能基準數據,對比3副本與EC的性能差距。

3副本 vs CLAY_3+2 vs CLAY_4+3

| 場景名稱 | iops | 帶寬 | 90th延時 | 99th延時 | 備注 |

|---|---|---|---|---|---|

| 3副本-4M順序讀 | |||||

| 3+2-4M順序讀 | |||||

| 4+3-4M順序讀 | |||||

| 3副本-4M順序寫 | |||||

| 3+2-4M順序寫 | |||||

| 4+3-4M順序寫 | |||||

| 3副本-4k隨機寫 | |||||

| 3+2-4k隨機寫 | |||||

| 4+3-4k隨機寫 | |||||

| 3副本-4k隨機讀 | |||||

| 3+2-4k隨機讀 | |||||

| 4+3-4k隨機讀 |

故障恢復效率

前置條件:集群提前寫入容量60%,模擬已有數據場景

目標:對比ISA和CLAY在K+M相同的情況下,RBD場景下持續讀寫數據,模擬單塊OSD、單個OSD節點故障、多個OSD節點故障(可選),數據遷移所需的時長,同時記錄對應的CPU、內存、網卡負載消耗情況,以及性能波動情況。

容災能力

前置條件:集群提前寫入容量60%,模擬已有數據場景

目標:RBD場景下持續讀寫數據,模擬最小故障域、單機柜、雙機柜故障,記錄對應的性能波動情況,考察在極端情況下整個集群的服務可用性和數據可靠性。

跨機柜容災方案1

單機柜容災方案2

責任編輯:xj

原文標題:Ceph最新的EC-CLAY插件調研-下

文章出處:【微信公眾號:Ceph對象存儲方案】歡迎添加關注!文章轉載請注明出處。

-

機柜

+關注

關注

0文章

46瀏覽量

10386 -

容災實現

+關注

關注

0文章

2瀏覽量

6742 -

Ceph

+關注

關注

1文章

22瀏覽量

9421

原文標題:Ceph最新的EC-CLAY插件調研-下

文章出處:【微信號:cephbook,微信公眾號:Ceph對象存儲方案】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

相關推薦

EC-Master 支持 Xenomai 4 了!實時性與可靠性再升級

如何測試光耦的性能與可靠性

不同制造商TOPCon光伏組件的老化測試:性能、穩定性與可靠性

GaN可靠性測試新突破:廣電計量推出高壓性能評估方案

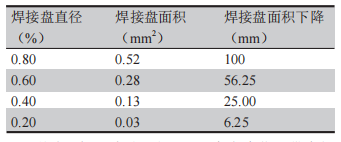

PCB高可靠性化要求與發展——PCB高可靠性的影響因素(上)

基于可靠性設計感知的EDA解決方案

汽車功能安全與可靠性的關系

DCAC電源模塊:效率與可靠性兼備的能源轉換解決方案

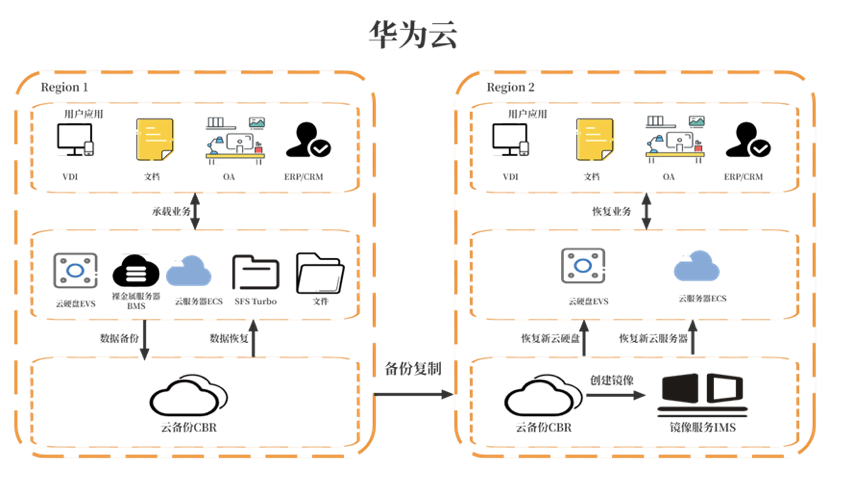

華為云 618 營銷季來襲,數據災備方案為云端業務筑牢安全防線

半導體封裝技術的可靠性挑戰與解決方案

谷景成功為客戶汽車雙滑軌項目提供電感替代方案

數倉中搭建細粒度容災應用的主要步驟

EC改進方案選型:容災方案在性能和可靠性方面如何做驗證

EC改進方案選型:容災方案在性能和可靠性方面如何做驗證

評論