01

研究背景及動機

近些年,元學習已經成為解決小樣本問題的主流技術,并且取得不錯的成果。然而,由于現有的元學習方法大多數集中在圖像分類上,而對文本分類上的關注比較少。與圖像不同,同一類別中文本具有多種表達方式,這使得當前元學習方法的性能更容易受到每個類別樣本數(即shot的數量)的影響。因此,現有的元學習方法很難在小樣本文本分類上取得令人滿意的結果。

為了解決這個問題,我們在元學習中引入了數據增強,它帶來的好處是我們可以產生增強樣本以增加新類別的樣本數量,并使訓練樣本多樣化。然而,這帶來了一個新的挑戰,如何在小樣本的情況下產生置信度高的樣本?

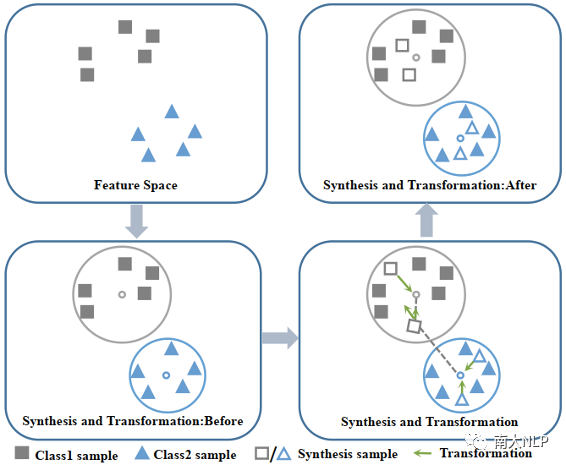

為此,我們提出了一種新穎的數據增強方法,稱為Ball generator,圖1給出了一個簡單的例子。首先,我們計算支持集的最小包圍球,并在該球中合成樣本。我們認為該球中的樣本具有較高的置信度,因為所有支持集樣本都包含在該球中,并且它們與球心的最遠距離最小。

其次,為避免合成樣本偏差的影響,我們引入了變換模塊,以使合成樣本靠近自己的球心,并遠離其他球心。此外,我們還提出了一個新的基于數據增強的元學習框架(MEta-Learning with Data Augmentation,MEDA),以聯合訓練ball generator和meta-learner,使二者協同進化。與普通元學習相比,通過增加新類別的樣本數量,有效地提高了meta-learning在小樣本情況下的泛化能力。

圖1:Ball generator示例

02

MEDA

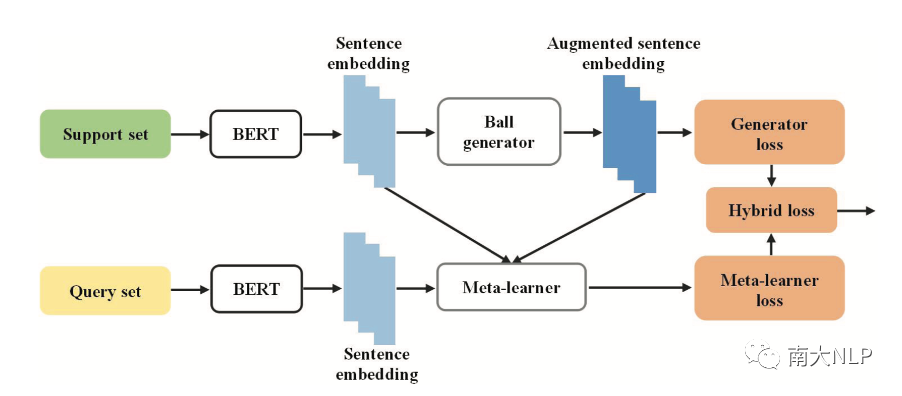

MEDA的框架如圖2所示。它是兩模塊組成:一個是ball generator模塊,它負責利用支持集生成增強支持集,并得到擴展支持集。另一個模塊是meta-learner,它在給定了擴展支持集的條件下計算每個查詢實例在類別上的概率分布,表示為。而不同的meta-learner的區別在于如何實現。這里我們選擇原型網絡和關系網絡作為MEDA的meta-learner。

圖2: MEDA

其中,ball generator是一種特征空間數據增強方法。它的核心思想是在特征空間中進行樣本的合成,并對合成的樣本進行調整。因此,整個ball generator由兩個子模塊組成:合成模塊和變換模塊。

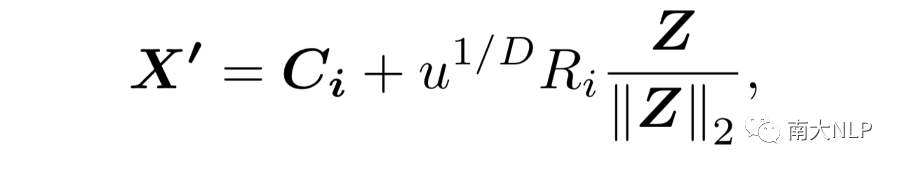

合成模塊利用空間采樣算法獲得相應的合成樣本。具體是將采樣空間限制為支持集的最小包圍球,這里是球心,是半徑。然后,通過如下公式計算得到合成樣本:

這里,和。

變換模塊,它是為了進一步避免合成樣本偏差的影響,在特征空間中對合成的樣本進行變換操作,使合成樣本更接近自己類別的球心,而遠離其他球心。因此,我們將變換操作寫成函數,該函數以合成樣本作為輸入,產生一個增強樣本作為輸出。

03

實驗

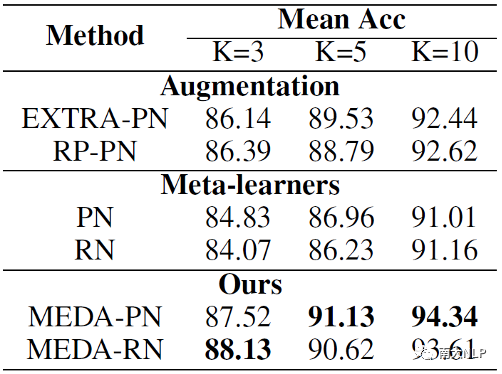

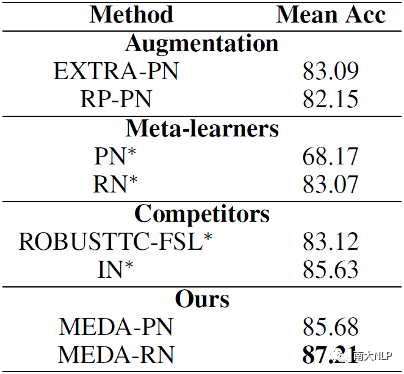

本文的實驗是在SNIPS和ARSC數據集上進行的。我們將MEDA與三組baseline模型進行了比較。第一組是數據增強的模型;第二組是傳統的元學習模型;第三組是最新的小樣本文本分類的SOTA模型。實驗結果如表1和2所示。

表1:SNIPS實驗結果

表2: ARSC實驗結果

從實驗結果上來看,由于通過數據增強獲得更多的訓練樣本,使得MEDA在兩個數據集上都取得一致且顯著的提升。

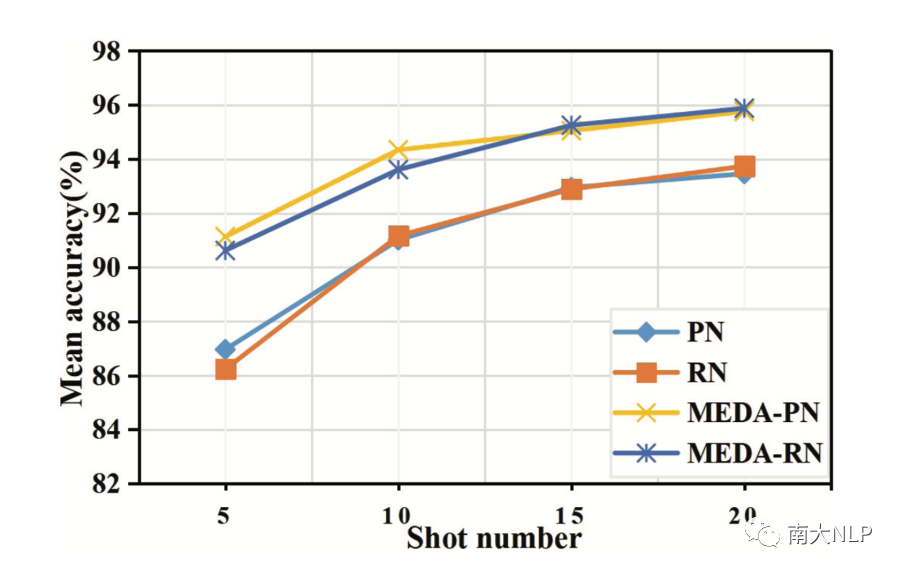

為了更進一步說明模型的shot數量對模型的影響,我們設計相應的實驗。如圖3所示,我們可以觀察到MEDA在所有設置中都取得了最好的表現。特別地,MEDA的準確率隨著shot數量的減少而增加(間距變大),這表明當shot數相對較小時,模型效果的提升更明顯。

圖3: 不同shot數量對模型準確率的影響

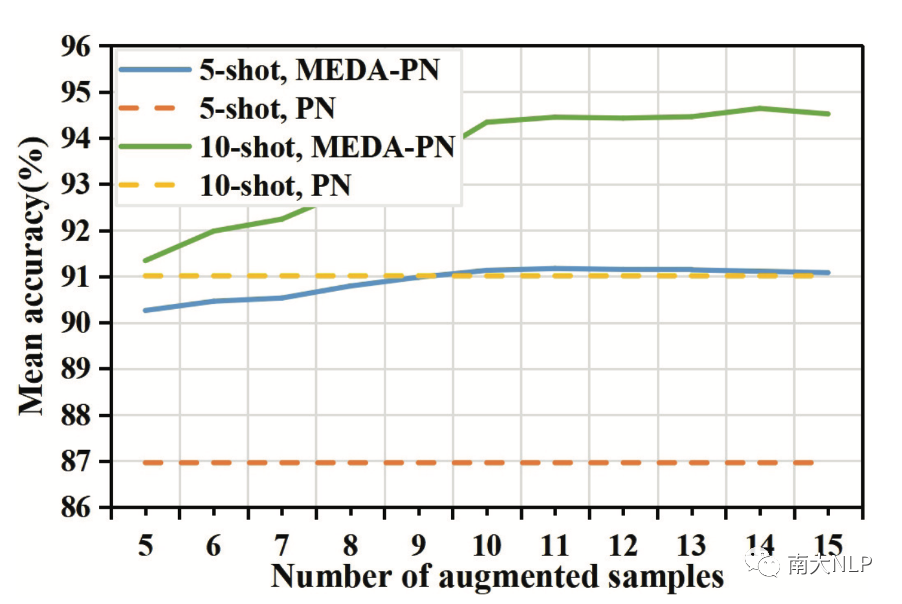

此外,我們還研究了模型的準確性如何隨著增強樣本數量的變化而變化。我們畫出不同模型在SNIPS數據集上的準確率變化情況。如圖4所示:

圖4: 不同模型的平均準確率隨增強樣本數量的變化而變化

可以看到,隨著增強樣本數量的增加,模型的準確率有所提高。同時,我們比較5-shot和10-shot的實驗設置,我們發現通過模型增強5個樣本與使用5個真實樣本的效果幾乎相同,這意味著我們的MEDA不是簡單地復制樣本,而是為模型生成有意義的樣本。

04

—

總結

在本文中,我們提出了一種新穎的數據增強方法,稱為ball generator,以增加新類別的樣本數量。此外,我們還提出了一個新的框架MEDA,該框架聯合優化了ball generator和meta-learner,從而使ball generator可以學習生成最適合meta-learner的增強樣本。更多的細節、結果以及分析請參考原論文。

編輯:jq

-

數據

+關注

關注

8文章

7104瀏覽量

89288 -

函數

+關注

關注

3文章

4343瀏覽量

62809

原文標題:IJCAI2021論文:MEDA:一種為小樣本文本分類設計的結合數據增強的元學習框架

文章出處:【微信號:zenRRan,微信公眾號:深度學習自然語言處理】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

相關推薦

HarmonyOS NEXT應用元服務開發Intents Kit(意圖框架服務)習慣推薦方案概述

HarmonyOS NEXT應用元服務開發Intents Kit(意圖框架服務)本地搜索方案概述

利用TensorFlow實現基于深度神經網絡的文本分類模型

增強現實是虛實結合嗎為什么

卷積神經網絡在文本分類領域的應用

基于助聽器開發的一種高效的語音增強神經網絡

基于神經網絡的呼吸音分類算法

基于深度學習的鳥類聲音識別系統

基于毫米波的人體跟蹤和識別算法

一種利用光電容積描記(PPG)信號和深度學習模型對高血壓分類的新方法

檢索增強生成(RAG)如何助力企業為各種企業用例創建高質量的內容?

一種高效的KV緩存壓縮框架--GEAR

一種為小樣本文本分類設計的結合數據增強的元學習框架

一種為小樣本文本分類設計的結合數據增強的元學習框架

評論