二、應用場景舉例

1、股票漲跌預測

放量+高換手率 -> 大概率上漲,歷史數據挖掘,假如發現放量+高換手率的股票大概率上漲,則挖掘當天滿足條件的個股,然后第二天買入,躺賺。2、視頻、音樂、圖書等推薦

根據歷史數據,如果大規模的存在某些用戶看劇列表為:小時代 -> 上海堡壘,那么一個新的用戶看了小時代,馬上就給推薦上海堡壘,那大概率也會被觀看,呼蘭的賬號,就是這么臟的。3、打車路線預測(考慮時空)

根據大量的數據挖掘出以下規則早上:起點家->目的地公司,晚上:起點家->目的高鐵站周末:起點家->目的地購物中心那當你每天早上打開軟件的時候,打車軟件就會推薦你的公司作為目的地,大大的減少用戶的打車時間。如下圖,我輸入小區名稱,馬上給我推薦了三個地方,杭州東站第一位,因為平時的打車這個組合的支持度最高。

4、風控策略自動化挖掘

根據歷史標題,總結出規律發現商品標題包含 老司機+百度網盤 -> 色情風險高,那后面遇到這標題包含這兩個詞語的,就直接拒絕了。 根據歷史行為數據,發現了沉默用戶+非常用地登錄+修改密碼->大概率都被盜號了,那一個新的賬戶滿足這個三個條件,那馬上就進行賬戶凍結或者實人認證,就能避免盜號風險的發生。 根據歷史數據,發現用戶A +B 每天都相隔10s登錄 ,則可以認為A、B存在關聯關系,可能是機器控制的同一批薅羊毛賬戶。風控策略的自動化挖掘,這個也是我們后續要重點關注和講解的地方。三、3個最重要的概念

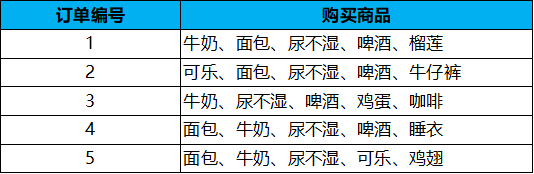

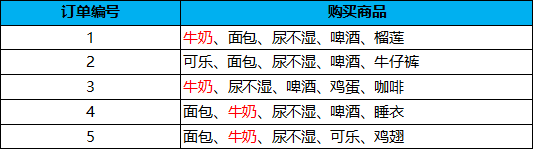

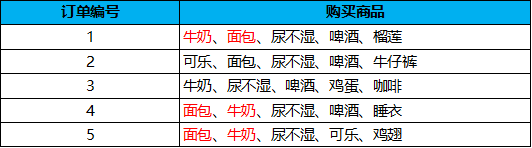

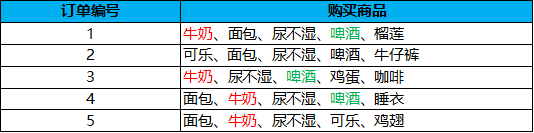

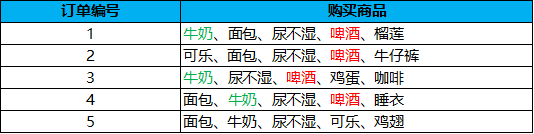

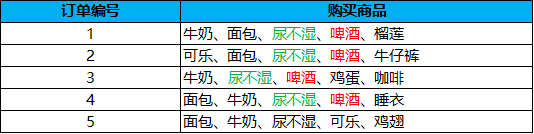

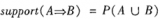

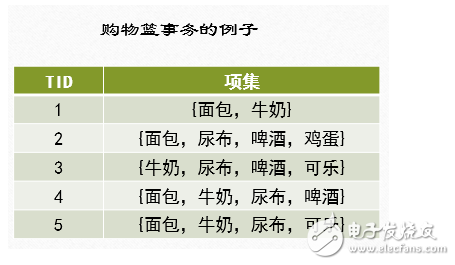

關聯規則有三個核心概念需要理解:支持度、置信度、提升度,下面用最經典的啤酒-尿不濕案例給大家舉例說明這三個概念,假如以下是幾名客戶購買訂單的商品列表:

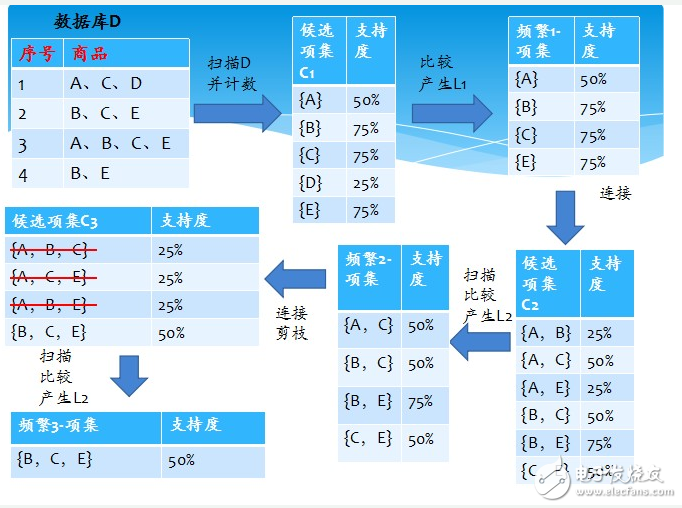

1、支持度

支持度 (Support):指某個商品組合出現的次數與總訂單數之間的比例。在這個例子中,我們可以看到“牛奶”出現了 4 次,那么這 5 筆訂單中“牛奶”的支持度就是 4/5=0.8。

同樣“牛奶 + 面包”出現了 3 次,那么這 5 筆訂單中“牛奶 + 面包”的支持度就是 3/5=0.6

同樣“牛奶 + 面包”出現了 3 次,那么這 5 筆訂單中“牛奶 + 面包”的支持度就是 3/5=0.6

這樣理解起來是不是非常簡單了呢,大家可以動動手計算下 '尿不濕+啤酒'的支持度是多少?

2、置信度

置信度 (Confidence):指的就是當你購買了商品 A,會有多大的概率購買商品 B,在包含A的子集中,B的支持度,也就是包含B的訂單的比例。置信度(牛奶→啤酒)= 3/4=0.75,代表購買了牛奶的訂單中,還有多少訂單購買了啤酒,如下面的表格所示。

置信度(啤酒→牛奶)= 3/4=0.75,代表如果你購買了啤酒,有多大的概率會購買牛奶?

置信度(啤酒→牛奶)= 3/4=0.75,代表如果你購買了啤酒,有多大的概率會購買牛奶? 置信度(啤酒→尿不濕)= 4/4=1.0,代表如果你購買了啤酒,有多大的概率會買尿不濕,下面的表格看出來是100%。

置信度(啤酒→尿不濕)= 4/4=1.0,代表如果你購買了啤酒,有多大的概率會買尿不濕,下面的表格看出來是100%。

由上面的例子可以看出,置信度其實就是個條件概念,就是說在 A 發生的情況下,B 發生的概率是多大。如果僅僅知道這兩個概念,很多情況下還是不夠用,需要用到提升度的概念。比如A出現的情況下B出現的概率為80%,那到底AB是不是有關系呢,不一定,人家B本來在大盤中的比例95%。你的A出現,反而減少了B出現的概率。

3、提升度

提升度 (Lift):我們在做商品推薦或者風控策略的時候,重點考慮的是提升度,因為提升度代表的是A 的出現,對B的出現概率提升的程度。提升度 (A→B) = 置信度 (A→B)/ 支持度 (B)所以提升度有三種可能:-

提升度 (A→B)>1:代表有提升;

-

提升度 (A→B)=1:代表有沒有提升,也沒有下降;

-

提升度 (A→B)<1:代表有下降。

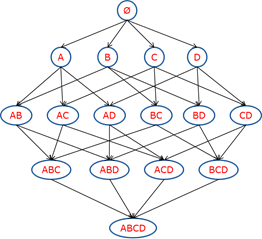

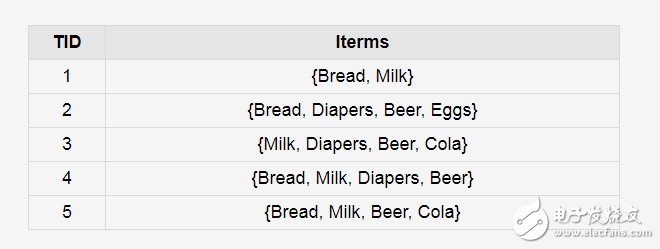

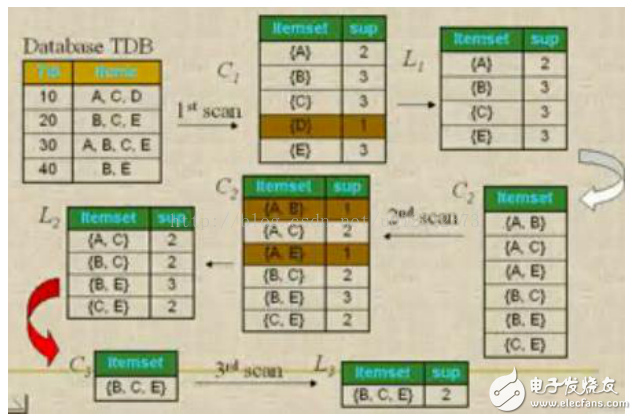

4、頻繁項集

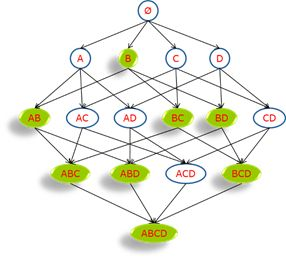

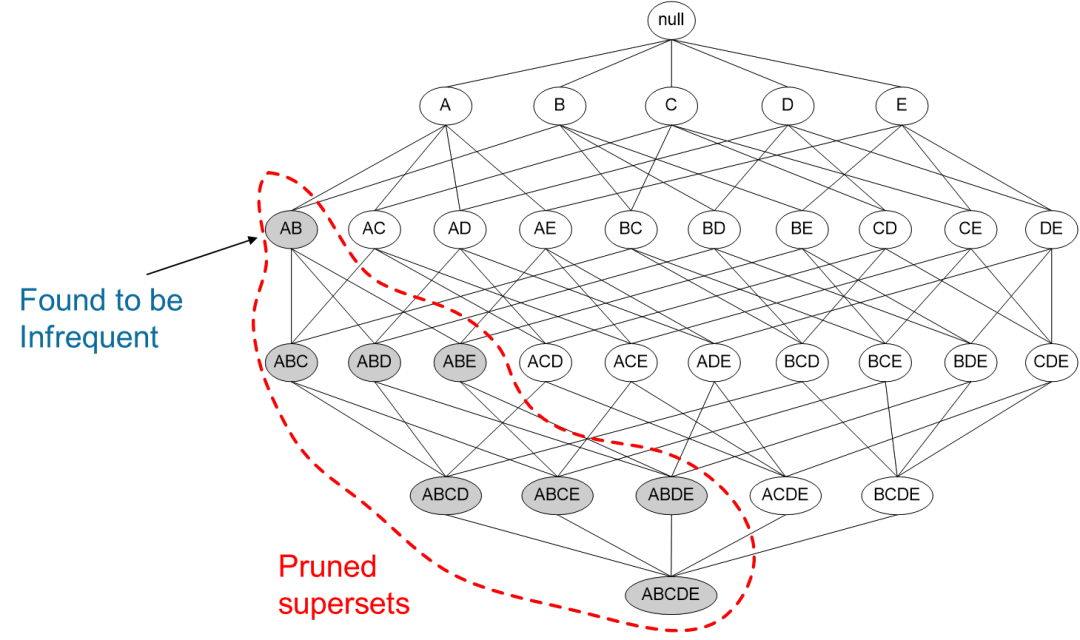

頻繁項集(frequent itemset) :就是支持度大于等于最小支持度 (Min Support) 閾值的項集,所以小于最小值支持度的項目就是非頻繁項集,而大于等于最小支持度的的項集就是頻繁項集,項集可以是單個商品,也可以是組合。頻繁集挖掘面臨的最大難題就是項集的組合爆炸,如下圖:

隨著商品數量增多,這個網絡的規模將變得特別龐大,我們不可能根據傳統方法進行統計和計算,為了解決這個問題,Apriori算法提出了兩個核心思想:

某個項集是頻繁的,那么它的所有子集也是頻繁的{Milk, Bread, Coke} 是頻繁的 → {Milk, Coke} 是頻繁的如果一個項集是 非頻繁項集,那么它的所有超集也是非頻繁項集

{Battery} 是非頻繁的 → {Milk, Battery} 也非平凡

如下圖,如果我們已知B不頻繁,那么可以說圖中所有綠色的項集都不頻繁,搜索時就要這些項避開,減少計算開銷。

同理,如果下圖所示,{A,B}這個項集是非頻繁的,那虛線框后面的都不用計算了,運用Apriori算法的思想,我們就能去掉很多非頻繁的項集,大大簡化計算量,當然,面對大規模數據的時候,這種排除還是解決不了問題,于是還有FP-Growth(Frequent pattern Growth,頻繁模式增長樹)這種更高效的方法,后面有機會慢慢講。

需要注意的是:

1)如果支持度和置信度閾值過高,雖然可以在一定程度上減少數據挖掘的時間,但是一些隱含在數據中的非頻繁特征項容易被忽略掉,難以發現足夠有用的規則;2)如果支持度和置信度閾值過低,可能會導致大量冗余和無效的規則產生,導致較大計算量負荷。四、Python算法介紹

這里用的是Python舉例,用的包是apriori,當然R語言等其他語言,也有對應的算法包,原理都是一樣的,大家自行進行試驗。

#包安裝我們使用efficient-apriori,python中也可以利用apyori庫和mlxtend庫

pipinstallefficient-apriori

#加載包

fromefficient_aprioriimportapriori

‘’‘

apriori(transactions:typing.Iterable[typing.Union[set,tuple,list]],

min_support:float=0.5,

min_confidence:float=0.5,

max_length:int=8,

verbosity:int=0,

output_transaction_ids:bool=False)

上面就是這個函數的參數

min_support:最小支持度

min_confidence:最小置信度

max_length:項集長度

‘’‘

#構造數據集

data=[('牛奶','面包','尿不濕','啤酒','榴蓮'),

('可樂','面包','尿不濕','啤酒','牛仔褲'),

('牛奶','尿不濕','啤酒','雞蛋','咖啡'),

('面包','牛奶','尿不濕','啤酒','睡衣'),

('面包','牛奶','尿不濕','可樂','雞翅')]

#挖掘頻繁項集和頻繁規則

itemsets,rules=apriori(data,min_support=0.6,min_confidence=1)

#頻繁項集

print(itemsets)

{1:{('啤酒',):4,('尿不濕',):5,('牛奶',):4,('面包',):4},

2:{('啤酒','尿不濕'):4,('啤酒','牛奶'):3,('啤酒','面包'):3,('尿不濕','牛奶'):4,('尿不濕','面包'):4,('牛奶','面包'):3},

3:{('啤酒','尿不濕','牛奶'):3,('啤酒','尿不濕','面包'):3,('尿不濕','牛奶','面包'):3}}

itemsets[1]#滿足條件的一元組合

{('啤酒',):4,('尿不濕',):5,('牛奶',):4,('面包',):4}

itemsets[2]#滿足條件的二元組合

{('啤酒','尿不濕'):4,('啤酒','牛奶'):3,('啤酒','面包'):3,('尿不濕','牛奶'):4,('尿不濕','面包'):4,('牛奶','面包'):3}

itemsets[3]#滿足條件的三元組合

{('啤酒','尿不濕','牛奶'):3,('啤酒','尿不濕','面包'):3,('尿不濕','牛奶','面包'):3}

#頻繁規則

print(rules)

[{啤酒}->{尿不濕},{牛奶}->{尿不濕},

{面包}->{尿不濕},{啤酒,牛奶}->{尿不濕},

{啤酒,面包}->{尿不濕},{牛奶,面包}->{尿不濕}]

#我們把max_length=2這個參數加進去看看

itemsets,rules=apriori(data,min_support=0.6,

min_confidence=0.5,

max_length=2)

#頻繁項集

print(itemsets)

{1:{('牛奶',):4,('面包',):4,('尿不濕',):5,('啤酒',):4,('R',):4},

2:{('R','啤酒'):4,('R','尿不濕'):4,('R','牛奶'):3,('R','面包'):3,('啤酒','尿不濕'):4,('啤酒','牛奶'):3,('啤酒','面包'):3,('尿不濕','牛奶'):4,('尿不濕','面包'):4,('牛奶','面包'):3}}

#通過這個數據我們可以看到,項集的長度只包含有兩個項了

五、挖掘實例

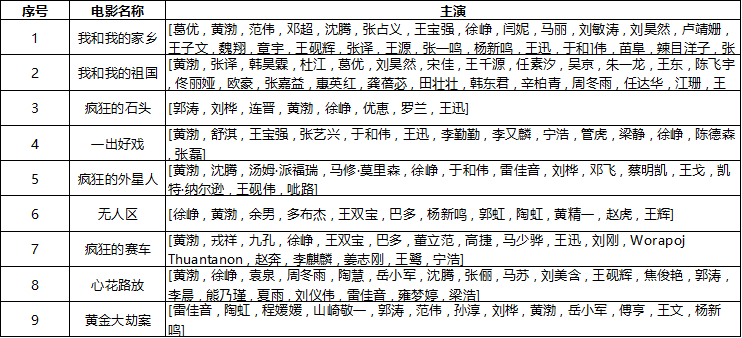

每個導演都有自己的偏好、比如周星馳有星女郎,張藝謀有謀女郎,且鞏俐經常在張藝謀的電影里面出現,因此,每個導演對演員的選擇都有一定的偏愛,我們以寧浩導演為例,分析下選擇演員的一些偏好,沒有找到公開的數據集,自己手動扒了一部分,大概如下,有些實在有點多,于是簡化下進行分析。

可以看到,我們一共扒了9部電影,計算的時候,支持度的時候,總數就是9.

#把電影數據轉換成列表

data=[['葛優','黃渤','范偉','鄧超','沈騰','張占義','王寶強','徐崢','閆妮','馬麗'],

['黃渤','張譯','韓昊霖','杜江','葛優','劉昊然','宋佳','王千源','任素汐','吳京'],

['郭濤','劉樺','連晉','黃渤','徐崢','優恵','羅蘭','王迅'],

['黃渤','舒淇','王寶強','張藝興','于和偉','王迅','李勤勤','李又麟','寧浩','管虎','梁靜','徐崢','陳德森','張磊'],

['黃渤','沈騰','湯姆·派福瑞','馬修·莫里森','徐崢','于和偉','雷佳音','劉樺','鄧飛','蔡明凱','王戈','凱特·納爾遜','王硯偉','呲路'],

['徐崢','黃渤','余男','多布杰','王雙寶','巴多','楊新鳴','郭虹','陶虹','黃精一','趙虎','王輝'],

['黃渤','戎祥','九孔','徐崢','王雙寶','巴多','董立范','高捷','馬少驊','王迅','劉剛','WorapojThuantanon','趙奔','李麒麟','姜志剛','王鷺','寧浩'],

['黃渤','徐崢','袁泉','周冬雨','陶慧','岳小軍','沈騰','張儷','馬蘇','劉美含','王硯輝','焦俊艷','郭濤'],

['雷佳音','陶虹','程媛媛','山崎敬一','郭濤','范偉','孫淳','劉樺','黃渤','岳小軍','傅亨','王文','楊新鳴']]

#算法應用

itemsets,rules=apriori(data,min_support=0.5,min_confidence=1)

print(itemsets)

{1:{('徐崢',):7,('黃渤',):9},2:{('徐崢','黃渤'):7}}

print(rules)[{徐崢}->{黃渤}]

通過上述分析可以看出:在寧浩的電影中,用的最多的是黃渤和徐崢,黃渤9次,支持度100%,徐崢7次,支持度78%,('徐崢', '黃渤') 同時出現7次,置信度為100%,看來有徐崢,必有黃渤,真是寧浩必請的黃金搭檔,且是一對好基友。 當然,這個數據量比較小,我們基本上肉眼也能看出來,這里只是提供一個分析案例和基礎方法,鞏固下基礎知識,算是開胃菜,大規模的數據,人眼無法直接感知的時候,算法的挖掘與發現,就顯得特別有意義了。

審核編輯 :李倩

-

關聯規則

+關注

關注

0文章

29瀏覽量

8000 -

Apriori

+關注

關注

0文章

10瀏覽量

7924

原文標題:Apriori 關聯規則算法(Python代碼)

文章出處:【微信號:DBDevs,微信公眾號:數據分析與開發】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

相關推薦

Python的Apriori算法和FP-Growth算法是什么

基于關聯規則的Apriori-Partition算法的可視化

基于項目編碼的關聯規則改進算法

基于關聯規則挖掘算法的用電負荷能效研究(ECALT和APRIORI算法)

關聯規則推薦算法分析及評估

簡介Apriori算法并解析該算法的具體策略和步驟,給出Python實現代碼

十大經典數據挖掘算法—Apriori

Apriori關聯規則算法(Python代碼)

Apriori關聯規則算法(Python代碼)

評論