英偉達并不是唯一一家創建專業計算單元的公司,這些計算單元擅長矩陣數學和張量處理,這些計算單元支持AI訓練,并且可以重新用于運行AI推理。英特爾已經收購了兩家這樣的公司—Nervana Systems,并緊隨其后的是Habana Labs,后者已被英特爾產品化,并緊隨英偉達的GPU加速器之后。

英特爾是一家優秀的公司,該公司認為將在未來五年內獲得500億美元的人工智能計算機會(用于訓練和推理),從現在到2027年,英特爾將以25%的復合年增長率增長,達到這一水平。鑒于“Ponte Vecchio”Xe HPC GPU加速器即將推出的相當大的矩陣和矢量數學,以及即將到來的“Sapphire Rapids”Xeon SP CPU中AMX矩陣數學單元中很可能有足夠的推理容量,因此有理由想知道英特爾預計會銷售多少Gaudi訓練和Goya推理芯片。

我們了解到,當英特爾在2016年8月以3.5億美元與Nervana Systems達成交易并在2019年12月以20億美元收購Habana Labs時,它追求的是知識產權和人,當然,因為這就是這場IT戰爭的玩法,但我們一直想知道這些設備,以及來自競爭對手GraphCore的設計, Cerebras,SambaNova Systems和Groq將部署在類似于主流的東西中。上述四家公司迄今為止共籌集了28.7億美元。

所有這些產品都剛剛開始滾動,這就是為什么英特爾將其賭注對沖到Nervana和Habana,就像它對數據中心的FPGA感到恐懼一樣(主要歸功于Microsoft Azure),并在2015年6月斥資167億美元收購了Altera。在2015年至2020年器件,在數據中心計算方面英特爾的Xeon CPU占據主導地位,并且通過收購方式,減少了一些競爭對手。

在本周舉行的Intel Vision 2022大會上,Gaudi2 AI訓練芯片是芯片制造商推出的大型新計算引擎,順便說一句,它不是英特爾實際制造的芯片,而是像其前身Gaudi1一樣,由競爭對手臺積電代工蝕刻而成。英特爾尚未透露對Gaudi2架構的深入研究,但這是我們所知道的。

通過Gaudi2,英特爾正在轉向臺積電的7納米工藝,隨著這種收縮,它能夠將芯片上的TPC數量從10個增加到24個,并增加了對新的8位FP8數據格式的支持,英偉達還將其添加到其“Hopper”GH100 GPU計算引擎中,該引擎于3月份推出,并在第三季度發貨。使用FP8格式,現在可以以相同的格式獲得低分辨率推理數據和高分辨率訓練數據,并且在從訓練移動到推理時不必在浮點和整數之間轉換模型。這對AI來說是一個真正的福音,盡管較低精度的整數格式可能會在未來許多年內保留在矩陣和矢量計算引擎中,以支持遺留代碼和其他類型的應用程序。Gaudi2芯片具有48 MB的SRAM,如果它與TPC數量線性擴展,將能達到2.4倍而不是2倍的SRAM,或57.6 MB。

Gaudi2芯片上有HBM2e內存組,可提供2.45 TB /秒的帶寬,比Gaudi1芯片增加了2.45倍。HBM2e內存庫的數量沒有透露,但六個16 GB HBM2e的存儲體為Gaudi2提供了訣竅,而Gaudi 1的四個存儲體為8 GB HBM2。僅兩個 HBM2e 內存控制器的增加就可將帶寬提高 1.33 倍,而帶寬的剩余增加來自提高內存速度。

Gaudi1芯片有十個100Gb/秒以太網端口,支持RoCE直接內存訪問協議,事實證明,每個TPC一個,但我們當時并不知道,因為只顯示了八個。但是Gaudi2有24個以太網端口以100 Gb / sec的速度運行,每個TPC一個。它的功率為650瓦。我們假設此設備插入PCI-Express 5.0插槽,但英特爾尚未確認這一點。

假設沒有重大的架構變化,并且該過程產生的時鐘速度從16納米縮小到7納米,我們預計Gaudi2芯片的性能將是Gaudi2的2.5倍。(還假設在任何給定應用程序中處理的精度水平相同。)但英特爾實際上并沒有說是否有任何架構變化(除了它增加了一些媒體處理功能)以及時鐘速度是如何變化的,所以我們必須推斷出來。

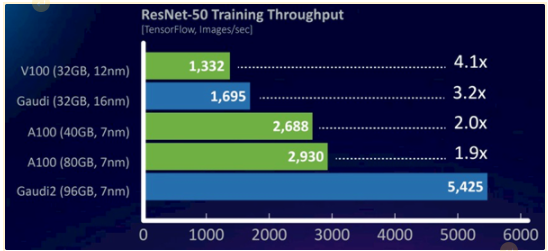

我們通過查看ResNet-50機器視覺訓練操作的圖表來做到這一點,該圖表使Gaudi1和Gaudi2與過去兩代英偉達GPU加速器競爭:

與Nervana Systems一樣,Habana Labs非常認真地致力于創建一套芯片,為AI工作負載提供最佳收益和最佳性能。哈瓦那戈雅HL-1000推理芯片于2019年初宣布,Gaudi1 AI訓練芯片(也稱為HL-2000)于當年夏天晚些時候首次亮相。Gaudi1架構有一個通用矩陣乘法(GEMM)前端,后端由十個張量處理器內核或TPC組成,芯片只向用戶公開其中的八個,以幫助提高封裝的良率。

Gaudi1使用了第二代TPC,而Goya HL-1000 AI推理芯片則使用了不那么強大和不那么復雜的原始TPC設計。Gadui1芯片中的TPC可以使用C編程語言直接尋址,并具有張量尋址以及BF16和FP32浮點以及INT8,INT16和INT32整數格式的支持。TPC指令集具有加速Sigmoid,GeLU,Tanh和其他特殊功能的電路。Gaudi 1采用臺積電的16納米工藝,具有24 MB片上SRAM,四組HBM2存儲器,容量為32 GB,帶寬為1 TB/秒。Gaudi1插入PCI-Express 4.0 x16插槽,消耗了350瓦的果汁,并將幾乎所有的果汁轉換為熱量,就像芯片一樣。

英特爾尚未透露對Gaudi2架構的深入研究。

根據ResNet-50的比較,Gaudi2的性能是Gaudi1的3.2倍,但很難估計有多少性能是由于整個芯片的容量增加。這個特定的測試正在運行TensorFlow框架來執行圖像識別訓練,顯示的數據是每秒處理的圖像數量。

有一件事沒有顯示,而且很重要,那就是Gaudi2加速器將如何與Hopper GPU堆疊,但英偉達尚未透露任何特定測試的性能結果。但是,由于 H100 中的 HBM3 內存運行速度比 A100 加速器中使用的 HBM2e 內存快 1.5 倍,而FP16、TF32 和 FP64 在新的 Tensor Core 上提供的性能是 3 倍,因此可以合理地預期 H100 的性能將是 ResNet-50 視覺訓練工作負載的 1.5 倍到 3 倍。因此,H100將在ResNet-50測試中每秒提供4,395至8,790張圖像的性能。我們的猜測是,它將比前者更接近后者,并且比英特爾通過Gaudi2可以提供的更大幅度更大。

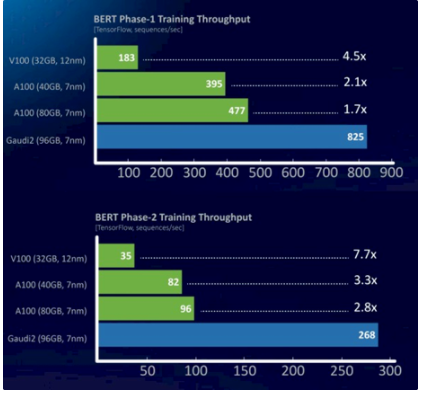

與使用BERT模型的自然語言處理相比,圖像識別和視頻處理相對容易。以下是Gaudi2與英偉達V100和A100的對比,請注意Gaudi1丟失了:

BERT 模型也在TensorFlow 框架上運行,此數據顯示了兩個不同訓練階段中每秒吞吐量的序列數。在一次預審中,哈瓦那實驗室部門首席商務官Eitan Medina表示,Gaudi2的性能不到A100的2倍。但是,H100擁有自己的FP8格式及其Transformer Engine,可以動態地改變AI訓練工作流程不同部分的數據精度和處理,可以做得更好。我們不知道具體到什么,但我們強烈懷疑英偉達至少可以縮小與Gaudi2的差距,并且很可能超越它。

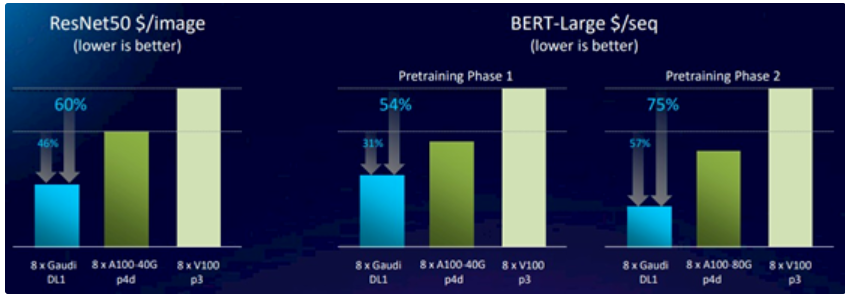

有趣的是,英特爾在亞馬遜網絡服務上啟動了DL1Gaudi1實例,然后分別基于A100和V100 GPU的p4d和p3實例,并進行了一些價格/性能分析,以計算ResNet-50基準測試中認可的每張圖像的成本。請看一下:

這張圖表的意思是,Gaudi1的性能略好于V100,使用上圖中ResNet-50中英特爾的性能數據為27.3% ,并且價格提高了約60%,這意味著DL1實例的成本比使用V100的p3實例低得多。隨著遷移到基于A100的p4d實例,該實例具有40GB的HBM2e內存,英偉達設備在ResNet-50上的吞吐量比Gaudi1高出58.6%,但Gaudi1處理的每個圖像的成本降低了46%。這意味著A100實例確實要貴得多。如果我們對Hopper GPU加速器定價的猜測是正確的,并且英偉達收取大約2倍的費用,大約3倍的性能,英特爾將不得不保持出售給AWS的Gaudi2芯片的價格,因為AWS仍然可以顯示出比運行AI訓練的H100實例更好的性價比。

無論如何,英特爾在其實驗室中運行了超過1000個Gaudi2,因此它可以調整SynapseAI軟件堆棧,其中包括在Habana的圖形編譯器,內核庫和通信庫上運行的PyTorch和TensorFlow框架。Gaudi2芯片現在正在發貨。

除了Gaudi2芯片外,英特爾還在預覽其Greco后續Goya推理引擎,該引擎也在臺積電躍升至7納米至16納米工藝。

Greco 推理卡具有 16GB 的 LPDDR5 主內存,可提供 204 GB/秒的內存帶寬,而使用先前的 Goya 推理引擎的 DDR4 內存塊為 40 GB/秒。哈瓦那架構的Greco變體支持INT4,BF16和FP16格式,功耗為75瓦,大大低于2019年初宣布的HL-1000設備的200瓦。如上圖所示,它被壓縮成一個更緊湊的半高,半長的PCI-Express卡。目前還沒有關于這個的性能或定價的消息。

綜合:半導體產業縱橫編輯部

-

英特爾

+關注

關注

61文章

9964瀏覽量

171776 -

gpu

+關注

關注

28文章

4740瀏覽量

128949 -

圖像識別

+關注

關注

9文章

520瀏覽量

38273 -

Gaudi2

+關注

關注

0文章

13瀏覽量

102

發布評論請先 登錄

相關推薦

英特爾推出全新英特爾銳炫B系列顯卡

英特爾發布全新企業AI一體化方案

英特爾12月或發布Battlemage GPU芯片

英特爾將攜手AMD共同捍衛x86生態

Inflection AI轉向英特爾Gaudi 3,放棄英偉達GPU

英特爾發布Gaudi3 AI加速器,押注低成本優勢挑戰市場

IBM Cloud將部署英特爾Gaudi 3 AI芯片

英特爾發布AI創作應用AI Playground,將于今夏正式上線!

英特爾最新GPU Gaudi2架構相關信息介紹

英特爾最新GPU Gaudi2架構相關信息介紹

評論