在深度學習產業落地過程中,我們經常能聽到一種說法——模型部署是打通AI應用的最后一公里!想要走通這一公里,看似簡單,但是真正實踐起來卻困難重重:顯卡利用率低、內存溢出、多線程調度奔潰、TensorRT加速算子不支持等等問題一直是深度學習模型最后部署的老大難問題。

在工業制造環境中,Windows系統有著廣泛的應用。為了更好的幫助工業用戶解決落地最后的一公里問題,飛槳聯合產業用戶,基于Windows系統,提供了工業級的部署Demo,支持圖像分類、目標檢測、實例分割和語義分割模型的部署,并提供了一鍵的TensorRT加速方式,極大的提升了部署的效率,同時支持多線程推理的方式,滿足了用戶多視頻輸入預測的需求!

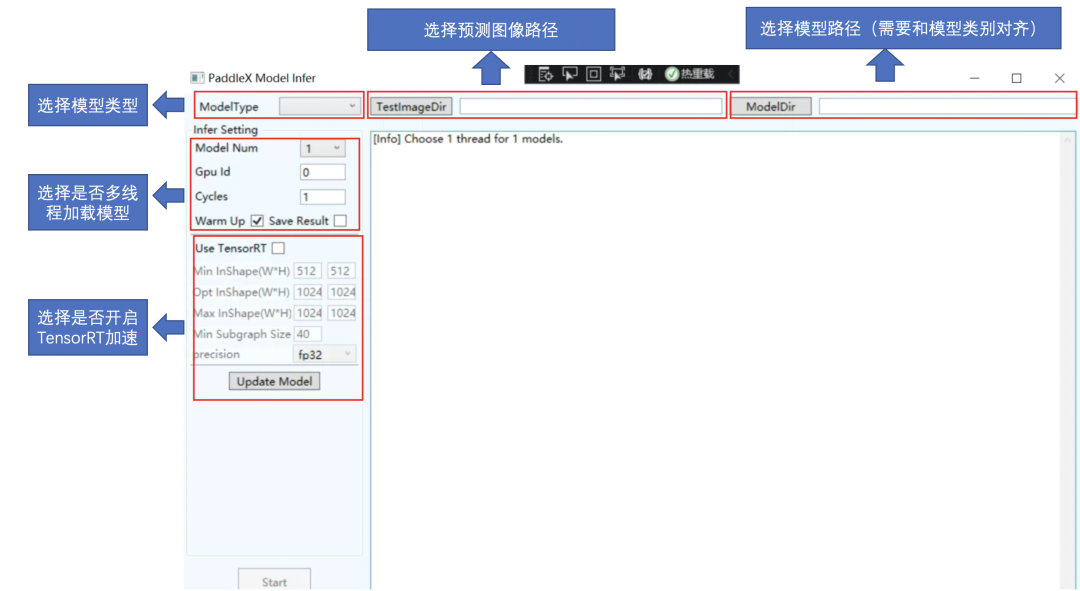

圖1部署開發示例說明

支持多種類別模型部署

滿足多種場景需求

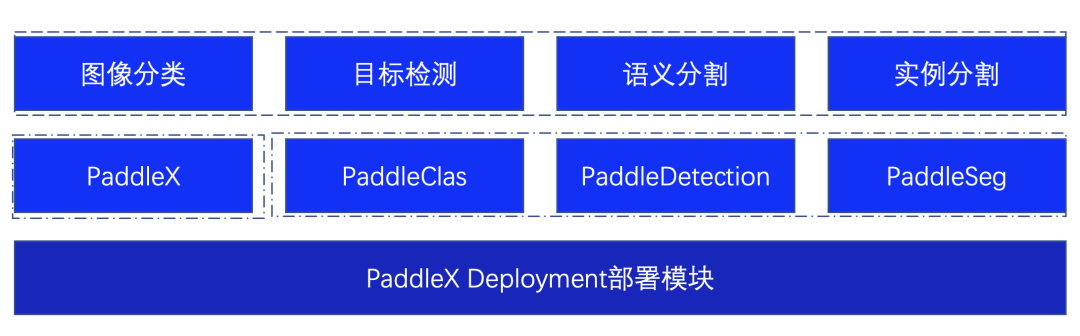

為了更好的滿足用戶多種視覺任務場景,部署Demo基于PaddleX的Deployment模塊進行二次開發,不僅僅支持對PaddleX自身訓練的模型進行推理,同時支持PaddleClas、PaddleDetection、PaddleSeg視覺開發套件的模型,滿足多種場景需求。

圖2 部署Demo支持模型說明

一鍵TensorRT加速

部署效率顯著提升

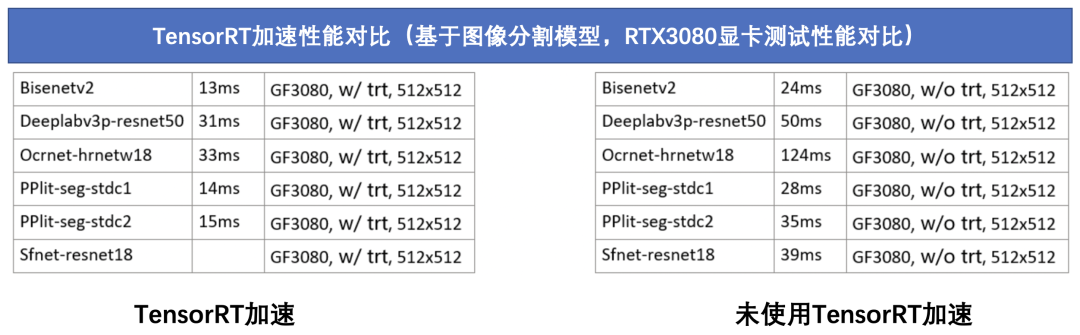

NVIDIA TensorRT 是一個高性能的深度學習預測庫,可為深度學習推理應用程序提供低延遲和高吞吐量。在部署Demo中集成了TensorRT預測庫,用戶只需一鍵啟動,即可進行高性能的部署。

圖3 部署Demo性能對比說明

為了更好的幫助用戶了解在工業制造場景部署的問題,飛槳邀請產業用戶現場coding,一步步帶著大家現場演示如何搭建部署開發示例,如何更高性能的應用在自己的產業落地中。

審核編輯 :李倩

-

AI

+關注

關注

87文章

30896瀏覽量

269087 -

圖像分類

+關注

關注

0文章

90瀏覽量

11918 -

工業制造

+關注

關注

0文章

404瀏覽量

28062

原文標題:TensorRT加速、多線程部署,打通工業高性能部署最后一公里

文章出處:【微信號:All_best_xiaolong,微信公眾號:大魚機器人】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

相關推薦

企業AI模型部署攻略

AI模型部署邊緣設備的奇妙之旅:目標檢測模型

AI模型部署邊緣設備的奇妙之旅:如何實現手寫數字識別

如何在STM32f4系列開發板上部署STM32Cube.AI,

解決驗證“最后一公里”的挑戰:芯神覺Claryti如何助力提升調試效率

英特爾AI PC無所不能的實力

亞馬遜云科技與伊克羅德信息攜手,共推AI賦能產業升級

言犀智能體平臺上線了!趕緊來試試!連接大模型與企業應用的“最后一公里”

北京靈奧科技基于亞馬遜云科技打造大模型中間件

云天勵飛正式發布“深目”AI模盒,讓大模型應用平民化

使用CUBEAI部署tflite模型到STM32F0中,模型創建失敗怎么解決?

智能硬件 | AI PC新市場,英特爾、高通、AMD、蘋果誰能拔得頭籌?

模型部署是打通AI應用的最后一公里

模型部署是打通AI應用的最后一公里

評論