無論是在正式還是非正式討論中,恩智浦員工經常會談及功能安全和信息安全的相互作用。如果再涉及汽車和人工智能,這個話題可能會變得更加復雜。

在去年的博文《未來挑戰:如何確保人工智能的安全》中,我們提到,恩智浦正在為安全的AI奠定堅實的基礎,例如恩智浦有關算法道德和Auto eIQ的白皮書。

在尋求功能安全和信息安全的汽車AI方面,我們不是在孤軍奮戰。在德國,德國聯邦信息安全辦公室 (BSI) 和采埃孚 (ZF) 攜手德國認證機構漢德集團 (TUV Nord),正合力探索如何在汽車上測試AI。德國人工智能研究中心 (DFKI) 和TUV SUD也在研究AI系統的汽車性能測試。

雖然尚不清楚這些測試的具體要求,但我們將在現有的基礎上再接再厲。

未來汽車如何利用機器學習和人工智能

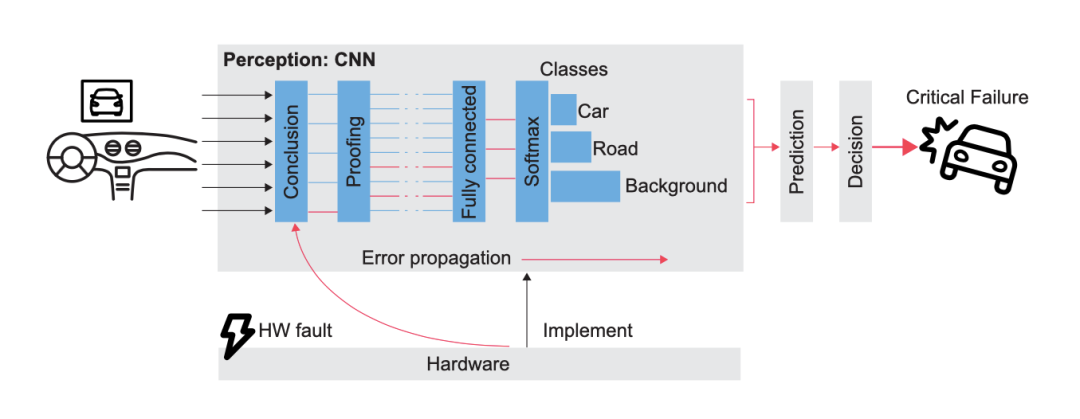

在推理方面,我們相信未來汽車將利用AI和機器學習來提供安全相關的功能。正因如此,我們與ANITI和ONERA合作,研究基于AI的系統中隨機硬件故障的影響。這項工作在功能安全標準(如ISO 26262)確立的先進水平之上,因為這些標準明確將機器學習排除在外。

功能安全框圖

本次合作的一個重點領域就是故障注入。故障注入技術可用于以下3個目的:

1

驗證安全機制的有效性

2

證明特定設計對隨機硬件故障的穩健性

3

在現場驗證設備能夠檢測出可預見的故障

確定邊緣隨機硬件故障的影響與機器學習模型之間的聯系,這是在現實世界中構建信任所必需的關鍵一環。如果沒有構建信任,我們就無法使用機器學習和AI來實現自動駕駛汽車所需的安全相關功能。

如何利用功能安全構建信任?

就構建信任而言,我們知道,不久后的將來,在運行人工智能安全功能的汽車中,完全按照機器學習模型運行不足以保障駕乘人員的安全。在這種情況下,硬件本身的重要性轉移到了模型的質量。

評估與模型的平均性能有關的指標是常見做法。而典型的方法是用準確率來定義正確分類的比率。在目標檢測中 (雷達的必備功能),通常選擇以mAP為指標。除了目標的正確分類,mAP還涵蓋了衍生邊界框的質量。

觀看恩智浦半導體

汽車4D成像雷達演示

但是,我們認為要構建對模型的信任,這還不夠。這些指標可能僅因為檢測目標的形狀較為罕見,便無法區分奇怪的錯誤與可以理解的人為失誤。

此外,如果出現奇怪的錯誤,需要了解造成錯誤的原因才能加以解決。即使預測是正確的,它也可能基于不正確的偏見,而這是人們希望避免的。

如何理解AI算法?

為了解決這些問題,我們需要采用適當的方法打開AI算法的“黑匣子”,讓人類能夠理解這些預測。Grad-CAM就是這種神經網絡方法的一個有趣的例子。Ramprasaath R.Selvaraju等人于2019年發表了一篇論文,其中解釋了如何將特征圖與其梯度相乘,以此確定輸入的哪些部分對模型的預測最重要。這為用戶提供了一個非常有價值的工具,可以更好地了解模型學到了什么,進而得出預測。

這也會增加人們對模型的信任,并有助于開發人員發現在訓練集中發現模型缺點,然后加以解決。

作者給出了一個示例,人們訓練了兩種模型分別用來識別醫生和護士。Grad-CAM提供了一個覆蓋圖(類似于熱圖),告訴人們使用圖片的哪些部分來做出判斷。在第一個模型(“有偏見”)中,模型使用面部特征來識別。這是我們不希望看到的情況,鑒于訓練集存在偏見(女護士照片和男醫生照片較多),模型可能會判斷照片中是“護士”。經過分析和再訓練后,第二個模型可根據其他要素做出決策。Grad-CAM用于驗證是否需要這些要素(如聽診器)。

這個例子可以很容易地推算至與安全相關的功能。在駕駛員監測系統檢測的情況下,Grad-CAM可以確保駕駛員疲勞標記的訓練無偏見。

恩智浦繼續投資打造功能安全和信息安全的AI解決方案。通過構建對訓練數據的信任,確保ML模型的完美執行(即使是在隨機硬件故障的情況下),恩智浦致力于朝著光明、安全的未來前行。

原文標題:汽車AI的功能安全和信息安全:新課題需要新解法!

文章出處:【微信公眾號:NXP客棧】歡迎添加關注!文章轉載請注明出處。

-

人工智能

+關注

關注

1792文章

47514瀏覽量

239250 -

機器學習

+關注

關注

66文章

8428瀏覽量

132848 -

AI算法

+關注

關注

0文章

252瀏覽量

12297

原文標題:汽車AI的功能安全和信息安全:新課題需要新解法!

文章出處:【微信號:NXP客棧,微信公眾號:NXP客棧】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

相關推薦

芯盾時代中標寶雞市金臺醫院零信任安全認證網關

Minitab常用功能介紹 如何在 Minitab 中進行回歸分析

簡單認識芯盾時代零信任業務安全平臺

化工企業安全生產管控平臺的構建與應用

芯盾時代為匯豐石化集團構建用戶身份與訪問管理平臺

什么是汽車ISO 26262功能安全標準?

Akamai將生成式AI嵌入零信任安全解決方案

森林環境監控系統方案應用功能

以守為攻,零信任安全防護能力的新范式

帶啟用功能的150mACMOS超低智商和IGND LDO穩壓器數據手冊

STM8L152C6芯片的引腳復用功能怎么配置啊?

芯盾時代中標中國聯通某省分公司 以零信任賦能遠程訪問安全

如何利用功能安全構建信任

如何利用功能安全構建信任

評論