計算機視覺兩大門派功力合體,給移動端視覺任務(wù)減負增速。

當下,計算機視覺領(lǐng)域最熱議的方向,莫過于近兩年越來越火的視覺Transformer(ViT)和傳統(tǒng)的卷積神經(jīng)網(wǎng)絡(luò)(ConvNet),誰才能主宰計算機視覺的未來?

風(fēng)頭正盛的ViT,是計算機視覺領(lǐng)域過去十年最矚目的研究突破之一。2020年,谷歌視覺大模型Vision Transformer(ViT)橫空出世,憑借碾壓各路ConvNet的性能表現(xiàn),一舉掀起Transformer在計算機視覺領(lǐng)域的研究熱潮。

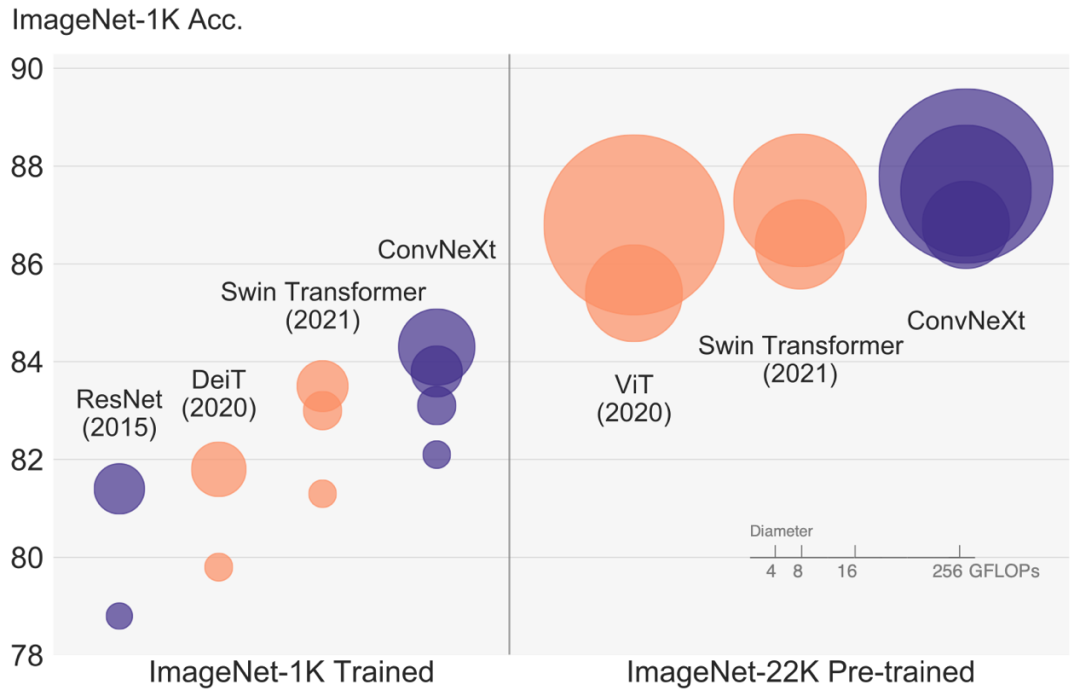

但“ConvNet派”還沒到低頭認輸?shù)臅r候。2022年1月,Meta AI研究院、加州大學(xué)伯克利分校的研究人員發(fā)表了卷積神經(jīng)網(wǎng)絡(luò)的“扛鼎之作”——ConvNeXt,基于純ConvNet新架構(gòu),取得了超過先進ViT的計算速度和精度。

▲ConvNet與ViT模型圖像分類實驗結(jié)果對比

ViT論文:https://arxiv.org/abs/2010.11929

ConvNeXt論文:https://arxiv.org/abs/2201.03545

那如果將這兩類模型的優(yōu)勢互補,會不會產(chǎn)生1+1》2的效果?

近日,基于這一思路的論文《ParC-Net:繼承ConvNet和Transformer優(yōu)點的位置敏感的循環(huán)卷積》入選了計算機視覺頂會ECCV 2022,并引發(fā)國內(nèi)外廣泛關(guān)注。

這篇論文提出了一種面向移動端、融入ViT優(yōu)點的純卷積結(jié)構(gòu)模型ParC-Net,能以更小的參數(shù)量,在常見視覺任務(wù)中實現(xiàn)比主流輕量級ConvNet更好的性能。

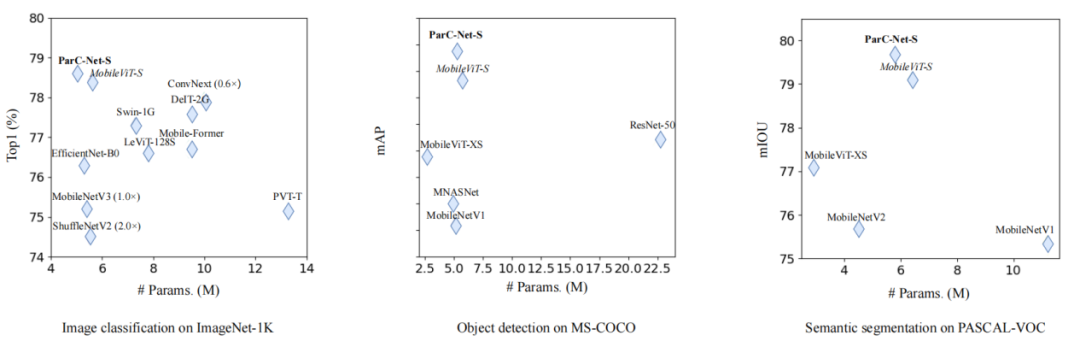

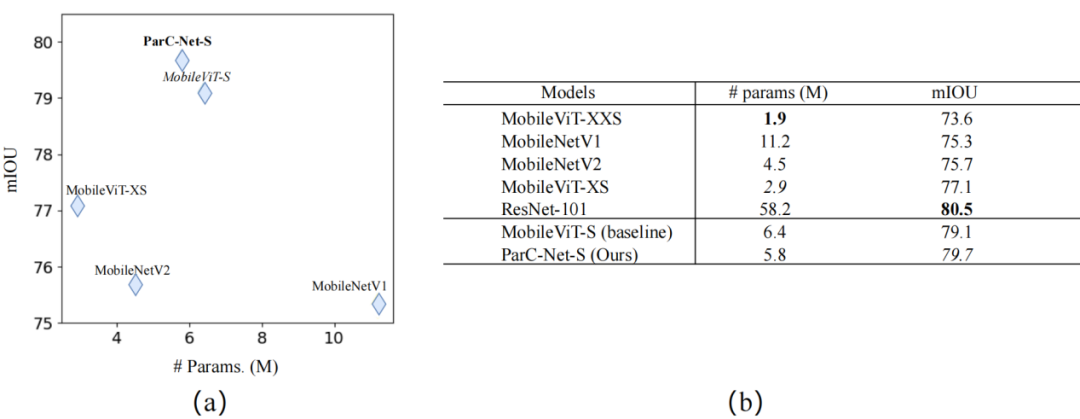

▲ParC-Net在三種視覺任務(wù)實驗中均以更小參數(shù)量取得最佳性能表現(xiàn)

值得一提的是,論文提出一種既有全局感受野、又對位置信息保持敏感的基礎(chǔ)卷積算子ParC,它能與現(xiàn)有主流網(wǎng)絡(luò)結(jié)構(gòu)融合,兼顧模型性能和計算速度的提升,相關(guān)代碼現(xiàn)已開源。

具體是怎么實現(xiàn)的?我們聯(lián)系到論文第一作者張?zhí)栧硬┦浚⑴c其進行深入交流。

ParC論文:https://arxiv.org/abs/2203.03952

源代碼:https://github.com/hkzhang91/ParC-Net

01.

取ViT的三個亮點,將純卷積結(jié)構(gòu)變強

在計算機視覺領(lǐng)域,ViT模型性能彪悍,門檻和成本卻驚人,無論是龐大數(shù)據(jù)量,還是超高算力需求,都離不開“鈔能力”的支撐。

相比之下,輕量級ConvNet雖然性能難以與ViT媲美,但具有易訓(xùn)練、參數(shù)量少、計算成本低、推理速度快等優(yōu)勢,對硬件資源的需求不像ViT那么受限,可部署在各種移動或邊緣計算設(shè)備上。此前較流行的輕量級ConvNet有ShuffleNet、MobileNet、EfficientNet、TinyNet等等。

經(jīng)對比,云天勵飛的研究人員借鑒ViT的優(yōu)點,基于卷積結(jié)構(gòu)設(shè)計了一個輕量級骨干模型ParC-Net。

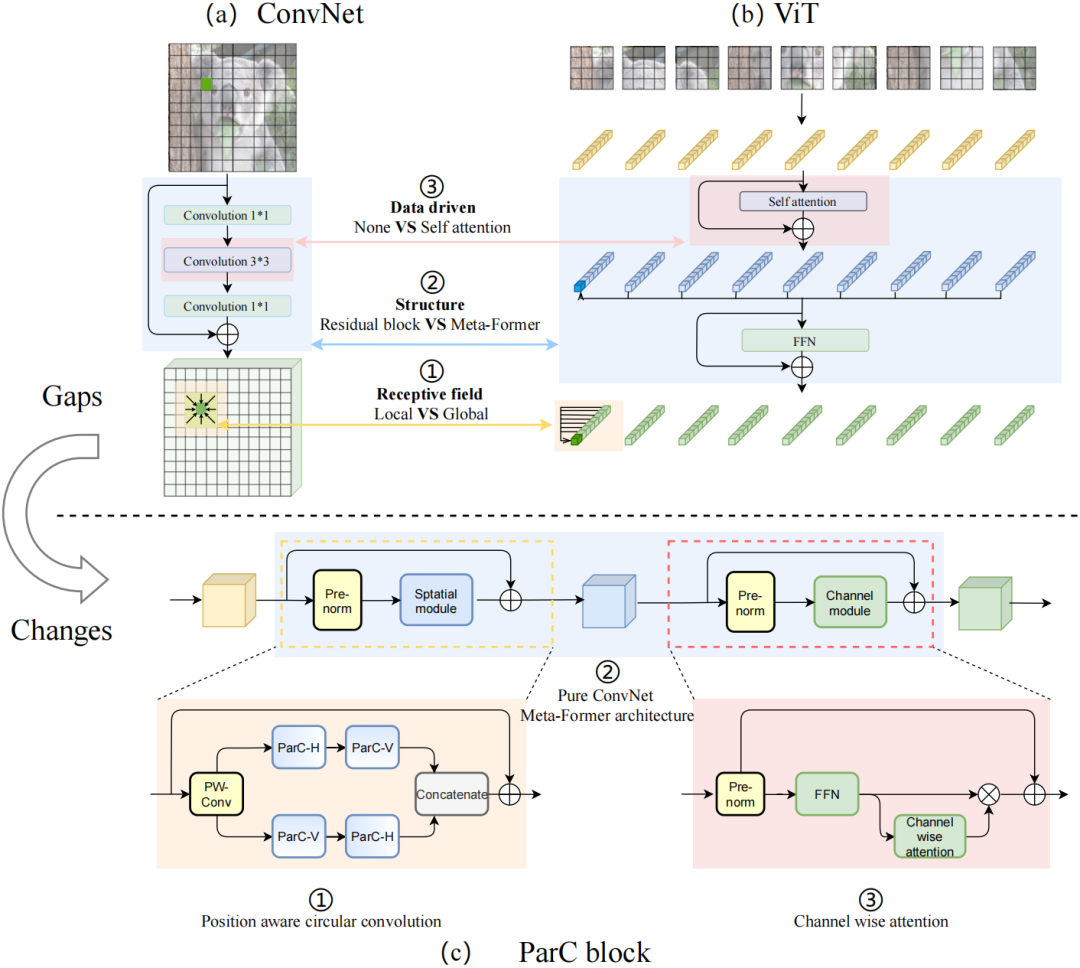

論文作者認為,ViT和ConvNet有三個主要區(qū)別:ViT更擅長提取全局特征,采用meta-former結(jié)構(gòu),而且信息集成由數(shù)據(jù)驅(qū)動。ParC的設(shè)計思路便是從這三點著手來優(yōu)化ConvNet。

▲普通ConvNet和ViT之間的三個主要區(qū)別。(a) ConvNet常用的Residual block;(b) ViT中常用的Meta-Former 結(jié)構(gòu);(c) 本文提出的ParC block。

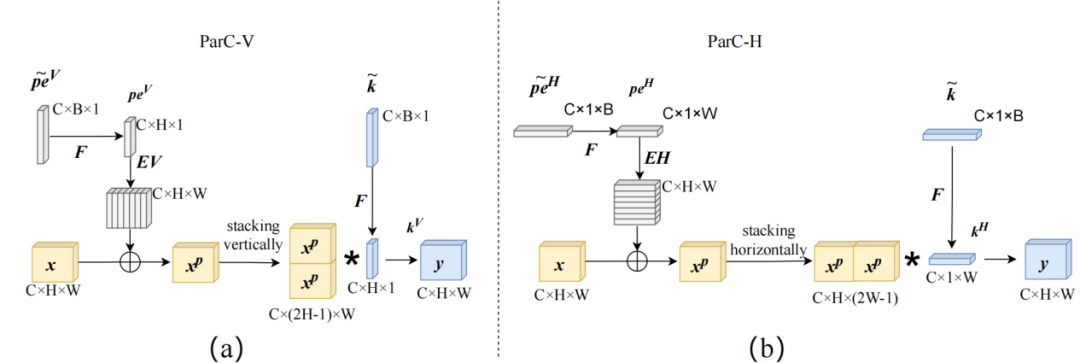

具體而言,研究人員設(shè)計了一種位置信息敏感的循環(huán)卷積(Position aware circular convolution, ParC)。這是一種簡單有效的輕量卷積運算算子,既擁有像ViT類結(jié)構(gòu)的全局感受野,同時產(chǎn)生了像局部卷積那樣的位置敏感特征,能克服依賴自注意力結(jié)構(gòu)提取全局特征的問題。

ParC結(jié)構(gòu)主要包含三部分改動:1)結(jié)合circular padding和大感受野低秩分解卷積核提取全局特征;2)引入位置嵌入,保證輸出特征對于空間位置信息的敏感性;3)動態(tài)插值實時生成尺寸適配的卷積核和位置編碼,應(yīng)對輸入分辨率變化情況,這增強了對不同尺寸輸入的適應(yīng)能力。

▲ParC結(jié)構(gòu)示例

研究人員還將ParC和squeeze exictation(SE)操作結(jié)合起來,構(gòu)建了一個純卷積結(jié)構(gòu)的meta former結(jié)構(gòu)。該結(jié)構(gòu)舍棄了自注意力硬件支持不友好的操作,但保留了傳統(tǒng)Transformer塊提取全局特征的特點。

然后,研究人員在channel mixer部分引入硬件支持較友好的通道注意力機制,使其純卷積meta former結(jié)構(gòu)也具備自注意力的特點。

基于ParC結(jié)構(gòu)最終得到的ParC塊,可作為一個即插即用的基礎(chǔ)單元,替換現(xiàn)有ViT或ConvNet模型中的相關(guān)塊,從而提升精度,并降低計算成本,有效克服硬件支持的問題。

▲ParC實驗結(jié)果

02.

三大視覺任務(wù)表現(xiàn)出色 多項指標打敗蘋果MobileViT

“據(jù)我們所知,這是第一次嘗試結(jié)合ConvNet和ViT的優(yōu)點來設(shè)計一個輕量級Pure-ConvNet的結(jié)構(gòu)。”論文作者如此描述ParC-Net的開創(chuàng)性。

實驗結(jié)果表明,在圖像分類、物體檢測、語義分割這三類常見的視覺任務(wù)中,混合結(jié)構(gòu)的模型性能表現(xiàn)普遍高于當前主流的一些純卷積結(jié)構(gòu)、ViT結(jié)構(gòu)的模型,其中ParC-Net模型取得了最好的整體性能表現(xiàn)。

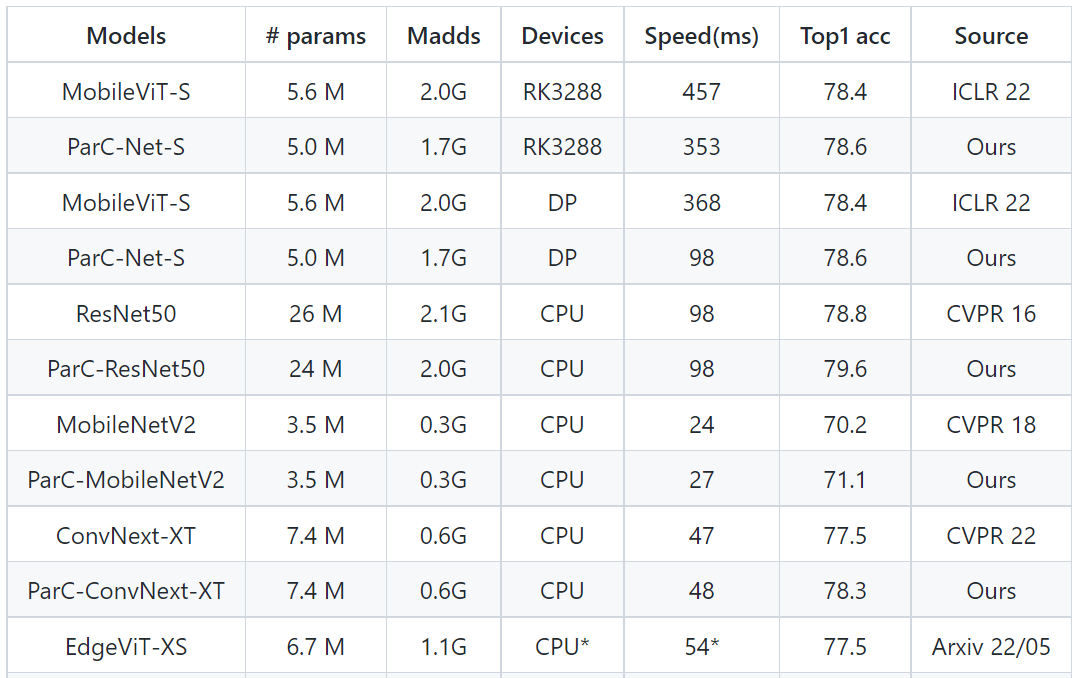

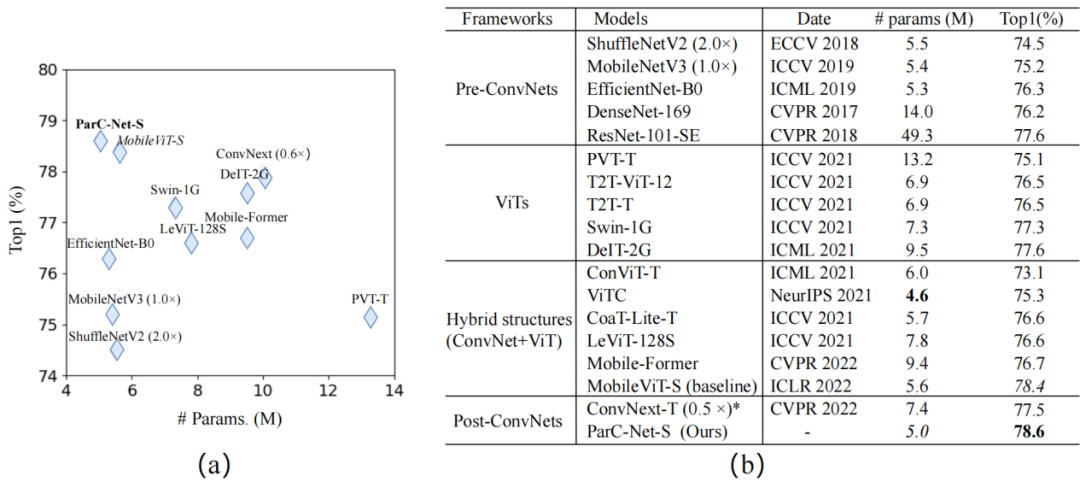

▲對于ImageNet-1k的圖像分類實驗結(jié)果

在圖像分類實驗中,對于ImageNet-1k的分類,ParC-Net使用的參數(shù)規(guī)模最小(大約500萬個參數(shù)),卻實現(xiàn)了最高準確率78.6%。

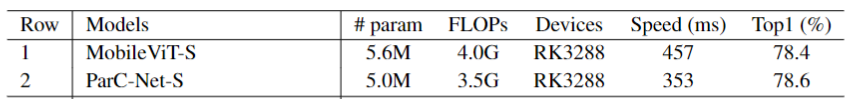

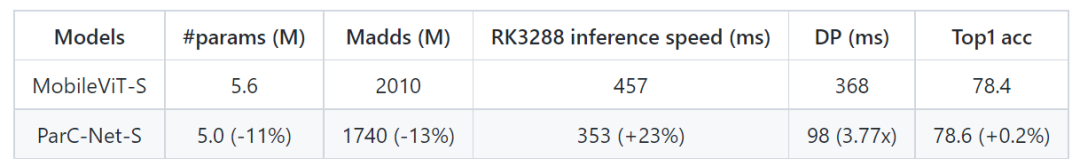

MobileViT是蘋果公司2022年在國際深度學(xué)習(xí)頂會ICLR22上提出的輕量級通用ViT模型。同樣部署在基于Arm的瑞芯微RK3288芯片上,相較基線模型MobileViT,ParC-Net節(jié)省了11%的參數(shù)和13%的計算成本,同時準確率提高了0.2%,推理速度提高了23%。

▲與基準模型的推理速度對比

與基于ViT結(jié)構(gòu)的模型相比,ParC-Net的參數(shù)量只有Meta AI團隊DeiT模型參數(shù)的一半左右,準確率卻比DeiT提高了2.7%。

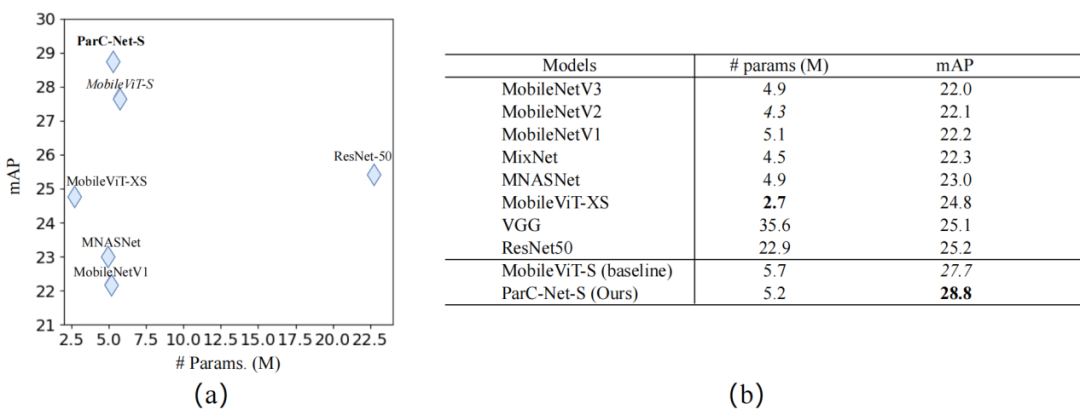

在MS-COCO物體檢測和PASCAL VOC分割任務(wù)中,ParC-Net同樣基于較少的參數(shù),實現(xiàn)了更好的性能、更快的推理速度。

▲MS-COCO物體檢測實驗結(jié)果

▲PASCAL VOC分割任務(wù)實驗結(jié)果

張?zhí)栧硬┦渴荘arC-Net論文的第一作者,現(xiàn)任深圳云天勵飛資深算法研究員,研究領(lǐng)域包括網(wǎng)絡(luò)結(jié)構(gòu)搜索、深度估計、輕量化骨干模型、信息檢索及高光譜圖像分類等。

他告訴智東西,傳統(tǒng)ConvNet可以適應(yīng)視覺任務(wù)中輸入分辨率的變化,而具有全局感受野的純卷積結(jié)構(gòu)的缺陷是卷積核必須跟輸入分辨率保持一致,為了更好應(yīng)對分辨率的變化,其團隊正在研究將模型做成動態(tài)卷積的形式,以提高魯棒性。

目前這項研究成果已經(jīng)可以用在算力受限的移動端或邊緣設(shè)備中,實現(xiàn)更高準確率的視覺任務(wù)。如果進行一些小的改動,ParC-Net還可以被用于其他的視覺任務(wù),例如6DOF姿態(tài)評估及其他dense prediction的任務(wù)。

03.

與自研芯片協(xié)同 運算速度可提升快3~4倍

那么ParC-Net模型的研究成果,具體如何在實際業(yè)務(wù)場景中發(fā)揮價值?

據(jù)介紹,一方面,ParC-Net模型可以集成到開源算法訓(xùn)練平臺YMIR中,然后被部署至終端設(shè)備;另一方面,通過與云天勵飛自研芯片協(xié)同,它能將運算速度和精度進一步提升。

YMIR是一個高度自動化的AI模型開發(fā)平臺,能做到利用鼠標簡單操作就可以完成數(shù)據(jù)收集、模型訓(xùn)練、數(shù)據(jù)挖掘、數(shù)據(jù)標注等功能。將擁有高運算效率的ParC-Net模型版本上傳至YMIR后,用戶可在該平臺上直接選用ParC-Net模型,也可以針對具體業(yè)務(wù)場景,添加相應(yīng)的數(shù)據(jù)集對ParC-Net進行再訓(xùn)練,從而獲得能更好滿足業(yè)務(wù)需求的模型。

以前有些對精度要求高或者采用ViT結(jié)構(gòu)的移動端視覺任務(wù),受限于計算效率問題,難以在攝像頭設(shè)備或手機上運行,而上傳到云端做運算,對有較高實時性要求的視覺任務(wù)不是很友好。

ParC-Net則較好地改善了這類問題,在模型精度和推理效率之間實現(xiàn)平衡,使得邊緣設(shè)備可以在本地運行一些對精度要求高的視覺任務(wù)。比如,人臉識別終端設(shè)備可運用ParC-Net直接對路過的人進行高質(zhì)量特征值提取,無需將數(shù)據(jù)傳輸?shù)皆贫耍湍芘c數(shù)據(jù)庫進行檢索比對。

與云天勵飛自研芯片搭配后,ParC-Net模型的性能表現(xiàn)還能再上一個臺階。

張?zhí)栧硬┦空劦溃鋱F隊考慮到軟硬件設(shè)計協(xié)同問題,在研發(fā)之初參考了云天勵飛自研芯片工具鏈的設(shè)計及算子支持情況,然后進行模型網(wǎng)絡(luò)結(jié)構(gòu)及算子的設(shè)計,以更好地發(fā)揮出芯片算力。

研究人員將ParC-Net和基線模型MobileVit均部署到自研低功耗芯片DP上進行推理速度測試。從實驗結(jié)果可以看到,ParC-Net的推理速度能夠達到MobileViT速度的3~4倍。

▲與基準模型在不同芯片平臺上的推理速度對比

這也是研究團隊決定選擇基于純卷積結(jié)構(gòu)來設(shè)計ParC-Net的原因之一。ConvNet已經(jīng)統(tǒng)治計算機視覺領(lǐng)域十年之久,而ViT在這一領(lǐng)域興起時間較短,很多現(xiàn)有的神經(jīng)網(wǎng)絡(luò)加速器、硬件優(yōu)化策略,都是圍繞卷積結(jié)構(gòu)設(shè)計。因此部署在移動端時,純ConvNet往往能比ViT享有更好的軟硬件及工具鏈支持,并實現(xiàn)更快的推理速度。

即便搭載在對支持ViT更友好的芯片上,張?zhí)栧硬┦空f,ParC-Net依然能取得比現(xiàn)有其他混合模型更好的性能表現(xiàn)。

絕大多數(shù)視覺任務(wù)可以分為兩類:一類對位置信息不敏感,如圖像分類等;另一類對位置信息較敏感,如物體檢測、3D姿態(tài)估計、AR試穿等。對于這些視覺任務(wù),無論用在智能門禁、手機識圖還是自動駕駛汽車的攝像頭,ParC-Net都能夠發(fā)揮出其兼顧模型精度和計算效率的優(yōu)勢,并且不會受部署終端設(shè)備配置的限制。

04.

結(jié)語:輕量級視覺模型設(shè)計的新啟發(fā)

當前ViT與ConvNet兩大研究方向在計算機視覺領(lǐng)域旗鼓相當,ViT在學(xué)術(shù)界四處屠榜,ConvNet則在工業(yè)界主導(dǎo)地位難以撼動,將兩者融合的相關(guān)研究也如雨后春筍般涌現(xiàn)。

此次入選ECCV頂會的ParC-Net模型,既顧及邊緣設(shè)備對模型規(guī)模的限制,基于純卷積結(jié)構(gòu),確保其具備易訓(xùn)練、易部署、推理效率高、硬件更友好等特點,又吸納了ViT的設(shè)計特征,實現(xiàn)比其他ConvNet模型更高的精度。這可以給移動端視覺任務(wù)的模型設(shè)計帶來一些啟發(fā)。

審核編輯 :李倩

-

神經(jīng)網(wǎng)絡(luò)

+關(guān)注

關(guān)注

42文章

4772瀏覽量

100792 -

計算機視覺

+關(guān)注

關(guān)注

8文章

1698瀏覽量

46002 -

輕量級

+關(guān)注

關(guān)注

0文章

16瀏覽量

7330

原文標題:媒體關(guān)注丨云天勵飛論文入選ECCV2022,提出輕量級視覺模型新架構(gòu)

文章出處:【微信號:IntelliFusion2,微信公眾號:云天勵飛】歡迎添加關(guān)注!文章轉(zhuǎn)載請注明出處。

發(fā)布評論請先 登錄

相關(guān)推薦

華為Flexus云服務(wù)器搭建SamWaf開源輕量級網(wǎng)站防火墻

EEPROM輕量級的簡易類文件的數(shù)據(jù)讀寫庫:EEPROMFS

開放原子開源大賽助力輕量級大語言模型應(yīng)用落地

電裝與京瓷合作開展輕量級太陽能發(fā)電系統(tǒng)實證實驗

國產(chǎn)芯上運行TinyMaxi輕量級的神經(jīng)網(wǎng)絡(luò)推理庫-米爾基于芯馳D9國產(chǎn)商顯板

國產(chǎn)芯上運行TinyMaxi輕量級的神經(jīng)網(wǎng)絡(luò)推理庫-米爾基于芯馳D9國產(chǎn)商顯板

鴻蒙語言基礎(chǔ)類庫:ohos.data.storage 輕量級存儲

國產(chǎn)芯上運行TinyMaxi輕量級的神經(jīng)網(wǎng)絡(luò)推理庫-米爾基于芯馳D9國產(chǎn)商顯板

消息稱蘋果正在研發(fā)輕量級AR眼鏡

部署在邊緣設(shè)備上的輕量級模型

深度詳解嵌入式系統(tǒng)專用輕量級框架設(shè)計

未來輕量級深度學(xué)習(xí)技術(shù)探索

輕量級視覺模型設(shè)計的新啟發(fā)

輕量級視覺模型設(shè)計的新啟發(fā)

評論