本文簡要介紹了發表于CVPR 2022的論文“Vision-Language Pre-Trainingfor Boosting Scene Text Detector”的相關工作。大規模預訓練在視覺任務中有著重要的作用,而視覺語言模型與多模態的特征聯合近期也收到了廣泛的關注。本文針對場景文本檢測的問題,提出了利用視覺語言模型對檢測器進行預訓練,通過設計Image-text Contrastive Learning、Masked LanguageModeling和Word-in-image Prediction三個預訓練任務有效得結合文本、圖像兩個模態的特征,幫助主干網絡提取到更豐富的視覺與語義特征,以此提高文本檢測器的性能。該預訓練方法可以有效提升各文本檢測器在各大公開場景文本數據集上的評估結果。

一、研究背景

預訓練通常被用于自然語言處理以及計算機視覺領域,以增強主干網絡的特征提取能力,達到加速訓練和提高模型泛化性能的目的。該方法亦可以用于場景文本檢測當中,如最早的使用ImageNet預訓練模型初始化參數,到使用合成數據直接預訓練檢測器再在真實數據上Finetune,再到通過定義一些預訓練任務訓練網絡參數等。但這些方法都存在一些問題,比如中合成數據與真實數據的Domain Gap導致模型在真實場景下Finetune效果不佳,中沒有充分利用視覺與文本之間的聯系。基于這些觀察,本文提出了一個通過視覺語言模型進行圖像、文本兩個模態特征對齊的預訓練方法VLPT-STD,用于提升場景文本檢測器的性能。

二、方法介紹

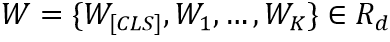

本文提出了一個全新的用于場景文本檢測預訓練的框架—VLPT-STD,它基于視覺語言模型設計,可以有效地利用文本、圖像兩種模態的特征,使得網絡提取到更豐富的特征表達。其算法流程如圖1所示,主要分為Image Encoder,Text Encoder以及Cross-model Encoder三個部分,并且設計了三個預訓練任務讓網絡學習到跨模態的表達,提高網絡的特征提取能力。

2.1 模型結構

Image Encoder用于提取場景文本圖片的視覺特征編碼,Text Encoder則提取圖片中文本內容的編碼,最后視覺特征編碼和文本內容編碼一起輸入Cross-model Encoder當中進行多模態特征融合。

Image Encoder 包含了一個ResNet50-FPN的主干網絡結構和一個注意力池化層。場景文本圖像首先輸入到ResNet50-FPN中得到特征,然后通過注意力池化層得到一個圖像特征編碼序列 ,

, 代表[CLS] Token的編碼,S代表視覺Token的數量,d是維度。注意力池化層是一層Transformer中的多頭注意力模塊。

代表[CLS] Token的編碼,S代表視覺Token的數量,d是維度。注意力池化層是一層Transformer中的多頭注意力模塊。

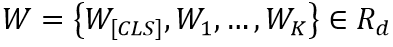

Text Encoder先將輸入的文本轉化成一個編碼序列 ,K代表序列長度,然后通過三層多頭注意力模塊得到文本特征編碼。

,K代表序列長度,然后通過三層多頭注意力模塊得到文本特征編碼。

Cross-model由四個相同的Transformer Decoder組成,它將視覺編碼序列和文本編碼序列W結合到了一起,并將其最后的輸出用于預測Masked Language Modeling預訓練任務。

圖1 VLPT-STD整體框架

2.2 預訓練任務

本文定義了三個預訓練任務,包括Image-text Contrastive Learning(ITC)、Word-in-image Prediction(WIP)和Masked Language Modeling(MLM)。

Image-text Contrastive Learning(ITC)的目的是使得文本編碼序列的每一項都能在視覺編碼序列中找到最相似的編碼,也就是讓每個單詞的文本編碼與其對應的文本圖片區域視覺特征匹配(例如,“Last”的Text Embedding與圖片中“Last”位置的區域特征相似度最高)。

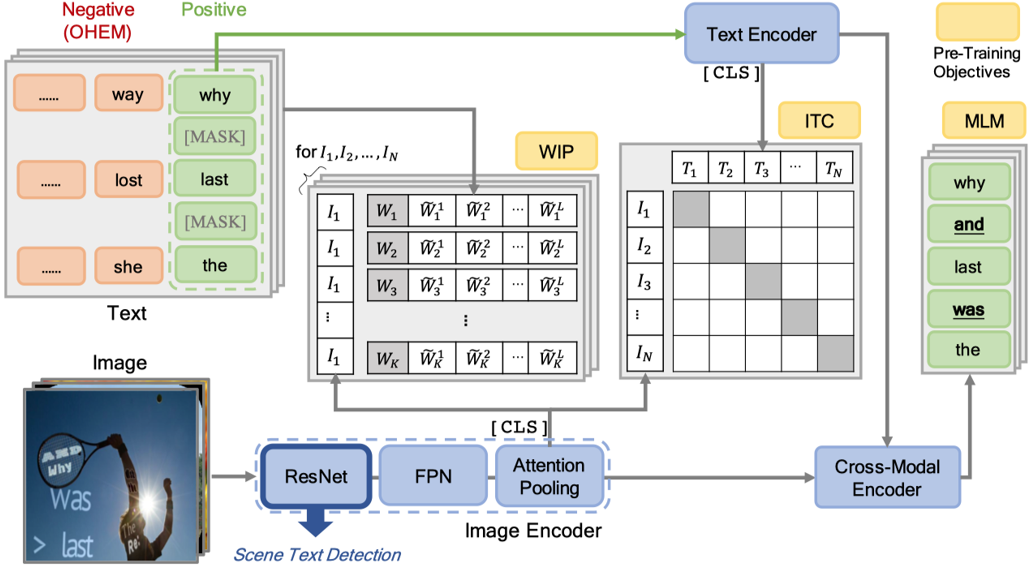

該任務對每個圖像編碼 和文本編碼

和文本編碼 分別運用InfoNCE loss[4]去計算相似度。

分別運用InfoNCE loss[4]去計算相似度。 和

和 代表一個Batch內所有的圖像編碼和文本編碼,它們分別為Image Encoder得到的

代表一個Batch內所有的圖像編碼和文本編碼,它們分別為Image Encoder得到的 和Text Encoder得到的

和Text Encoder得到的 。

。

N代表Batch Size。ITC任務最終的損失函數為:

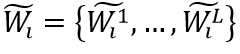

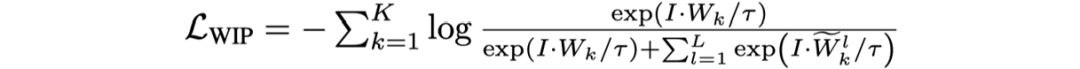

Word-in-Image Prediction(WIP)是通過在圖像編碼和文本單詞編碼中應用對比學習去區分出現在圖片中的文本(正類)與不存在德文本(負類),從而預測給定的一組單詞是否出現在輸入圖片中。如圖1左上角所示,訓練時圖片中有的單詞作為正樣本,其編碼為 ;負樣本則是訓練過程中基于文本編碼的相似度進行采樣得到(如對于正樣本“Lost”,負樣本可為“Lose”,“Last”等),文中選取的是Top-L(L=63)相似的文本,對于每一個正樣本的編碼

;負樣本則是訓練過程中基于文本編碼的相似度進行采樣得到(如對于正樣本“Lost”,負樣本可為“Lose”,“Last”等),文中選取的是Top-L(L=63)相似的文本,對于每一個正樣本的編碼 ,其負樣本編碼為

,其負樣本編碼為

。輸入圖片為I,WIP的損失函數定義如下:

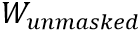

MaskedLanguage Modeling (MLM)類似于BERT,該任務首先隨機掩蓋文本編碼w,然后讓網絡利用所有的視覺特征編碼v和未被掩蓋的文本編碼 預測缺失的單詞文本

預測缺失的單詞文本 。如圖1所示,圖片中的文本“And”,“Was”等被掩蓋,MLM任務是將它們預測恢復。其損失函數如下所示:

。如圖1所示,圖片中的文本“And”,“Was”等被掩蓋,MLM任務是將它們預測恢復。其損失函數如下所示:

最終的損失函數為:

三、實驗

3.1 實驗細節

本文提出的VLPT-STD在SynthText [5]上進行預訓練,然后將預訓練得到的主干網絡用于EAST [6],PSENet [7]和DB[2]這三個文本檢測器在各個公開的真實場景數據集上進行Finetune。實驗使用了八塊v100,Batch Size為800。

3.2 與State-of-the-art的方法比較

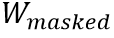

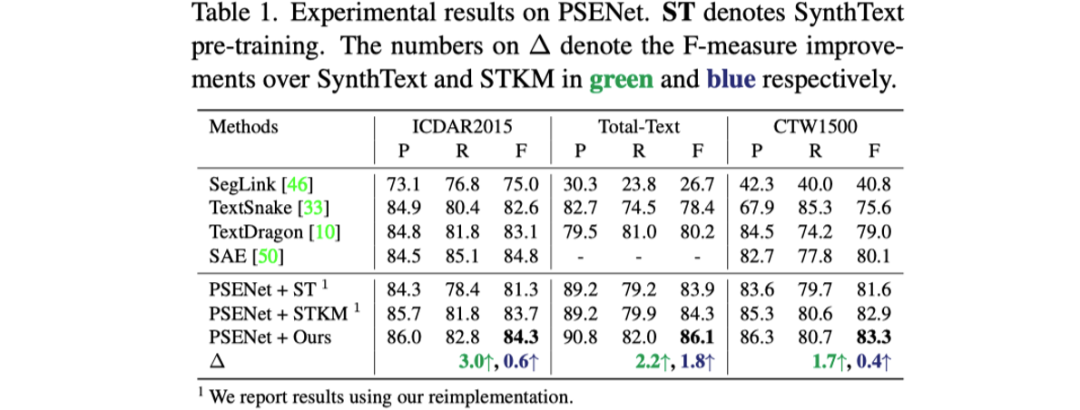

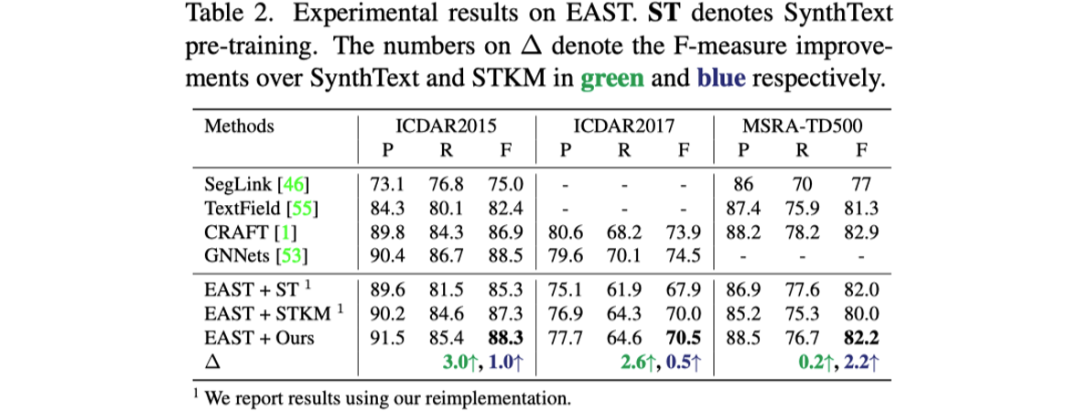

表格1到表格3展示了文章提出的預訓練方法與之前預訓練方法對于三個不同的文本檢測器性能提升的對比。

3.2 消融實驗

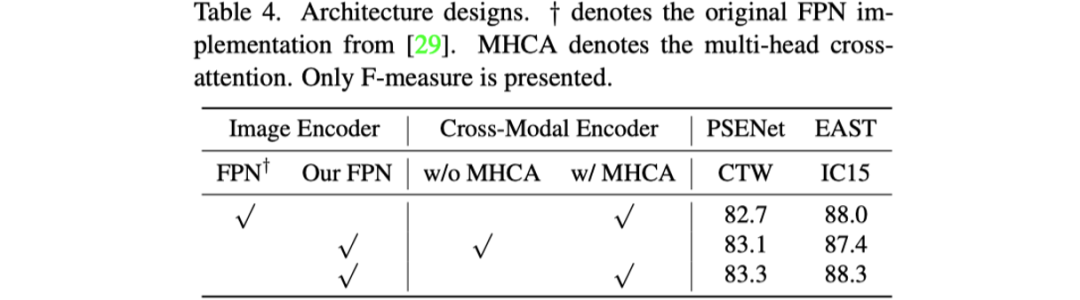

首先是對模型設計的消融實驗,如表格4所示。文章探究了Image Encoder中作者改進的FPN結構和Cross-model Encoder中Cross-attention的作用。

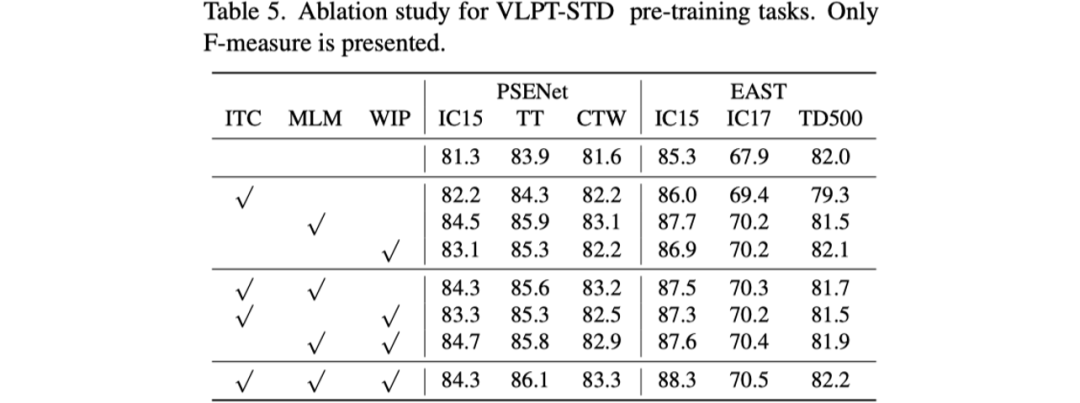

其次是對預訓練任務的消融實驗,如表格5所示。

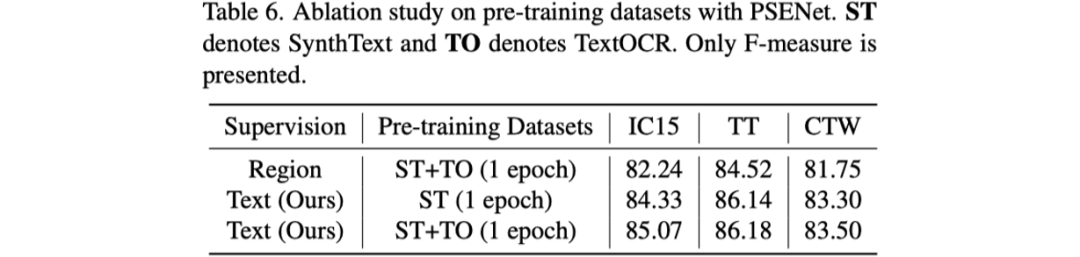

最后是對預訓練的數據集進行了探究,作者對比了SynthText和TextOCR [8]兩種數據集,結果如表6所示。

3.3 可視化結果

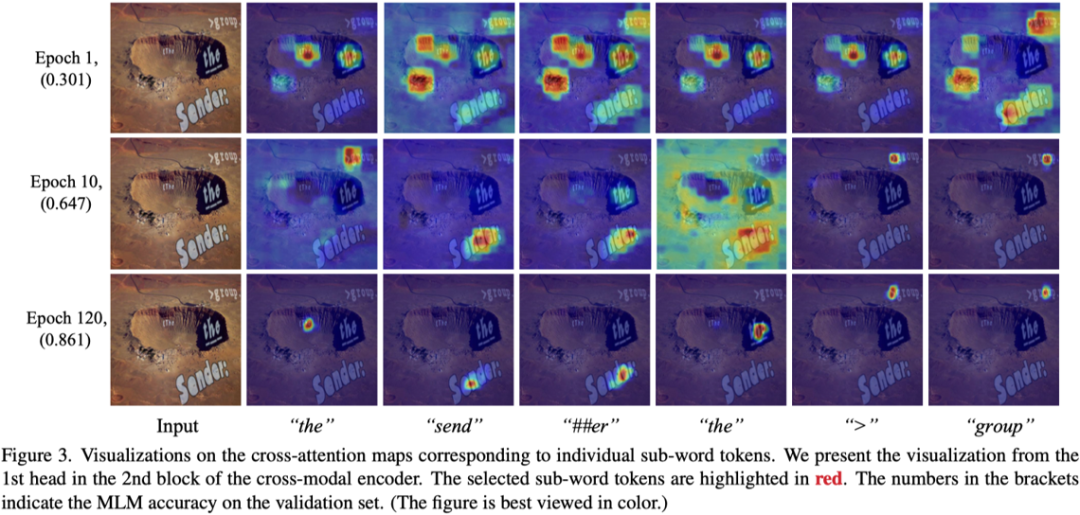

文章首先展示了Cross-model當中Attention Map的可視化結果。可以看到一個文本是與Attention Map中高亮區域是一一匹配的。

然后文章展示了和之前預訓練方法STKM [3] 對比的檢測結果。

四、總結與討論

在場景文本檢測當中,本文是第一篇用視覺語言模型以及多模態特征融合的思路去設計預訓練任務以提升文本檢測性能的工作,它設計了三個簡單有效的任務,提高了主干網絡對文本圖像特征的表征能力。如何利用文本和圖像兩種模態的特征也是未來OCR領域的一個重要方向。

原文作者:Sibo Song, Jianqiang Wan, Zhibo Yang, Jun Tang, Wenqing Cheng, Xiang Bai, Cong Yao

審核編輯:郭婷

-

檢測器

+關注

關注

1文章

864瀏覽量

47687 -

計算機

+關注

關注

19文章

7494瀏覽量

87949

原文標題:CVPR 2022 | 阿里&華科提出:針對場景文本檢測的視覺語言模型預訓練

文章出處:【微信號:CVer,微信公眾號:CVer】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

相關推薦

一文詳解知識增強的語言預訓練模型

【大語言模型:原理與工程實踐】大語言模型的基礎技術

【大語言模型:原理與工程實踐】大語言模型的預訓練

基于預訓練視覺-語言模型的跨模態Prompt-Tuning

利用視覺語言模型對檢測器進行預訓練

利用視覺語言模型對檢測器進行預訓練

評論