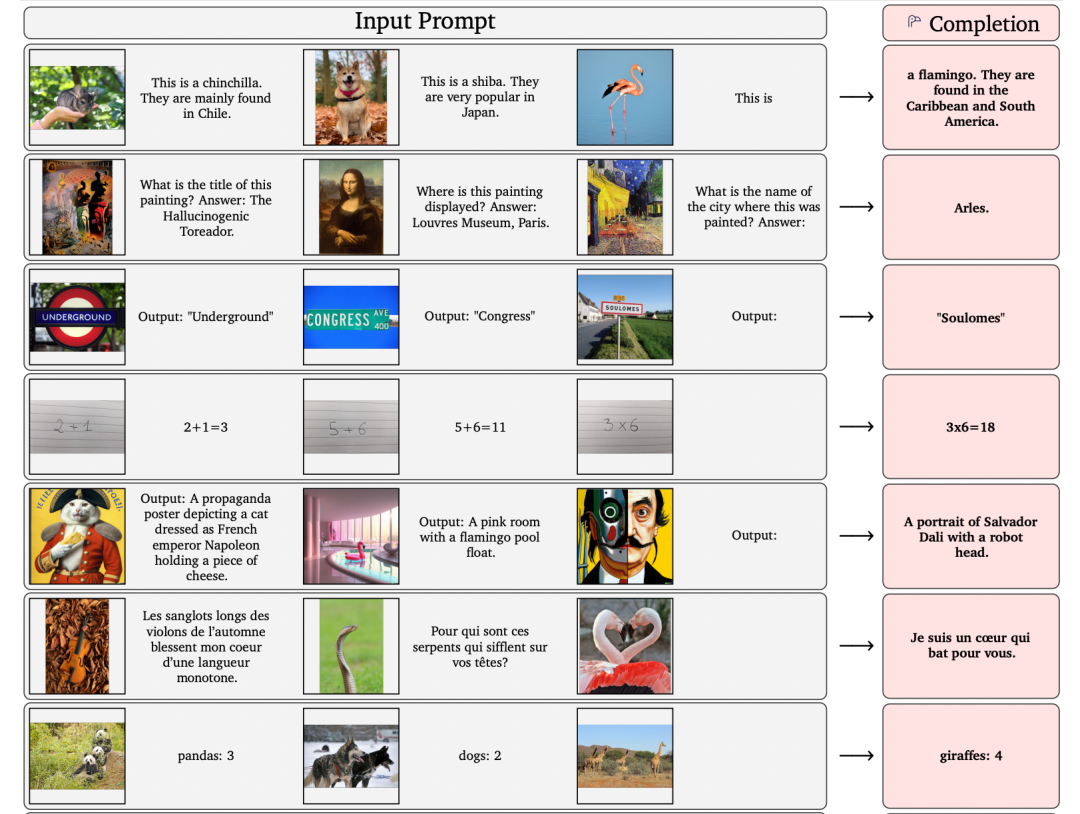

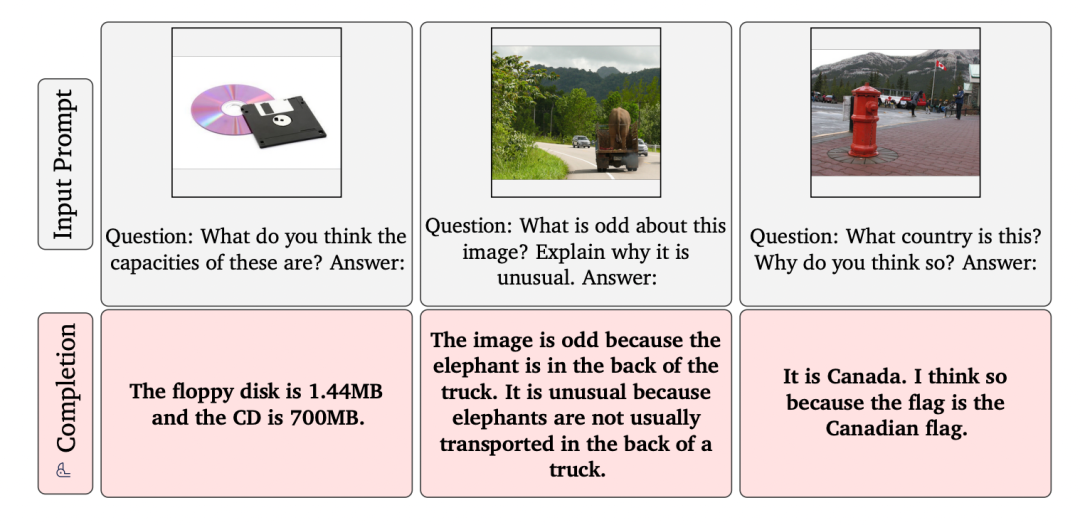

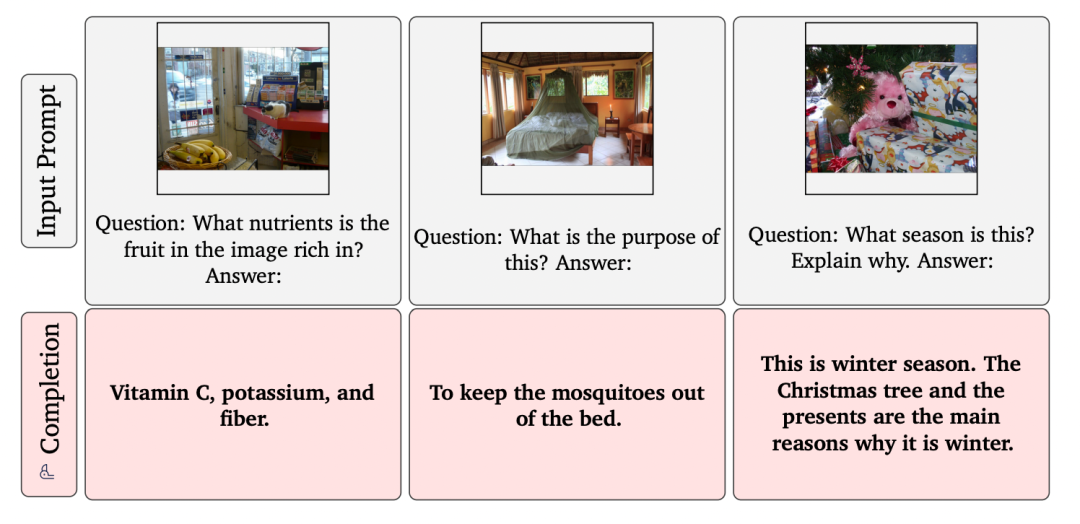

圖文多模態領域典型任務如img-text retrieval、VQA、captioning、grounding等,目前的學術設定難度尚可。但是, 一旦知識范圍擴展,到了open-ended scenario,任務難度立刻劇增 。但是DeepMind的Flamingo模型在這些挑戰場景中使用同一個模型便做到了。當時看到論文中的這些例子,十分驚訝!

可以看到,Flamingo模型不僅可以做到open-ended captioning、VQA等,甚至可以計數、算數。其中很多額外的知識,比如火烈鳥的發源地等知識,對于單模態的語言模型如GPT-3、T5、Chinchilla等可以說是難度不大。

但是對于傳統的多模態模型而言,很難通過傳統的img-text pair學到如此廣闊的外部知識,因為很多知識是蘊含在基于文本的單模態中的(如維基百科) 。所以,DeepMind在多模態領域的發力點就在 站人語言模型的巨人肩膀上,凍住超大規模訓練的語言模型,將多模態模型設計向NLP大模型靠攏。

Frozen

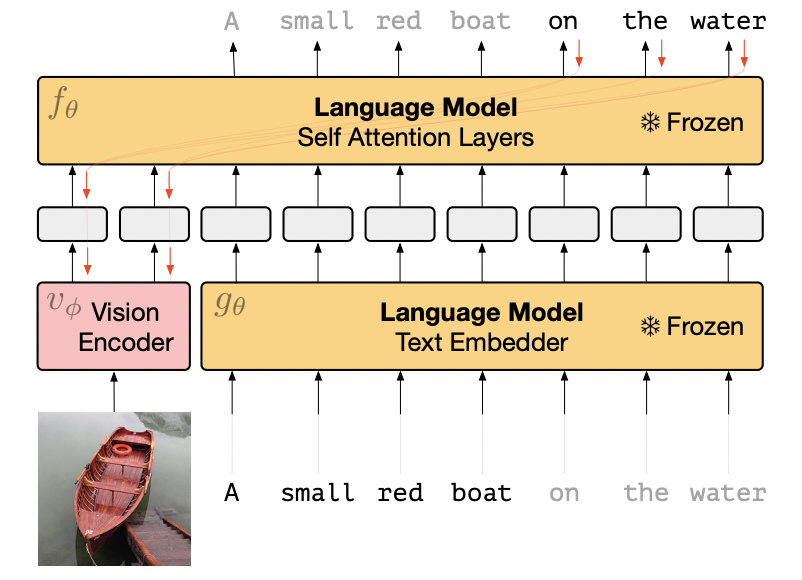

要介紹Flamingo模型,不得不先介紹DeepMind在NeurIPS 2021發表的前作Frozen。Frozen模型十分簡單,作者使用一個預訓練好的語言模型,并且完全凍結參數,只訓練visual encoder。

模型結構:其中LM模型是在C4數據上訓練的包含7B參數的transformer結構,visual encoder是NF-ResNet50。訓練數據:訓練時只采用了CC3M數據集,包含300萬img-text pair,預訓練數據量不大。Frozen框架如下。其中視覺特征可以看作是LM模型的prompt,凍結的語言模型就在視覺特征的“提示”下,做出應答。

Frozen模型結構

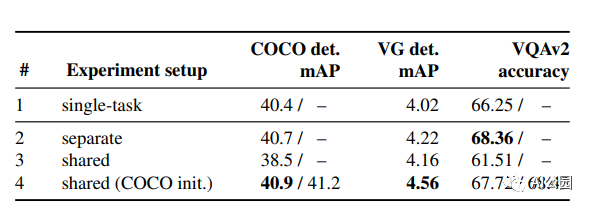

可以看到,通過一些img-text pair的約束,unfrozen的visual encoder是朝著frozen LM靠攏和對齊的。該算法在預訓練時只使用了captioning語料CC3M,并且知識的豐富度也有限。那么,Frozen模型能做什么呢?

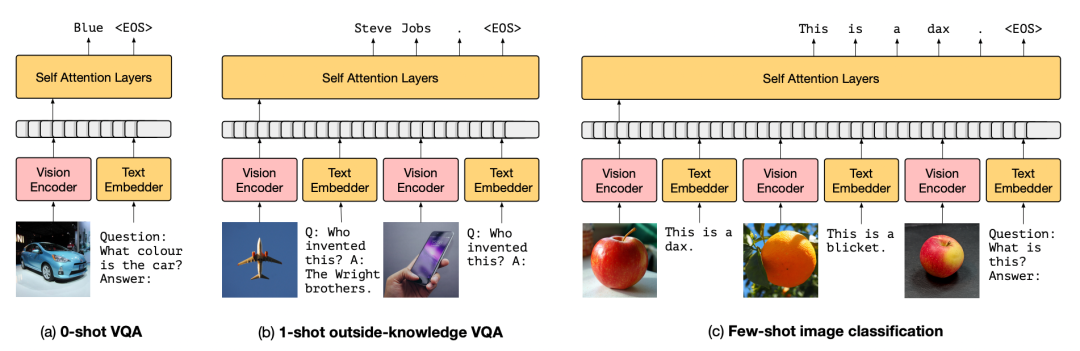

Frozen模型在下游場景的應用

雖然由caption數據(CC3M)訓練,它竟然可以做VQA甚至基于知識的VQA,比如上圖,你告訴它飛機是萊特兄弟發明的,它就能類比出蘋果手機是喬布斯創造的。很顯然, 這種外部知識肯定不是CC3M中有限的img-text pair能夠給予的,無非是來源于從始至終未參與訓練、凍結的LM模型 。接下來作者做了一系列實驗,可以看到,其實Frozen距離SOTA模型仍十分遙遠。

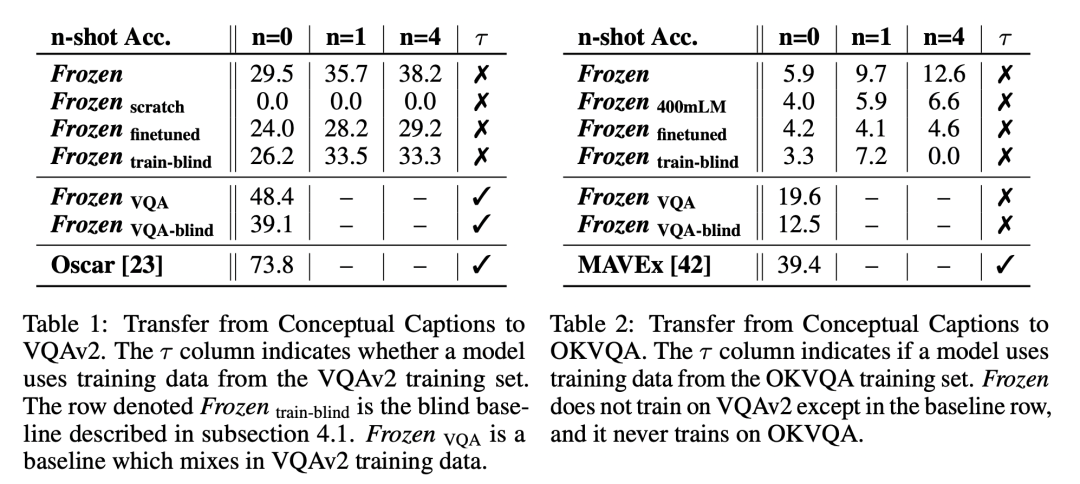

Frozen實驗結果

可以看到,Frozen模型距離VQA和OKVQA數據集上的SOTA算法仍有十分巨大的gap。

幾個有意思的現象:

如果模型看不到圖片(blind模型),只依賴于LM模型,效果尚可,但是明顯低于看得見圖片的模型。 說明Frozen確實對img-text模態進行了對齊,學習到了如何參考圖片信息再做出應答 ;

few-shot甚至zero-shot就可以達到還不錯的性能;

end-to-end finetune LM模型效果會下降,說明由大量單模態訓練出的LM模型參數很容易被少量的img-text數據破壞掉。證明了本文觀點,LM模型需要Frozen才能保留文本信息學到的知識!

Flamingo

介紹完了Frozen,那么DeepMind團隊再接再厲,創造效果驚艷的Flamingo模型就順理成章了。相比于Frozen,Flamingo模型的幾點改進:

更強的LM模型: 70B參數的語言模型Chinchilla;

更多的可訓練參數: visual encoder這次也凍結了,但是圖片特征采樣模型可以訓練,更重要的是LM模型的各層中也嵌入了可學習的參數,可訓練參數總量高達10B;

更恐怖的訓練數據:不僅加入了ALIGN算法的18億img-text pair,數百萬的video-text pair。此外,還有大量的不匹配的圖文信息,來源于MultiModal MassiveWeb (M3W) dataset,其中圖片數量上億,文本大概有182 GB。可以使用unpaired img-text數據進行訓練也是Flamingo模型的一大亮點。總而言之,它的數據量十分恐怖,已經遠遠超過目前業界的多模態算法比如CLIP、ALIGN、SimVLM、BLIP等。

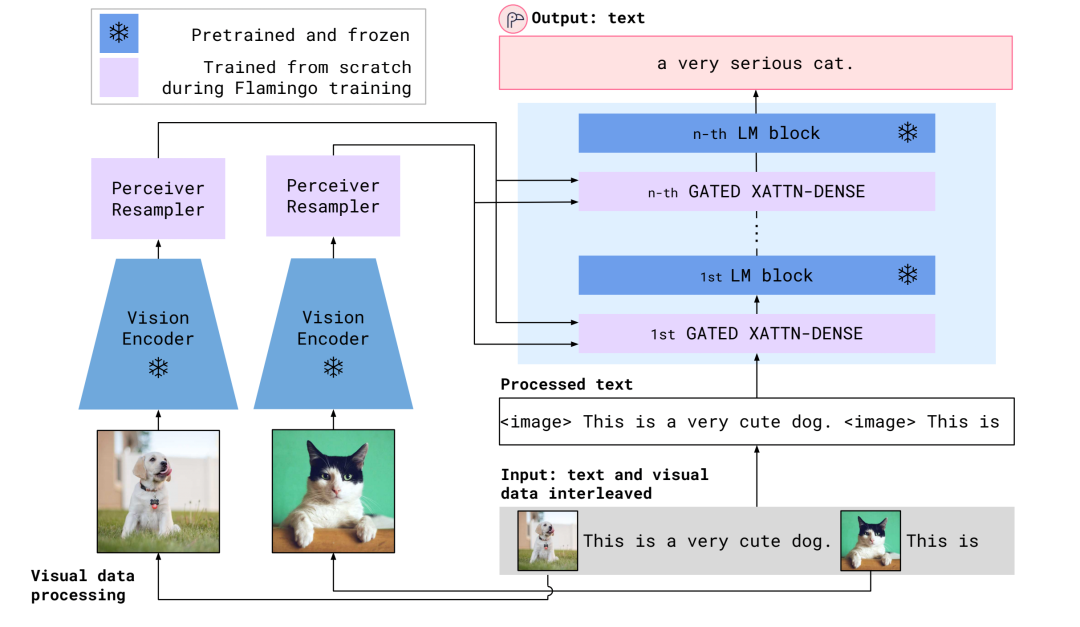

下面看看Flamingo的模型結構:

Flamingo模型結構

可以看到, 不同于Frozen,這一次visual encoder也是凍結的。參數可以學習的就兩部分,一個是Perceiver Resampler,一個是嵌入在LM模型中的Gated Block。Perceiver Resampler結構如下:

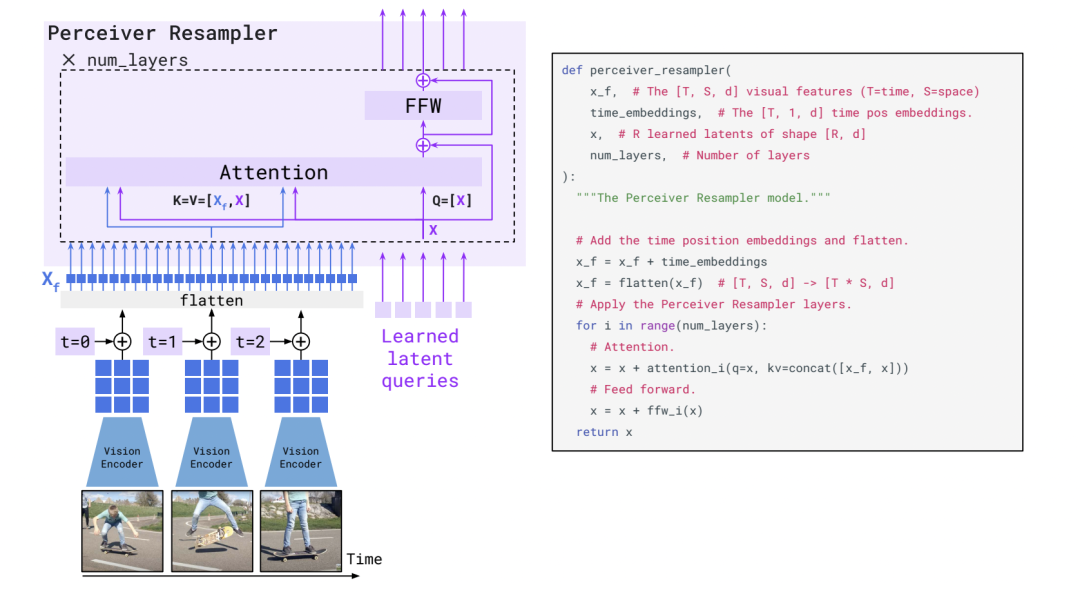

Perceiver Resampler結構

Perceiver Resampler結構一目了然,一些可學習的embedding作為query,然后圖片特征或者時續的視頻特征attend到query上,作為最后的輸出。

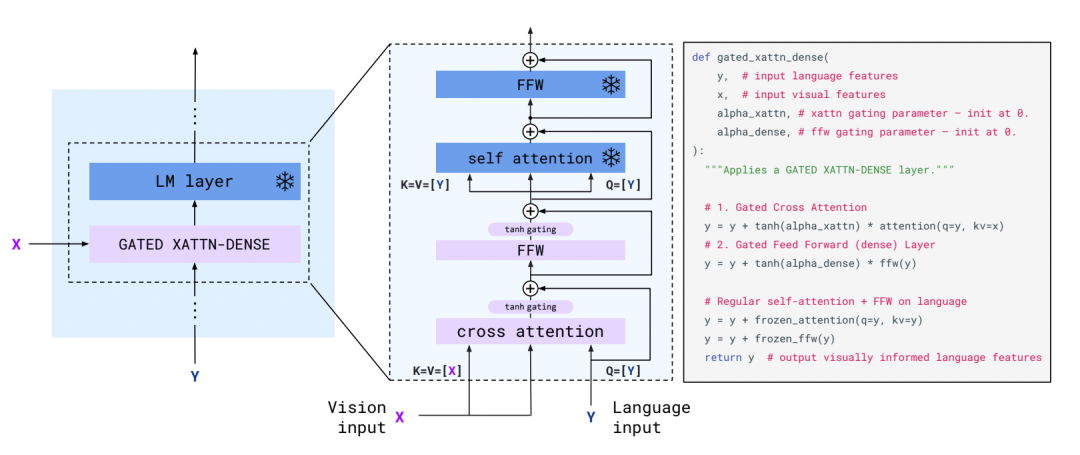

gated xattn-dense結構

嵌入在LM模型中的gated xattn-dense的結構同樣一目了然,使用文本信息作為query去aggregate視覺信息。其中text embedding作為query,visual embedding作為key和value。類比于transformer結構,唯一小的差別就是cross-attention和FFN之后額外加了一個gate。

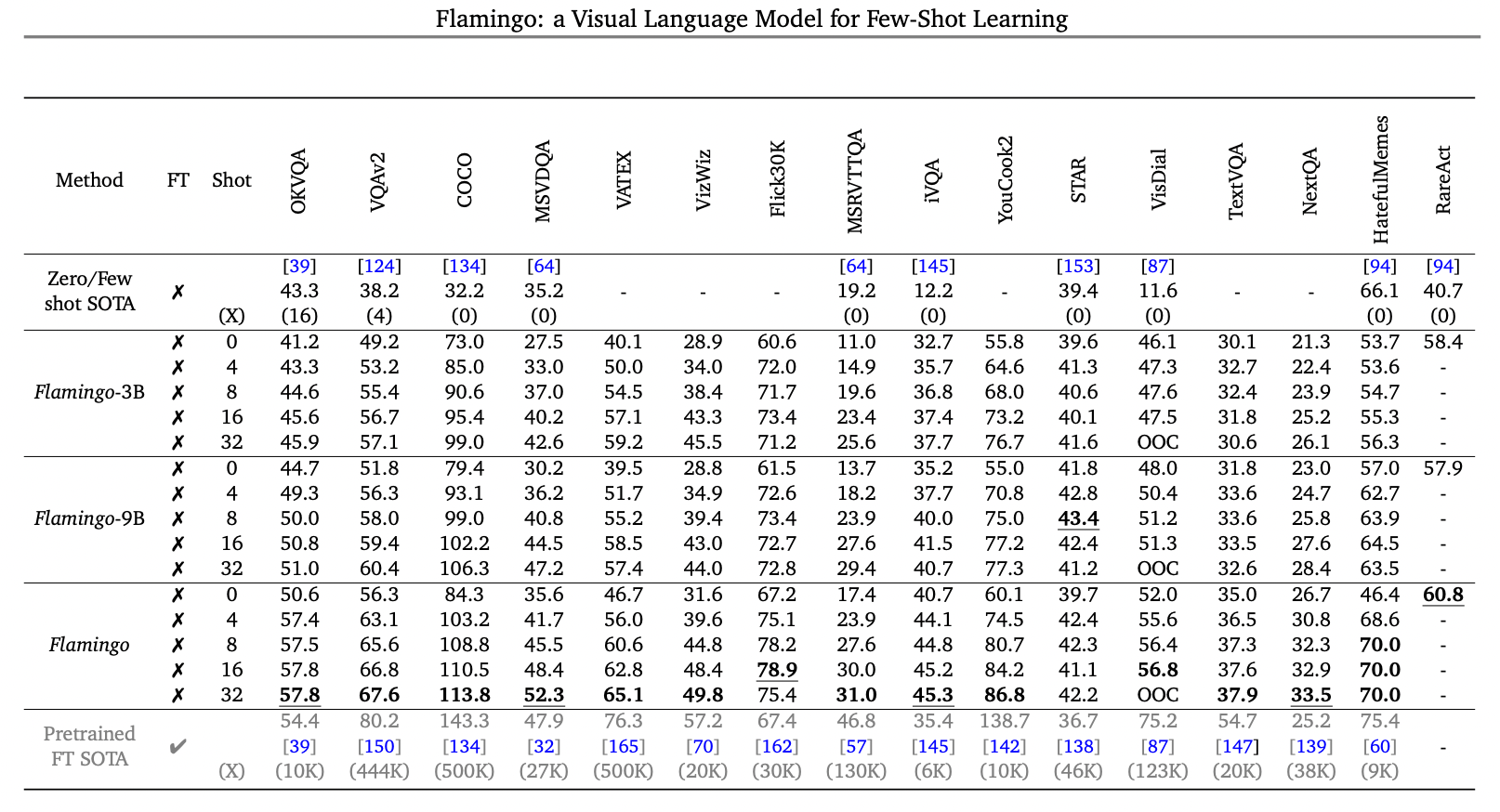

介紹完了Flamingo的模型結構,簡單看看它的爆表性能吧,可以說,下游場景中只用few-shot的情況下做到這種程度,讓人驚訝...... 在一些答案集合固定的任務中,比如傳統的VQAv2中優勢不明顯, 但是open-ended的knowledge-based VQA任務中,比如OKVQA,只用few-shot就可以刷新當前SOTA 。 在盲人場景的VizWiz以及OCR信息特別多的TextVQA等任務中,效果同樣可圈可點。一些基于視頻的QA比如NextQA和iVQA效果同樣刷新當前最好性能......

如果Flamingo不使用few-shot模式,而進行fine-tune模式,論文中顯示,同樣可以刷新不少業界SOTA指標,這里就不列舉了。最后再列出幾個讓人驚嘆的示例結束本文,準備再去好好研究一番論文細節。

多模態描述,多模態問答,多模態對話,多模態推薦……以前很多人覺得很遙遠,但是近年來進展飛速,距離實際場景的gap也在逐步縮小,未來可期~

-

語言模型

+關注

關注

0文章

524瀏覽量

10277 -

數據集

+關注

關注

4文章

1208瀏覽量

24703 -

nlp

+關注

關注

1文章

488瀏覽量

22038

原文標題:站在NLP巨人模型的肩膀才是多模態的未來?

文章出處:【微信號:zenRRan,微信公眾號:深度學習自然語言處理】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

相關推薦

多文化場景下的多模態情感識別

如何讓Transformer在多種模態下處理不同領域的廣泛應用?

簡述文本與圖像領域的多模態學習有關問題

如何使用多模態信息做prompt

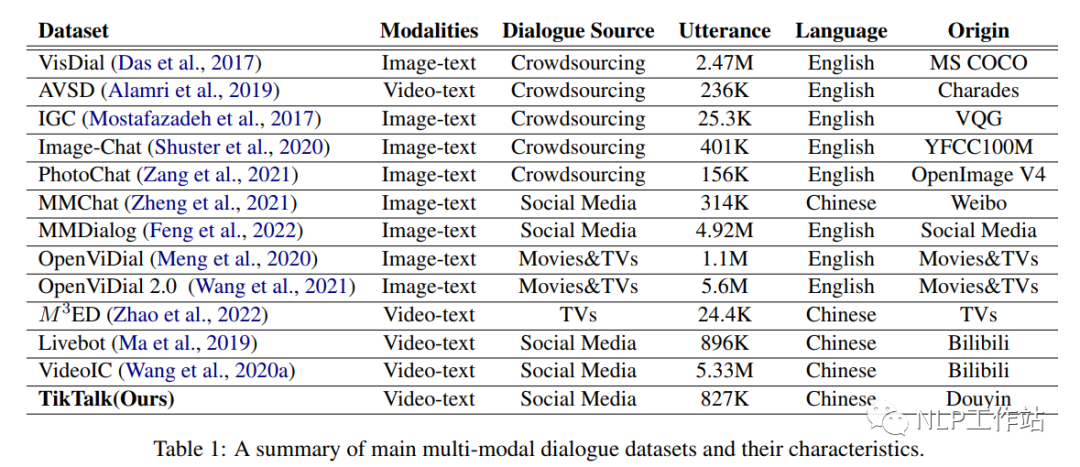

一個真實閑聊多模態數據集TikTalk

如何利用LLM做多模態任務?

邱錫鵬團隊提出具有內生跨模態能力的SpeechGPT,為多模態LLM指明方向

更強更通用:智源「悟道3.0」Emu多模態大模型開源,在多模態序列中「補全一切」

基于視覺的多模態觸覺感知系統

基于圖文多模態領域典型任務

基于圖文多模態領域典型任務

評論