通常來說,如果一個數據中心服務器規模超過10萬臺,就可以稱large-scale datacenter,也就是常說的大規模數據中心。大規模數據中心對于網絡的要求有很多,但是突出的就在于穩定和簡單。

這兩點要求本身也有一定的關聯性。比如,大規模數據中心因為網絡設備數量多,所以從統計學的角度來說,出故障的頻率也更高。這里說的故障,不僅包括設備本身出現的硬件軟件問題,還包括因為運維過程中對設備誤操作引起的故障。因此,一個簡單的網絡設計,例如采用統一的硬件連接方式,使用有限的軟件功能,能減少故障概率,從而一定程度提升整個網絡架構的穩定性。但是,或許不只對于IT行業,對于任何領域,用簡單的方法去解決一個復雜的問題,本身就不簡單。因此,這一次分析一下如何用CLOS架構,來“簡單的”管理大規模數據中心的網絡。

CLOS架構

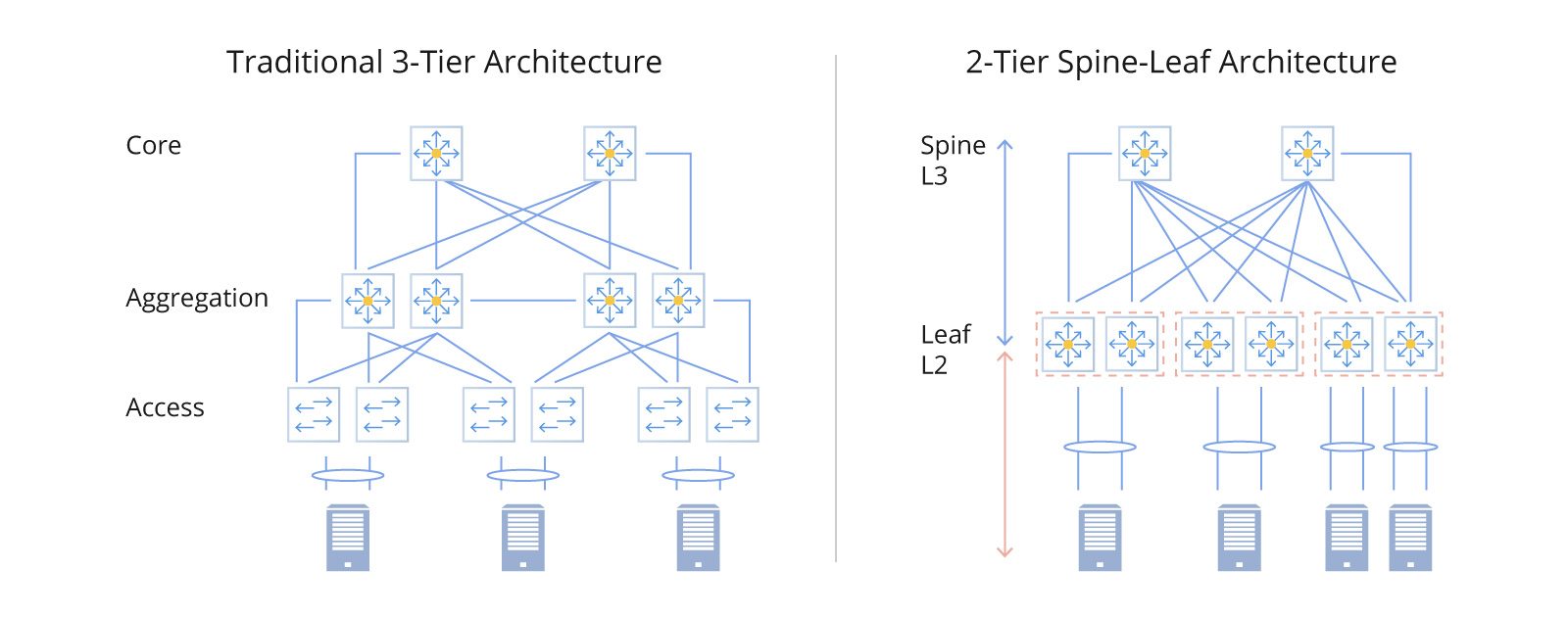

CLOS架構被廣泛應用在現代的數據中心,因為它提供了數據中心的水平擴展能力和大規模數據中心所需要的穩定和簡單。下圖就是一個基本的CLOS單元,Spine和Leaf交換機共同組成數據中心網絡,其中Leaf交換機作為TOR交換機,連接服務器;Spine交換機,為Leaf交換機提供網絡連接。

水平擴展能力

想要擴展一個CLOS網絡架構,通常有兩種方法,就是增加設備的端口數;第二就是增加更多的層級。在現有的spine-leaf基礎上,再增加一層super-spine交換機,就可以構成一個5-stages CLOS架構。增加了一層super-spine交換機,數據中心規模也水平擴大了一倍。

穩定簡單

從眼來看,CLOS架構是簡單的。根據CLOS理論,所有的交換機,不論是Super Spine,Spine和是Leaf,都應該采用同質的交換機。雖然實際應用和文中圖里面,都不一定嚴格按照這個要求來,但是至少是照著這個樣式去實現。所以從硬件構成來看,較為簡單。其次,CLOS架構采用的是一個純L3網絡的架構,也就是說所有的交換機都是三層交換機,交換機之間都通過IP網絡連接的。所以,從網絡連接來看,也較為簡單。畢竟,傳統三層網絡架構,要涉及到L2連接,L3連接,VLAN配置等等。

穩定包含很多,除了相對簡單的設計,還有就是減少故障范圍。0故障是不可能的,這輩子都不可能0故障。我們能做的是限制故障的范圍,而CLOS架構下,每個Leaf交換機下都是一個獨立的L2 Domain,這樣可以將所有二層網絡的問題,例如BUM風暴,限制在一個Leaf交換機范圍內。

所以網絡架構的IP地址分布如下:

看起來似乎很美好,但是相比較傳統的三層網絡,CLOS架構也有自己的問題,其中包括但不限于以下幾點:那如何為CLOS架構選取一個合適的路由協議?常規的選項是使用且僅使用EBGP。BGP一直以IBGP的形式來構建數據中心內部網絡,而且是構建在IGP,例如OSPF之上的。而EBGP一般用來連接不同的數據中心。但是在CLOS架構中,EBGP,卻是合適的一個協議,因為它能極大簡化實現。先因為現在路由條目數增多,這樣的量級只有BGP能穩定維護。

其次,因為現在每個Leaf Switch,都管理一個獨立的子網。而數據中心內網絡連通的前提是,每一個Leaf Switch的子網,都需要傳給其他所有的Leaf Switch。這樣,相當于每個Leaf Switch都是一個自治域(AS),現在要實現的就是實現所有的自治域的連通。這個問題,就是EBGP在互聯網上正在解決的問題。

因此在CLOS架構下,采用了EBGP作為路由協議,具體細節有以下幾點:

EBGP連接都是單跳。這樣就不用依賴IGP構建nexthop網絡,EBGP的nexthop都在鏈路的另一端。EBGP與IBGP的一個大不同在于,EBGP會轉發路由,因此借助Spine和Super Spine上面EBGP程序的轉發,一個Leaf的子網信息,可以發布給所有其他Leaf交換機,從而實現全數據中心內網絡聯通。

但是這里有一個問題,在大規模數據中心里面,按照10萬條服務器,一個機架40臺服務器算的話,總共會有2500個Leaf交換機,這樣,光是Leaf就把 ASN消耗完了。為了解決這個問題,可以使用4字節的ASN(RFC6793);也可以在一組Spine下面,復用ASN,:所以,僅通過EBGP,就是實現了CLOS架構中網絡連接需要的全部內容。相比較傳統三層網絡架構,CLOS架構這里又以簡單勝出。

審核編輯 黃昊宇

-

數據中心

+關注

關注

16文章

4778瀏覽量

72129 -

網絡架構

+關注

關注

1文章

93瀏覽量

12590

發布評論請先 登錄

相關推薦

華迅光通AI計算加速800G光模塊部署

數據中心布線光纜設計方案

Jim Keller:NVIDIA私有協議弊端多,倡導開放技術以省數十億

傳統數據中心架構和葉脊架構網絡解決方案

介紹一種高性能計算和數據中心網絡架構:InfiniBand(IB)

AI數據中心架構升級引發800G光模塊需求激增

數據中心網絡架構:萬兆電口模塊的重要作用

數據中心與網絡架構

數據中心與網絡架構

評論