如果你是一個活躍的 Jetson 開發者,你知道 NVIDIA ISAAC 的一個關鍵優點是它將 CPU 和 GPU 組合成一個單一的模塊,在一個可以部署在邊緣的小、低功耗軟件包中為你提供擴展的 NVIDIA 軟件堆棧。

Jetson 還具有多種其他處理器,包括硬件加速編碼器和解碼器、圖像信號處理器和深度學習加速器( DLA )。

DLA 可在 Jetson AGX Xavier, Xavier NX, Jetson AGX Orin 和 Jetson Orin-NX 模塊上使用。最近的 NVIDIA DRIVE Xavier 和基于 Orin 的平臺也有 DLA 核心。

深度學習加速器概述

DLA 是一種特定于應用的集成電路,能夠有效地執行固定操作,如卷積和池,這在現代神經網絡架構中很常見。雖然 DLA 沒有那么多 支持的層 作為 GPU ,它仍然支持許多流行的神經網絡架構中使用的各種層。

在許多情況下,層支持可能涵蓋模型的需求。例如, NVIDIA TAO 工具包 包括 DLA 支持的各種預訓練模型,從目標檢測到動作識別。

雖然需要注意的是, DLA 吞吐量通常低于 GPU 的吞吐量,但它具有能效,允許您卸載深度學習工作負載,將 GPU 釋放出來用于其他任務。或者,根據您的應用程序,您可以在 GPU 和 DLA 上同時運行相同的模型,以實現更高的凈吞吐量。

許多 NVIDIA Jetson 開發者已經在使用 DLA 成功優化他們的應用程序。 Postmates 利用 DLA 和 GPU 優化了 Jetson AGX Xavier 上的交付機器人應用。這個 菜鳥實驗室 使用 DLA 優化其物流車輛。如果您希望充分優化應用程序, DLA 是 Jetson 系列中需要考慮的一個重要部分。

如何使用深度學習加速器

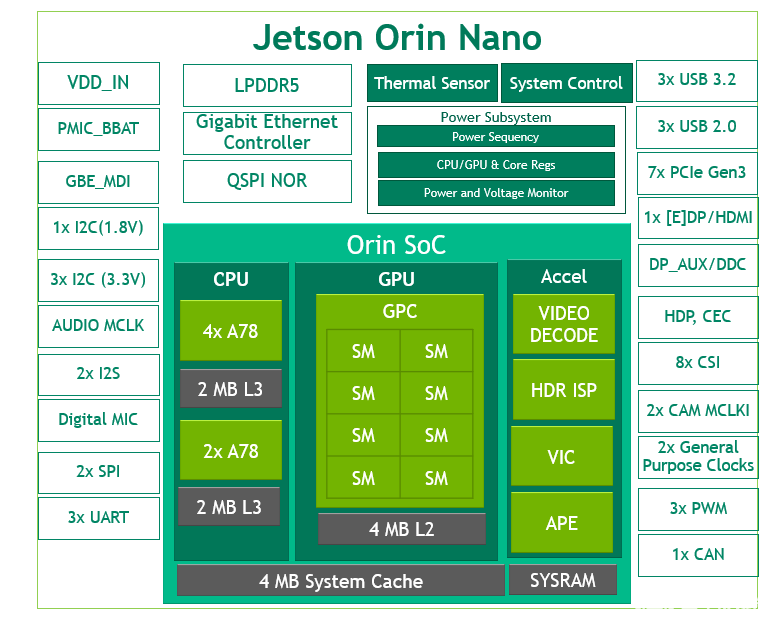

圖 1.Jetson Orin 上深度學習加速器的粗略架構圖

要使用 DLA ,首先需要使用深度學習框架(如 PyTorch 或 TensorFlow )來訓練模型。接下來,您需要使用 NVIDIA TensorRT 導入并優化您的模型。 TensorRT 負責生成 DLA 引擎,也可以用作執行這些引擎的運行時。最后,您應該分析您的模式,并盡可能進行優化,以最大限度地提高 DLA 兼容性。

開始使用深度學習加速器

準備好潛水了嗎?這個 Jetson_dla_tutorial GitHub 項目演示了一個基本的 DLA 工作流,可以幫助您優化 Jetson 的應用程序。

通過本教程,您可以學習如何在 PyTorch 中定義模型,使用 TensorRT 導入模型,使用 NVIDIA Nsight System profiler 分析性能,修改模型以獲得更好的 DLA 兼容性,以及為 INT8 執行進行校準。請注意, CIFAR10 數據集用作玩具示例,以便于再現步驟。

關于作者

John Welsh 是 NVIDIA 自治機器的開發技術工程師,他與 NVIDIA Jetson 一起開發加速應用程序。

審核編輯:郭婷

-

解碼器

+關注

關注

9文章

1144瀏覽量

40842 -

編碼器

+關注

關注

45文章

3655瀏覽量

134942 -

深度學習

+關注

關注

73文章

5511瀏覽量

121355

發布評論請先 登錄

相關推薦

英偉達推出Jetson Orin Nano模組最高40TOPS性能,為機器人和邊緣AI提供強動力

NVIDIA Jetson的相關資料分享

NVIDIA Jetson介紹

NVIDIA Jetson AGX Orin提升邊緣AI標桿

NVIDIA推出全新Jetson Orin Nano系統級模組

NVIDIA Nova Orin平臺助力AMR的構建和部署

將Jetson AGX Orin開發者套件轉化為任何Jetson Orin模塊

使用NVIDIA Jetson Orin Nano解決入門級邊緣人工智能挑戰

NVIDIA Jetson Orin Nano的性能基準

GTC23 | 使用 NVIDIA Jetson Orin Nano 開發套件開發 AI 機器人及智能視覺系統

NVIDIA 推出 Jetson AGX Orin 工業級模塊助力邊緣 AI

利用 NVIDIA Jetson 將 AI 學習延展至邊緣

NVIDIA Jetson Orin深度學習加速器入門

NVIDIA Jetson Orin深度學習加速器入門

評論