融入了Prompt的新模式大致可以歸納成”pre-train, prompt, and predict“,在該模式中,下游任務被重新調整成類似預訓練任務的形式。例如,通常的預訓練任務有Masked Language Model, 在文本情感分類任務中,對于 "I love this movie." 這句輸入,可以在后面加上prompt "The movie is ___" 這樣的形式,然后讓PLM用表示情感的答案填空如 "great"、"fantastic" 等等,最后再將該答案轉化成情感分類的標簽,這樣以來,通過選取合適的prompt,我們可以控制模型預測輸出,從而一個完全無監督訓練的PLM可以被用來解決各種各樣的下游任務。

因此,合適的prompt對于模型的效果至關重要。大量研究表明,prompt的微小差別,可能會造成效果的巨大差異。研究者們就如何設計prompt做出了各種各樣的努力——自然語言背景知識的融合、自動生成prompt的搜索、不再拘泥于語言形式的prompt探索等等。

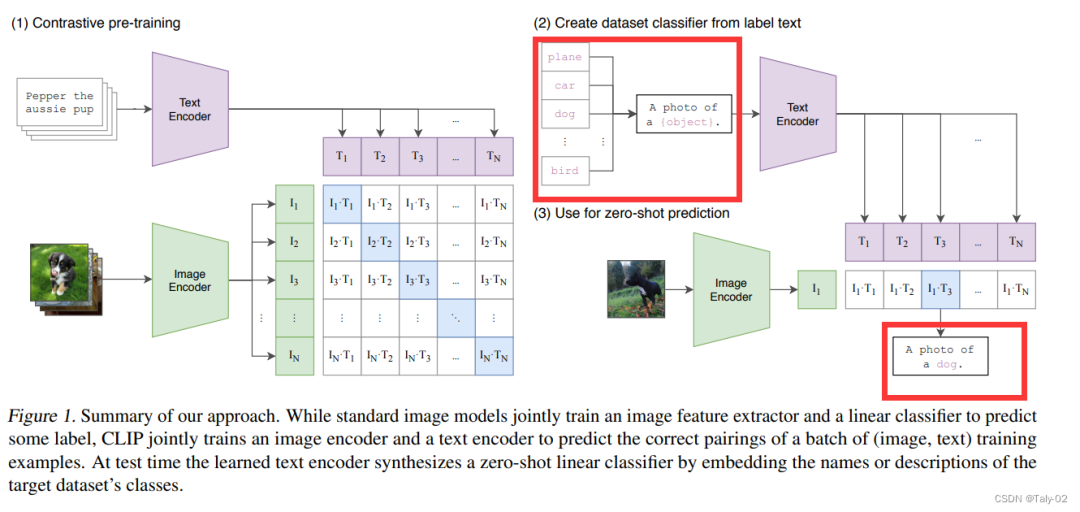

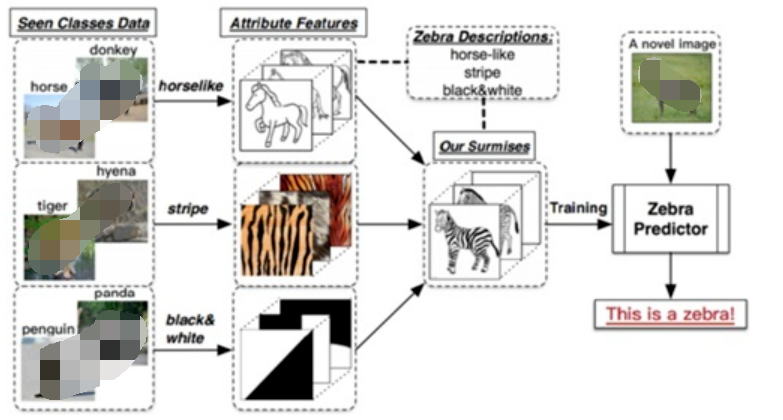

而對于視覺領域的prompt,最近在視覺語言預訓練方面的進展,如CLIP和ALIGN,prompt為開發視覺任務的基礎模型提供了一個有前途的方向。這些基礎模型在數百萬個有噪聲的圖像-文本對上進行訓練后編碼了廣泛的視覺概念,可以在不需要任務特定的訓練數據的情況下以零目標的方式應用于下游任務。這可以通過適當設計的prompt提示實現。

以CLIP為例,如下圖紅色方框強調所示,可以完成對“class label”的拓展,使得模型具有較為豐富的視覺信息。然后,可以使用CLIP對圖像進行分類,以度量它們與各種類描述的對齊程度。因此,設計這樣的提示在以zero-shot方式將基礎模型應用到下游任務中起著至關重要的作用。

然而,這種手工制作的prompt需要特定于領域的靈感,因此可能較難設計,所以如何設計一種模式,可以讓讓模型自適應地學習到有關prompt的一些參數和設定是非常有必要的。與手工制作的prompt相比,這種方法可以找到更好的prompt,但學習到的prompt僅限于與訓練數據對應的分布和任務,除此之外的泛化可能有限。

此外,這種方法需要帶注釋的訓練數據,這可能非常昂貴,而且不能很好地應用于zero-shot的相關任務中。為了解決上述的挑戰, 論文提出在測試階段使用test-time prompt tuning(TPT),只使用給定的測試樣本對prompt進行調整。由于避免了使用額外的訓練數據或標注,TPT仍然遵守了zero-shot的設置。

. 方法

論文首先簡單回顧了CLIP和基于CLIP的一些可學習參數的prompts獲取方法。對于為何要優化prompt,論文是這樣描述的:CLIP包含了豐富的知識,從前期的訓練中獲得了海量的知識和不同的數據感知能力。然而,如何更有效地提取這些知識仍然是一個開放的問題。一個簡單的策略是直接對模型進行微調,無論是端到端的還是針對的一個子集層,對一類的輸入。然而,先前的工作表明,這種微調策略導致特定于領域的行為失去了非分布泛化和魯棒性的基礎模型。

因此,這項工作的目標是利用現有的CLIP知識來促進其泛化到zero-shot的廠家中去。因此,調整prompt就是實現這一目標的理想途徑。此外,我們將測試時提示調優視為為模型提供上下文的一種方法為單個測試樣本量身定制,有助于精確檢索CLIP知識。

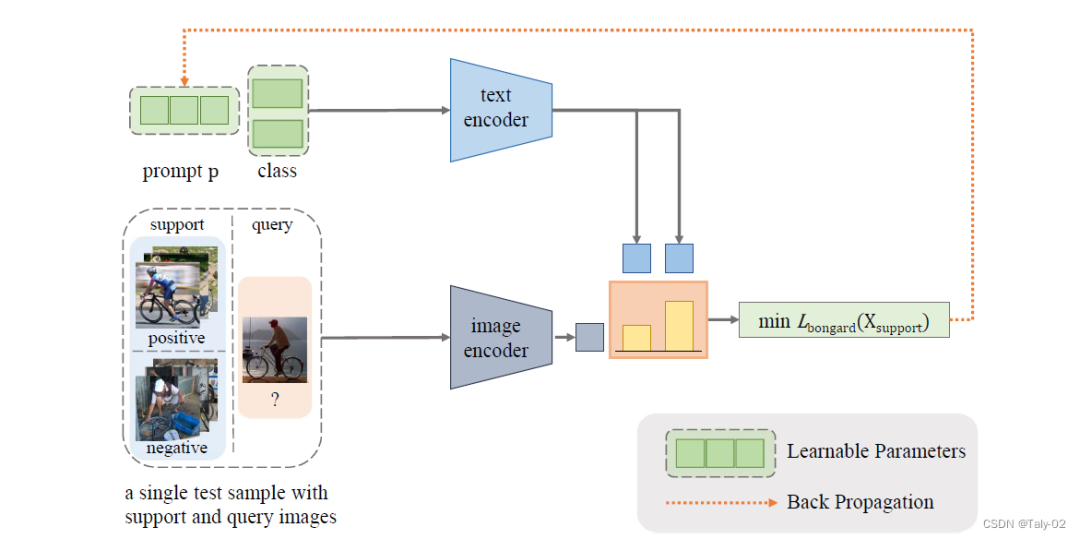

論文的目的很簡單,就是在測試階段得不到測試樣本ground-truth標注的時候,進行一定的訓練,具體表現為

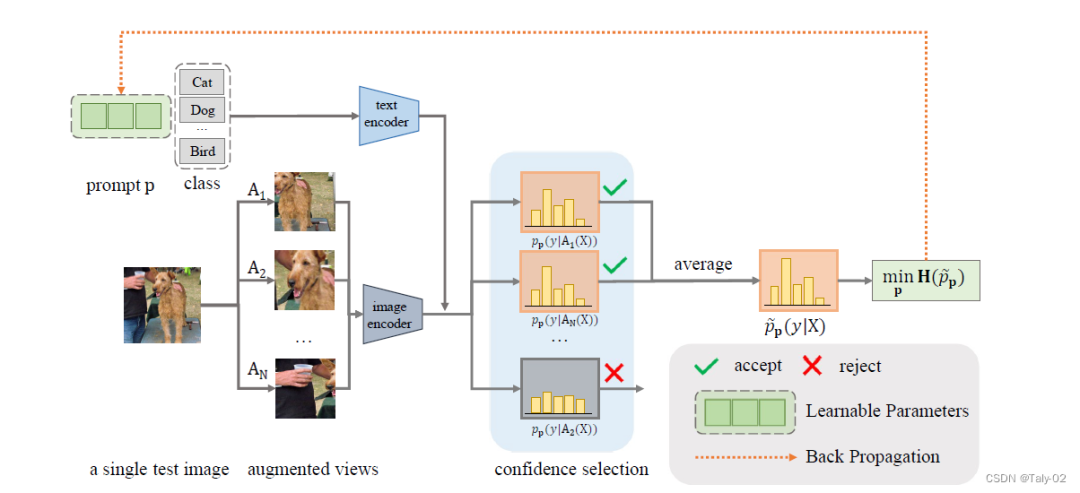

因為標簽不能用于測試階段的優化,所以我們如果想在測試階段進行優化就必須選擇用于能夠提供一定hint的無監督損失函數來指導優化。因此,論文設計了TPT目標來促進采用不同數據增強下,模型的一致性。通過對給定測試相同圖像的不同增強類型的特征,來依照他們預測的差值來進行訓練。具體來說,我們使用一個隨機增廣cluster生成測試圖像的N個隨機augumention視圖,最小化平均預測概率分布的熵:

這里 是根據物體不同prompt and the -th augmented view of the test image預測出的概率。

值得一提的是,為了減少隨機增強的噪聲(也就是說增強之后模型很難再預測出正確的分類信息,如刪去了圖像非常關鍵的content),本文還引入了一個新的機制:confidence selection,來選擇過濾增強產生的低置信度預測的view。數學表達式體現為:

實驗

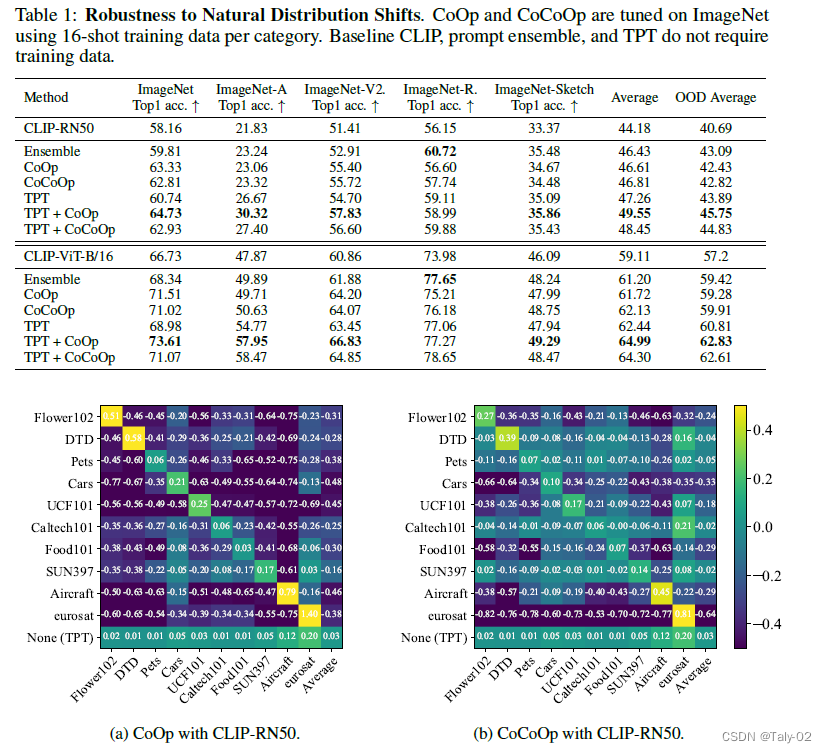

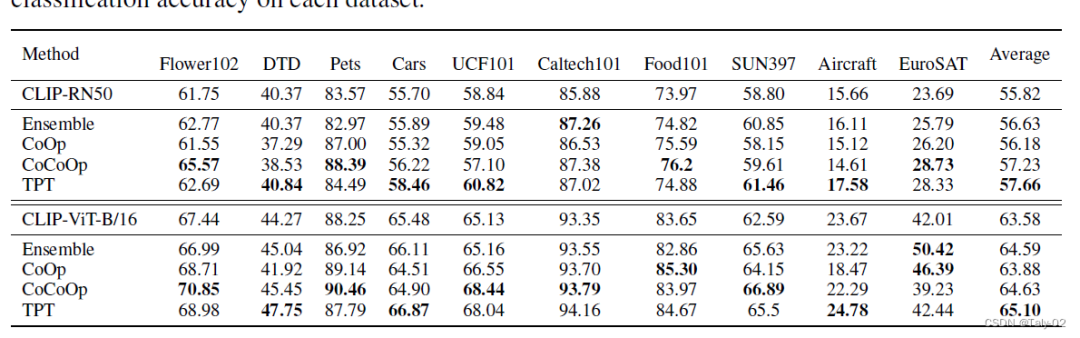

首先論文根據CoOp 和 CoCoOp的混淆矩陣可視化來判斷這兩種可學習的prompt參數化方式在不同數據集上的遷移性很差,有增加參數量過擬合的嫌疑。所以其實在訓練階段,增加參數量來做相應的操作不見得合理。因此才更能體現本文這種基于測試階段方法提出方法的優越性。

可以發現,本文提出的這種方法在不同數據集之間的遷移性非常之好。

結論

本文研究了如何充分挖掘預訓練視覺-語言基礎大模型的更好零樣本學習能力。論文提出了Test-time Prompt Tuning, TPT),這種新的prompt調整方法,可以使用單個測試樣本動態學習自適應提示。我們證明了該方法對自然分布變化的魯棒性跨數據集泛化,使用CLIP作為基礎模型。不需要任何訓練數據或標注,TPT提高了CLIP的zero-shot的泛化能力。

-

模型

+關注

關注

1文章

3244瀏覽量

48844 -

數據集

+關注

關注

4文章

1208瀏覽量

24703 -

Clip

+關注

關注

0文章

31瀏覽量

6667 -

自然語言

+關注

關注

1文章

288瀏覽量

13350 -

大模型

+關注

關注

2文章

2451瀏覽量

2714

原文標題:面向測試階段的prompt搜索方式

文章出處:【微信號:GiantPandaCV,微信公眾號:GiantPandaCV】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

相關推薦

【大語言模型:原理與工程實踐】大語言模型的預訓練

【大語言模型:原理與工程實踐】大語言模型的應用

基于深度學習的自然語言處理對抗樣本模型

基于預訓練視覺-語言模型的跨模態Prompt-Tuning

如何更高效地使用預訓練語言模型

預訓練數據大小對于預訓練模型的影響

一個通用的自適應prompt方法,突破了零樣本學習的瓶頸

什么是零樣本學習?為什么要搞零樣本學習?

如何充分挖掘預訓練視覺-語言基礎大模型的更好零樣本學習能力

如何充分挖掘預訓練視覺-語言基礎大模型的更好零樣本學習能力

評論