1. 論文信息

題目:Uncertainty Modeling for Out-of-Distribution Generalization

作者:Xiaotong Li, Yongxing Dai, Yixiao Ge, Jun Liu, Ying Shan, Ling-Yu Duan

論文鏈接:https://arxiv.org/abs/2202.03958v1

代碼鏈接:https://github.com/lixiaotong97/DSU

2. 引言

Deep neural networks 在Computer Vision領域取得了非常大的成功,但嚴重依賴于訓練和測試的domain遵循 identical distribution的假設。然而,這一假設在許多實際應用中并不成立。例如,當將在晴天訓練的分割模型用于雨天和霧天環境時,或用在照片上訓練的模型識別藝術繪畫時,在這種非分布部署場景中常常可以觀察到不可避免的性能下降。

因此,以提高網絡在各種不可見測試域上的魯棒性為目標的領域泛化問題就顯得十分重要。本文就主要聚焦,如何在分布發生偏移變化的時候,讓模型仍能比較好的work。

之前的許多工作都已經闡述了,特征數據其實算是可以比較好的建模訓練數據中抽象出來的特征。domain的feature主要是指對單個領域更具體但與任務目標相關性較小的信息,如物體識別中的照片風格和捕獲環境信息。因此,具有不同數據分布的域通常具有不一致的特征統計。所以我們只需要根據 Empirical Risk Minimization的原則來最小化訓練集損失誤差就可以了。

但是其實這些之前的方法都會有一個缺陷,就是這些方法在測試階段中沒有明確考慮潛在的domain偏移引起的不確定統計差異。因此可能帶來模型無法處理一部分的out-of-distribution數據,而在訓練集中提供的OOD樣本數過擬合。所以,在訓練階段引入一定的uncertain statistics對于模型泛化性能的提升是非常關鍵,且有必要的。

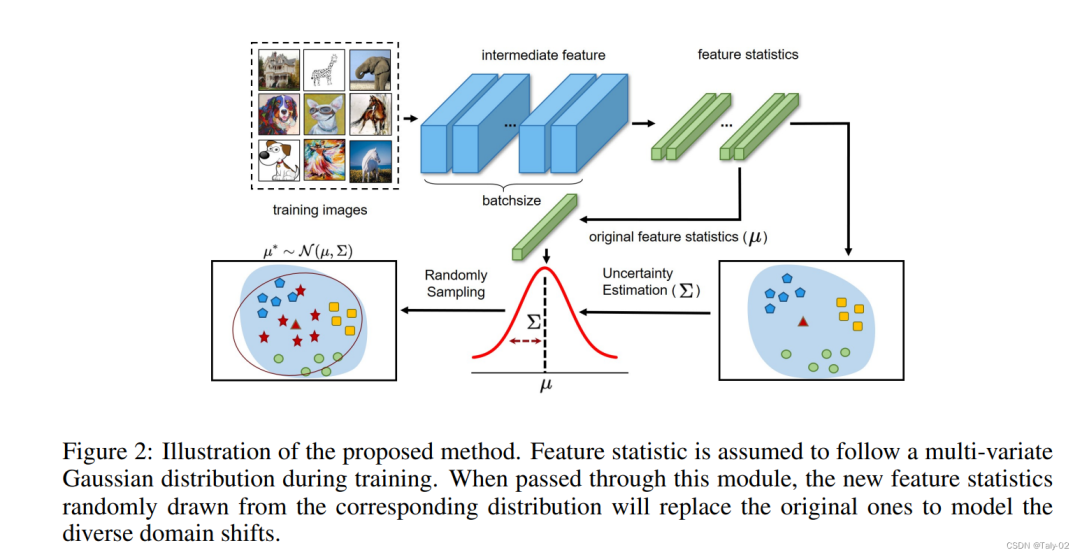

概括來講,本文的核心idea就是:將特征的統計數據進行分析計算,把它建模成一個不確定的分布,在分布中特征統計量的根據這種uncertain進行不同的采樣,從而生成各種不同的風格的圖像,來提升模型在不同目標域的泛化性。我們提出的方法簡單而有效地緩解了domain shift引起的性能下降,并且可以很容易地集成到現有的網絡中,而不帶來額外的模型參數或loss的約束。在廣泛的視覺任務上的綜合實驗證明了該方法的優越性,充分的實驗表明在特征統計中引入uncertainty可以很好地提高模型對域偏移的泛化能力。

3. 方法

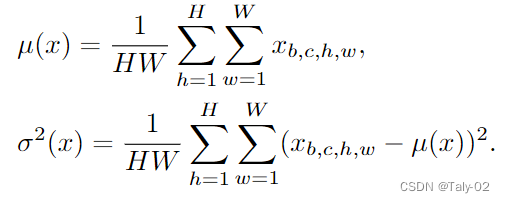

首先,是對一個mini-batch中的特征進行建模:

在非分布場景下,由于域特征不同,特征統計量往往與訓練域不一致,不適合于非線性層和歸一化層等深度學習模塊,降低了模型的泛化能力。然而,大多數深度學習方法只將特征統計量視為從特征中測量出的確定性值,而沒有明確考慮到潛在的不確定統計差異。

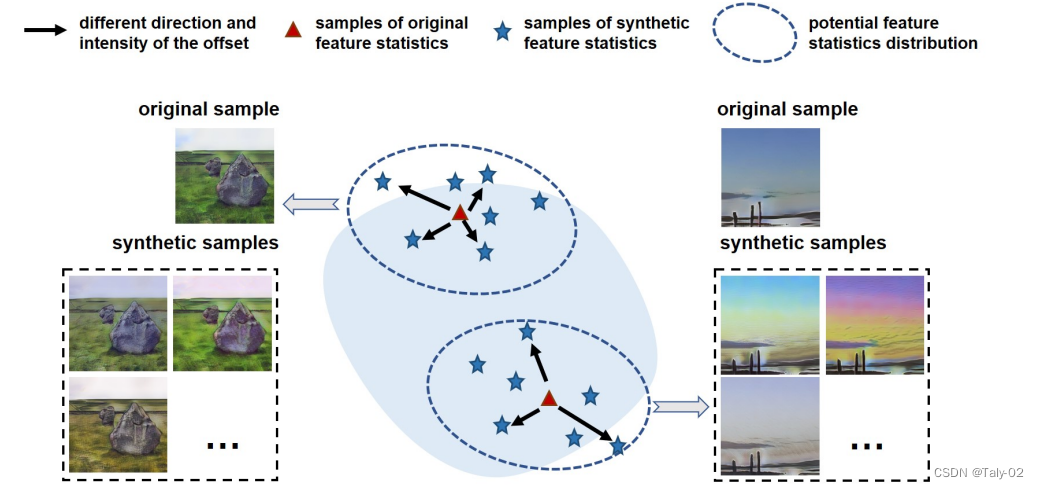

由于模型固有的易受這種差異的影響,學習到的表示的泛化能力受到了限制。盡管之前一些利用特征統計來解決領域泛化問題取得了成功,但它們通常采用成對樣本的線性操作(即交換和插值)來生成新的特征統計量,這限制了合成變化的多樣性。

具體而言,它們的變異方向由所選參考樣本決定,這種內部操作限制了它們的變化強度。因此,這些方法在處理現實世界中不同的、不確定的domain shift時是效果有限的。對于具有uncertainty的特征統計偏移方向的任意的test domain,如何正確建模domain的shift就是解決域泛化問題的重要任務。

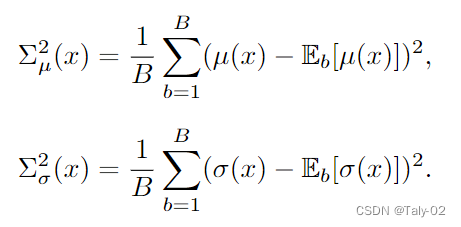

這篇文章提出的方法是在建模 Domain Shifts with Uncertainty (DSU)。通過對目標域的不確定性進行建模,來解決域泛化性能有限的問題。假設特征統計量都服從多元高斯分布,然后計算他們的方差,把這種方差定義為不確定性:

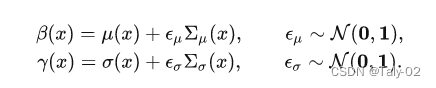

我們得到了每個銅套的不確定性后,在原有的分布上加一定的高斯噪聲,利用重參數來建模統計量:

通過利用給定的高斯分布,隨機采樣可以生成不同方向和強度組合的新特征統計信息。然后就是利用經典的

以上操作可以作為一個靈活的模塊集成在網絡的各個位置。注意,該模塊只在模型訓練期間工作,可以在測試時可以不適用。為了權衡這個模塊的強度,論文還設置了一個超參數p,表示使用這個模塊的概率,具體的算法細節描述在附錄中可以更好地參考。利用該方法,經過不確定特征統計量訓練的模型對潛在的統計量偏移具有更好的魯棒性,從而獲得更好的泛化能力。

4. 實驗

本文提出的方法其實是和內容無關的,所以為了說明方法的有效性和遷移性,作者在圖像分類、語義分割、實例檢索和 robustness to corruptions 等任務上都做了實驗。

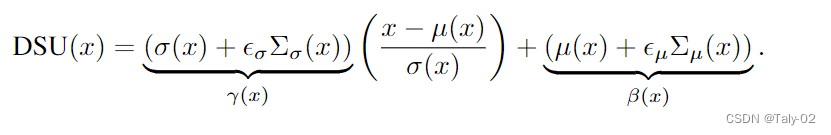

首先是Multi-domain classification的PACS數據集結果,包含了畫作、卡通、照片和素描四種風格的圖像。使用標準的leave-one-domain-out 的protocal,在三種風格上訓練,在剩下一種風格上測試。

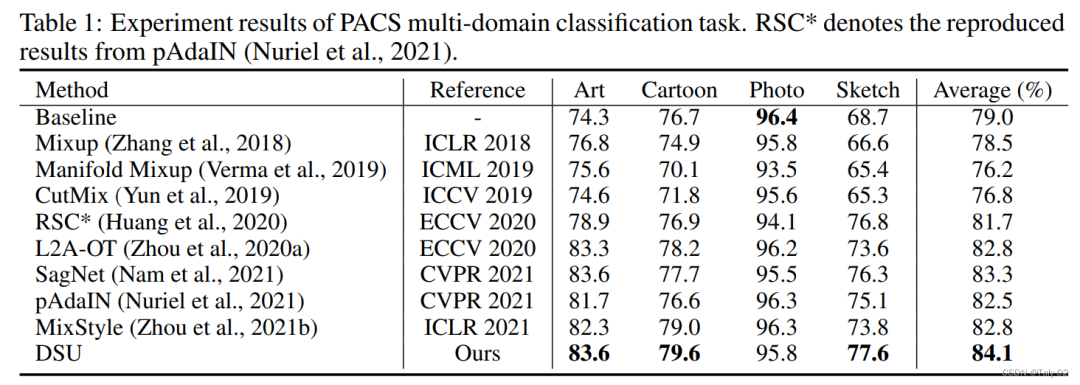

然后是在分割數據集上的表現:

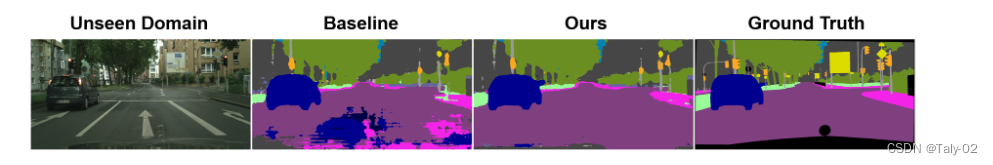

可視化效果也非常不錯:

更多的消融實驗可以參考原文。

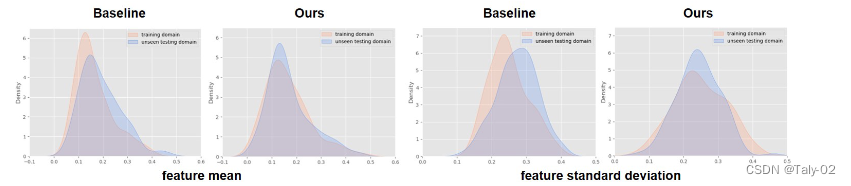

然后作者又利用PACS數據集,把art painting作為未知目標域,其他三種風格作為源域。作者backbone的中間特征,測量并可視化特征統計量的分布。可以看到DSU可以帶來更少的domain shift:

5. 結論

本文提出了一種提高網絡泛化能力的概率方法,通過在訓練過程中綜合特征統計量對領域偏移的不確定性進行建模。每個特征統計量假設遵循一個多變量高斯分布,以建模不同的domain shift。由于生成的特征統計量具有不同的分布的uncertainty,該模型對不同的domain shift具有更好的魯棒性。實驗結果證明了該方法在提高網絡泛化能力方面的有效性。

審核編輯:劉清

-

深度學習芯片

+關注

關注

0文章

3瀏覽量

2442

原文標題:ICLR 2022 基于不確定性的域外泛化

文章出處:【微信號:GiantPandaCV,微信公眾號:GiantPandaCV】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

相關推薦

一種網絡攻擊路徑重構方案

一種基于區域訪問概率的容遲網絡路由算法

容差模擬電路軟故障診斷的小波與量子神經網絡方法設計

求一種數字信道化IFM接收機的高效實現方案

一種基于機器學習的建筑物分割掩模自動正則化和多邊形化方法

一種基于綜合幾何特征和概率神經網絡的HGU軸軌識別方法

介紹一種解決overconfidence簡潔但有效的方法

一種基于概率模型的特征補償算法

一種新的自適應提升的概率矩陣分解算法

基于粒子群優化的條件概率神經網絡的訓練方法

一種基于聯合概率矩陣分解的群推薦方法

一種社交網絡用戶興趣點個性化推薦方法

一種提高網絡泛化能力的概率方法

一種提高網絡泛化能力的概率方法

評論