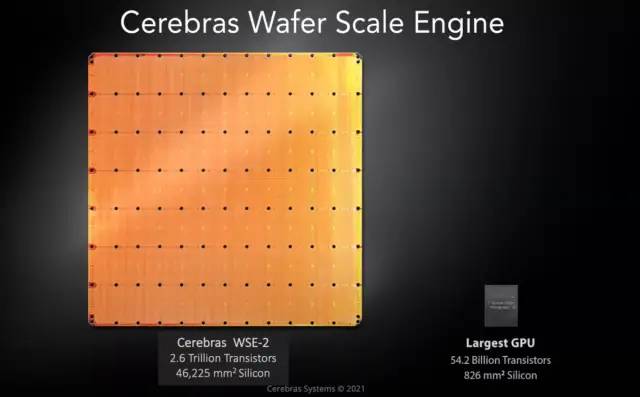

Cerebras以設計晶圓級別的芯片聞名,CS-2由世界最大芯片Cerebras WSE-2處理器提供動力(WSE-2將2.6萬億個晶體管和85萬個內核裝在一塊餐盤大小的晶圓上)。

在 SC22 上,Cerebras 展示了我們很少看到的東西,即其 CS-2 計算平臺的核心,即引擎塊。就此而言,我們不僅僅指的是我們之前多次看到的該公司的巨型 WSE-2 芯片。相反,是圍繞著一個巨大芯片的東西讓它運轉起來。

當我們討論 Cerebras 產品時,我們要么討論兩種觀點中的一種。第一個是該公司銷售的 CS-2 系統。

我們通常討論 Cerebras 產品的第二種方式是根據其巨大的芯片或其 Wafer-Scale Engine-2。

盡管如此,從一個巨大的人工智能芯片到一個系統并不是一件容易的事。這就是在 SC22 上展示的內容。

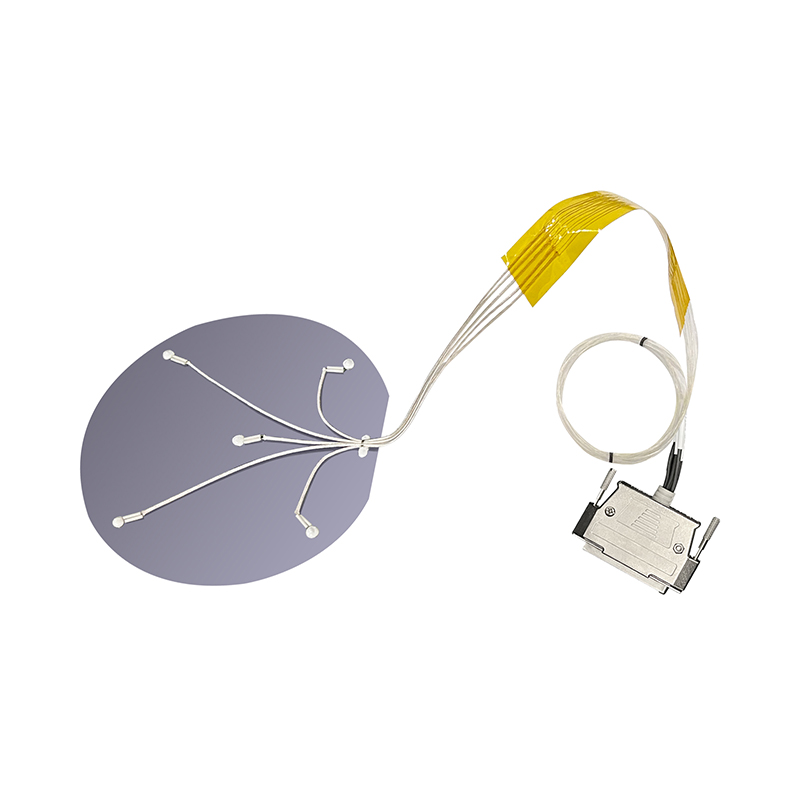

在展會上,該公司展示了看起來像一堆金屬的東西,上面有一些 PCB 伸出來。該公司稱其為發動機缸體。在我們之前與 Cerebras 的討論中,這是一項巨大的工程壯舉。弄清楚如何封裝、供電和冷卻這個巨大的芯片是一項關鍵的工程挑戰。讓代工廠制造特殊晶圓是一回事。讓晶圓開啟而不是過熱并做有用的工作是另一回事。

當我們談論服務器由于密度而不得不轉向液體冷卻時,我們談論的是 2kW/U 服務器或者可能是帶有 8x 800W 或 8x 1kW 部件的加速器托盤。對于 WSE/WSE-2,所有的電力和冷卻都需要輸送到一個大晶圓上,這意味著即使是不同材料的熱膨脹率等因素也很重要。另一個含義是該組件上的幾乎所有部件都采用液冷方式。

我們的一些讀者可能會在底板上的配件上看到文字。這是配件上的 Koolance 標簽,供有興趣的人使用。)

最上面一排木板非常密集。展位上的 Cerebras 代表告訴我,這些是有意義的電源,因為我們看到它們的連接器密度相對較低。

在 SC22 上展示 CS-2 發動機缸體的方式對某些人來說可能看起來很奇怪。這就是發動機缸體位于系統后部的方式(CS-2 是“后置發動機超級計算機”?):

這個用整塊晶圓做的芯片,性能超乎想象

Cerebras Systems 及其晶圓級硬件由于其完全非傳統的制造方法在業界引起了轟動。他們沒有像 AI 中的所有其他參與者一樣構建一個專用于機器學習的大芯片,而是瞄準了一個完全不同的擴展途徑。他們奉行將整個晶圓制成單個芯片的策略。該硬件已顯示出令人驚訝的多功能性,甚至在其他高性能計算應用程序中也取得了突破性進展。

這是由一個簡單的觀察結果驅動的,即摩爾定律已經顯著放緩。大幅增加晶體管數量的唯一途徑是增加每個芯片中的硅數量。Cerebras 正在開發他們的第二代產品 Cerebras WSE-2。該芯片的尺寸為 215mm x 215mm。

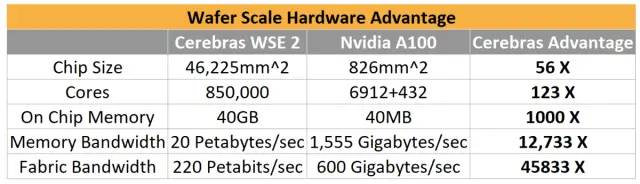

與可用的最大 GPU Nvidia A100 相比,Cerebras 取得了巨大的優勢,尤其是在將片上 40GB 的內存帶寬與 A100 的類似大小的 HBM 內存進行比較時。Cerebras 擁有令人難以置信的高結構帶寬,遠遠超過 GPU 到 GPU 的互連。

Cerebras 通過在水冷機箱中提供它來馴服他們的 20KW 野獸。作為參考,Nvidia A100 的功率范圍從 250W 到 500W,具體取決于配置。在創建這種冷卻解決方案時必須特別小心。由于該芯片的尺寸和功耗,諸如硅和其他組件的不同熱膨脹等問題成為主要問題。

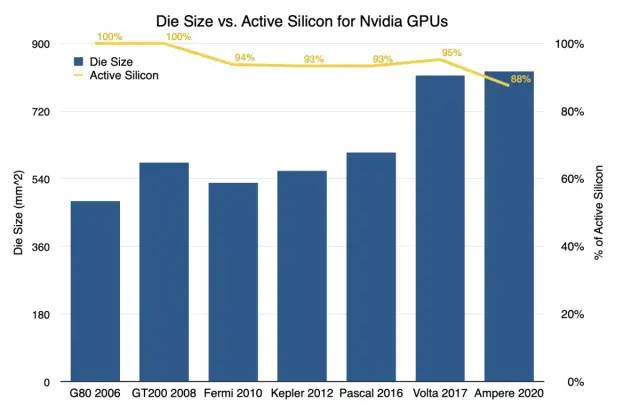

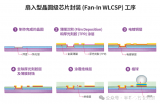

長期以來,半導體制造受限于裸片尺寸,一直受到掩模版的限制。掩模版限制為 33×26,這意味著這是 ASML 的光刻浸入式步進器可以在晶片上圖案化的最大尺寸。Nvidia 最大的芯片都在 800mm^2 的低范圍內,主要是因為超越這個范圍是不可能的。

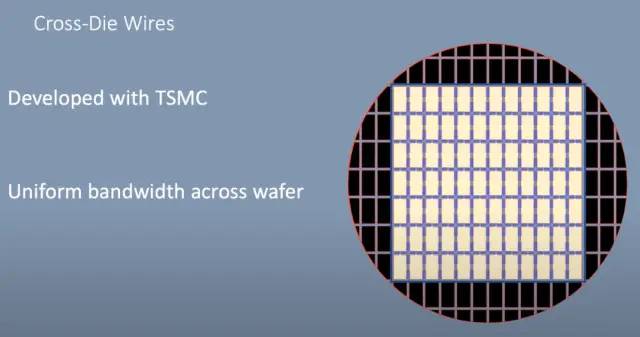

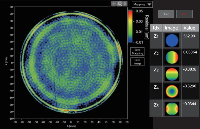

Cerebras WSE 實際上是在掩模版限制范圍內的晶圓上的許多芯片。他們沒有沿著芯片之間的劃線將芯片切割開,而是開發了一種跨芯片線的方法。這些導線與實際芯片分開圖案化,并允許芯片相互連接。實際上,芯片可以擴展到超出掩模版的限制。

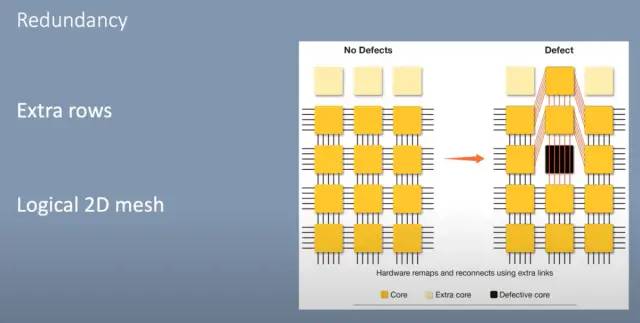

以經典方式構建芯片時,通常會存在缺陷。因此,必須丟棄來自每個晶片的多個芯片或必須禁用芯片的元件。Nvidia 通常將這種做法用于他們的 GPU。每一代都存在禁用更大比例內核的持續趨勢,而在當前一代 Ampere 中,大約有 12% 的內核被禁用。

Cerebras 通過在每個標線子芯片(reticle sub-chip)上添加 2 行額外的核心來解決這個問題。這些芯片內的互連是 2D 網格,其中每個核心在垂直和水平方向上連接。它們還為每個對角線核心提供額外的互連。這允許對有缺陷的核心進行布線,并且軟件仍然可以識別 2D 網格。

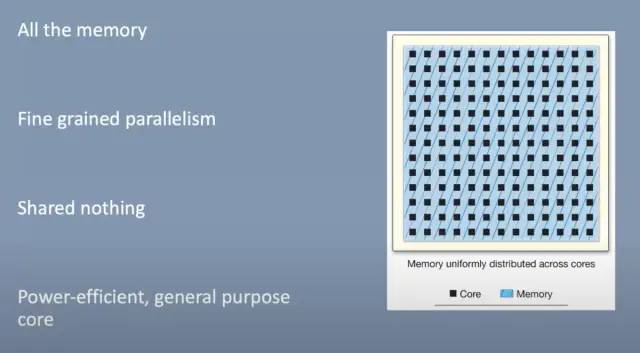

在這個 2D 網格中,Cerebras 設定了幾個目標。他們希望所有內存都保留在芯片上,而不必等待片外內存緩慢。唯一的外部連接是到主機系統。每個內核都有細粒度的并行性(fine grained parallelism ),彼此之間不共享任何內容。它們是具有 MIMD 能力的節能通用內核,并擁有自己的本地存儲器。

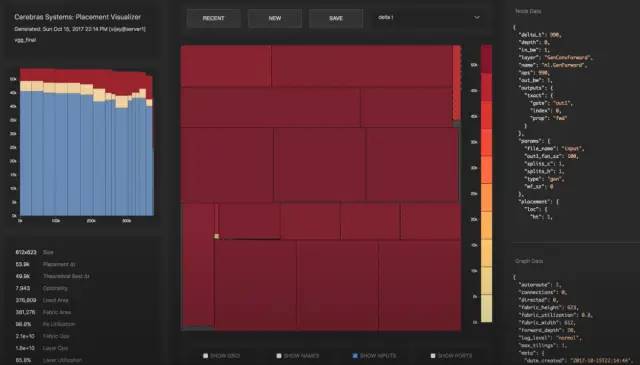

主要用例是機器學習訓練或推理。網絡層被映射到晶片大小的芯片區域。每個矩形塊對應一個層,有趣的是這被稱為“Colorado”。卷積、矩陣向量和矩陣乘法是在每一層的核心上計算的。2D 網格處理網絡每一層內和網絡層之間的核心間通信。

大多數通信通常在沿芯片的 X 或 Y 方向進行,但有些通信需要跨越芯片的大部分。網格可以處理這個而不會變得擁擠。這允許網絡中的層不必是連續的或彼此直接相鄰。Cerebras 軟件堆棧放置和路由這些層,同時保持核心和結構的高利用率。該軟件能夠在單個芯片上僅放置幾層網絡,或者在芯片上放置整個網絡的多個副本,以實現數據并行。

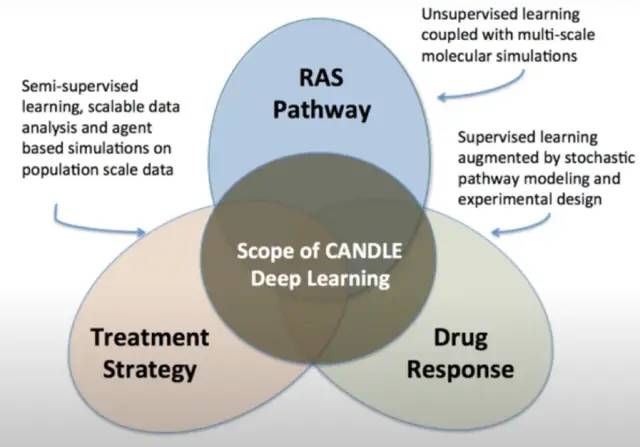

Cerebras 的客戶擁有實時生產的晶圓級引擎。這些用于許多不同的工作負載,但最有趣的一種是 CANDLE。WSE 用于精確模擬藥物組合的藥物反應及其對癌癥的影響。然后選擇最有希望的模擬結果進行實驗研究。

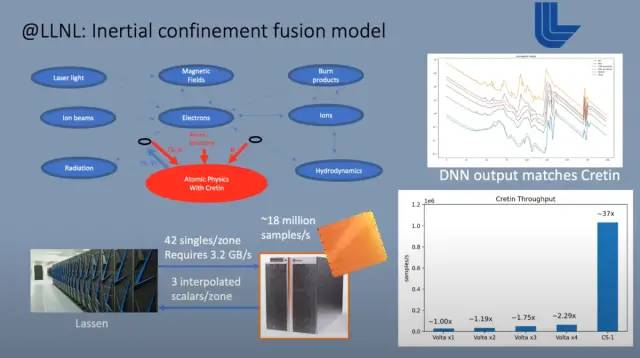

目前在這些芯片上運行的另一個用例是內部限制融合。它運行在一臺大型超級計算機上,該計算機還包含多個互連的 Cerebras WSE。這種大規模模擬的組成部分之一涉及原子和亞原子粒子之間的相互作用。該計算被一個在 Cerebras 硬件上運行的大型預訓練神經網絡所取代。這是一個僅使用推理的用例。它在模擬的每個時間步中都會被喚起。數據從較大的超級計算機流式傳輸到 Cerebras WSE,后者又為這些原子和亞原子交互提供輸出。

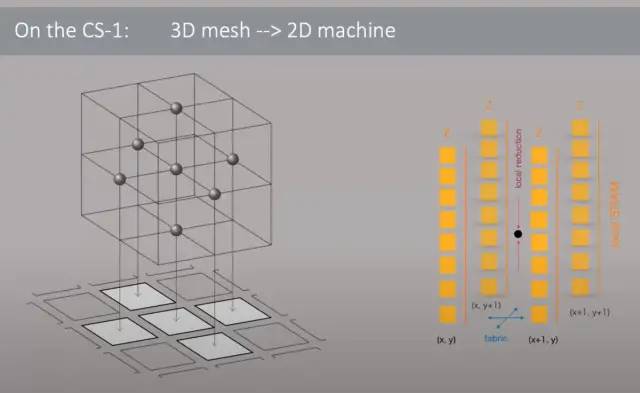

Cerebras 硬件也不僅僅用于機器學習。Joule 超級計算機在 3D 網格中運行的傳統硬件上運行計算流體動力學。他們以兩種不同的方式遇到了擴展問題。由于網絡帶寬的限制,他們無法通過核心數量來提高性能。此外,由于緩存未命中,內核通常會在表上留下很多性能,從而導致內存不足。該內存隨后遇到了巨大的帶寬瓶頸。

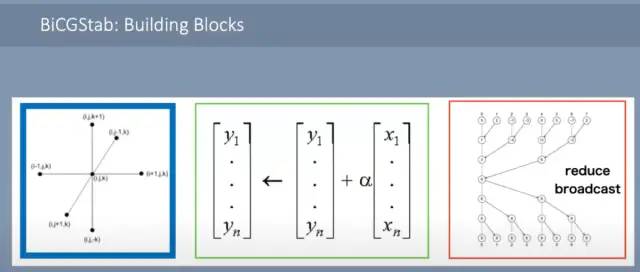

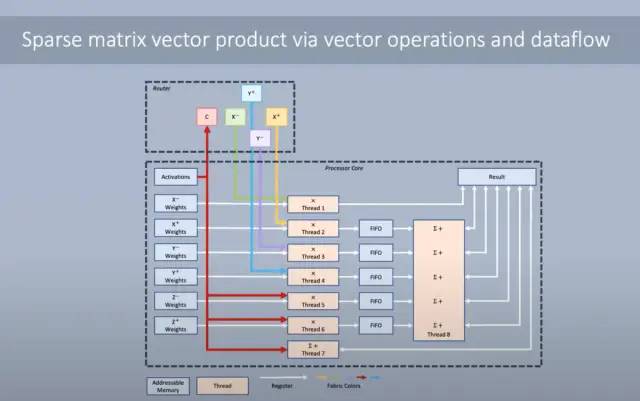

流體動力學模型的 3D 網格被映射到 WSE 芯片的 2D 網格。鄰居交換、向量 AXPY 和全局向量的點積,這需要局部點積和全局 all-reduce。由于大量的 SRAM 和每個單獨內核的相對較高的復雜性,所有這些操作都可以輕松處理。

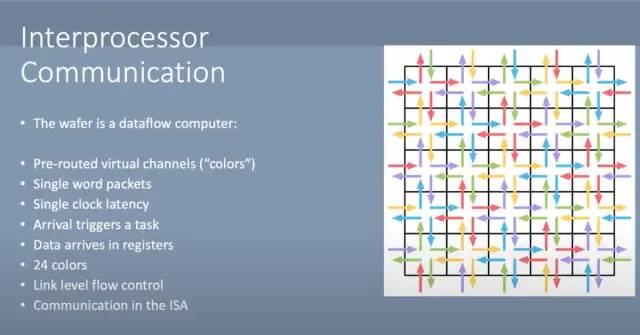

有大量的內核間通信,但片上內部網絡足夠強大,可以以低延遲處理它們。網絡通過沿著稱為“顏色”的虛擬通道而不是預先確定的地址發送消息來實現這一點。這種基于硬件的通信允許數據在整個芯片上每時鐘傳輸 1 跳。

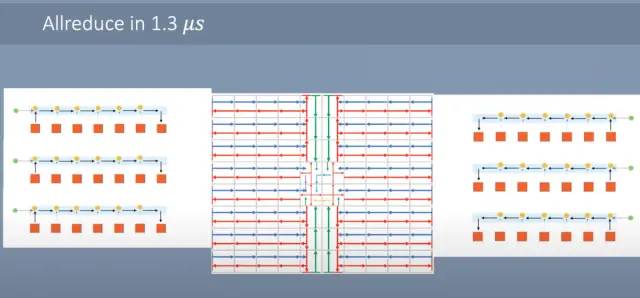

Allreduce 可以非常快地完成。每個內核將其標量發送到它旁邊的內核。當它到達那里時,標量被加在一起并向前發送。芯片的邊緣向東/西向中心發送數據。一旦它到達中心,就會發生同樣的過程,但北/南。結果被合并,然后在核心網格上廣播回來。只需1微秒,就可以完成這個allreduce。作為參考,超級計算機中的典型集群從一個處理器到另一個相鄰處理器的單個 MPI 通信需要大約這么長時間。

無論引入數據的延遲如何,都可以進行計算以實現全帶寬。路由器具有來自每個相鄰核心的 4 個傳入數據集。此外,內核可以將其輸出重新路由回,這樣就不需要將其存儲在 SRAM 中。內核可以同時運行多個線程。有一個主線程被賦予優先級,但是如果它在等待數據,其他線程就會前進。通過使用大量 SRAM 和多線程架構保持數據局部性,利用率保持極高。

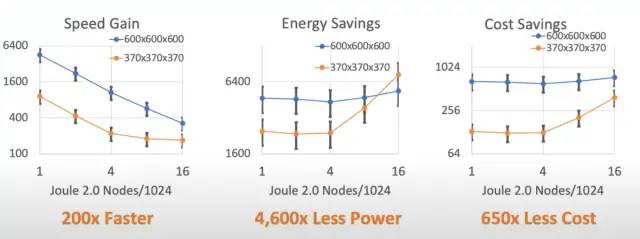

對硬件進行低級優化的結果使計算流體動力學速度提高了 200 倍。這與同樣高度優化的大型超級計算機集群相比。除了速度上的提升,成本,尤其是功耗,也有著巨大的優勢。這種優勢在某種程度上是顯而易見的,因為將超級計算機集群與單個(盡管是晶圓大小)芯片進行比較。

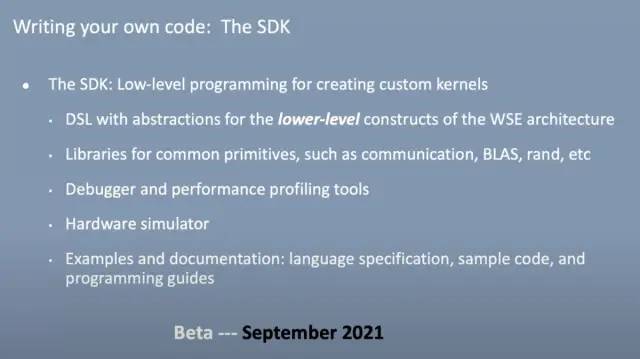

不幸的是,軟件還沒有完全符合要求。Beta SDK 將于今年晚些時候推出,用于編寫自定義內核操作。這種語言將完全特定于 WSE 的領域。他們將擁有數學函數和通信庫,有望在一定程度上減輕負擔。除此之外,還有一些功能和工具會有所幫助,但這將是高技能程序員的任務。這是唯一可以實現這種計算規模的硬件,因此對于那些需要這種性能水平的任務來說,它可能不是進入的巨大障礙。

Cerebras 將實時計算流體動力學作為利用 WSE 的下一個工作負載。有相當大的希望,這將打開一個全新的用例。

我們很高興基于 7nm 的 WSE2 全面推出。看看 SDK 是否可以允許開發人員生成其他工作負載,WSE 可以帶來數量級的性能提升,這將是令人興奮的。人工智能是 Cerebras 積極進取的領域,但晶圓級計算可能會改變這個行業,而不僅僅是機器學習。

-

芯片

+關注

關注

456文章

50936瀏覽量

424685 -

晶圓

+關注

關注

52文章

4927瀏覽量

128099 -

人工智能

+關注

關注

1792文章

47410瀏覽量

238925 -

計算平臺

+關注

關注

0文章

52瀏覽量

9674 -

AI芯片

+關注

關注

17文章

1890瀏覽量

35099

原文標題:Cerebras展示用整塊晶圓做的大芯片

文章出處:【微信號:TenOne_TSMC,微信公眾號:芯片半導體】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

相關推薦

為什么晶圓是圓的?芯片是方的?

晶圓/晶粒/芯片之間的區別和聯系

Cerebras提交IPO申請,估值達41億美元

碳化硅晶圓和硅晶圓的區別是什么

AI初出企業Cerebras已申請IPO!稱發布的AI芯片比GPU更適合大模型訓練

Cerebras Systems推出迄今最快AI芯片,搭載4萬億晶體管

芯片制造全流程:從晶圓加工到封裝測試的深度解析

Cerebras的實力 用整塊晶圓做的大芯片

Cerebras的實力 用整塊晶圓做的大芯片

評論