0 摘要

點(diǎn)云學(xué)習(xí)(Point cloud learning)因其在計(jì)算機(jī)視覺、自動(dòng)駕駛、機(jī)器人等領(lǐng)域的廣泛應(yīng)用而受到越來越多的關(guān)注。深度學(xué)習(xí)作為人工智能的主流技術(shù),已經(jīng)成功地應(yīng)用于解決各種2D視覺問題。然而,由于用深度神經(jīng)網(wǎng)絡(luò)處理點(diǎn)云所面臨的獨(dú)特挑戰(zhàn),點(diǎn)云的深度學(xué)習(xí)仍處于起步階段。 最近,關(guān)于點(diǎn)云的深入學(xué)習(xí)變得更加繁榮,有許多方法被提出來,解決這一領(lǐng)域的不同問題。為了促進(jìn)未來的研究,本文綜述了點(diǎn)云深度學(xué)習(xí)方法的最新進(jìn)展。包括三個(gè)主要任務(wù),3D分類、3D目標(biāo)檢測(cè)與跟蹤和3D點(diǎn)云分割。

1 Introduction

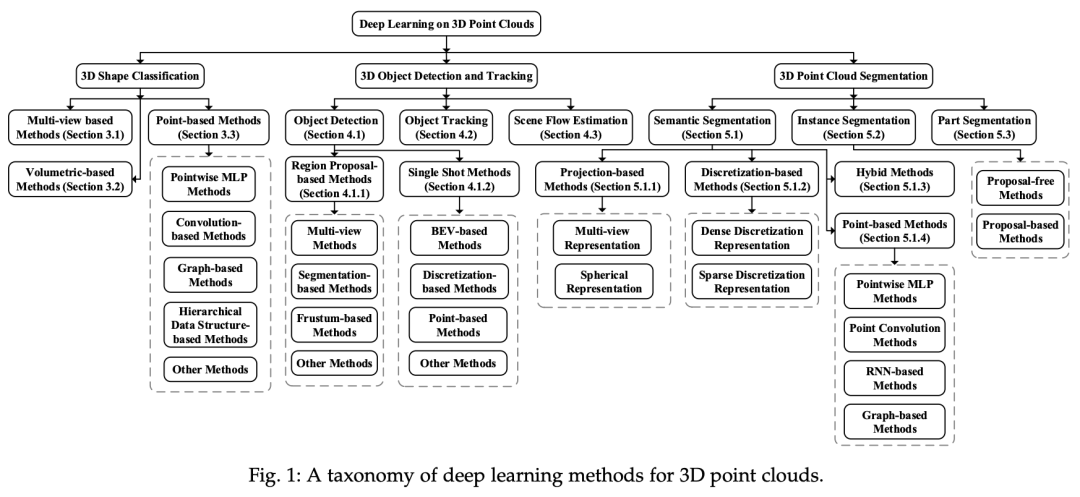

隨著3D采集技術(shù)的快速發(fā)展,3D傳感器變得越來越可用且價(jià)格實(shí)惠,包括各種類型的3D掃描儀、激光雷達(dá)和RGB-D相機(jī)(如Kinect、RealSense和Apple深度相機(jī))。這些傳感器獲取的三維數(shù)據(jù)可以提供豐富的幾何、形狀和比例信息。借助于二維圖像,三維數(shù)據(jù)為更好地了解機(jī)器周圍環(huán)境提供了機(jī)會(huì)。三維數(shù)據(jù)在不同領(lǐng)域有著廣泛的應(yīng)用,包括自動(dòng)駕駛、機(jī)器人技術(shù)、遙感和醫(yī)療。 三維數(shù)據(jù)通常可以用不同的格式表示,包括深度圖像、點(diǎn)云、網(wǎng)格和體積網(wǎng)格。點(diǎn)云表示作為一種常用的表示格式,在三維空間中保留了原始的幾何信息,而不需要進(jìn)行任何離散化。因此,它是許多場(chǎng)景理解相關(guān)應(yīng)用的首選表示,如自主駕駛和機(jī)器人技術(shù)。近年來,深度學(xué)習(xí)技術(shù)已成為計(jì)算機(jī)視覺、語音識(shí)別、自然語言處理等領(lǐng)域的研究熱點(diǎn)。然而,三維點(diǎn)云的深度學(xué)習(xí)仍然面臨著幾個(gè)重大的挑戰(zhàn),如數(shù)據(jù)集的小規(guī)模、高維性和三維點(diǎn)云的非結(jié)構(gòu)化性質(zhì)。在此基礎(chǔ)上,重點(diǎn)分析了用于三維點(diǎn)云處理的深度學(xué)習(xí)方法。點(diǎn)云的深度學(xué)習(xí)越來越受到人們的關(guān)注,特別是近五年來。還發(fā)布了一些公開數(shù)據(jù)集,例如ModelNet、ScanObjectNN、ShapeNet、PartNet、S3DIS、ScanNet、Semantic3D、ApololCar3D和KITTI Vision基準(zhǔn)套件。這些數(shù)據(jù)集進(jìn)一步推動(dòng)了三維點(diǎn)云深度學(xué)習(xí)的研究,越來越多的方法被提出來解決與點(diǎn)云處理相關(guān)的各種問題,包括三維形狀分類、三維目標(biāo)檢測(cè)與跟蹤、三維點(diǎn)云分割、三維點(diǎn)云配準(zhǔn)等,六自由度姿態(tài)估計(jì)和三維重建。關(guān)于三維數(shù)據(jù)的深度學(xué)習(xí)的調(diào)查也很少,我們的論文是第一次專門關(guān)注點(diǎn)云理解的深度學(xué)習(xí)方法。圖1顯示了現(xiàn)有的點(diǎn)云學(xué)習(xí)方法。

圖1:三維點(diǎn)云深度學(xué)習(xí)方法的分類

2 BACKGROUND

2.1 Datasets

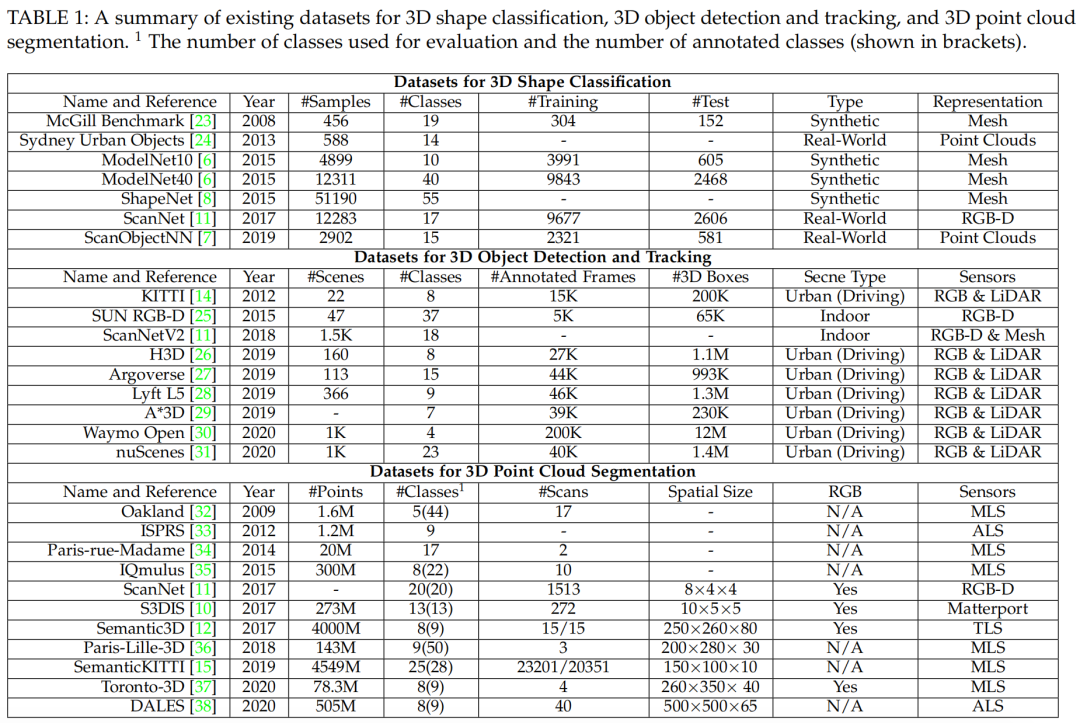

分類數(shù)據(jù)集主要分為:合成數(shù)據(jù)集[6], [8]和真實(shí)場(chǎng)景數(shù)據(jù)集[7], [11];

檢測(cè)與跟蹤數(shù)據(jù)集主要分為:室內(nèi)[11], [25]的和室外[14], [28], [30], [31];

分割數(shù)據(jù)集主要分為:移動(dòng)式激光掃描儀(MLS)[15],[34],[36],航空激光掃描儀(ALS)[33],[38],靜態(tài)地面激光掃描儀(TLS) [12], RGB-D 相機(jī)[11]和其他3D掃描儀[10]。

表1:數(shù)據(jù)集匯總

2.2 評(píng)估方式

分類任務(wù)的主要指標(biāo):Overall Accuracy (OA) 和 mean class accuracy (mAcc)

檢測(cè)任務(wù)的主要指標(biāo):Average Precision (AP)

單目標(biāo)跟蹤的主要指標(biāo):Precision 和 Succes

多目標(biāo)跟蹤的主要指標(biāo):Average Multi-Object Tracking Accuracy (AMOTA) 和 Average Multi-Object Tracking Precision (AMOTP)

分割任務(wù)的主要指標(biāo):OA, mean Intersection over Union (mIoU) 和 mean class Accuracy (mAcc),另外也有 mean Average Precision (mAP)

3 3D分類

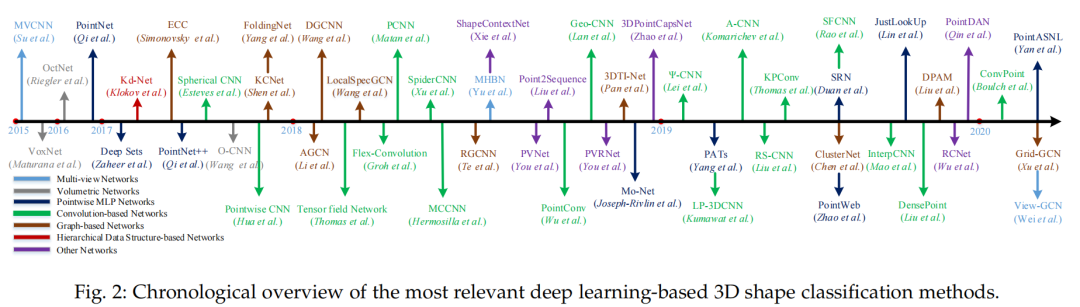

此任務(wù)的方法通常是先學(xué)習(xí)每個(gè)點(diǎn)的嵌入,然后使用聚合方法從整個(gè)點(diǎn)云中提取全局形狀嵌入。最后通過將全局嵌入嵌入到幾個(gè)完全連通的層中來實(shí)現(xiàn)分類。根據(jù)神經(jīng)網(wǎng)絡(luò)輸入的數(shù)據(jù)類型,現(xiàn)有的三維形狀分類方法可分為基于多視圖、基于體積和基于點(diǎn)的方法。如圖2。

圖2:3D分類方法 基于多視圖的方法將非結(jié)構(gòu)化點(diǎn)云投影到二維圖像中,而基于體積的方法將點(diǎn)云轉(zhuǎn)換為三維體積表示。然后,利用成熟的二維或三維卷積網(wǎng)絡(luò)實(shí)現(xiàn)形狀分類。相比之下,基于點(diǎn)的方法直接在原始點(diǎn)云上工作,而不需要任何體素化或投影。基于點(diǎn)的方法不會(huì)引入顯性信息丟失并日益流行。

3.1 Multi-view based Methods

首先將一個(gè)三維圖形投影到多個(gè)視圖中,然后提取各個(gè)視圖的特征,然后融合這些特征進(jìn)行精確的形狀分類。如何將多視圖特征聚合成一個(gè)有區(qū)別的全局表示是這些方法的一個(gè)關(guān)鍵挑戰(zhàn)。

MVCNN(Multi-view Convolutional Neural Networks for 3D Shape Recognition)(CVPR'15)是一個(gè)開創(chuàng)性的工作,它簡(jiǎn)單地將多視圖特性匯集到一個(gè)全局描述符中。但是,最大池只保留特定視圖中的最大元素,從而導(dǎo)致信息丟失。

MHBN[41]通過協(xié)調(diào)bilin監(jiān)聽池集成局部卷積特征,生成一個(gè)緊湊的全局描述符。Yang等人[42]首先利用關(guān)系網(wǎng)絡(luò)在一組視圖上利用相互關(guān)系(如區(qū)域-區(qū)域關(guān)系和視圖-視圖關(guān)系),然后聚合這些視圖以獲得有區(qū)別的3D對(duì)象表示。此外,還提出了其他幾種方法[43],[44],[45],[46],以提高識(shí)別精度。

與之前的方法不同,Wei等人[47]通過將多個(gè)視圖作為grpah節(jié)點(diǎn),在View-GCN中使用了有向圖。然后將由局部圖卷積、非局部消息傳遞和選擇性視圖采樣組成的核心層應(yīng)用于構(gòu)建的圖。最后,將所有級(jí)別的最大池節(jié)點(diǎn)特征串聯(lián)起來,形成全局形狀描述符。

3.2 Volumetric-based Methods

通常將點(diǎn)云體素化為三維網(wǎng)格,然后將三維卷積神經(jīng)網(wǎng)絡(luò)(CNN)應(yīng)用于體表示進(jìn)行形狀分類。

VoxNet(IROS'15)[48]: A 3D convolutional neural network for real-time object recognition(VoxNet)網(wǎng)絡(luò)、基于卷積深度的三維形狀網(wǎng),雖然已經(jīng)取得了令人鼓舞的性能,但由于計(jì)算量和內(nèi)存占用隨著分辨率的增加而呈立方體增長(zhǎng),因此這些方法無法很好地適應(yīng)密集的三維數(shù)據(jù)。

Wu等人[6]提出了一種基于卷積深度信念的3D shapenet,從各種3D形狀(由二進(jìn)制變量在體素網(wǎng)格上的概率分布表示)中學(xué)習(xí)點(diǎn)的分布。

盡管已經(jīng)取得了令人鼓舞的性能,但由于計(jì)算和內(nèi)存占用隨著分辨率的增加呈立方體增長(zhǎng),這些方法無法很好地?cái)U(kuò)展到密集的3D數(shù)據(jù)。

3.3 Point-based Methods

基于網(wǎng)絡(luò)結(jié)構(gòu)的不同,這類方法可以被分為以下幾類,包括:點(diǎn)光滑的MLP(PointWise);基于卷積的方法;基于圖的方法;基于數(shù)據(jù)索引的方法以及其它網(wǎng)絡(luò)。

3.3.1 Pointwise MLP Methods

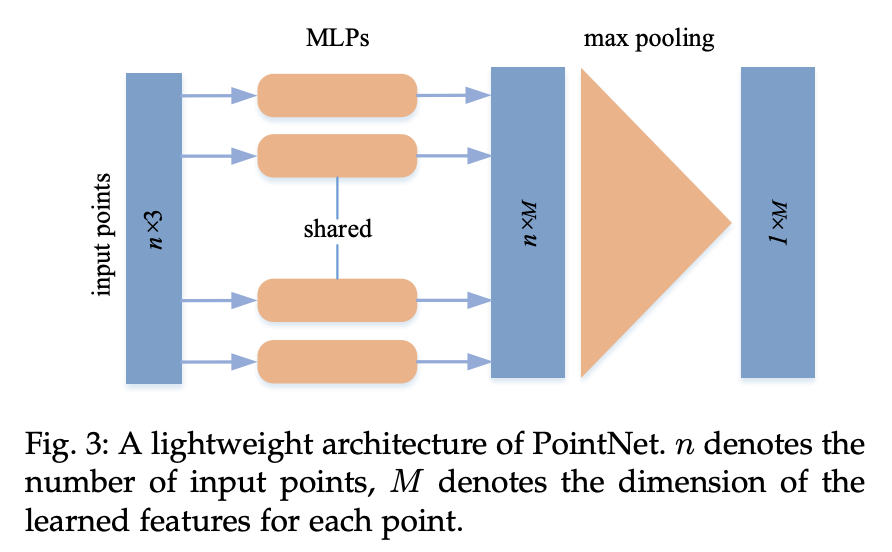

使用多個(gè)共享多層感知器(MLP)獨(dú)立地對(duì)每個(gè)點(diǎn)建模,然后使用對(duì)稱聚合函數(shù)聚合全局特征,如圖3所示。典型的二維圖像深度學(xué)習(xí)方法由于其固有的數(shù)據(jù)不規(guī)則性而不能直接應(yīng)用于三維點(diǎn)云。

圖3:PointNet的輕量級(jí)架構(gòu)。n表示輸入點(diǎn)的個(gè)數(shù),M表示每個(gè)點(diǎn)學(xué)習(xí)特征的維數(shù)

PointNetPointNet: Deep learning on point sets for 3D classification and segmentation(PointNet) 直接以點(diǎn)云作為輸入并實(shí)現(xiàn)對(duì)稱函數(shù)的置換不變性。PointNet使用幾個(gè)MLP層獨(dú)立地學(xué)習(xí)點(diǎn)態(tài)特征,并使用最大池化層提取全局特征。由于PointNet中每個(gè)點(diǎn)的特征都是獨(dú)立學(xué)習(xí)的,因此無法獲取點(diǎn)之間的局部結(jié)構(gòu)信息。

PointNet++因此,提出了一種層次網(wǎng)絡(luò)pointnet++來從每個(gè)點(diǎn)的鄰域中捕捉精細(xì)的幾何結(jié)構(gòu)。作為PointNet++層次結(jié)構(gòu)的核心,其集合抽象層由三層組成:采樣層、分組層和基于PointNet的學(xué)習(xí)層。通過疊加多個(gè)集合抽象層次,pointnet++從局部幾何結(jié)構(gòu)中學(xué)習(xí)特征,并逐層抽象局部特征。

由于PointNet[5]的簡(jiǎn)單性和較強(qiáng)的表示能力,許多網(wǎng)絡(luò)都是基于它開發(fā)的。Mo-Net[55]的架構(gòu)類似于PointNet[5],但它采用有限的力矩集作為其輸入。Ponit Attention Transformer(PATs)[56]用它自己的絕對(duì)位置和相對(duì)于相鄰點(diǎn)的相對(duì)位置表示每個(gè)點(diǎn),并通過MLP學(xué)習(xí)高維特征。然后,利用分組洗選注意(GSA)捕獲點(diǎn)之間的關(guān)系,并開發(fā)一個(gè)排列不變、可微、可訓(xùn)練的端到端岡貝爾子集采樣(GSS)層來學(xué)習(xí)層級(jí)的度量特征。PointWeb[57] uti在pointnet++[54]的基礎(chǔ)上,對(duì)局部鄰域的上下文進(jìn)行處理,使用自適應(yīng)特征調(diào)整(AFA)改進(jìn)點(diǎn)特征。Duan等人[58]提出了一種結(jié)構(gòu)關(guān)系網(wǎng)絡(luò)(SRN)利用MLP學(xué)習(xí)不同局部結(jié)構(gòu)之間的結(jié)構(gòu)關(guān)系特征。Lin等人[59]通過為PointNet學(xué)習(xí)的輸入空間和函數(shù)空間構(gòu)建查找表,加快了推理過程。ModelNet和ShapeNet數(shù)據(jù)集上的推理時(shí)間比中等機(jī)器上的PointNet加快了1.5 ms和32倍。SRINet[60]首先投射一個(gè)點(diǎn)云以獲得旋轉(zhuǎn)不變表示,然后利用基于pointnet的骨干網(wǎng)提取全局特征,并利用基于圖的聚合提取局部特征。在PointASNL中,Yan等[61]利用自適應(yīng)采樣(Adaptive Sampling, AS)模塊自適應(yīng)調(diào)整由最遠(yuǎn)點(diǎn)采樣(FPS)算法采樣的點(diǎn)的坐標(biāo)和特征,并提出了local-non-local (L-NL)模塊來捕獲這些采樣點(diǎn)的本地和遠(yuǎn)程依賴關(guān)系。

3.3.2 Convolution-based Methods

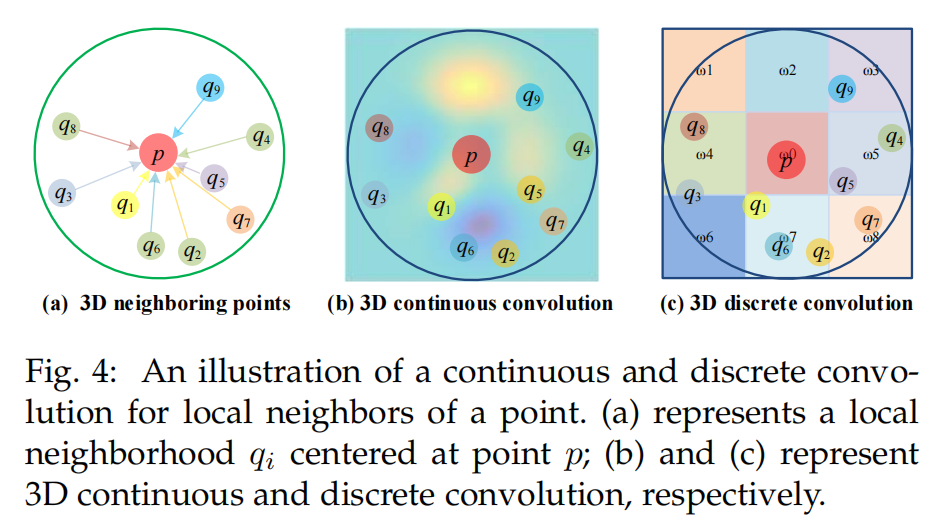

與二維網(wǎng)格結(jié)構(gòu)(如圖像)上定義的卷積核相比,由于點(diǎn)云的不規(guī)則性,三維點(diǎn)云的卷積核很難設(shè)計(jì)。根據(jù)卷積核的類型,目前的三維卷積方法可分為連續(xù)卷積法和離散卷積法,如圖4所示。

圖4:一個(gè)點(diǎn)的局部鄰域的連續(xù)和離散卷積的圖示。(a)表示以點(diǎn)p為中心的局部鄰域qi;(b)和(c)分別表示三維連續(xù)卷積和離散卷積

3D Continuous Convolution Methods

這類方法在連續(xù)的空間中定義卷積核,其中鄰居點(diǎn)的權(quán)重與它和中心點(diǎn)的空間分布有關(guān)。3D卷積可被認(rèn)為是在給定子集上的加權(quán)。MLP是一種簡(jiǎn)單的學(xué)習(xí)權(quán)重的方法。作為RS-CNN[62]的核心層,RS-Conv將某個(gè)點(diǎn)周圍的局部子集作為其輸入,使用MLP的方法來進(jìn)行卷積,學(xué)習(xí)低維關(guān)系到高維關(guān)系的映射。(“And the convolution is implemented using an MLP by learning the mapping from low-level relations to high-level relations between points in the local subset”)。在[63]中,卷積核的元素是在單位球中隨機(jī)選取的,接著使用基于MLP的連續(xù)函數(shù)來確定核元素的位置與點(diǎn)云的關(guān)系。在DensePoint[64]中,卷積被定義為單層感知機(jī)(Single-Layer Perceptron)。某層的特征是將其之前所有層的特征級(jí)聯(lián)起來,從而使得空間信息被充分利用。Thomas等人[65]使用一組可學(xué)習(xí)的核點(diǎn),提出了三維點(diǎn)云的剛性和變形核點(diǎn)卷積(KPConv)算子。ConvPoint[66]將卷積核分為空間部分和特征部分。空間部分的位置從一個(gè)單位球中隨機(jī)選擇,并通過一個(gè)簡(jiǎn)單的MLP學(xué)習(xí)權(quán)重函數(shù)。 有些方法使用已有的算法來進(jìn)行卷積。在PointConv[67]中,卷積被定義為對(duì)重要性采樣的連續(xù)3D卷積的蒙特卡洛估計(jì)。卷積核由加權(quán)函數(shù)(由MLP層學(xué)到)和密度函數(shù)(由核密度估計(jì)和MLP層學(xué)到)組成。為了提升內(nèi)存和計(jì)算效率,3D卷積被簡(jiǎn)化成兩部分:矩陣乘法和2D卷積,在相同的參數(shù)設(shè)置下,內(nèi)存消耗可減小64倍。在MCCNN[68]中,卷積被當(dāng)做是蒙特卡洛估計(jì)的過程(依賴樣本的密度函數(shù),用MLP實(shí)現(xiàn)),使用泊松圓盤采樣(Poisson disk sampling)來構(gòu)建點(diǎn)云等級(jí)。該卷積算子可用于在兩個(gè)或多個(gè)采樣方法之間進(jìn)行卷積,并可處理不同的采樣密度。在SpiderCNN[69]中,SpiderConv提出將卷積定義為階躍函數(shù)與定義在k個(gè)最近鄰居上的泰勒展開的乘積。階躍函數(shù)通過編碼局部測(cè)地線距離來捕獲粗幾何,而泰勒展開通過在立方體的頂點(diǎn)插入任意值來捕獲固有的局部ge度量變化。此外,還提出了一種基于徑向的三維點(diǎn)云卷積網(wǎng)絡(luò)PCNN[70]基函數(shù)。 針對(duì)三維卷積網(wǎng)絡(luò)所面臨的旋轉(zhuǎn)等變問題,提出了幾種解決方法。Esteves等人[71]提出了3D球形CNN來學(xué)習(xí)3D形狀的旋轉(zhuǎn)等變表示,該方法以多值球形函數(shù)為輸入。通過在球面調(diào)和域上用錨點(diǎn)參數(shù)化譜,得到了局部卷積濾波器。張量場(chǎng)網(wǎng)絡(luò)[72]被用來定義點(diǎn)卷積運(yùn)算為可學(xué)習(xí)的徑向函數(shù)和球面諧波的乘積,球面諧波與三維旋轉(zhuǎn)、平移和排列具有局部等變性。[73]中的卷積是基于球面互相關(guān)定義的,并使用廣義快速傅立葉變換(FFT)算法實(shí)現(xiàn)。SPHNet[74]基于PCNN,通過在體積函數(shù)卷積過程中加入球形諧波核來實(shí)現(xiàn)旋轉(zhuǎn)不變性。 為了加快計(jì)算速度,F(xiàn)lex-Convolution[75]將卷積核的權(quán)重定義為對(duì)k個(gè)最近鄰的標(biāo)準(zhǔn)標(biāo)量積,可以使用CUDA進(jìn)行加速。實(shí)驗(yàn)結(jié)果表明,該算法在參數(shù)較少、內(nèi)存消耗較低的小數(shù)據(jù)集上具有較好的性能。

3D Discrete Convolution Methods

在規(guī)則網(wǎng)格上定義卷積核,其中相鄰點(diǎn)的權(quán)重與相對(duì)于中心點(diǎn)的偏移量(offset)有關(guān)。 [76]將非歸一化的點(diǎn)云變換至歸一化的網(wǎng)格,接著在各個(gè)網(wǎng)格上定義卷積核。與2D卷積不同(在各個(gè)像素上分配權(quán)重),所提的3D卷積核在網(wǎng)格內(nèi)的所有點(diǎn)賦予相同的權(quán)重。對(duì)于給定點(diǎn),鄰域內(nèi)所有點(diǎn)(在相同網(wǎng)格上)的平均特征通過之前的層來計(jì)算得到。接著,所有網(wǎng)格的平均特征通過加權(quán)和產(chǎn)生當(dāng)前層的輸出。[77]定義了球狀的卷積核,通過將3D球體鄰域分成多個(gè)體素bins,并且將各個(gè)bin通過學(xué)到的加權(quán)矩陣聯(lián)系到一起。球狀卷積核的輸出由其鄰域點(diǎn)的加權(quán)均值 通過非線性激活層得到。在GeoConv[78]中,一個(gè)點(diǎn)與其相鄰點(diǎn)之間的幾何關(guān)系是基于六個(gè)基顯式建模的。沿基的每個(gè)方向的邊緣特征由方向相關(guān)的可學(xué)習(xí)矩陣獨(dú)立加權(quán)。這些方向相關(guān)的特征然后根據(jù)給定點(diǎn)及其相鄰點(diǎn)形成的角度進(jìn)行聚合。對(duì)于一個(gè)給定的點(diǎn),它在當(dāng)前層的特征被定義為給定點(diǎn)的特征及其上一層相鄰邊緣特征的和。PointCNN[79]通過χ-conv trans(通過MLP實(shí)現(xiàn))將輸入點(diǎn)轉(zhuǎn)換為潛在的和潛在的規(guī)范順序,然后對(duì)轉(zhuǎn)換后的特征應(yīng)用典型的卷積算子。Zhang等人[81]提出了一種RIConv算子來實(shí)現(xiàn)在方差中進(jìn)行旋轉(zhuǎn),該算子以低級(jí)旋轉(zhuǎn)不變的幾何特征為輸入,然后通過簡(jiǎn)單的bin方法將卷積轉(zhuǎn)化為1D。A-CNN[82]通過在查詢點(diǎn)的每個(gè)環(huán)上按內(nèi)核大小循環(huán)近鄰數(shù)組來定義環(huán)形卷積,并學(xué)習(xí)局部子集中近鄰點(diǎn)之間的關(guān)系。 為了降低3D CNNs的計(jì)算和存儲(chǔ)成本,Kumawat等人[83]提出了一種基于3D短期傅里葉變換(STFT)的校正局部相位體積(ReLPV)塊,用于在3D局部鄰域中提取相位,該塊顯著減少了參數(shù)的數(shù)量。在SFCNN[84]中,點(diǎn)云被投影到具有對(duì)齊球坐標(biāo)的正則型二十面體格上。然后通過卷積-maxpool -卷積結(jié)構(gòu)對(duì)球面格的頂點(diǎn)及其鄰近點(diǎn)拼接的特征進(jìn)行卷積。SFCNN抗旋轉(zhuǎn)和擾動(dòng)。

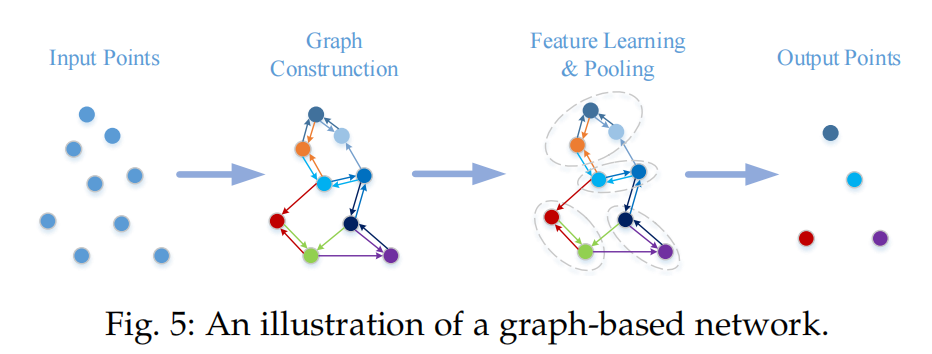

3.3.3 Graph-based Methods

將點(diǎn)云中的每個(gè)點(diǎn)看作圖的頂點(diǎn),并根據(jù)每個(gè)點(diǎn)的鄰域生成有向邊。然后在空間或光譜域中進(jìn)行特征學(xué)習(xí)。典型的基于圖的網(wǎng)絡(luò)如圖5所示。

圖5:基于圖網(wǎng)絡(luò)

空間域中的基于圖的方法

這類方法在空間域中定義卷積和池化操作。卷積通過在空間鄰域內(nèi)的MLP實(shí)現(xiàn),池化操作通過集成信息產(chǎn)生新的較粗的圖。各個(gè)頂點(diǎn)的特征由坐標(biāo)、激光強(qiáng)度、顏色來確定,各個(gè)邊的特征由兩個(gè)連接點(diǎn)的幾何屬性確定。 作為先驅(qū)工作,[85]將各個(gè)點(diǎn)視為圖的頂點(diǎn),利用有向邊將頂點(diǎn)與其鄰域內(nèi)的點(diǎn)相連,接著使用Edge-Condition Convolution(使用生成filter的網(wǎng)絡(luò)得到,MLP等)。最大池化用來集成鄰域信息,圖的粗化使用VoxelGrid[86]算法得到。首先通過卷積和池化的相互交錯(cuò),再跟著為全局平均池化和全連接層來產(chǎn)生分類score。 在DGCNN[87]中,在特征空間中構(gòu)造一個(gè)圖,并在網(wǎng)絡(luò)的每一層之后動(dòng)態(tài)更新。MLP作為EdgeConv的核心層,被用作每條邊緣的特征學(xué)習(xí)函數(shù),通道對(duì)稱聚合應(yīng)用于與每個(gè)點(diǎn)的鄰居相關(guān)聯(lián)的邊緣特征。此外,LDGCNN[88]去掉了轉(zhuǎn)換網(wǎng)絡(luò),并將DGCNN[87]中來自不同層的hier—度量特征連接起來,以提高其性能并減小模型尺寸。還提出了端到端無監(jiān)督深度AutoEncoder網(wǎng)絡(luò)(即FoldingNet[89]),該網(wǎng)絡(luò)使用向量化局部協(xié)方差矩陣和點(diǎn)坐標(biāo)的拼接作為輸入。受Inception[90]和DGCNN[87]的啟發(fā),Hassani和Haley[91]提出了一種無監(jiān)督的多節(jié)點(diǎn)任務(wù)自動(dòng)編碼器來學(xué)習(xí)點(diǎn)和形狀特征。編碼器是基于多尺度圖構(gòu)造的。該譯碼器使用三元非監(jiān)督任務(wù)(包括聚類、自監(jiān)督分類和偵察構(gòu)造)構(gòu)建,并與多任務(wù)損失聯(lián)合訓(xùn)練。Liu等[92]提出了一種基于圖卷積的動(dòng)態(tài)點(diǎn)聚集模塊(DPAM),將點(diǎn)聚集(采樣、分組和池化)的過程簡(jiǎn)化為一個(gè)簡(jiǎn)單的步驟,該過程通過聚集矩陣和點(diǎn)特征矩陣的乘法實(shí)現(xiàn)。在點(diǎn)網(wǎng)體系結(jié)構(gòu)的基礎(chǔ)上,通過堆疊多個(gè)DPAM來構(gòu)建一個(gè)層次化的學(xué)習(xí)體系結(jié)構(gòu)。與Pointnet++ [54]的層次結(jié)構(gòu)策略相比,DPAM動(dòng)態(tài)地利用了點(diǎn)之間的關(guān)系,并在語義空間中聚合了點(diǎn)。 為了利用局部幾何結(jié)構(gòu),KCNet[93]基于核相關(guān)學(xué)習(xí)特征。具體地說,描述局部結(jié)構(gòu)幾何類型的一組可學(xué)習(xí)點(diǎn)被定義為核。然后,計(jì)算了核與給定點(diǎn)鄰域之間的親和度。在G3D[94]中,將卷積定義為鄰接矩陣多項(xiàng)式的變體,將池化定義為將拉普拉斯矩陣和verutx矩陣乘以一個(gè)粗化矩陣。ClusterNet[95]利用一個(gè)嚴(yán)格的旋轉(zhuǎn)不變量模塊,從每個(gè)點(diǎn)的k個(gè)最近鄰居中提取旋轉(zhuǎn)不變量的特征,并基于無監(jiān)督凝聚層次聚類方法構(gòu)建點(diǎn)云的層次結(jié)構(gòu)[96]。每一個(gè)的特性子集群首先通過EdgeConv塊學(xué)習(xí),然后通過最大池聚集。 為了解決當(dāng)前數(shù)據(jù)結(jié)構(gòu)方法(如FPS和鄰居點(diǎn)查詢)耗時(shí)的問題,Xu等人[97]提出融合基于體積和基于點(diǎn)的方法的優(yōu)點(diǎn),以提高計(jì)算效率。在ModelNet分類任務(wù)上的實(shí)驗(yàn)表明,所提出的Grid-GCN網(wǎng)絡(luò)的計(jì)算效率比其他模型平均提高5倍。

譜域中的基于圖的方法

這類方法將卷積定義為譜的濾波,是通過在圖上的拉普拉斯矩陣的特征向量上的乘法來實(shí)現(xiàn)的[98][99]。與上述方法不同的是,RGCNN[100]將點(diǎn)云中的點(diǎn)與其余所有的點(diǎn)相連得到圖,接著在各層當(dāng)中更新圖的拉普拉斯矩陣。為了使相鄰頂點(diǎn)的特征更加相似,圖信號(hào)光滑的先驗(yàn)被加入到了損失函數(shù)中。為了解決數(shù)據(jù)的不同圖拓?fù)浣Y(jié)構(gòu)帶來的挑戰(zhàn),AGCN[101]中的SGC-LL層利用一個(gè)可學(xué)習(xí)距離度量來參數(shù)化圖上兩個(gè)頂點(diǎn)之間的相似性。利用高斯核和學(xué)習(xí)距離歸一化了從圖中得到的鄰接矩陣。HGNN[102]通過在超圖上應(yīng)用頻譜卷積來構(gòu)建超邊卷積層。 上述方法都是在全圖上操作的。為了利用詳細(xì)的局部結(jié)構(gòu)信息,Wang等人[103]提出了一種端到端光譜卷積網(wǎng)絡(luò)LocalSpecGCN,用于處理局部圖(由k個(gè)最近鄰構(gòu)建)。該方法不需要對(duì)圖的拉普拉斯矩陣和圖的層次結(jié)構(gòu)進(jìn)行離線計(jì)算。在PointGCN[104]中,基于點(diǎn)云的k個(gè)最近鄰居構(gòu)建了一個(gè)圖,并且使用高斯核對(duì)每條邊進(jìn)行加權(quán)。卷積函數(shù)定義為圖譜域中的切比雪夫多項(xiàng)式。全局池和多分辨率池用于捕獲點(diǎn)云的全局和局部特征。Pan等人[105]通過對(duì)譜域中k個(gè)最近鄰圖進(jìn)行卷積,提出了3DTI-Net。對(duì)幾何變換的不變性是通過學(xué)習(xí)相對(duì)歐氏距離和方向距離來實(shí)現(xiàn)的。

3.3.4 Hierarchical Data Structure-based Methods

基于索引數(shù)據(jù)的網(wǎng)絡(luò)是基于不同的數(shù)據(jù)索引結(jié)構(gòu)(八叉樹、KD樹)構(gòu)建的。在這類方法中,點(diǎn)的特征是從葉節(jié)點(diǎn)到根節(jié)點(diǎn)中分級(jí)學(xué)習(xí)的道德。 [77]提出了八叉樹導(dǎo)向的CNN,利用了球狀卷積核。網(wǎng)絡(luò)中的每一層對(duì)應(yīng)八叉樹的一層,球狀的卷積核在各層中均使用。當(dāng)前神經(jīng)元的值是:在之前層中相關(guān)的子節(jié)點(diǎn)的均值。而Kd-Net[106]由多重的K-d樹構(gòu)成,這些K-d樹在每次迭代時(shí)有著不同的分裂方向。根據(jù)從下到上的方法,非葉節(jié)點(diǎn)的表示是由其子節(jié)點(diǎn)通過MLP計(jì)算得到的。根節(jié)點(diǎn)的特征(描述整個(gè)點(diǎn)云)最終被送入至全連接層來得到分類輸出。值得注意的是,Kd-Net在各級(jí)之間共享參數(shù)。3DContextNet[107]使用標(biāo)準(zhǔn)的平衡K-d樹進(jìn)行特征提取和集成。 在每個(gè)級(jí)別上,點(diǎn)特征首先通過基于局部線索(模擬局部區(qū)域內(nèi)點(diǎn)之間的相互依賴關(guān)系)和全局上下文線索(模擬一個(gè)位置相對(duì)于所有其他位置的關(guān)系)的MLP學(xué)習(xí)。然后,利用MLP從子節(jié)點(diǎn)計(jì)算非葉節(jié)點(diǎn)的特征,并通過最大池化聚合。為了分類,重復(fù)上述過程,直到獲得根節(jié)點(diǎn)。SO-Net網(wǎng)絡(luò)的層次結(jié)構(gòu)是通過點(diǎn)到節(jié)點(diǎn)k次最近鄰搜索來構(gòu)建的[108]。具體而言,采用一種改進(jìn)的排列不變自組織圖(SOM)來模擬點(diǎn)云的空間分布。通過一系列完全連接的層,從歸一化點(diǎn)到節(jié)點(diǎn)坐標(biāo)中學(xué)習(xí)單個(gè)點(diǎn)的特征。SOM中每個(gè)節(jié)點(diǎn)的特征是使用通道最大池從與該節(jié)點(diǎn)相關(guān)的點(diǎn)特征中提取出來的。然后使用類似于PointNet[5]的方法從節(jié)點(diǎn)特征中學(xué)習(xí)最后一個(gè)特征。與Pointnet++[54]相比,SOM的層次結(jié)構(gòu)更加高效,充分挖掘了點(diǎn)云的空間分布。

3.3.5 Other Methods

此外,還提出了許多其他方案。RBFNet[113]通過聚集來自核位置和大小可學(xué)習(xí)的稀疏分布徑向基函數(shù)(RBF)核的特征,顯式地為點(diǎn)的空間分布建模。3DPointCapsNet[112]使用點(diǎn)式MLP和卷積層學(xué)習(xí)相關(guān)度為度量值為1 × 4的特征中的點(diǎn),并使用多個(gè)最大池化層提取全局潛在表示。在無監(jiān)督動(dòng)態(tài)路由的基礎(chǔ)上,學(xué)習(xí)了具有代表性的強(qiáng)潛在膠囊。Qin等人[116]提出了一種用于3D點(diǎn)云表示的端到端unsu授權(quán)域適應(yīng)網(wǎng)絡(luò)PointDAN。為了捕捉點(diǎn)云的語義屬性,提出了一種自監(jiān)督方法來重構(gòu)點(diǎn)云,該點(diǎn)云的各個(gè)部分已經(jīng)進(jìn)行了大規(guī)模重排[117]。Li等人[118]提出了一種自動(dòng)擴(kuò)充框架PointAugment,用于自動(dòng)優(yōu)化和擴(kuò)充用于網(wǎng)絡(luò)訓(xùn)練的點(diǎn)云樣本。具體地說,每個(gè)輸入樣本的形狀變換和點(diǎn)位移都是自動(dòng)學(xué)習(xí)的,網(wǎng)絡(luò)通過交替優(yōu)化和更新其可學(xué)習(xí)參數(shù)來訓(xùn)練 增強(qiáng)器和分類器。受形狀上下文[119]的啟發(fā),Xie等人[109]提出了一種ShapeContextNet體系結(jié)構(gòu),將親和性點(diǎn)選擇和緊湊特征集合結(jié)合到使用點(diǎn)產(chǎn)品自注意的軟對(duì)齊操作中[120]。為了處理3D點(diǎn)云中的噪聲和遮擋,Bobkov等人[121]將手工制作的基于點(diǎn)對(duì)函數(shù)的4D旋轉(zhuǎn)不變描述子輸入到4D卷積神經(jīng)網(wǎng)絡(luò)中。Prokudin等[122]首先從單位球隨機(jī)采樣一個(gè)分布均勻的基點(diǎn)集,然后將點(diǎn)云編碼為到基點(diǎn)集的最小距離。因此,點(diǎn)云被轉(zhuǎn)換為一個(gè)相對(duì)較小的固定長(zhǎng)度的向量。然后可以用現(xiàn)有的機(jī)器學(xué)習(xí)方法處理編碼后的表示。RCNet[115]利用標(biāo)準(zhǔn)RNN和2D CNN構(gòu)建了一個(gè)用于3D點(diǎn)云處理的排列不變網(wǎng)絡(luò)。首先將點(diǎn)云劃分為平行光束,并沿特定維度排序,然后將每個(gè)光束送入共享RNN。學(xué)習(xí)到的特征進(jìn)一步被輸入到一個(gè)有效的2D CNN中,用于層次結(jié)構(gòu)的特征聚合。為了提高RCNet-E的描述能力,提出了將多個(gè)RCNets沿不同劃分和排序方向進(jìn)行集成的方法。Point2Sequences[114]是另一個(gè)基于RNN的模型,它捕獲點(diǎn)云局部區(qū)域中不同區(qū)域之間的相關(guān)性。它將從多個(gè)尺度的局部區(qū)域?qū)W習(xí)到的特征視為序列,并將這些來自所有局部區(qū)域的序列輸入到基于RNN的編碼器-解碼器結(jié)構(gòu)中,以聚合局部區(qū)域的特征。 一些方法也可以從3D點(diǎn)云和2D圖像中學(xué)習(xí)。在PVNet[110]中,從多視點(diǎn)圖像中提取的高層次全局特征通過嵌入網(wǎng)絡(luò)投射到點(diǎn)云的子空間中,并通過軟注意掩碼與點(diǎn)云特征融合。最后,利用殘差連接對(duì)融合特征和多視圖特征進(jìn)行形狀識(shí)別。隨后,進(jìn)一步提出PVRNet[111],通過關(guān)系評(píng)分模塊來開發(fā)3D點(diǎn)云與其多個(gè)視圖之間的關(guān)系。在關(guān)系評(píng)分的基礎(chǔ)上,對(duì)二維全局視圖特征進(jìn)行增強(qiáng),實(shí)現(xiàn)點(diǎn)級(jí)的單視圖融合和點(diǎn)級(jí)的多視圖融合。

3.4 Summary

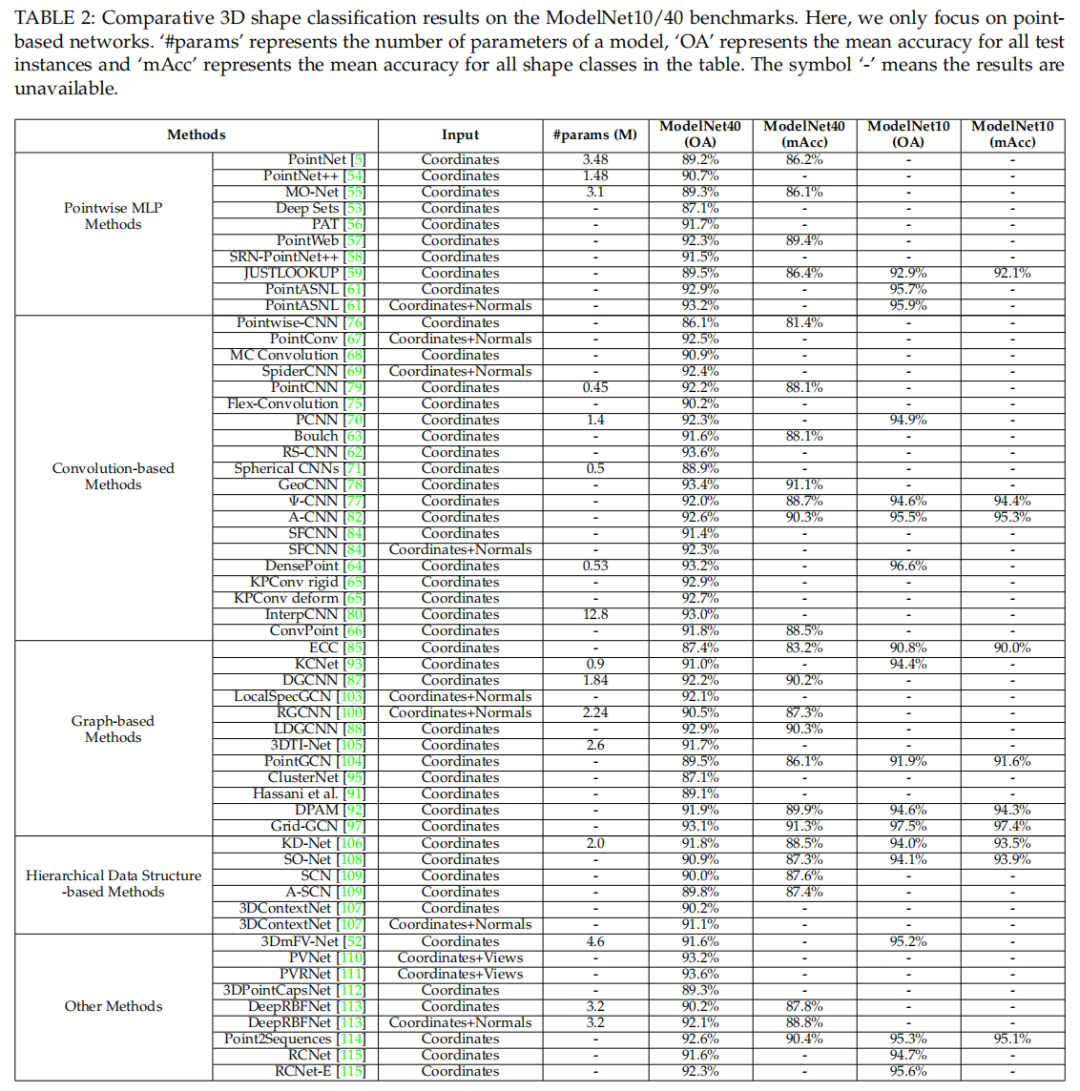

ModelNet10/40[6]數(shù)據(jù)集是3D形狀分類中最常用的數(shù)據(jù)集。表2顯示了不同基于點(diǎn)的網(wǎng)絡(luò)所獲得的結(jié)果。可以得出以下幾點(diǎn)觀察:

點(diǎn)態(tài)MLP網(wǎng)絡(luò)通常作為其他類型網(wǎng)絡(luò)學(xué)習(xí)點(diǎn)態(tài)特征的基本構(gòu)建塊。

作為一種標(biāo)準(zhǔn)的深度學(xué)習(xí)架構(gòu),基于卷積的網(wǎng)絡(luò)可以在不規(guī)則的3D點(diǎn)云上獲得卓越的性能。對(duì)于不規(guī)則數(shù)據(jù)的離散卷積網(wǎng)絡(luò)和連續(xù)卷積網(wǎng)絡(luò)都應(yīng)該給予更多的關(guān)注。

基于圖的網(wǎng)絡(luò)由于其固有的強(qiáng)大的數(shù)據(jù)處理能力,近年來受到越來越多的關(guān)注。然而,將譜域的基于圖的網(wǎng)絡(luò)擴(kuò)展到各種圖結(jié)構(gòu)仍然是一個(gè)挑戰(zhàn)。

表2

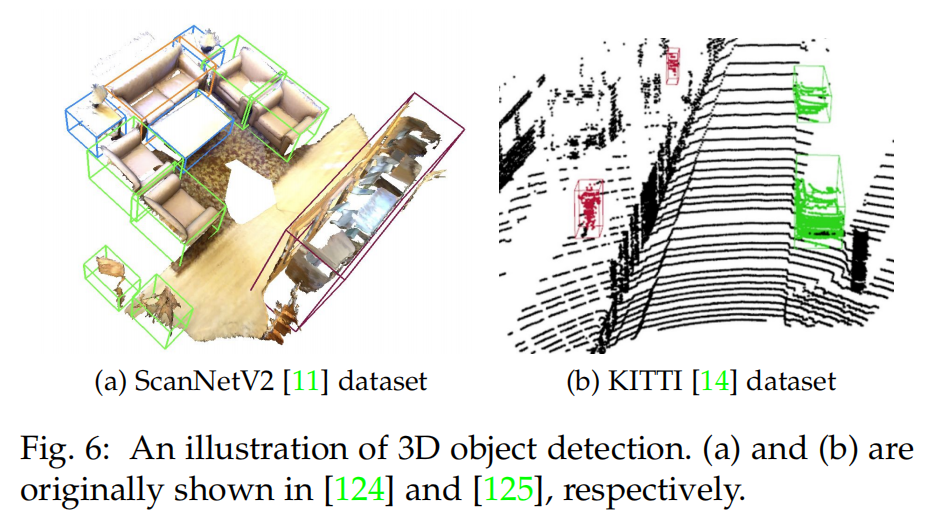

4 3D目標(biāo)檢測(cè)與跟蹤

圖6:3D目標(biāo)檢測(cè)

4.1 3D Object Detection

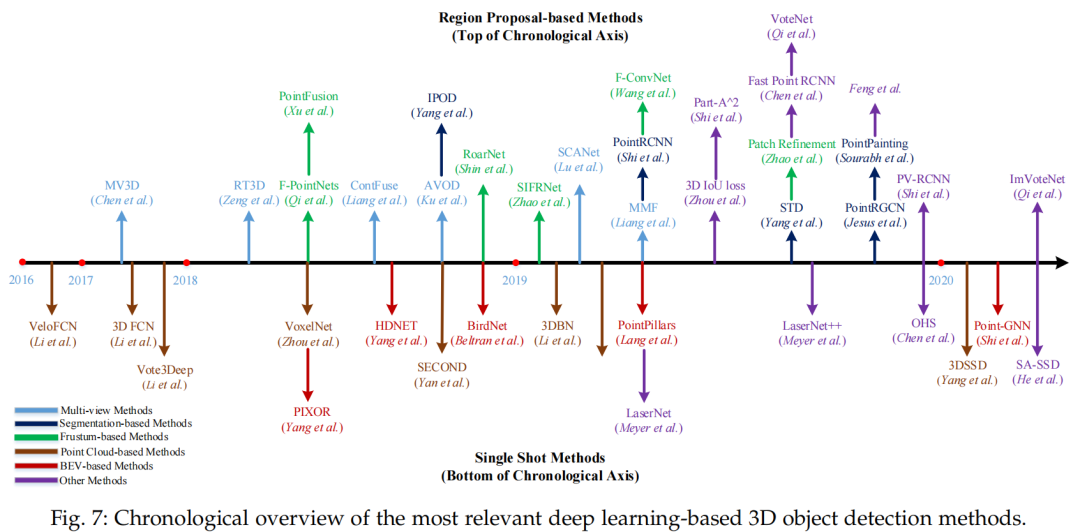

與普通2D中的目標(biāo)檢測(cè)方法類似,3D中的目標(biāo)檢測(cè)方法也可分為兩類:基于候選區(qū)域的方法和直接映射的方法。

圖7:3D目標(biāo)檢測(cè)

4.1.1 Region Proposal-based Methods

這些方法首先產(chǎn)生一些可能包含物體的區(qū)域(Proposals),接著對(duì)各個(gè)區(qū)域提取特征,來決定各個(gè)候選區(qū)域的物體類別。 根據(jù)不同的產(chǎn)生候選區(qū)域的方法,這些方法可進(jìn)一步分為三類:基于多視角的方法;基于分割的方法以及基于錐體的方法。

Multi-view based Methods

這類方法從不同的視角圖像(雷達(dá)前景圖,鳥瞰圖,圖像等)中融合各個(gè)候選框的特征,來產(chǎn)生3D旋轉(zhuǎn)盒。在[4]中,Chen等人從鳥瞰圖中產(chǎn)生一組準(zhǔn)確的3D候選框,并且將其投影到其它視角中(雷達(dá)前景圖,RGB圖像),接著將各個(gè)區(qū)域的特征組合到一起,來預(yù)測(cè)有方向的3D bounding boxes。盡管這種方法在0.25IOU, 300個(gè)候選框設(shè)置時(shí)達(dá)到了99.1%的recall,但是速度非常慢。后續(xù)的基于多視角的3D物體檢測(cè)方法主要從以下兩個(gè)方面來提升。 (1)提出了很多方法來有效的融合不同模態(tài)之間的信息。為了針對(duì)小物體產(chǎn)生有較高recall的候選框,[126]提出了多模態(tài)的基于融合融合的區(qū)域生成網(wǎng)絡(luò)。首先從鳥瞰圖和普通圖像視角提取相同大小的特征,然后在各個(gè)元素位置使用了平均池化來融合特征。[127]利用了連續(xù)的卷積來進(jìn)行圖像與3D雷達(dá)前景圖的特征融合。具體而言,他們對(duì)BEV(鳥瞰視角)空間中的每個(gè)點(diǎn)提取最近的對(duì)應(yīng)點(diǎn)的圖像特征,接著通過將圖像特征投影至BEV空間的方法,使用雙線性插值得到稠密的BEV的特征圖。實(shí)驗(yàn)結(jié)果證明稠密的BEV特征圖比起離散的圖像特征圖和LiDAR(雷達(dá)激光)特征圖更加適合3D物體檢測(cè)。[128]提出了多任務(wù),多感知器的3D物體檢測(cè)網(wǎng)絡(luò)來進(jìn)行端到端的訓(xùn)練。具體而言,利用多種任務(wù)(2D物體檢測(cè),背景估計(jì),深度補(bǔ)償),幫助網(wǎng)絡(luò)學(xué)習(xí)到更好的特征表示。學(xué)習(xí)到的跨模態(tài)的表示,可進(jìn)一步用來產(chǎn)生更準(zhǔn)確的物體檢測(cè)結(jié)果。實(shí)驗(yàn)證明這類方法在2D,3D,BEV識(shí)別任務(wù)上有著非常好的提升,在TOR4D基準(zhǔn)[129, 130]上超越了之前的SOTA。 (2)其它的一些方法致力于提取更魯棒的表示。[39]通過引入空間Channel注意力機(jī)制模塊(Spatial Channel Attention Module),探索了多尺度的環(huán)境信息,其捕獲了全局的以及多尺度的場(chǎng)景環(huán)境,加強(qiáng)了有用的特征。同樣的,通過將不同尺度的低層次特征融合的方法,他們提出了Extension Spatial Unsample模塊來得到有著更豐富空間信息的高層次特征,接著來產(chǎn)生更可靠的3D物體候選框。盡管達(dá)到了更好的檢測(cè)效果,但上述所提的多視角方法都需要較長(zhǎng)的運(yùn)行時(shí)間,因?yàn)樗麄冊(cè)诟鱾€(gè)候選框都進(jìn)行了特征的池化。因此,[131]使用了提前的ROI池化卷積(pre-ROI pooling convolution)來提高[4]的效率。具體而言,他們將大部分的卷及操作移動(dòng)到ROI pooling模塊之前。因此,對(duì)于所有的物體候選框,ROI卷積只使用一次。實(shí)驗(yàn)結(jié)果顯示這類方法可達(dá)到11.1fps, 速度達(dá)到了MV3D[4]的5倍。

Segmentation-based Methods

這類方法首先利用現(xiàn)有的語義分割技術(shù)來移除多數(shù)的背景點(diǎn),接著在前景點(diǎn)上,產(chǎn)生大量的高質(zhì)量的候選框來節(jié)約計(jì)算。與多視角的方法[4],[126],[131]相比,這類方法達(dá)到了更好的物體recall,并且更適合一些復(fù)雜的場(chǎng)景。 [132]中,Yang et al使用了2D的分割網(wǎng)絡(luò)來預(yù)測(cè)前景的像素并將其投影至點(diǎn)云中,以此來剔除掉多數(shù)的背景點(diǎn)。接著在這些前景點(diǎn)中生成候選框,并且設(shè)計(jì)了一種新的標(biāo)準(zhǔn)稱之為PointsIoU來減少候選框的冗余性和模棱兩可之處。跟著[132]的腳步,[133]提出了PointRCNN的框架。具體而言,他們直接對(duì)3D點(diǎn)云進(jìn)行分割,得到前景點(diǎn),并且將語義特征和局部空間特征融合從而得到高質(zhì)量的3D boxes。[143]跟著[122]中的RPN,提出了一種利用圖卷積網(wǎng)絡(luò)來進(jìn)行3D物體檢測(cè)。具體而言,利用圖卷積,在此處引入了兩個(gè)模塊來修復(fù)物體的候選框。第一個(gè)模塊R-GCN利用一個(gè)候選框中的所有點(diǎn),得到每個(gè)候選框的特征集成。第二個(gè)模塊C-GCN將所有候選框中的每一幀信息融合起來,利用環(huán)境來回歸準(zhǔn)確的物體boxes。[135]將點(diǎn)云投影至基于圖像的分割網(wǎng)絡(luò)的輸出,將其附加至語義的預(yù)測(cè)值。通過將涂色的點(diǎn)送入至一些檢測(cè)器中[133,136,137],得到了顯著的性能提升。[138]將每個(gè)點(diǎn)與spherical anchor相關(guān)聯(lián),每個(gè)點(diǎn)的語義值用來移除多余的anchors。這樣的方法得到了更好的recall以及有著更小的計(jì)算消耗。與此同時(shí),文中提出了PointsPool層,對(duì)候選框中的內(nèi)部點(diǎn)學(xué)習(xí)相容的特征,并且引入了并行的IOU來提高位置的準(zhǔn)確度的檢測(cè)性能。

Frustum-based Methods

這類方法首先利用現(xiàn)有的2D物體檢測(cè)子,產(chǎn)生2D的候選矩形框,接著對(duì)每個(gè)2D的候選框提取3D的錐體候選框,如圖8(c)所示。盡管這類方法可以有效地給出3D物體的坐標(biāo),但step-by-step的pipeline使得性能受限(受限于2D圖像的檢測(cè)子)。F-PointNets[139]為此類方向的先驅(qū)工作。它在每個(gè)2D區(qū)域上產(chǎn)生錐形的候選框,并且應(yīng)用PointNet[5]或PointNet++[54]來學(xué)習(xí)各個(gè)3D錐體的點(diǎn)云特征,從而進(jìn)行3D box的估計(jì)。在隨后的工作中,[140]提出了Point-SENet模塊,來預(yù)測(cè)一系列的縮放因子,從而被用來突出有用特征和抑制無用特征。同時(shí)他們也將PointSIFT[141]模塊集成至網(wǎng)絡(luò)中,來獲取點(diǎn)云的方向信息,其可以得到對(duì)形狀尺度的強(qiáng)魯棒性。該方法在[14], [25]的數(shù)據(jù)集上,與F-PointNets [139]相比得到了顯著的提高。 方法[142]利用了2D圖像區(qū)域和對(duì)應(yīng)的錐體點(diǎn)來回歸3D boxes。為了融合圖像特征和點(diǎn)云的全局特征,他們提出了全局的融合網(wǎng)絡(luò)來直接回歸box的角坐標(biāo)。他們也提出了稠密的網(wǎng)絡(luò)網(wǎng)絡(luò)來預(yù)測(cè)各個(gè)點(diǎn)對(duì)于各個(gè)角的補(bǔ)償(offsets)。[143]第一次從2D圖像中估計(jì)2D的bounding boxes和3D物體姿態(tài),從而提取物體候選框。這類3D候選框被送入至box 回歸網(wǎng)絡(luò)來預(yù)測(cè)準(zhǔn)確的3D物體boxes。[144]對(duì)于各個(gè)2D區(qū)域,在錐體軸上產(chǎn)生一系列的錐體,并使用PointNet來對(duì)各個(gè)錐體提取特征。錐體層次的特征用來產(chǎn)生2D特征圖,再被送入至FCN來估計(jì)3D box。該方法在基于2D圖像的方法中達(dá)到了state-of-the-art的性能,并且在KITTI積分榜上排在很靠前的位置。[145]首先在鳥瞰圖上得到初步的檢測(cè)結(jié)果,接著基于鳥瞰圖的預(yù)測(cè)結(jié)果,提取小部分點(diǎn)的子集,再應(yīng)用局部的微調(diào)網(wǎng)絡(luò)來學(xué)習(xí)局部特征,預(yù)測(cè)高精度的3D bounding boxes。

Other Methods

受軸向IoU在圖像目標(biāo)檢測(cè)中的成功激勵(lì),Zhou等人[146]將兩個(gè)3D旋轉(zhuǎn)邊界盒的IoU集成到幾個(gè)先進(jìn)的檢測(cè)器[133]、[137]、[158],以實(shí)現(xiàn)一致的性能改進(jìn)。Chen等人[147]提出了一種兩階段網(wǎng)絡(luò)架構(gòu),可以同時(shí)使用點(diǎn)云和體素表示。首先,對(duì)點(diǎn)云進(jìn)行體素化,并將點(diǎn)云輸入到三維骨干網(wǎng)中生成初始檢測(cè)結(jié)果。其次,進(jìn)一步利用初始預(yù)測(cè)的內(nèi)點(diǎn)特征進(jìn)行箱體細(xì)化。雖然這種設(shè)計(jì)在概念上很簡(jiǎn)單,但在保持16.7 fps的速度的同時(shí),它達(dá)到了與[133]相當(dāng)?shù)男阅堋hi等人[148]提出了PointVoxel-RCNN(PV-RCNN),利用3D卷積網(wǎng)絡(luò)和基于PointNet的集合抽象來學(xué)習(xí)點(diǎn)云特征。具體來說,輸入點(diǎn)云首先體素化,然后輸入到三維稀疏卷積網(wǎng)絡(luò)中生成高質(zhì)量的提案。然后,通過體素集抽象模塊將學(xué)習(xí)到的體素相關(guān)特征編碼為一個(gè)小的關(guān)鍵點(diǎn)集。此外,他們還提出了一個(gè)關(guān)鍵點(diǎn)到網(wǎng)格的ROI抽象模塊,以捕獲豐富的上下文信息用于框細(xì)化。實(shí)驗(yàn)結(jié)果表明,該方法的性能明顯優(yōu)于以往的方法,在KITTI三維檢測(cè)基準(zhǔn)的Car類測(cè)試中排名第一。 受到Hough投票的二維物體探測(cè)器的啟發(fā),Qi等人[124]提出了VoteNet,直接從點(diǎn)云中對(duì)物體的虛擬中心點(diǎn)進(jìn)行投票,并通過聚集投票特征生成一組高質(zhì)量的3D物體提議。VoteNet的性能明顯優(yōu)于之前僅使用幾何信息的方法,并在兩個(gè)大型室內(nèi)工作臺(tái)(即ScanNet[11]和SUN RGB-D[25])上實(shí)現(xiàn)了最先進(jìn)的性能。然而,對(duì)于部分遮擋的物體,虛擬中心點(diǎn)的預(yù)測(cè)是不穩(wěn)定的。此外,F(xiàn)eng等人[149]增加了方向向量的輔助分支,以提高虛擬中心點(diǎn)和3D候選盒的預(yù)測(cè)精度。此外,建立了提案之間的三維對(duì)象-對(duì)象關(guān)系圖,強(qiáng)調(diào)了用于精確目標(biāo)檢測(cè)的有用特征。Qi等人[150]提出了一種ImVoteNet檢測(cè)器,將2D對(duì)象檢測(cè)線索(如幾何和語義/紋理線索)融合到3D投票管道中。Shi等人[151]觀察到3D對(duì)象的ground truth box提供了對(duì)象內(nèi)部部分的精確位置,受到這一啟發(fā),提出了Part-A2 Net,該網(wǎng)絡(luò)由部分感知階段和部分聚合階段組成。部分感知階段采用類似UNet的[165]net工作,并帶有稀疏卷積和稀疏反褶積,以學(xué)習(xí)點(diǎn)級(jí)特征,用于預(yù)測(cè)和粗略生成對(duì)象內(nèi)部部件位置。零件聚合階段采用感知roi的池化來聚合預(yù)測(cè)的零件位置,進(jìn)行箱體細(xì)化。

4.1.2 Single Shot Methods

這類方法使用單階段的網(wǎng)絡(luò),直接預(yù)測(cè)類別概率和回歸物體的3D bounding boxes。這類方法不需要產(chǎn)生區(qū)域候選框和后處理。結(jié)果是,這類方法有著很快的速度,很適合實(shí)時(shí)的應(yīng)用。根據(jù)輸入數(shù)據(jù)的形式,single shot方法可分為兩類:基于鳥瞰圖的方法和基于點(diǎn)云的方法。

BEV-based Methods

基于鳥瞰圖的方法將BEV表示作為輸入。[129]將場(chǎng)景的點(diǎn)云離散化,使用FCN來預(yù)測(cè)位置和物體的航向角。該方法超越了大多數(shù)的single shot方法(VeloFCN [154], 3D-FCN [155] 和 Vote3Deep [156])并且達(dá)到了28.6fps。之后,[152]利用HP map提供的幾何和語義先驗(yàn)信息,提高了[129]的魯棒性和檢測(cè)性能。具體來說,他們從HD地圖上獲取地面點(diǎn)的坐標(biāo),然后用相對(duì)于地面的距離進(jìn)行BEV表示,以彌補(bǔ)由于道路坡度引起的平移方差。此外,他們沿著通道維度將二元道路掩模與BEV表示連接起來,以聚焦于移動(dòng)的物體。因?yàn)椴皇撬械胤蕉加懈咔宓貓D,所以它們也提出了一種在線地圖預(yù)測(cè)模塊,用于從單個(gè)LiDAR點(diǎn)云中估計(jì)地圖先驗(yàn)。該地圖感知方法在TOR4D[129]、[130]和KITTI[14]數(shù)據(jù)集上的表現(xiàn)明顯優(yōu)于基線。但對(duì)不同密度點(diǎn)云的概化性能較差。為了解決這個(gè)問題,Beltr′an等人[153]提出了一種考慮差異的歸一化圖在不同的激光雷達(dá)傳感器之間。歸一化映射是一個(gè)與BEV映射具有相同分辨率的2D網(wǎng)格,它對(duì)每個(gè)單元格中包含的最大點(diǎn)數(shù)進(jìn)行編碼。結(jié)果表明,該歸一化映射顯著提高了基于BEV的檢測(cè)器的泛化能力。

Discretization-based Methods

離散化方法將點(diǎn)云轉(zhuǎn)換為規(guī)則的離散表示,然后應(yīng)用CNN預(yù)測(cè)對(duì)象的類別和3D盒子。 Li等人[154]提出了第一種使用FCN進(jìn)行3D目標(biāo)檢測(cè)的方法。他們將點(diǎn)云轉(zhuǎn)換為2D點(diǎn)圖,并使用2D FCN預(yù)測(cè)對(duì)象的邊界框和置信度。隨后,他們[155]將點(diǎn)云離散為具有長(zhǎng)、寬、高、通道等維度的4D張量,并將基于二維fcns的檢測(cè)技術(shù)擴(kuò)展到三維領(lǐng)域進(jìn)行三維物體檢測(cè)。與[154]相比,基于3D fcn的方法[155]在精度上獲得了20%以上的增益,但由于3D卷積和數(shù)據(jù)稀疏性,不可避免地要消耗更多的計(jì)算資源。為了解決體素的稀疏性問題,Engelcke等人[156]利用以特征為中心的投票方案為每個(gè)非空體素生成一組選票,并通過累積選票獲得卷積結(jié)果。它的計(jì)算復(fù)雜度與被占用的體素?cái)?shù)量成正比。Li等人[157]通過堆疊多個(gè)稀疏的3D CNN構(gòu)建了一個(gè)3D骨干網(wǎng)。該方法充分利用體素的稀疏性來節(jié)省內(nèi)存和加快計(jì)算速度。該三維骨干網(wǎng)在不引入大量計(jì)算量的前提下,提取了豐富的三維特征進(jìn)行目標(biāo)檢測(cè)。 Zhou等人[136]提出了一種基于體素的端到端可訓(xùn)練框架VoxelNet。他們將點(diǎn)云劃分為等間距的體素,并將每個(gè)體素中的特征編碼為4D張量。然后連接區(qū)域建議網(wǎng)絡(luò)產(chǎn)生檢測(cè)結(jié)果。雖然該方法性能較強(qiáng),但由于體素的稀疏性和三維卷積的影響,其速度非常慢。之后Yan等[158]利用稀疏卷積網(wǎng)絡(luò)[166]提高了[136]的推理效率。他們還提出了正弦誤差角度損失來解決0和π方向之間的歧義。Sindagi等人[159]在早期階段通過融合圖像和點(diǎn)云特征擴(kuò)展了VoxelNet。具體來說,他們將[136]生成的非空體素投影到圖像中,并使用預(yù)先訓(xùn)練的網(wǎng)絡(luò)提取每個(gè)投影體素的圖像特征。然后將這些圖像特征與體素特征連接起來,生成精確的3D盒子。與[136]、[158]相比,該方法可以有效利用多模態(tài)信息,減少假陽性和陰性。Lang等人[137]提出了一種名為point柱子的3D對(duì)象檢測(cè)器。該方法利用PointNet[5]學(xué)習(xí)以垂直列(柱子)組織的點(diǎn)云的特征,并將學(xué)習(xí)到的特征編碼為偽圖像。然后應(yīng)用二維物體檢測(cè)管道預(yù)測(cè)三維邊界盒。在AP方面,point柱子優(yōu)于大多數(shù)融合方法(包括MV3D [4], RoarNet[143]和AVOD[126])。此外,point柱子可以在3D和BEV KITTI[14]基準(zhǔn)上以62幀/秒的速度運(yùn)行,使其非常適合實(shí)際應(yīng)用。 He等人[160]觀察到,在現(xiàn)有的單鏡頭檢測(cè)器逐步縮小的特征圖中,點(diǎn)云的部分空間信息不可避免地會(huì)丟失,受此啟發(fā),He等人提出了一種SA-SSD檢測(cè)器,利用細(xì)粒度結(jié)構(gòu)信息提高定位精度。具體來說,他們首先將點(diǎn)云轉(zhuǎn)換為張量,并將其輸入骨干網(wǎng),以提取多級(jí)特征。此外,利用具有點(diǎn)級(jí)監(jiān)督的輔助網(wǎng)絡(luò)引導(dǎo)特征學(xué)習(xí)點(diǎn)云的結(jié)構(gòu)。實(shí)驗(yàn)結(jié)果表明,SA-SSD在KITTI BEV檢測(cè)基準(zhǔn)的Car類中排名第2。

Point-based Methods

這些方法直接以原始點(diǎn)云作為輸入。3DSSD[161]是這方面的開創(chuàng)性工作。它引入了距離- fps (D-FPS)和特征- fps (F-FPS)的融合采樣策略,以去除耗時(shí)的特征傳播(FP)層和[133]中的細(xì)化模塊。然后,利用候選生成(Candidate Generation, CG)層充分挖掘代表點(diǎn),進(jìn)一步將代表點(diǎn)輸入帶有3D中心度標(biāo)簽的無錨回歸頭,預(yù)測(cè)3D對(duì)象盒。實(shí)驗(yàn)結(jié)果表明,3DSSD在保持25fps速度的情況下,性能優(yōu)于兩階段點(diǎn)法PointRCNN [133]。

Other Methods

Meyer等人[162]提出了一種名為L(zhǎng)aserNet的高效3D物體檢測(cè)器。該方法預(yù)測(cè)每個(gè)點(diǎn)在邊界盒上的概率分布,然后結(jié)合這些點(diǎn)分布生成最終的3D對(duì)象盒。進(jìn)一步,采用點(diǎn)云的密集距離視圖(RV)表示作為輸入,提出了一種快速的均值-位移算法來降低點(diǎn)云預(yù)測(cè)產(chǎn)生的噪聲。LaserNet在0 ~ 50米范圍內(nèi)實(shí)現(xiàn)了最先進(jìn)的性能,運(yùn)行時(shí)間明顯低于現(xiàn)有方法。Meyer等人[163]隨后擴(kuò)展了LaserNet[162],利用RGB圖像(例如50至70米)提供的密集紋理。具體來說,他們通過將3D點(diǎn)云投影到2D圖像上,將LiDAR點(diǎn)與圖像像素相關(guān)聯(lián),并利用這種關(guān)聯(lián)將RGB信息融合到3D點(diǎn)中。他們還認(rèn)為3D語義分割是學(xué)習(xí)更好表示的輔助任務(wù)。該方法在保持LaserNet高效率的同時(shí),在長(zhǎng)距離(例如50 ~ 70米)的對(duì)象檢測(cè)和語義分割方面都取得了顯著的改進(jìn)。Chen等人[164]觀察到孤立物體上的點(diǎn)可以提供關(guān)于物體位置和方向的豐富信息,受此啟發(fā),提出了一種新的熱點(diǎn)表示和第一個(gè)基于熱點(diǎn)的無錨檢測(cè)器。具體來說,原始點(diǎn)云首先體素化,然后輸入骨干網(wǎng)絡(luò)生成3D特征圖。利用這些特征圖對(duì)熱點(diǎn)進(jìn)行分類,同時(shí)預(yù)測(cè)三維邊界盒。注意,熱點(diǎn)分配在骨干網(wǎng)的最后一個(gè)卷積層。實(shí)驗(yàn)結(jié)果表明,該方法對(duì)稀疏點(diǎn)云具有較好的魯棒性。Shi et el。[125]提出了一種用于檢測(cè)激光雷達(dá)點(diǎn)云三維目標(biāo)的圖神經(jīng)網(wǎng)絡(luò)Point-GNN。他們首先將輸入點(diǎn)云編碼為具有固定半徑的近鄰圖,然后將該圖輸入Point-GNN,以預(yù)測(cè)對(duì)象的類別和盒子。

4.2 3D Object Tracking

給定物體在第一幀中的位置,目標(biāo)跟蹤的任務(wù)是估計(jì)其在后續(xù)幀中的狀態(tài)[167],[168]。由于三維目標(biāo)跟蹤可以利用點(diǎn)云中豐富的幾何信息,因此有望克服基于圖像的跟蹤所面臨的遮擋、光照和尺度變化等缺點(diǎn)。 受Siamese網(wǎng)絡(luò)[169]在基于圖像的目標(biāo)跟蹤方面的成功啟發(fā),Giancola等人[170]提出了一種形狀補(bǔ)全正則化的3D Siamese網(wǎng)絡(luò)。具體來說,他們首先使用卡爾曼濾波器生成候選對(duì)象,然后使用形狀正則化將模型和候選對(duì)象編碼成一個(gè)緊湊的表示。然后使用余弦相似度在下一幀中搜索被跟蹤對(duì)象的位置。該方法可以作為對(duì)象跟蹤的替代方法,并且顯著優(yōu)于大多數(shù)2D對(duì)象跟蹤方法,包括STAPLECA[171]和SiamFC[169]。為了高效地搜索目標(biāo)對(duì)象,Zarzar等人[172]利用2D Siamese網(wǎng)絡(luò)生成大量的粗對(duì)象可對(duì)BEV表示進(jìn)行解析。然后,他們利用3D Siamese網(wǎng)絡(luò)中的余弦相似度,對(duì)罐頭證書進(jìn)行了細(xì)化。該方法在精確度(即18%)和成功率(即12%)方面顯著優(yōu)于[170]。Simon等人[173]提出了一種用于語義點(diǎn)云的3D對(duì)象檢測(cè)和跟蹤體系結(jié)構(gòu)。他們首先通過融合二維視覺語義信息生成體素化語義點(diǎn)云,然后利用時(shí)間信息提高多目標(biāo)跟蹤的準(zhǔn)確性和魯棒性。此外,他們還引入了一種功能強(qiáng)大且簡(jiǎn)化的評(píng)估指標(biāo)(即量表-旋轉(zhuǎn)-翻譯評(píng)分(SRFs)),以加速訓(xùn)練和推斷。Complexer-YOLO取得了很好的跟蹤性能,并且仍然可以實(shí)時(shí)運(yùn)行。此外,Qi等人[174]提出了點(diǎn)到箱(Point-to-Box, P2B)網(wǎng)絡(luò)。他們將模板和搜索區(qū)域放入主干中以獲取種子。搜索區(qū)域利用目標(biāo)特異性特征增強(qiáng)種子,然后通過Hough投票回歸潛在目標(biāo)中心。實(shí)驗(yàn)結(jié)果表明,當(dāng)以40幀/秒的速度運(yùn)行時(shí),P2B的性能比[170]高出10%以上。

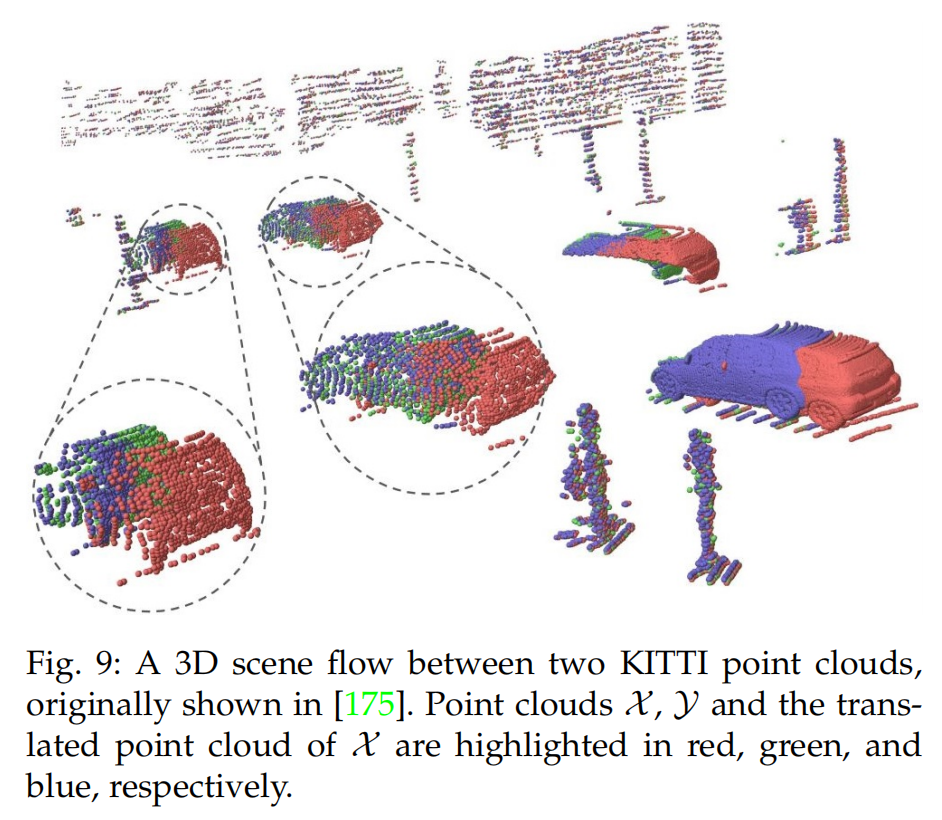

4.3 3D Scene Flow Estimation

給定兩個(gè)點(diǎn)云和,3D場(chǎng)景流描述了中的每一個(gè)點(diǎn)到Y(jié)中相應(yīng)位置的移動(dòng),。圖9顯示了兩個(gè)KITTI點(diǎn)云之間的3D場(chǎng)景流。類似于二維視覺中的光流估計(jì),一些方法已經(jīng)開始從點(diǎn)云序列中學(xué)習(xí)有用的信息(如3D場(chǎng)景流、空間臨時(shí)信息)。

圖9 Liu等人[175]提出FlowNet3D可以直接從一對(duì)連續(xù)的點(diǎn)云中學(xué)習(xí)場(chǎng)景流。FlowNet3D通過流嵌入層學(xué)習(xí)點(diǎn)級(jí)特征和運(yùn)動(dòng)特征。然而,F(xiàn)lowNet3D有兩個(gè)問題。首先,一些預(yù)測(cè)的運(yùn)動(dòng)向量在方向上明顯不同于地面真實(shí)情況。其次,F(xiàn)lowNet很難應(yīng)用于非靜態(tài)場(chǎng)景,特別是由可變形物體引起的場(chǎng)景。為了解決這一問題,Wang等人[176]引入了余弦距離損失來最小化預(yù)測(cè)與地面真相之間的角度。此外,他們還提出了點(diǎn)到平面的距離損失,以提高剛性和動(dòng)態(tài)場(chǎng)景的精度。實(shí)驗(yàn)結(jié)果表明,這兩個(gè)損失項(xiàng)將FlowNet3D的準(zhǔn)確率從57.85%提高到63.43%,加快和穩(wěn)定了訓(xùn)練過程。Gu等人[177]提出了一種分層Permutohedral Lattice FlowNet (HPLFlowNet)來直接估計(jì)大規(guī)模點(diǎn)云的場(chǎng)景流。在降低計(jì)算成本的同時(shí),提出了幾種雙邊卷積層來恢復(fù)原始點(diǎn)云的結(jié)構(gòu)信息。 為了有效地處理順序點(diǎn)云,F(xiàn)an和Yang[178]提出了PointRNN、PointGRU和PointLSTM網(wǎng)絡(luò)以及一個(gè)序列對(duì)序列模型來跟蹤mov - ing點(diǎn)。PointRNN、PointGRU和PointLSTM能夠捕獲空間臨時(shí)信息,并對(duì)動(dòng)態(tài)點(diǎn)云進(jìn)行建模。類似地,Liu等人[179]提出了metenet直接從動(dòng)態(tài)學(xué)習(xí)表示點(diǎn)云。該方法學(xué)習(xí)從時(shí)空相鄰點(diǎn)聚合信息。進(jìn)一步引入直接分組和鏈流分組來確定時(shí)間鄰居。然而,上述方法的性能受到數(shù)據(jù)集規(guī)模的限制。Mittal等人[180]提出了兩種自我監(jiān)督損失,在大型未標(biāo)記數(shù)據(jù)集上訓(xùn)練他們的網(wǎng)絡(luò)。他們的主要思想是,一個(gè)魯棒的場(chǎng)景流量估計(jì)方法應(yīng)該在正向和反向預(yù)測(cè)都有效。由于場(chǎng)景流的不可測(cè)性,預(yù)測(cè)變換點(diǎn)的最近鄰被認(rèn)為是偽地真。然而,真正的地面真相可能與最近的點(diǎn)不一樣。為了避免這一問題,他們計(jì)算了反向的場(chǎng)景流,并提出了一個(gè)循環(huán)一致性損失來將點(diǎn)平移到原始位置。實(shí)驗(yàn)結(jié)果表明,該自監(jiān)督方法優(yōu)于現(xiàn)有的基于監(jiān)督學(xué)習(xí)的方法。

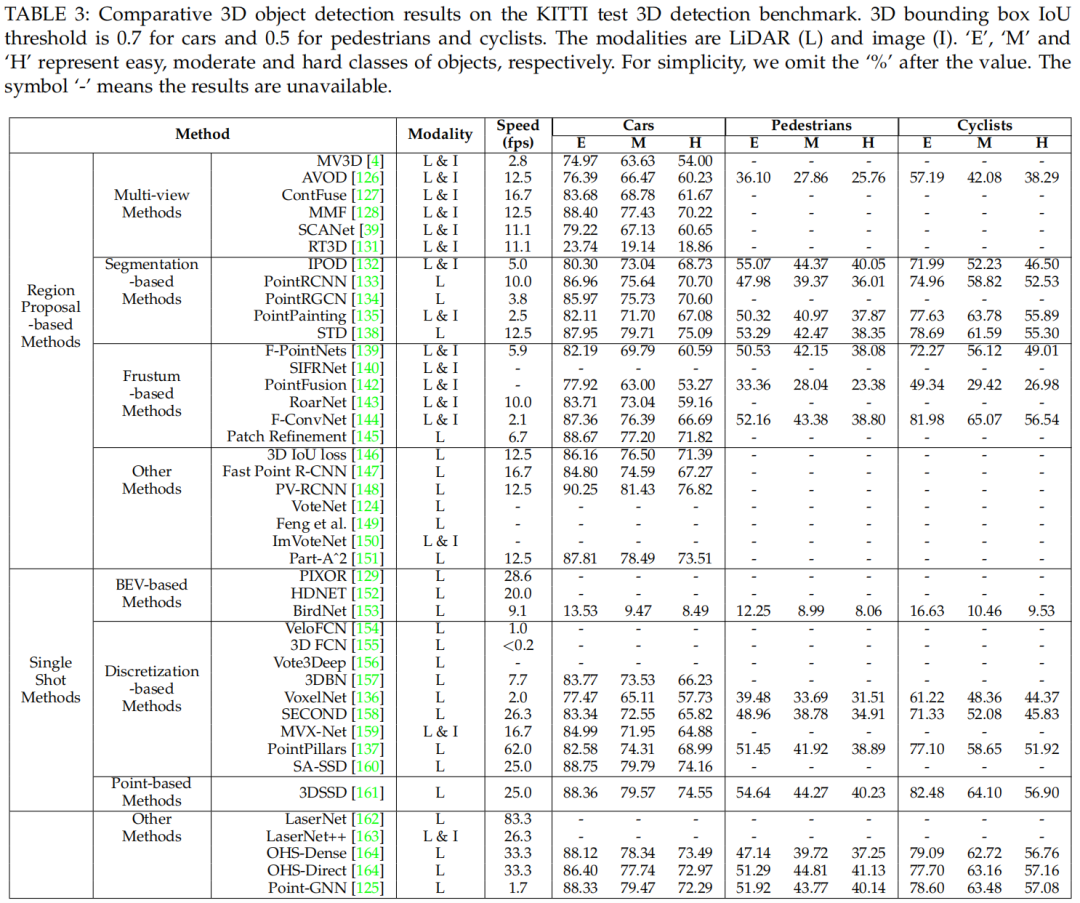

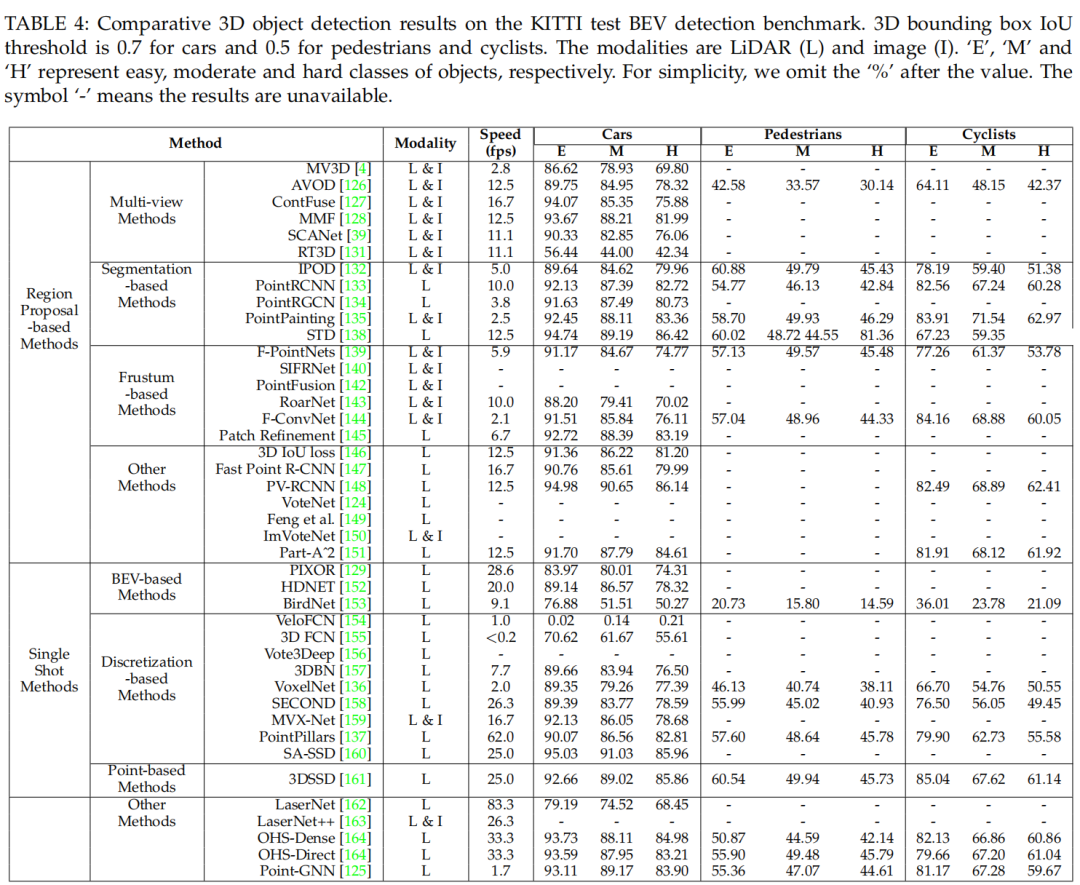

4.4 Summary

KITTI[14]基準(zhǔn)是自動(dòng)駕駛領(lǐng)域最具影響力的數(shù)據(jù)集之一,在學(xué)術(shù)界和工業(yè)界都得到了廣泛應(yīng)用。表3和表4展示了不同檢測(cè)器在KITTI測(cè)試3D基準(zhǔn)測(cè)試上獲得的結(jié)果。可以看出以下幾點(diǎn):

基于區(qū)域提案的方法是這兩種方法中被研究最多的方法,并且在KITTI測(cè)試3D和BEV臺(tái)架測(cè)試的結(jié)果中都大大優(yōu)于單發(fā)方法。

現(xiàn)有的3D物體探測(cè)器有兩個(gè)限制。首先,現(xiàn)有方法的遠(yuǎn)程檢測(cè)能力相對(duì)較差。第二,如何充分利用圖像中的紋理信息仍然是一個(gè)有待解決的問題。

多任務(wù)學(xué)習(xí)是3D目標(biāo)檢測(cè)的未來發(fā)展方向。例如,MMF[128]學(xué)習(xí)跨模態(tài)表示,通過合并多個(gè)任務(wù)來實(shí)現(xiàn)最先進(jìn)的檢測(cè)性能。

3D目標(biāo)跟蹤和場(chǎng)景流量估計(jì)是新興的研究課題,自2019年以來逐漸受到越來越多的關(guān)注。

表3

表4

5 3D Point Cloud Segmentation

3D點(diǎn)云分割要求了解全局的幾何結(jié)構(gòu)以及各個(gè)點(diǎn)的細(xì)粒度的細(xì)節(jié)。根據(jù)分割的細(xì)粒度,3D 點(diǎn)云分割方法可分為以下三類:語義分割(場(chǎng)景級(jí))、實(shí)例分割(物體級(jí))和part segmentation(part level)。

5.1 3D Semantic Segmentation

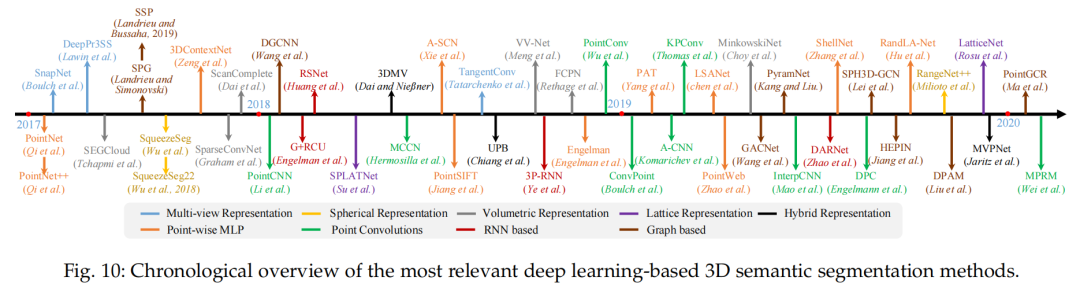

給定一個(gè)點(diǎn)云,語義分割的目標(biāo)是,根據(jù)語義信息,將各個(gè)點(diǎn)分成一定的子集。與3D形狀分類的分類類似,語義分割可分為兩種方法:基于投影的方法和基于點(diǎn)的方法。

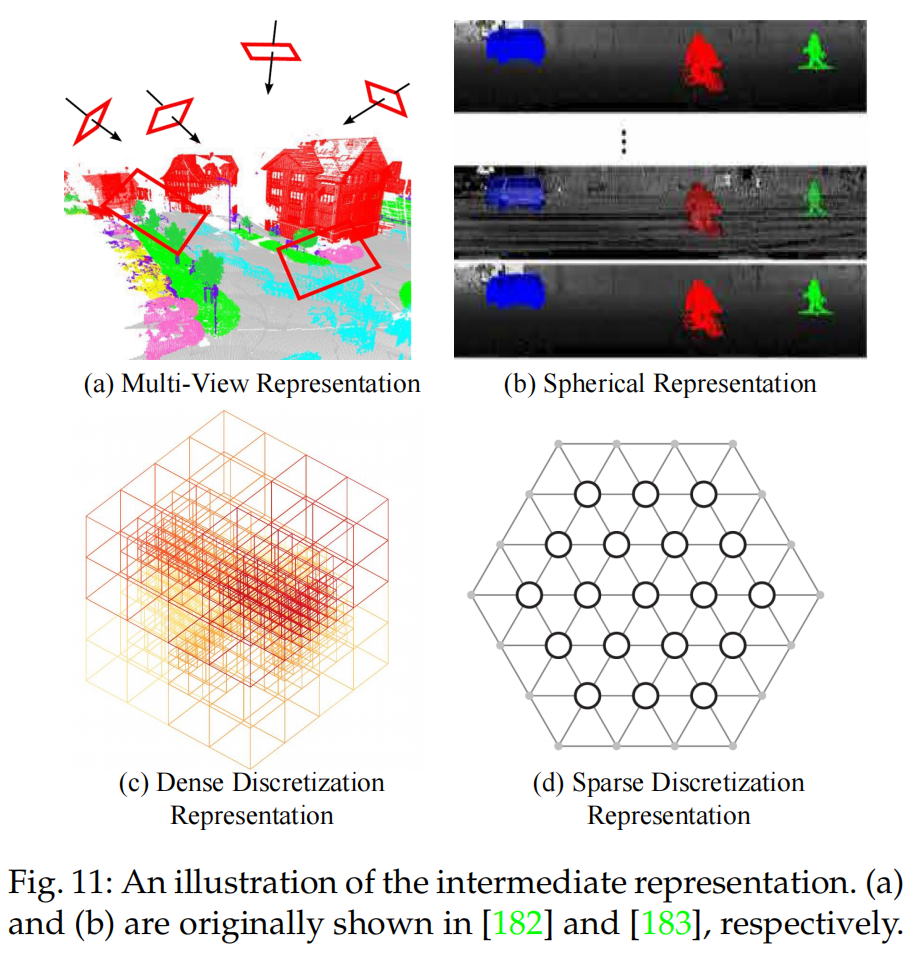

圖10:3D語義分割 Intermediate regular representations可被分成以下幾種:多視角表示[148], [149]、球狀表示[150], [151], [152]、體素表示[153], [154], [155]、超多面體晶格表示[156], [157]以及混合表示[158], [159]。具體可見圖11。

圖11:Intermediate regular representations

5.1.1 基于投影的網(wǎng)絡(luò)

多視角表示

[181]首先將3D點(diǎn)云從多個(gè)虛擬的相機(jī)視角投影至2D平面上,接著,使用多流的FCN在人造的圖像上預(yù)測(cè)各個(gè)像素的scores。最終各個(gè)點(diǎn)的語義標(biāo)簽為不同視角上scores的融合。

相似地,[182]首先利用多組相機(jī)的位置,得到點(diǎn)云的一些RGB和深度圖。接著使用2D的分割網(wǎng)絡(luò),在這些圖片上得到各個(gè)像素的label,這些從RGB和深度圖上得到的scores用來融合(使用redisual correction[192])。

基于點(diǎn)云是從局部歐式曲面上采樣得到的假設(shè),[193]引入了tangent convolutions進(jìn)行稠密的點(diǎn)云分割。該方法首先將各個(gè)點(diǎn)周圍的局部曲面投影至虛擬的切平面。Tangent convolutions在曲面上直接進(jìn)行。

總的來說,多視角分割方法的性能對(duì)視角的選擇和遮擋非常敏感。同時(shí),這類方法并未能完全利用潛在的幾何和結(jié)構(gòu)信息,因?yàn)橥队安僮鞑豢杀苊獾匾肓诵畔p失。

球狀表示

為了得到更快更準(zhǔn)確的3D點(diǎn)云分割,[183]提出了基于SqueezeNet和條件隨機(jī)場(chǎng)的端到端的網(wǎng)絡(luò)。

為了進(jìn)一步提升分割準(zhǔn)確率,引入了SqueezeSegV2[184]利用無監(jiān)督的domain adaptation解決domain shift。

[185]提出了**RangeNet++**,針對(duì)LiDAR點(diǎn)云進(jìn)行實(shí)時(shí)的語義分割。2D深度圖的語義標(biāo)簽首先轉(zhuǎn)移至3D點(diǎn)云上,接著使用基于KNN的后處理步驟來減輕離散化誤差的問題。

與單一的視角映射相比,球映射保持了更多的信息,并且更適合LiDAR點(diǎn)云。然而,這樣的中間表示不可避免地引入了一些問題,比如離散化誤差和遮擋問題。

5.1.2 基于離散化的方法

密集離散化表示

[195]首先將點(diǎn)云分成一系列占有的體素。接著將這些過渡數(shù)據(jù)送入至fully-3D CNN中進(jìn)行體素級(jí)別的分割。最后,一格體素中的所有點(diǎn)的語義信息與該體素的label相同。該方法的性能極其受限于體素的細(xì)粒度和邊界的偽影。

之后,[196]提出SEGCloud來得到更細(xì)粒度和global consistent的語義分割。該方法引入了確定性的三線性插值,將由3D-FCNN產(chǎn)生的粗糙的網(wǎng)格預(yù)測(cè)映射回點(diǎn)云中,接著使用Fully Connected CRF,確保推測(cè)出的點(diǎn)云有著空間上的一致性。

[186]引入了一種基于核的變分自編碼器結(jié)構(gòu)地局部幾何結(jié)構(gòu)進(jìn)行編碼。這里摒棄了binary occupancy representations, 使用RBF得到連續(xù)的表示,并且捕獲到每個(gè)體素中點(diǎn)的分布。再使用VAE將各個(gè)體素中的點(diǎn)映射至隱空間,最后使用CNN得到魯棒的特征表示。

良好的尺度擴(kuò)展性質(zhì)是體素表示中的優(yōu)點(diǎn)之一。具體而言,基于體素的網(wǎng)絡(luò)對(duì)于有著不同空間尺寸的點(diǎn)云,其訓(xùn)練和測(cè)試是不受限制的。

在Fully-Convolutional Point Network(FCPN)[187] 中,不同級(jí)別的幾何相關(guān)性從點(diǎn)云中提取出來,再使用3D卷積核加權(quán)的均值池化來提取特征。該方法可處理大規(guī)模的點(diǎn)云,并且在推斷時(shí)有著良好的尺度擴(kuò)展性質(zhì)。

[198]提出了ScanComplete來實(shí)現(xiàn)3D補(bǔ)全,以及對(duì)各個(gè)體素進(jìn)行語義預(yù)測(cè)。該方法利用了全卷積網(wǎng)絡(luò)的尺度擴(kuò)展性,在訓(xùn)練和測(cè)試階段應(yīng)對(duì)不同的輸入數(shù)據(jù)大小。使用從粗到細(xì)的策略來提高預(yù)測(cè)結(jié)果的分辨率。

綜上所述,體素表示很自然地保留了3D點(diǎn)云的鄰域結(jié)構(gòu)。其規(guī)范的數(shù)據(jù)形式也是的標(biāo)準(zhǔn)的3D卷積可師姐應(yīng)用。這些因素在這一領(lǐng)域有著不錯(cuò)的性能提升。然而,體素化的過程內(nèi)在地引入了離散化的偽影和信息損失。通常,高分辨率會(huì)導(dǎo)致較高的內(nèi)存和計(jì)算消耗,低分辨率引入了信息的損失。在實(shí)際中如何選擇合適的網(wǎng)格分辨率是non-trivial的。

系數(shù)離散化表示

體素表示(volumetric representation)是稀疏的,其中非零元素的數(shù)量?jī)H僅占很小一部分。因此,在空間上稀疏的數(shù)據(jù)使用稠密的卷積網(wǎng)絡(luò)是比較無效的。

為此,[166]提出了子流形的稀疏卷積網(wǎng)絡(luò)。該方法顯著地減小了內(nèi)存擬合計(jì)算消耗,通過限制卷積的輸出只能與被占據(jù)的體素有關(guān)。同時(shí),該稀疏卷積也可以通知提取出的特征的稀疏性。該子流形稀疏卷積很適合處理高維度且空間較稀疏的數(shù)據(jù)。

更進(jìn)一步,[199]提出的“MinkowskiNet”,即4D時(shí)間-空間卷積網(wǎng)絡(luò)用以3D視頻感知。廣義上的稀疏卷積來處理高維數(shù)據(jù)。

另一方面,Su等人[188]提出了基于雙邊卷積層(BCLs)的稀疏點(diǎn)陣網(wǎng)絡(luò)(SPLATNet)。該方法首先將原始點(diǎn)云插值到一個(gè)互面體稀疏點(diǎn)陣中,然后利用BCL對(duì)稀疏點(diǎn)陣的占用部分進(jìn)行卷積。然后將過濾后的輸出插值回原始點(diǎn)云。此外,該方法還可以靈活地聯(lián)合處理多視圖圖像和點(diǎn)云。

此外,Rosu等人[189]提出了LatticeNet來實(shí)現(xiàn)對(duì)大型點(diǎn)云的高效處理。還引入了一個(gè)名為DeformsSlice的數(shù)據(jù)相關(guān)插值模塊,將點(diǎn)陣特征反向投影到點(diǎn)云上。

5.1.3 混合表示

為了進(jìn)一步利用所有可用信息,許多方法試圖學(xué)習(xí)多模態(tài)特征。

[190]提出了joint 3D-mult-view網(wǎng)絡(luò),來組合RGB和幾何特征。一個(gè)3D CNN流和一些2D CNN流用來提取特征,另一個(gè)可微分的back-projection layer用來合并3D和2D特征。

更進(jìn)一步,[200]提出了unified point-based network來學(xué)習(xí)2D紋理信息,3D結(jié)構(gòu)和全局特征。該方法直接應(yīng)用基于點(diǎn)的網(wǎng)絡(luò)來提取局部幾何特征和環(huán)境信息。

[191]提出了Multiview PointNet(MVPNet)來集成2D多視角特征和空間幾何特征。

5.1.4 基于點(diǎn)的網(wǎng)絡(luò)

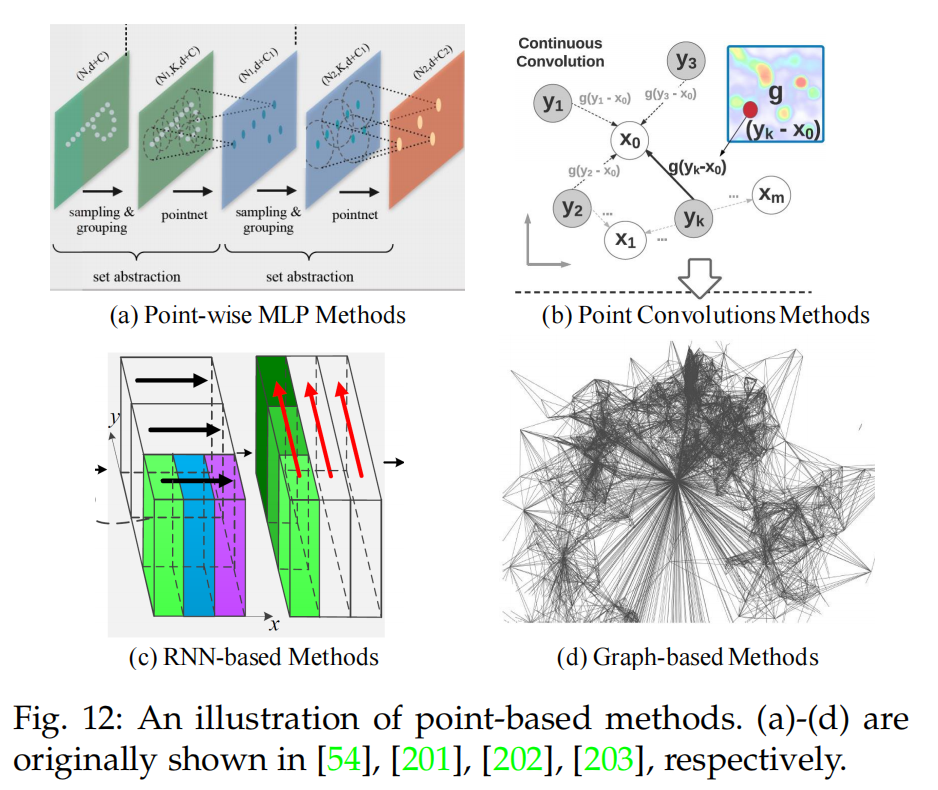

基于點(diǎn)的網(wǎng)絡(luò)直接在點(diǎn)云上進(jìn)行操作。然而,點(diǎn)云通常是無序且無結(jié)構(gòu)的,使得直接應(yīng)用標(biāo)準(zhǔn)的CNN不現(xiàn)實(shí)。為此,先驅(qū)的工作PointNet[5]用來對(duì)每個(gè)點(diǎn)進(jìn)行特征學(xué)習(xí),使用的是標(biāo)準(zhǔn)的MLP和全局特征。基于PointNet,一系列基于點(diǎn)的網(wǎng)絡(luò)被提出。總體而言,這類方法可悲簡(jiǎn)單的分為以下幾類:基于各個(gè)點(diǎn)的MLP方法,基于點(diǎn)卷積的方法,基于RNN的方法和基于圖的方法。

Pointwise MLP Methods

這類方法通常利用共享的MLP作為網(wǎng)絡(luò)中的基本單元。然而,由共享MLP提取出的各個(gè)點(diǎn)上的特征,并不能獲取到點(diǎn)云中的局部幾何關(guān)系,以及點(diǎn)與點(diǎn)之間的關(guān)系[5]。為了獲取各個(gè)點(diǎn)周圍更廣泛的信息,以及學(xué)習(xí)到更豐富的局部結(jié)構(gòu),有很多方法被提出,包括基于鄰近點(diǎn)特征池化的方法,基于注意力機(jī)制的集成(attention-based aggregation)以及局部-全局的特征級(jí)聯(lián)。 Neighboring feature pooling:為了獲取局部的幾何形式,這類方法通過將局部鄰域點(diǎn)集成的方式,對(duì)各個(gè)點(diǎn)學(xué)習(xí)特征。

具體而言,PointNet++[54]將點(diǎn)分層次,逐步地分成一些組,如下圖所示。多尺度的grouping和多分辨率的grouping來克服點(diǎn)云多樣性造成的問題。圖12(a)。

之后,[141]提出了PointSIFT模塊來實(shí)現(xiàn)方向的編碼和scale awareness。該模塊通過使用3階段的有向的卷積操作,將8個(gè)空間方向的信息堆疊并且編碼,將多尺度的特征提取并級(jí)聯(lián)來實(shí)現(xiàn)對(duì)不同尺度的適應(yīng)性。

與PointNet++中使用GROUPING的方法不同,[204]利用K-Means聚類和KNN的方法在世界空間和特征空間定義兩種鄰域。基于這樣的假設(shè):來自于同一類的點(diǎn)在特征空間中應(yīng)當(dāng)接近,該論文提出了pairwise distance loss and a centroid loss來對(duì)特征學(xué)習(xí)進(jìn)行正則。

為了建模點(diǎn)與點(diǎn)之間的相互關(guān)系,[57]提出了PointWeb來尋找局部區(qū)域內(nèi)所有點(diǎn)對(duì)之間的關(guān)系。

[205]提出了置換不變性的卷積稱之為Shellconv。

[206]提出了有效、輕量的網(wǎng)絡(luò)稱為RandLA-Net實(shí)現(xiàn)大規(guī)模的點(diǎn)云處理。該方法利用隨機(jī)樣本采樣,在內(nèi)存和計(jì)算方面提升很多。提出的局部特征集成用來獲取和保持幾何特征。

Attention-based aggregation:

為了進(jìn)一步提升分割的準(zhǔn)確率,[120]針對(duì)點(diǎn)云分割,提出了基于注意力的機(jī)制。

[56]提出了組隨機(jī)注意力機(jī)制(group shuffle attention)來建模點(diǎn)之間的關(guān)系,并且提出了具有置換不變性、task-agnostic以及可微分的Gumbel Subset Sampling(GSS)來替代被廣泛應(yīng)用的Furthest Point Sampling(FPS)方法。該方法對(duì)離群點(diǎn)不敏感,并且可以選擇具有代表性的點(diǎn)的子集。

為了更好地獲取點(diǎn)云的空間分布,[207]提出了Local Spatial Aware(LSA)層來學(xué)習(xí)空間感知權(quán)重。

與CRF類似,[208]提出了Attention-based Score Refinement(ASR)模塊對(duì)分割的結(jié)果進(jìn)行后處理。初始分割結(jié)果通過pooling的方式進(jìn)行修正。該模塊很容易被集成至其他的深度網(wǎng)絡(luò)中來提升分割效果。

Local-global concatenation:[112]提出了置換不變性的PS2-Net,將點(diǎn)云的局部結(jié)構(gòu)和全局信息合并。Edgeconv[87]與NetVLAD[209]重復(fù)的級(jí)聯(lián)起來,來獲取局部信息和場(chǎng)景級(jí)別的全局特征。

Point Convolution Methods

這類方法通常試圖提出在點(diǎn)云上進(jìn)行更有效的卷積操作。

[76]提出了在各個(gè)點(diǎn)上的卷積操作,其中鄰域點(diǎn)被分入至kernel cell,卷積時(shí)卷積核有權(quán)重。

[201]提出了稱之為PCCN的網(wǎng)絡(luò),該網(wǎng)絡(luò)基于參數(shù)化的連續(xù)卷積層。該層的核參數(shù)通過MLP和張成的連續(xù)向量空間所參數(shù)化。圖12(b)。

[65]提出了Kernel Point Fully Convolutional Network(KP-FCNN),基于Kernel Point Convolution(KPConv)。具體而言,KPConv的卷積權(quán)重由歐式空間的距離決定,卷積核的點(diǎn)數(shù)也并不固定。卷積核點(diǎn)的位置由一個(gè)最優(yōu)化問題確定。

在[211]中,作者提供了豐富的消融實(shí)驗(yàn)(ablation experiments)和可視化結(jié)果展示了集成方法中,感受野的重要性。同時(shí)他們提出了Dilated Point Convolution(DPC)操作,來集成鄰近點(diǎn)的特征,進(jìn)而取代KNN的方法。該方法在提升感受野上非常有效,并且可以容易地集成至aggregation-based networks。

圖12

RNN-based Methods

為了獲取點(diǎn)云中的內(nèi)在環(huán)境特征,RNN也比用來進(jìn)行點(diǎn)云的語義分割。

基于PointNet[5], [213]首先將一大塊點(diǎn)云轉(zhuǎn)換成多尺度的塊和網(wǎng)格塊來獲取輸入級(jí)別的環(huán)境。接著,使用PointNet對(duì)各個(gè)塊提取特征并送入Consolidation Units 或Recurrent Consolidation Units來獲取輸出級(jí)別的環(huán)境信息。實(shí)驗(yàn)結(jié)果顯示,這樣處理空間環(huán)境信息的方法在提高分割性能時(shí)是很重要的。

[212]提出了一種輕量的模塊,利用了slice pooling layer將無序的點(diǎn)云特征轉(zhuǎn)換成有序的特征向量。

[202]提出了Pointwise Pyramid Pooling (3P)模塊來獲取從粗到細(xì)的局部特征,并利用雙向的RNN來實(shí)現(xiàn)端到端學(xué)習(xí)。圖12(c)。

然而這類方法損失了豐富的幾何特征和密度分布[220]。[220]提出了Dynamic Aggregation Network(DAR-Net)來同時(shí)考慮全局場(chǎng)景復(fù)雜度和局部幾何特征。

[221]提出了3DCNN-DQN-RNN。該網(wǎng)絡(luò)首先使用3DCNN學(xué)習(xí)空間分布和顏色特征,使用DQN進(jìn)一步定位類別物體。最后級(jí)聯(lián)的特征向量送入RNN中獲取最后的分割結(jié)果。

Graph-based Methods

為了獲取3D點(diǎn)云中潛在的形狀和幾何結(jié)構(gòu),一些方法使用了圖神經(jīng)網(wǎng)絡(luò)。

[203]將點(diǎn)云看做是一些相連的簡(jiǎn)單形狀和Superpoint的集合,并且使用有向圖來獲取結(jié)構(gòu)和環(huán)境信息。接著講大規(guī)模的點(diǎn)云分割問題分成三個(gè)子問題,即,geometrically homogeneous partition, superpoint embedding and contextual segmentation。圖12(d)。

為了進(jìn)一步提升,[214]提出了有監(jiān)督的框架 to oversegment a point cloud into pure superpoints。

為了更好地獲取高維空間中的局部幾何關(guān)系,[222]提出了基于Graph Embedding Module(GEM)和Pyramid Attention Network(PAN)的網(wǎng)絡(luò)PyramNet。GEM模塊將點(diǎn)云表述為有向無環(huán)圖,并且在構(gòu)建相似度矩陣時(shí),利用協(xié)方差矩陣代替歐式距離。在PAN模塊中,使用4個(gè)不同尺寸的卷積核來提取特征。

在[215]中,提出的Graph Attention Convolution用來選擇性地提取特征。該操作是通過根據(jù)不同相鄰點(diǎn)和fea通道的空間位置和特征差異動(dòng)態(tài)分配注意權(quán)重來實(shí)現(xiàn)的。GAC可以學(xué)習(xí)捕獲鑒別的特征進(jìn)行分割,并且與常用的CRF模型具有相似的特征。

Ma等人[223]提出了一種點(diǎn)全局上下文推理(PointGCR)模塊,使用無向圖表示沿通道維度捕獲全局上下文信息。PointGCR是一個(gè)即插即用的端到端可培訓(xùn)模塊。它可以很容易地集成到現(xiàn)有的細(xì)分網(wǎng)絡(luò)中,以實(shí)現(xiàn)性能改進(jìn)。

此外,最近的一些工作試圖在弱監(jiān)督下實(shí)現(xiàn)點(diǎn)云的語義分割。

Wei等人[224]提出了一種兩階段方法,用子云級(jí)標(biāo)簽訓(xùn)練分割網(wǎng)絡(luò)。

Xu等人[225]研究了幾種用于點(diǎn)云語義分割的不精確監(jiān)督方案。他們還提出了一種僅能用部分標(biāo)記點(diǎn)(例如10%)進(jìn)行訓(xùn)練的網(wǎng)絡(luò)。

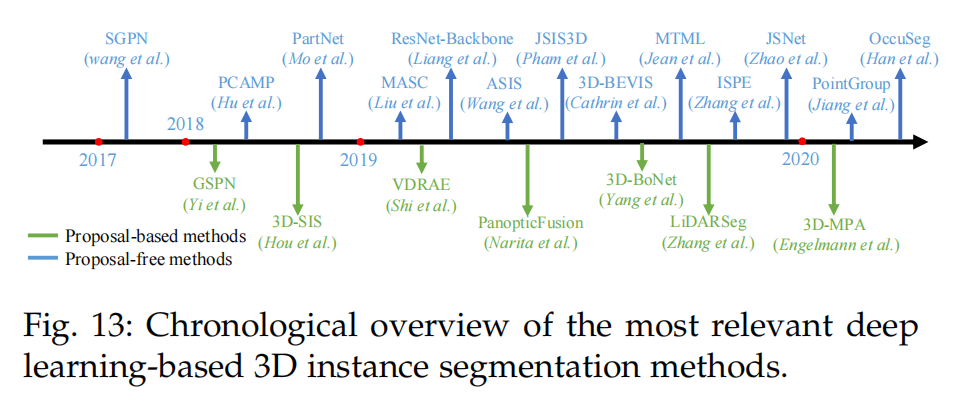

5.2 Instance Segmentation

與語義分割相比,實(shí)例分割更具有挑戰(zhàn)性因?yàn)樗枰鼫?zhǔn)確和更小的細(xì)粒度,具體而言,他不僅需要將有著不同語義的點(diǎn)分辨出來,還需要將有著相同語義的實(shí)例分出來。總體而言,目前的方法可分為兩個(gè)方向:基于候選框的方法以及不需要候選框的方法。一些里程碑式的方法具體見圖13。

圖13:3D實(shí)例分割方法

5.2.1 Proposal-based Methods

這類方法將實(shí)例分割問題分成兩個(gè)子任務(wù):3D物體檢測(cè)和實(shí)例mask預(yù)測(cè)。

[226]提出了3D fully-convolutional Semantic Instance Segmentation (3D-SIS) network,來實(shí)現(xiàn)在RGB-D數(shù)據(jù)上的語義實(shí)例分割。該網(wǎng)絡(luò)從顏色和幾何中學(xué)習(xí)特征。與3D目標(biāo)檢測(cè)類似,3D Region Proposal Network(3D-RPN)和3D ROI layer用來預(yù)測(cè)bounding box的位置,物體類別和實(shí)例的mask。

根據(jù)合成分析策略,[227]提出了Generative Shape Proposal Network(GSPN)來產(chǎn)生3D候選框。這些候選框再通過R-PointNet修正。最終的標(biāo)簽通過預(yù)測(cè)各個(gè)點(diǎn)的二進(jìn)制mask來得到。與直接從點(diǎn)云中回歸3D bounding boxes不同,該方法移除了許多無用的候選框。

[228]通過將2D panoptic分割延伸至3D映射,提出了在線的體素化3D行社系統(tǒng)來實(shí)現(xiàn)大規(guī)模的3D重建,給語義標(biāo)簽以及實(shí)例分割。該方法首先利用2D語義和實(shí)例分割獲得像素級(jí)別的panoptic 標(biāo)簽,接著將這些標(biāo)簽集成至體素map中。使用全連接的CRF來實(shí)現(xiàn)準(zhǔn)確的分割。該語義映射系統(tǒng)可得到高質(zhì)量的語義映射和具有判別性的目標(biāo)檢測(cè)。

[229]提出了單階段的,不需要anchor的可訓(xùn)練網(wǎng)絡(luò)稱為3D-BoNet,來實(shí)現(xiàn)點(diǎn)云上的實(shí)例分割。該方法對(duì)所有可能的實(shí)例直接回歸大致的3D bounding boxes,接著利用點(diǎn)級(jí)別的二分類器來獲取實(shí)例標(biāo)簽。特別地,該bounding boxe的任務(wù)是被當(dāng)做是最優(yōu)分配問題。同時(shí),使用了multi-criteria 損失函數(shù)來正則化生成的bounding boxes。該方法不需要任何的后處理操作,并且有很高的計(jì)算效率。

[230]提出了針對(duì)大規(guī)模戶外LiDAR點(diǎn)云進(jìn)行實(shí)例分割的網(wǎng)絡(luò)。該方法使用self-attention blocks,在點(diǎn)云的鳥瞰圖上學(xué)習(xí)特征表示,最后獲取的實(shí)例分割標(biāo)簽基于預(yù)測(cè)的水平中心和高度限制。

Shi等人[231]提出了一種層級(jí)意識(shí) 變分去噪遞歸自動(dòng)編碼器(VDRAE) 預(yù)測(cè)室內(nèi)三維空間布局。目標(biāo)建議 由遞歸上下文迭代生成和細(xì)化嗎 聚合和傳播。

總體而言,基于提議的方法[226]、[227]、[229]、[232]直觀直觀,實(shí)例分割結(jié)果通常具有較好的客觀性。然而,這些方法需要多階段的訓(xùn)練和對(duì)新提案的修剪。因此通常都需要更多的時(shí)間和計(jì)算資源。

5.2.2 Proposal-free Methods

不需要候選框的方法[233-240]并沒有目標(biāo)檢測(cè)的模塊。作為替代的是,他們通常將實(shí)例分割認(rèn)為是語義分割后的聚類步驟。具體而言,需要現(xiàn)有的方法都基于這樣的假設(shè):屬于同一實(shí)例的點(diǎn)應(yīng)當(dāng)有著相似的特征。因此這類方法通常聚焦于判別式的特征學(xué)習(xí)和點(diǎn)云聚類。

[233]作為先驅(qū)性的工作,首次提出了Similarity Group Proposal Network(SGPN)。該方法首先對(duì)每個(gè)點(diǎn)學(xué)習(xí)特征和語義map,接著引入相似度矩陣來表示各對(duì)點(diǎn)之間的相似度。為了學(xué)習(xí)到更多的判別式特征,使用了double-hinge loss來互相適應(yīng)相似度矩陣和語義分割的結(jié)果。最后使用啟發(fā)式的NMS方法將相似的點(diǎn)歸并進(jìn)一個(gè)實(shí)例中。由于相似度矩陣的構(gòu)建需要大量的內(nèi)存消耗,該方法應(yīng)用的規(guī)模收到了限制。

類似地,[237]首先利用子流形稀疏卷積來預(yù)測(cè)各個(gè)體素的語義scores,急著引入聚類算法將點(diǎn)聚集至實(shí)例中。

更進(jìn)一步,[238]提出了structure-aware loss來學(xué)習(xí)判別式的embeddings。該損失函數(shù)同時(shí)考慮了特征的相似度和點(diǎn)之間的幾何關(guān)系。最后使用基于注意力機(jī)制的graph CNN來自適應(yīng)地對(duì)特征進(jìn)行修正。

由于一個(gè)點(diǎn)的語義分類和實(shí)例標(biāo)簽通常互相決定,許多方法將該兩個(gè)任務(wù)合并成一個(gè)任務(wù)。

[234]通過引入端到端可學(xué)習(xí)的Associatively Segmenting Instances and Semantics (ASIS)模塊,將兩個(gè)任務(wù)集成到一起。實(shí)驗(yàn)結(jié)果顯示語義特征和實(shí)例特征可相互支撐,達(dá)到了一定的性能提升。

[235]首先引入了Multi-Task Point-Wise Network(MT-PNet), 給各個(gè)點(diǎn)分配標(biāo)簽信息,并且對(duì)特征空間的embedding進(jìn)行正則。接著將預(yù)測(cè)的語義標(biāo)簽和embeddings融合至Multi-Value Conditional Random Field(MV-CRF)進(jìn)行聯(lián)合優(yōu)化。最后,mean-field variational inference用來得到語義標(biāo)簽和實(shí)例標(biāo)簽。

[244]提出了Dynamic Region Growing (DRG) method,自動(dòng)地將點(diǎn)云分成一系列的塊,接著使用無監(jiān)督的K-means++ 算法進(jìn)行聚類。接著在環(huán)境信息的指導(dǎo)下進(jìn)行大規(guī)模的patch segmentation。最后,這類有標(biāo)簽的patches融合進(jìn)物體級(jí)別,得到最后的語義和實(shí)例標(biāo)簽。

為了實(shí)現(xiàn)在整個(gè)3D場(chǎng)景上的實(shí)例分割

[236]提出了混合的2D-3D網(wǎng)絡(luò),該網(wǎng)絡(luò)學(xué)習(xí)全局一致性的實(shí)例特征和局部的幾何特征。學(xué)習(xí)到的特征被組合起來實(shí)現(xiàn)語義和實(shí)例分割。

在將點(diǎn)聚集成實(shí)例時(shí),并非使用GroupMerging算法[197],而是更靈活的Meanshift[233]。

[246]同時(shí)學(xué)習(xí)了每個(gè)實(shí)例的獨(dú)特的特征表示,以及對(duì)于物體中心的方向信息。使用feature embedding loss and directional loss 在隱空間中學(xué)習(xí)特征。Mean-shift 聚類和NMS用來將體素積聚成實(shí)例。該方法在ScanNet[11]基準(zhǔn)上達(dá)到了SOTA性能。同時(shí),預(yù)測(cè)出的方向信息可以確定實(shí)例的邊界。

[247]引入了概率embeddings進(jìn)行點(diǎn)云的實(shí)例分割。該方法也繼承了不確定估計(jì)并且提出了新的損失函數(shù)。

Jiang等人[240] 提出了一種PointGroup網(wǎng)絡(luò),它由語義分割分支和偏移量預(yù)測(cè) 分支。雙集聚類算法和ScoreNet 是否進(jìn)一步利用以獲得更好的分組結(jié)果

總體而言,不需要候選框的方法不需要耗費(fèi)資源的區(qū)域生成步驟。然而,該方法的準(zhǔn)確率較低因?yàn)樵摲椒ú粰z測(cè)物體的邊界。

5.3 Part Segmentation

零件分割(Part Segmentation)的主要困難來自于兩方面。第一,有相同語義標(biāo)簽的部件有著較大的幾何變化和不確定性;第二,該方法需要對(duì)噪聲和采樣具有魯棒性。

[248]提出了VoxSegNet,在3D體素?cái)?shù)據(jù)上來實(shí)現(xiàn)細(xì)粒度的零件分割。Spatial Dense Extraction(SDE)模塊用來在稀疏體素?cái)?shù)據(jù)上提取大規(guī)模的具有判別性的e特征。學(xué)習(xí)到的特征被重新賦予權(quán)重,并且使用Attention Feature Aggregation (AFA)模塊進(jìn)行融合。

[249]將FCN與surface-based CRF組合,實(shí)現(xiàn)端到端的3D 零件分割。他們首先從不同的視角產(chǎn)生圖像來實(shí)現(xiàn)optimal surface coverage,并將這些圖片送入至2D網(wǎng)絡(luò)產(chǎn)生置信圖。接著,使用surface-based CRF將置信圖集成起來,用來對(duì)整個(gè)場(chǎng)景打標(biāo)簽。

[250]引入了Synchronized Spectral CNN(SyncSpecCNN),在不規(guī)則非同構(gòu)形狀圖上實(shí)現(xiàn)卷積。

[251]通過引入Shape Fully Convolutional Networks(SFCN),在3D網(wǎng)格上實(shí)現(xiàn)了形狀分割,并且將三種低層次的幾何特征作為輸入。接著利用基于投票的多標(biāo)簽graph cut來修正分割結(jié)果。

[252]提出了弱監(jiān)督的CoSegNet進(jìn)行3D形狀分割。該網(wǎng)絡(luò)將一些未分割的3D點(diǎn)云形狀作為輸入,接著通過最小化group consistency loss,產(chǎn)生形狀零件的標(biāo)簽。與CRF類似,預(yù)訓(xùn)練的part-refinement網(wǎng)絡(luò)用來修正并且去噪。

[253]提出了Branched Auto-encoder network(BAE-NET)用來無監(jiān)督,one-shot和弱監(jiān)督3D形狀分割。該方法將形狀分割任務(wù)看做是特征學(xué)習(xí)問題并試圖找到最簡(jiǎn)單的零件表示(通過最小化形狀重建損失函數(shù))。基于編碼-解碼的結(jié)構(gòu),該網(wǎng)絡(luò)的每個(gè)分支都在學(xué)習(xí)特定零件形狀的相容表示。學(xué)到的特征與點(diǎn)坐標(biāo)一起送入解碼器中,產(chǎn)生二進(jìn)制的值(該值表示該點(diǎn)是否屬于這一part)。該方法有著良好的繁華性,并且可以處理大規(guī)模的3D形狀幾何。然而該方法對(duì)處值較為敏感,并且并未利用到形狀的語義信息,妨礙了該方法在每次迭代中得到魯棒、穩(wěn)定的估計(jì)。

[254]提出了一種自頂向下遞歸零件分解網(wǎng)絡(luò)(PartNet),用于分層形狀分割。與現(xiàn)有的將形狀分割為固定標(biāo)簽集的方法不同,該網(wǎng)絡(luò)將零件分割為級(jí)聯(lián)二元標(biāo)記問題,并根據(jù)幾何結(jié)構(gòu)將輸入點(diǎn)云分解為任意數(shù)量的零件。

[255]針對(duì)零鏡頭3D零件分割任務(wù),提出了一種基于學(xué)習(xí)的分組框架。為了提高跨類別泛化能力,該方法傾向于學(xué)習(xí)一種分組策略,限制網(wǎng)絡(luò)在局部環(huán)境中學(xué)習(xí)零件級(jí)特征。

5.4 Summary

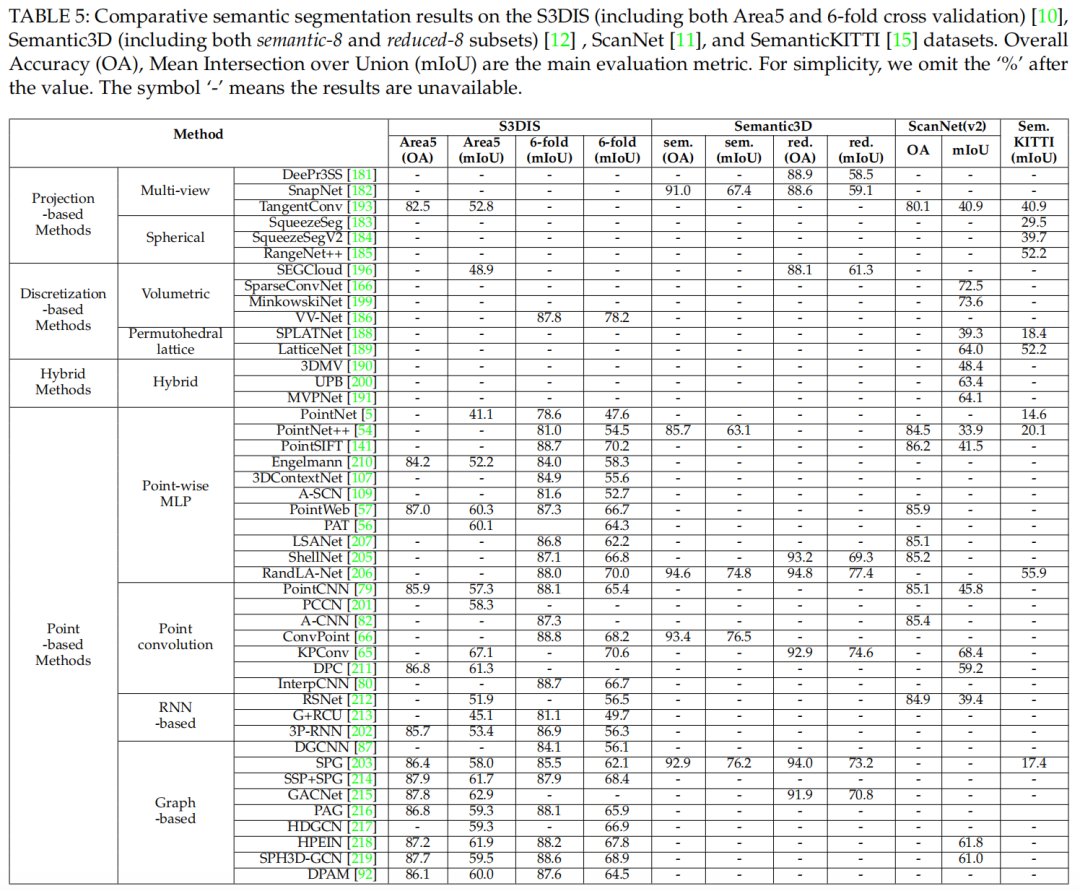

表5:分割結(jié)果對(duì)比 待進(jìn)一步研究的問題有:

由于常規(guī)的數(shù)據(jù)表示,基于投影的方法和基于離散化的方法都可以從二維圖像中利用成熟的網(wǎng)絡(luò)架構(gòu)。然而,基于投影的方法的主要局限性在于3D-2D投影帶來的信息丟失,而基于離散化的方法的主要瓶頸是分辨率的提高帶來的計(jì)算和存儲(chǔ)成本的大幅增加。為此,在索引結(jié)構(gòu)基礎(chǔ)上構(gòu)建稀疏卷積是一種可行的解決方案,值得進(jìn)一步探索。

基于點(diǎn)的網(wǎng)絡(luò)是最常被研究的方法。然而,點(diǎn)表示自然不具有顯式的鄰近信息,現(xiàn)有的大多數(shù)基于點(diǎn)的方法不得不借助于昂貴的鄰近搜索機(jī)制(如KNN或ball query)。這從本質(zhì)上限制了這些方法的效率,因?yàn)猷従铀阉鳈C(jī)制既需要很高的計(jì)算成本,又需要不規(guī)則的內(nèi)存訪問。

從不平衡數(shù)據(jù)中學(xué)習(xí)仍然是點(diǎn)云分割中一個(gè)具有挑戰(zhàn)性的問題。雖然有幾種的方法取得了顯著的綜合成績(jī),但它們?cè)陬悩?biāo)很少的情況下表現(xiàn)仍然有限。例如,RandLA-Net在Semantic3D的reduced-8子集上獲得了76.0%的整體IoU,而在hardscape類上獲得了41.1%的非常低的IoU。

大多數(shù)現(xiàn)有的方法都適用于小點(diǎn)云(如1m*1m,共4096個(gè)點(diǎn))。在實(shí)際中,深度傳感器獲取的點(diǎn)云通常是巨大的、大規(guī)模的。因此,有必要進(jìn)一步研究大規(guī)模點(diǎn)云的有效分割問題。

已有少數(shù)文獻(xiàn)開始研究動(dòng)態(tài)點(diǎn)云的時(shí)空信息。預(yù)期時(shí)空信息可以幫助提高后續(xù)任務(wù)的性能,如三維目標(biāo)識(shí)別、分割和完成。

審核編輯 :李倩

-

3D

+關(guān)注

關(guān)注

9文章

2910瀏覽量

107859 -

深度學(xué)習(xí)

+關(guān)注

關(guān)注

73文章

5512瀏覽量

121445

原文標(biāo)題:TPAMI三維點(diǎn)云深度學(xué)習(xí)技術(shù)綜述

文章出處:【微信號(hào):3D視覺工坊,微信公眾號(hào):3D視覺工坊】歡迎添加關(guān)注!文章轉(zhuǎn)載請(qǐng)注明出處。

發(fā)布評(píng)論請(qǐng)先 登錄

相關(guān)推薦

Qorvo在手機(jī)RF和Wi-Fi 7技術(shù)上的最新進(jìn)展及市場(chǎng)策略

FF將發(fā)布FX品牌最新進(jìn)展

傳統(tǒng)機(jī)器學(xué)習(xí)方法和應(yīng)用指導(dǎo)

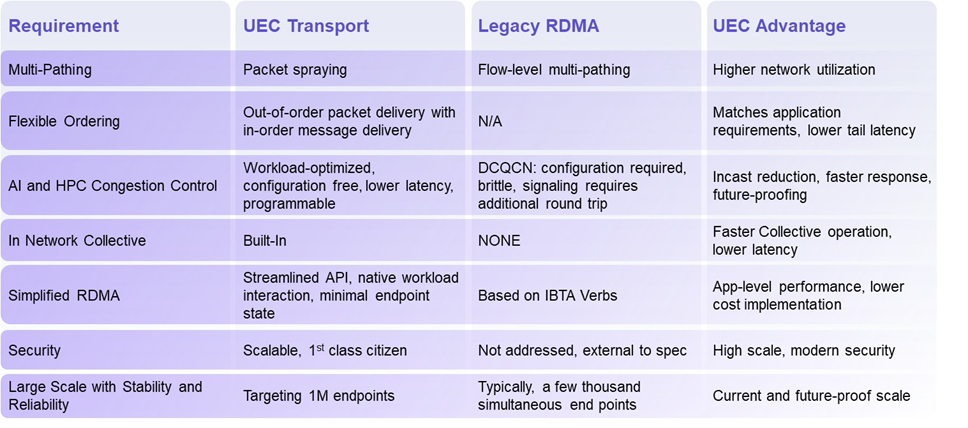

揭秘超以太網(wǎng)聯(lián)盟(UEC)1.0 規(guī)范最新進(jìn)展(2024Q4)

Qorvo在射頻和電源管理領(lǐng)域的最新進(jìn)展

中軟國(guó)際亮相華為云生態(tài)應(yīng)用創(chuàng)新交流會(huì)

基于深度學(xué)習(xí)的三維點(diǎn)云分類方法

芯片和封裝級(jí)互連技術(shù)的最新進(jìn)展

5G新通話技術(shù)取得新進(jìn)展

深度學(xué)習(xí)中的時(shí)間序列分類方法

深度學(xué)習(xí)中的無監(jiān)督學(xué)習(xí)方法綜述

廣東的5G-A、信號(hào)升格和低空經(jīng)濟(jì),又有新進(jìn)展!

百度首席技術(shù)官王海峰解讀文心大模型的關(guān)鍵技術(shù)和最新進(jìn)展

腦機(jī)接口電極界面材料與改性技術(shù)進(jìn)展綜述

點(diǎn)云深度學(xué)習(xí)方法的最新進(jìn)展綜述

點(diǎn)云深度學(xué)習(xí)方法的最新進(jìn)展綜述

評(píng)論