從數據分析、經典機器學習到搜索、推薦,再到語言處理和圖像識別,每個 AI 任務運行的背后都需要海量的數學計算。可以說,AI 真的就是數學,但卻是很多很多的數學。 尤其是在 AI 進入大模型時代的當下,模型的大規模訓練和推理更是對計算資源有著巨大的需求。但同時,算力的掣肘正在阻礙著 AI 走向大規模落地。 當前 AI 面臨的“數學題”都是何種難度?“算珠”又該如何撥弄得更快才能追得上不斷增長的計算需求呢? 讓我們從 CPU 的 AI 算力談起。

1

大規模推理時代

深度學習加速的天花板在哪?

人工智能迎來第三次浪潮后,以深度學習為代表的AI已經進入應用階段。而深度學習 AI 需要進行大量矩陣乘法以訓練神經網絡模型,并利用推理將這些模型應用于實際任務。

也就是說,深度學習分為訓練和推理兩個階段,而推理則是推動AI大規模走向落地的關鍵。

訓練深度學習模型可能需要數小時或數天的算力。而深度學習推理可能需要幾分之一秒到幾分鐘,具體取決于模型的復雜程度和對結果的準確度的要求。在推理過程中,計算機將輸入數據與模型進行比較,然后推斷數據的含義。

讓人工智能落地更多是推理層面的工作,無論是推薦引擎、圖像識別、媒體分析、語言翻譯 、自然語言處理、強化學習等負載中推理性能的大幅提升對落地應用的貢獻都十分重要。

在此背景下,硬件架構將成為AI落地的重中之重。

而做大規模推理,CPU平臺具有較大優勢——用戶學習門檻低、部署速度快等,在類似推薦系統的應用中,CPU也擔當著算力支撐,那么如何提升CPU的AI算力?

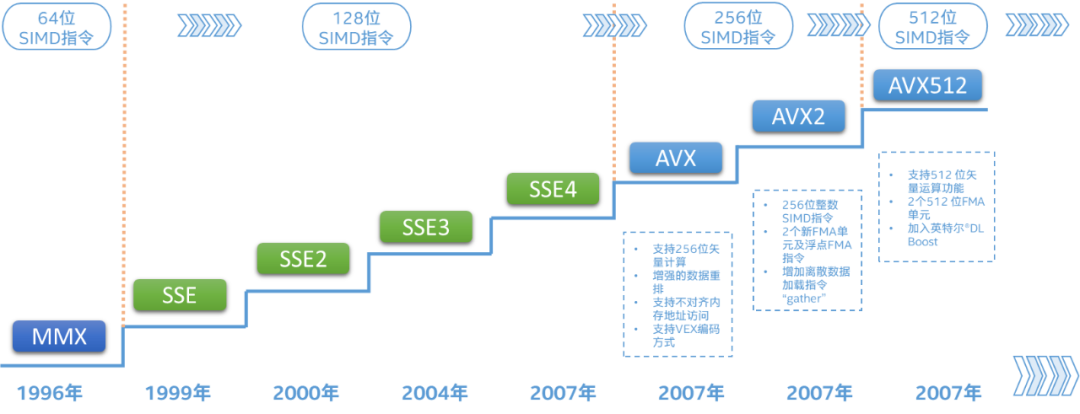

CPU的算力取決于 CPU 特定加速指令集或運算單元的持續引入及改進,那么通過強化算力單元和增加算力單元數量并舉,即Scale-Up與Scale-Out相結合,提升CPU的AI算力。

回望英特爾歷代至強 可擴展處理器的深度學習加速技術(即DL Boost),已經將這一提升路徑充分實踐并拉高優化天花板:從第一代至強可擴展處理器引入的AVX-512——中低端型號每核心配備1個FMA單元、高端型號每核心配備2個FMA單元,到代號Ice Lake-SP的雙路第三代至強可擴展處理器將此類配置擴展到全系列產品,并將最高核心數從28增加至40個,CPU的向量處理能力得以大幅提升。

指令優化方面,第二代英特爾至強 可擴展處理器引入了簡稱VNNI(Vector Neural Network Instruction,矢量神經網絡指令)的擴展,提高了數據格式INT8推理的效率;代號Cooper Lake的第三代英特爾至強可擴展處理器又引入了數據格式bfloat16(BF16)加速功能,可以用于推理和訓練。 目前,前三代英特爾至強 可擴展處理器的加速路徑,主要依靠現有的計算單元,即AVX-512,配合指令集、算法和數據上的優化,輸出AI算力。 但加速的天花板就到此為止了嗎?

還有別的思路——內置硬件加速器,且與本就高性能的CPU內核無縫配合,疊加buff推高天花板。

2

硬件直接“貼貼”加速

第四代至強內置多種專用加速器

在今年11月,英特爾宣布將在2023年1月11日發布代號為Sapphire Rapids的全新第四代英特爾至強 可擴展處理器。

Sapphire Rapids將為廣泛的標量和并行工作負載提供跨越式的性能提升,更重要的是,它的基本架構旨在實現彈性計算模型(如容器化微服務)的突破性性能,以及在所有形式的以數據為中心的計算中快速擴展 AI 的使用。

第四代英特爾至強可擴展處理器的核心數量有顯著增長,并支持DDR5、PCIe 5.0和CXL 1.1等下一代內存和接口標準,在內置硬件加速上,Sapphire Rapids也集成了5項加速器:

用于AI的高級矩陣擴展(Advanced Matrix Extensions),簡稱AMX;

用于數據分析的存內分析加速器(In-Memory Analytics Accelerator),簡稱IAA;

用于5G/網絡的數據流加速器(Data Streaming Accelerator),簡稱DSA;

用于存儲的動態負載均衡器(Dynamic Load Balancer),簡稱DLB;

用于數據壓縮和加解密的QuickAssist技術,英特爾數據保護與壓縮加速技術,簡稱QAT。

首先,內置加速器可以消除在將數據從 CPU 移至協處理器加速器時產生的大部分開銷。

同時,Sapphire Rapids還引入了加速器接口架構 (AIA),解決了無縫集成加速引擎和高性能核心時面臨的關鍵挑戰——能夠處理 CPU 內核與內置加速器之間的數據高效調度、同步和信令傳遞,而不是高開銷內核模式。

內置的硬件加速器也易獲得更出色的性能,而不必將時間浪費在進行片外傳輸設置上。

AMX與上述其他4個加速器的一大區別,就是它本身就集成在了CPU核心內,與AVX-512一樣,隨核心數同步增長,線性提升處理能力。

3

開啟全新計算單元

AMX升維加速深度學習工作負載

AMX與AVX-512又有什么區別?

AMX是全新的計算單元,有自己的存儲和操作電路,并行度高,以便為AI工作負載加速Tensor運算,支持bfloat16和INT8兩種數據類型。

Tensor處理是深度學習算法的核心,AMX功能可以實現每個循環2000次int8運算和1000次bfloat16運算。

同時,AMX的寄存器(名為Tile)是二維的,寄存器組是三維的,均比AVX-512高一個維度,寄存器組存儲的數據相當于一個小型矩陣,這樣AMX 能夠在每個時鐘周期執行更多矩陣乘法以每時鐘周期來看。

理論上,AMX的TMUL(矩陣乘法運算)對AVX-512的2個FMA(融合乘加操作)單元,INT8性能高達8倍;處理浮點數據,AMX使用動態范圍與FP32相當的BF16,性能可達AVX-512的16倍。

如此,有全新可擴展二維寄存器文件和全新矩陣乘法指令,可增強各種深度學習工作負載中推理及訓練性能,也就代表著計算能力的大幅提升,這些計算能力可以通過行業標準框架和運行時無縫訪問。

據今年1月數據表明,基于TensorFlow框架,INT8 精度下每秒檢測的圖像的數量增幅以及高達 6 倍多 BF16 精度下進行對象檢測時每秒檢測的圖像的數量增幅明顯增加:

56核的第四代英特爾 至強可擴展處理器全新的AMX,對比40核的第三代英特爾 至強可擴展處理器,在SSD-ResNet34上進行實時推理時,每秒處理的圖像數量增加高達4.5倍。(注:實際性能受使用情況、配置和其他因素的差異影響,且性能測試結果基于配置信息中顯示的日期進行的測試[1])

當然AVX-512本身就以FP32、FP64等高精度浮點數據的運算見長,依然可以專注于如數據分析、科學計算、經典機器學習等高精度計算。

如今第三代人工智能浪潮是以深度學習為代表,并非只有深度學習,AI的范圍正在不斷擴大,計算需求也在多元化,當人工智能的工作負載出現混合精度計算需求,AMX和AVX-512就可搭配使用,發展各自長處。

對于數據精度不高但要求高準確度的推理場景,如圖像識別、推薦引擎、媒體分析、語言翻譯、自然語言處理(NLP)、強化學習等典型AI應用場景,AMX其實屬于降維打擊,可發揮空間很大。

根據預告,英特爾第四代至強可擴展處理器是處理AI等更現代化、更新興并行工作負載的基礎設施,在進行整體設計時也考慮到了未來技術發展趨勢——絕大多數新的可擴展服務將采用容器化微服務等彈性計算模型進行開發。

新版Windows、Linux Kernel和虛擬化軟件也確實都具備支持AMX指令集的條件,所謂“引領”就是要更先一步到達未來。

1月11號,讓我們期待至強新品的發布和更多信息吧~可以先點擊閱讀原文,提前了解至強產品組合~

審核編輯 :李倩

-

cpu

+關注

關注

68文章

10882瀏覽量

212236 -

人工智能

+關注

關注

1792文章

47442瀏覽量

239013 -

算力

+關注

關注

1文章

995瀏覽量

14866

原文標題:明年1月,推高CPU人工智能算力天花板

文章出處:【微信號:AI_Architect,微信公眾號:智能計算芯世界】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

相關推薦

游戲體驗天花板,一加 Ace 5 系列售價 2299 元起

NPU在深度學習中的應用

使用EMBark進行大規模推薦系統訓練Embedding加速

GPU深度學習應用案例

使用OpenVINO C++在哪吒開發板上推理Transformer模型

【「大模型時代的基礎架構」閱讀體驗】+ 第一、二章學習感受

《黑神話:悟空》8月20日發售,海信電視Mini LED電視天花板中板現身!

FPGA在人工智能中的應用有哪些?

深度學習編譯器和推理引擎的區別

深度學習模型量化方法

大規模推理時代深度學習加速的天花板在哪?

大規模推理時代深度學習加速的天花板在哪?

評論