InfiniBand(直譯為“無限帶寬”技術,縮寫為IB)是一個用于高性能計算的計算機網絡通信標準,它具有極高的吞吐量和極低的延遲,用于計算機與計算機之間的數據互連。

在最新發布的全球最強超級計算機排名 Top500 的榜單中,InfiniBand 網絡再次以絕對的數量和性能優勢蟬聯超級計算機互連設備數量榜首,比上次排行榜的數量又有了大幅度的增長。縱觀這次的榜單,可以歸納出以下三個趨勢:

基于InfiniBand網絡的超級計算機以197臺的數量大幅領先于其它網絡技術。特別在 Top100 的系統中,基于 InfiniBand 網絡的超級計算機更是遙遙領先,InfiniBand 網絡已經成為了追求性能的超級計算機的標配。

NVIDIA網絡產品成為Top500系統中的主流互連設備,其中超過三分之二的超級計算機在使用NVIDIA網絡互連,NVIDIA 網絡的性能和技術領先性已經得到了廣泛認可。

還值得一提的是,InfiniBand網絡不僅在傳統的HPC業務,在企業級數據中心和公有云上也已被廣泛使用。目前性能第一的企業級超級計算機NVIDIA Selene 和微軟公司的Azure公有云都在利用InfiniBand網絡來發揮其超高的業務性能。

無論是數據通訊技術的演進、互聯網技術的革新、還是視覺呈現的升級,都是得益于更強大的計算、更大容量更安全的存儲以及更高效的網絡;基于InfiniBand網絡為基礎的集群架構方案,不僅可以提供更高帶寬的網絡服務,同時也降低了網絡傳輸負載對計算資源的消耗,降低了延時,又完美地將HPC與數據中心融合。

為什么InfiniBand網絡在 Top500 中受到如此高的重視?其性能優勢起到了決定性的作用。下面,納多德將InfiniBand十大優勢總結如下:

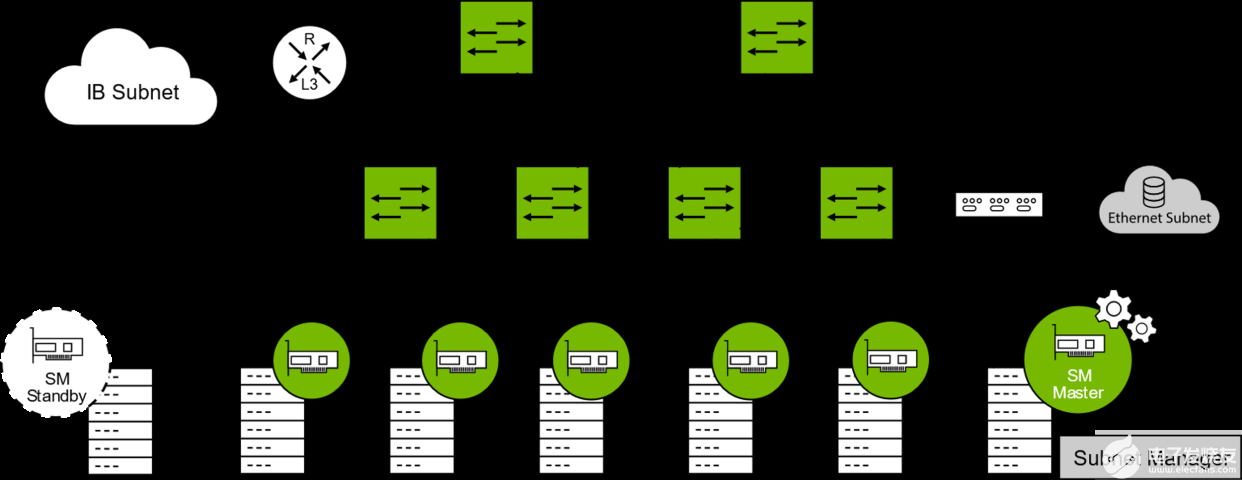

1. 簡單的網絡管理

InfiniBand是第一個真正意義上原生按照SDN設計的網絡架構,它由子網管理器來管理。

子網管理器對本地子網進行配置并確保能連續運行。所有的信道適配器和交換機都必須實現一個SMA,該SMA與子網管理器一起實現對通信的處理。每個子網必須至少有一個子網管理器來進行初始化管理以及在鏈路連接或斷開時對子網進行重新配置。通過仲裁機制來選擇一個子網管理器作為主子網管理器,而其他子網管理器工作于待機模式(每個待機模式下的子網管理器都會備份此子網的拓撲信息,并檢驗此子網是否能夠運行)。若主子網管理器發生故障,一個待機子網管理器接管子網的管理以確保不間斷運行。

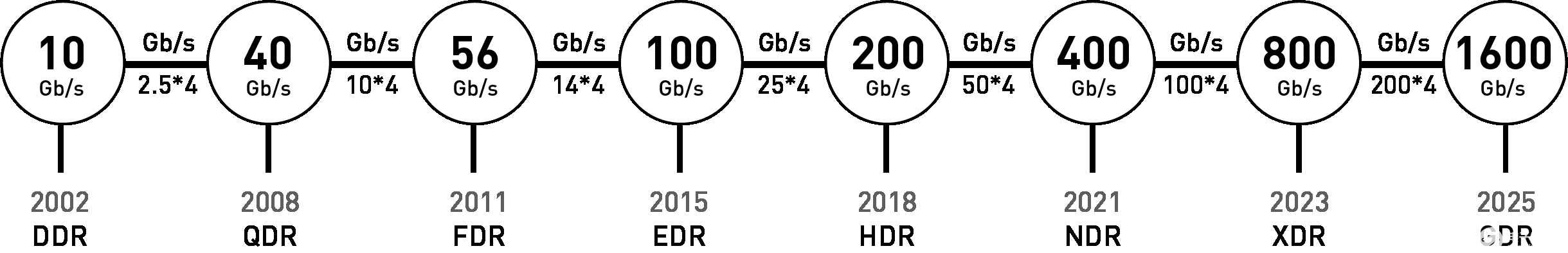

2. 高帶寬

自InfiniBand誕生以來,很長一段時間InfiniBand網絡速率的發展都是快于Ethernet的,主要原因就是因為InfiniBand應用于高性能計算中服務器之間的互連,對帶寬上的需求更高。

各個速率的縮寫如下:

SDR - Single Data Rate

DDR - Double Data Rate

QDR - Quad Data Rate

FDR - Fourteen Data Rate

EDR - Enhanced Data Rate

HDR - High Dynamic Range

NDR - Next Data Rate

XDR - eXtreme Data Rate

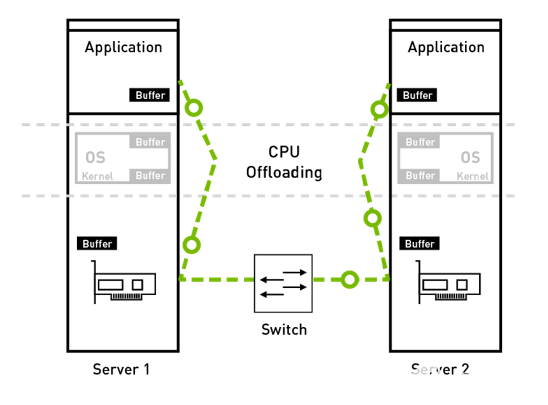

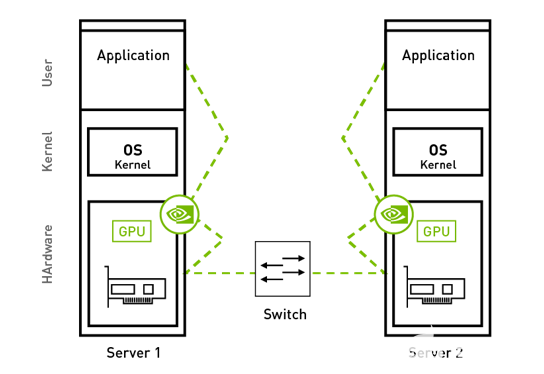

加速計算的一個關鍵技術,是CPU卸載。InfiniBand網絡架構可以以最少的CPU資源來傳輸數據,這點是通過下面的方式來做到的:

硬件卸載整個傳輸層協議棧

Bypass內核,zero copy

RDMA,把一個服務器內存中的數據直接寫入另一臺的內存,不需要CPU的參與

同時可以使用GPU Direct技術,可以直接訪問GPU內存中的數據,將GPU內存中的數據傳輸到其他節點。這樣可以加速計算類的應用,比如AI, Deep Learning等。

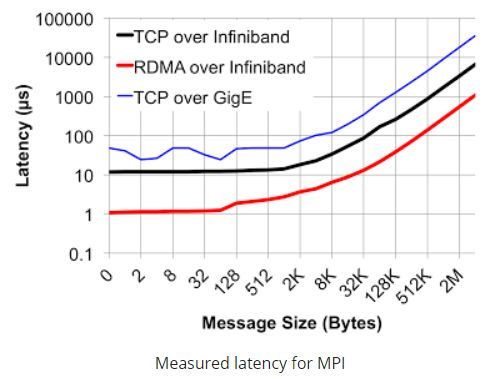

4.低延遲

此處主要分為兩部分進行對比,一部分在交換機上,作為網絡傳輸模型中的二層技術,Ethernet交換機普遍采用了MAC查表尋址和存儲轉發的方式(有部分產品借鑒了InfiniBand的Cut-though技術)由于需要考慮諸如IP、MPLS、QinQ等復雜業務的處理,導致Ethernet交換機處理流程較長,一般會在若干us(支持cut-though的會在200ns以上),而InfiniBand交換機二層處理非常簡單,僅需要根據16bit的LID就可以查到轉發路徑信息,同時采用了Cut-Through技術大大縮短了轉發時延至100ns以下,遠遠快于Ethernet交換機;網卡層面如前所述,采用RDMA技術,網卡轉發報文不需要經過CPU,大大加快了報文在封裝解封裝處理的時延,一般InfiniBand的網卡收發時延(write,send)在600ns,而基于Ethernet上的TCP UDP應用的收發時延會在10us左右,相差十幾倍之多。

5.擴展性和靈活性

IB網絡一個主要的優勢就是單個子網可以部署一個48,000節點,形成一個巨大的2層網絡。而且IB網絡不依賴ARP等廣播機制,不會產生廣播風暴或者額外的帶寬浪費。

多個IB子網也可以通過路由器和交換機連接。

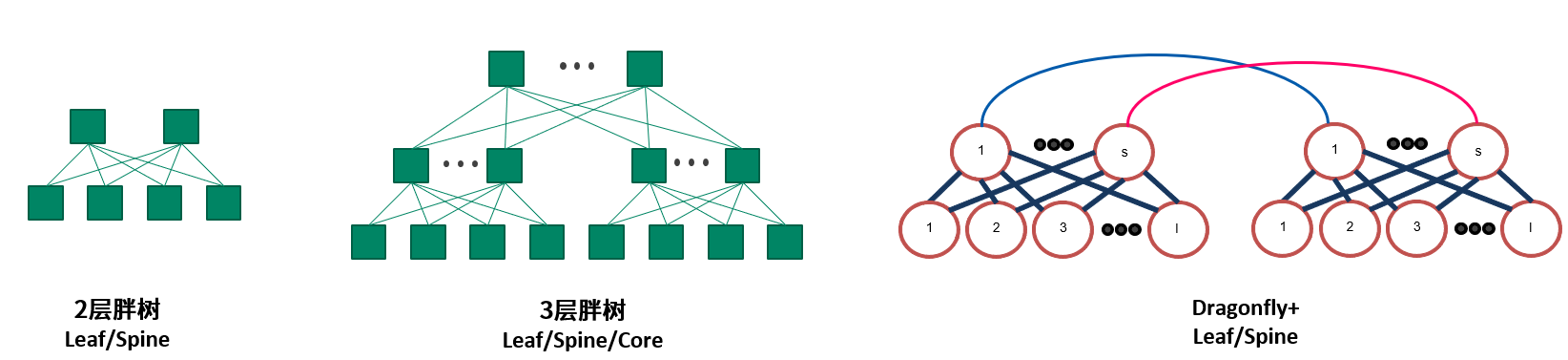

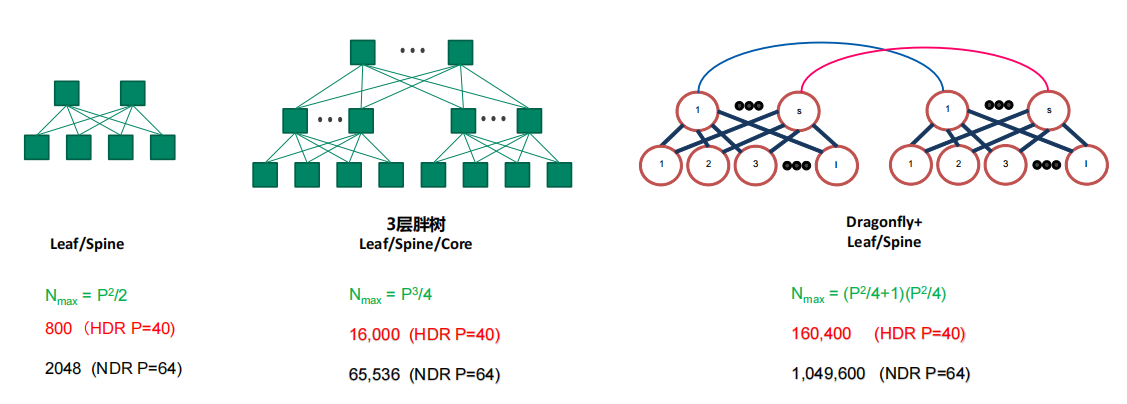

IB支持多種網絡拓撲:

規模較小時,建議選用2層fat-tree。更大規模可以采用3層fat-tree的組網拓撲。一定規模以上,可以采用Dragonfly+的拓撲節約一部分成本。

6.QoS

如果多個不同的應用在同一個子網運行,并且其中一些應用需要比其他更高的優先級,IB網絡如何提供QoS支持呢?

QoS是一種能力,可以為不同的應用,用戶或者數據流提供不同的優先級服務。高優先級的應用可以被映射到不同的端口隊列,隊列里的報文可以被優先發送。

InfiniBand采用虛通道(VL,即Virtual Lanes)方式來實現QoS。虛通道是一些相互分立的邏輯通信鏈路,它們共享一條物理鏈接,每條物理鏈接可支持多達15條的標準虛通道和一條管理通道(VL15)。

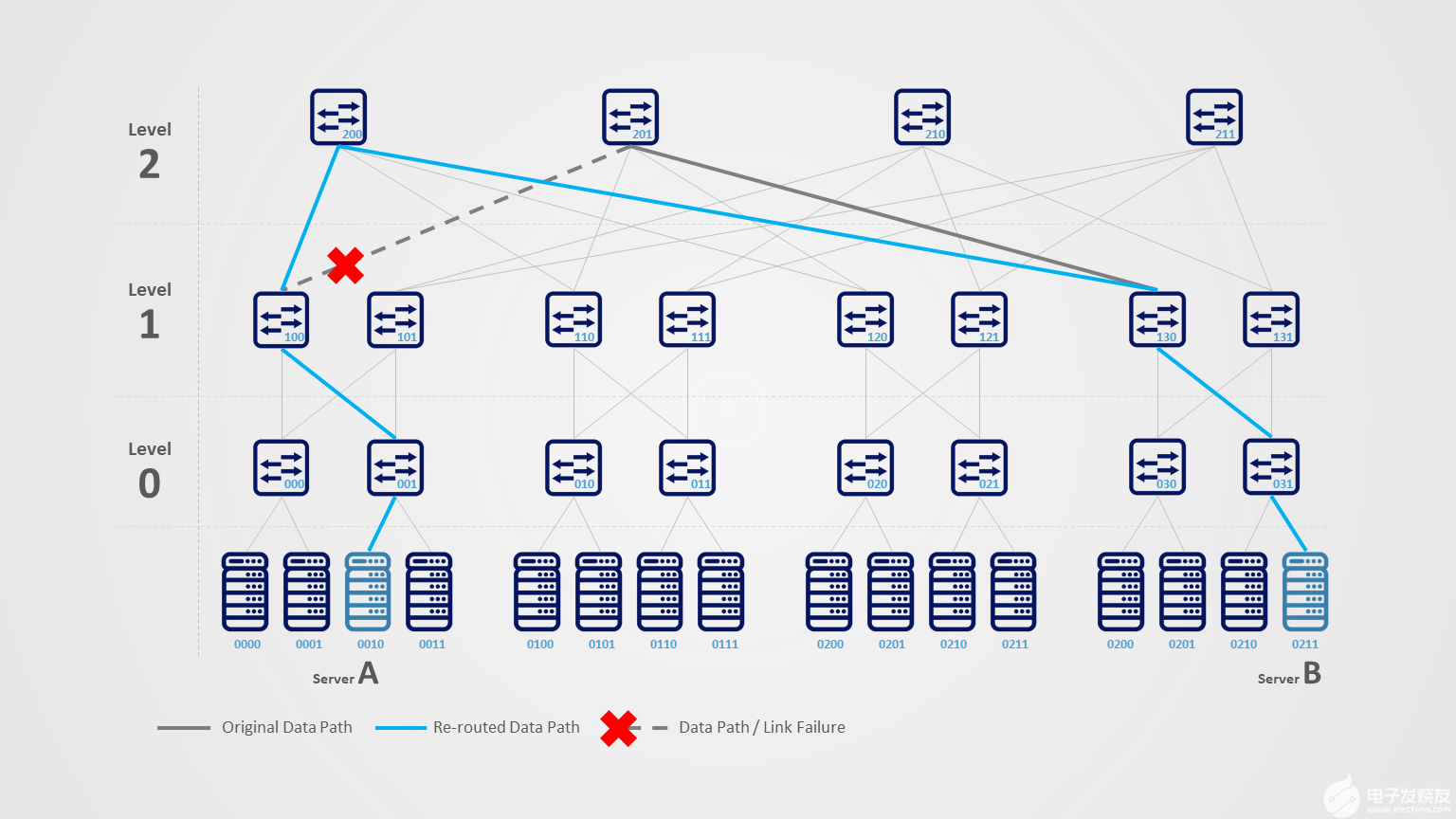

7.網絡穩定性和彈性

理想情況下,網絡非常穩定,沒有任何故障。但是長期運行的網絡不可避免的會出現一些故障,InfiniBand如何處理這些失敗,并且快速恢復的呢?

NVIDIA IB解決方案提供一個機制,叫做Self-Healing Networking。自愈網絡是一個硬件能力,它基于IB交換機。自愈網絡可以讓鏈路故障恢復的時間僅僅需要1毫秒,比普通的恢復時間快5000x倍。

8.優化的負載均衡

在高性能數據中心里面,一個很重要的需求,是如何提高網絡的利用率。其中一種方法是使用負載均衡。

負載均衡是一種路由策略,它讓流量在多個可用端口上發送。

Adaptive Routing就是這樣一個特性,它可以讓流量在交換機端口上均勻的分布。AR在交換機上硬件支持,由Adaptive Routing Manager管理。

當AR開啟,交換機上的Queue Manager會監測所有GROUP EXIT端口的流量,均衡每個隊列的負載,把流量導向利用率低的端口。AR支持動態負載均衡,避免網絡擁塞,并最大化網絡帶寬利用率。

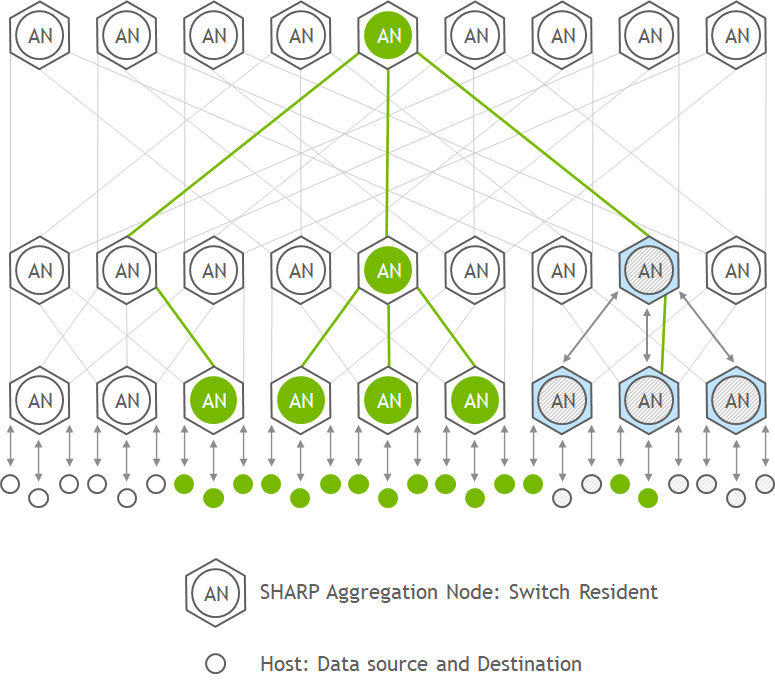

9.網絡計算 - SHARP

IB交換機還支持網絡計算的技術,SHARP – Scalable Hierarchical Aggregation and Reduction Protocol.

SHARP是一個基于交換機硬件的軟件,并且是一個集中管理的軟件包。

SHARP可以把原來在CPU和GPU上運行的集合通信offload到交換機上,優化集合通信,避免了節點間的多次數據傳輸,減少了需要在網絡上傳輸的數據量。因此,SHARP可以極大的提升加速計算的性能,基于MPI應用,比如AI,機器學習等等。

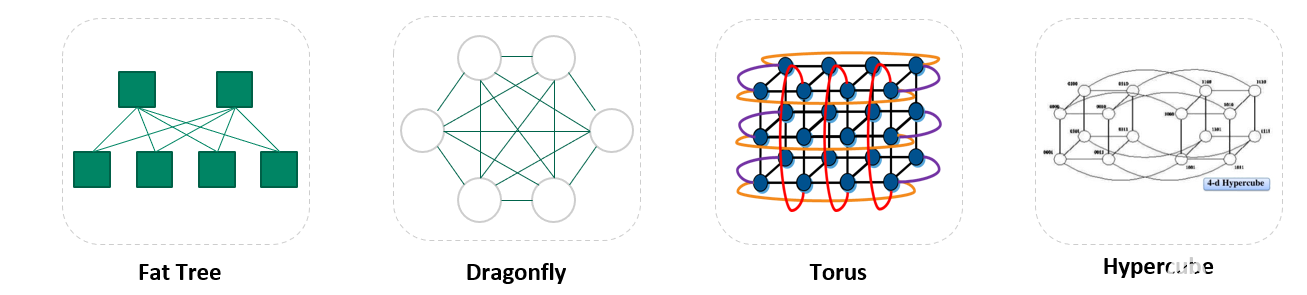

10.支持多種網絡拓撲

InfiniBand網絡可以支持非常多的topo,比如:

Fat Tree

Torus

Dragonfly+

Hypercube

HyperX

支持不同的網絡topo,從而滿足不同的需求,比如:

易于網絡擴展

降低TCO

最大化阻塞比

最小化延遲

最大化傳輸距離

Infiniband憑借著無與倫比的技術優勢,極大簡化了高性能網絡架構,并降低了多級架構層次造成的延時,為關鍵計算節點接入帶寬的平滑升級提供有力支撐。InfiniBand 網絡憑借其極致的性能,不斷創新的技術架構,在更低功耗、更少硬件設備的前提下幫助用戶實現了業務性能的最大化,其進入越來越多的使用場景自是大勢所趨。

納多德是NVIDIA網絡產品的Elite Partner,攜手NVIDIA實現光連接+網絡產品與解決方案的強強聯合,尤其是在InfiniBand高性能網絡建設與應用加速方面擁有深刻的業務理解和豐富的項目實施經驗,可根據用戶不同的應用場景,提供最優的InfiniBand高性能交換機+智能網卡+AOC/DAC/光模塊產品組合方案,為數據中心、高性能計算、邊緣計算、人工智能等應用場景提供更具優勢與價值的光網絡產品和整體解決方案,以低成本和出色的性能,大幅提高客戶業務加速能力。

審核編輯黃昊宇

-

InfiniBand

+關注

關注

1文章

29瀏覽量

9197

發布評論請先 登錄

相關推薦

敦泰榮獲車載顯示年度十大知名品牌

InfiniBand網絡內計算的關鍵技術和應用

InfiniBand與以太網的對比分析

“智能網聯汽車全球十大發展突破”在京發布

中國信通院發布“2024云計算十大關鍵詞”

AI浪潮下的十大消費者新趨勢

深入探索InfiniBand網絡、HDR與IB技術

臺積電重回全球十大上市公司

睿創微納8微米榮獲“2023年度山東十大科技創新成果”

2023年度十大科技名詞

納多德視點 | InfiniBand十大優勢

納多德視點 | InfiniBand十大優勢

評論