前言概述

得益于近十年來在自有“飛槳”人工智能(Artificial Intelligence, AI)框架上的前瞻布局和大力投入,以及在語言與知識技術(shù)上積累的豐厚經(jīng)驗與成果,百度已在自然語言處理(Natural Language Processing,以下簡稱NLP)領(lǐng)域構(gòu)建起完整的產(chǎn)品體系與技術(shù)組合。ERNIE 3.0 作為其飛槳文心 · NLP 大模型的重要組成部分,也在各種 NLP 應(yīng)用場景,尤其是中文自然語言理解和生成任務(wù)中展現(xiàn)出卓越的性能。

隨著 NLP 逐漸進入技術(shù)和產(chǎn)業(yè)結(jié)合的快車道,并在更多行業(yè)中實現(xiàn)商業(yè)化落地,用戶對 ERNIE 3.0 也提出了更多細(xì)分需求,例如更高的處理效率和更廣泛的部署場景等。為此,百度不僅借助其創(chuàng)新技術(shù)優(yōu)勢,推出了輕量版 ERNIE-Tiny,也與合作伙伴英特爾攜手,提前引入即將發(fā)布的全新第四代英特爾 至強 可擴展處理器,作為 ERNIE-Tiny 未來的硬件承載基座。

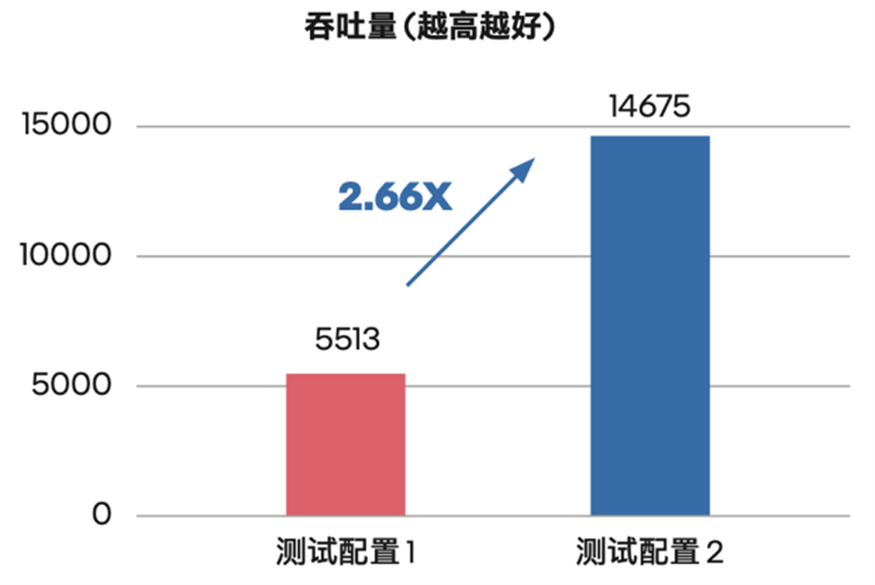

為了讓 ERNIE-Tiny 在第四代英特爾 至強 可擴展處理器及其內(nèi)置的全新英特爾 高級矩陣擴展(Intel Advanced Matrix Extension,英特爾 AMX)技術(shù)的加速支持下實現(xiàn)更優(yōu)推理性能,雙方也攜手開展了多項優(yōu)化工作。而來自對比測試的數(shù)據(jù)表明,相比通過英特爾 AVX-512_VNNI 技術(shù)來實現(xiàn)AI加速的、面向單路和雙路的第三代英特爾 至強 可擴展處理器,ERNIE-Tiny 在升級使用內(nèi)置英特爾 AMX 技術(shù)的第四代英特爾 至強 可擴展處理器后,其整體性能提升高達(dá) 2.66 倍1,取得了令人滿意的效果。

引言

“作為百度面向 NLP 領(lǐng)域的重要技術(shù)方案,基于輕量化技術(shù)的 ERNIE 3.0 輕量版可在搜索排序、推薦、信息抽取、地圖檢索、自然語言推斷等應(yīng)用場景中為用戶提供響應(yīng)迅速、質(zhì)量可靠的能力輸出。全新第四代英特爾 至強 可擴展處理器及英特爾 AMX 技術(shù)的引入,使得輕量版 ERNIE 3.0 在通用 CPU 平臺上也能獲得令人滿意的推理效能,從而能幫助更多用戶在其既有 IT 設(shè)施中更為方便地部署 ERNIE 3.0,從而進一步普及其應(yīng)用范圍。”

方案背景:ERNIE 3.0 走向輕量化

為更多行業(yè)用戶提供 NLP 應(yīng)用助力

作為 AI 領(lǐng)域的重要分支,NLP 正獲得前所未有的市場關(guān)注與技術(shù)追蹤。有預(yù)測數(shù)據(jù)表明,到 2024 年全球 NLP 市場規(guī)模將達(dá) 264 億美元3,并將大幅緩解金融、醫(yī)療、法律等行業(yè)中人力密集型工作環(huán)節(jié)帶來的效率和成本壓力。例如在醫(yī)療健康領(lǐng)域,利用 NLP 應(yīng)用對醫(yī)療記錄開展篩查有助于發(fā)現(xiàn)藥物的長期不良反應(yīng);在法律領(lǐng)域, NLP 應(yīng)用也在幫助人們從浩如煙海的記錄中梳理出案件的來龍去脈。

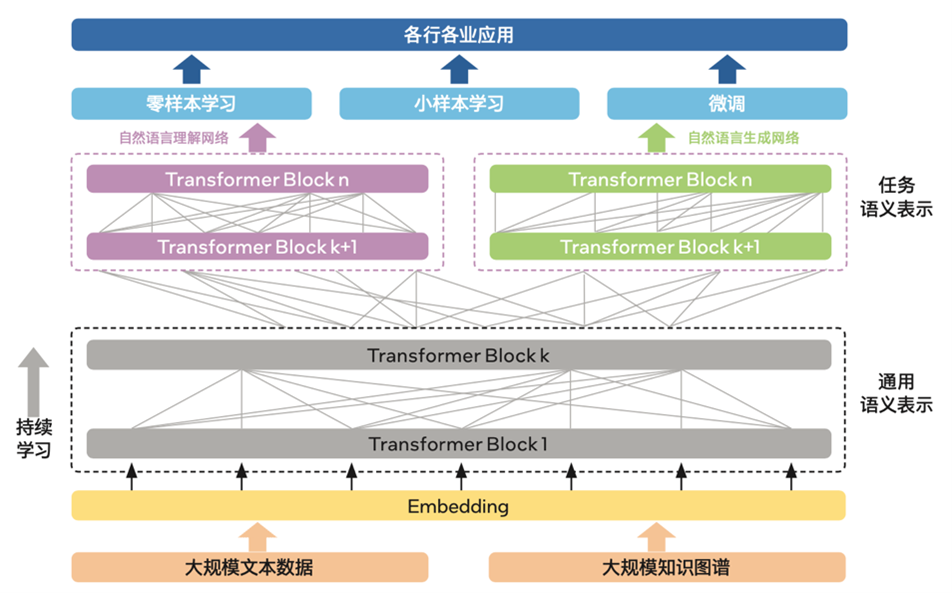

作為擁有強大互聯(lián)網(wǎng)基礎(chǔ)的領(lǐng)先 AI 公司,百度憑借其旗下飛槳文心 · NLP 大模型所具備的創(chuàng)新技術(shù)優(yōu)勢,在語言理解、語言生成等NLP場景中已獲取了明顯的市場優(yōu)勢,并在中國 AI 公有云 NLP 領(lǐng)域連續(xù)多年取得市場份額第一4。如圖一所示,在大模型中,基于知識增強的多范式統(tǒng)一預(yù)訓(xùn)練框架 ERNIE 3.0 融合了自回歸網(wǎng)絡(luò)與自編碼網(wǎng)絡(luò),并加入了大數(shù)據(jù)預(yù)訓(xùn)練與多源豐富知識相結(jié)合、持續(xù)學(xué)習(xí)等特性,在理解任務(wù)、生成任務(wù)、零樣本學(xué)習(xí)任務(wù)和常識推理任務(wù)上均有著優(yōu)秀的表現(xiàn),在 14 種類型/45 個 NLP 數(shù)據(jù)集取得了 SOTA(State Of The Art Model,當(dāng)前最佳模型)的結(jié)果。在中文領(lǐng)域,ERNIE 3.0 的表現(xiàn)則更為突出,不僅刷新了 54 個中文 NLP 任務(wù)基準(zhǔn),并登頂 SuperGLUE 全球榜首,同時也因具備非常出色的語言理解能力,還可以完成寫小說、歌詞、詩歌等的文學(xué)創(chuàng)作任務(wù)5。

圖一 ERNIE 3.0框架基本架構(gòu)

在 ERNIE 3.0 的實際落地應(yīng)用過程中,許多細(xì)分領(lǐng)域也根據(jù)自身業(yè)務(wù)特點,對它提出了特定化需求。眾所周知,模型中更多的層數(shù)、參數(shù)意味著更大的模型體積、更強的計算資源需求以及更長的推理耗時,對于業(yè)務(wù)響應(yīng)速度和構(gòu)建成本敏感的用戶而言,無疑提高了引入和使用門檻。

借助模型輕量化技術(shù)對 ERNIE 3.0 大模型進行蒸餾壓縮,是助力 ERNIE 3.0 推廣到更多行業(yè)與場景的有效方法。為此,百度基于其“在線蒸餾”等創(chuàng)新技術(shù)方案,推出多個 ERNIE 3.0 輕量化版本 ERNIE-Tiny,在保持模型平均精度的前提下實現(xiàn)了更短的運算時間以及更少的算力需求。同時,ERNIE-Tiny 在推理時,也無需再為之配備昂貴的專用 AI 算力設(shè)備,在通用平臺,如 CPU 平臺上即可高效率完成推理作業(yè)。這無疑能讓用戶在既有公有云或數(shù)據(jù)中心的 IT 配置上即可使用該模型,而無需增添額外硬件或服務(wù)。

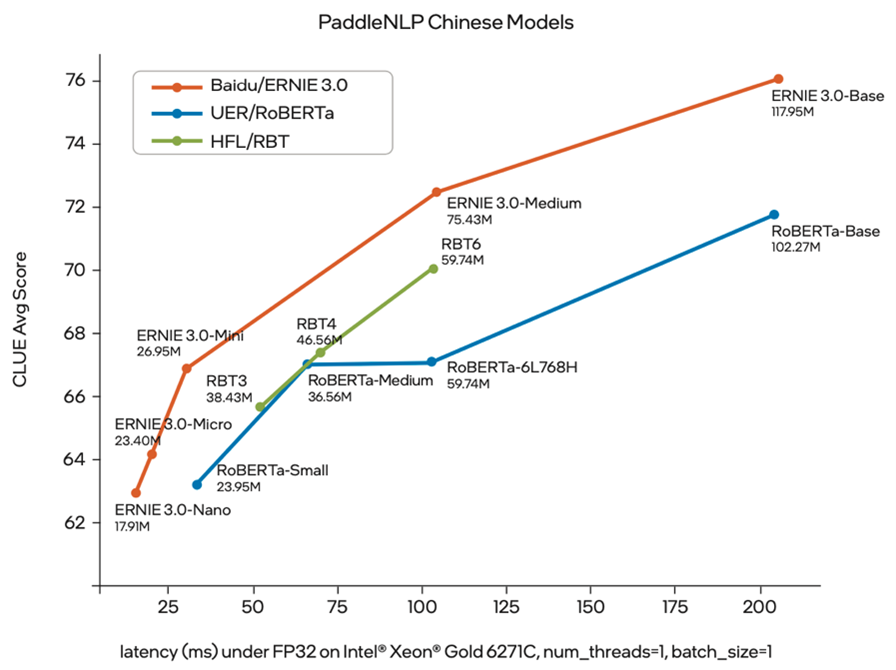

圖二 ERNIE-Tiny 模型精度-推理時延對比度6

與此同時,引入更強的通用計算平臺和優(yōu)化方案,也是助力 ERNIE-Tiny 獲得更優(yōu)效率的另一項重要手段。百度為此與英特爾開展深度技術(shù)合作:一方面將全新第四代英特爾 至強 可擴展處理器引入 ERNIE-Tiny 的推理計算過程;另一方面,也推進了多項優(yōu)化措施,例如通過英特爾 oneAPI 深度神經(jīng)網(wǎng)絡(luò)庫(Intel oneAPI Deep Neural Network Library,英特爾 oneDNN)來調(diào)用英特爾 AMX指令等,以確保 ERNIE-Tiny 可以更為充分地利用這款處理器內(nèi)置的全新AI加速技術(shù)帶來的性能加速“紅利”。

解決方案:三項優(yōu)化方案

助 ERNIE-Tiny 盡釋新平臺 AI 加速潛能

新一代英特爾至強 可擴展處理器為 ERNIE 3.0 帶來更強 AI 加速引擎

百度與英特爾攜手開展的優(yōu)化方案,首先圍繞 ERNIE-Tiny 系列中 Medium 版展開,這一輕量版本與基礎(chǔ)版 ERNIE 3.0 相比,其網(wǎng)絡(luò)層數(shù)從 12 層減少到了 6 層,以此可有效降低所需的算力資源并縮短推理時長。

優(yōu)化方案中,英特爾為 ERNIE-Tiny Medium 版本(以下簡稱 ERNIE-Tiny)提供了第四代英特爾 至強 可擴展處理器作為推理工作的算力輸出引擎。這一采用 Intel 7 制程工藝的新一代至強 可擴展處理器,可憑借全新的性能核微架構(gòu)設(shè)計來提升處理速度,并在低時延和單線程性能上實現(xiàn)突破。

在整個芯片的架構(gòu)層面,第四代英特爾 至強 可擴展處理器通過使用嵌入式多芯片互連橋接(Embedded Multi-die Interconnect Bridge,EMIB)技術(shù),可在保持既有單核優(yōu)勢的同時,大幅提升可擴展性。同時,新處理器也提供了對先進內(nèi)存和下一代 I/O 技術(shù),包括 DDR5、PCIe 5.0、CXL 1.1 以及高帶寬內(nèi)存(High Bandwidth Memory,HBM)技術(shù)的支持,這些技術(shù)特性能為 ERNIE 3.0 這樣的 AI 模型所需的高強度工作負(fù)載提供更可靠的全局性能加速。

更重要的是,第四代英特爾 至強 可擴展處理器還增添了多種新的內(nèi)置加速引擎來助力用戶在不同應(yīng)用場景中提升性能,如英特爾 加速器接口架構(gòu)指令集(英特爾 AIA)、英特爾 數(shù)據(jù)流加速器(英特爾 DSA)和英特爾 高級矩陣擴展(英特爾 AMX)。其中,AMX 對于AI工作負(fù)載的加速尤為顯著。

基于全新處理器和內(nèi)置 AI 加速能力,雙方攜手為 ERNIE-Tiny 加入三項優(yōu)化方案

1) 全新 AI 加速引擎優(yōu)化提升處理效率

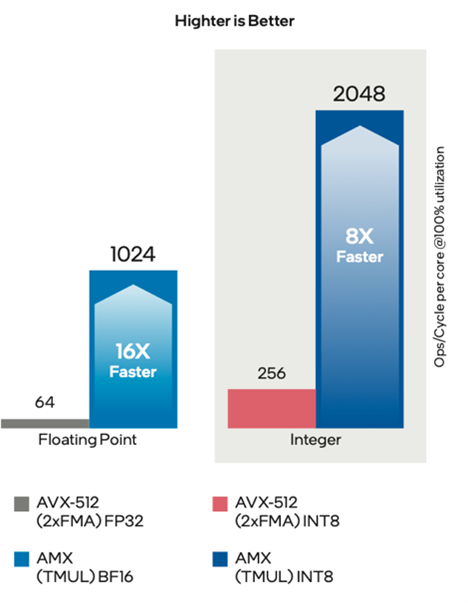

與英特爾在此前的至強 可擴展處理器中提供的兩種 AI 加速能力,即英特爾 AVX-512_VNNI_INT8 與英特爾 AVX-512_VNNI_BF16 不同,英特爾 AMX 采用了全新的指令集與電路設(shè)計。在實際的工作負(fù)載中,英特爾 AMX 能同時支持 BF16 和 INT8 數(shù)據(jù)類型,其每個物理核在每個時鐘周期可實現(xiàn) 2,048 次 INT8 運算和 1,024 次 BF16 運算7,與上一代 AI 加速引擎相比,大幅提升了 AI 工作負(fù)載的效率,這顯然有助于提升 ERNIE-Tiny 在推理環(huán)節(jié)的性能表現(xiàn)。

8

2) 利用英特爾 oneDNN 實現(xiàn)對英特爾 AMX 指令的調(diào)用

為了讓英特爾 AMX 的加速能力能直接作用于 ERNIE-Tiny,百度與英特爾一同借助英特爾 oneDNN 來實現(xiàn)英特爾 AMX 指令的調(diào)用。作為開源的、跨平臺的性能庫,英特爾 oneDNN 可有效助力用戶提升其 AI 應(yīng)用與框架在英特爾 架構(gòu)平臺上的性能,而且它也已加入了對英特爾 AMX 的支持。

在本次合作中,雙方除攜手完成了英特爾 oneDNN 與飛槳開源深度學(xué)習(xí)平臺(PaddlePaddle,https://www.paddlepaddle.org.cn/)的集成外,也根據(jù) ERNIE-Tiny 的實際運行需求開展了一系列增量工作,包括將 Linux 操作系統(tǒng)的內(nèi)核更新為支持英特爾 AMX 的版本等。

3) 內(nèi)存性能優(yōu)化

借助第四代英特爾 至強 可擴展處理器與英特爾 AMX 獲得計算性能的大幅提升之后,內(nèi)存性能的優(yōu)化自然也不可或缺,為此百度與英特爾也制定了針對性的優(yōu)化方案。雙方通過分析發(fā)現(xiàn),ERNIE-Tiny 在推理過程中有許多串行操作,即每次運算都會先讀數(shù)據(jù)再寫數(shù)據(jù),然后下一次運算也是如此,這會消耗大量操作時間。優(yōu)化方案則是將矩陣乘法與元素的運算及激活融合在一起,即把連續(xù)的操作合并為一個大操作,可使內(nèi)存的運行效率顯著提升。

同時,方案中針對多線程的優(yōu)化也被證明可助力 ERNIE 3.0 提升推理計算性能,與上一版本相比,方案進一步優(yōu)化了多線程的效率,并提升了多核的擴展性。

優(yōu)化方案驗證:

第四代英特爾 至強 可擴展處理器

可大幅提升 ERNIE-Tiny 性能表現(xiàn)

為了驗證第四代英特爾 至強 可擴展處理器與上述多項優(yōu)化方案對 ERNIE-Tiny 性能提升的實際作用,英特爾協(xié)助百度推進了性能對比測試。測試在第四代英特爾 至強 可擴展平臺與第三代英特爾 至強 可擴展平臺之間展開。后者使用英特爾 AVX-512_VNNI 對模型進行了 INT8 量化提速,而前者則啟用英特爾 AMX 技術(shù)進行加速。

測試結(jié)果如圖四所示,ERNIE-Tiny 的性能(測試采用吞吐量 (Throughput) 作為測評指標(biāo))獲得了顯著的提升,對比上一代英特爾 至強 可擴展平臺,其吞吐量提升到了它的 2.66 倍9。

圖四 ERNIE-Tiny 在不同處理器平臺上的性能對比10

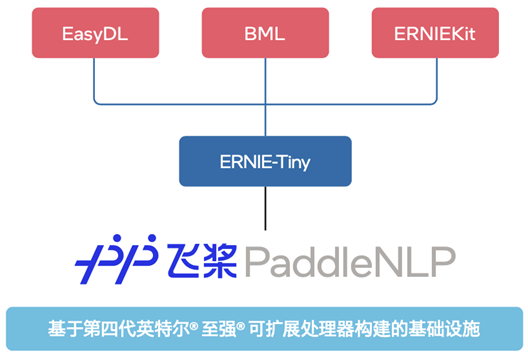

如圖五所示,目前,各個 ERNIE-Tiny 不僅已部署在零門檻 AI 開發(fā)平臺 EasyDL、全功能 AI 開發(fā)平臺 BML 和 ERNIEKit(旗艦版)產(chǎn)品中,它們也將與平臺和產(chǎn)品的其它能力一起協(xié)同,在基于第四代英特爾 至強 可擴展處理器的基礎(chǔ)設(shè)施上,為使用者提供文本分類、關(guān)系抽取、文本生成以及問答等能力。同時,它們也將作為百度飛槳 PaddleNLP 自然語言處理開發(fā)庫的核心模型,搭配訓(xùn)練-壓縮-推理端到端全流程應(yīng)用與豐富的產(chǎn)業(yè)實踐范例,全力加速 NLP 技術(shù)產(chǎn)業(yè)落地。

(如欲了解更多詳情,請訪問:https://github.com/PaddlePaddle/PaddleNLP/tree/develop/model_zoo/ernie-3.0)

圖五 ERNIE-Tiny 對外能力輸出

未來展望

百度與英特爾本次協(xié)作優(yōu)化的成功,再一次證明各個行業(yè)用戶在通用的 CPU 平臺上也能同樣方便地部署高效能的 ERNIE-Tiny,用以應(yīng)對越來越多的 NLP 應(yīng)用需求。使用這一方案,用戶不必額外采購昂貴的專用 AI 算力設(shè)備,這將大幅降低企業(yè)借助 NLP 能力提升業(yè)務(wù)效率的門檻,并加速更多 NLP 技術(shù)與應(yīng)用的商業(yè)落地過程。

面向未來,英特爾還將與百度一起在 NLP 領(lǐng)域開展更多也更為深入的技術(shù)合作,讓新一代至強 可擴展處理器及其內(nèi)置的更強 AI 加速技術(shù)為更多 AI 應(yīng)用的落地與實踐提供更多助力。

審核編輯 :李倩

-

處理器

+關(guān)注

關(guān)注

68文章

19382瀏覽量

230479 -

英特爾

+關(guān)注

關(guān)注

61文章

9995瀏覽量

172027 -

百度

+關(guān)注

關(guān)注

9文章

2273瀏覽量

90561

原文標(biāo)題:百度 ERNIE-Tiny 借力 AMX:性能升至 2.66 倍

文章出處:【微信號:英特爾中國,微信公眾號:英特爾中國】歡迎添加關(guān)注!文章轉(zhuǎn)載請注明出處。

發(fā)布評論請先 登錄

相關(guān)推薦

百度百科啟動“繁星計劃”

百度正式回應(yīng)進軍短劇領(lǐng)域

百度文心大模型日均調(diào)用量超15億

李彥宏宣布:百度文心大模型日調(diào)用量超15億

百度小度將發(fā)布AI智能眼鏡

百度百舸AI計算平臺4.0震撼發(fā)布

百度申請文小言商標(biāo)

2024百度移動生態(tài)萬象大會:百度新搜索11%內(nèi)容已AI生成

百度移動生態(tài)大會:智能體驅(qū)動生產(chǎn)力,助力超級個體實現(xiàn)

百度與特斯拉探討Robotaxi合作新機遇

百度文心大模型擴展合作領(lǐng)域

百度智能云正式發(fā)布了《百度智能云水業(yè)大模型白皮書》

百度ERNIE-Tiny借力AMX:性能升至2.66倍

百度ERNIE-Tiny借力AMX:性能升至2.66倍

評論