近年來(lái) NLP 學(xué)術(shù)領(lǐng)域發(fā)展真是突飛猛進(jìn),剛火完對(duì)比學(xué)習(xí)(contrastive learning),又有更火的提示學(xué)習(xí) prompt learning。眾所周知,數(shù)據(jù)標(biāo)注數(shù)據(jù)很大程度上決定了AI算法上限,并且成本非常高,無(wú)論是對(duì)比學(xué)習(xí)還是提示學(xué)習(xí)都著重解決少樣本學(xué)習(xí)而提出,甚至在沒(méi)有標(biāo)注數(shù)據(jù)的情況下,也能讓模型表現(xiàn)比較好的效果。本文主要介紹 prompt learning 思想和目前常用的方法。

目錄

一. NLP的訓(xùn)練范式有哪些

二. 為什么需要提示學(xué)習(xí)

三. 提示學(xué)習(xí)是什么

四. 常見(jiàn)的提示學(xué)習(xí)方法

五. 總結(jié)

一. NLP的訓(xùn)練范式有哪些

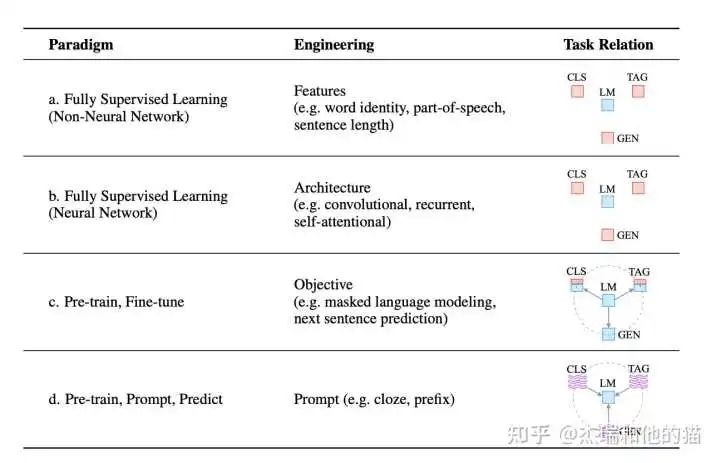

目前學(xué)術(shù)界一般將NLP任務(wù)的發(fā)展分為四個(gè)階段即NLP四范式:

- 第一范式:基于「?jìng)鹘y(tǒng)機(jī)器學(xué)習(xí)模型」的范式,如 tf-idf 特征+樸素貝葉斯等機(jī)器算法;

- 第二范式:基于「深度學(xué)習(xí)模型」的范式,如 word2vec 特征 + LSTM 等深度學(xué)習(xí)算法,相比于第一范式,模型準(zhǔn)確有所提高,特征工程的工作也有所減少;

- 第三范式:基于「預(yù)訓(xùn)練模型 + finetuning」的范式,如 BERT + finetuning 的NLP任務(wù),相比于第二范式,模型準(zhǔn)確度顯著提高,但是模型也隨之變得更大,但小數(shù)據(jù)集就可訓(xùn)練出好模型;

- 第四范式:基于「預(yù)訓(xùn)練模型 + Prompt + 預(yù)測(cè)」的范式,如 BERT + Prompt 的范式相比于第三范式,模型訓(xùn)練所需的訓(xùn)練數(shù)據(jù)顯著減少。

在整個(gè)NLP領(lǐng)域,你會(huì)發(fā)現(xiàn)整個(gè)發(fā)展是朝著精度更高、少監(jiān)督,甚至無(wú)監(jiān)督的方向發(fā)展的,而 Prompt Learning 是目前學(xué)術(shù)界向這個(gè)方向進(jìn)軍最新也是最火的研究成果。

二. 為什么需要提示學(xué)習(xí)為什么呢?

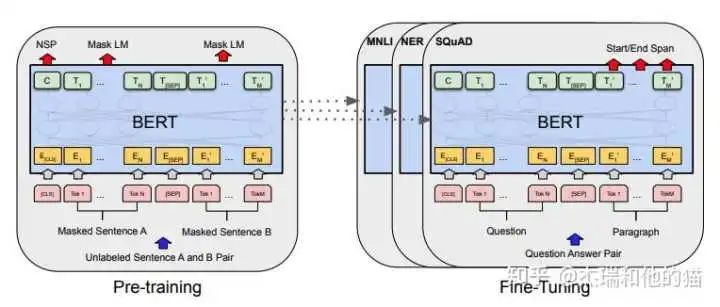

要提出一個(gè)好的方式那必然是用來(lái)「解決另一種方式存在的缺陷或不足」,那我們就先從它的上一個(gè)范式來(lái)說(shuō)起,就是預(yù)訓(xùn)練模型 PLM + finetuning范式 常用的是 BERT+ finetuning:

這種范式是想要預(yù)訓(xùn)練模型更好的應(yīng)用在下游任務(wù),需要利用下游數(shù)據(jù)對(duì)模型參數(shù)微調(diào);首先,模型在「預(yù)訓(xùn)練的時(shí)候,采用的訓(xùn)練形式:自回歸、自編碼,這與下游任務(wù)形式存在極大的 gap」,不能完全發(fā)揮預(yù)訓(xùn)練模型本身的能力

必然導(dǎo)致:較多的數(shù)據(jù)來(lái)適應(yīng)新的任務(wù)形式——>少樣本學(xué)習(xí)能力差、容易過(guò)擬合

上下游任務(wù)形式存在gap

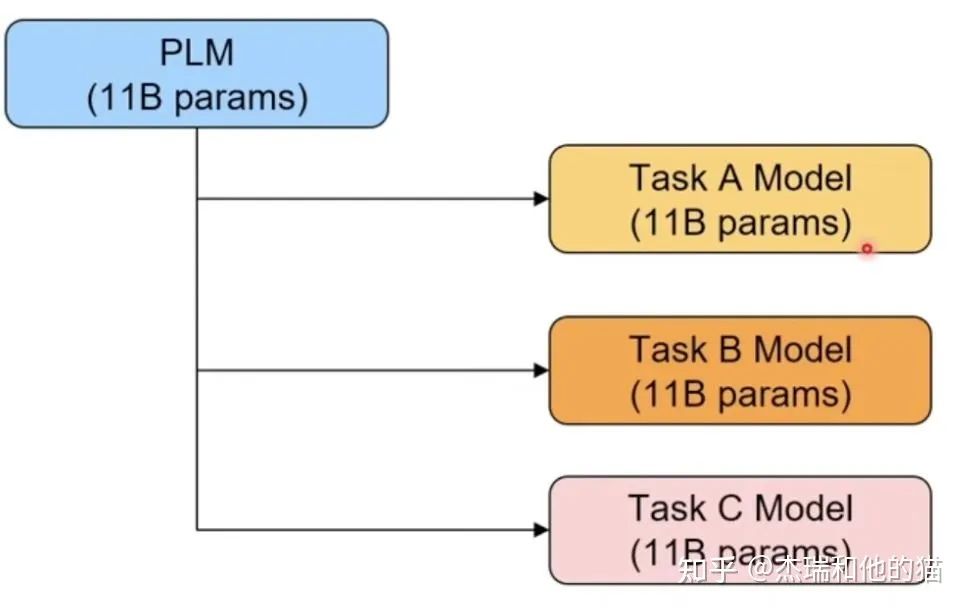

其次,現(xiàn)在的預(yù)訓(xùn)練模型參數(shù)量越來(lái)越大,為了一個(gè)特定的任務(wù)去 finetuning 一個(gè)模型,然后部署于線上業(yè)務(wù),也會(huì)造成部署資源的極大浪費(fèi)。

模型專用性特定任務(wù)微調(diào)導(dǎo)致部署成本過(guò)高

三. 提示學(xué)習(xí)是什么

首先我們應(yīng)該有的「共識(shí)」是:預(yù)訓(xùn)練模型中存在大量知識(shí);預(yù)訓(xùn)練模型本身具有少樣本學(xué)習(xí)能力。

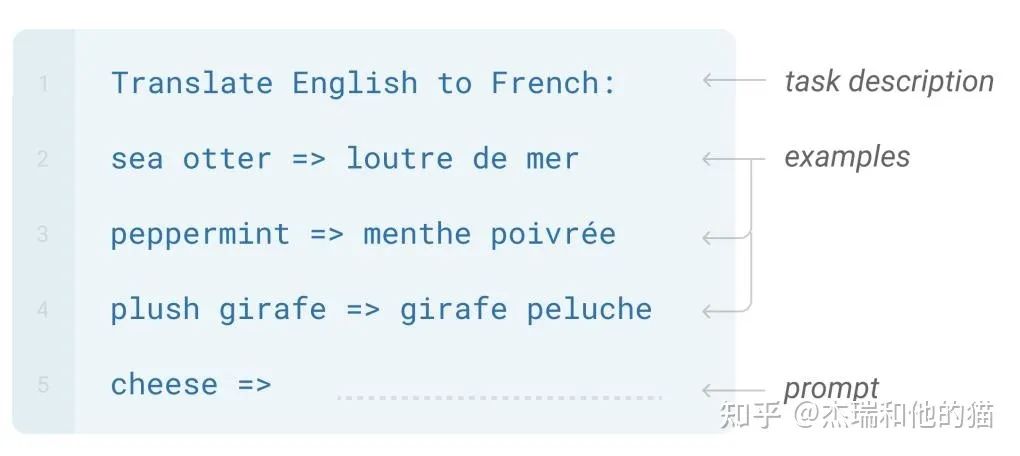

GPT-3 提出的 In-Context Learning,也有效證明了在 Zero-shot、Few-shot場(chǎng)景下,模型不需要任何參數(shù),就能達(dá)到不錯(cuò)的效果,特別是近期很火的GPT3.5系列中的 ChatGPT。

Prompt Learning 的本質(zhì)

將所有下游任務(wù)統(tǒng)一成預(yù)訓(xùn)練任務(wù);「以特定的模板,將下游任務(wù)的數(shù)據(jù)轉(zhuǎn)成自然語(yǔ)言形式」,充分挖掘預(yù)訓(xùn)練模型本身的能力。

本質(zhì)上就是設(shè)計(jì)一個(gè)比較契合上游預(yù)訓(xùn)練任務(wù)的模板,通過(guò)模板的設(shè)計(jì)就是「挖掘出上游預(yù)訓(xùn)練模型的潛力」,讓上游的預(yù)訓(xùn)練模型在盡量不需要標(biāo)注數(shù)據(jù)的情況下比較好的完成下游的任務(wù),關(guān)鍵包括3個(gè)步驟:

- 設(shè)計(jì)預(yù)訓(xùn)練語(yǔ)言模型的任務(wù)

- 設(shè)計(jì)輸入模板樣式(Prompt Engineering)

- 設(shè)計(jì)label 樣式 及模型的輸出映射到label 的方式(Answer Engineering)

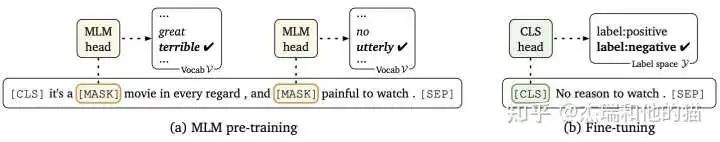

Prompt Learning 的形式

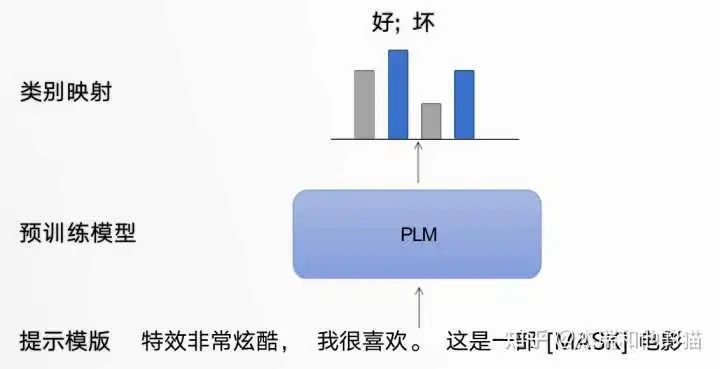

以電影評(píng)論情感分類任務(wù)為例,模型需根據(jù)輸入句子做二分類:

原始輸入:特效非常酷炫,我很喜歡。

Prompt 輸入:「提示模板1」: 特效非常酷炫,我很喜歡。這是一部[MASK]電影 ;「提示模板2」: 特效非常酷炫,我很喜歡。這部電影很[MASK]

提示模板的作用就在于:將訓(xùn)練數(shù)據(jù)轉(zhuǎn)成自然語(yǔ)言的形式,并在合適的位置 MASK,以激發(fā)預(yù)訓(xùn)練模型的能力。

提示學(xué)習(xí)模板框架

類別映射/Verbalizer:選擇合適的預(yù)測(cè)詞,并將這些詞對(duì)應(yīng)到不同的類別。

類別映射

通過(guò)構(gòu)建提示學(xué)習(xí)樣本,只需要少量數(shù)據(jù)的 Prompt Tuning,就可以實(shí)現(xiàn)很好的效果,具有較強(qiáng)的零樣本/少樣本學(xué)習(xí)能力。

四. 常見(jiàn)的提示學(xué)習(xí)方法

1. 硬模板方法

1.1 硬模板-PET(Pattern Exploiting Training)

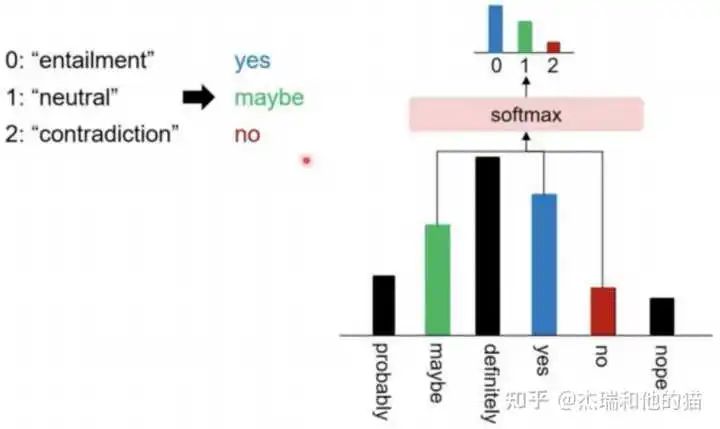

PET 是一種較為經(jīng)典的提示學(xué)習(xí)方法,和之前的舉例一樣,將問(wèn)題建模成一個(gè)完形填空問(wèn)題,然后優(yōu)化最終的輸出詞。雖然 PET 也是在「優(yōu)化整個(gè)模型的參數(shù)」,但是相比于傳統(tǒng)的 Finetuning 方法,對(duì)「數(shù)據(jù)量需求更少」。

建模方式:

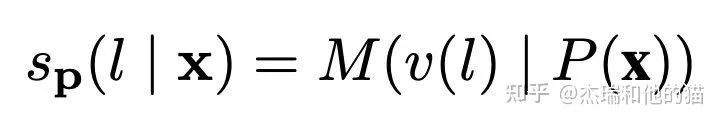

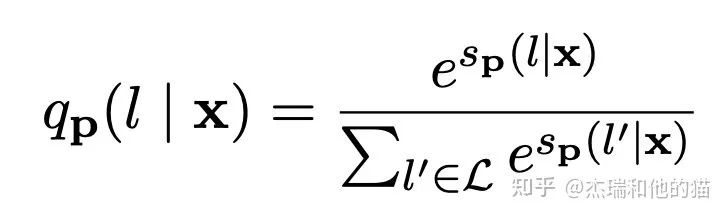

以往模型只要對(duì)P(l|x)建模就好了(l是label),但現(xiàn)在加入了Prompt P以及標(biāo)簽映射(作者叫verbalizer),所以這個(gè)問(wèn)題就可以更新為:

其中M表示模型,s相當(dāng)于某個(gè)prompt下生成對(duì)應(yīng)word的logits。再通過(guò)softmax,就可以得到概率:

作者在訓(xùn)練時(shí)又加上了「MLM loss」,進(jìn)行聯(lián)合訓(xùn)練。

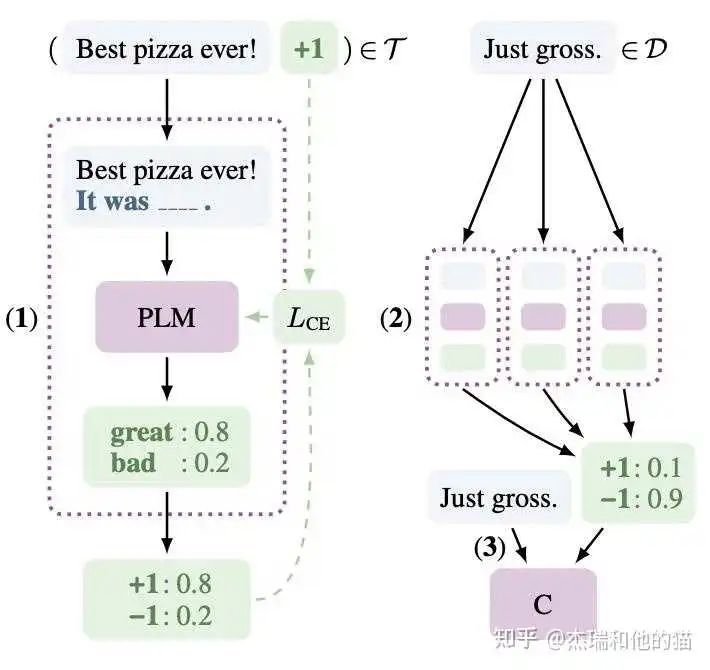

具體的做法:

- 在少量監(jiān)督數(shù)據(jù)上,給每個(gè) Prompt 訓(xùn)練一個(gè)模型;

- 對(duì)于無(wú)監(jiān)督數(shù)據(jù),將同一個(gè)樣本的多個(gè) prompt 預(yù)測(cè)結(jié)果進(jìn)行集成,采用平均或加權(quán)(根據(jù)acc分配權(quán)重)的方式,再歸一化得到概率分布,作為無(wú)監(jiān)督數(shù)據(jù)的 soft label ;

- 在得到的soft label上 finetune 一個(gè)最終模型。

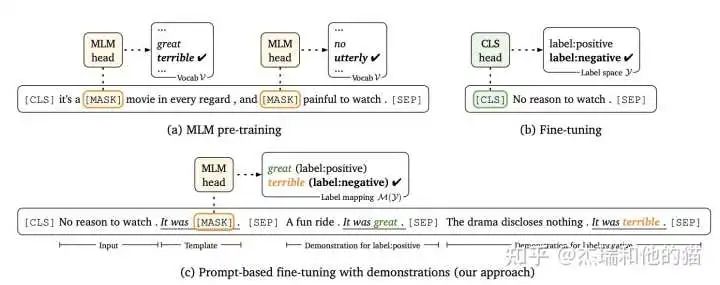

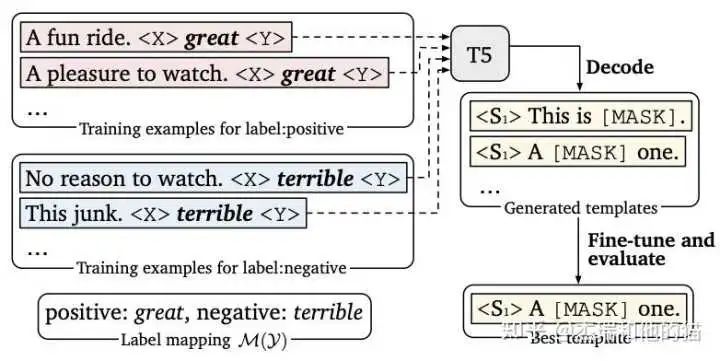

1.2 硬模板- LM-BFF

LM-BFF 是陳天琦團(tuán)隊(duì)的工作,在 Prompt Tuning 基礎(chǔ)上,提出了Prompt Tuning with demonstration & Auto Prompt Generation。

「硬模板方法的缺陷」:

硬模板產(chǎn)生依賴兩種方式:根據(jù)經(jīng)驗(yàn)的人工設(shè)計(jì) & 自動(dòng)化搜索。但是,人工設(shè)計(jì)的不一定比自動(dòng)搜索的好,自動(dòng)搜索的可讀性和可解釋性也不強(qiáng)。

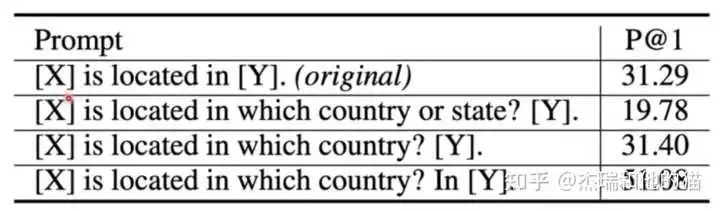

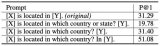

上圖實(shí)驗(yàn)結(jié)果可以看出硬模板 對(duì)于prompt,改變prompt中的單個(gè)單詞 會(huì)給實(shí)驗(yàn)結(jié)果帶來(lái)巨大的差異, 所以也為后續(xù)優(yōu)化提供了方向,如索性直接放棄硬模板,去優(yōu)化 prompt token embedding。

2. 軟模板方法

2.1 軟模板- P tuning

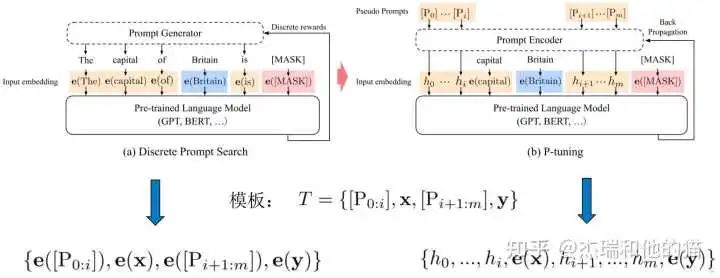

不再設(shè)計(jì)/搜索硬模板,而是在輸入端直接插入若干可被優(yōu)化的 Pseudo Prompt Tokens,「自動(dòng)化地尋找連續(xù)空間」中的知識(shí)模板:

- 不依賴人工設(shè)計(jì)

- 要優(yōu)化的參數(shù)極少,避免了過(guò)擬合(也可全量微調(diào),退化成傳統(tǒng) finetuning)

傳統(tǒng)離散prompt 直接將模板 T 的每個(gè) token 映射為對(duì)應(yīng)的embedding,而 P-Tuning 將模板 T 中的Pi(Pseudo Prompt)映射為一個(gè)「可訓(xùn)練的參數(shù) hi」 。

「優(yōu)化關(guān)鍵點(diǎn)」在于,自然語(yǔ)言的hard prompt,替換為可訓(xùn)練的soft prompt;使用雙向LSTM 對(duì)模板 T 中的 pseudo token 序列進(jìn)行表征;引入少量自然語(yǔ)言提示的錨字符(Anchor)提升效率,如上圖的“capital” ,可見(jiàn) p-tuning是hard+soft的形式,并不是完全的soft形式。

具體的做法:

- 初始化一個(gè)模板:The capital of [X] is [mask]

- 替換輸入:[X] 處替換為輸入 “Britian”,即預(yù)測(cè) Britain 的首都

- 挑選模板中的一個(gè)或多個(gè) token 作為 soft prompt

- 將所有 soft prompt 送入 LSTM,獲得每個(gè) soft prompt 的「隱狀態(tài)向量 h」

- 將初始模板送入 BERT 的 Embedding Layer,「所有 soft prompt 的 token embedding用 h 代替」,然后預(yù)測(cè)mask。

核心結(jié)論:基于全量數(shù)據(jù),大模型:僅微調(diào) prompt 相關(guān)的參數(shù),媲美 fine-tuning 的表現(xiàn)。

代碼:https://github.com/THUDM/

2.2 軟模板- Prefix tuning

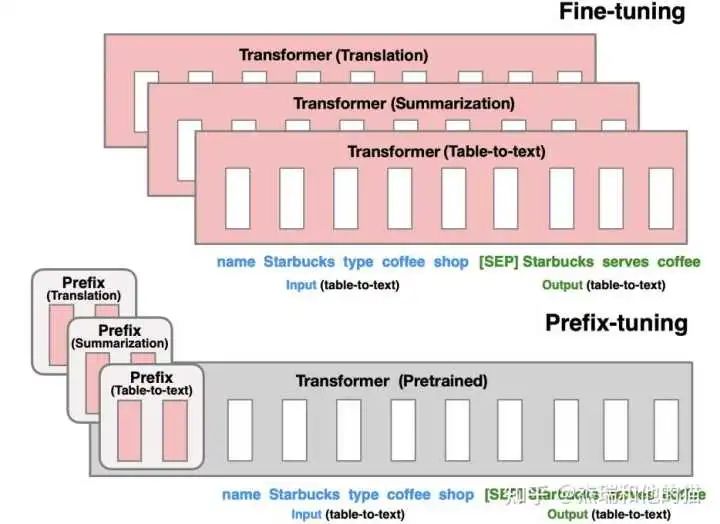

P-tuning 更新 prompt token embedding 的方法,能夠優(yōu)化的參數(shù)較少。Prefix tuning 希望能夠優(yōu)化更多的參數(shù),提升效果,但是又不帶來(lái)過(guò)大的負(fù)擔(dān)。雖然prefix tuning是在生成任務(wù)上被提出來(lái)的,但是它對(duì)soft prompt后續(xù)發(fā)展有著啟發(fā)性的影響。

優(yōu)化每一層的 Prompt token embedding,而不僅僅是輸入層

由上圖可見(jiàn),模型上在每層 transformer 之前加入 prefix。特點(diǎn)是 prefix 不是真實(shí)的 token,而是「連續(xù)向量」(soft prompt),Prefix-tuning 訓(xùn)練期間凍結(jié) transformer 的參數(shù),只更新 Prefix 的參數(shù)。

只需要存儲(chǔ)大型 transformer 的一個(gè)副本和學(xué)習(xí)到的特定于任務(wù)的前綴即可,為每個(gè)附加任務(wù)產(chǎn)生非常小的開(kāi)銷。

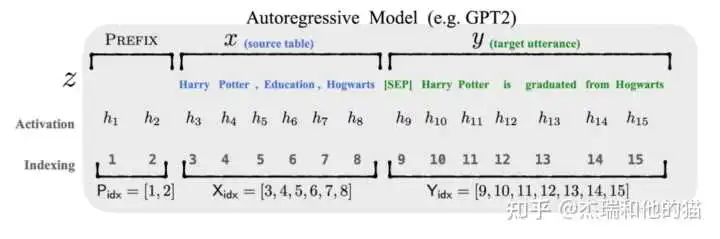

自回歸模型

以圖上自回歸模型為例的做法:

- 輸入表示為 Z = [ prefix ; x ; y ]

- Prefix-tuning 初始化一個(gè)訓(xùn)練的 矩陣 P,用于存儲(chǔ) prefix parameters

- 前綴部分 token,參數(shù)選擇設(shè)計(jì)的訓(xùn)練矩陣,而其他部分的token,參數(shù)則固定 且為預(yù)訓(xùn)練語(yǔ)言模型的參數(shù)

核心結(jié)論:Prefix-tuning 在生成任務(wù)上,全量數(shù)據(jù)、大模型:僅微調(diào) prompt 相關(guān)的參數(shù),媲美 fine-tuning 的表現(xiàn)。

代碼:https://github.com/XiangLi1999/PrefixTuning

2.3 軟模板- Soft Prompt Tuning

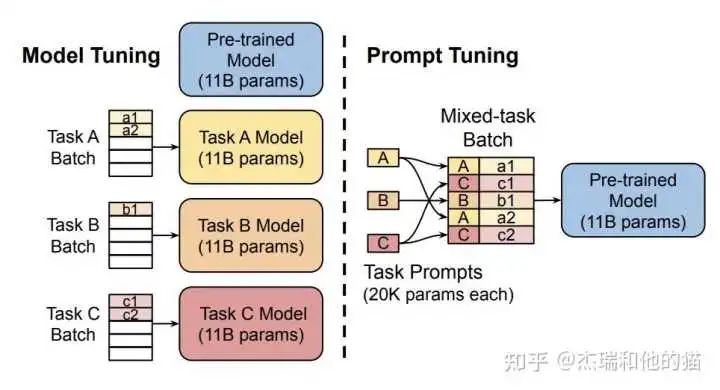

Soft Prompt Tuning 系統(tǒng)后驗(yàn)證了軟模板方法的有效性,并提出:固定基礎(chǔ)模型,有效利用任務(wù)特定的 Soft Prompt Token,可以大幅減少資源占用,達(dá)到大模型的通用性。

對(duì) Prefix-tuning 的簡(jiǎn)化,固定預(yù)訓(xùn)練模型,只對(duì)下游任務(wù)的輸入「添加額外的 k個(gè)可學(xué)習(xí)的 token」。這種方式在大規(guī)模預(yù)訓(xùn)練模型的前提下,能夠媲美傳統(tǒng)的 fine-tuning 表現(xiàn)。

代碼:https://github.com/kipgparker/soft-prompt-tuning

五. 總結(jié)

「Prompt Learning 的組成部分」

- 提示模板:根據(jù)使用預(yù)訓(xùn)練模型,構(gòu)建 完形填空 or 基于前綴生成 兩種類型的模板

- 類別映射/Verbalizer:根據(jù)經(jīng)驗(yàn)選擇合適的類別映射詞、3. 預(yù)訓(xùn)練語(yǔ)言模型

「典型的 Prompt Learning 方法總結(jié)」

-

硬模板方法:人工設(shè)計(jì)/自動(dòng)構(gòu)建基于離散 token 的模板

1)PET 2)LM-BFF -

軟模板方法:不再追求模板的直觀可解釋性,而是直接優(yōu)化 Prompt Token Embedding,是向量/可學(xué)習(xí)的參數(shù)

1)P-tuning 2)Prefix Tuning

后續(xù)會(huì)在分類、信息抽取任務(wù)中嘗試 Prompt Learning,持續(xù)更新中...

審核編輯 :李倩

-

模型

+關(guān)注

關(guān)注

1文章

3279瀏覽量

48976 -

深度學(xué)習(xí)

+關(guān)注

關(guān)注

73文章

5510瀏覽量

121345 -

nlp

+關(guān)注

關(guān)注

1文章

489瀏覽量

22064

原文標(biāo)題:Prompt Tuning 相比于 Fine Tuning 在哪些場(chǎng)景下表現(xiàn)更好?

文章出處:【微信號(hào):zenRRan,微信公眾號(hào):深度學(xué)習(xí)自然語(yǔ)言處理】歡迎添加關(guān)注!文章轉(zhuǎn)載請(qǐng)注明出處。

發(fā)布評(píng)論請(qǐng)先 登錄

相關(guān)推薦

使用PPC3軟件,進(jìn)入Tuning and Audio Processing模塊后,喇叭就不發(fā)聲了怎么解決?

使用DCC tuning tool 調(diào)試gamma,不可以通過(guò)曲線拉伸,請(qǐng)問(wèn)這是什么原因?

請(qǐng)問(wèn)導(dǎo)致image tuning tools打開(kāi)raw文件出錯(cuò)是什么原因?如何解決?

請(qǐng)問(wèn)DM36x Image Tuning Tool這個(gè)軟件哪里可以下載?

Altium差分信號(hào)length tuning中的gap,amplitude increase gap increase該怎么設(shè)置?

晶振溫度特性-音叉Tuning Fork

請(qǐng)問(wèn)采用開(kāi)關(guān)電容進(jìn)行tuning,精度上可行嗎?

Antenna Tuning Approach Aids C

Tuning the MAX2009/MAX2010 RF

電子管的Tuning Indicator——調(diào)諧指示管

Hand-Tuning Loops and Control Code on the TMS320C6000

Prompt范式你們了解多少

基于預(yù)訓(xùn)練視覺(jué)-語(yǔ)言模型的跨模態(tài)Prompt-Tuning

Prompt Tuning相比于Fine Tuning在哪些場(chǎng)景下表現(xiàn)更好?

Prompt Tuning相比于Fine Tuning在哪些場(chǎng)景下表現(xiàn)更好?

評(píng)論