特斯拉 NOA 導航輔助駕駛

大家想象中的自動駕駛,其實沒有那么多定語,應該是從任意地點到任意地點都能自動駕駛。

但是自動駕駛技術的開發難度實在太大,各種限制因素也多,所以現在在乘用車自動駕駛領域,業界劃分出了不同的 ODD(可運行區域),包括泊車域、行車域,行車域里面又有城市域、高速域,像蔚來還要把換電場景自動駕駛這個域加進去。

一段從車輛啟動到車輛停好的旅程,被切割成了細分的很多段,業內企業們正分段攻破。

正是因為這些域的存在,衍生出了很多的自動駕駛功能(現在只能稱為「輔助駕駛功能」),比如泊車域的自動泊車、遙控泊車、記憶泊車;而在行車域,又有基礎輔助駕駛功能(ACC、LCC、ALC),還有更高級一些的導航輔助駕駛,可覆蓋高速域以及城市域,再往后那就是真正的點到點自動駕駛。

不過目前由于自動駕感知技術還未達到極致成熟,從高速到城市,感知難度指數級提升,同時有其他限制因素,當下最主流的智駕功能——導航輔助駕駛系統開城的速度依然很慢。

01

導航輔助加速內卷

BEV感知技術成主流

從目前業內自動駕駛的產品形態看,導航輔助駕駛功能越來越火爆,這個由特斯拉帶火的層次稍高一些的輔助駕駛功能,正在被國內的新老車企爭相推動上車,國內的供應商們也都往這個方向上卷,因為這個方向既受到法規允許,也能吸引到真實消費者使用并為其買單。

未來 1-2 年,國內的導航輔助駕駛功能 NOA、NGP、NOP、NZP、ANP、NOH、NCA、NOM 等將迎來大爆發。當然,速度有快有慢,有的還在打磨高速導航輔助駕駛,有的已經把車開進了城市,開啟了更難的挑戰。

就在本月,此前主打 Robotaxi 開發和運營的小馬智行正式宣布開辟乘用車智能駕駛業務產品線,并已成立獨立事業部。

從其公布的智能駕駛量產方案中,要打造高速和城市導航輔助駕駛的規劃非常明確。

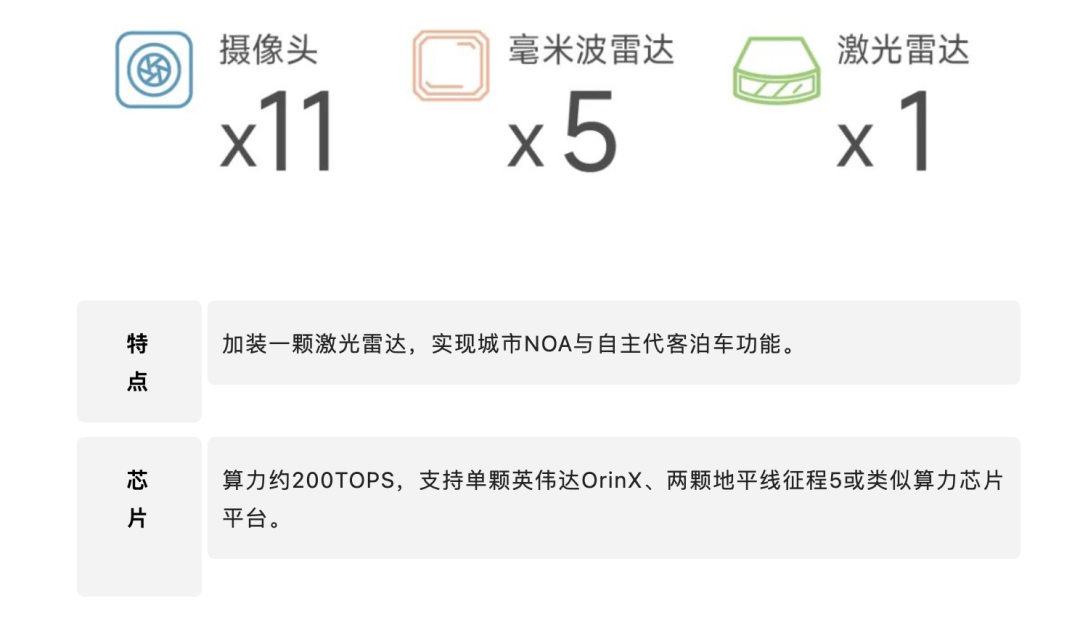

小馬智行公布的量產自動駕駛方案

這也足夠說明導航輔助駕駛系統已經成為車企和供應商的兵家必爭之地。

在導航輔助駕駛功能火爆和上量的背后,是自動駕駛核心技術在驅動。

感知技術、決策/規劃/控制技術、高精地圖技術等等,都在深刻影響著導航輔助駕駛產品的能力和體驗。其中,感知技術以及定位技術是導航輔助駕駛功能實現的前提,沒有這二者,后面的規劃控制也就無從談起。

感知能幫助系統「看」到道路上的參與者和道路要素,定位能告訴系統「我在哪里」,所以你可以看到現在各家的導航輔助駕駛一方面要在傳感器種類和數量上卷;另一方面也很依賴于高精地圖數據。

其中的高精地圖覆蓋范圍以及新鮮度很大程度上限定了導航輔助駕駛的運行連續性以及可用范圍。

可以預見的是,無論是高速導航輔助駕駛還是城市導航輔助駕駛,未來很長一段時間還是得依賴高精地圖這一重要「傳感器」。因為單從體驗上來看,有高精地圖的功能和沒高精地圖的功能確實有著非常大的差距。

但是依賴高精地圖也不意味著行業放棄了對車端感知能力和技術的更高追求。其實是要尋找一種平衡:在有高精地圖的地方增強車輛智駕系統體驗;在沒有高精地圖的區域,系統能通過車上感知模塊來指導車輛完成自動駕駛,比如像北京五環內這樣的區域。

所以,行業也在推動自動駕駛感知技術的突破。感知技術接下來的主流會是什么?很多車企和供應商的答案是 —— BEV 感知。

02

BEV是什么?為什么被需要?

BEV 全稱是 Bird's Eye View,也就是鳥瞰圖,是一種用于描述感知到的現實世界的視角或坐標系(3D 空間),就像是上帝視角。另外,BEV 也是計算機視覺領域內的一種端到端的、由神經網絡將圖像信息從圖像空間轉換到 BEV 空間的技術。

大家知道在自動駕駛車上,有很多的傳感器,如攝像頭、毫米波雷達、激光雷達,自動駕駛系統里傳統的圖像空間感知方法是將汽車上的雷達、攝像頭等不同傳感器采集來的數據分別進行分析運算,然后再把各路分析結果融合到一個統一的空間坐標系,用于規劃車輛的行駛軌跡。

但這個過程中每個獨立傳感器收集到的數據和人眼類似,受特定視角的局限,經過各自的分析運算后,在后處理融合階段會導致誤差疊加,很難精準地拼湊出道路實際全貌,給車輛的決策規劃帶來困難。

BEV 感知就好比是一個從高處統觀全局的「上帝視角」,車身多個傳感器采集的數據,會輸入到一個統一模型進行整體推理,這樣生成的「鳥瞰圖」,有效地避免了誤差疊加;BEV 方案還支持「時序融合」,也就是不僅收集一個時刻的數據,分析一個時刻的數據,而是支持把過去一個時間片段中的數據都融合進模型做環境感知建模,這樣可以讓系統感知到的結果更穩定,使得車輛對于道路情況的判斷更加準確,讓自動駕駛更安全。

BEV 感知技術其實是特斯拉帶火的,作為業內純視覺感知技術的鼻祖,很早就在這方面下功夫。

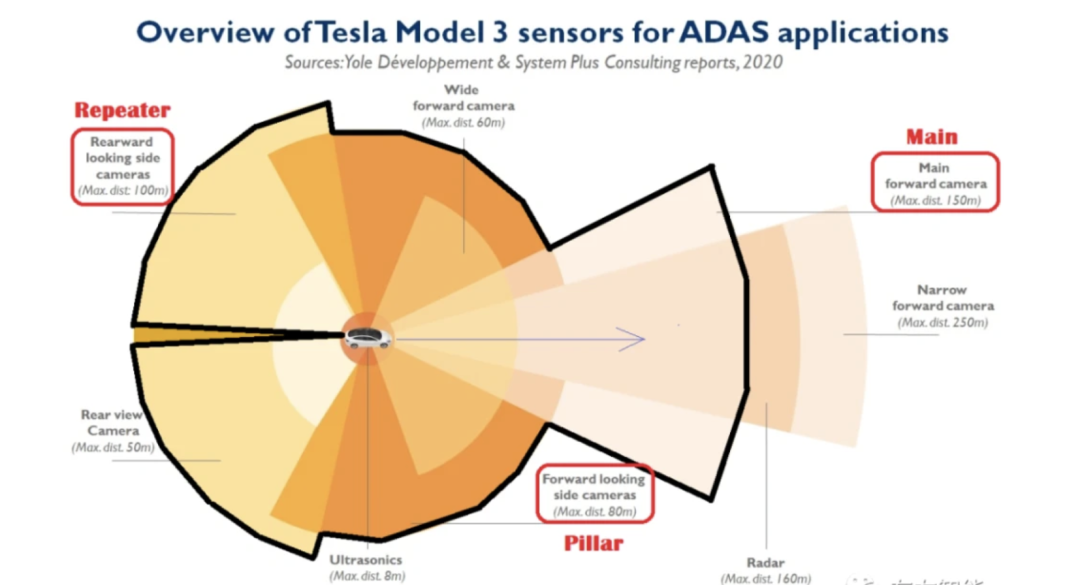

特斯拉車身上有多個攝像頭和毫米波雷達,在做感知的時候,需要把不同傳感器的感知數據收集并有效融合起來,輸出感知結果。

特斯拉車上不同位置的攝像頭的參數并不一樣(相機的內外參不同),包括焦距長度、視野寬度、深度感受野等等,這就導致同一個物體在不同的相機里是不一樣的。

特斯拉在引入 BEV 之前采用的方式是:在每個相機上單獨進行感知,然后再將不同相機感知到的結果進行融合。

但這種方式會存在幾個問題:

比如融合困難,將不同相機的感知結果進行融合需要大量的超參,寫起來非常復雜,并且由于深度估計的誤差,最終的輸出結果可能會相互沖突,導致融合結果不一致。

另外就是圖像空間的輸出對于后續任務來說很不友好,比如在一些預測任務上,如果不同相機單獨感知,則很難預測被大面積遮擋的物體;單個攝像機也無法看到大物體的全貌,會導致難以正確預測。

為了解決這些問題,特斯拉采取的方法就是用神經網絡將圖像空間映射到 BEV 空間。

其做法是把多個視角的圖像統一通過一個公共的特征提取器投影到一個統一的 BEV 空間里面。

在這個空間里面,通過深度學習去完成一個特征的融合,然后再通過一個 3D 的解碼器,直接端到端輸出最后的一個 3D 檢測和道路結構信息。下游的像規劃與控制模塊直接可以在 BEV 的空間上去進行。

特斯拉 BEV 坐標轉換

從 2D 圖像空間到 3D BEV 空間如何轉換?

這里不得不提到 Transformer。

大概從 2017 年開始,Transformer 作為一種新型的神經網絡結構開始引起研究人員的廣泛關注。

Transformer 與處理序列數據常用的循環神經網絡(RNN)不同,Transformer 中的注意力機制并不會按照順序來處理數據,也就是說,每個元素和序列中的所有元素都會產生聯系,這樣就保證了不管在時序上相距多遠,元素之間的相關性都可以被很好地保留。通俗點說就是會「聯系上下文」,而且還會抓重點。

Transformer 首先被應用在自然語言處理領域(NLP),用來處理序列文本數據。在自然語言處理領域取得廣泛應用后,Transformer 也被成功移植到了很多視覺任務上,比如「圖像分類,物體檢測」等,并同樣取得了不錯的效果。而且,Transformer 在海量數據上可以獲得更大的性能提升,這不正好就是自動駕駛領域所需要的嗎?

正是因為看到了這一點,面向量產的自動駕駛公司在擁有數據收集優勢的情況下,自然就會傾向于選擇 Transformer 作為其感知算法的主體。

2021 年夏天,特斯拉的自動駕駛技術負責人 Andrej Karpathy 在 AI Day 上,公開了 FSD 自動駕駛系統中采用的算法,而 Transformer 則是其中最核心的模塊之一。

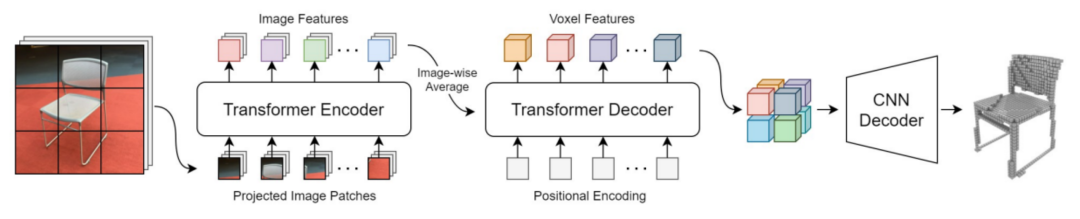

BEV 感知技術要廣泛應用,離不開 Transformer 這樣的模塊進行空間坐標系的轉換,比如將 2D 圖像轉換到 3D 空間里去。

其架構簡單說就是:先通過一個共享的主干網絡來提取每個相機的特征,然后再通過 Transformer 等將多攝像頭數據,完成從圖像空間到 BEV 空間(3D)的轉換。

在 BEV 空間內,由于坐標系相同,可以很方便地將圖像數據和激光雷達、毫米波雷達數據進行融合,還可以進行時序融合形成 4D 空間,這也是當下 BEV 技術的大趨勢。當然,特斯拉目前不需要融合激光雷達數據。

BEV 感知技術很好地解決了傳感器融合的很多阻礙性難題,而且也給了后續異構傳感器大量上車之后的融合提供了借鑒。

國內的自動駕駛團隊百度 Apollo 也經歷了這個過程,他們在 2019 年推出了 Apollo Lite 方案,其實也是一個多攝像頭融合的方案,包括單目前視+多個環視。

他們當時也是采用后融合方式來做。

在這個感知方案的整體框架方面,每一個不同朝向的相機,會先經過一個神經網絡去推理出相機下面的障礙物位置、大小、朝向等信息;單相機里面的目標跟蹤,以及多相機融合等都是一些基于規則的方案去做的。

百度團隊在單相機里面把深度學習做到一個比較高的程度了,整個單相機里面的 3D 感知信息都可以通過模型來輸出,然后基于 3D 標注結果,直接端到端產出單相機的結果。

在過去的幾年里,單相機的 3D 感知能力也有一個比較大的提升,但是最后也遇到了一些瓶頸,比如有一些截斷的物體,在一個相機里面是看不全的,就沒辦法很好地去對它做感知。

另外,一些跟蹤和平滑策略在圖像視角下,和最后規劃控制模塊所要的輸出空間其實是不一致的,這樣會總體上限制自動駕駛的能力。

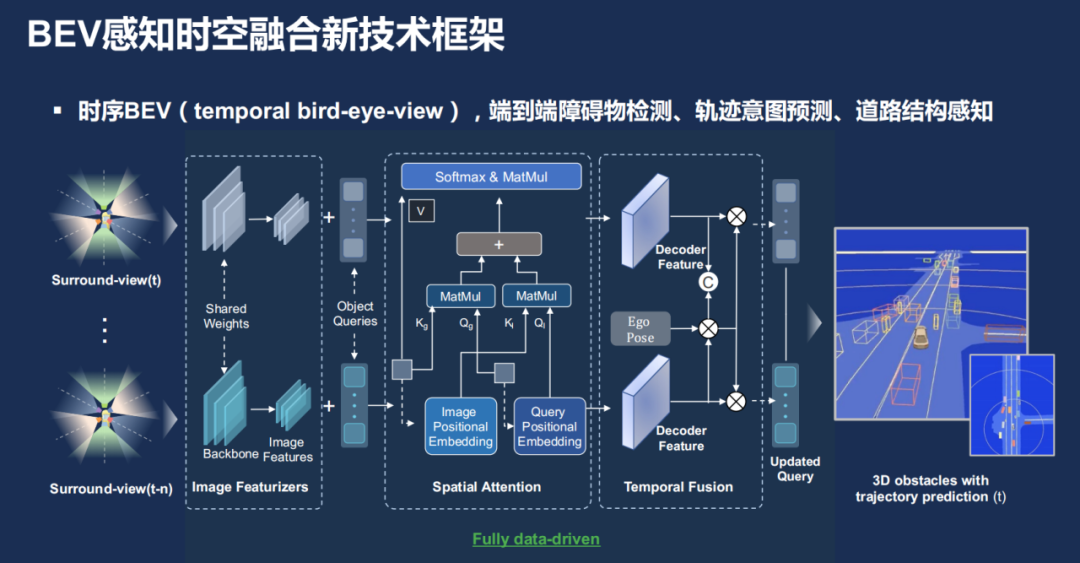

所以在過去一年里,百度 Apollo 的團隊也將 BEV 感知應用了進來,整體上使用一種持續并列的框架去端到端地做障礙物檢測、軌跡預測以及道路結構感知,整體上會有一個時間序列,多幅圖像輸入進來。然后通過圖像的特征提取器之后,得到圖像視角的特征,然后再通過 Transformer 把那個特征投影到一個統一的 BEV 空間,再經過解碼,最終得到一個端到端的一個 3D 感知效果。

特別是在道路結構這一部分,百度因為有自己的高精地圖數據,把這些數據和車輛的高精定位信息結合起來,是可以直接轉換成 BEV 道路結構的訓練數據,用于算法的訓練。

也正是在 BEV 感知技術的加持下,百度的導航輔助駕駛 ANP 3.0 系統正在加速落地,這套系統能覆蓋高速場景、城市場景,甚至能自動通過收費站。作為已經確定應用這套能力的集度 ROBO-01 車型,最近也已經去到交通流復雜的廣州進行測試,去征服更多的感知難題。

除了像特斯拉和 Apollo Lite 這種純視覺自動駕駛方案,國內現在掀起的是多傳感器融合方案,激光雷達(單顆或多顆)、攝像頭(像素越來越高)、毫米波雷達、超聲波傳感器等等。

這么多的異構傳感器放在一起,感知數據如何融合?視覺數據和激光雷達點云數據如何融合?它們一個是 2D 圖像空間,一個是 3D 空間,如何比較穩定的融合,而且效果還要好?

答案依然是 BEV 感知。

如前文所述,可以先通過 Transformer 把視覺的 2D 圖像轉換到 3D 坐標下,和其他的傳感器數據如激光雷達點云在空間坐標上保持一致,在相同坐標下融合起來就更加游刃有余。

如果從國內的這些車企和供應商的選擇來看,BEV 感知已經是主流了。

而 BEV 感知技術成為應用主流,也意味著其將推動導航輔助駕駛這類功能更快量產、更好地落地。

一方面,那些應用 BEV 感知技術的造車新勢力們,能更加好的提升系統的感知能力,讓功能的體驗更好。

另一方面,那些應用 BEV 感知技術的智駕供應商,能夠更快去適配不同車企、不同車型的五花八門的需求,比如他們對車上智駕傳感器的不同配置的需求,可以靈活應變,在感知效果上也不會因為傳感器配置變化而變得不穩定、不可控。

03

哪些公司在用BEV?

雖然 BEV 感知技術不能解決自動駕駛感知領域的一切疑難雜癥,但它提供了一個相比圖像更加貼近物理世界的空間,可以給后續的融合、規劃提供更多的可能性。

現在很多自研智駕系統的車企以及智駕供應商都在使用 BEV 技術。

比如車企里面的蔚來、理想、小鵬;供應商里面的百度 Apollo、毫末智行、紐勱科技、地平線;Robotaxi 公司轉型做智駕系統供應商的輕舟智航、小馬智行等等。

每一家在具體使用這項技術的時候肯定會有不同,但是大致的技術框架應該如下:

先將攝像頭數據輸入到共享的骨干網絡(Backbone),提取每個攝像頭的數據特征(Feature);

把所有的攝像頭數據進行融合,并轉換到 BEV 空間;

在 BEV 空間內,進行異構傳感器數據融合,將視覺數據和激光雷達點云進行融合;

進行時序融合,形成 4D 時空維度的感知信息(3D+速度);

進行多任務輸出,可以是靜態語義地圖、動態檢測和運動預測等,給到下游規控模塊使用。

就拿剛剛公布要進行智駕系統量產上車的小馬智行來講,其已明確自研了 BEV 感知算法。

可通過大模型識別各類型障礙物、車道線及可通行區域等信息,最大限度降低算力需求,同時在無高精地圖的情況下,僅用導航地圖也可實現高速與城市導航輔助駕駛功能。

特別是在高速場景中,小馬智行壓榨傳感器的性能,用魚眼相機參與行車 BEV 感知模型,減少對傳感器數量的依賴—— 使用 6 個攝像頭(4 個魚眼相機及前后向各 1 個長距相機)與 1 個前向毫米波雷達就可以實現高速導航輔助駕駛這樣的功能。

成功推出高速及城市 NOH 系統的毫末智行在感知領域同樣采用了 BEV 融合感知技術,毫末的融合感知其實包含三個不同的維度:空間、時間和傳感器。

空間融合主要是將來自多個相機的圖像轉換到統一的 BEV 坐標,再進行特征層融合;另外,單幀的信息會有很大的隨機性,因此,時序信息對于自動駕駛環境感知來說是非常重要的,毫末的時序融合也是采用了車輛自身的運動信息來統一多幀數據的空間坐標系,從而在一個統一的空間坐標系下融合來自不同時間的數據。

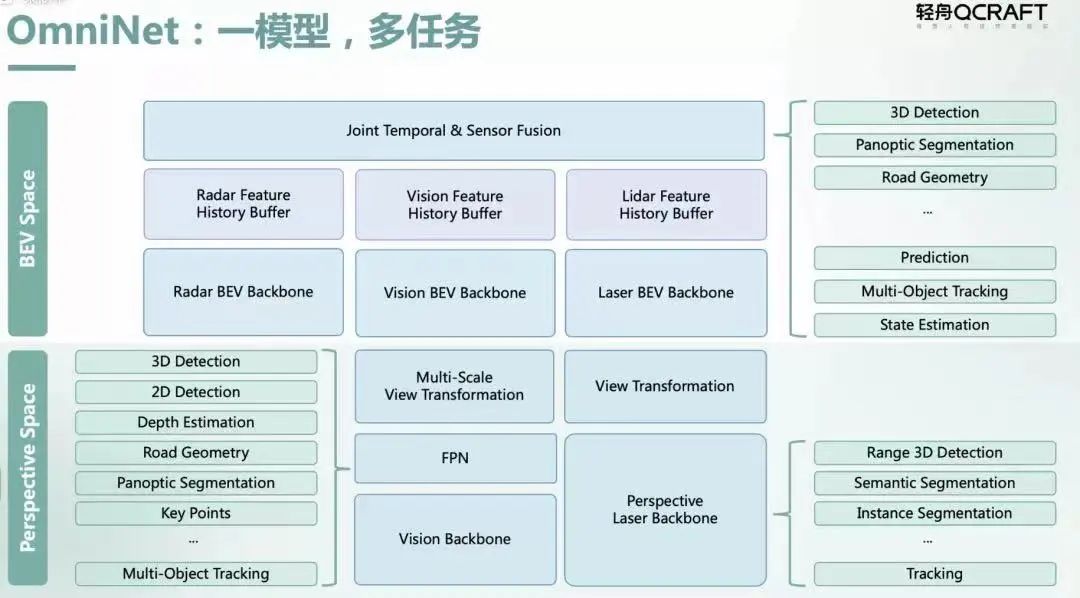

輕舟智航去年發布的 OmniNet 感知融合大模型就是將視覺、毫米波雷達、激光雷達等數據通過前融合和 BEV 空間特征融合,讓本來獨立的各個計算任務通過共享主干網絡(Backbone)和記憶網絡(Memory Network)進行高效多任務統一計算,最終同時在圖像空間和 BEV 空間中輸出不同感知任務的結果,為下游的預測和規劃控制模塊提供更豐富的輸出。

雖然地平線是一家芯片企業,但是其打造的 SuperDrive 全場景智能駕駛方案里,其實也應用了感知融合 BEV 技術,這套方案可支持高速、城區、泊車場景自動駕駛,目前正給吉利方面供貨。

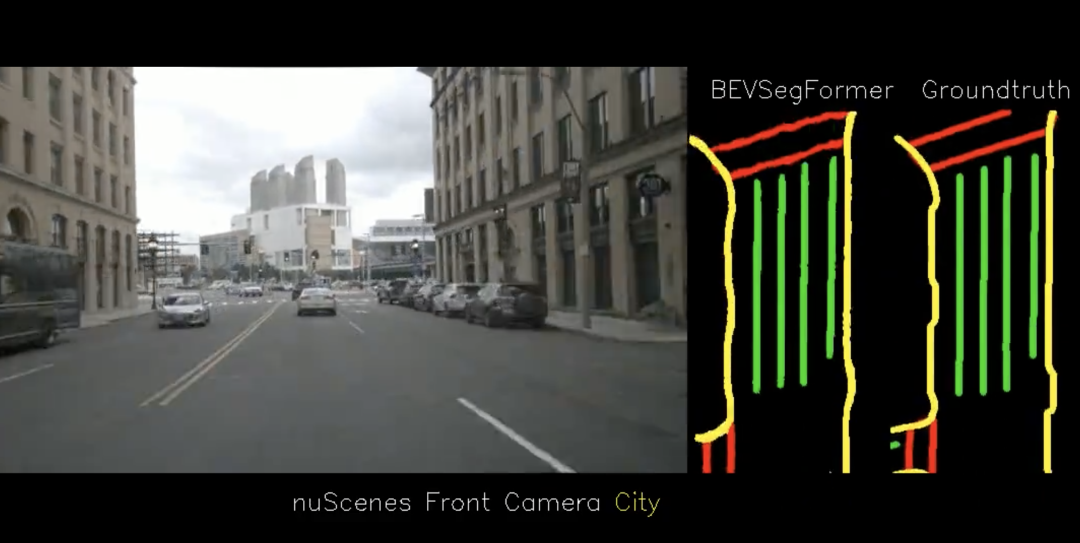

智駕供應商紐勱科技的感知團隊也基于 BEV 提出了 BEVSegFormer,一種基于 Transformer 的 BEV 語義分割方法,可面向任意配置的相機進行 BEV 語義分割。

具體來說,BEVSegFormer 首先使用了共享的主干網絡,對來自任意相機的圖像特征進行編碼,然后通過基于可變形 Transformer 的編碼器對這些特征進行增強。BEVSegFormer 還引入了一個 BEV Transformer 解碼器模塊,對 BEV 語義分割的結果進行解析,以及一種高效的多相機可變形注意單元,完成 BEV 到圖像的視圖變換。最后,根據 BEV 中的網格布局對查詢進行重塑,并進行上采樣,以有監督的方式生成語義分割結果。

在車企方面,理想汽車的 L9 車型所搭載的 AD Max 系統也應用了融合感知 BEV 技術,它利用所謂「純視覺」進行運動感知預測,同時多傳感融合和高精地圖的信息輸入作為輔助。

另外,蔚來自動駕駛 NAD 系統,在 2023 年的上半年,也會進行底層感知架構的切換,轉向 BEV 模型,向特斯拉看齊。

當然,以上并未完全列出所有采用 BEV 技術的行業玩家。

BEV 技術成為了廠商們選擇的主流感知融合技術,該如何去定位這一技術?MAXIEYE CEO 周圣硯是這么看的:BEV 是深度學習之后的又一個新臺階,解決了過去多傳感器的變化和異構帶來的各種各樣的融合感知算法的開發問題。

04

BEV還有什么新的玩法嗎?

當 BEV 感知技術成為主流,而且被多數廠商采用的時候,有些企業就開始對其進行改造了。

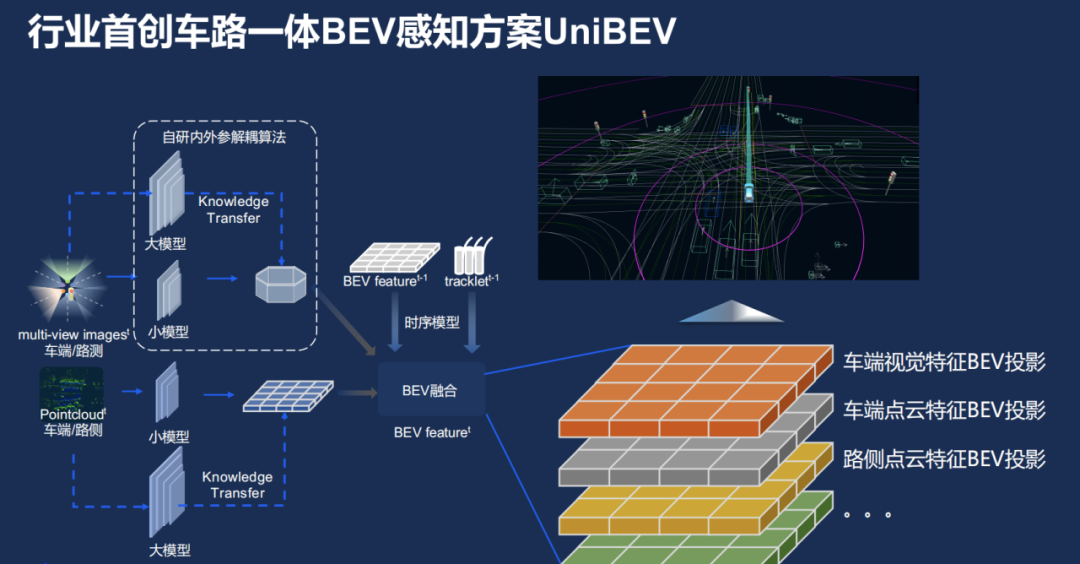

在今年 Create AI 開發者大會上,百度就在 BEV 感知基礎上,提出了一個叫做「車路一體 BEV」的感知方案,取名叫 UniBEV,有點像「聯合 BEV」。

簡單點理解就是,UniBEV 不但會將車端的感知數據拿過來做融合,也會將路端的感知數據也放進來,放到同一個坐標系下。BEV 本來就是個上帝視角了,這里再加上路端的超視距感知數據,那簡直是開掛一般的存在。但什么時候能在車端量產應用現在還不太清楚。

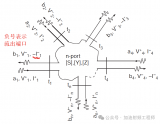

具體來看看 UniBEV 的框架。

框架中的虛線框里有一個自研的內外參解耦算法,這里的內外參指的是傳感器的內外參數,比如相機內參數,指的是與相機自身特性相關的參數,比如焦距、像素大小等;而相機外參數則是相機在真實世界坐標系中的參數,比如相機的安裝位置、旋轉方向等。

那為何要把內外參解耦呢?百度說他們作為智駕方案商,需要把方案供應給不同的車廠,不同車廠車型會有不一樣的傳感器配置,比如供給集度的和供給比亞迪的傳感器方案就會不一樣。

有了這個解耦算法,可以把不同相機解耦開,讓每個相機獨立,這樣不管傳感器的相對位置如何變,研發團隊都可以將其投影到一個統一的 BEV 空間下。

框架中另一部分是車端和路側的點云,而且路側也會裝一些攝像頭,這些數據的特征到最后都會投影到一個統一的 BEV 空間下,便能把可能的信息都融合起來。

最終,在 UniBEV 加持下,百度的智駕系統在車端、路側的動靜態感知任務上都有不錯的表現。

當然,也不是誰家都能搞這樣的車路一體 BEV 感知的,因為這也需要有大量的路段感知設備傳回的數據,這是需要路側基建的。目前國內,百度是為數不多有車路協同路端基建業務的智駕供應商,這一點也強化了 UniBEV 的獨特性。

當然,我們也期待其他廠商,基于 BEV 感知技術再研究出更加突破性的技術,助力自動駕駛技術在感知領域的大躍進。

-

傳感器

+關注

關注

2552文章

51356瀏覽量

755622 -

特斯拉

+關注

關注

66文章

6322瀏覽量

126701 -

輔助駕駛系統

+關注

關注

5文章

85瀏覽量

17026

原文標題:BEV還有什么新的玩法嗎?

文章出處:【微信號:nev360,微信公眾號:焉知新能源汽車】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

相關推薦

淺析基于自動駕駛的4D-bev標注技術

電裝新技術助力BEV電池循環再利用

自動駕駛中一直說的BEV+Transformer到底是個啥?

正力新能為零跑T03歐盟版供應BEV標準化電芯產品

電裝總部啟動基于BEV的能源管理系統實證實驗

豐田與比亞迪合作僅限BEV領域,廣汽豐田無DMI插混項目?

黑芝麻智能開發多重亮點的BEV算法技術 助力車企高階自動駕駛落地

OpenAI表示Sora還有很長的路要走

多款大作扎堆面世,存儲空間急需擴容!

滑動變阻器除了保護電路,還有什么作用?

BEV感知算法:下一代自動駕駛的核心技術

基于Transformer的多模態BEV融合方案

BEV還有什么新的玩法嗎

BEV還有什么新的玩法嗎

評論