今年整體接收率為 31.8%,你的論文出現(xiàn)在列表中了嗎?

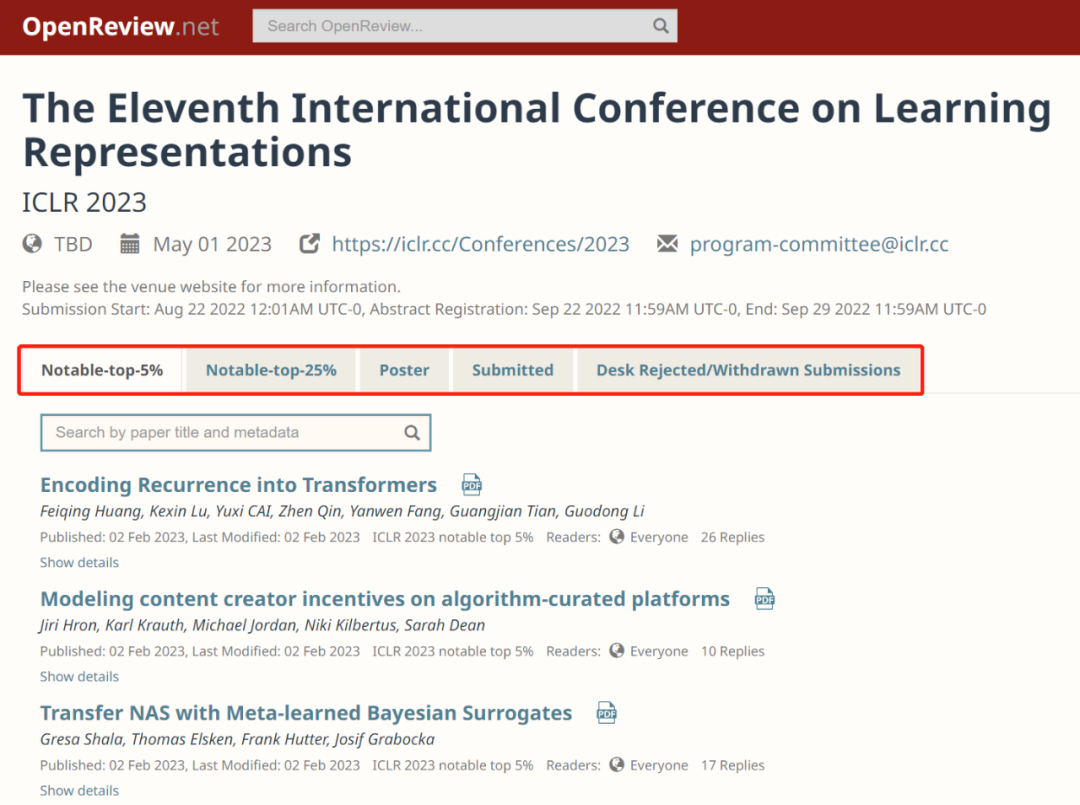

深度學(xué)習(xí)頂級(jí)學(xué)術(shù)會(huì)議 ICLR 2023 錄用結(jié)果已經(jīng)公布!論文接收的完整列表已經(jīng)在 OpenReview 平臺(tái)上公開。

ICLR 2022 完整論文列表:https://openreview.net/group?id=ICLR.cc/2023/Conference#notable-top-5-

ICLR 全稱為國際學(xué)習(xí)表征會(huì)議(International Conference on Learning Representations),今年將舉辦的是第十一屆,預(yù)計(jì)將于 5 月 1 日至 5 日在盧旺達(dá)首都基加利線下舉辦。

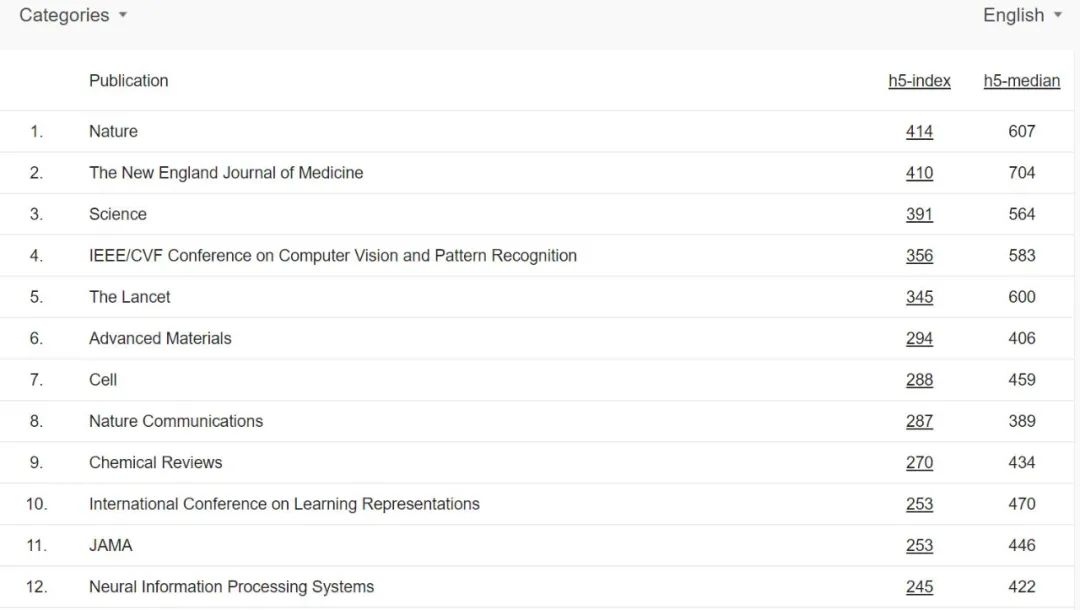

在機(jī)器學(xué)習(xí)社區(qū)中,ICLR 是較為「年輕」的學(xué)術(shù)會(huì)議,它由深度學(xué)習(xí)巨頭、圖靈獎(jiǎng)獲得者 Yoshua Bengio 和 Yann LeCun 牽頭舉辦,2013 年才剛剛舉辦第一屆。不過 ICLR 很快就獲得了學(xué)術(shù)研究者們的廣泛認(rèn)可,被認(rèn)為是深度學(xué)習(xí)的頂級(jí)會(huì)議。在 Google Scholar 的學(xué)術(shù)會(huì)議 / 雜志排名中,ICLR 目前排名第十位,要高于 NeurIPS。

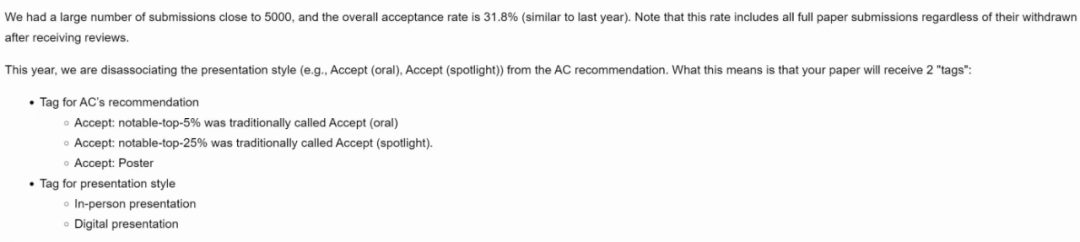

在今年的接收統(tǒng)計(jì)中,ICLR 共接收近 5000 篇投稿,整體接收率為 31.8%,接近于去年的 32.26%。今年還有一個(gè)變化是接收論文的 tag 會(huì)有兩個(gè),一個(gè)是論文類型(oral、spotlight、poster),另一個(gè)是 presentation 的方式。

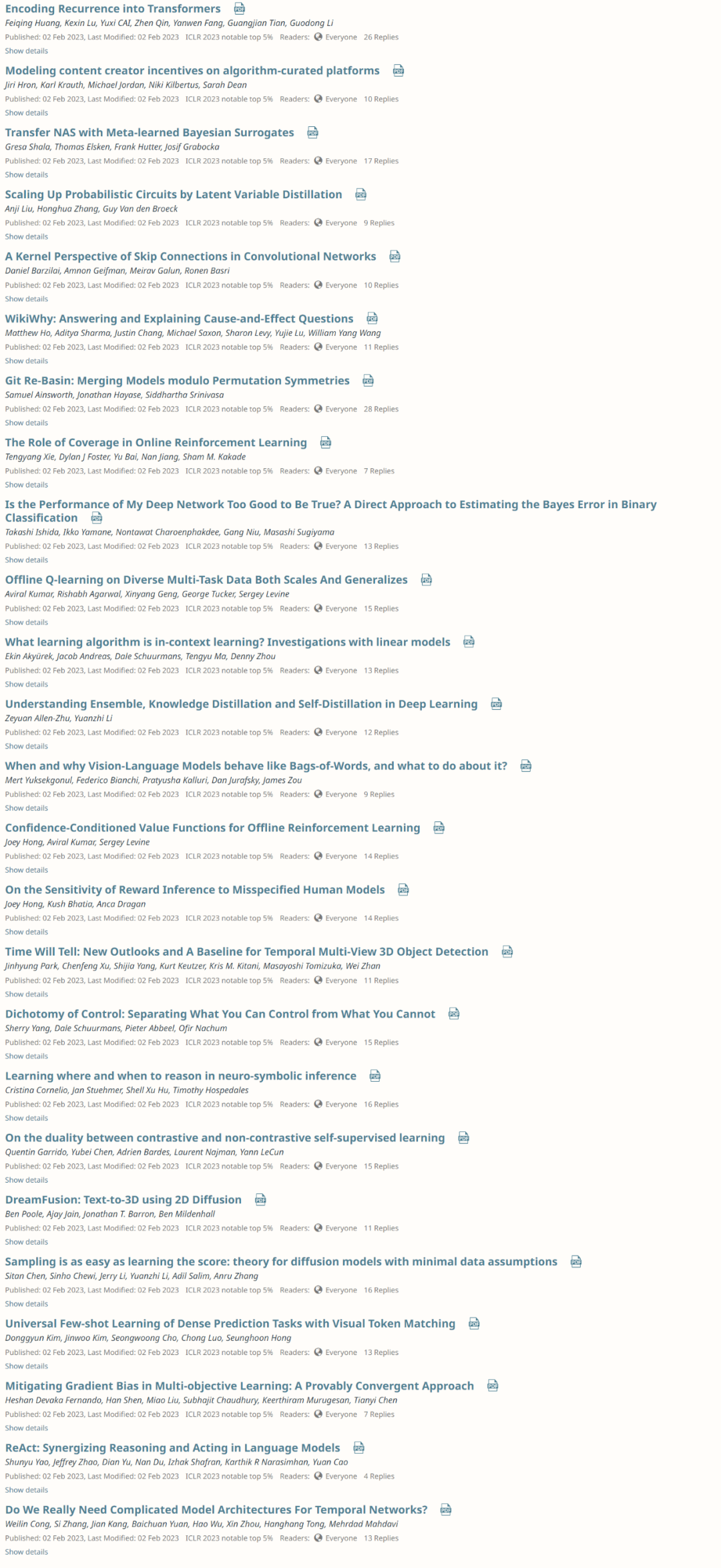

位于 top5% 論文內(nèi)容涉及 Transformer、in-context learning、擴(kuò)散模型等內(nèi)容。

top5% 論文列表截圖

論文接收列表一放出,在推特上引起了熱烈討論。

斯坦福大學(xué)計(jì)算機(jī)科學(xué)博士 Dan Fu 表示自己參與的論文中了 spotlight,他還談到,大家都在議論 Attention is all you need,但沒有人給出到底需要多少層 Attention?在這篇論文中,他們提出了一個(gè)新的生成語言模型 H3,其性能優(yōu)于 GPT-Neo-2.7B,只需要 2 個(gè) Attention 層。

KAIST AI(韓國電信公司與韓國科學(xué)技術(shù)院合作成立的 AI 研發(fā)機(jī)構(gòu))表示,他們總共有 24 篇論文被 ICLR 2023 錄取,包括 9 篇 Spotlights。

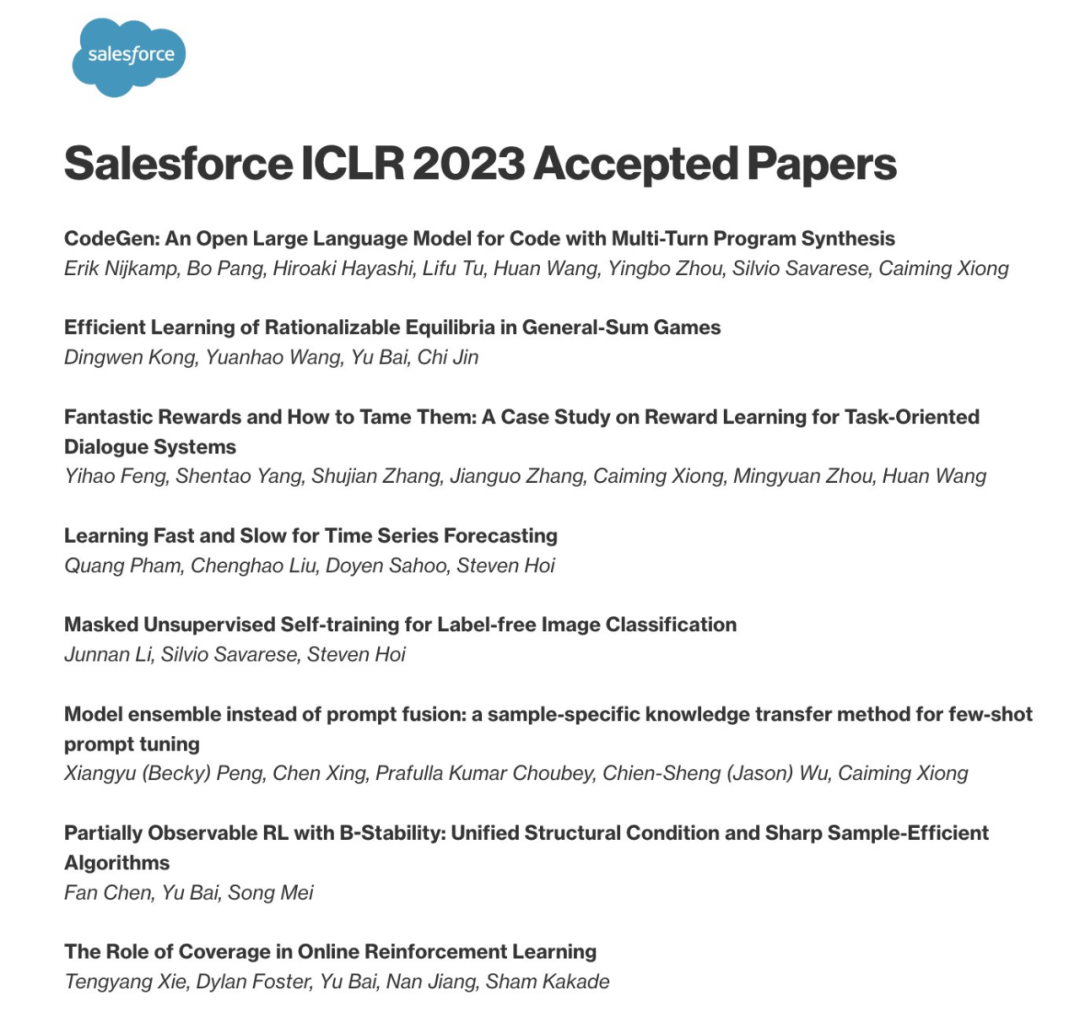

除此以外,Salesforce AI Research 也有多篇論文被接收。

在本次接收名單中,馬毅教授、Yann LeCun 等人合作撰寫的文章《Minimalistic Unsupervised Learning with the Sparse Manifold Transform》也被接收,除此以外,馬毅教授參與的另一篇關(guān)于增量學(xué)習(xí)論文也在接收列表中。

最近一段時(shí)間,生成模型發(fā)展迅速,隨之而來的風(fēng)險(xiǎn)也在增加,谷歌一篇關(guān)于大型語言模型如何更好的向用戶顯示輸出的研究也被接收:

很多網(wǎng)友都在推特上分享了論文被接收的喜悅,沒有中的小伙伴也不要灰心,爭取在接下來的頂會(huì)上有所斬獲。

審核編輯 :李倩

-

機(jī)器學(xué)習(xí)

+關(guān)注

關(guān)注

66文章

8430瀏覽量

132858 -

深度學(xué)習(xí)

+關(guān)注

關(guān)注

73文章

5511瀏覽量

121356

原文標(biāo)題:ICLR2023 | 論文列表公布,5000 篇投稿,整體接收率為 31.8%

文章出處:【微信號(hào):zenRRan,微信公眾號(hào):深度學(xué)習(xí)自然語言處理】歡迎添加關(guān)注!文章轉(zhuǎn)載請注明出處。

發(fā)布評(píng)論請先 登錄

相關(guān)推薦

IEEE MEMS 2025 中國大陸地區(qū)論文錄用情況:北京大學(xué)/中科院微系統(tǒng)所/上海交大排名前三

NPU在深度學(xué)習(xí)中的應(yīng)用

潤和軟件出席中華預(yù)防醫(yī)學(xué)會(huì)環(huán)境衛(wèi)生分會(huì)2024年學(xué)術(shù)會(huì)議

圓滿收官|(zhì) Aigtek參展第二屆波動(dòng)力學(xué)前沿與應(yīng)用學(xué)術(shù)會(huì)議載譽(yù)歸來!

Nullmax視覺感知能力再獲國際頂級(jí)學(xué)術(shù)會(huì)議認(rèn)可

邀請函| Aigtek安泰電子攜經(jīng)典產(chǎn)品,亮相第二屆波動(dòng)力學(xué)前沿與應(yīng)用學(xué)術(shù)會(huì)議!

銳思智芯展示融合視覺感知技術(shù)創(chuàng)新與產(chǎn)品應(yīng)用

中微公司受邀出席第十八屆全國MOCVD學(xué)術(shù)會(huì)議

CET中電技術(shù)邀您參加第八屆全國電能質(zhì)量學(xué)術(shù)會(huì)議暨電能質(zhì)量行業(yè)發(fā)展論壇

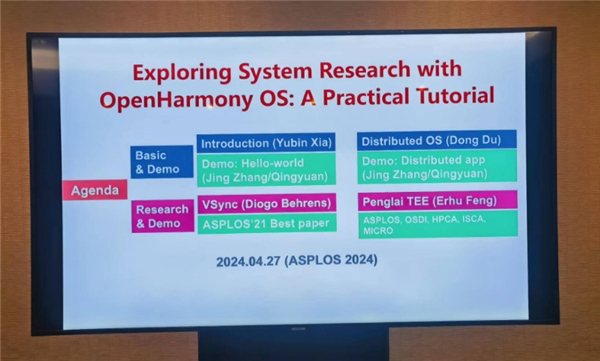

OpenHarmony 成功亮相國際學(xué)術(shù)會(huì)議 ASPLOS 2024

國科微即將出席國際頂級(jí)學(xué)術(shù)會(huì)議CPS-IoT Week2024

電壓敏學(xué)術(shù)研討委員會(huì)暨學(xué)習(xí)交流專題會(huì)議圓滿召開

OpenHarmony即將首次亮相國際頂級(jí)學(xué)術(shù)會(huì)議

Aigtek安泰電子第一屆全國等離子體生物醫(yī)學(xué)學(xué)術(shù)會(huì)議圓滿結(jié)束!

3月15-17日 與Aigtek相約第一屆全國等離子體生物醫(yī)學(xué)學(xué)術(shù)會(huì)議!

深度學(xué)習(xí)頂級(jí)學(xué)術(shù)會(huì)議ICLR 2023錄用結(jié)果已經(jīng)公布!

深度學(xué)習(xí)頂級(jí)學(xué)術(shù)會(huì)議ICLR 2023錄用結(jié)果已經(jīng)公布!

評(píng)論