主要內(nèi)容:

提出了一種新的2D-3D匹配方法,幾何輔助匹配(GAM),使用外觀信息和幾何上下文來改進2D-3D特征匹配,可以在保持高精度的同時增強2D-3D匹配的recall,將GAM插入到分層視覺定位pipeline中,表明GAM可以有效地提高定位的魯棒性和準確性,其實驗表明,GAM可以找到比手工啟發(fā)式和學(xué)習(xí)的方法更正確的匹配,在多個視覺定位數(shù)據(jù)集上獲得了最先進的結(jié)果。

Contributions:

提出了GAM,首先根據(jù)視覺外觀為每個2D點建立多個候選匹配,然后根據(jù)幾何上下文過濾不正確的匹配。

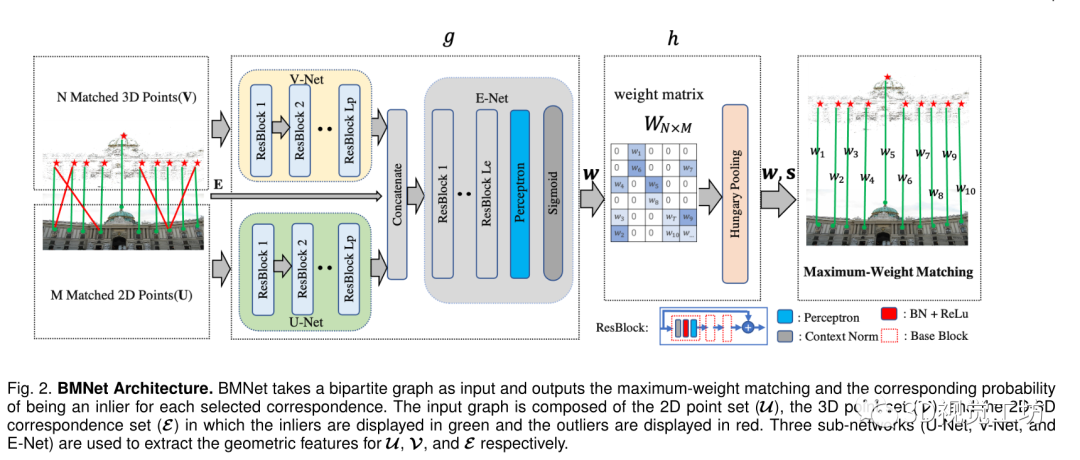

提出了一種稱為BMNet的深度神經(jīng)網(wǎng)絡(luò)來處理多對多候選匹配,它可以預(yù)測每個2D-3D匹配的幾何先驗并輸出全局最優(yōu)匹配集。

提出了一種具有新場景檢索策略的分層視覺定位方法,進一步提高了姿態(tài)估計的魯棒性。

所提出的定位方法在多個數(shù)據(jù)集上優(yōu)于最先進的方法。

幾何輔助匹配:

網(wǎng)絡(luò)架構(gòu):

Hungarian Pooling:

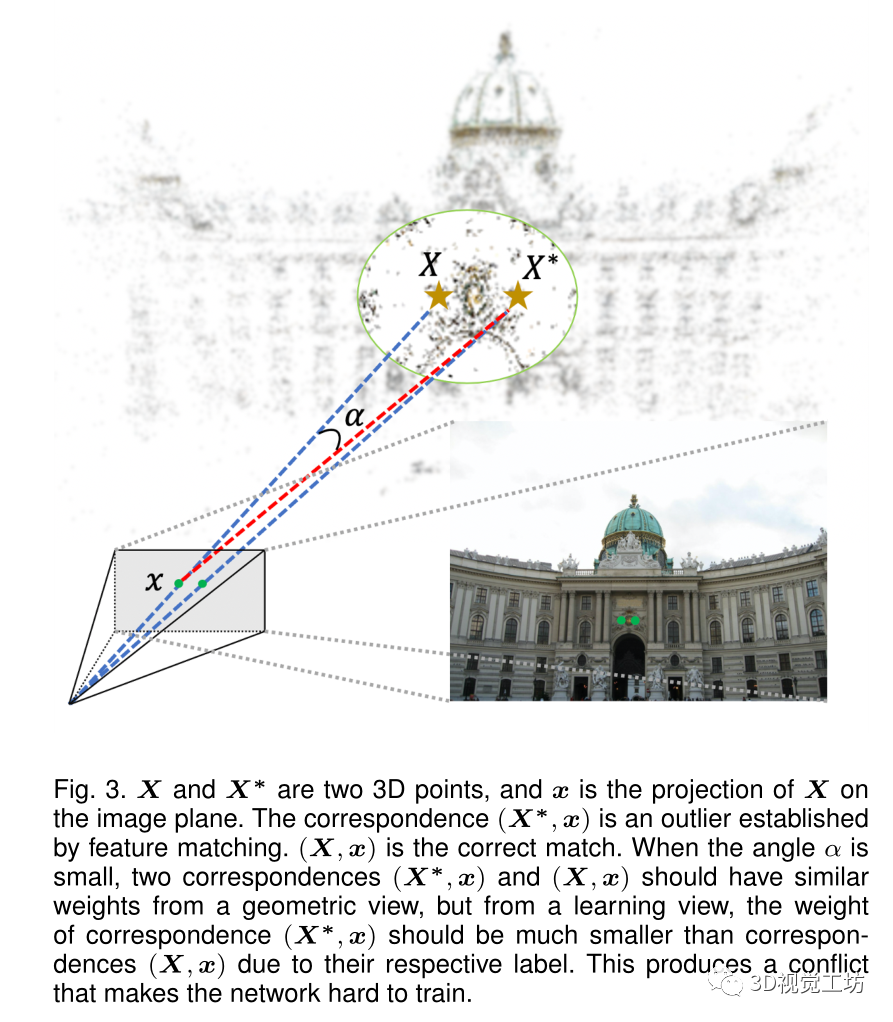

如果直接訓(xùn)練g(g;θ),網(wǎng)絡(luò)參數(shù)將很難學(xué)習(xí),因為幾何一致性可能與監(jiān)督?jīng)_突,如下圖所示。

2D圖像點與在3D空間中接近的兩個3D點匹配,在相同的相機姿勢下,它們可能都有小的重投影誤差,網(wǎng)絡(luò)易于根據(jù)提取的幾何特征為它們生成相似的權(quán)重,這兩種對應(yīng)關(guān)系都被認為是幾何一致的。

然而其中只有一個是inlier,其余的則是outlier,多個對應(yīng)具有相似的幾何特征但具有不同標簽的這種差異使得網(wǎng)絡(luò)難以收斂。

為了解決這個問題,將匈牙利算法引入到網(wǎng)絡(luò)中進行端到端訓(xùn)練。匈牙利算法可以找到全局最優(yōu)的一對一匹配,因為只選擇了兩個對應(yīng)關(guān)系中的一個,所以可以消除幾何一致性和監(jiān)督之間的差異。

基于由g(g;θ)預(yù)測的權(quán)重向量w和二分圖g,權(quán)重矩陣w被構(gòu)造為:

其中W的未填充元素被設(shè)置為0,然后將匈牙利算法應(yīng)用于該權(quán)重矩陣W獲得匹配M的最大權(quán)重。分配向量s由下列公式獲得:

由于輸出邊緣來自輸入邊緣的子集,引入匈牙利算法的層可以被視為一個特殊的采樣層,稱之為匈牙利池,端到端訓(xùn)練中使用的反向傳播公式如下:

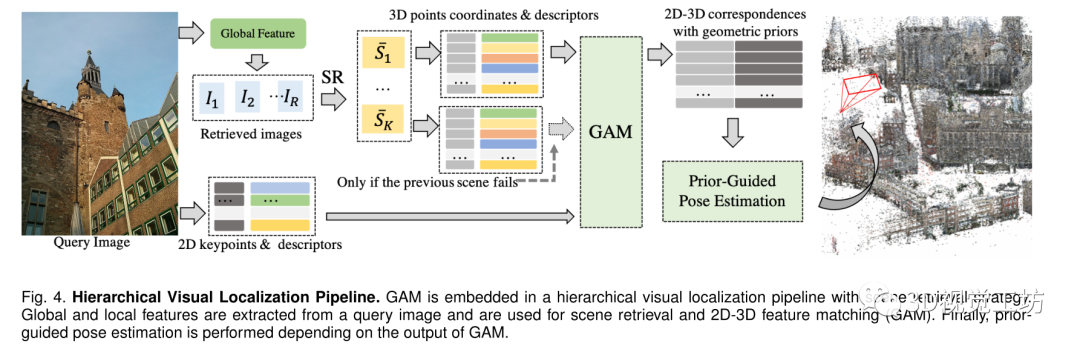

分層定位pipeline:

對于查詢圖像,提取其全局特征和局部特征,全局特征用于粗略定位以確定要匹配的3D點集,提取的局部特征和結(jié)合相應(yīng)描述符的3D點集都被送到GAM中以獲得全局最優(yōu)2D-3D對應(yīng)。

整個定位過程分為三個模塊,即場景檢索、2D-3D特征匹配和先驗引導(dǎo)姿態(tài)估計。

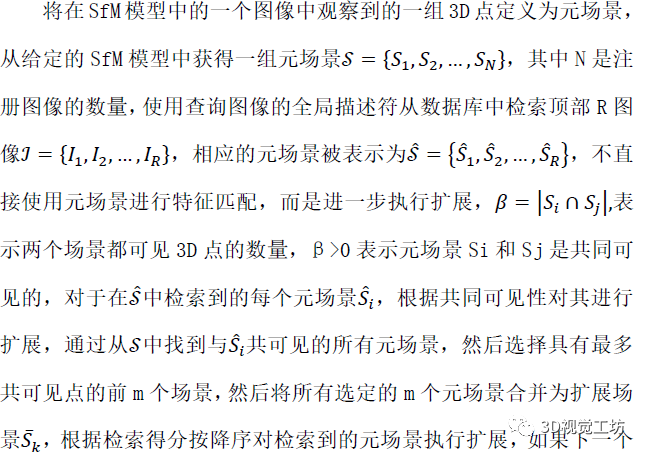

場景檢索:

2D-3D特征匹配:

根據(jù)場景檢索的順序執(zhí)行GAM并輸出匹配的2D-3D對應(yīng),對于第k個場景 ,獲取其3D點和相應(yīng)的描述子來構(gòu)建3D特征集,在從查詢圖像提取的2D局部特征和3D特征之間執(zhí)行GAM,輸出匹配M的最大權(quán)重,根據(jù)歐氏距離執(zhí)行kNN比率匹配,當(dāng)描述子被歸一化時,這可以通過矩陣運算有效地實現(xiàn)。

,獲取其3D點和相應(yīng)的描述子來構(gòu)建3D特征集,在從查詢圖像提取的2D局部特征和3D特征之間執(zhí)行GAM,輸出匹配M的最大權(quán)重,根據(jù)歐氏距離執(zhí)行kNN比率匹配,當(dāng)描述子被歸一化時,這可以通過矩陣運算有效地實現(xiàn)。

先驗引導(dǎo)的姿態(tài)估計:

由于M中仍然存在一些錯誤匹配,在RANSAC循環(huán)中應(yīng)用PnP解算器,在RANSAC loop中,采樣2D-3D對應(yīng)的概率由BMNet預(yù)測的似然決定,這使得能夠以更大的機會對可能的inlier進行采樣。

實驗:

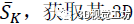

首先進行了2D-3D匹配實驗,表明GAM以比手工制作的方法和學(xué)習(xí)方法更高的精度找到更多的真實匹配。

數(shù)據(jù)集:MegaDepth數(shù)據(jù)集中選擇一個位置作為2D-3D匹配評估的測試數(shù)據(jù)集。

將GAM與傳統(tǒng)手工制作方法和學(xué)習(xí)匹配方法進行了比較 使用最近鄰(NN)匹配器從描述符空間中的每個2D點的所有3D點中找到最近鄰,手工制作的異常值剔除方法包括比率測試(ratio)、距離閾值(distance)和彼此最近的鄰居(cross check),因為沒有其他基于學(xué)習(xí)的方法直接用于2D-3D特征匹配,因此將最近提出的一些在2D-2D匹配中表現(xiàn)良好的方法遷移到2D-3D進行比較,將LGCNet和OANet的輸入從2D-2D對應(yīng)替換為2D3D對應(yīng),即LGCNet-2D3D和OANet2D3D

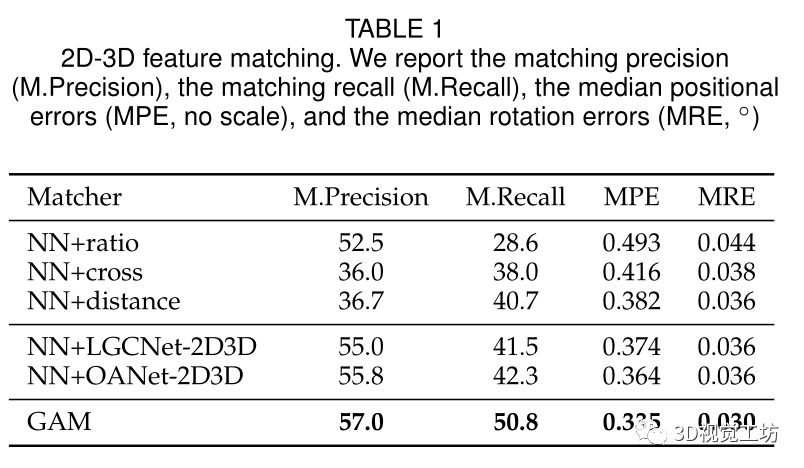

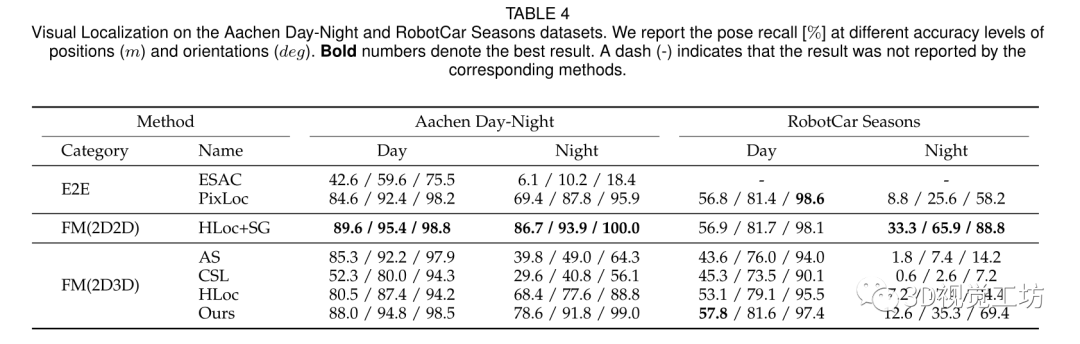

評估GAM在視覺定位方面的有效性以及提出的視覺定位框架: 數(shù)據(jù)集:Aachen Day-Night

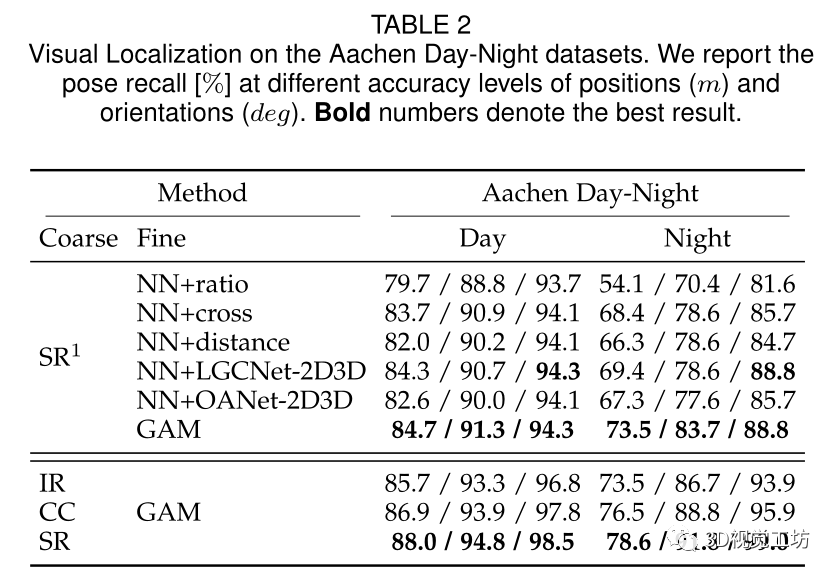

與SOTA定位方法的比較: 數(shù)據(jù)集:Cambridge Landmarks 和Aachen Day-Night

總結(jié):

提出了一種用于視覺定位的2D-3D匹配方法GAM,同時使用外觀信息和幾何上下文來提高匹配性能,在保持高精度的同時提高了2D-3D匹配的召回率,其引入了一種新的二部匹配神經(jīng)網(wǎng)絡(luò)BMNet以提取2D-3D對應(yīng)的幾何特征,并可以學(xué)習(xí)全局幾何一致性以預(yù)測每個對應(yīng)的真實匹配的可能性,還將匈牙利算法集成到BMNet中作為一個特殊的池層以端到端的方式找到最大權(quán)重匹配,使得定位能夠獲得更正確的匹配從而提高了定位的魯棒性和準確性。

審核編輯:劉清

-

神經(jīng)網(wǎng)絡(luò)

+關(guān)注

關(guān)注

42文章

4776瀏覽量

100945 -

gam

+關(guān)注

關(guān)注

0文章

5瀏覽量

7284 -

匹配器

+關(guān)注

關(guān)注

0文章

6瀏覽量

5749

原文標題:用幾何信息來輔助基于特征的視覺定位(arxiv 2022)

文章出處:【微信號:3D視覺工坊,微信公眾號:3D視覺工坊】歡迎添加關(guān)注!文章轉(zhuǎn)載請注明出處。

發(fā)布評論請先 登錄

相關(guān)推薦

多維精密測量:半導(dǎo)體微型器件的2D&3D視覺方案

一種降低VIO/VSLAM系統(tǒng)漂移的新方法

一種將NeRFs應(yīng)用于視覺定位任務(wù)的新方法

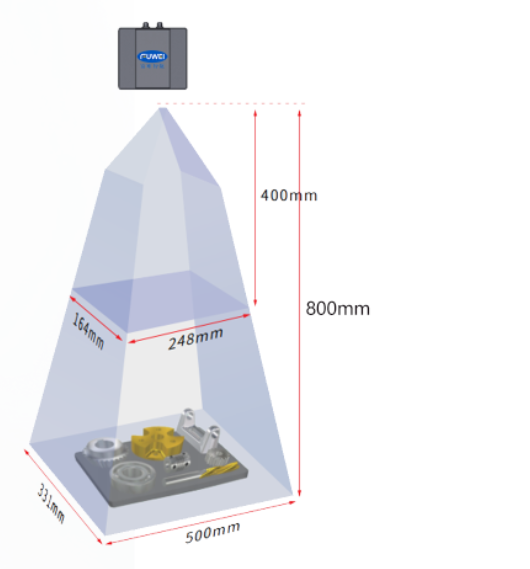

適用于3D機器視覺的高度可擴展的TI DLP技術(shù)

復(fù)合機器人搭載2D視覺和3D視覺分別有什么不同 #2D視覺 #3D視覺 #視覺定位 #視覺引導(dǎo) #復(fù)合機器人

3D視覺引導(dǎo)的多SKU紙箱拆解

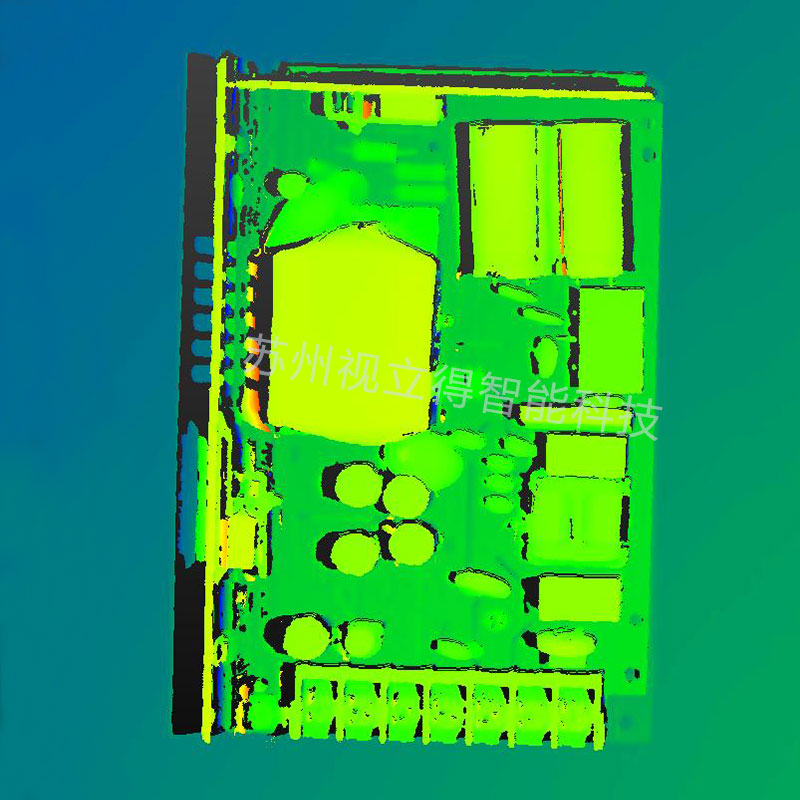

蘇州吳中區(qū)多色PCB板元器件3D視覺檢測技術(shù)

英倫科技的15.6寸2D-3D可切換光場裸眼3D顯示屏有哪些特點?

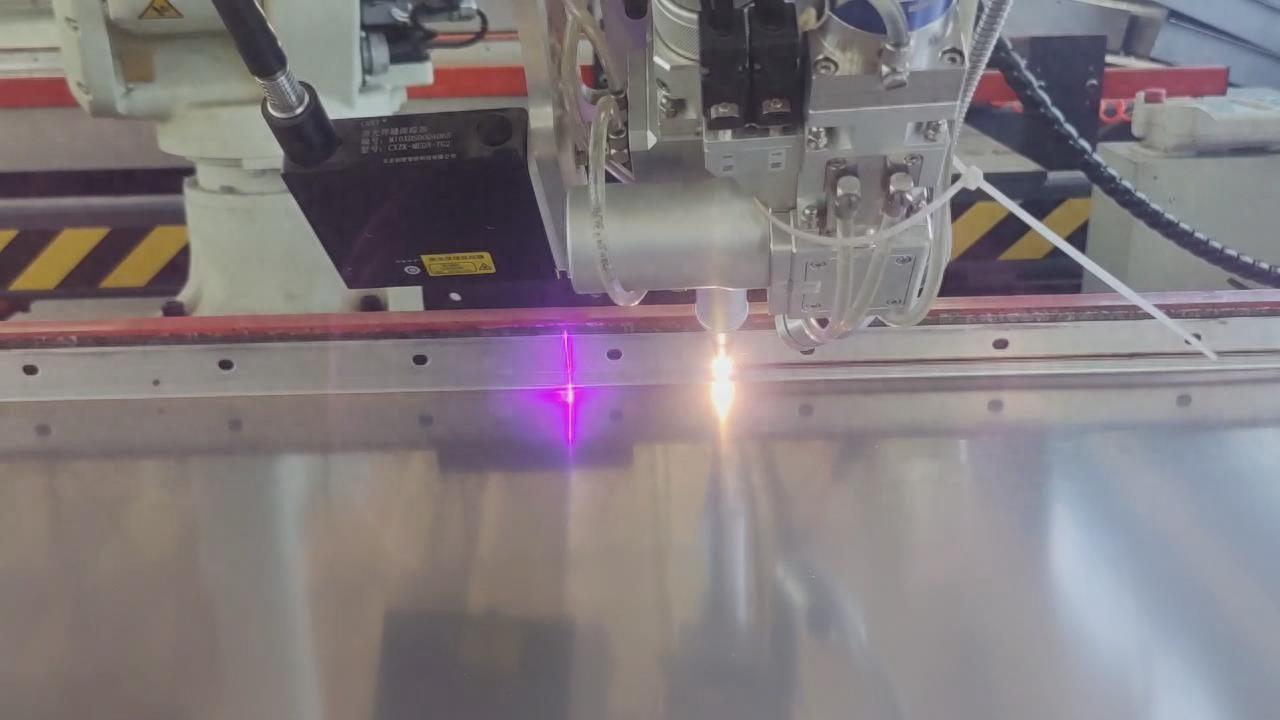

激光焊接視覺定位引導(dǎo)方法

3D視覺引導(dǎo)方案解決工廠產(chǎn)線上下料難題

Nullmax提出多相機3D目標檢測新方法QAF2D

工業(yè)自動化,3D視覺在五金件上下料中的應(yīng)用

高分工作!Uni3D:3D基礎(chǔ)大模型,刷新多個SOTA!

3D視覺引導(dǎo)3C薄片自動化上料

一種用于視覺定位的2D-3D匹配方法GAM

一種用于視覺定位的2D-3D匹配方法GAM

評論