-

一個開源完整的基于 PyTorch 的 ChatGPT 等效實現流程,涵蓋所有 3 個階段,可以幫助你構建基于預訓練模型的 ChatGPT 式服務。

-

提供了一個迷你演示訓練過程供用戶試玩,它只需要 1.62GB 的 GPU 顯存,并且可能在單個消費級 GPU 上實現,單GPU模型容量最多提升10.3 倍。

-

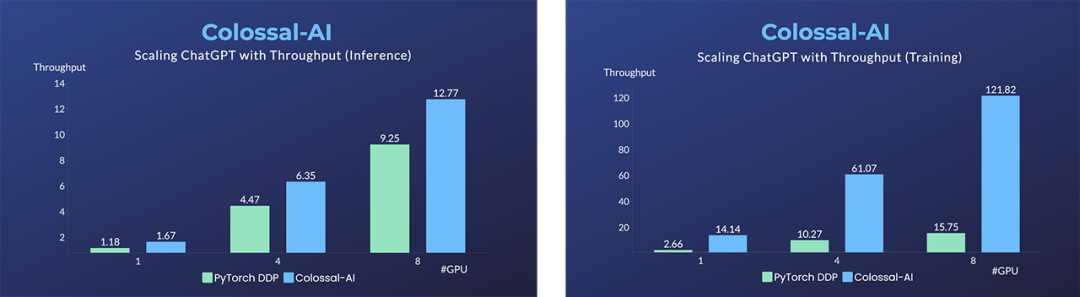

與原始 PyTorch 相比,單機訓練過程最高可提升7.73 倍,單 GPU 推理速度提升 1.42 倍,僅需一行代碼即可調用。

-

在微調任務上,同樣僅需一行代碼,就可以在保持足夠高的運行速度的情況下,最多提升單GPU的微調模型容量3.7 倍。

-

提供多個版本的單 GPU 規(guī)模、單節(jié)點多 GPU 規(guī)模和原始 1750 億參數規(guī)模。還支持從 Hugging Face 導入 OPT、GPT-3、BLOOM 和許多其他預訓練的大型模型到你的訓練過程中。

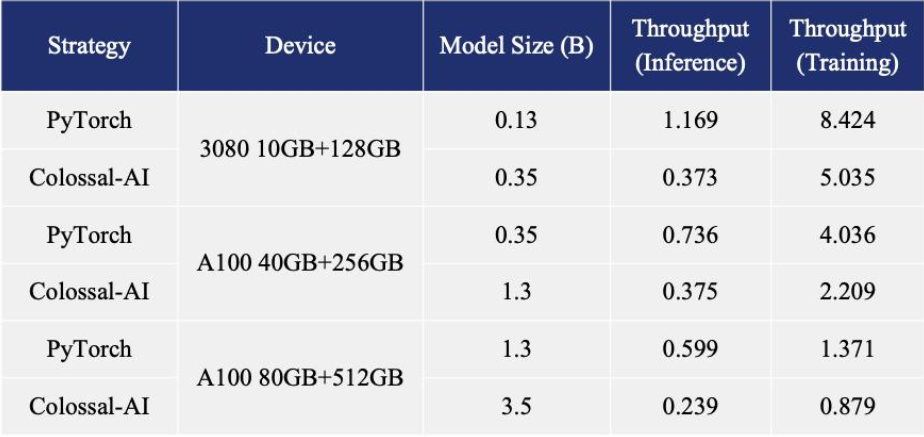

博客內容還指出,在單機多 GPU 服務器上,即便使用最高端的 A100 80GB 顯卡,由于 ChatGPT 的復雜性和內存碎片,PyTorch 最大僅能啟動基于 GPT-L(774M)這樣的小模型的 ChatGPT。用 PyTorch 原生的 DistributedDataParallel (DDP) 進行多卡并行擴展至 4 卡或 8 卡,性能提升有限。Colossal-AI 不僅在單GPU速度上訓練和推理優(yōu)勢明顯,隨著并行規(guī)模擴大還可進一步提升,最高可提升單機訓練速度 7.73 倍,單 GPU 推理速度 1.42 倍;并且能夠繼續(xù)擴展至大規(guī)模并行,顯著降低 ChatGPT 復現成本。

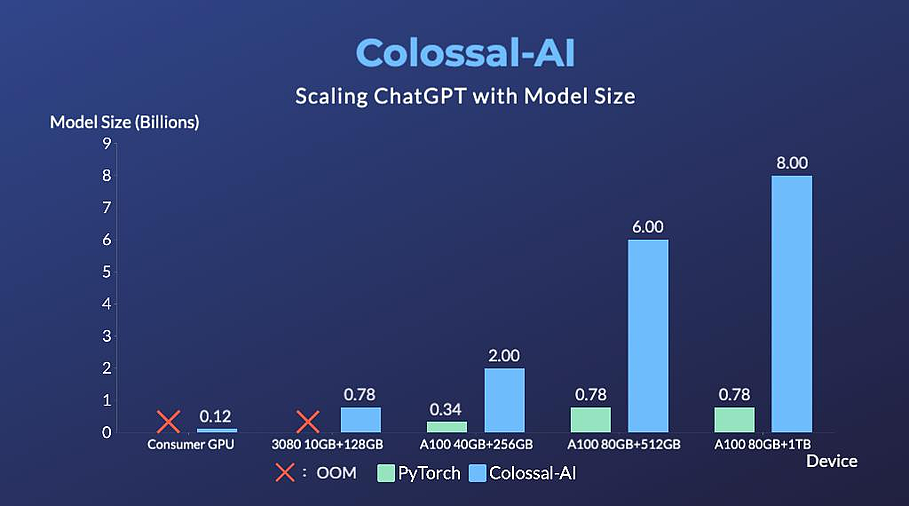

博客內容還指出,在單機多 GPU 服務器上,即便使用最高端的 A100 80GB 顯卡,由于 ChatGPT 的復雜性和內存碎片,PyTorch 最大僅能啟動基于 GPT-L(774M)這樣的小模型的 ChatGPT。用 PyTorch 原生的 DistributedDataParallel (DDP) 進行多卡并行擴展至 4 卡或 8 卡,性能提升有限。Colossal-AI 不僅在單GPU速度上訓練和推理優(yōu)勢明顯,隨著并行規(guī)模擴大還可進一步提升,最高可提升單機訓練速度 7.73 倍,單 GPU 推理速度 1.42 倍;并且能夠繼續(xù)擴展至大規(guī)模并行,顯著降低 ChatGPT 復現成本。 為了最大限度地降低培訓成本和易用性,Colossal-AI 提供了可以在單個 GPU 上試用的 ChatGPT 培訓流程。與在 14999 美元的 A100 80GB 上最多只能啟動 7.8 億個參數模型的 PyTorch 相比,Colossal-AI 將單個 GPU 的容量提升了 10.3 倍,達到 80 億個參數。對于基于 1.2 億參數的小模型的 ChatGPT 訓練,至少需要 1.62GB 的 GPU 內存,任意單個消費級 GPU 都可以滿足。

為了最大限度地降低培訓成本和易用性,Colossal-AI 提供了可以在單個 GPU 上試用的 ChatGPT 培訓流程。與在 14999 美元的 A100 80GB 上最多只能啟動 7.8 億個參數模型的 PyTorch 相比,Colossal-AI 將單個 GPU 的容量提升了 10.3 倍,達到 80 億個參數。對于基于 1.2 億參數的小模型的 ChatGPT 訓練,至少需要 1.62GB 的 GPU 內存,任意單個消費級 GPU 都可以滿足。 此外,Colossal-AI 還在致力于降低基于預訓練大型模型的微調任務的成本。以 ChatGPT 可選的開源基礎模型 OPT 為例,Colossal-AI 能夠在單 GPU 上將微調模型的容量提高到 PyTorch 的 3.7 倍,同時保持高速運行。Colossal-AI 為 Hugging Face 社區(qū)的 GPT、OPT 和 BLOOM 等主流預訓練模型,提供了開箱即用的 ChatGPT 復現代碼。以 GPT 為例,僅需一行代碼,指定使用 Colossal-AI 作為系統(tǒng)策略即可快速使用。

此外,Colossal-AI 還在致力于降低基于預訓練大型模型的微調任務的成本。以 ChatGPT 可選的開源基礎模型 OPT 為例,Colossal-AI 能夠在單 GPU 上將微調模型的容量提高到 PyTorch 的 3.7 倍,同時保持高速運行。Colossal-AI 為 Hugging Face 社區(qū)的 GPT、OPT 和 BLOOM 等主流預訓練模型,提供了開箱即用的 ChatGPT 復現代碼。以 GPT 為例,僅需一行代碼,指定使用 Colossal-AI 作為系統(tǒng)策略即可快速使用。

from chatgpt.nn import GPTActor, GPTCritic, RewardModel

from chatgpt.trainer import PPOTrainer

from chatgpt.trainer.strategies import ColossalAIStrategy

strategy = ColossalAIStrategy(stage=3, placement_policy='cuda')

with strategy.model_init_context():

actor = GPTActor().cuda()

critic = GPTCritic().cuda()

initial_model = deepcopy(actor).cuda()

reward_model = RewardModel(deepcopy(critic.model)).cuda()

trainer = PPOTrainer(strategy, actor, critic, reward_model, initial_model,...)

trainer.fit(prompts)

審核編輯 :李倩-

gpu

+關注

關注

28文章

4760瀏覽量

129134 -

服務器

+關注

關注

12文章

9255瀏覽量

85752 -

ChatGPT

+關注

關注

29文章

1564瀏覽量

7863

原文標題:開源方案低成本復現ChatGPT流程,僅需1.6GB顯存即可體驗

文章出處:【微信號:OSC開源社區(qū),微信公眾號:OSC開源社區(qū)】歡迎添加關注!文章轉載請注明出處。

發(fā)布評論請先 登錄

相關推薦

香蕉派開源社區(qū)與矽昌通信共推BPI-Wifi5 低成本路由器開源方案

低成本藍牙串口模塊解決方案

追求性能提升 使用8GB HBM2顯存

科技大廠競逐AIGC,中國的ChatGPT在哪?

低成本遙控器線路ICHQ1628產品規(guī)格書

堅果Pro 3開啟了促銷活動最高直降500元8GB+128GB版僅需2399元

榮耀V30 PRO在5G網絡環(huán)境下下載一部1.6GB大小的1080P電影僅需2分鐘

華為Mate 20降價促銷 6+128GB版僅需2199元

源2.0-M32大模型發(fā)布量化版 運行顯存僅需23GB 性能可媲美LLaMA3

開源方案低成本復現ChatGPT流程,僅需1.6GB顯存即可體驗

開源方案低成本復現ChatGPT流程,僅需1.6GB顯存即可體驗

評論