0. 引言

基于特征點法的視覺SLAM系統很難應用于稠密建圖,且容易丟失動態對象。而基于直接法的SLAM系統會跟蹤圖像幀之間的所有像素,因此在動態稠密建圖方面可以取得更完整、魯棒和準確的結果。本文將帶大家精讀2022 CVPR的論文:"基于學習視覺里程計的動態稠密RGB-D SLAM"。該論文提出了一種基于直接法的動態稠密SLAM方案,重要的是,算法已經開源。

1. 論文信息

摘要

我們提出了一種基于學習的視覺里程計(TartanVO)的稠密動態RGB-D SLAM系統。TartanVO與其他直接法而非特征點法一樣,通過稠密光流來估計相機姿態。而稠密光流僅適用于靜態場景,且不考慮動態對象。同時由于顏色不變性假設,光流不能區分動態和靜態像素。

因此,為了通過直接法重建靜態地圖,我們提出的系統通過利用光流輸出來解決動態/靜態分割,并且僅將靜態點融合到地圖中。此外,我們重新渲染輸入幀,以便移除動態像素,并迭代地將它們傳遞回視覺里程計,以改進姿態估計。

3. 算法分析

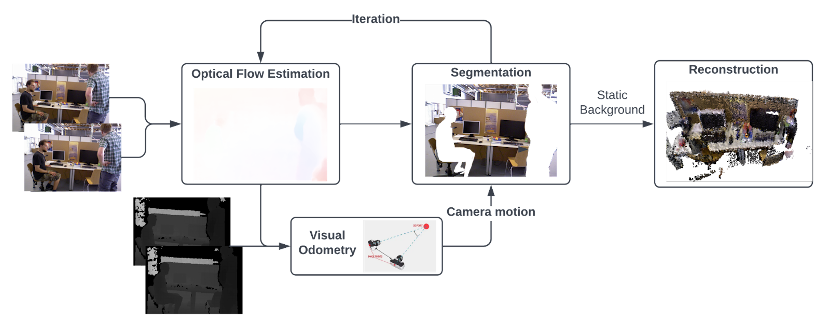

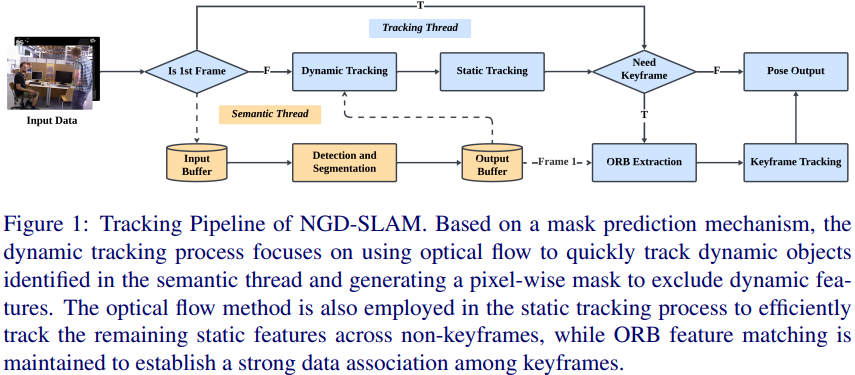

圖1所示是作者提出的具有基于學習的視覺里程計的動態稠密RGB-D SLAM的頂層架構,其輸出的地圖是沒有動態對象的稠密全局地圖。 算法的主要思想是從兩個連續的RGB圖像中估計光流,并將其傳遞到視覺里程計中,以通過匹配點作為直接法來預測相機運動。然后通過利用光流來執行動態分割,經過多次迭代后,移除動態像素,這樣僅具有靜態像素的RGB-D圖像就被融合到全局地圖中。

圖1 基于學習的視覺里程計的動態稠密RGB-D SLAM頂層架構

3.1 分割算法

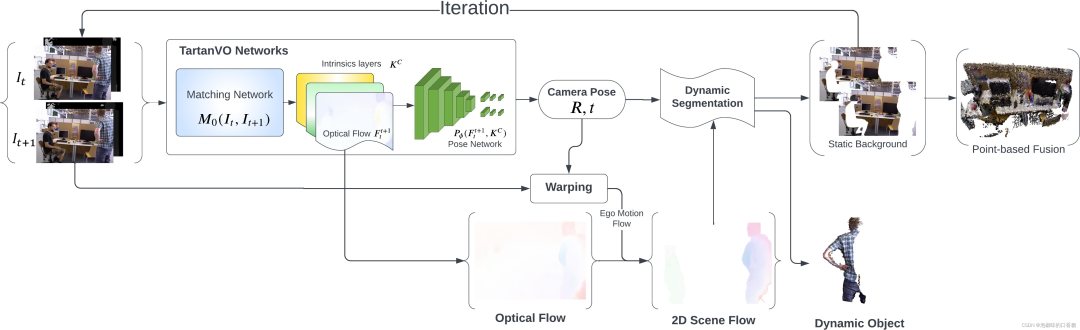

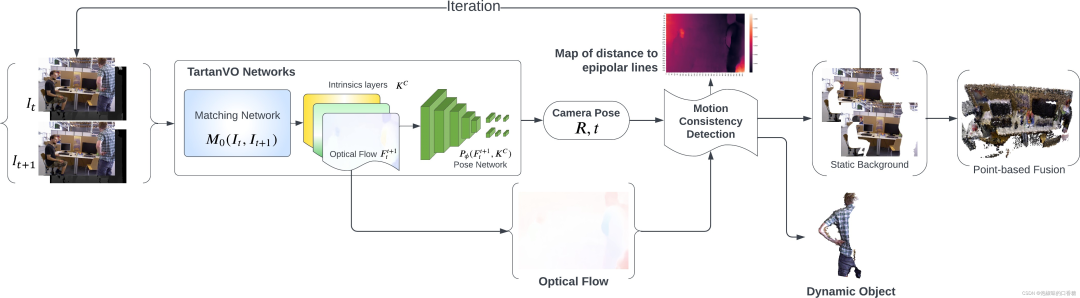

為了利用來自TartanVO的光流輸出來分類動態/靜態像素,作者提出了兩種分割方法:一種是使用2D場景流作為光流和相機運動之間的差值。另一種是提取一幀中的像素到它們匹配的核線的幾何距離。圖2和圖3所示分別為兩種方法的算法原理。

圖2 使用基于2D場景流的分割的稠密RGB-D SLAM架構

圖3 基于運動一致性檢測的稠密RGB-D SLAM架構

在圖2中,作者首先使用來自TartanVO的匹配網絡從兩個連續的RGB圖像中估計光流,隨后使用姿態網絡來預測相機運動。然后通過從光流中減去相機自身運動來獲得2D場景流,并通過對2D場景流進行閾值處理來執行動態分割。 同時,靜態背景被前饋到網絡,以實現相機運動的迭代更新。

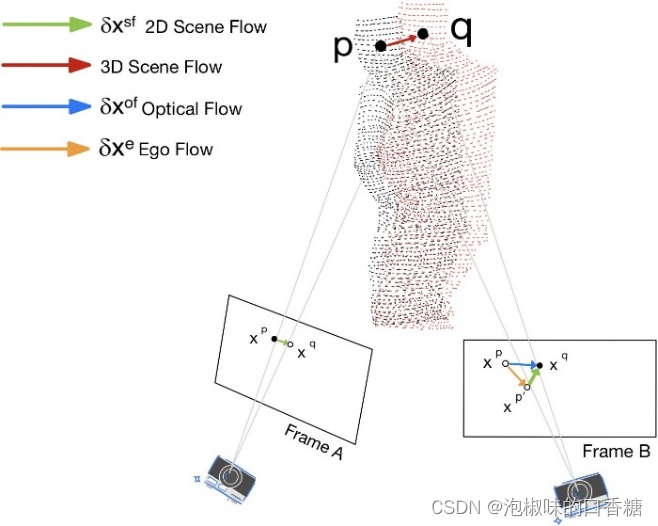

經過幾次迭代后,動態像素被移除,僅具有靜態像素的RGB-D圖像被傳遞到基于點的融合中進行重建。圖4所示為使用2D場景流進行動態像素分割的原理。

圖4 圖像平面中投影的2D場景流

在圖3中,作者首先使用來自TartanVO的匹配網絡從兩個連續的RGB圖像中估計光流,隨后使用姿態網絡來預測相機運動。 然后計算從第二幀中的像素到它們的對應核線的距離,其中核線使用光流從匹配像素中導出。

最后通過距離閾值化來執行動態分割。經過幾次迭代后,動態像素被移除,僅具有靜態像素的RGB-D圖像被傳遞到基于點的融合中進行重建。

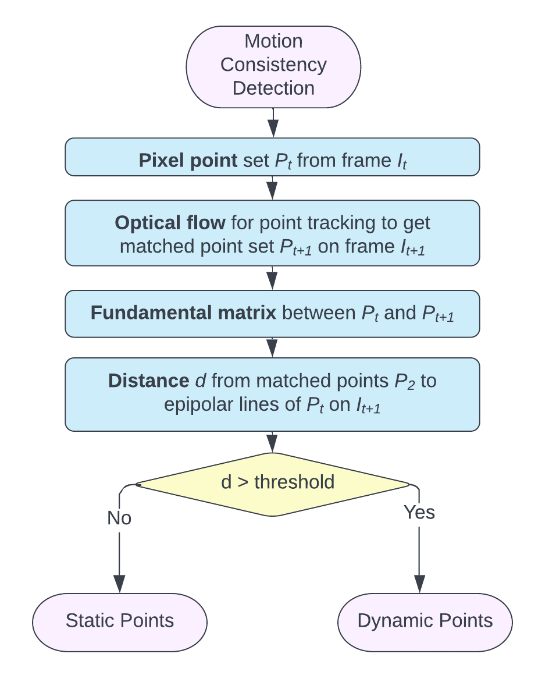

圖3所示的動態稠密框架基于的思想是:如果場景中沒有動態物體,那么第二幀圖像中的每個像素應該在其第一幀圖像匹配像素的核線上。 在這種情況下,可以使用給定的相機位姿、光流和內在特性進行分割,而不是將第一幀圖像直接投影到第二幀。這種方法也被作者稱為"運動一致性"檢測。

圖5所示是運動一致性的細節檢測原理。該算法首先獲得匹配的像素對,即每對圖像中的像素直接施加光流矢量到第一幀上,并計算具有匹配像素對的基礎矩陣。 然后,再計算每個像素的對應核線基本矩陣和像素的位置。當第二幀中匹配像素與它的核線大于閾值時,它被分類作為動態像素。

圖5 運動一致性檢測的算法原理

3.2 迭代和融合

在RGB-D圖像中僅剩下靜態像素后,作者迭代地將其傳遞回TartanVO進行改進光流估計,從而獲得更精確的相機姿態。理想情況下,通過足夠的迭代,分割掩模將移除與動態對象相關聯的所有像素,并且僅在圖像中留下靜態背景。 同時作者發現,即使使用粗糙的掩模,仍然可以提高TartanVO的ATE。另外,如果粗掩模允許一些動態像素進入最終重建,那么它們將很快從地圖中移除。

經過固定次數的迭代后,將去除了大多數動態像素的細化圖像對與其對應的深度對一起進行融合。數據融合首先將輸入深度圖中的每個點與全局圖中的點集投影關聯,使用的方法是將深度圖渲染為索引圖。 如果找到相應的點,則使用加權平均將最可靠的點與新點估計合并。

如果沒有找到可靠的對應點,則估計的新點作為不穩定點被添加到全局圖中。

隨著時間的推移,清理全局地圖,以去除由于可見性和時間約束導致的異常值,這也確保了來自分割的假陽性點將隨著時間的推移而被丟棄。因為作者利用稠密的光流并在每個像素上分割圖像而不進行下采樣,所以算法可以重建稠密的RGB-D全局圖。

4. 實驗

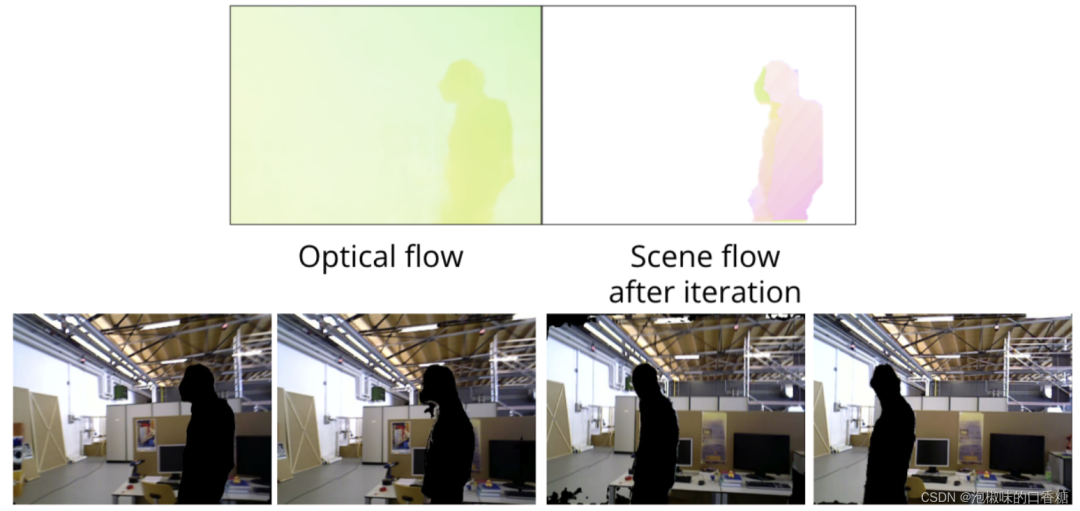

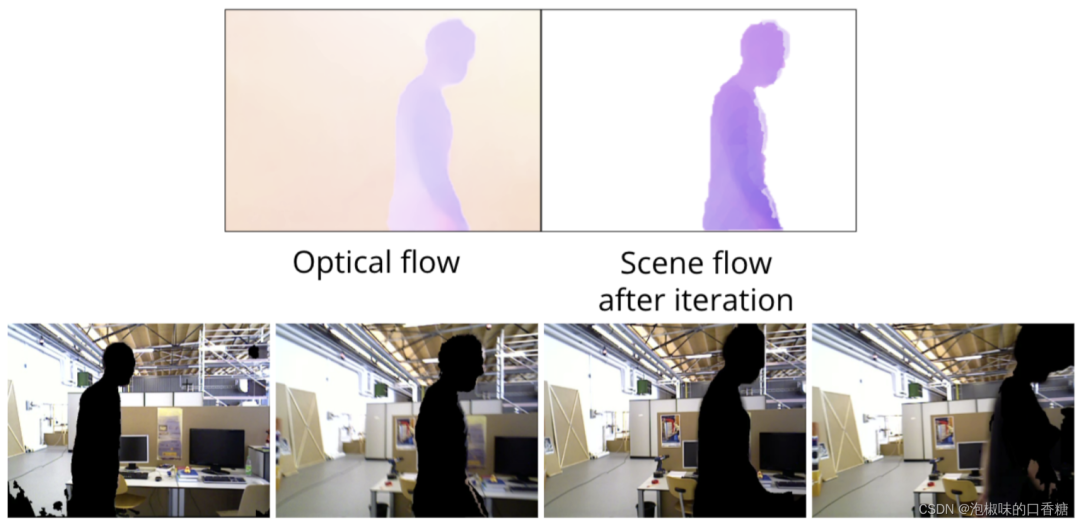

作者使用TUM數據集中的freiburg3行走xyz序列,圖6和圖7所示為使用2D場景流的分割結果。

圖6 基于2D場景流動態分割向左移動的對象

圖7 基于2D場景流動態分割向右移動的對象

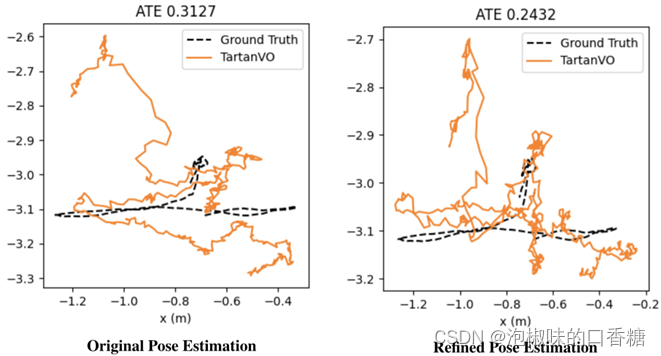

隨后,作者迭代地將重新渲染的圖像對傳遞回TartanVO。作者認為這一操作將改進光流估計,并且獲得更精確的相機姿態,如圖8所示是實驗結果。其中左圖是使用原始TartanVO的絕對軌跡誤差,右圖是使用改進TartanVO的絕對軌跡誤差。實驗結果顯示,如果有足夠的迭代,分割過程將移除動態物體中的大多數像素,并且僅保留靜態背景。

圖8 原始TartanVO和回環優化的軌跡誤差對比結果

圖9所示是在TUM整個freiburg3行走xyz序列上的重建結果,結果顯示動態對象(兩個移動的人)已經從場景中移除,只有靜態背景存儲在全局地圖中。

圖9 基于點融合的三維重建結果

此外,為了進行不同方法的對比,作者首先嘗試掩蔽原始圖像以濾除對應于3D中的動態點的像素,然后,在此之上嘗試用在先前圖像中找到的匹配靜態像素來修補空缺,但降低了精度。與產生0.1248的ATE的TartanVO方法相比,原始掩蔽方法產生了更理想的光流,而修補方法產生因為產生過多的偽像而阻礙了光流的計算。如圖10所示是對比結果。

圖10 tartan VO的三種輸入類型對比

5.結論

在2022 CVPR論文"Dynamic Dense RGB-D SLAM using Learning-based Visual Odometry"中,作者提出了一種全新的動態稠密RGB-D SLAM框架,它是一種基于學習視覺里程計的方法,用于重建動態運動物體干擾下的靜態地圖。重要的是,算法已經開源,讀者可在開源代碼的基礎上進行二次開發。

此外,作者也提到了基于該論文的幾個重要的研究方向:

(1) 引入自適應閾值機制,通過利用流、姿態和地圖等來為分割提供更一致的閾值。

(2) 在預訓練的基于學習的視覺里程計中,使用對相機姿態和光流的BA來補償大范圍運動感知。

(3) 使用動態感知迭代最近點(ICP)算法來代替TartanVO中的姿態網絡。

(4) 在更多樣化的數據集上進行測試和迭代,以提供更好的魯棒性。

審核編輯:劉清

-

RGB

+關注

關注

4文章

800瀏覽量

58597 -

SLAM

+關注

關注

23文章

425瀏覽量

31878 -

ATE

+關注

關注

5文章

124瀏覽量

26652 -

ICP

+關注

關注

0文章

70瀏覽量

12801

原文標題:基于學習視覺里程計的動態稠密RGB-D SLAM

文章出處:【微信號:3D視覺工坊,微信公眾號:3D視覺工坊】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

相關推薦

從基本原理到應用的SLAM技術深度解析

一種基于動態口令和動態ID的遠程認證方案

一種適用于動態場景的SLAM方法

一種基于RBPF的、優化的激光SLAM算法

基于增強動態稠密軌跡特征的視頻布料材質識別

3D重建的SLAM方案算法解析

一種基于直接法的動態稠密SLAM方案

一種基于直接法的動態稠密SLAM方案

評論