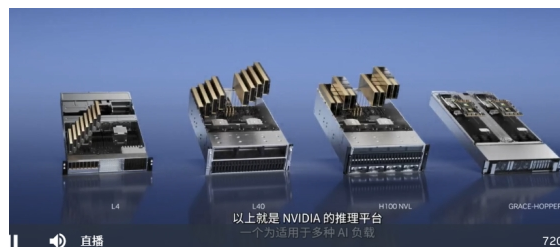

針對ChatGPT等大型語言模型的推理,我們宣布推出一款新的Hopper GPU配備雙GPU NVLINK的PCIE H100

同時還可支持商用PCIE服務器輕松擴展

目前在云上唯一可以實際處理ChatGPT的GPU是HGX A100與適用于GPT-3處理的HGX A100相比,一臺搭載四對H100及雙GPU NVLINK的標準服務器的速度

H100可將大型語言模型的處理成本,降低一個數量級

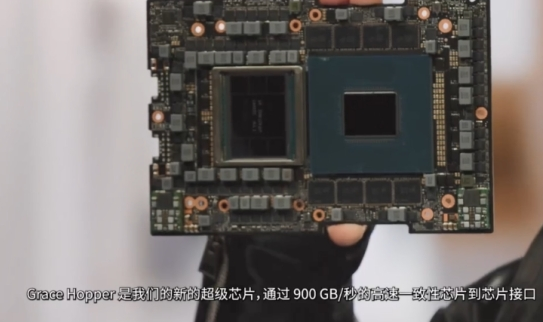

Grace Hopper非常適合處理大型數據集,例如適用于推薦系統和大型語言模型的AI數據庫。

如今,利用大容量內存,CPU會存儲和查詢巨型嵌入表,然后將結果傳輸到GPU進行推理,借助Grace-Hopper, Grace可以查詢嵌入表,并將結果直接傳輸到Hopper速度比PCIE快7倍

GTC 2023主題直播地址:https://t.elecfans.com/live/2302.html

-

cpu

+關注

關注

68文章

10989瀏覽量

214812 -

服務器

+關注

關注

12文章

9547瀏覽量

86834 -

gtc

+關注

關注

0文章

73瀏覽量

4529 -

ChatGPT

+關注

關注

29文章

1584瀏覽量

8549

發布評論請先 登錄

相關推薦

立訊技術亮相英偉達GTC 2025大會

英偉達GTC25亮點:NVIDIA Blackwell Ultra 開啟 AI 推理新時代

新思科技亮相英偉達GTC 2025大會

軟銀升級人工智能計算平臺,安裝4000顆英偉達Hopper GPU

英偉達:Hopper芯片需求強勁 英偉達發言人談生產增長

英偉達GPU新品規劃與HBM市場展望

英偉達去年數據中心GPU出貨量占比約98%

亞馬遜AWS暫緩訂購英偉達Grace Hopper,等待新品Grace Blackwel

英偉達靜候新品來臨,亞馬遜暫緩購買Grace Hopper

進一步解讀英偉達 Blackwell 架構、NVlink及GB200 超級芯片

英偉達、AMD、英特爾GPU產品及優勢匯總

全面解讀英偉達NVLink技術

評論