1 分鐘的舞蹈動畫,美術手工制作或需 20 多天,用 AIxPose 輔助制作僅需 3 天,整個流程縮短了 80% 以上。

AIGC 又出新魔法了! 不用動畫師手 K、慣捕或光捕,只需提供一段視頻,這個 AI 動捕軟件就能自動輸出動作。僅需短短幾分鐘,虛擬人的動畫制作就搞定了。

? 不僅是四肢大框架動作,連手部的細節都能精準捕捉。

除了單視角視頻,還能支持多個視角的視頻,相比其他只支持單目識別的動捕軟件,該軟件能提供更高的動捕質量。

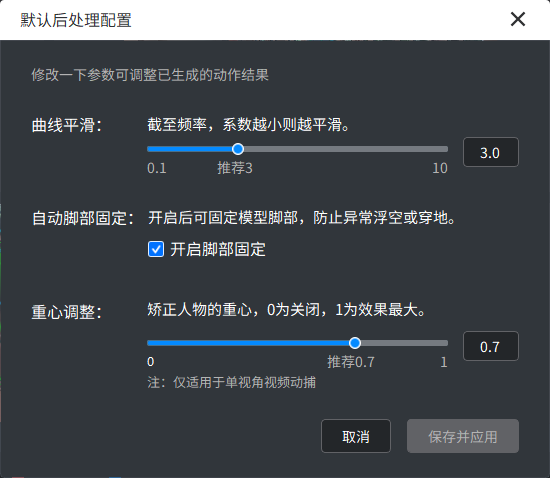

同時,該軟件還支持對識別的人體關鍵點、平滑度、腳步細節等進行編輯修改。從普通玩家的興趣體驗,到硬核玩家的專業需求,它都可滿足。

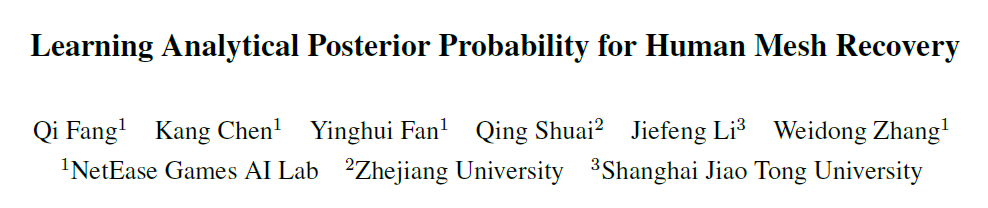

這就是網易互娛 AI Lab 深根多年、結合專業美術反饋不斷迭代優化、低調開發的 AIxPose 視頻動捕軟件。據悉,該軟件已經處理了超過數十個小時的視頻資源,并應用于游戲劇情動畫、熱門舞蹈動畫等資源的制作流程。經實際項目驗證,1 分鐘的舞蹈動畫,美術手工制作或需 20 多天,用 AIxPose 輔助制作僅需 3 天,整個流程縮短了 80% 以上。 近日,網易互娛 AI Lab 基于開發該軟件的經驗,并結合在動捕領域的相關研究工作進行了整理,其所撰寫的論文《Learning Analytical Posterior Probability for Human Mesh Recovery》被計算機視覺頂會 CVPR 2023 接收。

主頁地址:https://netease-gameai.github.io/ProPose/

論文地址:https://netease-gameai.github.io/ProPose/static/assets/CVPR2023_ProPose.pdf

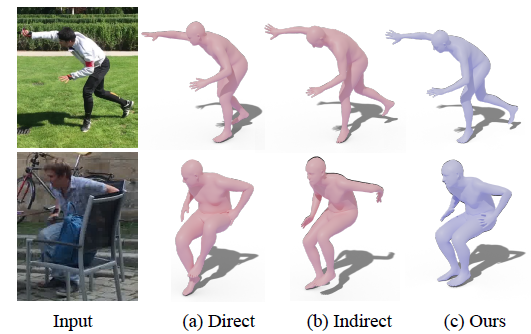

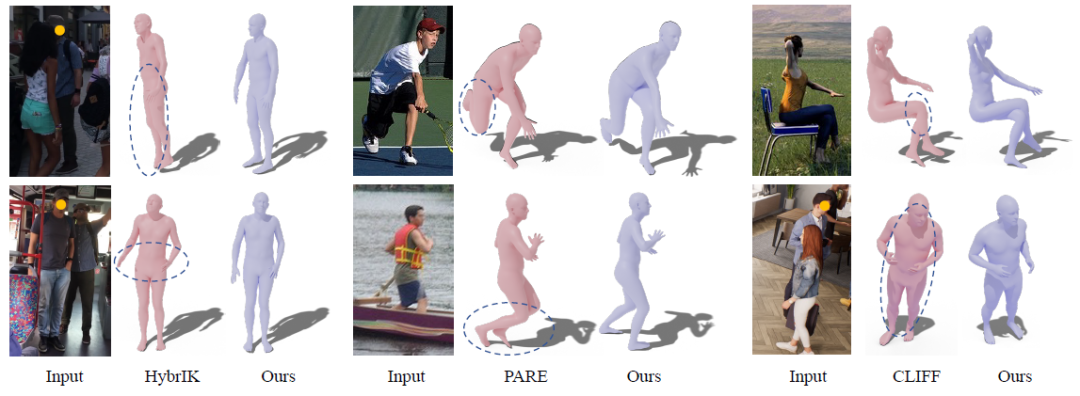

該論文創新性地提出了一種基于后驗概率的視頻動捕技術 ProPose,能夠在單張圖像、多傳感器融合等不同設定下實現準確的三維人體姿態估計。技術精度比使用先驗的基準概率方法高了 19%,且在公開數據集 3DPW、Human3.6M 和 AGORA 上均超越了過去的方法。此外,對于多傳感器融合任務,該技術也能達到比基準模型更高的精度,且無需因為引入新傳感器而修改神經網絡的骨干部分。 技術背景 本研究的任務是從 RGB 圖像中預測人體姿態和外形(human mesh recovery, hmr),現有的方法可以歸納為兩類:直接法和間接法。直接法采用神經網絡端到端地回歸人體關節的旋轉表示(如軸角、旋轉矩陣、6D 向量等),而間接法先預測一些中間表示(如三維關鍵點、分割等),然后通過這些中間表示得到關節旋轉。 然而,這兩類方法都存在著一些問題。對于直接法而言,由于這類方法需要網絡直接學習旋轉這類抽象表示,與學習關鍵點、分割相比,學習旋轉相對困難,因此網絡輸出的結果有時候很難和圖像對齊,且無法完成一些大幅度的動作,如下圖 (a) 第一行的右腳無法完全向后伸展。與之相比,間接法一般能產生更高的精度,但是這類方法的表現很大程度上依賴于中間表示的準確性,當中間表示由于噪聲產生誤差時,容易讓最終的旋轉出現相當明顯的錯誤,如下圖 (b) 第二行的左手所示。

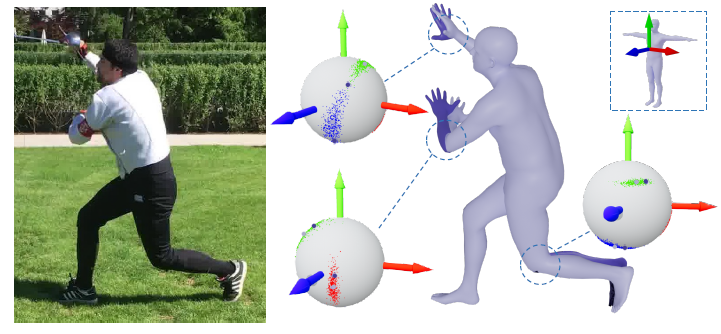

除了前述這些確定性的方法,還有一些方法通過學習某些概率分布來建模人體姿態的不確定性,從而將噪聲納入考慮,提高系統魯棒性。目前主要的概率建模方式包括多元高斯分布、標準化流、神經網絡隱式建模等,但是這些非 SO (3) 上的概率分布無法真實地反映關節旋轉的不確定性。比如在不確定性較大時,高斯分布在 SO (3) 上的局部線性假設不成立。近期的一篇工作直接用網絡學習了 matrix Fisher 分布的參數,雖然這是一種 SO (3) 上的分布,但該方法的學習方式和直接法類似,收斂表現無法和現有的間接法相比。 為了同時兼顧高準確性和魯棒性,提升概率方法的性能,ProPose 推導了關節旋轉的解析后驗概率,不僅能夠受益于不同觀測變量帶來的高精度,也能衡量不確定性,盡可能減弱噪聲對算法的影響。如下圖所示,對于輸入的圖片,ProPose 可以通過輸出的概率分布一定程度上度量該關節旋轉在各個方向的不確定性,如右手沿著手臂軸的旋轉、左手臂上下擺動的朝向、左小腿遠近的程度等。

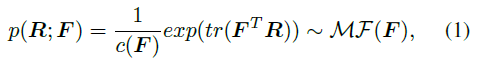

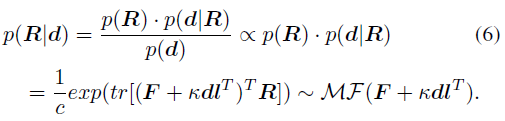

技術實現 人體建模 本研究對人體姿態進行概率建模,目標是求關節旋轉 R 在一些觀測變量條件下(如骨骼朝向 d 等)的后驗概率 p (R|d,?)。 具體而言,由于人體的關節旋轉位于 SO (3) 上,而子關節相對于父關節的單位骨骼朝向位于 S^2 上,因此可基于這兩種流形上的概率分布進行分析。 首先,SO (3) 上的 matrix Fisher 分布 MF (?) 可作為關節旋轉 R 的先驗分布,如下式所示,F∈R^(3×3) 是該分布的參數,c (F) 是一個歸一化常量,tr 表示矩陣的跡。

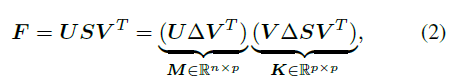

如下式所示,F 可以通過 SVD 分解直接求解均值 M 和一個表征分布聚集程度的聚集項 K。其中,Δ=diag (1,1,|UV|) 是一個對角正交矩陣,用于保證 M 的行列式為 1,從而能落在特殊正交群中。

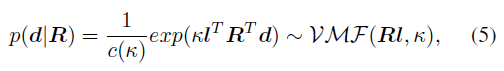

其次,考慮到骨骼的朝向能通過關節旋轉計算得到,因此可將關節旋轉 R 看作隱變量,骨骼朝向 d 作為觀測變量,給定 R 的條件下,S^2 上的單位朝向 d 服從 von Mises-Fisher 分布:

其中,κ∈R 和 d∈S^2 分別是該分布的聚集項和均值,l 是參考姿態下(如 T-pose)的單位骨骼朝向,理論上滿足 Rl=d,即通過關節旋轉將參考骨骼朝向轉到當前骨骼朝向。 利用貝葉斯理論,給定先驗分布 p (R) 和似然函數 p (d|R),可以計算以骨骼朝向為條件的關節旋轉的后驗概率 p (R|d) 的解析形式:

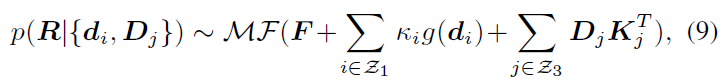

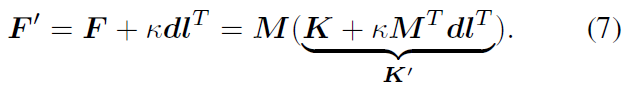

由此可得到結論:后驗概率 p (R|d) 同樣服從 matrix Fisher 分布,且其參數從 F 更新為 F^'=F+κdl^T。 上述后驗概率只考慮了人體骨骼朝向作為觀測量,類似地,還可以推廣到其它的方向觀測量 d_i 或旋轉觀測量 D_j(可由別的傳感器產生,如 IMUs 等),得到如下一般形式的解析后驗概率:

其中 κ_i 和 K_j 是聚集項。g (?) 是一個 IK 形式的映射,能夠將方向觀測量轉換到旋轉估計,可以采用最簡單的形式如 g (d_i )=dl^T。Z_1 和 Z_3 分別表示方向觀測量和旋轉觀測量的集合。 特性 該部分進一步闡述后驗概率分布相較于先驗概率分布有更高的聚集程度。 前述部分介紹了人體關節旋轉后驗概率的解析形式,該概率由一個新的參數 F' 表征。可以從另一個角度理解后驗參數 F^',即 F^' 是與 F 相同的均值項 M 和一個新的聚集項 K^' 的乘積:

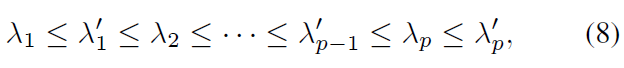

其中 M^T dl^T=ll^T 是一個秩 1 實對稱矩陣,而 K 也是一個實對稱矩陣,即后驗的聚集項 K' 同樣是實對稱矩陣。根據矩陣分析中關于實對稱矩陣的交錯定理,可以得到 K' 的特征值 λ_i' 和 K 的特征值 λ_i 具有如下不等式關系:

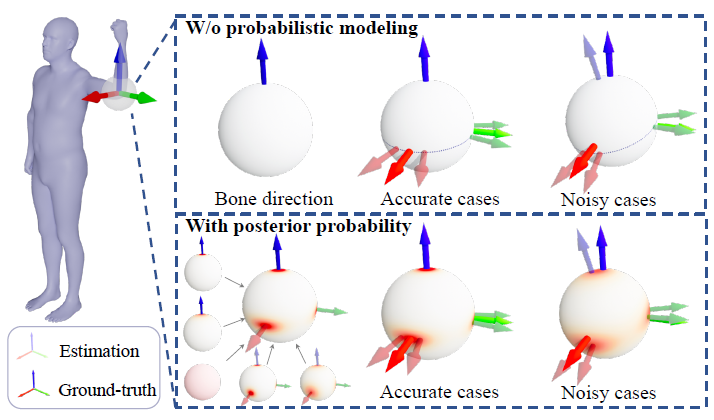

考慮到聚集項的特征值等價于分布參數的奇異值,而分布參數的奇異值能反映該分布的置信度,因此可以得到結論,當似然項非零時,后驗估計比先驗估計更集中,可以快速收斂到似然函數偏好的那個 mode 上,從而能更容易地被學習。 除了先驗概率方法,另一類主要的基準方法是利用逆運動學(IK)直接通過骨骼朝向計算旋轉,下面這張圖可以直觀地展示后驗概率方法和確定性 IK 方法之間的對比。

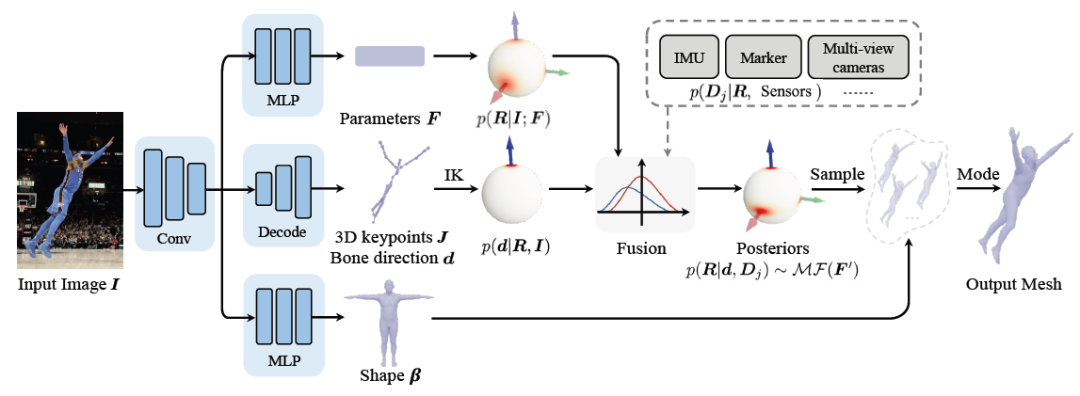

上圖以人體肘部關節為例。實的三維坐標軸表示真實值,透明三維坐標軸表示估計值。第一行表示確定性 IK 方法,這類方法背后的建模方式是一個表示骨骼朝向的向量,當骨骼朝向估計準確時,剩余的一個自由度(twist)便能縮小到一個圓上(圖中球上的虛線圈);當骨骼朝向估計不準確時,則會使得所有可能的估計都與真實值偏離。第二行表示本研究的后驗概率模型,由多個不同類型的模型融合而成,球面上的紅色區域表示某個旋轉的概率,即便骨骼朝向估計有誤差,這種方式也有可能恢復到真實值,因為骨骼朝向的噪聲能夠被先驗或其它觀測量所盡可能緩解。 網絡框架圖和損失函數 基于前述理論和推導,可以直接構建出下圖所示的框架圖。利用多分支網絡從單張圖片中估計先驗分布參數 F、三維關鍵點 J(從中計算出骨骼朝向 d)、外形參數 β。通過貝葉斯法則計算得到后驗概率,最終可從后驗分布中得到姿態估計,從而輸出人體 mesh。

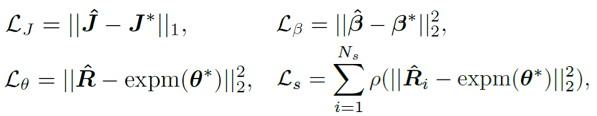

損失函數的選擇比較直接,為如下四個約束的加權和,其中 L_J 表示關鍵點約束,L_β 表示外形參數約束,L_θ 表示矩陣形式的姿態參數約束,L_s 表示對分布進行采樣后的姿態約束。關于對分布的約束,這里并未直接采用 MAP 是考慮了歸一化參數的數值穩定性問題。關于采樣策略,類似之前的工作,將 matrix Fisher 分布轉為等價的四元數形式的 Bingham 分布,然后通過拒絕采樣得到,其中拒絕采樣的建議分布采用 angular central Gaussian 分布。

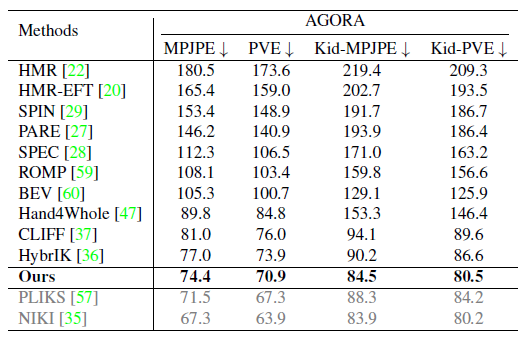

實驗結果 實驗部分,本研究在公開數據集 Human3.6M、3DPW、AGORA、TotalCapture 上和過去方法進行了定量對比。可以看到,本研究的方法超越了過去的一眾方法。其中右下表中最后灰色的兩行是同期工作,這里為了榜單完整性也列了出來。

下圖展示了和現有 SOTA 方法 HybrIK、PARE、CLIFF 的定性對比,可以看到對一些遮擋的情況,ProPose 可以得到更好的效果。

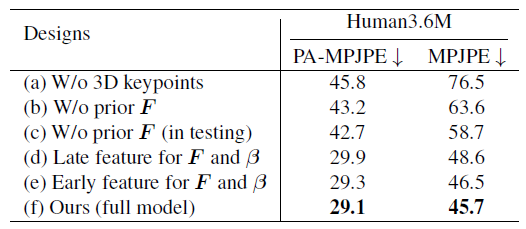

下表展示了一系列消融實驗,主要展示 ProPose 的準確性和魯棒性。基準方法包括不使用三維關鍵點、不使用先驗、測試時不使用先驗、骨干網絡不同位置特征的選擇等,下面左表充分驗證了所提出的后驗概率分布有著更高的精度。下面右表則展示了后驗方法和確定性 IK 方法對噪聲的魯棒性比較,可以看到后驗方法能夠更大程度地抵御噪聲的干擾。

除了上述 hmr 任務,本研究還在多傳感器融合的任務上進行了評估,下面給出了一個單視角和 IMUs 融合的效果。

審核編輯 :李倩

-

傳感器

+關注

關注

2551文章

51171瀏覽量

754245 -

高精度

+關注

關注

1文章

526瀏覽量

25477 -

計算機視覺

+關注

關注

8文章

1698瀏覽量

46022

原文標題:動畫制作效率提升80%!這個AI軟件一鍵實現高精度視頻動捕

文章出處:【微信號:CVSCHOOL,微信公眾號:OpenCV學堂】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

相關推薦

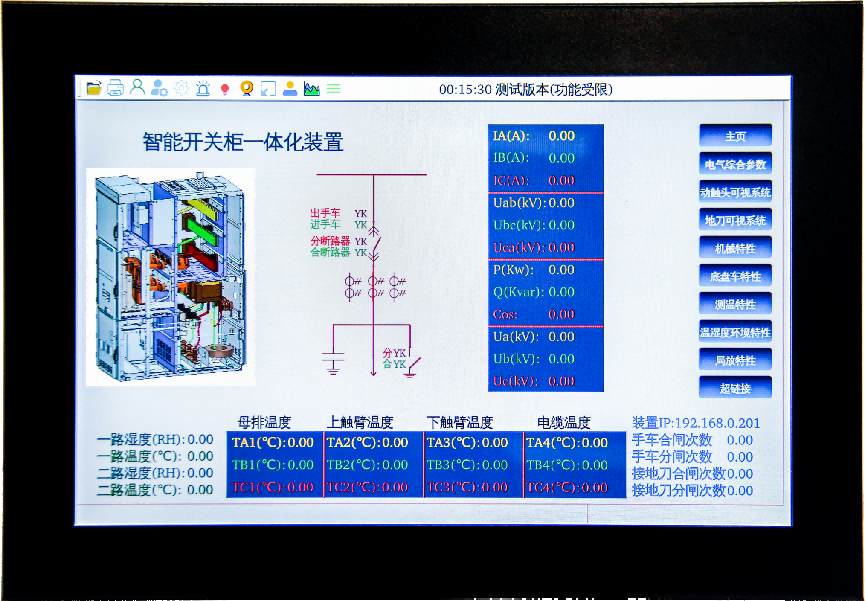

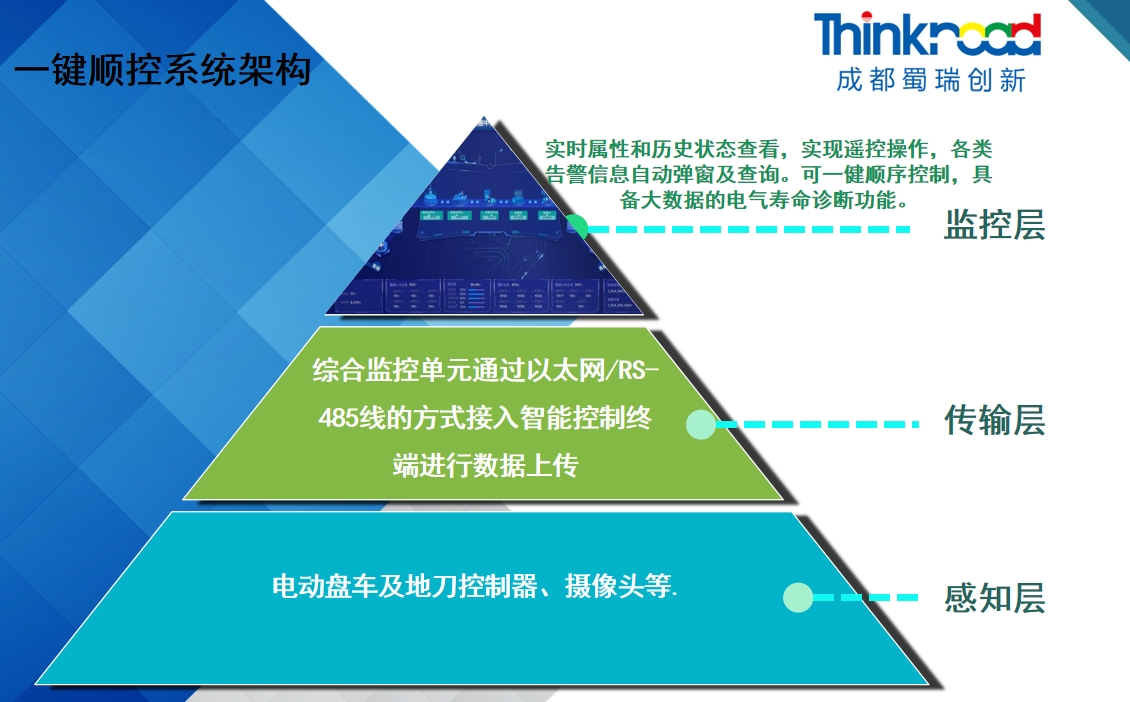

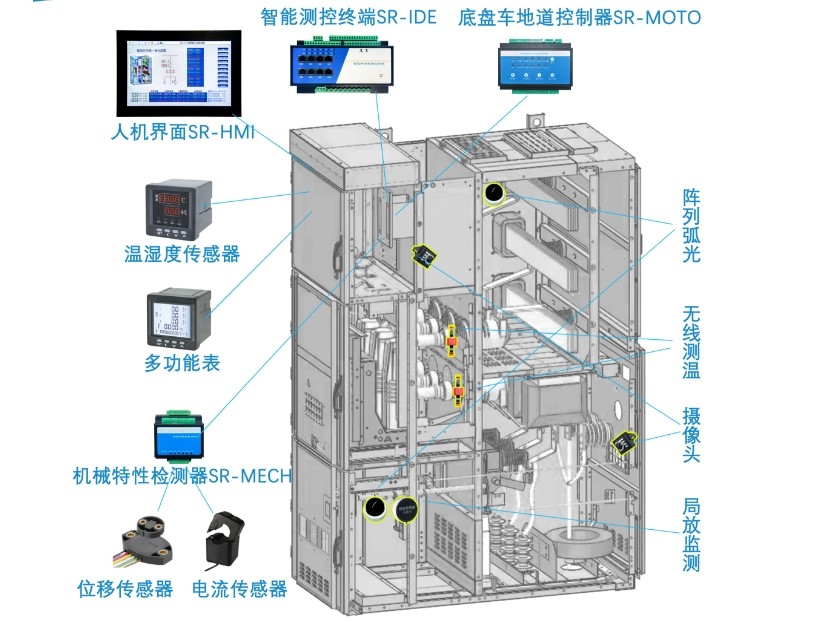

開關柜一鍵順控在化工領域的應用

在中壓開關柜上使用微機五防鎖是否可以實現一鍵順控

人機界面在開關柜一鍵順控中起到什么作用?

一鍵斷電開關的種類有哪些

一鍵斷電開關的控制原理是什么

開關柜一鍵順控比傳統方式時間效率上提升多少

一鍵生成屬于自己的AI客服:開啟智能服務新時代

智能開關柜能如何實現“可視化一鍵順控”?

迪思與百度智能云聯手發布AI視頻創作模型

華為云 Serverless 應用中心:一鍵開啟 AI 文生圖新時代,引領行業創新浪潮

華為云 Serverless 應用中心嶄新上線,一鍵部署 AI 文生圖應用引領創新潮流

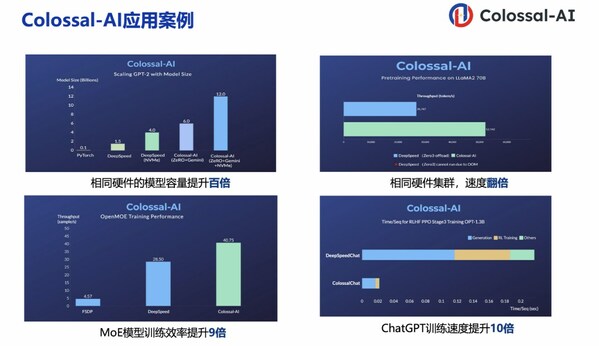

潞晨科技Colossal-AI + 浪潮信息AIStation,大模型開發效率提升10倍

動畫制作效率提升80%!這個AI軟件一鍵實現高精度視頻動捕

動畫制作效率提升80%!這個AI軟件一鍵實現高精度視頻動捕

評論