根據(jù),在線性可分情況下,支持向量機尋找最優(yōu)分類超平面的優(yōu)化問題可以表示為:

最小化:1/2||ω||2,

限制條件:yi(ωTXi+b)≥1,i=1~N。

求解上述最優(yōu)化問題,可得出一組ω和b的值,使得ωTx+b=0所表示的超平面為最優(yōu)分類超平面。

但在訓練樣本是線性不可分的情況下,上述最優(yōu)化問題不存在合適的解(個人理解:不存在合適的解的原因是上述最優(yōu)化問題的本質(zhì)是求解最優(yōu)分類超平面,最優(yōu)分類超平面應滿足可將訓練數(shù)據(jù)完全分為兩類的條件,但在訓練樣本是線性不可分的情況,不存在滿足上述條件的超平面)。

因此,尋找線性不可分的訓練樣本的最優(yōu)超平面時,需將上述優(yōu)化問題的限制條件放松。放松限制條件的方式是引入松弛變量δi(slack variable),將上述優(yōu)化問題的限制條件改寫為:

yi(ωTXi+b)≥1-δi,i=1~N

在線性不可分的情況下,訓練樣本的數(shù)據(jù)無法滿足均yi(ωTXi+b)≥1,但可通過調(diào)整δi的值使所有訓練數(shù)據(jù)均滿足yi(ωTXi+b)≥1-δi。同時,為使分類的準確性盡可能高,δi的值也需被限定。

根據(jù)上述思路,在線性不可分的情況下,支持向量機尋找最優(yōu)分類超平面的優(yōu)化問題可以表示為:

最小化:1/2||ω||2+C∑δi或1/2||ω||2+C∑δi2,

限制條件:(1)δi≥0,i=1~N;(2)yi(ωTXi+b)≥1-δi,i=1~N。

其中,最小化1/2||ω||2+C∑δi或1/2||ω||2+C∑δi2使δi的取值盡可能小,C為比例因子,C的值需人為設(shè)定。算法中需人為設(shè)定的參數(shù)被稱為算法的超參數(shù)(hyper parameter)。

在實際應用中,開發(fā)人員會不斷被變化超參數(shù)值,并測試各種超參數(shù)算法的識別率,以選取使算法識別率達至最高的超參數(shù)值。

如果一個算法的超參數(shù)越多,該算法需手動調(diào)整的部分越多,其自動性越低,支持向量機是超參數(shù)較少的算法模型,超參數(shù)較多的算法模型包括:人工神經(jīng)網(wǎng)絡(luò)、卷積神經(jīng)網(wǎng)絡(luò)(根據(jù)百度百科:卷積神經(jīng)網(wǎng)絡(luò)是深度學習的代表算法之一)等。

盡管在線性不可分的情況下,機器學習可以通過使1/2||ω||2+C∑δi或1/2||ω||2+C∑δi2最小化尋找最優(yōu)分類超平面,但該方法的分類準確率不一定較高。

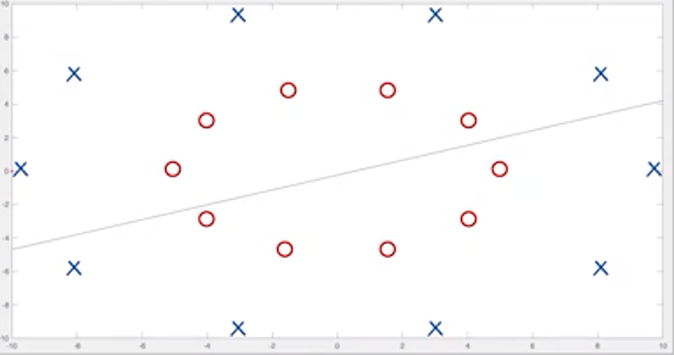

如圖一所示,圖一中的直線為機器學習通過支持向量機尋找最優(yōu)分類超平面,但該直線對圖一中圓圈和叉的分類的準確率與隨機猜測的準確率差異不大。

?

?

圖一,圖片來源:中國慕課大學《機器學習概論》

此情況出現(xiàn)的原因是通過使1/2||ω||2+C∑δi或1/2||ω||2+C∑δi2最小化尋找最優(yōu)分類超平面的算法模型是線性的,即假設(shè)算法模型的分類函數(shù)是線性的。因此,該算法模型對分類函數(shù)為非線性函數(shù)的訓練樣本進行分類時,將出現(xiàn)分類錯誤的情況。

當訓練樣本的非線性分類函數(shù)與線性函數(shù)差異較大時,分類錯誤的情況出現(xiàn)的概率將較大,可能出現(xiàn)分類的準確率與隨機猜測的準確率差異不大的情況。

審核編輯:劉清

-

向量機

+關(guān)注

關(guān)注

0文章

166瀏覽量

20888 -

機器學習

+關(guān)注

關(guān)注

66文章

8425瀏覽量

132771 -

卷積神經(jīng)網(wǎng)絡(luò)

+關(guān)注

關(guān)注

4文章

367瀏覽量

11882

原文標題:機器學習相關(guān)介紹(9)——支持向量機(線性不可分情況)

文章出處:【微信號:行業(yè)學習與研究,微信公眾號:行業(yè)學習與研究】歡迎添加關(guān)注!文章轉(zhuǎn)載請注明出處。

發(fā)布評論請先 登錄

相關(guān)推薦

FRED應用:LED發(fā)光顏色優(yōu)化

高速、RF射頻信號的參考平面分析

超結(jié)MOSFET體二極管性能優(yōu)化

如何優(yōu)化單片機項目的功耗

25G/28G重定時器與轉(zhuǎn)接驅(qū)動器在常見應用中的最優(yōu)化實現(xiàn)

量子計算場景實用秘籍:開物SDK之“高階函數(shù)降階”

基于計算機視覺與機器學習技術(shù)的跌倒風險預測

電路PCB的地平面設(shè)計對EMI的影響

寬帶熱成像中超平面光學元件的應用研究

基于三維超球面的聲學復眼裝置,可用于全向?qū)拵盘栐鰪?/a>

離軸超構(gòu)透鏡的理論分析和實際應用

COMSOL Multiphysics在超材料與超表面仿真中的應用

什么是中斷向量偏移,為什么要做中斷向量偏移?

支持向量機尋找最優(yōu)分類超平面的優(yōu)化問題

支持向量機尋找最優(yōu)分類超平面的優(yōu)化問題

評論