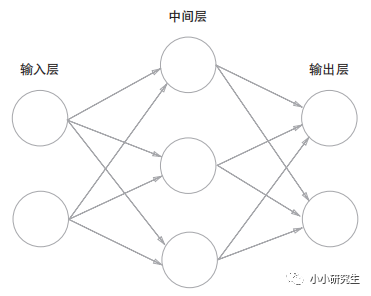

二、神經網絡

第0層是輸入層,最后一層是輸出層,中間是中間層或隱藏層。上圖中的網絡有3層神經元,實質只有兩層有權重,因此稱為兩層網絡。

1、激活函數

感知器:y=0(b+w1x1+w2x2<=0)或y=1(b+w1x1+w2x2>0)改寫為

y=h(b+w1x1+w2x2),h(x)=0(x<=0)或h(x)=1(x>0)

激活函數h(x):將輸入信號的總和轉換為輸出信號的表達式,決定如何激活輸入信號的總和。

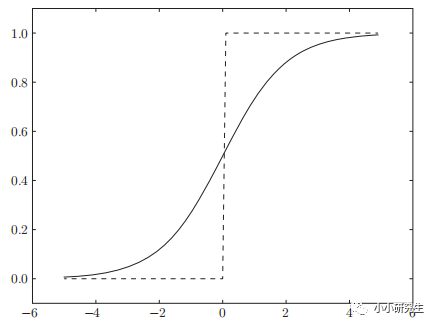

上式中的激活函數是階躍函數,只能返回0或1,而神經網絡中的激活函數常用的是sigmoid函數和ReLU函數。

1'sigmoid函數

h(x)=1/(1+exp(-x))

和階躍函數的對比:sigmoid是平滑的函數,輸出隨輸入發生連續的變化,因此可以返回0-1之間的實數。

和階躍函數的相同點:輸入小時,輸出接近0,輸入增大時輸出向1靠近,即當輸入信號為重要信息時,都會輸出較大值,且兩者輸出都在0-1之間。

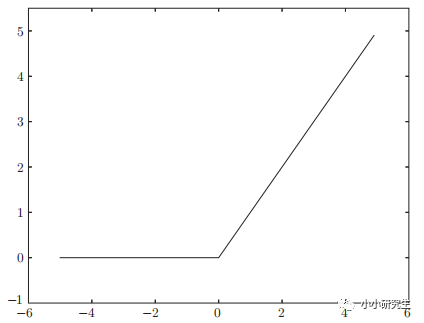

2'ReLU函數

h(x)=x(x>0);h(x)=0(x<=0)

輸入大于0時直接輸出,輸入小于0時輸出0

總結:激活函數只能為非線性函數,因為線性函數的問題是多個隱藏層可以用一個隱藏層實現。例如h(x)=cx作為激活函數,y(x)=h(h(h(x)))對應的三層神經網絡可以用一層表示y(x)=c^3x。如果要用疊加層則必須使用非線性函數。

-

神經網絡

+關注

關注

42文章

4771瀏覽量

100773 -

網絡

+關注

關注

14文章

7567瀏覽量

88794 -

函數

+關注

關注

3文章

4331瀏覽量

62622 -

感知器

+關注

關注

0文章

34瀏覽量

11841 -

深度學習

+關注

關注

73文章

5503瀏覽量

121170

發布評論請先 登錄

相關推薦

深度學習基礎知識(2)

深度學習基礎知識(2)

評論