1 引言

1.1 “谷歌和 OpenAI 都沒有護城河,大模型門檻正被開源踏破”

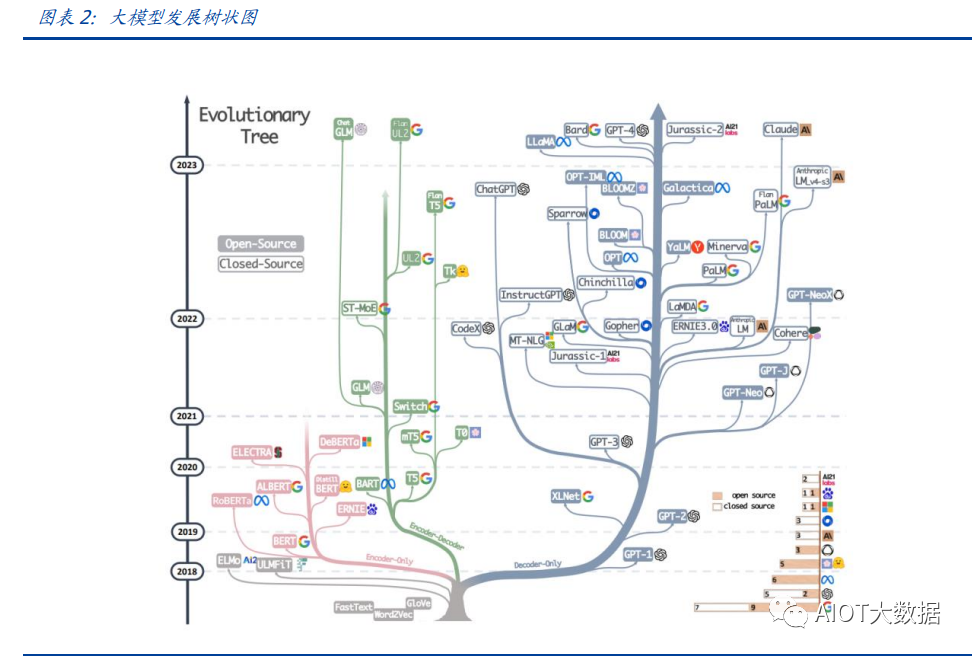

“除非谷歌和 OpenAI 改變態度,選擇和開源社區合作,否則將被后者替代”,據彭博 和 SemiAnalysis 報道,4 月初,谷歌工程師 Luke Sernau 發文稱,在人工智能大語言模 型(Large Language Models,LLM,以下簡稱“大模型”)賽道,谷歌和 ChatGPT 的推 出方 OpenAI 都沒有護城河,開源社區正在贏得競賽。 這一論調讓公眾對“年初 Meta 開源大模型 LLaMA 后,大模型大量出現”現象的關注推 向了高潮,資本市場也在關注大公司閉源超大模型和開源大模型誰能贏得競爭,在“模 型”“算力”“數據”三大關鍵要素中,大模型未來競爭格局如何,模型小了是否就不再 需要大量算力,數據在其中又扮演了什么角色?……本報告試圖剖析這波開源大模型風 潮的共同點,回顧開源標桿 Linux 的發展史,回答以上問題,展望大模型的未來。

1.2 開源大模型集中出現,堪稱風潮

2 月 24 日,Meta 發布 LLaMA 開源大模型,此后,市場集中涌現出一批大模型,大致可 以分為三類。

1.2.1 “LLaMA 系”:表現好,但商用化程度低

LLaMA 包括四個不同的參數版本(70 億/130 億/330 億/650 億),不支持商用,指令數 據集基于 OpenAI,模型表現可與 GPT-3 持平或優于 GPT-3。其中,70 億和 130 億參數 版擁有包含 1 萬億個標識符(Token)的預訓練數據集;330 億和 650 億參數版擁有包 含 1.4 萬億個標識符的預訓練數據集。在與 GPT-3 的對比中,LLaMA-70 億參數版在常 識推理任務、零樣本任務、自然問題和閱讀理解中的表現與 GPT-3 水平相當,而 130 億 參數及更高參數的版本模型在以上領域的表現均優于 GPT-3。

LLaMA 模型本身沒有使用指令數據集,但考慮到效果優于 GPT-3 的 ChatGPT 使用了人 類指令數據集,一批開源大模型在 LLaMA 模型基礎上,使用了 OpenAI 指令數據集來優 化模型的表現,包括 Alpaca、GPT4All、Vicuna、Koala、Open Assistant 和 Hugging Chat。 由于 OpenAI 指令數據集不可商用,因此這批基于 LLaMA 的開源大模型也都不可商用。

1.2.2 Dolly2.0、RedPajama、StableLM 等:商用化程度高

這些大模型沒有使用 OpenAI 指令數據集,因此可以商用,但大多數還在持續開發中。

1.2.3 中文雙子星:ChatGLM-6B 和 MOSS

ChatGLM-6B 和 MOSS 分別由清華大學和復旦大學相關研究團體推出,在中文社區知名 度較高。

2 共同點一:始于開源

2.1 為什么要開源?

市場對開源大模型的重要問題是,為什么要開源,這是否會損傷大模型行業的商業模式。 我們梳理了部分大模型對開源原因的自述,總結如下。

2.1.1 模型視角:防止大公司壟斷,破除商業禁用限制

為了使人工智能研究民主化,彌合開放模型和封閉模型之間的質量差距,破除商業化禁 用限制,開源大模型的蓬勃發展有望促進以上目標。

2.1.2 數據視角:保護企業機密,使定制化數據訓練成為可能

保障數據隱私,允許企業定制化開發。對于許多行業而言,數據是企業的命脈,大模型 的開源使得企業可以將自己的數據集在大模型上進行訓練,同時做到對數據的控制,保 護企業數據隱私。同時,開源大模型允許企業的開發人員在模型的基礎上進行定制化開 發,定向訓練數據,也可以針對某些主題進行過濾,減少模型體量和數據的訓練成本。

2.1.3 算力視角:降低算力成本,使大模型的使用“普惠化”

開源大模型節省了訓練階段的算力消耗,為企業降低算力成本,推動大模型使用“普惠 化”。算力總需求=場景數*單場景算力需求。在大模型的訓練和使用中,算力消耗分為兩 部分場景,即訓練成本消耗及推理成本消耗。 就訓練成本而言,大模型的訓練成本高,普通企業的算力資源難以承受,而開源大 模型主要節省了企業預訓練階段的算力。但由于不同垂類的訓練場景更加豐富,所 以整體訓練需求是增長的。 就推理成本而言,大模型在參數體量龐大的情況下,其推理成本也很高,普通公司 難以維持其日常開銷,因此,降低模型參數體量可進而降低企業在使用模型時的推 理成本。

2.2 開源,需要什么土壤?

開源大模型的蓬勃發展并非沒有先例,全球規模最大的開源軟件項目——Linux 有類似 的故事。研究 Linux 的發展史,對展望開源大模型的未來,有借鑒意義。

2.2.1 從開源標桿 Linux 說開去

Linux 是一款基于 GNU 通用公共許可證(GPL)發布的免費開源操作系統。所有人都 能運行、研究、分享和修改這個軟件。經過修改后的代碼還能重新分發,甚至出售,但 必須基于同一個許可證。而諸如 Unix 和 Windows 等傳統操作系統是鎖定供應商、以原 樣交付且無法修改的專有系統。 許多全球規模最大的行業和企業都仰賴于 Linux。時至今日,從維基百科等知識共享網 站,到紐約證券交易所,再到運行安卓(一個包含免費軟件的 Linux 內核專用發行版) 的移動設備,Linux 無處不在。當前,Linux 不僅是公共互聯網服務器上最常用的操作系 統,還是速度排名前 500 的超級電腦上使用的唯一一款操作系統。

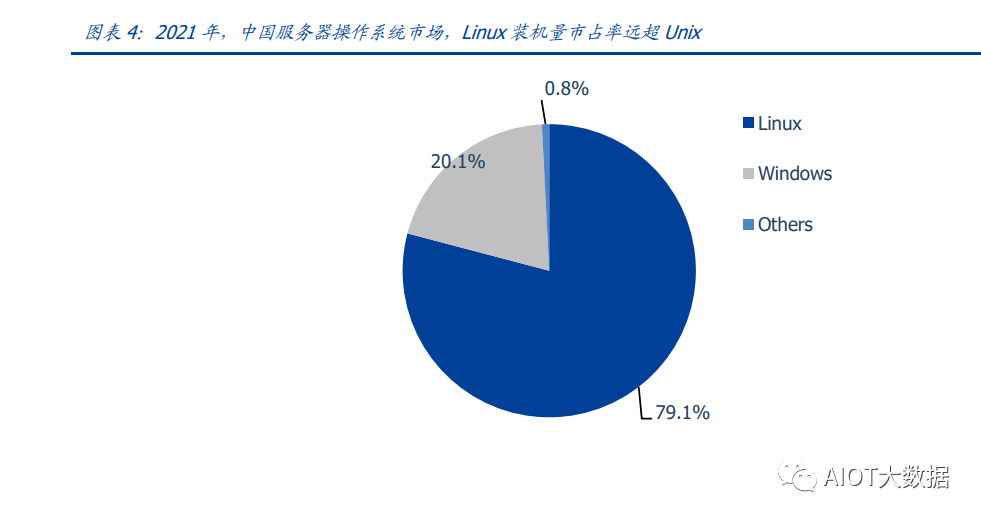

服務器市場,Linux 市占率已經遠超操作系統“鼻祖”Unix,“Linux 時刻”發生。以 中國市場為例,根據賽迪顧問數據,按照裝機量統計,在服務器架構上,Linux 是市場主 流,占據絕對領先地位,市場占有率達到 79.1%。Windows 市場占有率降至 20.1%, Unix 市場占有率僅剩 0.8%。

2.2.2 Linux 并非一己之作,借力于社區深厚的開源歷史

Unix 開源過,為 Linux 提供了火種

Unix,現代操作系統的鼻祖。操作系統是指直接管理系統硬件和資源(如 CPU、內存和 存儲空間)的軟件,它位于應用與硬件之間,負責在所有軟件與相關的物理資源之間建 立連接。而 Unix 被許多觀點認為是現代操作系統的鼻祖。 Unix 曾開源。世界上第一臺通用型計算機誕生于 1946 年,而 Unix 開發于 1969 年。在 長達十年的時間中,UNIX 擁有者 AT&T 公司以低廉甚至免費的許可將 Unix 源碼授權給 學術機構做研究或教學之用,許多機構在此源碼基礎上加以擴展和改進,形成了所謂的 “Unix 變種”。后來 AT&T 意識到了 Unix 的商業價值,不再將 Unix 源碼授權給學術機 構,并對之前的 Unix 及其變種聲明了著作權權利。

Unix 回歸閉源之后太貴,促成了 Linux 的開發

Linux 由 Linux Torvalds 于 1991 年設計推出,當時他還在讀大學,認為當時流行的商業 操作系統 Unix 太貴了,于是基于類 Unix 操作系統 Minix 開發出了 Linux,并將其開放給 像自己這樣負擔不起的團隊。

僅用于教學的 Minix,啟發了 Linux 的開發

在 AT&T 將源碼私有化后,荷蘭阿姆斯特丹自由大學教授塔能鮑姆為了能在課堂上教授 學生操作系統運作的實務細節,決定在不使用任何AT&T的源碼前提下,自行開發與UNIX 相容的作業系統,以避免版權上的爭議。他以小型 UNIX(mini-UNIX)之意,將它稱為 MINIX。第一版 MINIX 于 1987 年釋出,只需要購買它的磁片,就能使用。在 Linux 系統 還沒有自己的原生檔案系統之前,曾采用 Minix 的檔案系統。

開源社區、許可證與標準助力

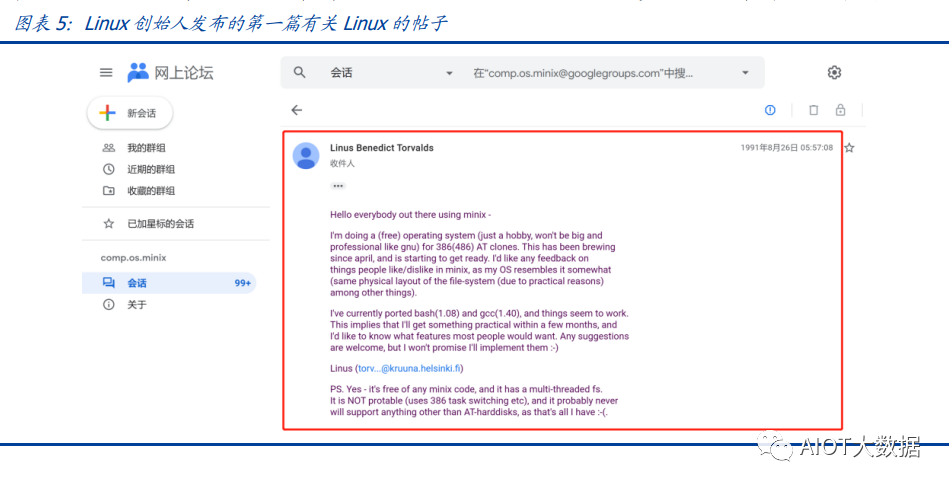

從開始就開源。1991 年 8 月,Linux 創始人 Linus Torvalds 將 Linux 發到 Minix Usenet 新聞組。隨后他將 Linux 發布到 FTP 網站上,因為他想讓更多人一起來開發這個內核。

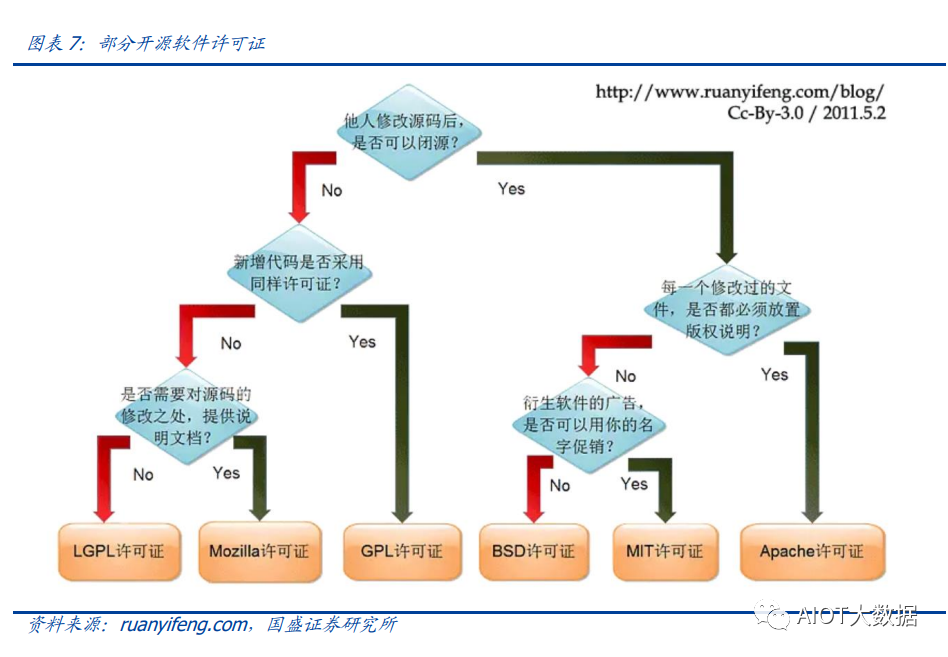

許可證助力生態開枝散葉、生生不息。Linux 基于 GNU GPL 許可證(GNU’s Not Unix General Public License,革奴計劃通用公共許可證)模式。GPL 許可證賦予“自由軟件” 賦予用戶的四種自由,或稱“Copyleft(公共版權)”: 自由之零:不論目的為何,有“使用”該軟件的自由。 自由之一:有“研究該軟件如何運作”的自由,并且得以“修改”該軟件來符合用 戶自身的需求。可訪問源代碼是此項自由的前提。 自由之二:有“分發軟件副本”的自由,所以每個人都可以借由散布自由軟件來敦 親睦鄰。 自由之三:有將“公布修訂后的版本”的自由,如此一來,整個社群都可以受惠。 可訪問源代碼是此項自由的前提。 GPL 許可證要求 GPL 程序的派生作品也要在遵循 GPL 許可證模式。相反,BSD 式等許可 證并不禁止派生作品變成專有軟件。GPL 是自由軟件和開源軟件的最流行許可證。遵循 GPL 許可證使得 Linux 生態能生生不息,不至于走進無法繼續發展的“死胡同”。

標準對內使生態“形散而神不散”,對內擁抱“巨鯨”。 對內統一標準。Linux 制定了標準 LSB(Linux Standard Base,Linux 標準基礎)來 規范開發,以免各團隊的開發結果差異太大。因此,各 Linux 衍生開發工具只在套 件管理工具和模式等方面有所不同。我們認為,這使得 Linux 開源社區的發展“形 散而神不散”,使 Linux 生態的發展不至于分崩離析。 對外兼容 Unix。為了讓 Linux 能兼容 Unix 軟件,Linus Torvalds 參考 POSIX(Portable Operating System Interface,可攜帶式操作系統接口)標準修改了 Linux,這使得 Linux 使用率大增。該標準由 IEEE(Institue of Electrical and Electronics Engineers, 電氣和電子工程師協會)于 20 世紀 90 年代開發,正是 Linux 的起步階段,它致力 于提高 Unix 操作系統環境與類 Unix 操作系統環境下應用程序的可移植性,為 Linux 的推廣提供了有利環境。

2.3 開源了,還怎么賺錢?

市場對“開源”的核心疑問是商業模式。“開源”本身免費,但“開源”作為土壤,“開 源社區”孕育出了各種商業模式,從 Linux 的生態中可以學習到這一點。

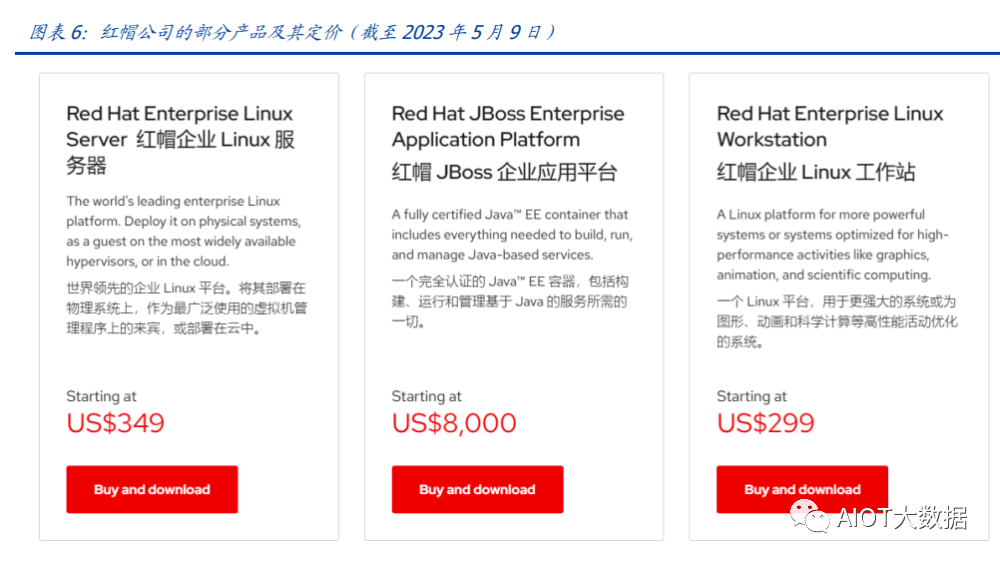

2.3.1 紅帽公司(Red Hat):服務至上

紅帽公司(Red Hat)是 Linux 生態的領軍企業,超過 90%的《財富》500 強公司信賴紅 帽公司,紅帽作為公司的商業價值巨大。1993 年,紅帽成立,1999 年,紅帽即在納斯 達克上市,紅帽招股書援引 IDC 的數據稱,截止到 1998 年所有經授權的新安裝 Linux 操 作系統中,有 56%來自紅帽;2012 年,紅帽成為第一家收入超過 10 億美元的開源技術 公司;2019 年,IBM 以約 340 億美元的價格收購了紅帽。 關于 Linux 和紅帽的商業模式,就像好奇心日報打的比方,某種意義上,開源的 Linux 內 核像免費、公開的菜譜,紅帽們像餐廳,人們仍然愿意去餐廳品嘗加工好的菜肴和享受 貼心的服務。紅帽面向企業提供 Linux 操作系統及訂閱式服務,主要服務內容包括:1、 24*7 技術支持;2、與上游社區和硬件廠商合作,支持廣泛的硬件架構,如 x86、ARM、 IBM Power 等;3、持續的漏洞警報、定向指導和自動修復服務;4、跨多個云的部署; 5、實時內核修補、安全標準認證等安全防護功能;6、檢測性能異常、構建系統性能綜 合視圖,并通過預設調優配置文件應用等。

2.3.2 安卓系統(Android):背靠谷歌,靠廣告變現

根據 Statcounter 數據,截至 2023 年 4 月,安卓系統(Android)是全球第一手機操作 系統,市占率高達 69%,遠超第二名(iOS,31%)。安卓基于 Linux 內核開發,2005 年 被谷歌收購。隨后,谷歌以 Apache 免費開放源代碼許可證的授權方式,發布了安卓的 源代碼,使生產商可以快速推出搭載安卓的智能手機,這加速了安卓的普及。 而關于商業模式,安卓手機預裝的諸多服務由谷歌私有產品提供,例如地圖、Google Play 應用商店、搜索、谷歌郵箱(Gmail)……因此,盡管安卓免費、開源,但谷歌仍能通過 其在移動市場“攻城略地”,將用戶流量變現。

谷歌還直接向安卓手機廠商收取授權費,從 2018 年 10 月 29 日開始,使用安卓系統的 手機、平板電腦的歐盟廠商使用谷歌應用程序套件,必須向谷歌支付許可費,每臺設備 費用最高達 40 美元(約 277 元)。

2.4 開源大模型主流許可證支持商用

開源社區已經有 GPL、BSD、Apache 等知名許可證。大模型方面,我們注意到,2023 年 2 月發布的、引領了大模型開源浪潮的 LLaMA 禁止商用,僅可用于研究,MetaAI 將根據 具體情況,授予公務員、社會團體成員、學術人員和行業研究實驗室,訪問該模型的權 限。其中,LLaMA 的推理代碼基于 GPL3.0 許可證,這意味著:1)他人修改 LLaMA 的推 理代碼后,不能閉源;2)新增代碼也必須采用 GPL 許可證。不過,我們注意到,部分開 發人員在 LLaMA 基礎之上開發的變體模型,有不同類型的許可證。例如,基于 nanoGPT 的LLaMA實現Lit-LLaMA新增了部分模型權重,這部分模型采用的許可證是Apache2.0。 開源大模型采用的協議主要是 Apache 2.0 和 MIT 許可證。Alpaca、Vicuna、Dolly、 OpenAssistant 和 MOSS 均采用 Apache 2.0 許可證,Koala 和 GPT4all 采用 MIT 許可證。 這兩個許可證均允許商用。但令人惋惜的是,Alpaca、Vicuna、Koala 和 GPT4all 因 OpenAI 或 LLaMA 限制無法商用。同時,值得注意的是,Apache2.0 和 MIT 許可證均允許再修改 源碼后閉源,公司可以在開源大模型基礎上開發自己的模型,或對公司更有吸引力。

3 共同點二:開源大模型參數少、小型化

3.1 超大模型和大模型分別多大?

預訓練賦予模型基本能力。在自然語言處理(NLP)中,預訓練是指在特定任務微調之 前,將語言模型在大量文本語料庫上訓練,為模型賦予基本的語言理解能力。在預訓練 過程中,模型被訓練以根據前面的上下文預測句子中的下一個單詞。這可以通過掩蓋一 些輸入中的單詞并要求模型預測它們的方式進行,也可以采用自回歸的方法(例如 GPT), 即根據句子中的前面單詞預測下一個單詞。 預訓練模型通常包括大量的參數和對應的預訓練數據(通常用標識符即 Token 的數量衡 量)。2017 年谷歌大腦團隊 Transformer(變換器)模型的出現,徹底改變了 NLP 的面 貌,使得模型可以更好地理解和處理語言,提高 NLP 任務的效果和準確性。

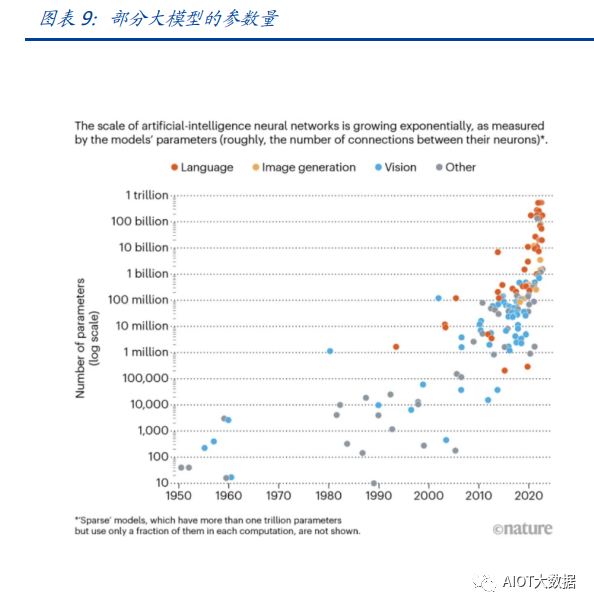

超大模型和大模型分別多大?語言模型的大小是根據其參數量來衡量的,參數量主要描 述了神經元之間連接強度的可調值。目前一般大語言模型參數量在幾十到幾百億之間, 超過千億參數的我們稱為“超大模型”,例如 GPT-3(1750 億參數)。

3.2 GPT 系超大模型能力最強,但難復現

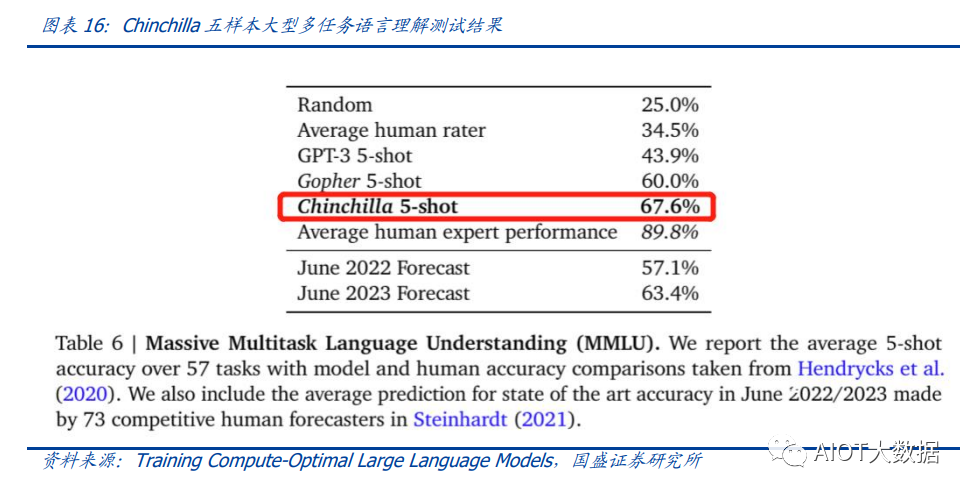

大模型的性能評價標準并沒有統一。一個重要原因是大模型生成內容的任務種類多,不 同的應用場景和任務可能需要不同的指標和方法去評估模型的表現。其中部分任務可能 有公信力較強的評分標準,如機器翻譯中的 BLEU,但大部分任務缺乏類似標準。 模糊共識是超大模型性能好。大語言模型目前的發展趨勢是越來越大,原因 是大模型在預訓練后就具有較好通用性和穩定性。例如,谷歌團隊的超大模型 PaLM (5400 億參數),在零樣本和少量樣本測試中均有良好的成績,并且隨著其訓練標識符數量的上升,性能仍能提升。這也不難理解,簡單來說,模型見得多了,自 然會的也多了。

“同行評議”,GPT 系大模型“風華絕代”。當前,OpenAI GPT 系的超大模型擁有著強 大的能力和廣泛的應用,在處理自然語言任務時具有高準確性和強大的表達能力,其在 文本生成、問答系統、機器翻譯等多個領域都取得了出色效果,成為了當前自然語言處 理領域的標桿之一,被各類大模型當作比較基準。復現 ChatGPT 的門檻并沒有降低,開 源大模型大部分僅在某些方面有較好的表現,整體質量與 ChatGPT 仍不可比,尚需觀望。

3.2.1 Vicuna:利用 GPT-4 評估

目前大部分開源大模型性能未進行系統評價,更多處在起步試驗階段。在對性能進行評 價的開源大模型中,Vicuna 的報告中利用 GPT-4 進行的評估相對較為系統,結果也最令 人矚目。

3.2.2 Zeno Build 測評:較新,較全面

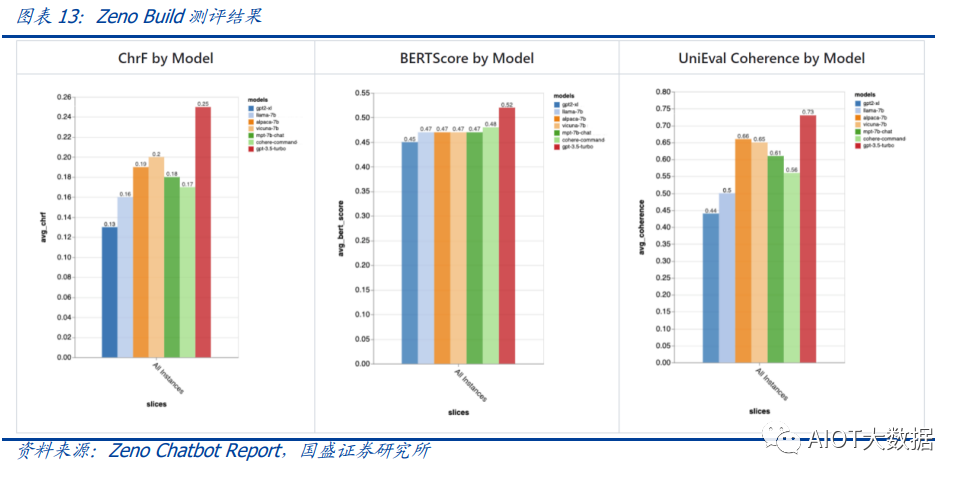

Zeno Build 對 GPT-2、LLaMA、Alpaca、Vicuna、MPT-Chat、Cohere Command、ChatGPT (gpt-3.5-turbo)七個模型測評,結果與 GPT-4 評價結果相近。ChatGPT 有明顯優勢, Vicuna 在開源模型中表現最佳。

3.2.3 C-Eval:全面的中文基礎模型評估套件

C-Eval 評估結果顯示,即便是在中文能力上,GPT-4 也是一騎絕塵,但 GPT-4 也僅能達 到 67%的正確率,目前大模型的中文處理能力尚有很大提升空間。

3.2.4 GPT 系超大模型訓練成本高,短期內難復現

ChatGPT 所需算力和訓練成本可觀。不考慮與日活高度相關的推理過程所需的算力,僅 考慮訓練過程,根據論文《Language Models are Few-Shot Learners》的測算,ChatGPT 的上一代 GPT-3(1750 億參數版)所需的算力高達 3640PF-days(即假如每秒做一千萬 億次浮點運算,需要計算 3640 天),已知單張英偉達 A100 顯卡的算力約為 0.6PFLOPS, 則訓練一次 GPT-3(1750 億參數版),大約需要 6000 張英偉達 A100 顯卡,如果考慮互 聯損失,大約需要上萬張 A100,按單張 A100 芯片價格約為 10 萬元,則大規模訓練就 需要投入約 10 億元。OpenAI 在 GPT-3(1750 億參數)的訓練上花費了超過 400 萬美 元,而為了維持 ChatGPT 和 GPT4(參數量未公布,預計更高)的運轉,每個月理論上 更高。

3.3 開源大模型性價比高,超大模型以下大模型的壁壘正在消失

開源大模型小型化趨勢明顯,參數約為百億級別,成本降低乃題中之義。開源大模型通 常具有較少的參數,在設計、訓練和部署上,需要的資源和成本都相對較低。這波開源 大模型的參數普遍較小,均在十億~百億級別左右。

“船小好調頭”,基于已有的開源預訓練模型進行微調也是開源大模型的優勢之一。在預 訓練模型基礎上進行微調和優化,以適應不同的任務和應用場景,這種方法不僅可以大 大縮短模型的訓練時間和成本,而且還可以提高模型的性能和效率。 更多標識符訓練數據和新技術,讓超大模型以下的大模型壁壘趨于消失。LLaMA 被“開 源”,讓大家都有了一個可上手的大模型,并且隨著 DeepSpeed、RLHF 等技術的發展, 幾百億的模型可以部署在消費級 GPU 上。

4 共同點三:開源大模型數據集重視人類指令,并自立門戶

4.1 學習 ChatGPT 方法論,引入人類指令數據集

微調是提升特定性能的捷徑。微調是指在已經預訓練的模型上,使用具有標注數據的特 定任務數據集,進一步小規模訓練。微調可以以較小的算力代價,使模型更加適應特定 任務的數據和場景,從而提高模型的性能和準確性。目前微調多為指令微調,指令數據 集逐漸成為開源大模型的標配。 RLHF(Reinforcement Learning from Human Feedback,基于人類反饋的強化學習),是 一種新興的微調方法,它使用強化學習技術來訓練語言模型,并依據人類反饋來調整模 型的輸出結果。RLHF(基于人類反饋的強化學習)是 ChatGPT 早期版本 GPT3 所不具備 的功能,它使得只有 13 億參數的 InstructGPT 表現出了比 1750 億參數 GPT-3 更好的真 實性、無害性和人類指令遵循度,更被標注員認可,同時不會折損 GPT-3 在學術評估維 度上的效果。

RLHF(基于人類反饋的強化學習)分為三個步驟:1)監督微調(SFT):讓標注員回答 人類提問,用這一標注數據訓練 GPT;2)獎勵模型(RM)訓練:讓標注員對機器的回 答排序,相較于第一步由標注員直接撰寫回答的生成式標注,排序作為判別式標注的成 本更低,用這一標注訓練模型,讓它模擬人類排序;3)無人類標注,用近端策略優化算 法(PPO)微調模型。 這三個步驟對應的數據集的大小分別為 1.3 萬個、3.3 萬個、3.1 萬個。

對于具有大量數據和一定算力的公司來說,使用自己的數據進行微調可以展現出模型的 特化能力,并且用較小的算力達成接近大模型的效果。如多校聯合開發的 Vicuna 語言模 型,基于 Meta 的 LLaMA-130 億參數版模型,對 7 萬條用戶分享的 ChatGPT 對話指令微調,部分任務上,達到了 92%的 GPT4 的效果。在通用性和穩定性上無法超過超大模型, 但可以通過微調強化其某些方面的能力,性價比要更高,更適合中小公司應用。

4.2 數據集走向商用

數據集是語言模型發展的重要基礎和支撐,通常是由公司或組織自主收集、整理或直接 購買獲得。相比之下,開源數據集大多由社區或學術界共同維護的,其數據量和種類更 加豐富,但可能存在一定的數據質量問題和適用性差異。

4.2.1 預訓練數據集少量可商用

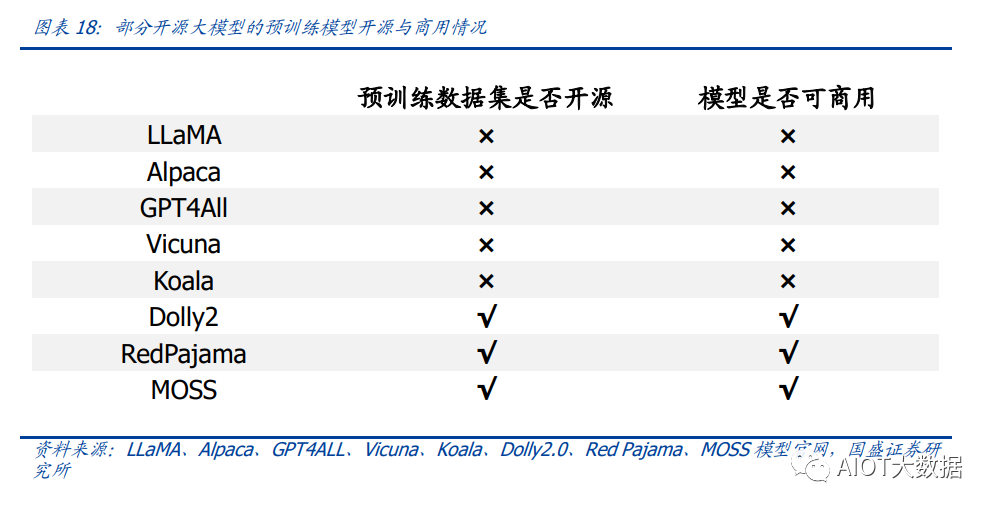

預訓練數據集開源對模型商用至關重要。在后 LLaMA 時代,開源大模型猶如雨后春筍般 涌現,但很快大家便發現由于 LLaMA 和 OpenAI 的限制,基于其開發的模型無法商用 (Alpaca、Koala、GPT4All、Vicuna),為了打破這一局面,Dolly2.0 率先出手,“為了解 決這個難題,我們開始尋找方法來創建一個新的,未被“污染”的數據集以用于商業用 途。”隨后 Red Pajama 和 MOSS 接踵而至。

4.2.2 指令數據集部分可商用

打造開源生態,各取所需。在早期開源項目中,因其指令數據及多來自 ChatGPT 生成 或對話內容,受 OpenAI 限制無法商用。除去研究用途微調外,目前越來越多模型選擇 自己構建指令數據集來繞開這一限制。 指令數據集多樣化,部分模型的指令數據集可商用化。按照上文對此批集中出現的大模 型的分類,除去 LLaMA、基于 LLaMA 開發出的模型以及 StableLM 使用 OpenAI 的指令 數據集外,其余大模型的指令數據集均不基于 OpenAI,也因此這些大模型的指令數據集 可商用化,這會加快推動使用且重視 RLHF(基于人類反饋的強化學習)訓練范式的此類 大模型的更迭與發展。

5 展望

5.1 多模態化:助力通用人工智能(AGI)發展

多模態開源大模型開始出現,將大模型推向新高潮,助力人類走向通用人工智能。多模 態即圖像、聲音、文字等多種模態的融合。多模態模型基于機器學習技術,能夠處理和 分析多種輸入類型,可以讓大模型更具有通用性。基于多領域知識,構建統一、跨場景、 多任務的模型,推動人類走向通用人工智能(Artificial General Intelligence,AGI)時代。

5.1.1 ImageBind 閃亮登場,用圖像打通 6 種模態

ImageBind 開源大模型可超越單一感官體驗,讓機器擁有“聯想”能力。5 月 9 日, Meta 公司宣布開源多模態大模型 ImageBind。該模型以圖像為核心,可打通 6 種模態, 包括圖像(圖片/視頻)、溫度(紅外圖像)、文本、音頻、深度信息(3D)、動作捕捉傳 感(IMU)。相關源代碼已托管至 GitHub。該團隊表示未來還將加入觸覺、嗅覺、大腦磁 共振信號等模態。 從技術上講,ImageBind 利用網絡數據(如圖像、文本),并將其與自然存在的配對數據 (如音頻、深度信息等)相結合,以學習單個聯合嵌入空間,使得 ImageBind 隱式地將 文本嵌入與其他模態對齊,從而在沒有顯式語義或文本配對的情況下,能在這些模態上 實現零樣本識別功能。 目前 ImageBind 的典型用例包括:向模型輸入狗叫聲,模型輸出狗的圖片,反之亦可; 向模型輸入鳥的圖片和海浪聲,模型輸出鳥在海邊的圖片,反之亦可。

5.1.2 開源大模型的多模態探索集中于圖片,但進展飛快

當前開源大模型在多模態的探索仍處于初級階段,除 ImageBind 打通了六種模態外,多 數仍在探索文本與圖像的融合,但速度相當快,我們梳理了其中部分。

VisualGLM-6B:可在消費級顯卡上本地部署

團隊:VisualGLM-6B 是開源大語言模型 ChatGLM-6B 的多模態升級版模型,支 持圖像、中文和英文,由清華大學知識工程和數據挖掘小組發布。 技術:VisualGLM-6B 是由語言模型 ChatGLM-6B 與圖像模型 BLP2-Qformer 結 合,二者結合后的參數為 78 億(62 億+16 億)。該模型使用的預訓練數據集是 CogView 數據集中 3000 萬個高質量的“中文圖像-文本”和 3 億個“英文圖像 -文本”對。在微調階段,該模型在長視覺問答數據集上進行訓練,以生成符合 人類偏好的答案。 性能:根據 DataLearner,VisualGLM-6B 集成了模型量化技術,用戶可以在消 費級顯卡上本地部署模型,INT4 量化級別只需要 8.7G 的顯存。這意味著即使 是擁有游戲筆記本的用戶也可以快速且私密地部署這個模型,這在此類大小的 ChatGPT 類模型中尚屬首次。

UniDiffuser:為多模態設計的概率建模框架 UniDiffuser

團隊:清華大學計算機系朱軍教授帶領的 TSAIL 團隊于 3 月 12 日公開的一篇 論文《One Transformer Fits All Distributions in Multi-Modal Diffusion at Scale》, 進行了一些多模態的探索。 技術:UniDiffuser 采用該團隊提出的基于 Transformer 的網絡架構 U-ViT,在開 源的大規模圖文數據集 LAION 的 50 億參數版上,訓練了一個十億參數量的模 型,使得其能夠高質量地完成多種生成任務。 功能:簡單來講,該模型除了單向文生圖,還能實現圖生文、圖文聯合生成、 無條件圖文生成、圖文改寫等多種功能,實現了任意模態之間的相互轉化。

LLaVA:部分指令表現可比肩 GPT-4

團隊:由威斯康星大學麥迪遜分校,微軟研究院和哥倫比亞大學共同出品的 LLaVA,在 GitHub 上開源了代碼、模型和數據集。 技術:LLaVA 是一個端到端的多模態大模型,它連接了一個視覺編碼器和大語 言模型,用于通用的視覺和語言理解。 功能: 以文本為基礎的任務:LLaVA 可以處理并分析文本,允許用戶問問題,可以 和用戶交談,或者完成用戶輸入的任務,比如提煉文件概要、情感分析、實 體識別等。 以圖像為基礎的任務:LLaVA 可以分析圖像,描述圖像,進行物體識別,分 析理解場景。 性能:早期實驗表明,LLaVA 的多模態聊天能力有時在未見過的圖像/指令上都 能輸出比肩 GPT-4 的表現,在合成的多模態指令跟隨數據集上與 GPT-4 相比, 獲得了 85.1%的相對分數。

MiniGPT-4:脫胎于 LLaMA 的多模態開源大模型,個人用戶的 GPT-4“平替”

團隊:多模態 GPT-4 大模型的發布,將大眾對于大模型的熱情推到了一個新的高潮。但是 GPT-4 并沒有完全免費開放給個人,要想使用 GPT-4,要么需要通 過官方的邀請,要么需要升級到付費賬號。但即使付費,一些地區也無法進行 相關服務的購買。在這種環境下,阿布杜拉國王科技大學的 Deyao Zhu、Jun Chen 等人于 4 月 23 日發布了 MiniGPT-4,旨在將來自預訓練視覺編碼器的視 覺信息與先進的大語言模型結合。 技術:具體來說,MiniGPT-4 采用了與 BLIP-2 相同的預訓練視覺組件,其中該 組件由 EVA-CLIP 的 ViT-G/14 和 Q-Former 組成,同時使用大語言模型 Vicuna 調優,可以執行各種復雜的語言任務。 功能:MiniGPT-4 可實現許多玩法,如上傳一張海鮮大餐照片,即可得到菜譜; 上傳一張商品效果圖,即可獲得一篇帶貨文案;手繪一個網頁,即可得到對應 的 HTML 代碼。據使用過的人士反饋,MiniGPT-4 整體效果不錯,但目前對中文 支持還有待提高。

mPLUG-Owl:模塊化多模態大模型

團隊:mPLUG-Owl 是阿里巴巴達摩院 mPLUG 系列的最新工作,延續 mPLUG 系列的模塊化訓練思想,將語言大模型遷移為多模態大模型。 技術:mPLUG-Owl 采用 CLIP ViT-L/14 作為視覺基礎模塊,采用 LLaMA 初始化 的結構作為文本解碼器,采用類似 Flamingo 的 Perceiver Resampler 結構對視 覺特征進行重組。此外,mPLUG-Owl 第一次針對視覺相關的指令評測提出了全 面的測試集 OwlEval。 功能:mPLUG-Owl 具有很強的多輪對話能力、推理能力及笑話解釋能力。此外, 研究團隊還觀察到 mPLUG-Owl 初顯一些意想不到的能力,比如多圖關聯、多 語言、文字識別和文檔理解等能力。 性能:實驗證明 mPLUG-Owl 在視覺相關的指令回復任務上優于 BLIP2、LLaVA、 MiniGPT4。

5.2 專業化:下游生態發力,針對特定任務微調模型

大模型開源化為下游生態的蓬勃生長提供了絕佳機會,在細分產業的開發下,大模型開 始在特定任務上深化開發,改變人類生活。自開源大模型 LLaMA 推出后,基于 LLaMA 預 訓練模型微調的下游專業化模型開始浮現,例如醫療問診領域中的華駝。

團隊:華駝是基于中文醫學知識的 LLaMa 指令微調模型,在智能問診層面表現出色, 可生成一些更為可靠的醫學知識回答。在生物醫學領域,已發布的大語言模型模型 因為缺乏一定的醫學專業知識語料而表現不佳。4 月 14 日,哈爾濱工業大學一團隊 發布了其對 LLaMa 模型進行指令微調后得到的、針對醫學領域的、開源智能問診模 型 Hua Tuo。

技術:LLaMA 擁有 70 億~650 億參數等多個版本,為了更快速、高效地訓練,節約 訓練成本,華駝采用了 LLaMA70 億參數版本作為基礎模型。為了保證模型在醫學領 域回答問題的準確性,研究人員通過從中文醫學知識圖譜 CMeKG 中提取相關的醫 學知識,生成多樣的指令數據,并收集了超過 8000 條指令數據進行監督微調,以 確保模型回答問題的事實正確性。

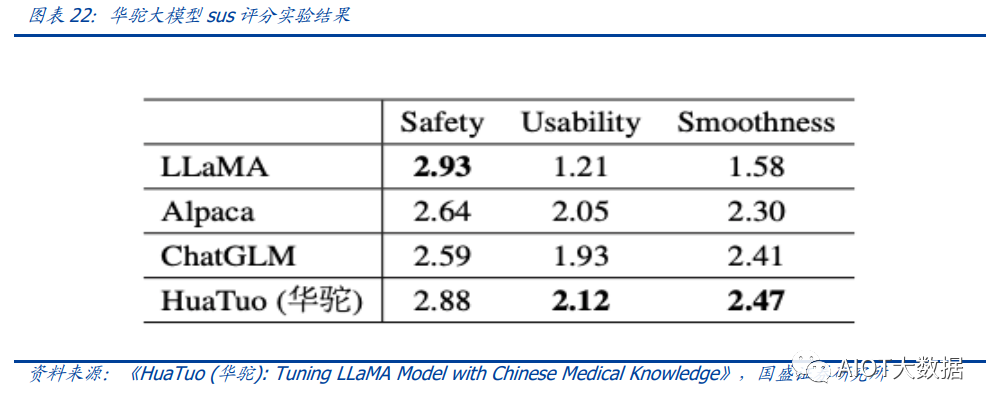

性能:在模型效果上,華駝與其他三個基準模型進行了比較。為了評估模型性能, 研究人員招募了五名具有醫學背景的專業醫師,在安全性、可用性、平穩性(SUS) 三個維度上進行評估。SUS 刻度從 1(不可接受)到 3(好),其中 2 表示可接受的 響應。平均 SUS 得分如下圖所示。結果表明,華駝模型顯著提高了知識可用性,同 時沒有太多地犧牲安全性。

華駝或將是未來開源大模型下游的特定任務模型發展的范式,即采用低參數體量的小型 開源大模型作為基礎模型,加之以特定專業領域的數據進行訓練,得到表現更好的細分 領域模型。

6 投資分析

6.1 微軟:與 OpenAI 深度合作

我們認為,短期內,ChatGPT 系仍是能力最強的大模型,與其深度合作的微軟將受益。 股權上,根據《財富》雜志報道,在 OpenAI 的第一批投資者收回初始資本后,微 軟將有權獲得 OpenAI 75%利潤,直到微軟收回投資成本(130 億美元);當 OpenAI 實現 920 億美元的利潤后,微軟的份額將降至 49%。與此同時,其他風險投資者和 OpenAI 的員工,也將有權獲得 OpenAI 49%的利潤,直到他們賺取約 1500 億美元。 如果達到這些上限,微軟和投資者的股份將歸還給 OpenAI 非營利基金會。 產品上,除了讓搜索引擎必應(Bing)整合 ChatGPT,2023 年 1 月,微軟宣布推出 Azure OpenAI 服務,Azure全球版企業客戶可以在云平臺上直接調用OpenAI模型, 包括 GPT3.5、Codex 和 DALL.E 模型,其后不久,微軟宣布將 GPT4 整合到了新必 應和 Office 升級版 Copilot 上。

6.2 英偉達:開源大模型帶動應用風起,算力需求狂飆

算力服務是開源大模型浪潮中受益確定性較強的方向,在軟硬件一體化方面具有明顯的 領先優勢,是當前 AI 算力的領頭羊。

6.2.1 超大模型對算力的需求將保持高增長

超大模型質量優勢突出,市場將持續追捧,其對算力的需求會一直增長。超大型模型具 有強大的表達能力和高準確性,在質量上具有優勢,市場將持續追捧這種模型。超大模 型規模、數據集和日活持續擴大,所需算力將持續增多。

6.2.2 開源大模型的快速追趕也將利好算力

短期內,市場對開源大模型持觀望態度。開源大模型在通用性上表現較差,短時間內無 法與大型模型抗衡,加之目前難以系統評價模型的具體性能,市場對開源大模型持觀望 態度,等待它們證明自己的性能和優勢。 中長期看,開源大模型有望進一步提高性能,從而在市場上占據更大的份額。相較于超 大模型,開源大模型具有更低的算力需求和更易于部署的特點,還可以通過快速微調等 方式,針對某些專業領域優化,具備一定吸引力和實用性。在中長期內,如果有開源大 模型能夠接近或超越 ChatGPT 在質量上的表現,那么市場對這類模型的需求可能會迅速 上升。相應地,這類算力需求會很快起量。

6.2.3 催化劑:開源大模型許可證、標準和能力評價體系的發展

許可證:我們認為,開源社區發展已久的許可證體系,豐富了開發者的選擇,有助 于大模型選擇適合自己的許可證,從而推動商業應用。大模型的繁榮發展,顯然將 帶動市場對算力的需求。

標準:我們預計,大模型社區或許還將產生類似于 Linux 開發標準 LSB 的標準,適 當的標準化將使得大模型的生態不至于過于分散。我們看好開源社區源源不斷的生命力對英偉達等算力服務商業績的推動。

大模型能力評價體系:有公信力的大模型能力評價體系將有助于市場快速分辨大模 型的能力,有助于大模型賽道的發展。

6.3 Meta:開源“急先鋒”,受益于開源生態

回顧安卓的發展史,我們看好“谷歌-安卓”體系中的類谷歌角色,在該體系中,谷歌作 為開源操作系統安卓的開發商,將開源作為激勵生態上下游發展的工具,增強自身專有 服務在終端客戶的曝光度。 映射到大模型,我們認為,開源了 LLaMA 的 Meta,可能通過 LLaMA,加深與下游大模 型開發廠商的合作,將自身體系中的專有產品,綁定銷售給客戶。

審核編輯 :李倩

-

Linux

+關注

關注

87文章

11329瀏覽量

209969 -

AI

+關注

關注

87文章

31294瀏覽量

269654 -

人工智能

+關注

關注

1792文章

47514瀏覽量

239246 -

模型

+關注

關注

1文章

3279瀏覽量

48976 -

數據集

+關注

關注

4文章

1208瀏覽量

24752

原文標題:技術與市場:AI大模型的“Linux時刻”降臨

文章出處:【微信號:AIOT大數據,微信公眾號:AIOT大數據】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

相關推薦

AI模型市場分析

AI大模型與深度學習的關系

《AI for Science:人工智能驅動科學創新》第二章AI for Science的技術支撐學習心得

ai大模型和傳統ai的區別在哪?

AI大模型與傳統AI的區別

AI大模型與小模型的優缺點

STM CUBE AI錯誤導入onnx模型報錯的原因?

防止AI大模型被黑客病毒入侵控制(原創)聆思大模型AI開發套件評測4

技術與市場:AI大模型的“Linux時刻”降臨

技術與市場:AI大模型的“Linux時刻”降臨

評論