2023年5月25日,美國微軟公司發(fā)布報告《AI治理:未來藍圖》(Governing AI: A Blueprint for the Future),詳細介紹了政府在制定人工智能的政策、法律和法規(guī)時應(yīng)考慮的五項指導方針。

元戰(zhàn)略觀察員精心編譯本報告,為人工智能治理研究提供參考。

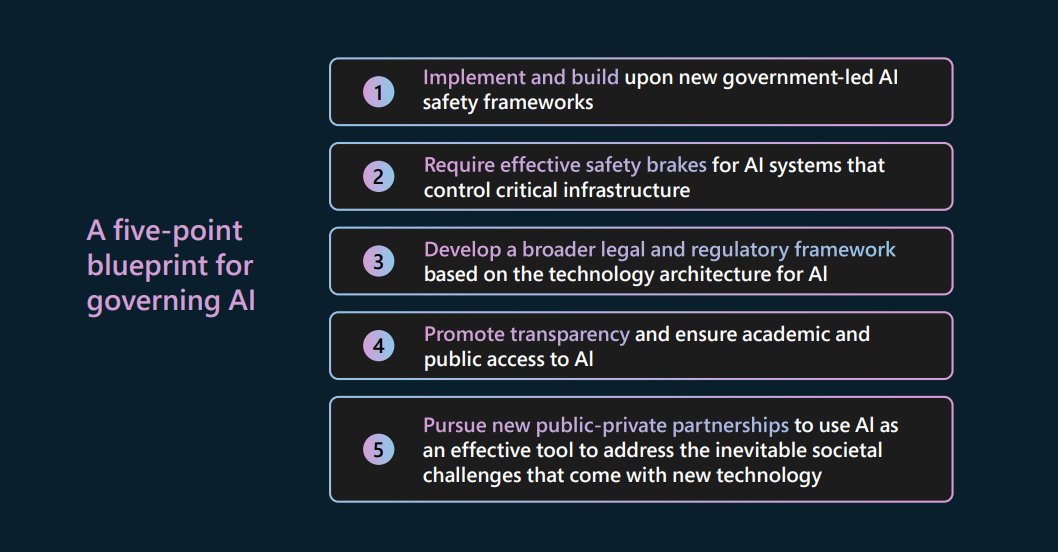

各國政府正在尋求或制定治理人工智能的新藍圖。基于眾多緊迫的問題和議題,本報告在此提出一個方案,以幫助人工智能治理取得更快進展。該方案認同人工智能可以改善人們的生活,同時也制定了新的治理措施。基于政府和私營部門的倡議,該方案為人工智能治理提出五項建議:

1.搭建并執(zhí)行以政府為主導的人工智能安全新框架;

2.控制關(guān)鍵基礎(chǔ)設(shè)施的人工智能系統(tǒng)必須具備有效的安全防護措施;

3.基于人工智能技術(shù)架構(gòu),搭建范圍更廣的法律監(jiān)管框架;

4.提升透明度,確保學界和公眾可利用人工智能技術(shù);

5.加強公私合作,用人工智能解決新技術(shù)引發(fā)的社會挑戰(zhàn)。

通過該方案,微軟在一定程度上回應(yīng)了美國白宮最近對人工智能公司的倡議,承諾確保人工智能的安全性和可靠性。

1、搭建并執(zhí)行以政府

為主導的人工智能安全新框架

微軟以政府工作的最新進展為基礎(chǔ),通過以下四種方式來提升人工智能的安全性:

第一,微軟回應(yīng)美國白宮最近的倡議,承諾將實施美國國家標準與技術(shù)研究院(NIST)的人工智能風險管理框架。

第二,將通過采取新措施,進一步加強與高風險人工智能系統(tǒng)相關(guān)的工程實踐,來完善微軟現(xiàn)有的人工智能測試工作。

第三,政府可以通過行政命令推進治理進程,要求向美國政府提供關(guān)鍵人工智能系統(tǒng)的供應(yīng)商,應(yīng)當自證其正在實施NIST的人工智能風險管理框架。

第四,與其他行業(yè)領(lǐng)導者和政府合作,制定與高度可靠的基礎(chǔ)模型相關(guān)的新標準。

我們認識到,人工智能的快速發(fā)展帶來了新的安全問題,并且通過合作制定可操作的標準,以幫助評估和解決這些問題。OpenAI、Google、Anthropic和其他人工智能公司的領(lǐng)導者已提出了重要的想法,為未來人工智能安全的進展奠定基礎(chǔ)。

2、控制關(guān)鍵基礎(chǔ)設(shè)施的人工智能系統(tǒng)

必須具備有效的安全防護措施

展望人工智能的未來,控制新技術(shù)潛在風險的基本方法一直以來都是有效的。該方法就是提前識別出新產(chǎn)品何時失控,并部署有效的安全“剎車”機制,以確保人工監(jiān)督的有效性、及時性。

隨著人工智能變得越來越強大,電網(wǎng)、供水系統(tǒng)和城市交通等關(guān)鍵基礎(chǔ)設(shè)施交由人工智能控制的程度日益加深。因此,我們需要安全“剎車”機制來確保這些系統(tǒng)處于人類控制之下。

新的安全要求能為控制關(guān)鍵基礎(chǔ)設(shè)施運行的人工智能系統(tǒng)進行安全“剎車”,從而確保基礎(chǔ)設(shè)施人工監(jiān)督的有效性、彈性和穩(wěn)健性。政府將定義控制關(guān)鍵基礎(chǔ)設(shè)施的高風險人工智能系統(tǒng)的類別,并確保運營商定期測試高風險系統(tǒng),以確保系統(tǒng)安全措施有效。

3、基于人工智能技術(shù)架構(gòu)

搭建范圍更廣的法律監(jiān)管框架

隨著對人工智能潛在監(jiān)管問題的深入思考,我們需要建立一個與人工智能技術(shù)本身相符的法律和監(jiān)管框架。簡而言之,法律需要根據(jù)不同行為者在管理人工智能技術(shù)上的不同角色,賦予他們不同的監(jiān)管責任。

在搭建人工智能的法律監(jiān)管框架時,一方面,需要將現(xiàn)有的法律保護措施應(yīng)用于人工智能。

第一,與客戶合作,推動他們使用最佳方式來合法、負責地部署人工智能。

第二,監(jiān)管機構(gòu)需要新的人工智能專業(yè)知識和能力。

第三,支持廣泛的教育倡議,為立法者、法官和律師提供人工智能技術(shù)和負責任的人工智能信息。

第四,人工智能的快速進步給立法者或執(zhí)法人員帶來了新壓力,他們需要了解新的人工智能技術(shù)及其工作原理。

另一方面,針對高水平能力的人工智能基礎(chǔ)模型制定新的法律法規(guī)。

第一,和其他領(lǐng)先的人工智能開發(fā)者共享先進人工智能模型的專業(yè)知識,以降低監(jiān)管門檻。

第二,確立開發(fā)或部署高水平人工智能模型需要滿足的條件。

第三,通過對人工智能數(shù)據(jù)中心運營商施加許可要求,確保有效執(zhí)行高水平人工智能模型的許可制度。

4、提升透明度

確保學界和公眾可利用人工智能技術(shù)

未來,有許多人工智能的政策問題有待認真討論,包括安全與透明度之間的關(guān)系問題。在某些領(lǐng)域,許多專家認為保密對于安全至關(guān)重要,尤其是對于國家安全和公共安全。除此之外,透明度也很重要,甚至有助于更好地理解安全需求和最佳實踐。

微軟于2018年采用了人工智能倫理準則,并將透明度作為六項基本原則之一。在實施這一原則時,我們意識到在不同情況下提供不同類型的透明度非常重要。生成式人工智能的出現(xiàn)使得這一原則比以往更加重要,這也是需要持續(xù)進行研究和創(chuàng)新的關(guān)鍵領(lǐng)域。為了推動該領(lǐng)域的工作,微軟向美國白宮做出了以下三項承諾:

第一,微軟將發(fā)布年度透明度報告,向公眾介紹其在負責任和安全管理人工智能方面的政策、系統(tǒng)、進展和表現(xiàn)。

第二,微軟將支持建立一個開放的、供公眾查閱的國家高風險人工智能系統(tǒng)注冊機構(gòu),讓公眾了解這些系統(tǒng)的使用情況和方式。

第三,微軟承諾確保其人工智能系統(tǒng)在與公眾互動時能夠清晰地向其傳達系統(tǒng)的能力和不足。

第四,微軟認同在重要場景中需標記人工智能生成的內(nèi)容,以便公眾“知曉所接收的內(nèi)容”。

5、加強公私合作

用人工智能解決新技術(shù)引發(fā)的社會挑戰(zhàn)

微軟相信,公共和私營部門可以聯(lián)合起來利用人工智能來改善世界,其中包括對抗技術(shù)變革所帶來的挑戰(zhàn)。微軟對未來保持清醒的認識,并意識到有些人試圖將人工智能作為武器而不是工具,技術(shù)變革會不可避免地帶來難以預(yù)料的困難和問題。

近年來,人們越來越關(guān)注解決民主社會所面臨的新風險,這些風險源于人工智能的潛在武器化。我們對未來技術(shù)的擔憂是合理的,需要共同努力來對抗這種威脅。

在這一進程中,內(nèi)容溯源和真實性聯(lián)盟(C2PA)至關(guān)重要。該聯(lián)盟由Adobe、BBC、Intel、Microsoft、Sony和Truepic等公司共同創(chuàng)立,整合了Adobe領(lǐng)導的內(nèi)容真實性倡議(CAI),該倡議致力于為數(shù)字媒體提供歷史背景,以及Microsoft和BBC領(lǐng)導的Project Origin倡議,旨在解決數(shù)字新聞生態(tài)系統(tǒng)中的虛假信息問題。

正如微軟首席科學官埃里克·霍維茨去年所說,公私合營的成功需要采取“多管齊下的方法,包括媒體素養(yǎng)、意識和警覺性的培養(yǎng),以及投資高質(zhì)量傳媒業(yè)的發(fā)展”。

微軟將推出一套新的先進溯源工具,幫助公眾識別人工智能生成的視聽內(nèi)容并了解其來源。在年度開發(fā)者大會上,微軟宣布正在開發(fā)新的媒體溯源服務(wù)。該服務(wù)將使用元數(shù)據(jù)標記和簽名來驗證人工智能生成的視頻和圖像的真實性,該服務(wù)將按照C2PA的規(guī)范來實施。微軟將支持主流的圖像和視頻格式,并將該服務(wù)提供給兩款新人工智能產(chǎn)品Microsoft Designer和Bing Image Creator使用。這是一個重要措施,但也只是眾多措施中的一個。幸運的是,許多人也正在采取類似且關(guān)鍵的行動,因此,需要將相關(guān)實踐與更廣泛的倡議結(jié)合起來。

-

微軟

+關(guān)注

關(guān)注

4文章

6612瀏覽量

104162 -

人工智能

+關(guān)注

關(guān)注

1792文章

47425瀏覽量

238948

原文標題:微軟發(fā)布!人工智能治理:未來藍圖

文章出處:【微信號:AI智勝未來,微信公眾號:AI智勝未來】歡迎添加關(guān)注!文章轉(zhuǎn)載請注明出處。

發(fā)布評論請先 登錄

相關(guān)推薦

微軟發(fā)布!人工智能治理:未來藍圖

微軟發(fā)布!人工智能治理:未來藍圖

評論