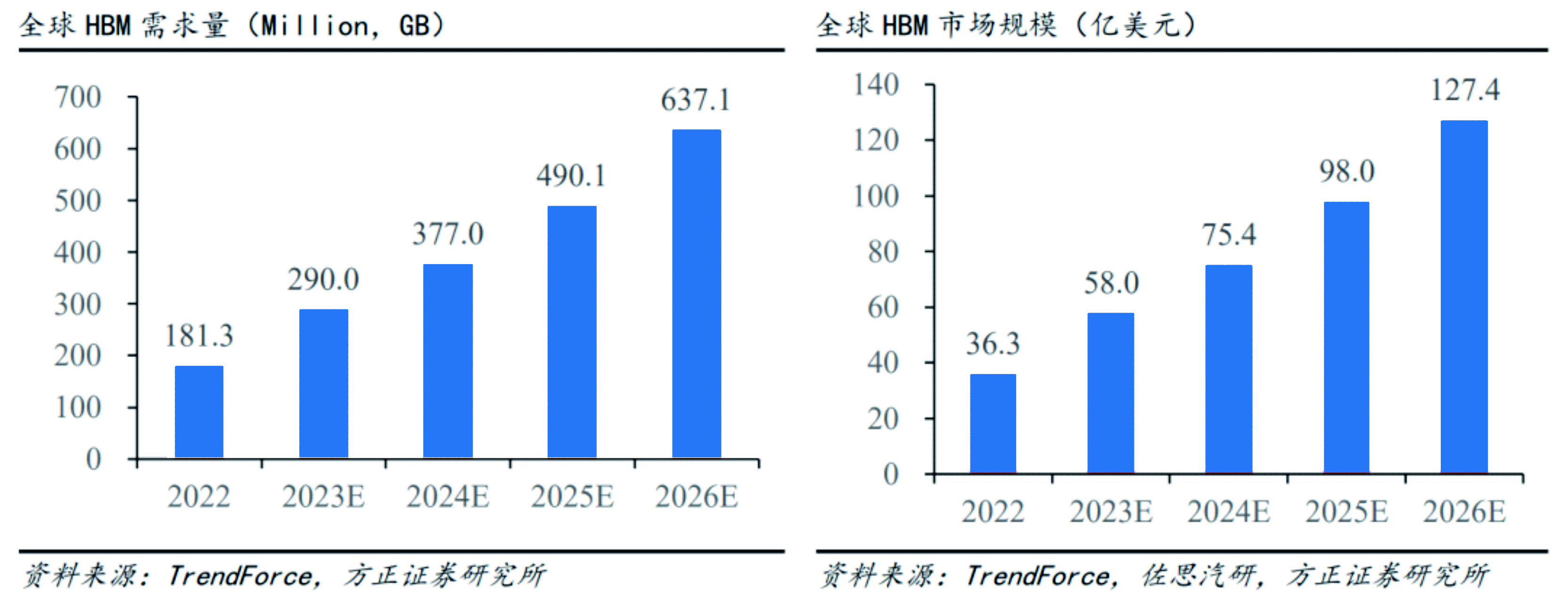

6月28日,trendforce集邦咨詢公司發表研究報告稱,hbm芯片搭載在尖端ai服務器gpu上,預計到2023年,hbm需求將每年增加60%,達到2.9億gb,到2024年將增加30%。

到2025年,如果世界上有5個像chatgpt這樣的超大型aigc, 25個像midjourney這樣的中尺寸產品,以及80個小型產品,那么nvidia a100 gpu將至少包括145,600到233,700個。此外,超級電腦、8k動影像、ar/vr等的應用也可以進一步提高云計算系統的負載。

由于hbm存儲器芯片比ddr sdram的帶寬更高,電力消耗相對較低,因此,最近上市的主力hpc處理器和加速運算gpu都使用hbm存儲器。預計,今后hbm將能夠代替部分gddr sd內存和ddr sd內存的普通內存。

據集邦咨詢公司預測,目前nvidia a100、h100、amd mi300及大型云提供企業谷歌、aws等自行開發的asic ai服務器需求較強,到2023年ai服務器出貨量(包括gpu、fpga、asic等)將達到120萬臺。年增長率接近38%。ai芯片的出貨量也將一致轉為上升趨勢,預計今年將增加50%。

-

云計算

+關注

關注

39文章

7848瀏覽量

137629 -

ChatGPT

+關注

關注

29文章

1566瀏覽量

7878 -

AIGC

+關注

關注

1文章

366瀏覽量

1573

發布評論請先 登錄

相關推薦

AI興起推動HBM需求激增,DRAM市場面臨重塑

HBM明年售價預計上漲18%,營收年增156%

機構:2024年中國大陸芯片出口額將達950億美元

三星預測HBM需求至2025年翻倍增長

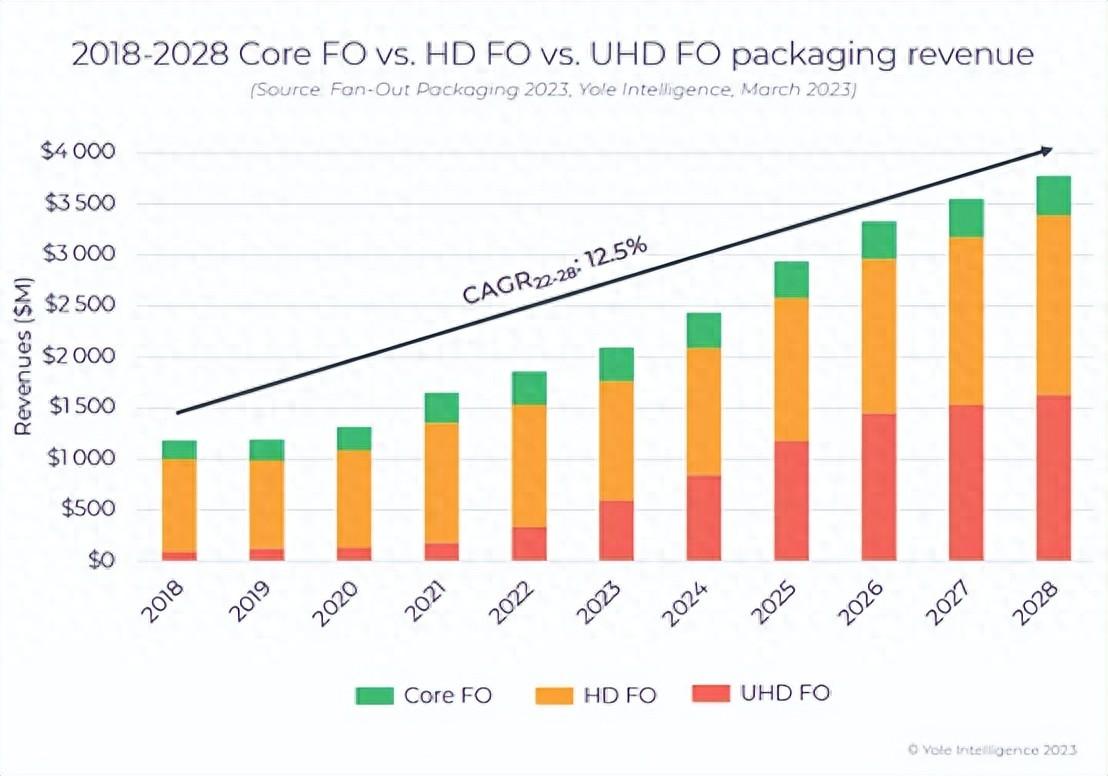

扇出型 (Fan-Out)封裝市場規模到2028 年將達到38 億美元

劍指HBM及AI芯片,普萊信重磅發布Loong系列TCB先進封裝設備

預計2023年對HBM需求量將增加60%,達到2.9億GB

預計2023年對HBM需求量將增加60%,達到2.9億GB

評論