LLM 的能力還可以發揮到機器學習的更多子領域。

當前,大型語言模型(LLM)已經掀起自然語言處理(NLP)領域的變革浪潮。我們看到 LLM 具備強大的涌現能力,在復雜的語言理解任務、生成任務乃至推理任務上都表現優異。這啟發人們進一步探索 LLM 在機器學習另一子領域 —— 計算機視覺(CV)方面的潛力。 LLM 的一項卓越才能是它們具備上下文學習的能力。上下文學習不會更新 LLM 的任何參數,卻在各種 NLP 任務中卻展現出了令人驚艷的成果。那么,GPT 能否通過上下文學習解決視覺任務呢? 最近,來自谷歌和卡內基梅隆大學(CMU)的研究者聯合發表的一篇論文表明:只要我們能夠將圖像(或其他非語言模態)轉化為 LLM 能夠理解的語言,這似乎是可行的。

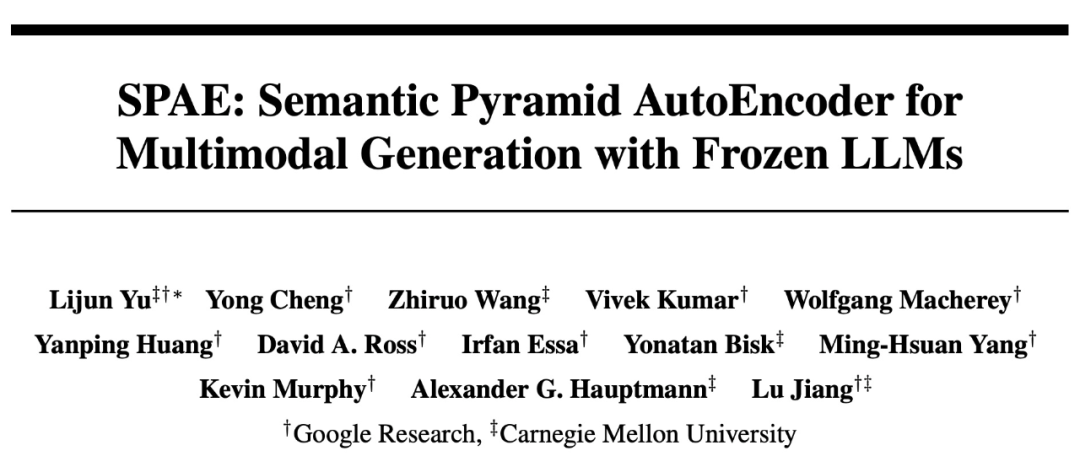

SPAE: Semantic Pyramid AutoEncoder for Multimodal Generation with Frozen LLMs 代碼:https://github.com/google-research/magvit/ 論文地址:https://arxiv.org/abs/2306.17842 這篇論文揭示了 PaLM 或 GPT 在通過上下文學習解決視覺任務方面的能力,并提出了新方法 SPAE(Semantic Pyramid AutoEncoder)。這種新方法使得 LLM 能夠執行圖像生成任務,而無需進行任何參數更新。這也是使用上下文學習使得 LLM 生成圖像內容的首個成功方法。 我們先來看一下通過上下文學習,LLM 在生成圖像內容方面的實驗效果。 例如,在給定上下文中,通過提供 50 張手寫圖像,論文要求 PaLM 2 回答需要生成數字圖像作為輸出的復雜查詢:

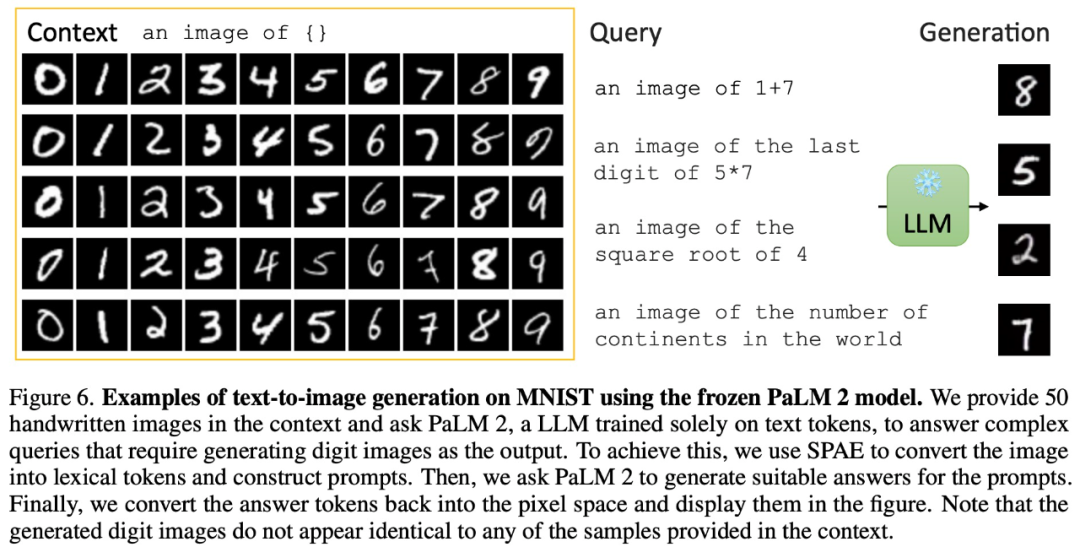

還能在有圖像上下文輸入的情況下生成逼真的現實圖像:

除了生成圖像,通過上下文學習,PaLM 2 還能進行圖像描述:

還有與圖像相關問題的視覺問答:

甚至可以去噪生成視頻:

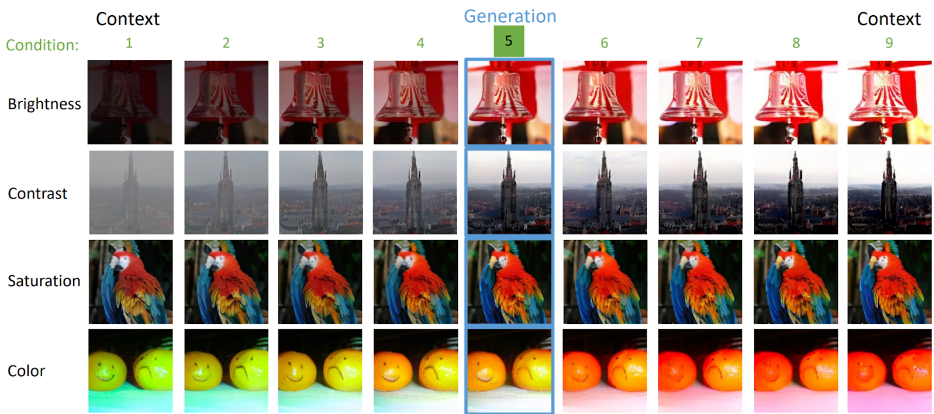

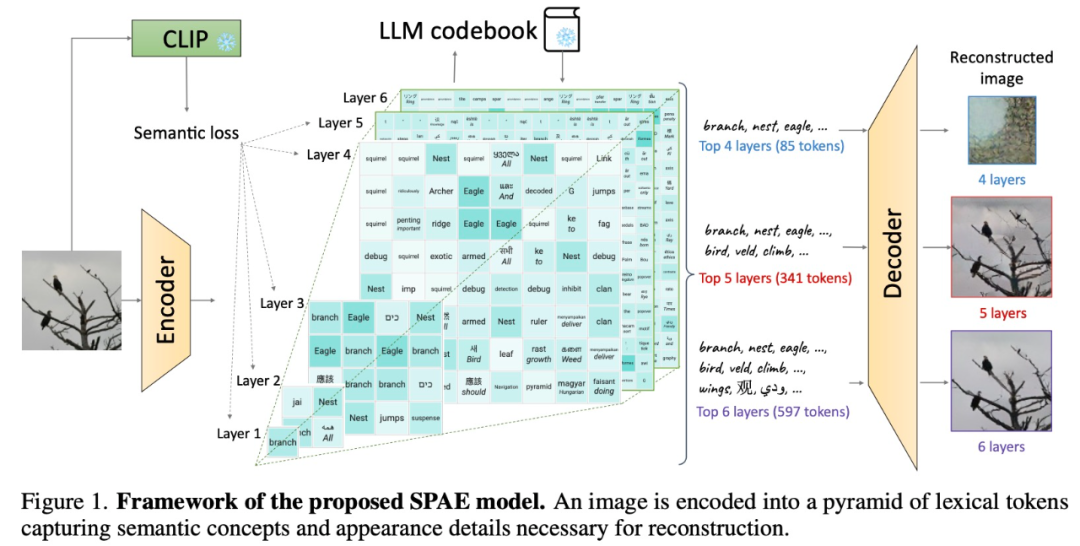

方法概述 實際上,將圖像轉化為 LLM 能夠理解的語言,是在視覺 Transformer(ViT)論文中就已經研究過的問題。在 Google 和 CMU 的這篇論文中,他們將其提升到了一個新的層次 —— 使用實際的單詞來表示圖像。 這種方法就像建造一個充滿文字的塔樓,捕捉圖像的語義和細節。這種充滿文字的表示方法讓圖像描述可以輕松生成,并讓 LLM 可以回答與圖像相關的問題,甚至可以重構圖像像素。

具體來說,該研究提出使用經過訓練的編碼器和 CLIP 模型將圖像轉換為一個 token 空間;然后利用 LLM 生成合適的詞法 token;最后使用訓練有素的解碼器將這些 token 轉換回像素空間。這個巧妙的過程將圖像轉換為 LLM 可以理解的語言,使我們能夠利用 LLM 在視覺任務中的生成能力。

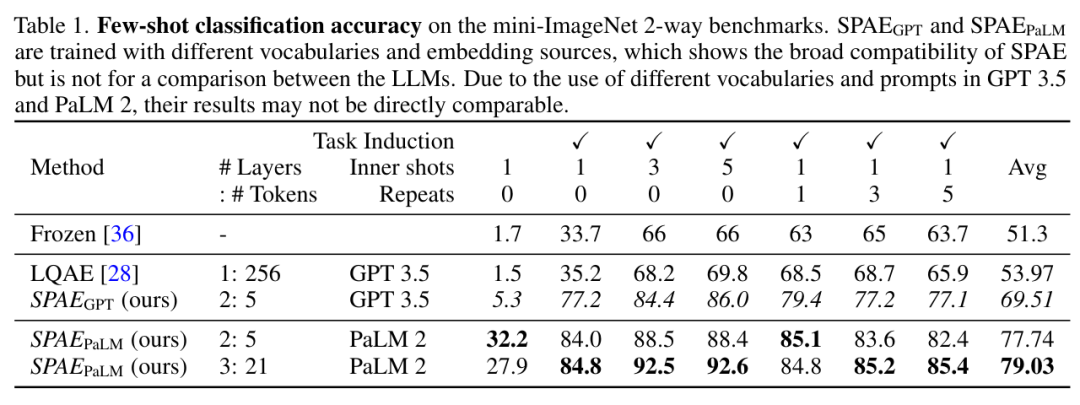

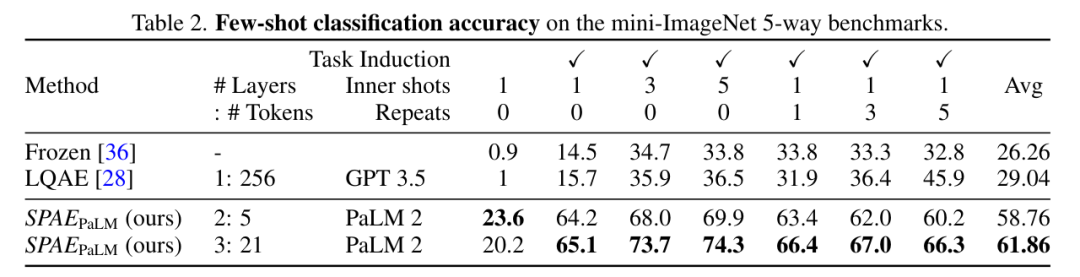

實驗及結果 該研究將 SPAE 與 SOTA 方法 Frozen 和 LQAE 進行了實驗比較,結果如下表 1 所示。SPAEGPT 在所有任務上性能均優于LQAE,且僅使用 2% 的 token。

總的來說,在 mini-ImageNet 基準上的測試表明,SPAE 方法相比之前的 SOTA 方法提升了 25% 的性能。

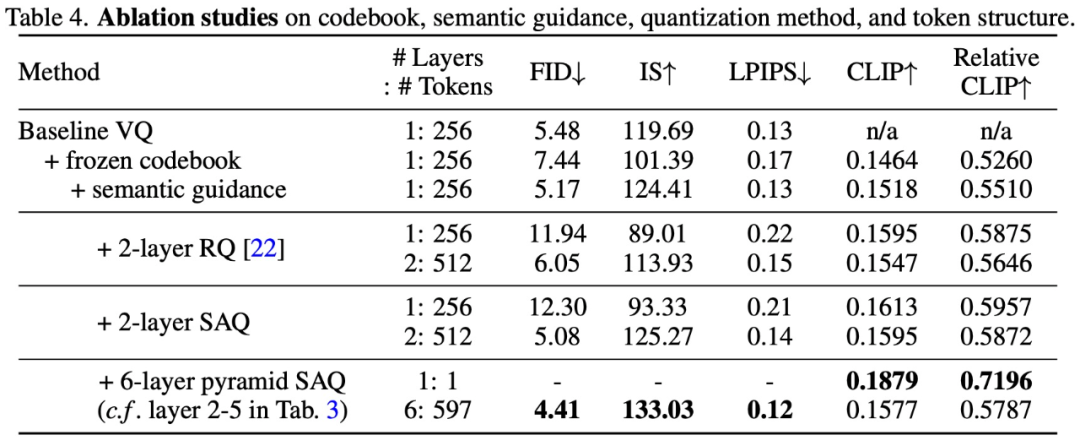

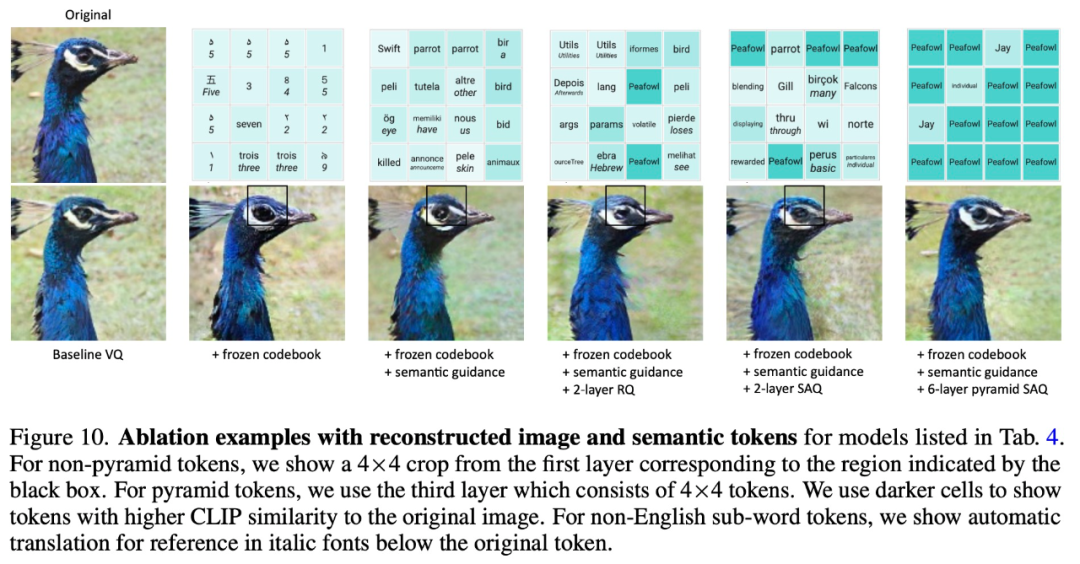

為了驗證 SPAE 設計方法的有效性,該研究進行了消融實驗,實驗結果如下表 4 和圖 10 所示:

-

語言模型

+關注

關注

0文章

524瀏覽量

10277 -

GPT

+關注

關注

0文章

354瀏覽量

15372 -

nlp

+關注

關注

1文章

488瀏覽量

22035

原文標題:谷歌新作SPAE:GPT等大語言模型可以通過上下文學習解決視覺任務

文章出處:【微信號:CVer,微信公眾號:CVer】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

相關推薦

為什么transformer性能這么好?Transformer的上下文學習能力是哪來的?

【大語言模型:原理與工程實踐】揭開大語言模型的面紗

【大語言模型:原理與工程實踐】大語言模型的基礎技術

《具身智能機器人系統》第7-9章閱讀心得之具身智能機器人與大模型

關于進程上下文、中斷上下文及原子上下文的一些概念理解

進程上下文與中斷上下文的理解

中斷中的上下文切換詳解

基于多Agent的用戶上下文自適應站點構架

終端業務上下文的定義方法及業務模型

基于上下文相似度的分解推薦算法

Web服務的上下文的訪問控制策略模型

首篇!Point-In-Context:探索用于3D點云理解的上下文學習

更強更通用:智源「悟道3.0」Emu多模態大模型開源,在多模態序列中「補全一切」

谷歌新作SPAE:GPT等大語言模型可以通過上下文學習解決視覺任務

谷歌新作SPAE:GPT等大語言模型可以通過上下文學習解決視覺任務

評論