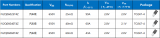

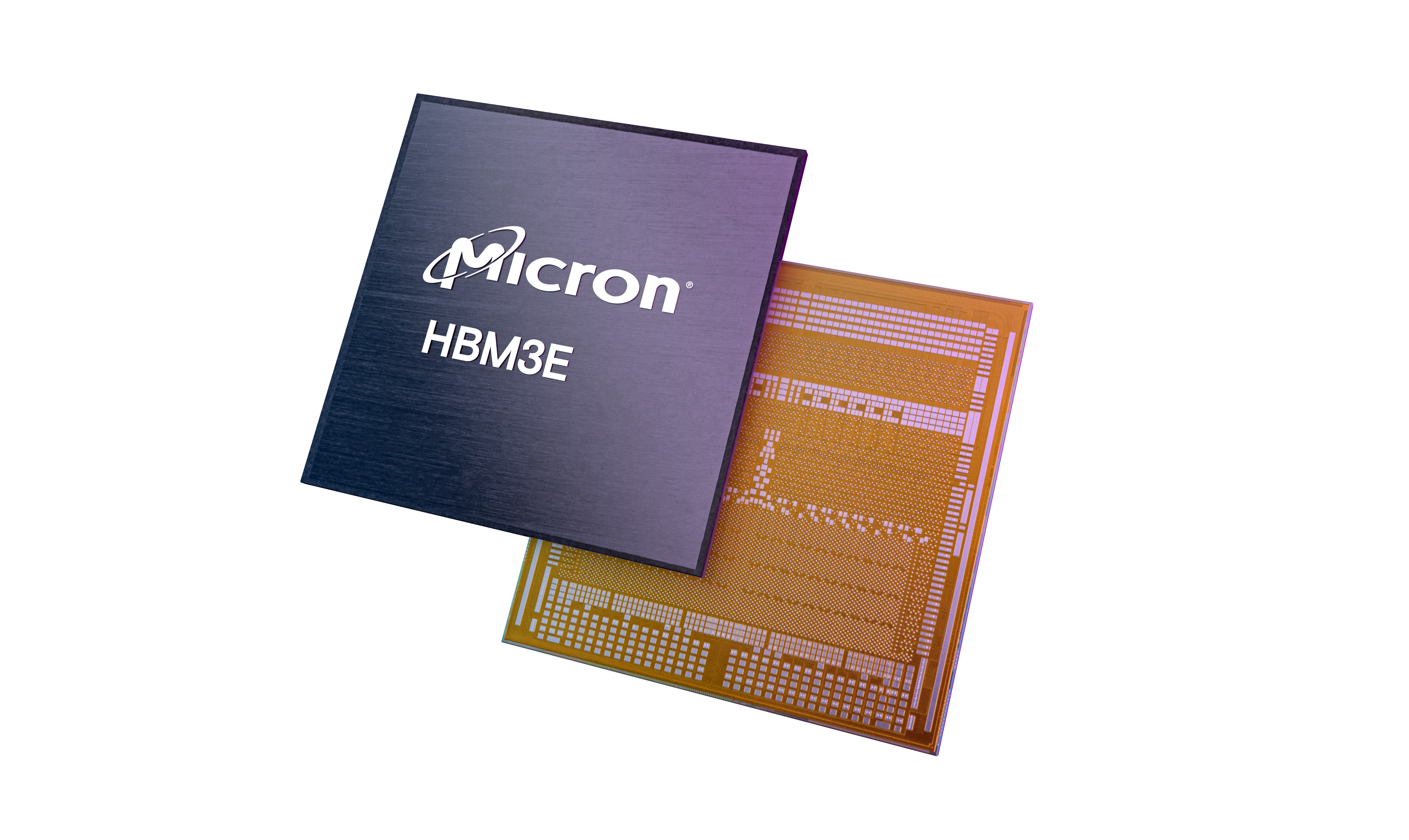

Micron Technology Inc.(美光科技股份有限公司,納斯達克股票代碼:MU)今日宣布,公司已開始出樣業界首款 8 層堆疊的 24GB 容量第二代 HBM3 內存,其帶寬超過 1.2TB/s,引腳速率超過 9.2Gb/s,比當前市面上現有的 HBM3 解決方案性能可提升最高 50%。美光第二代 HBM3 產品與前一代產品相比,每瓦性能提高 2.5 倍,創下了關鍵型人工智能(AI)數據中心性能、容量和能效指標的新紀錄,將助力業界縮短大型語言模型(如 GPT-4 及更高版本)的訓練時間,為 AI 推理提供高效的基礎設施,并降低總體擁有成本(TCO)。

美光基于業界前沿的 1β DRAM 制程節點推出高帶寬內存(HBM)解決方案,將 24Gb DRAM 裸片封裝進行業標準尺寸的 8 層堆疊模塊中。此外,美光 12 層堆疊的 36GB 容量產品也將于 2024 年第一季度開始出樣。與當前市面上其他的 8 層堆疊解決方案相比,美光 HBM3 解決方案的容量提升了 50%。美光第二代 HBM3 產品的性能功耗比和引腳速度的提升對于管理當今 AI 數據中心的極端功耗需求至關重要。美光通過技術革新實現了能效的顯著提升,例如與業界其他 HBM3 解決方案相比,美光將硅通孔(TSV)數量翻倍,增加 5 倍金屬密度以降低熱阻,以及設計更為節能的數據通路。

美光作為 2.5D/3D 堆疊和先進封裝技術領域長久以來的存儲領導廠商,有幸成為臺積電 3DFabric 聯盟的合作伙伴成員,共同構建半導體和系統創新的未來。在第二代 HBM3 產品開發過程中,美光與臺積電攜手合作,為 AI 及高性能計算(HPC)設計應用中順利引入和集成計算系統奠定了基礎。臺積電目前已收到美光第二代 HBM3 內存樣片,正與美光密切合作進行下一步的評估和測試,助力客戶的下一代高性能計算應用創新。

美光第二代 HBM3 解決方案滿足了生成式 AI 領域對多模態、數萬億參數 AI 模型日益增長的需求。憑借高達 24GB 的單模塊容量和超過 9.2Gb/s 的引腳速率,美光 HBM3 能使大型語言模型的訓練時間縮短 30% 以上,從而降低總體擁有成本。此外,美光 HBM3 將觸發每日查詢量的顯著增加,從而更有效地利用訓練過的模型。美光第二代 HBM3 內存擁有業界一流的每瓦性能,將切實推動現代 AI 數據中心節省運營開支。在已經部署的 1,000 萬個圖形處理器(GPU)用例中,單個 HBM 模塊可節約 5W 功耗,能在五年內節省高達 5.5 億美元的運營費用。

美光副總裁暨計算與網絡事業部計算產品事業群總經理 Praveen Vaidyanathan 表示:“美光第二代 HBM3 解決方案旨在為客戶及業界提供卓越的人工智能和高性能計算解決方案。我們的一個重要考量標準是,該產品在客戶平臺上是否易于集成。美光 HBM3 具有完全可編程的內存內建自測試(MBIST)功能,可在完整規格的引腳速度下運行,使美光能為客戶提供更強大的測試能力,實現高效協作,助力客戶縮短產品上市時間。”

英偉達超大規模和高性能計算副總裁 Ian Buck 表示:“生成式 AI 的核心是加速計算,HBM 的高帶寬至關重要,并帶來更出色的能效。我們與美光在眾多產品領域保持了長期合作,非常期待與美光在第二代 HBM3 產品上繼續合作,加速 AI 創新。”

第二代 HBM3 是美光領先技術的又一個里程碑。美光此前宣布推出基于 1α(1-alpha)節點、24Gb 單塊 DRAM 裸片的 96GB 容量 DDR5 模組用于大容量服務器解決方案;如今推出基于 1β 節點、24Gb 單塊 DRAM 裸片的 24GB 容量 HBM3 產品,并計劃于 2024 年上半年推出基于 1β 節點、32Gb 單塊 DRAM 裸片的 128GB 容量 DDR5 模組。這些新品展現了美光在 AI 服務器領域的前沿技術創新。

審核編輯:湯梓紅

-

內存

+關注

關注

8文章

3025瀏覽量

74056 -

AI

+關注

關注

87文章

30896瀏覽量

269110 -

美光

+關注

關注

5文章

712瀏覽量

51419 -

英偉達

+關注

關注

22文章

3776瀏覽量

91111 -

HBM3

+關注

關注

0文章

74瀏覽量

154

原文標題:美光推出性能更出色的大容量高帶寬內存 (HBM),助力生成式人工智能創新

文章出處:【微信號:gh_195c6bf0b140,微信公眾號:Micron美光科技】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

相關推薦

Rambus推出業界首款HBM4控制器IP

AMD推出第二代Versal Premium系列

三星推出業界首款24Gb(3GB)GDDR7 DRAM內存芯片

三星發布業界首款24Gb GDDR7 DRAM

聚辰基于第二代NORD工藝平臺推出業界最小尺寸高可靠NOR Flash系列芯片

NVIDIA預定購三星獨家供應的大量12層HBM3E內存

瞻芯電子開發的3款第二代650V SiC MOSFET通過了車規級可靠性認證

美光推出業界首款8層堆疊的24GB容量第二代HBM3內存

美光推出業界首款8層堆疊的24GB容量第二代HBM3內存

評論