2023 年《NVIDIA 專家面對面技術沙龍----——大語言模型專場》于 7 月 30 日下午在北京順利舉行。闊別兩年,首次重返線下!即便是滂沱大雨,也阻擋不了數百位與會者的熱情。本次活動共匯聚了 40 余位 NVIDIA 技術專家和上百位業界人才圍繞大語音模型進行全面交流和深入探討。包含來自科研教育、汽車、金融服務、能源、消費者互聯網、醫療健康、電信、云服務、制造業、農業及初創企業等各大領域的開發人員、工程師、研發經理、技術負責人等專家。NVIDIA 全球副總裁劉念寧以及 NVIDIA中國區工程和解決方案高級總監賴俊杰博士通過現場致辭,成功為本屆的技術沙龍揭開完美序幕。

劉念寧表示,“在 NVIDIA,除了過往的經驗累積造就成功決策之外,更重要的是,研發團隊大量創新想法的涌現以及團隊之間的相互碰撞和與客戶之間的相互激蕩 。正如同本次的專家面對面活動,專家們不僅來自于 NVIDIA 團隊,更包括來自現場在坐的各位,你們最了解前端的應用場景,雙方透過互動交流,NVIDIA 才能夠一步步在 AI 領域造就技術創新。”

賴俊杰表示,“NVIDIA 之所以在軟硬件生態做得相對優秀,其實是因為我們很注重去聽取來自不同行業客戶的反饋,包括軟件、硬件、應用的需求,針對這個需求,我們研發出相應的解決方案,然后再將其融入固化到產品中。透過這樣的專家面對面線下的活動,我們期許這個交流是雙向的,而不只是單向輸出。衷心希望大家不虛此行,通過今天的交流,各位皆能有所收獲。”

主論壇分享精彩回顧

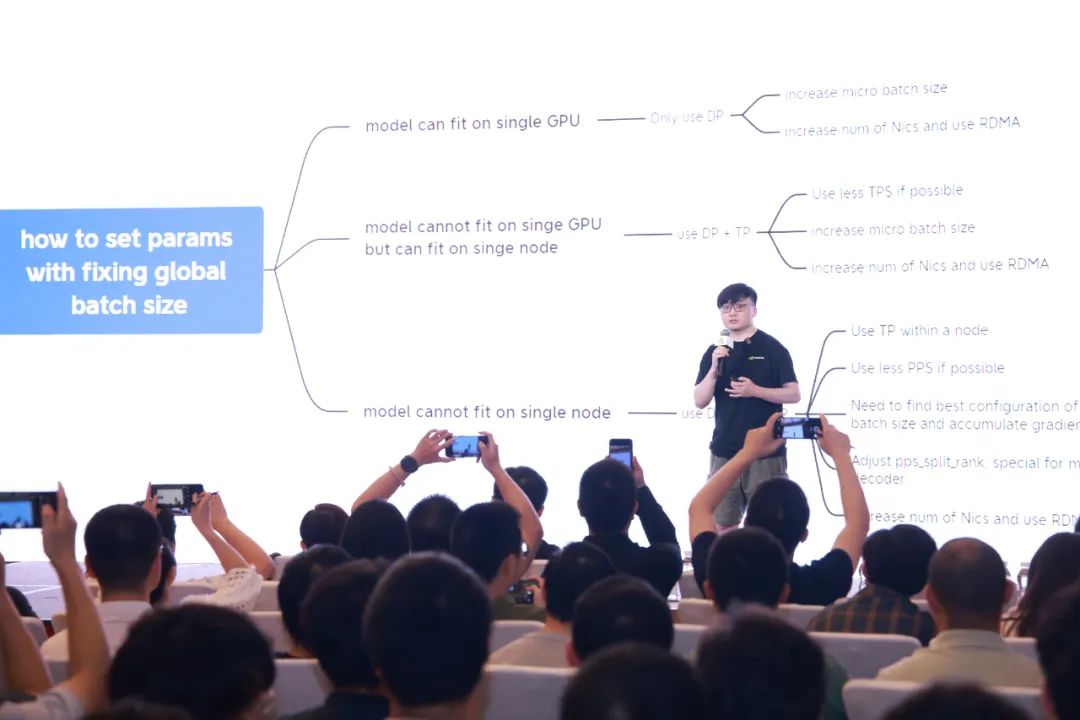

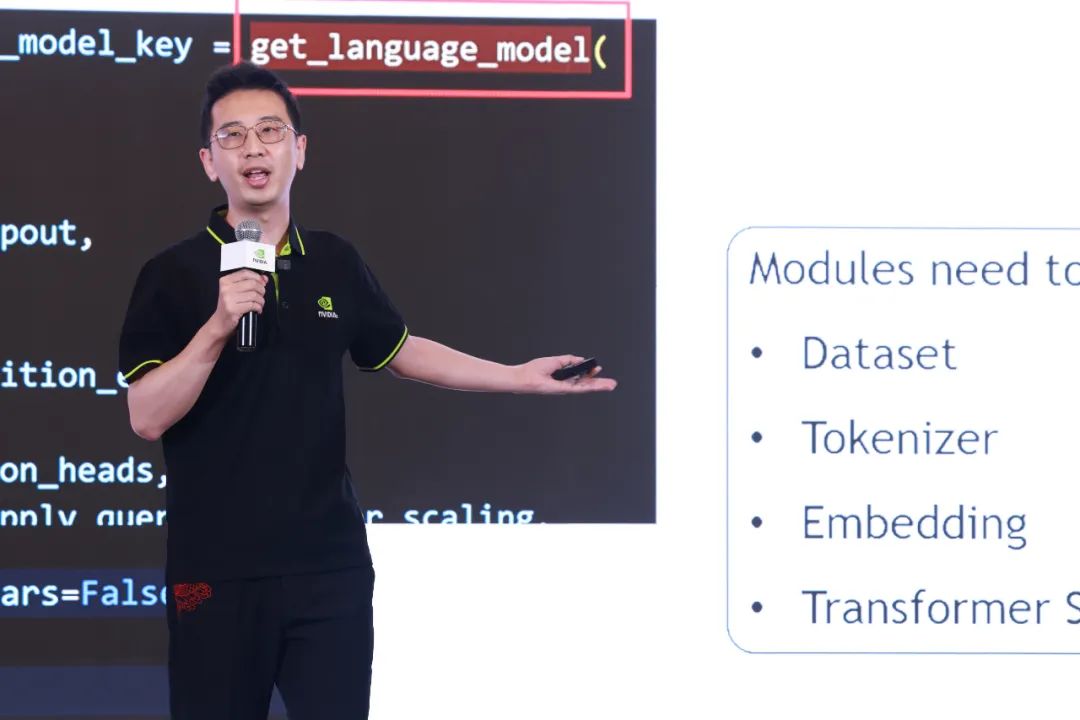

本次技術沙龍以大語言模型(LLM)為主題,NVIDIA 技術團隊共分享了三大技術指南,包括從大語言模型的基礎設施搭建、訓練到推理,助力企業打造專屬的大模型高光時刻。

-

LLM 基礎設施最佳實踐:如何建構穩定的大模型訓練系統的方法論,訓練任務生命周期拆解,如何做好集群監控、確保環境可靠和針對大模型訓練集群的存儲設計,以及集群參考架構的分享。

-

LLM 訓練最佳實踐:NVIDIA 針對大模型訓練的解決方案 NeMo Framework 概要,如何做數據治理、超參搜尋、分布式訓練加速、FP8 混合精度訓練以及 RLHF 的最佳實踐,NeMo Framework 對社區模型和自定義模型的支持進展和方法。

-

LLM 推理最佳實踐:剖析 LLM 生成階段之加速技術 K/V Cache、Self-Attention 推理加速技術實測、LLM 推理服務部署優化技術實踐,以及如何進行大模型低精度推理的最佳實踐。

左右滑動查看主論壇活動照片

深度交流,共話 LLM 挑戰與創新進展

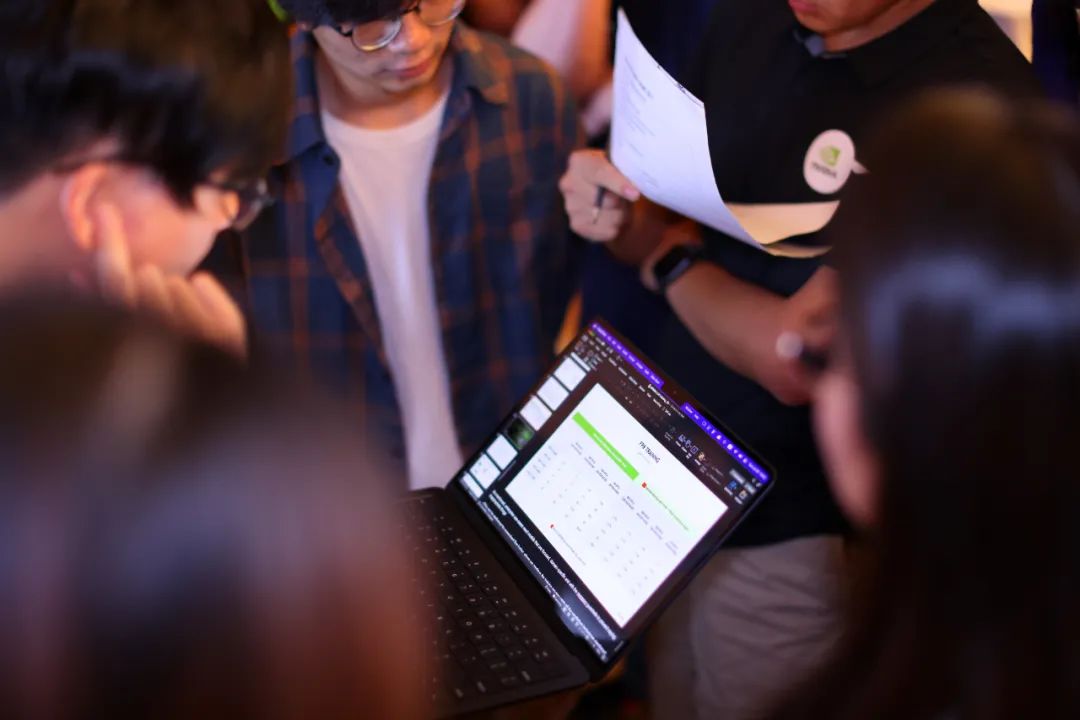

除了主論壇分享,我們也安排了“分論壇技術話題及技術演示”的交流環節,讓來自行業的技術伙伴們能與 NVIDIA 專家面對面探討 LLM 的最新趨勢及應用挑戰。專家親自剖析構建及訓練 LLM 的實例,分享相關實戰經驗及 LLM 對行業未來發展。包括大模型訓練集群監控實踐及演示、常見集群穩定性問題詳解及解決方案、NeMo Framework RLHF 設計解讀及實踐、NVIDIA 多模態訓練方案解讀、如何評估大模型訓練計算熱點、低精度推理管線詳解及演示、如何在 NVIDIA 大模型推理產品中新增模型、基于 NeMo LLM Service 定制化開發企業級 AI 應用,以及如何通過 NeMo-Guardrails 讓大語言模型的使用合法合規等豐富內容。

左右滑動查看分論壇活動照片

AI 之路,NVIDIA 從未止步

從首屆舉辦到現在,我們定制了不同主題的專場,無論線下或線上,NVIDIA 中國團隊通過“專家面對面技術沙龍”已累計與千余名各界的技術專家交流互動。未來,我們將持續舉辦技術沙龍,引導更多的行業人才在科技創新之路,精準實踐專業技能,一同聚焦 AI 發展,通過近距離交流及答疑,加速解決跨行業痛點。

再次感謝所有與會者的熱情支持,

讓本次活動圓滿成功。

NVIDIA 期待與您下一次相見!

點擊“閱讀原文”,或掃描下方海報二維碼,在 8 月 8日聆聽NVIDIA 創始人兼 CEO 黃仁勛在 SIGGRAPH 現場發表的 NVIDIA 主題演講,了解 NVIDIA 的新技術,包括屢獲殊榮的研究,OpenUSD 開發,以及最新的 AI 內容創作解決方案。

原文標題:闊別兩年,重返線下!上百位與會者齊聚“NVIDIA 專家面對面技術沙龍”,暢談大模型最佳實踐!

文章出處:【微信公眾號:NVIDIA英偉達】歡迎添加關注!文章轉載請注明出處。

-

英偉達

+關注

關注

22文章

3796瀏覽量

91320

原文標題:闊別兩年,重返線下!上百位與會者齊聚“NVIDIA 專家面對面技術沙龍”,暢談大模型最佳實踐!

文章出處:【微信號:NVIDIA_China,微信公眾號:NVIDIA英偉達】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

相關推薦

央國企數字化轉型新趨勢:凡泰極客的創新理念與實踐

名單公布!【書籍評測活動NO.49】大模型啟示錄:一本AI應用百科全書

先楫HPM6E00技術日 | 百人研討共話工業應用創新及發展趨勢

飛凌嵌入式技術創新日(深圳站)精彩回顧

拓維信息旗下開鴻智谷精彩亮相OpenHarmony開發者大會2024

CS1237模數轉換值百位跳動

【大語言模型:原理與工程實踐】探索《大語言模型原理與工程實踐》2.0

廣東移動攜手華為斬獲“2023年度SDN、NFV、網絡AI最佳實踐案例”

數勢科技副總裁宋麗出席百度智能云GENERATE全球生態大會,共商大模型生態

闊別兩年,重返線下!上百位與會者齊聚“NVIDIA 專家面對面技術沙龍”,暢談大模型最佳實踐!

闊別兩年,重返線下!上百位與會者齊聚“NVIDIA 專家面對面技術沙龍”,暢談大模型最佳實踐!

評論