北京2023年8月8日/美通社/ -- 冬瓜哥上次學習AI和ML,還是在2019年初。當時其實是卷積神經(jīng)網(wǎng)絡和深度神經(jīng)網(wǎng)絡蓬勃發(fā)展期,其主要目的是分類識別。當時冬瓜哥還做了一個4小時的視頻,那真是我見過的最小白的白也能輕松入門,理清楚最基本的名詞概念關(guān)系的視頻了,沒有之一。那時候利用AI生成一些藝術(shù)作品已經(jīng)初見雛形,但是非常不成熟,基本上都是僅供娛樂。我記得曾經(jīng)至少有兩部科幻電影描述過(比如《機械公敵》,《Finch》),也許做夢對于一個機器人來講,是一種超級進化的開端。

生成式AI,AI2.0

時過境遷。短短幾年內(nèi),新的不同于傳統(tǒng)分類器的模型Transformer,讓AI再一次革新。以往的RNN在自然語言處理訓練方面的并行度不是很好,需要太多通信,處理長句子時效率比較低。而Transformer模型從新的維度上解決了這個問題,高并行度讓GPU訓練效率大幅提升。這個過程,感覺像極了當年分布式系統(tǒng)興起的時候,大家也是拿著幾篇經(jīng)典論文翻來覆去的研讀,然后開始用開源軟件,最后逐漸發(fā)展出自己的技術(shù)。

當AI突破了人類語言這道關(guān)卡,后續(xù)就有點一馬平川的感覺了。因為人類知識目前主要儲存在各種語言文本當中。再結(jié)合對圖片、聲音等各種信息的數(shù)字化映射和分析,讓AI能夠運行于多模態(tài)模式下,能夠更好的理解字里行間的信息,更精細化的生成對應的內(nèi)容,走進了現(xiàn)實。

多模態(tài)生成式AI(AI Generated Content,AIGC)是指通過生成和分析多種模態(tài)的數(shù)據(jù),如文本、圖像、音頻、視頻等,以實現(xiàn)更加豐富和精準的智能應用。與傳統(tǒng)機器學習方法相比,多模態(tài)生成式AI能夠充分利用多種數(shù)據(jù)之間的關(guān)聯(lián)性,提高模型的泛化能力和魯棒性。生產(chǎn)式AI是人工智能從1.0時代進入2.0時代的重要標志,其具備強大的認知智能,在搜索引擎、藝術(shù)創(chuàng)作、影音游戲、文本生成、語音生成、圖片生成、視頻生成、代碼生成、虛擬人生成以及金融、教育、醫(yī)療、工業(yè)等領(lǐng)域有著廣闊的應用前景。

Gartner預測,到2023年將有20%的內(nèi)容被AIGC所創(chuàng)建;到2025 年人工智能生成數(shù)據(jù)占比將達到10%。據(jù)分析師預測,到2032年,生成式人工智能市場規(guī)模將達到2,000億美元,占據(jù)人工智能支出總額的約20%,顯著高出當前的5%。換言之,未來十年市場規(guī)模可能每兩年就會翻一番。

生成式AI的背后是基于行業(yè)上下游對數(shù)據(jù)進行采集、標注、訓練、推理、歸檔,其特征是數(shù)據(jù)量大、多元數(shù)據(jù)類型復雜、服務協(xié)議多樣、性能要求苛刻、要求服務持續(xù)在線。由于多模態(tài)數(shù)據(jù)具有復雜性和多樣性,因此多模態(tài)生成式AI需要具備以下特點:

跨模態(tài)數(shù)據(jù)融合:能夠?qū)⒉煌B(tài)的數(shù)據(jù)進行有效的融合,以提取更豐富的信息。

跨語言理解:能夠理解不同語言之間的語義差異,提高跨語言應用的準確性。

上下文感知:能夠根據(jù)上下文信息進行智能推斷和預測,提高應用的場景適應能力。

知識表示:能夠?qū)⒅R和信息進行有效的表示,以支持更高級別的認知和決策。

革新帶來的新挑戰(zhàn),現(xiàn)有存儲系統(tǒng)還能不能打?

多模態(tài)生成式AI系統(tǒng)本身是一個大規(guī)模集群,無論是集中式存儲還是本地直連存儲,都早已無法滿足該系統(tǒng)對存儲性能和容量的基本需求。另外,以機械硬盤構(gòu)建的任何存儲系統(tǒng),也根本無法承擔生成式AI對存儲系統(tǒng)帶寬和時延的要求。總的來講,生成式AI在存儲方面所面臨的挑戰(zhàn)如下:

大型數(shù)據(jù)集:隨著數(shù)據(jù)和模型規(guī)模的增長,獨立存儲無法滿足應用需求。因此,解決這些問題的分布式存儲解決方案勢在必行。

歷史數(shù)據(jù)的完整歸檔:在某些場景下,AI集群每天都會產(chǎn)生大量新的數(shù)據(jù)集,必須將其歸檔為歷史數(shù)據(jù)。這在自動駕駛領(lǐng)域尤為重要,道路測試車輛收集的數(shù)據(jù)(例如雷達和攝像頭數(shù)據(jù))對于公司來說是非常有價值的資產(chǎn)。在這些情況下,獨立存儲被證明是不夠的,因此分布式存儲成為必要的考慮因素。

小文件和非結(jié)構(gòu)化數(shù)據(jù)過多:傳統(tǒng)分布式文件系統(tǒng)難以管理大量小文件,導致元數(shù)據(jù)存儲負擔過重。這對于視覺模型來說尤其成問題。為了解決這個問題,需要一個針對小文件存儲進行優(yōu)化的分布式存儲系統(tǒng)。這樣既保證了上層訓練任務的高效進行,又保證了海量小文件的輕松管理。

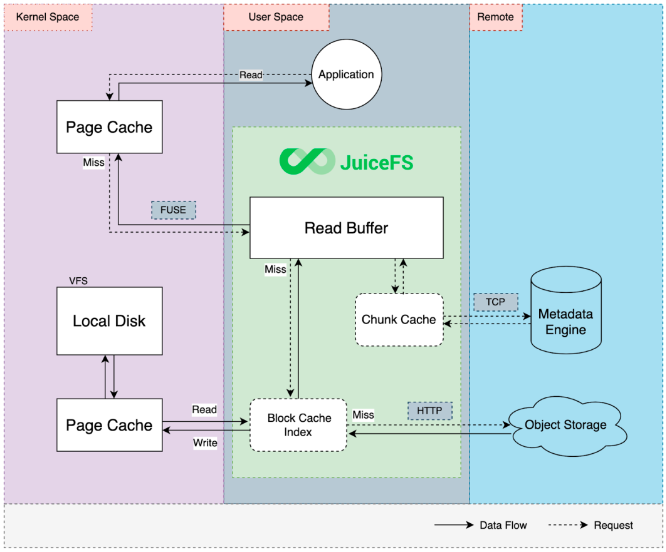

云訓練數(shù)據(jù)I/O效率低:云模型訓練往往采用對象存儲作為存儲計算分離架構(gòu)的底層存儲。然而,對象存儲較差的讀寫性能可能會導致訓練過程中出現(xiàn)嚴重的瓶頸。

異構(gòu)數(shù)據(jù)的融合:生成式AI訓練模型的數(shù)據(jù)呈現(xiàn)來源多、格式多的多源異構(gòu)現(xiàn)狀,傳統(tǒng)存儲面向單一數(shù)據(jù)類型設(shè)計,需要以搬移數(shù)據(jù)的方式實現(xiàn)多協(xié)議訪問,存儲成為應用平臺的關(guān)鍵瓶頸。

持續(xù)的低延遲與高帶寬:模型訓練過程中,頻繁的從數(shù)據(jù)集取Token,每個Token一般4字節(jié),實時高并發(fā)小IO性能需要極低的延遲;存儲模型Checkpoint時,為Checkpoint數(shù)據(jù)可快速寫入,需要高帶寬。

EB級大容量存儲需求:越多的數(shù)據(jù)投喂結(jié)果越精準的工作原理,決定了大模型訓練存在深度學習網(wǎng)絡層數(shù)多、連接多、參數(shù)和數(shù)據(jù)集種類復雜、數(shù)據(jù)量大的特征,隨著模型參數(shù)和數(shù)據(jù)量的快速增長,對于存儲的大容量和擴展需求也迫在眉睫。

數(shù)據(jù)存儲產(chǎn)業(yè)需要進行全方位的技術(shù)升級,通過在多源異構(gòu)融合、數(shù)據(jù)高速傳輸、海量數(shù)據(jù)管理等方面持續(xù)創(chuàng)新,打造專業(yè)的生成式AI存儲產(chǎn)品與解決方案。

塊,文件,對象,哪種存儲方式最好?

塊存儲

傳統(tǒng)觀點認為,低延遲高帶寬場景,使用塊存儲是最佳方案。然而,塊存儲在可擴展性方面卻不能令人滿意。AI集群必須在數(shù)據(jù)量、數(shù)據(jù)類型、決策速度,當然還有預算方面進行平衡。AI訓練環(huán)境對實時運行的基于網(wǎng)絡的推薦引擎提出了不同的要求。塊存儲傳統(tǒng)上非常適合高吞吐量和高I/O工作負載,其中低延遲非常重要,然而,隨著現(xiàn)代數(shù)據(jù)分析工作負載(包括人工智能、機器學習甚至數(shù)據(jù)湖)的出現(xiàn),人們發(fā)現(xiàn)傳統(tǒng)的基于塊的平臺缺乏滿足這些平臺計算方面所產(chǎn)生的橫向擴展需求的能力。因此,必須采用基于文件和對象的方法來支持這些現(xiàn)代工作負載。

文件和對象

因此,系統(tǒng)架構(gòu)師更傾向于基于文件或?qū)ο蟮腁I 和 ML 存儲。對象存儲在構(gòu)建時考慮到了 PB 級大容量,并且是按規(guī)模構(gòu)建的,還支持物聯(lián)網(wǎng) (IoT) 等應用。對象存儲在性能方面落后于塊存儲系統(tǒng),盡管隨著更新的高性能對象技術(shù)的出現(xiàn),差距正在縮小。另外一個需要考慮的因素是,AI應用程序支持的存儲訪問接口各不相同,并非所有人工智能、機器學習或分析工具都支持 AWS 的 S3 接口(對象的事實標準)。

云儲存

云存儲主要是基于對象的,但為人工智能和機器學習項目提供了其他優(yōu)勢。其中最主要的是靈活性和較低的前期成本。云存儲的主要缺點是延遲和潛在的數(shù)據(jù)傳輸成本。云存儲對于基于云的人工智能和機器學習系統(tǒng)來說是一個不錯的選擇,對于長期數(shù)據(jù)歸檔來說還是劃算的。

綜上,傳統(tǒng)觀點認為,沒有單一選項可以滿足人工智能、機器學習和分析的所有存儲需求。然而這個觀點在浪潮信息AS13000這個老牌分布式存儲系統(tǒng)面前就顯得有點過于武斷了。

浪潮信息生成式AI存儲解決方案

浪潮信息生成式AI存儲解決方案用一套AS13000融合存儲支撐生成式AI的全階段應用,提供全閃、混閃、帶庫、光盤四種介質(zhì),支持文件、對象、大數(shù)據(jù)、視頻、塊協(xié)議,可滿足大容量、多協(xié)議共享,百萬以上IOPS,100GB以上帶寬,冷數(shù)據(jù)的長期保存和歸檔。結(jié)合AIGC數(shù)據(jù)處理的五個階段:數(shù)據(jù)采集、數(shù)據(jù)準備、數(shù)據(jù)訓練、數(shù)據(jù)推理和數(shù)據(jù)歸檔,由同一套存儲提供端到端的數(shù)據(jù)流支持流程,滿足面向文本、音頻、圖像、視頻、代碼以及多模態(tài)和全模態(tài)的模型需求。

浪潮信息生成式AI存儲解決方案擁有極致融合、極致性能、極致節(jié)能,和熱溫冷冰四級全生命周期存儲管理四大特點,助力AIGC突破海量數(shù)據(jù)存力瓶頸,加速釋放數(shù)據(jù)的AI價值:

極致融合。為了應對不同模態(tài)的多樣性需求,浪潮信息提出協(xié)議融合設(shè)計理念,一個集群內(nèi)支持多個存儲池,一個存儲池內(nèi)支持文本、圖片、音頻、視頻等多種類型數(shù)據(jù)存儲,一份數(shù)據(jù)又可以被前端不同業(yè)務場景以文件、對象、大數(shù)據(jù)以及視頻的存儲方式進行并行訪問。用一套存儲實現(xiàn)多模態(tài)場景應用,應用間數(shù)據(jù)實現(xiàn)實時共享,同時節(jié)省了大量的存儲空間。

極致性能。AIGC場景數(shù)據(jù)類型多樣化,文件大小不一數(shù)量多,且讀寫頻繁,對存儲系統(tǒng)的100GB級帶寬、100萬級IOPS需求成了常態(tài)。浪潮信息在軟件方面,通過數(shù)控分離架構(gòu)減少東西向數(shù)據(jù)量的轉(zhuǎn)發(fā),通過GDS、RMDA技術(shù)縮短I/O路徑,通過SPDK、緩存零拷貝技術(shù)減少I/O路徑上的數(shù)據(jù)拷貝,以及基于自研NVMe SSD開發(fā)的盤控協(xié)同技術(shù),減少I/O訪問SSD盤的次數(shù),使存儲性能得到進一步釋放。在硬件方面,優(yōu)化IO路徑通道,均衡IO路徑,最大化發(fā)揮硬件性能,全閃單節(jié)點帶寬超過50GB/s,IOPS超過50萬;創(chuàng)新性的引入雙控全閃節(jié)點,帶寬超過100GB/s,IOPS超過100萬,真正使系統(tǒng)達到了TB級帶寬、千萬級IOPS、EB級帶寬。

極致節(jié)能。浪潮信息最新發(fā)布的G7硬件平臺,存儲專用的液冷服務器涵蓋性能型和容量型,且均采用模塊化冷板組件設(shè)計模式。在系統(tǒng)方案層面,浪潮信息具有風液式,液液式等完善的端到端解決方案,能夠為用戶全方位打造液冷數(shù)據(jù)中心交鑰匙工程,并且完成了業(yè)界首次液冷整機柜批量交付,實現(xiàn)PUE<1.1。

端到端的全生命周期管理。浪潮生成式AI存儲方案采用閃存、磁盤、磁帶、光盤四種介質(zhì)提供熱溫冷冰四種存儲資源,且實現(xiàn)了資源的互通和數(shù)據(jù)全生命周期的管理。基于數(shù)據(jù)的熱度識別,自動釋放在線存儲空間,可以將海量數(shù)據(jù)自動歸檔到光盤庫,降低長期存儲成本;實現(xiàn)冷數(shù)據(jù)的分鐘級快速回調(diào),滿足0~4級應用的存儲需求。四種介質(zhì)、四類存儲節(jié)點,提供熱溫冷冰自動流轉(zhuǎn),滿足各類應用的靈活配置需求,通過性能型、均衡型、容量型、高密容量型四種機型的按需靈活配置,進一步降低整體投入。

浪潮信息自研的源大模型

目前,浪潮信息生成式AI存儲解決方案已經(jīng)在全球領(lǐng)先的中文語言大模型"源1.0"中成功落地。"源"中文語言大模型有近2500億個模型參數(shù),算力消耗達4000+PetaFlop/s-day,底層采用AS13000并行存儲支撐,原始數(shù)據(jù)、經(jīng)過粗篩和精篩的處理后得到高質(zhì)量中文數(shù)據(jù)都集中在AS13000上。

模型訓練過程中對存儲的挑戰(zhàn)主要有對小文件并發(fā)的性能,和訓練過程中要求快速保存Checkpoint存檔文件的高速寬寫入要求。AS13000采用最新硬件平臺,搭載全閃SSD和高速IB網(wǎng)絡,支撐源的訓練過程高效完成。

據(jù)測算,GPT-3使用10000塊GPU、花了30天訓練完成1750億參數(shù),"源1.0"在2128個GPU集群上跑了16天完成了訓練,源1.0的算力效率達到44.8%,遠超MT-NLG與GPT-3等國際知名模型,其中存儲的極致性能功不可沒。

某AI獨角獸公司

該公司計劃發(fā)布5000億參數(shù)量的NLP語言類大模型,為了極致的提升計算效率,采用了計算網(wǎng)絡和存儲網(wǎng)絡分離的設(shè)計,計算網(wǎng)絡采用高速IB、存儲網(wǎng)絡選擇了RoCE,并對于存儲提出了明確要求:不小于3.5PB的高速存儲,性能要求帶寬300GB,IOPS 350萬以上。客戶從專業(yè)性、開發(fā)成本、周期及運維等方面進行全面評估后,選擇浪潮信息AS13000分布式全閃存儲集群,支持高性能RocE組網(wǎng)和GPU直通存儲功能,為算力集群提供高性能低延時的數(shù)據(jù)讀取保障。同時隨著業(yè)務的上線,進行了兩次在線存儲擴容,具有非常好的靈活性和容量性能線性擴展能力。

隨著AIGC時代的到來,浪潮信息作為最早布局AIGC大模型的企業(yè)之一,持續(xù)圍繞"新存儲之道"的理念,持續(xù)打造平臺型存儲產(chǎn)品,應對智能時代、AIGC時代的存儲挑戰(zhàn)。

本文作者 | 大話存儲 冬瓜哥

審核編輯 黃宇

-

AI

+關(guān)注

關(guān)注

87文章

31133瀏覽量

269470 -

存儲系統(tǒng)

+關(guān)注

關(guān)注

2文章

413瀏覽量

40880 -

人工智能

+關(guān)注

關(guān)注

1792文章

47425瀏覽量

238966 -

AIGC

+關(guān)注

關(guān)注

1文章

363瀏覽量

1561 -

大模型

+關(guān)注

關(guān)注

2文章

2489瀏覽量

2862 -

生成式AI

+關(guān)注

關(guān)注

0文章

509瀏覽量

502

發(fā)布評論請先 登錄

相關(guān)推薦

網(wǎng)絡存儲系統(tǒng)可生存性量化評估

一種針對存儲系統(tǒng)設(shè)計的應用級緩存回收策略

存儲系統(tǒng)的層次結(jié)構(gòu)

基于虛擬存儲的嵌入式存儲系統(tǒng)的設(shè)計方法

淺析嵌入式存儲系統(tǒng)設(shè)計方法

探討AI在存儲中的應用和對存儲系統(tǒng)的改進

關(guān)于騰訊的開源分布式存儲系統(tǒng)DCache

盤點分布式存儲系統(tǒng)的主流框架

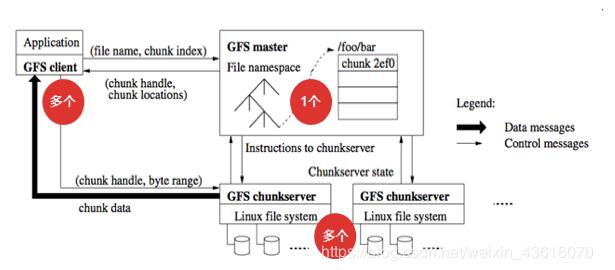

分布式文件存儲系統(tǒng)GFS的基礎(chǔ)知識

一文詳解LeoStor并行存儲系統(tǒng)

如何使用分布式存儲系統(tǒng)促進AI模型訓練

智慧有數(shù) 浪潮信息發(fā)布生成式AI存儲解決方案

存儲系統(tǒng)如何支持大模型生成式AI

生成式 AI 進入模型驅(qū)動時代

存儲系統(tǒng)如何支持大模型生成式AI

存儲系統(tǒng)如何支持大模型生成式AI

評論