電子發(fā)燒友網(wǎng)報(bào)道(文/周凱揚(yáng))在諸多云服務(wù)廠商或互聯(lián)網(wǎng)廠商一頭扎進(jìn)GPU的瘋搶潮后,不少公司也發(fā)現(xiàn)了限制AI大模型性能或是成本消耗的除了GPU以外,還有內(nèi)存。內(nèi)存墻作為橫亙?cè)贏I計(jì)算和HPC更進(jìn)一步的阻礙之一,在計(jì)算量井噴的今天,已經(jīng)變得愈發(fā)難以忽視。所以,在今年的HotChips大會(huì)上,內(nèi)存廠商們也競(jìng)相展示自己的內(nèi)存技術(shù)在AI計(jì)算上的優(yōu)勢(shì)。

三星

三星作為最早一批開(kāi)始跟進(jìn)存內(nèi)計(jì)算的公司,早在兩年前的HotChips33上,就展示了HBM2-PIM的技術(shù)Aquabolt-XL。三星在去年底展示了用PIM內(nèi)存和96個(gè)AMD Instinct MI100 GPU組建的大規(guī)模計(jì)算系統(tǒng),并宣稱這一配置將AI訓(xùn)練的速度提高了近2.5倍。

而今年的HotChips上,三星也著重點(diǎn)明了PIM和PNM技術(shù)在生成式AI這類熱門應(yīng)用上的優(yōu)勢(shì)。三星認(rèn)為在ChatGPT、GPT-3之類的應(yīng)用中,主要瓶頸出現(xiàn)在生成階段的線性層上,這是因?yàn)镚PU受到了內(nèi)存限制且整個(gè)過(guò)程是線性順序進(jìn)行的。

在三星對(duì)GPT的分析中,其主要由概括和生成兩大負(fù)載組成,其中概括考驗(yàn)的是計(jì)算單元的性能,而生成則考驗(yàn)的是內(nèi)存的性能。而生成占據(jù)了絕大多數(shù)的運(yùn)算次數(shù)和耗時(shí),其中占據(jù)了60%到80%延遲的GEMV(矩陣向量操作)也就成了三星試圖用PIM和PNM攻克的目標(biāo)。

根據(jù)三星的說(shuō)法,像GPT這類Transformer架構(gòu)的模型,都可以將多頭注意力(MHA)和前饋神經(jīng)網(wǎng)絡(luò)(FFN)完全交給PIM或PNM,完全利用他們的所有帶寬,從而減少在推理上所花費(fèi)的時(shí)間和能耗。三星也在單個(gè)AMD MI100-PIM的GPU上進(jìn)行了試驗(yàn),得出運(yùn)行GPT模型時(shí),在HBM-PIM的輔助下,能效是GPU搭配傳統(tǒng)HBM的兩倍,性能同樣提升至兩倍以上。

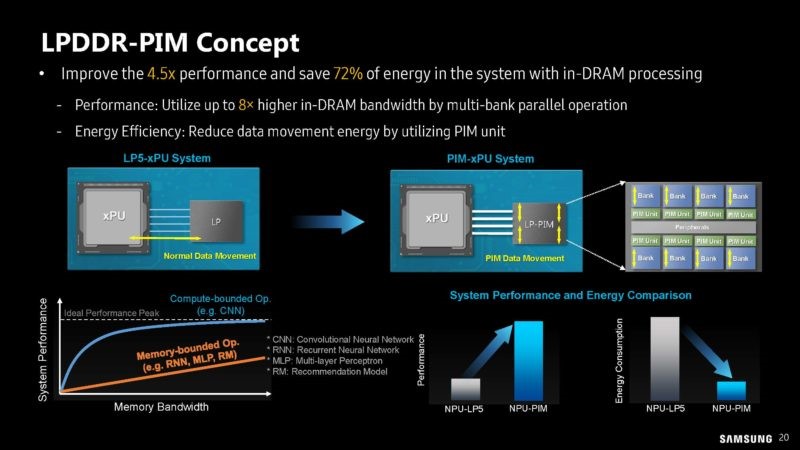

LPDDR-PIM概念 / 三星

除了HBM-PIM外,這次三星還展示了最新的LPPDR-PIM概念。除了云端生成式AI需要存內(nèi)計(jì)算的輔助外,諸如智能手機(jī)這樣的端側(cè)生成式AI概念也被炒起來(lái),所以LPPDR-PIM這樣的存內(nèi)計(jì)算技術(shù),可以進(jìn)一步保證續(xù)航的同時(shí),也不會(huì)出現(xiàn)為了帶寬內(nèi)存使用超量的情況。

SK海力士

另一大韓國(guó)內(nèi)存巨頭SK海力士也沒(méi)有閑著,在本次HotChips大會(huì)上,他們展示了自己的AiM存內(nèi)加速器方案。相較三星而言,他們?yōu)樯墒紸I的推理負(fù)載準(zhǔn)備的是基于GDDR6的存內(nèi)計(jì)算方案。

GDDR6-AiM采用了1y的制造工藝,具備512GB/s內(nèi)部帶寬的同時(shí),也具備32GB/s的外部帶寬。且GDDR6-AiM具備頻率高達(dá)1GHz的處理單元,算力可達(dá)512GFLOPS。GDDR6-AiM的出現(xiàn),為存內(nèi)進(jìn)行GEMV計(jì)算提供了端到端的加速方案,比如乘法累加和激活函數(shù)等操作都可以在內(nèi)存bank內(nèi)同時(shí)進(jìn)行,單條指令實(shí)現(xiàn)全bank操作提供更高的計(jì)算效率。

同時(shí),SK海力士也已經(jīng)考慮到了AiM的擴(kuò)展性問(wèn)題,比如單個(gè)AiM卡中集成了8個(gè)AiM封裝,也就是8GB的容量和256個(gè)處理單元。但這類擴(kuò)展方案最大的問(wèn)題還是在軟件映射、硬件架構(gòu)和接口上,這也是絕大多數(shù)集成存內(nèi)計(jì)算的新式內(nèi)存面臨的問(wèn)題。

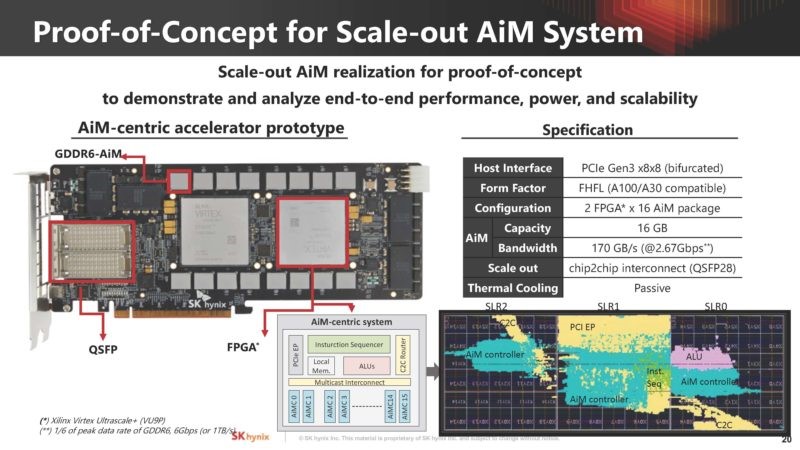

AiM系統(tǒng)擴(kuò)展性驗(yàn)證Demo / SK海力士

而SK海力士已經(jīng)給出了這方面的解決方案,比如專門針對(duì)AiM的Tiling、基于AiM架構(gòu)的控制器、路由和ALU等等。他們還展示了在兩個(gè)FPGA上結(jié)合GDDR6-AiM的Demo,以及用于LLM推理的軟件棧。與此同時(shí),他們也還在探索AiM的下一代設(shè)計(jì),比如如何實(shí)現(xiàn)更高的內(nèi)存容量,用于應(yīng)對(duì)更加龐大的模型。

寫(xiě)在最后

無(wú)論是三星還是SK海力士都已經(jīng)在存內(nèi)計(jì)算領(lǐng)域耕耘多年,此次AI熱來(lái)勢(shì)洶洶,也令他們研發(fā)速度進(jìn)一步提快。畢竟如今能夠解決大模型訓(xùn)練與推理的耗時(shí)與TCO的硬件持續(xù)大賣,如果存內(nèi)計(jì)算產(chǎn)品商業(yè)化量產(chǎn)落地進(jìn)展順利,且確實(shí)能為AI計(jì)算帶來(lái)助力的話,很可能會(huì)小幅提振如今略微萎縮的內(nèi)存市場(chǎng)。

-

gpu

+關(guān)注

關(guān)注

28文章

4744瀏覽量

129018

發(fā)布評(píng)論請(qǐng)先 登錄

相關(guān)推薦

NVIDIA和GeForce RTX GPU專為AI時(shí)代打造

GPU是如何訓(xùn)練AI大模型的

PON不只是破網(wǎng)那么簡(jiǎn)單

《算力芯片 高性能 CPUGPUNPU 微架構(gòu)分析》第3篇閱讀心得:GPU革命:從圖形引擎到AI加速器的蛻變

為什么ai模型訓(xùn)練要用gpu

科技云報(bào)到:大模型時(shí)代下,向量數(shù)據(jù)庫(kù)的野望

不只是前端,后端、產(chǎn)品和測(cè)試也需要了解的瀏覽器知識(shí)(二)

為什么跑AI往往用GPU而不是CPU?

AI訓(xùn)練,為什么需要GPU?

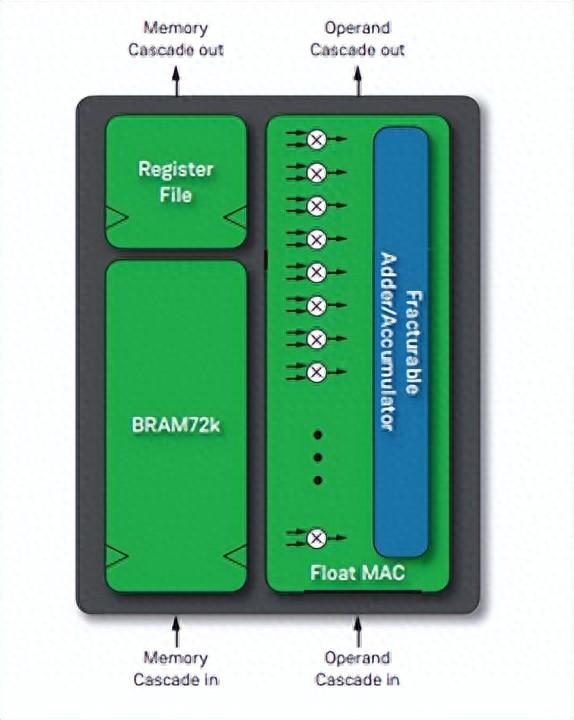

新型的FPGA器件將支持多樣化AI/ML創(chuàng)新進(jìn)程

國(guó)產(chǎn)GPU在AI大模型領(lǐng)域的應(yīng)用案例一覽

Achronix新推出一款用于AI/ML計(jì)算或者大模型的B200芯片

FPGA在深度學(xué)習(xí)應(yīng)用中或?qū)⑷〈?b class='flag-5'>GPU

GPU交期緩解,AI服務(wù)器廠商營(yíng)收暴漲

不只是GPU,內(nèi)存廠商們的AI野望

不只是GPU,內(nèi)存廠商們的AI野望

評(píng)論