大模型現存的問題和挑戰這篇文章介紹了關于大型語言模型(LLMs)研究中的十個主要方向和問題:

1. 減少和度量幻覺:幻覺指的是AI模型虛構信息的情況,可能是創意應用的一個特點,但在其他應用中可能是一個問題。這個方向涉及減少幻覺和開發衡量幻覺的度量標準。

2. 優化上下文長度和構造:針對大多數問題,上下文信息是必需的,文章介紹了在RAG(Retrieval Augmented Generation)架構中優化上下文長度和構造的重要性。

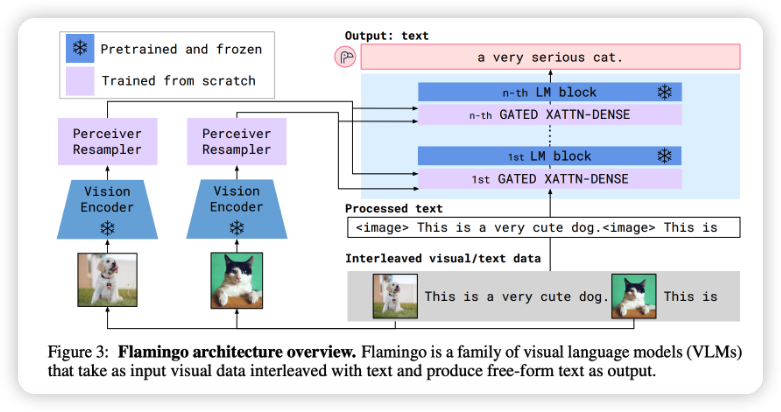

3. 整合其他數據形式:多模態是強大且被低估的領域,文章探討了多模態數據的重要性和潛在應用,如醫療預測、產品元數據分析等。

4. 使LLMs更快、更便宜:討論了如何使LLMs更高效、更節約資源,例如通過模型量化、模型壓縮等方法。

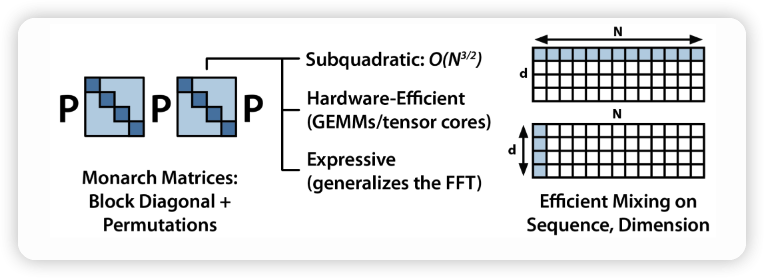

5. 設計新的模型架構:介紹了開發新的模型架構以取代Transformer的嘗試,以及挑戰和優勢。

6. 開發GPU替代方案:討論了針對深度學習的新硬件技術,如TPUs、IPUs、量子計算、光子芯片等。

7. 使代理人更易用:探討了訓練能夠執行動作的LLMs,即代理人,以及其在社會研究和其他領域的應用。

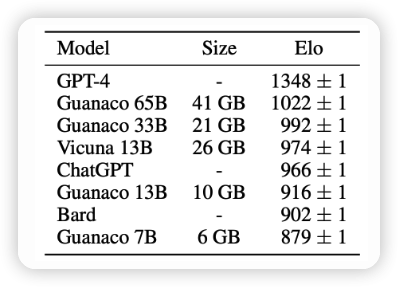

8. 提高從人類偏好中學習的效率:討論了從人類偏好中訓練LLMs的方法和挑戰。

9. 改進聊天界面的效率:討論了聊天界面在任務處理中的適用性和改進方法,包括多消息、多模態輸入、引入生成AI等。

10. 為非英語語言構建LLMs:介紹了將LLMs擴展到非英語語言的挑戰和必要性。

1. 減少和衡量幻覺

幻覺是一個廣受關注的話題,指的是當AI模型編造信息時發生的情況。在許多創造性的應用場景中,幻覺是一種特性。然而,在大多數其他用例中,幻覺是一個缺陷。一些大型企業近期在關于大型語言模型的面板上表示,影響企業采用LLMs的主要障礙是幻覺問題。

減輕幻覺問題并開發用于衡量幻覺的度量標準是一個蓬勃發展的研究課題。有許多初創公司專注于解決這個問題。還有一些降低幻覺的方法,例如在提示中添加更多的上下文、思維鏈、自我一致性,或要求模型在回答中保持簡潔。

要了解更多關于幻覺的信息,可以參考以下文獻:

- Survey of Hallucination in Natural Language Generation (Ji et al., 2022)

- How Language Model Hallucinations Can Snowball (Zhang et al., 2023)

- A Multitask, Multilingual, Multimodal Evaluation of ChatGPT on Reasoning, Hallucination, and Interactivity (Bang et al., 2023)

- Contrastive Learning Reduces Hallucination in Conversations (Sun et al., 2022)

- Self-Consistency Improves Chain of Thought Reasoning in Language Models (Wang et al., 2022)

- SelfCheckGPT: Zero-Resource Black-Box Hallucination Detection for Generative Large Language Models (Manakul et al., 2023)

- NVIDIA’s NeMo-Guardrails中關于事實核查和幻覺的簡單示例

2. 優化上下文長度限制

大部分問題需要上下文信息。例如,如果我們詢問ChatGPT:“哪家越南餐廳最好?”,所需的上下文將是“在哪里”,因為越南在越南和美國的最佳越南餐廳不同。

在這篇論文中提到,許多信息尋求性的問題都有依賴于上下文的答案,例如Natural Questions NQ-Open數據集中約占16.5%。對于企業用例,這個比例可能會更高。例如,如果一家公司為客戶支持構建了一個聊天機器人,為了回答客戶關于任何產品的問題,所需的上下文可能是該客戶的歷史或該產品的信息。由于模型“學習”來自提供給它的上下文,這個過程也被稱為上下文學習。

3. 合并其他數據模態

多模態是非常強大但常常被低估的概念。它具有許多優點:

首先,許多用例需要多模態數據,特別是在涉及多種數據模態的行業,如醫療保健、機器人、電子商務、零售、游戲、娛樂等。例如,醫學預測常常需要文本(如醫生的筆記、患者的問卷)和圖像(如CT、X射線、MRI掃描)。

其次,多模態承諾可以顯著提高模型的性能。一個能夠理解文本和圖像的模型應該比只能理解文本的模型表現更好。基于文本的模型需要大量的文本數據,因此有現實擔憂稱我們可能會很快用完訓練基于文本的模型的互聯網數據。一旦我們用完了文本數據,我們需要利用其他數據模態。

其中一個特別令人興奮的用例是,多模態可以幫助視障人士瀏覽互聯網和導航現實世界。

4. 使LLMs更快且更便宜

當GPT-3.5于2022年底首次發布時,很多人對在生產中使用它的延遲和成本表示擔憂。這是一個復雜的問題,牽涉到多個層面,例如:

訓練成本:訓練LLMs的成本隨著模型規模的增大而增加。目前,訓練一個大型的LLM可能需要數百萬美元。

推理成本:在生產中使用LLMs的推理(生成)可能會帶來相當高的成本,這主要是因為這些模型的巨大規模。

解決這個問題的一種方法是研究如何減少LLMs的大小,而不會明顯降低性能。這是一個雙重的優勢:首先,更小的模型需要更少的成本來進行推理;其次,更小的模型也需要更少的計算資源來進行訓練。這可以通過模型壓縮(例如蒸餾)或者采用更輕量級的架構來實現。

5. 設計新的模型架構

盡管Transformer架構在自然語言處理領域取得了巨大成功,但它并不是唯一的選擇。近年來,研究人員一直在探索新的模型架構,試圖超越Transformer的限制。

這包括設計更適用于特定任務或問題的模型,以及從根本上重新考慮自然語言處理的基本原理。一些方向包括使用圖神經網絡、因果推理架構、迭代計算模型等等。

新的架構可能會在性能、訓練效率、推理速度等方面帶來改進,但也需要更多的研究和實驗來驗證其實際效果。

6. 開發GPU替代方案

當前,大多數深度學習任務使用GPU來進行訓練和推理。然而,隨著模型規模的不斷增大,GPU可能會遇到性能瓶頸,也可能無法滿足能效方面的要求。

因此,研究人員正在探索各種GPU替代方案,例如:

TPUs(張量處理器):由Google開發的專用深度學習硬件,專為加速TensorFlow等深度學習框架而設計。

IPUs(智能處理器):由Graphcore開發的硬件,旨在提供高度并行的計算能力以加速深度學習模型。

量子計算:盡管仍處于實驗階段,但量子計算可能在未來成為處理復雜計算任務的一種有效方法。

光子芯片:使用光學技術進行計算,可能在某些情況下提供更高的計算速度。

這些替代方案都有其獨特的優勢和挑戰,需要進一步的研究和發展才能實現廣泛應用。

7. 使代理人更易于使用

研究人員正在努力開發能夠執行動作的LLMs,也被稱為代理人。代理人可以通過自然語言指令進行操作,這在社會研究、可交互應用等領域具有巨大潛力。

然而,使代理人更易于使用涉及到許多挑戰。這包括:

指令理解和執行:確保代理人能夠準確理解和執行用戶的指令,避免誤解和錯誤。

多模態交互:使代理人能夠在不同的輸入模態(文本、語音、圖像等)下進行交互。

個性化和用戶適應:使代理人能夠根據用戶的個性、偏好和歷史進行適應和個性化的交互。

這個方向的研究不僅涉及到自然語言處理,還涉及到機器人學、人機交互等多個領域。

8. 提高從人類偏好中學習的效率

從人類偏好中學習是一種訓練LLMs的方法,其中模型會根據人類專家或用戶提供的偏好進行學習。然而,這個過程可能會面臨一些挑戰,例如:

數據采集成本:從人類偏好中學習需要大量的人類專家或用戶提供的標注數據,這可能會非常昂貴和耗時。

標注噪聲:由于人類標注的主觀性和誤差,數據中可能存在噪聲,這可能會影響模型的性能。

領域特異性:從人類偏好中學習的模型可能會在不同領域之間表現不佳,因為偏好可能因領域而異。

研究人員正在探索如何在從人類偏好中學習時提高效率和性能,例如使用主動學習、遷移學習、半監督學習等方法。

9. 改進聊天界面的效率

聊天界面是LLMs與用戶交互的方式之一,但目前仍然存在一些效率和可用性方面的問題。例如:

多消息對話:在多輪對話中,模型可能會遺忘之前的上下文,導致交流不連貫。

多模態輸入:用戶可能會在消息中混合文本、圖像、聲音等不同模態的信息,模型需要適應處理這些多樣的輸入。

對話歷史和上下文管理:在長時間對話中,模型需要有效地管理對話歷史和上下文,以便準確回應用戶的問題和指令。

改進聊天界面的效率和用戶體驗是一個重要的研究方向,涉及到自然語言處理、人機交互和設計等多個領域的知識。

-

AI

+關注

關注

87文章

30887瀏覽量

269070 -

人工智能

+關注

關注

1791文章

47274瀏覽量

238469 -

模型

+關注

關注

1文章

3243瀏覽量

48836

發布評論請先 登錄

相關推薦

【「大模型啟示錄」閱讀體驗】對大模型更深入的認知

高效大模型的推理綜述

國產大模型發展的經驗與教訓

當前主流的大模型對于底層推理芯片提出了哪些挑戰

在PyTorch中搭建一個最簡單的模型

AI大模型的發展歷程和應用前景

助聽器降噪神經網絡模型

【大語言模型:原理與工程實踐】大語言模型的應用

【大語言模型:原理與工程實踐】大語言模型的評測

【大語言模型:原理與工程實踐】探索《大語言模型原理與工程實踐》

大模型時代,國產GPU面臨哪些挑戰

大模型現存的10個問題和挑戰

大模型現存的10個問題和挑戰

評論