前言:

3D場景理解是自動駕駛、機器人導航等領域的基礎。當前基于深度學習的方法在3D點云數據上表現出了十分出色的性能。然而,一些缺點阻礙了它們在現實世界中的應用。第一個原因是他們嚴重依賴大量的帶注釋點云,尤其是當高質量的3D注釋獲取成本高昂時。此外,他們通常不能識別訓練數據中從未見過的新物體。因此,可能需要額外的注釋工作來訓練模型識別這些新的對象,這既繁瑣又費時。

OpenAI的CLIP為緩解2D視覺中的上述問題提供了一個新的視角。該方法利用網站上大規模免費提供的圖文對進行訓練,建立視覺語言關聯,以實現有前景的開放詞匯識別。基于此,MaskCLIP做了基于CLIP的2D圖像語義分割的擴展工作。在對CLIP預訓練網絡進行最小修改的情況下,MaskCLIP可以直接用于新對象的語義分割,而無需額外的訓練工作。PointCLIP將CLIP的樣本分類問題從2D圖像推廣到3D點云。它將點云框架透視投影到2D深度圖的不同視圖中,以彌合圖像和點云之間的模態間隙。上述研究表明了CLIP在2D分割和3D分類性能方面的潛力。然而,CLIP是否可以及如何有利于3D場景理解仍有待探索。

本文探討了如何利用 CLIP 的2D 圖像-文本預習知識進行3D 場景理解。作者提出了一個新的語義驅動的跨模態對比學習框架,它充分利用 CLIP 的語義和視覺信息來規范3D 網絡。

作者主要的貢獻如下:

1、作者是第一個將CLIP知識提煉到3D網絡中用于3D場景理解的。

2、作者提出了一種新的語義驅動的跨模態對比學習框架,該框架通過時空和語義一致性正則化來預訓練3D網絡。

3、作者提出了提出了一種新的語義引導的時空一致性正則化,該正則化強制時間相干點云特征與其對應的圖像特征之間的一致性。

4、該方法首次在無注釋的三維場景分割中取得了良好的效果。當使用標記數據進行微調時,本文的方法顯著優于最先進的自監督方法。這里也推薦「3D視覺工坊」新課程《徹底搞懂視覺-慣性SLAM:VINS-Fusion原理精講與源碼剖析》

相關工作:

三維零樣本學習:

零樣本學習(ZSL)的目標是識別訓練集中看不見的對象。但是目前的方法主要都是基于2D識別的任務,對三維領域執行ZSL的研究特別有限。本文進一步研究了 CLIP 中豐富的語義和視覺知識對三維語義分割任務的影響。

自監督表征學習:

自我監督學習的目的是獲得有利于下游任務的良好表現。主流的方法是使用對比學習來與訓練網絡。受CLIP成功的啟發,利用CLIP的預訓練模型來完成下游任務引起了廣泛的關注。本文利用圖像文本預先訓練的CLIP知識來幫助理解3D場景。

跨模式知識蒸餾:

近年來,越來越多的研究集中于將二維圖像中的知識轉化為三維點云進行自監督表示學習。本文首先嘗試利用 CLIP 的知識對一個三維網絡進行預訓練。

具體方法:

本文研究了用于3D場景理解的CLIP的跨模態知識轉移,稱為CLIP2Scene。本文的工作是利用CLIP知識進行3D場景理解的先驅。本文的方法由三個主要組成部分組成:語義一致性正則化、語義引導的時空一致性規則化和可切換的自我訓練策略。

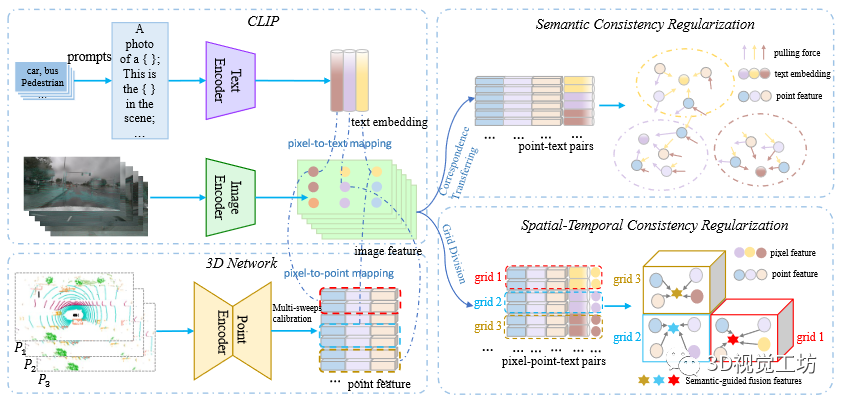

圖1 語義驅動的跨模態對比學習圖解。首先,本文分別通過文本編碼器、圖像編碼器和點編碼器獲得文本嵌入、圖像像素特征和點特征。本文利用CLIP知識來構建用于對比學習的正樣本和負樣本。這樣就得到了點-文本對和短時間內的所有像素點文本對。因此,和分別用于語義一致性正則化和時空一致性規則化。最后,通過將點特征拉到其相應的文本嵌入來執行語義一致性正則化,并通過將時間上相干的點特征模仿到其對應的像素特征來執行時空一致性正則化。

CLIP2Scene

語義一致性正則化

由于CLIP是在2D圖像和文本上預先訓練的,作者首先關注的是2D圖像和3D點云之間的對應關系。具體的,使用既可以獲得圖像和點云的因此,可以相應地獲得密集的像素-點對應,其中和表示第i個成對的圖像特征和點特征,它們分別由CLIP的圖像編碼器和3D網絡提取。M是對數。

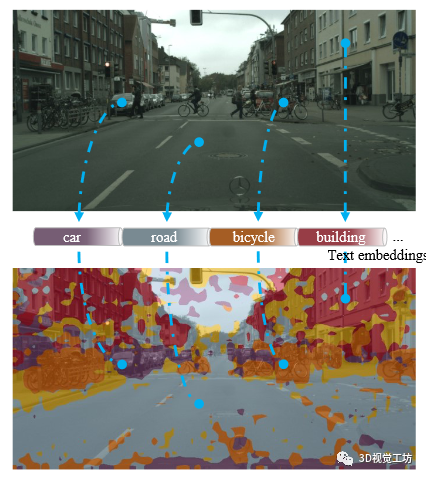

圖2 圖像像素到文本映射的圖示。密集像素-文本對應關系是通過MaskCLIP的方法提出的。

本文提出了一種利用CLIP的語義信息的語義一致性正則化。具體而言,本文通過遵循off-the-shelf方法MaskCLIP(圖2)生成密集像素文本對,其中是從CLIP的文本編碼器生成的文本嵌入。請注意,像素文本映射可從CLIP免費獲得,無需任何額外的訓練。然后,我們將像素文本對轉換為點文本對,并利用文本語義來選擇正點樣本和負點樣本進行對比學習。目標函數如下:其中,代表由第個類名生成,并且是類別的數量。表示標量積運算,是溫度項()。由于文本是由放置在預定義的模板中的類名組成,因此文本嵌入表示相應的類的語義信息。因此那些具有相同語義的點將被限制在相同的文本嵌入附近,而那些具有不同語義的點將被推開。為此,語義一致性正則化會減少對比學習中的沖突。

語義引導的時空一致性正則化

除了語義一致性正則化之外,本文還考慮圖像像素特征如何幫助正則化3D網絡。自然替代直接引入點特征及其在嵌入空間中的對應像素。然而,圖像像素的噪聲語義和不完美的像素點映射阻礙了下游任務的性能。為此,提出了一種新的語義引導的時空一致性正則化方法,通過對局部空間和時間內的點施加軟約束來緩解這一問題。

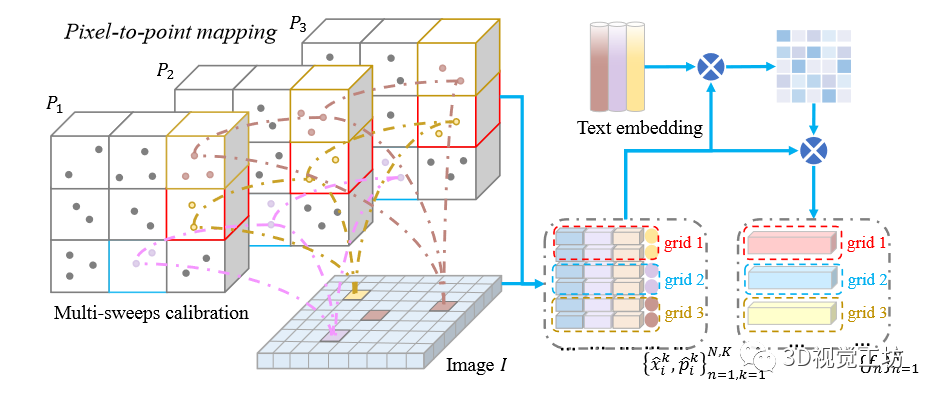

具體地,給定圖像和時間相干LiDAR點云,其中,是秒內掃描的次數。值得注意的是圖像與像素點對的點云第一幀進行匹配。本文通過校準矩陣將點云的其余部分配準到第一幀,并將它們映射到圖像上(圖3)。

圖3 圖像像素到點映射(左)和語義引導的融合特征生成(右)示意圖。本文建立了在秒內圖像和時間相干激光雷達點云之間的網格對應關系,并且生成語義引到的融合特征。和用于執行時空一致性正則化。

因此,我們在短時間內獲得所有像素點文本對。接下來,作者將整個縫合的點云劃分為規則網格,其中時間相干點位于同一網格中。本文通過以下目標函數在各個網格內施加時空一致性約束:

其中,代表像素-點對位于第個網格。是一種語義引導的跨模態融合特征,由以下公式表示:

其中和是注意力權重是由以下來計算的:

其中代表溫度項。實際上,局部網格內的那些像素和點特征被限制在動態中心附近。因此,這種軟約束減輕了噪聲預測和校準誤差問題。同時,它對時間相干點特征進行了時空正則化處理。

實驗

數據集的選擇:兩個室外數據集 SemanticKITTI 和 nuScenes一個室內數據集 ScanNet

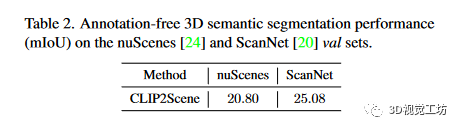

無注釋語義分割

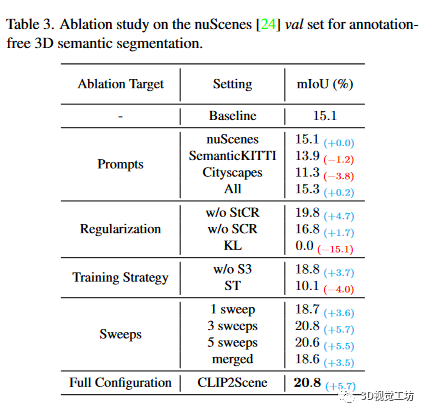

表2 是針對不同數據集的無注釋的3D語義分割的性能表3 是無注釋三維語義分割的nuScenes數據集消融研究。這里也推薦「3D視覺工坊」新課程《徹底搞懂視覺-慣性SLAM:VINS-Fusion原理精講與源碼剖析》

高效注釋的語義分割

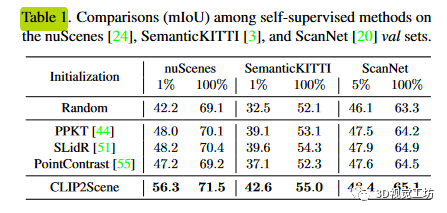

如表1所示,當對1%和100%nuScenes數據集進行微調時,該方法顯著優于最先進的方法,分別提高了8.1%和1.1%。與隨機初始化相比,改進幅度分別為14.1%和2.4%,表明了本文的語義驅動跨模態對比學習框架的有效性。定性結果如圖4所示。此外,本文還驗證了該方法的跨域泛化能力。

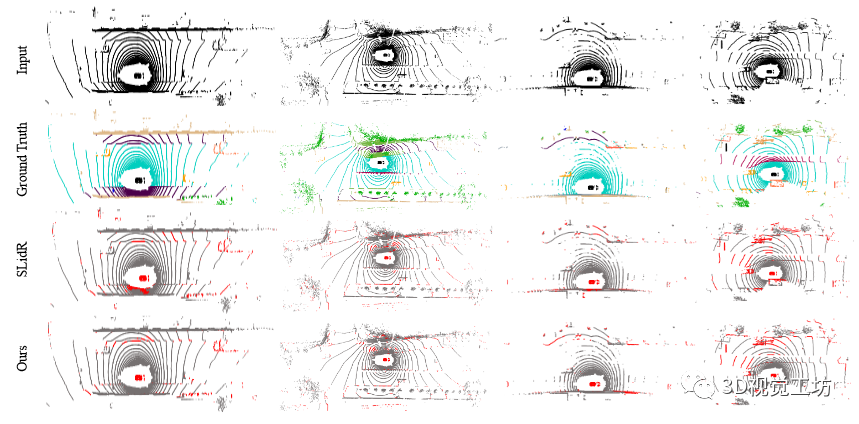

圖4 對1%nuScenes數據集進行微調的定性結果。從第一行到最后一行分別是輸入激光雷達掃描、真值、SLidR預測和我們的預測。請注意,我們通過誤差圖顯示結果,其中紅點表示錯誤的預測。顯然,本文的方法取得了不錯的性能。

結論

在這項名為CLIP2Scene的工作中,作者探討了CLIP知識如何有助于3D場景理解。為了有效地將CLIP的圖像和文本特征轉移到3D網絡中,作者提出了一種新的語義驅動的跨模態對比學習框架,包括語義正則化和時空正則化。作者的預訓練3D網絡首次以良好的性能實現了無注釋的3D語義分割。此外,當使用標記數據進行微調時,我們的方法顯著優于最先進的自監督方法。

-

3D

+關注

關注

9文章

2894瀏覽量

107658 -

模型

+關注

關注

1文章

3268瀏覽量

48926 -

Clip

+關注

關注

0文章

31瀏覽量

6673 -

深度學習

+關注

關注

73文章

5507瀏覽量

121298

原文標題:結論

文章出處:【微信號:3D視覺工坊,微信公眾號:3D視覺工坊】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

相關推薦

AN-1249:使用ADV8003評估板將3D圖像轉換成2D圖像

TechWiz LCD 3D應用:局部液晶配向

3D封裝熱設計:挑戰與機遇并存

蘇州吳中區多色PCB板元器件3D視覺檢測技術

英倫科技的15.6寸2D-3D可切換光場裸眼3D顯示屏有哪些特點?

銀牛微電子引領3D空間計算芯片前沿技術

NVIDIA Instant NeRF將多組靜態圖像變為3D數字場景

通過2D/3D異質結構精確控制鐵電材料弛豫時間

Adobe Substance 3D整合AI功能:基于文本生成紋理、背景

Nullmax提出多相機3D目標檢測新方法QAF2D

Adobe提出DMV3D:3D生成只需30秒!讓文本、圖像都動起來的新方法!

高分工作!Uni3D:3D基礎大模型,刷新多個SOTA!

如何利用CLIP 的2D 圖像-文本預習知識進行3D場景理解

如何利用CLIP 的2D 圖像-文本預習知識進行3D場景理解

評論