摘要

人工智能和機器學習的最新研究在很大程度上強調了通用學習和越來越大的訓練集以及越來越多的計算。

相反,我提出了一種以認知模型為中心的混合,知識驅動,基于推理的方法,該方法可以為比當前可能的更豐富,更健壯的AI提供基礎。

1.邁向強大的人工智能

盡管沒有人完全知道深度學習或人工智能將在未來幾十年發展,但是如果我們要達到一個新的水平,那么既要考慮過去十年所學到的知識,又要研究下一步應該研究的東西。

讓我們將其稱為健壯的人工智能新水平:雖然不一定是超人或自我完善的智能,但可以依靠它以系統和可靠的方式將其所學知識應用到廣泛的問題中,從各種知識中綜合知識來源,這樣它就可以靈活,動態地對世界進行推理,以一種我們對普通成年人所期望的方式,將它在一個環境中學到的東西轉移到另一環境中。

從某種意義上說,這是一個微不足道的目標,既不像“超人”或“人工智能”那樣雄心勃勃,也沒有像它那樣無邊無際,但也許是邁出重要的一步,并且是可以實現的,如果我們要實現這一目標,那是至關重要的一步。創建我們可以信賴的人工智能,無論是在我們的家中,在道路上,在醫生的辦公室和醫院,在企業中還是在社區中,我們都可以信賴。

簡而言之,如果我們不能指望人工智能能夠可靠地表現,那么我們就不應該信任它。(當然,事實并非如此:可靠性不能保證可信度;相反,可靠性不能保證可信度。這只是許多前提條件之一,包括價值和良好的工程實踐;請參閱Marcus和Davis(Marcus&Davis,2019)進行進一步討論。)

§

有人可能會將強大的AI與例如狹義的智能,可以很好地完成單個狹窄目標(例如下棋或識別狗的品種)的系統進行對比,但這些系統往往以非常單一的任務為中心,并且不健壯且無法轉移到甚至適度不同的環境(例如,到不同尺寸的電路板,或從一個具有相同邏輯但字符和設置不同的視頻游戲到另一個視頻游戲),而無需進行大量的重新培訓。當將這些系統應用到要在其上進行訓練的確切環境時,它們通常會表現出令人印象深刻的良好效果,但是,如果環境與他們在其上進行訓練的環境有所不同,有時甚至是很小的差異,我們通常就無法指望它們。這種系統在游戲環境中已顯示出強大的功能,但在現實世界的動態,開放式流程中尚未被證明是足夠的。

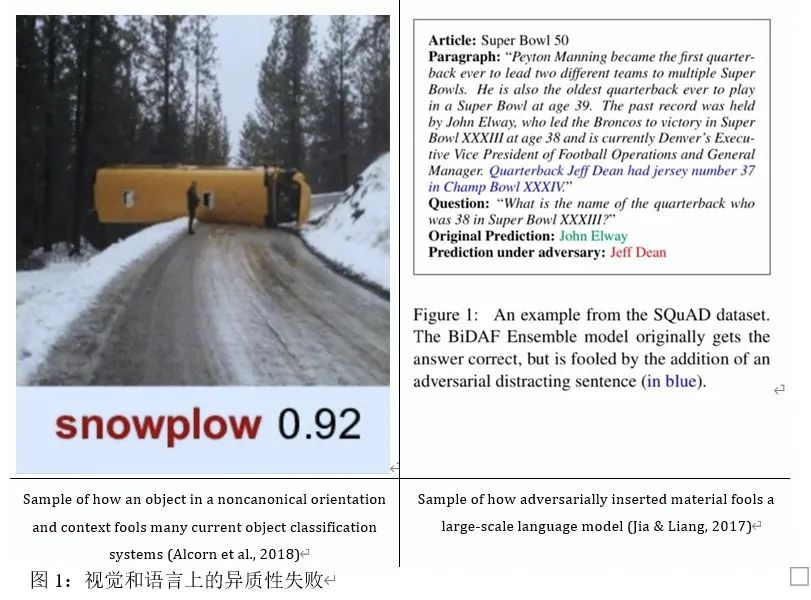

還必須將強大的智能與我稱之為點畫式智能進行對比,點智能在許多情況下都有效,但在許多其他情況下卻失敗了,表面上看起來很相似,以某種無法預測的方式。圖1展示了一個視覺系統,該視覺系統通常可以識別校車,但是在積雪的道路中(左)無法識別翻倒的校車(左),而閱讀系統(右)可以正確地解釋一些句子,但在閱讀過程中卻失敗。存在無關的干擾物。

任何密切關注AI文獻的人都將意識到,健壯性從一開始就一直遙遙無期。盡管已經投入了巨大的資源,但深度學習迄今仍未解決該問題。

相反,到目前為止,深度學習技術已證明是數據饑渴,淺薄,易碎且泛化能力有限(Marcus,2018)。或者,正如Francois Chollet(Chollet,2019年)最近所說的那樣,人工智能一直未能達到其理想:盡管我們能夠設計出在特定任務上表現出色的系統,但它們仍然存在明顯的局限性,脆弱性,數據量饑餓,無法理解與培訓數據或創建者的假設略有不同的情況,并且在沒有人類研究人員的大量參與的情況下無法調整自己的工作方式來應對新穎的任務。

用Facebook AI研究人員團隊的話說(Nieet al。,2019)

“越來越多的證據表明,最先進的模型學會了利用數據集中的虛假統計模式……而不是像人類那樣靈活而可概括地學習意義。”

正如Yoshua Bengio在最近的一篇文章(Bengio等人,2019年)中所指出的那樣,一個關鍵的弱點是當需要將機器學習方法推廣到訓練分布之外時,當前的機器學習方法似乎很薄弱,而這在實踐中通常是需要的。

我們怎樣才能將AI提升到一個新的水平?

§

我認為,如果不首先開發具有我和ErnieDavis所說的深刻理解的系統的能力,我們就不會獲得強大的情報,這不僅具有關聯和辨別復雜數據集中細微模式的能力,而且還具有查看任何場景并解決一些問題,例如記者可能會問:誰,什么,什么地方,為什么,何時以及如何。

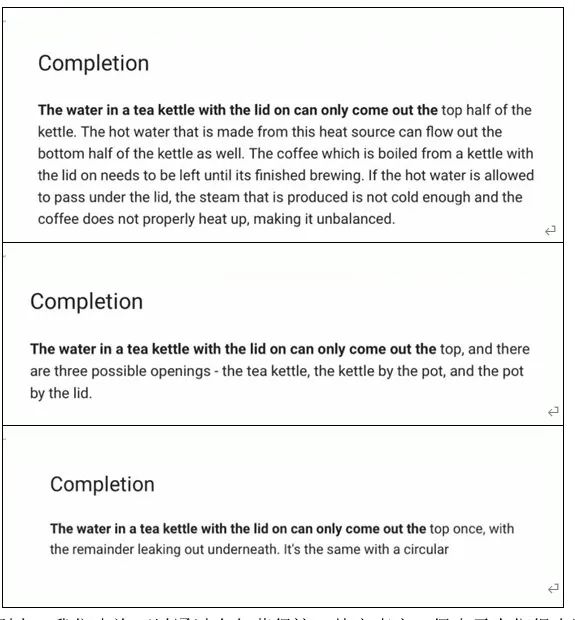

在美好的一天,像被廣泛討論的神經網絡GPT-2這樣的系統可以產生故事和類似的給定句子片段,可以傳達表面上似乎反映出深刻理解的東西。例如,給定一個句子片段(以粗體顯示),例如“兩個士兵走進酒吧”,它通常可以產生流利且聽起來似真實的連續感,例如人,酒吧,飲料和金錢之間的關系:

兩名士兵走進摩蘇爾的一家酒吧,把所有的錢都花在了喝酒上。

但是,無論許多GPT-2例子看起來多么引人注目,事實都是它的表示很單薄且不可靠,類似于Nie等人(2019)所指出的那樣,通常在密切檢查下會崩潰(Marcus,2020)。這是兩個典型案例,取材自我于2019年12月在NeurIPS(Marcus,2019)上提出的開發中基準測試。

?昨天我把衣服放在干洗店里了,還沒撿起來。我的衣服在哪里?在我媽媽的房子里。

?原木上有六只青蛙。兩只離開,三只加入。現在原木上的青蛙數是十七。

首先,GPT-2可以正確預測查詢片段后面的元素類別(即位置),但無法跟蹤干洗位置。在第二篇中,GPT-2再次正確預測了正確的響應類別(在這種情況下為數字),并且再次無法掌握細節。正如Marcus(Marcus,2020; Marcus,2019)所討論的那樣,這種錯誤非常普遍。顯然,我們將需要更穩定的基材以實現堅固性。

§

一切照舊主要集中在穩步改善深度學習工具箱中的函數逼近和組合工具,以及收集更大的訓練集并擴展到越來越大的GPU和TPU集群。可以想象通過收集更大的數據集,以各種方式擴充這些數據集以及在基礎架構中納入各種改進來改進像GPT-2這樣的系統。盡管這些方法具有價值,但需要進行更根本的重新思考。

可能會采用更多激烈的方法。例如,Yoshua Bengio為大幅擴展深度學習工具包提出了許多復雜的建議,包括開發通過對分布變化的敏感性統計提取因果關系的技術(Bengio等人,2019)和自動提取模塊化的技術。結構(Goyal et al。,2019),我都十分同情。

但我認為這還不夠,可能需要更強有力的藥物。特別是,本文的建議,即我們必須重新集中精力,致力于開發一個框架,用于構建能夠常規獲取、表示和操作抽象知識的系統,使用這些知識來構建、更新和推理復雜的外部世界內部模型。 §

從某種意義上說,我將要咨詢的是回歸到三個問題:經典人工智能知識、內部模型和推理,但希望以新的方式,用現代的技術來解決它們。

這些問題都是經典人工智能的核心。例如,約翰·麥卡錫在他的開創性論文《程序與常識》(Programs withCommon Sense)中指出了常識知識的價值[McCarthy 1959];道格·萊納特(Doug Lenat)將常識知識的機器表達形式作為他畢生的工作來解釋(Lenat,Prakash,&Shepherd,1985;Lenat,2019)。由TerryWinograd(谷歌創始人Larry Page和Sergey Brin的導師)設計的經典AI“blocks world”系統SHRLDU圍繞一個內部的、可更新的世界認知模型展開,該模型表示軟件對一組堆疊物理對象的位置和屬性的理解(Winograd,1971)。然后,SHRLDU對這些認知模型進行推理,以便推斷出隨著時間的推移,世界的狀態。

瀏覽一下機器學習領域最新論文的標題,你會發現很少有人引用這些觀點。一小部分人會提到推理,另一小部分人可能會提到實現常識的愿望,大多數人會(故意地)缺乏豐富的認知模型,比如個人和物體,它們的屬性,以及它們之間的關系。

例如,一個像GPT-2這樣的系統,做它所做的事情,不管是好是壞,沒有任何明確的(直接表示和隨時共享的)常識知識,沒有任何明確的推理,也沒有任何它試圖討論的世界的明確的認知模型。

許多人認為這種缺乏費力編碼的顯性知識的優勢。GPT-2并不是反常的,而是一種當前趨勢的特征,即遠離經典人工智能的關注,轉向一種不同的、更為數據驅動的范式,這種范式是由深度學習的復蘇所推動的(大約2012年)。隨著DeepMind備受推崇的Atari游戲系統(Mnihet al.,2015)的出現,這一趨勢加速發展,正如后面所討論的,該系統在不使用任何詳細認知模型的情況下成功地玩了各種各樣的游戲。

最近,強化學習的創始人之一Rich Sutton在一篇廣為閱讀的文章中明確了這一趨勢。這篇名為“痛苦的教訓”的文章明確建議不要利用人類的知識:

從70年的人工智能研究中可以得到的最大教訓是,利用計算的一般方法最終是最有效的,而且在很大程度上……研究人員試圖利用人類對該領域的知識,但從長遠來看,唯一重要的是利用計算。…人類知識方法傾向于使方法復雜化,使它們不太適合利用利用計算的一般方法。

在某種程度上,將人類知識構建到機器學習系統中甚至在機器學習界被視為作弊,當然也不可取。在DeepMind最有影響力的論文之一“掌握圍棋的游戲而不需要人類知識”中,其目標是完全放棄人類知識,以便“學習、制表、超人在挑戰領域的熟練程度”(Silver等人,2017)。如果能從大規模的語料庫中歸納出常識,并且有最小的先驗約束,那么機器學習社區的一大群人將非常高興。【當然,盲目地同化所有人類所說的一切,都會以自己的方式產生問題。正如ConceptNet的主要維護者Robyn Speer所說,我們的雄心壯志應該更好:“我們希望避免僅僅因為電腦對人來說很糟糕就讓電腦對人來說很糟糕。我們希望提供的(知識表達)不僅是技術上最好的,而且在道德上也很好。】模型構建也被證明是一項艱苦的工作,而且普遍的看法是,如果能跳過這一步,生活會更輕松。

§

問題是,即使有大量數據,也有像GPT-2(Radford等人,2019)那樣的Transformer(Vaswani等人,2017)這樣的基礎,當代神經網絡收集的知識仍然是零散的和點狀的,可以說是有用的,當然令人印象深刻,但永遠不可靠(Marcus,2020)。

上面的例子(如果你把洗好的衣服放在家里,顯然不可能還在你媽媽家里)和更明確的GPT-2測試中都暗含著這種不可靠和不可靠,比如:

如果打破玻璃瓶水,水可能會滾動。

如果打破玻璃瓶水,水可能會破裂一些并濺到地板上。水會產生氣泡,當瓶子中的水量增加時氣泡會膨脹。

如果您打破了一個裝有玩具兵的玻璃瓶,玩具兵可能會跟隨您到那里。

至關重要的是,薩頓關于用“通用方法”代替人類知識的價值的例子來自封閉性領域,例如游戲,對象分類和語音識別,而常識則是開放性的。在Go之類的游戲中獲勝與解釋和評估新聞故事或解決現實世界中意料之外的計劃問題大不相同,例如阿波羅13號機如何確定如何在宇航員所在的瀕危航天器上解決空氣過濾器問題快速耗盡。這是一種一次性解決方案,似乎超出了無知識的深度強化學習所可能管理的范圍。當要知道干洗地點在哪里時(就像前面的例子一樣,昨天,我把衣服放在干洗店里了,還沒有撿起來。),您需要一個世界的內部模型,以及一種隨著時間的推移更新模型的方法,這是一些語言學家稱為話語更新的過程(Bender&Lascarides,2019)。像GPT-2這樣的系統根本沒有那樣的功能。

當純粹的計算能力應用于開放式領域,如會話語言理解和對世界的推理時,事情就不會完全按照計劃進行。結果總是過于尖刻和零散,不可靠。

是時候反思一下了:如果我們接受了深度學習的教訓,但人類的知識和認知模式再次成為尋求人工智能的一流公民,我們的系統會是什么樣子?

2,一種混合的、知識驅動的、基于認知模型的方法

許多認知科學家,包括我自己,都以一種循環的方式來對待認知:有機體(例如人類)從外部吸收感知信息,他們基于對信息的感知建立內部認知模型,然后做出尊重的決策。這些認知模型,其中可能包括有關外部世界中存在哪種類型的實體,它們的屬性是什么以及這些實體之間如何關聯的信息。認知科學家普遍認識到,此類認知模型可能不完整或不準確,但也將它們視為有機體如何看待世界的關鍵(Gallistel,1990; Gallistel&King,2010)。即使是不完美的形式,認知模型也可以作為世界的有力指南。在很大程度上,有機體在世界上的繁榮程度取決于這些內部認知模型的良好程度。

電子游戲實質上是按照類似的邏輯運行的:該系統具有某種世界內部模型,并且該模型會根據用戶輸入(以及游戲模擬世界中其他實體的活動)定期進行更新。游戲的內部模型可能會跟蹤角色的位置,角色的健康狀況和所有物等。)游戲中發生的事情(用戶朝特定方向移動后是否發生碰撞)是該模型動態更新的功能。

語言學家通常根據一個相似的循環來理解語言:句子中的單詞被解析成一個語法,映射到一個語義上,這個語義指定了各種實體參與的事件之類的事情。該語義用于動態更新世界模型(例如,各種實體的當前狀態和位置)。機器人學的許多工作(雖然不是全部)都是以類似的方式進行的:感知、更新模型、做出決策。(有些工作,特別是對物體抓取的端到端的深度學習不起作用。)

當前論文最強烈、最核心的觀點是,如果我們不做類似的事情,我們就不會成功地尋求強大的智能。如果我們的人工智能系統不能利用對世界及其動力學的大量知識,對外部世界的過于詳細、結構化、內部模型進行描述和推理,它們將永遠類似于GPT-2:它們會利用大量的相關數據庫,正確地處理一些事情,但它們不會理解正在發生的事情,我們也不會能夠依靠他們,特別是當現實世界中的情況偏離訓練數據時,就像他們經常做的那樣。【如果GPT-2的輸入范圍擴大到包括感性輸入而不僅僅是文本輸入,它會做得更好嗎?也許,但我不認為僅僅擴大輸入范圍就能解決系統缺乏明確的內部模型的根本問題。同時,值得注意的是,盲童發展出豐富的內部模型,學習了相當多的語言以及如何將其與這些模型聯系起來,完全沒有視覺輸入(Landau,Gleitman,&Landau,2009)。】

§

為了擁有能夠以健壯的方式對世界進行推理的系統,我們需要什么計算先決條件?想要將深度學習(主要側重于學習)和經典AI(更關注知識,推理和內部認知模型)之間的橋梁聯系起來,將需要做什么?

作為熱身運動,可以考慮將簡單的任務作為較大挑戰的替代品。假設您正在構建一個機器學習系統,該系統必須基于少量數據來獲得廣泛范圍的概括,并且您將獲得少量這樣的訓練對,其輸入和輸出均表示為二進制數:

| Input | Output |

| 0010 | 0010 |

| 1000 | 1000 |

| 1010 | 1010 |

| 0100 | 0100 |

對于任何人來說,很快就會發現這里有一個籠統的概括(稱為“規則”),例如恒等式的數學定律f(x)= x +0。適用于新案例[f(1111)= 1111; f(10101)= 10101,依此類推]。

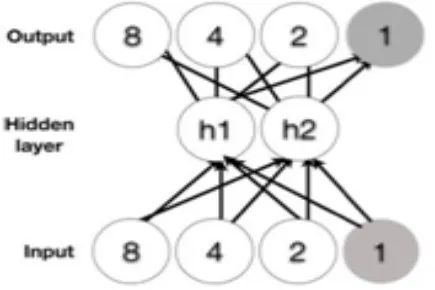

令人驚訝的是,一些神經網絡體系結構(例如,多層感知器,最近被一本教科書描述為深度學習的典型例子)遇到了麻煩。這是一個多層感知器的示例,輸入在底部,輸出在頂部,中間是一個隱藏層。對于任何接觸過神經網絡的人來說,它應該看起來很熟悉:

多層感知器接受身份功能訓練

這樣的網絡可以容易地學習將輸入與輸出相關聯,并且實際上“通用函數逼近”的各種定律可以保證這一點。給定足夠的訓練數據和通過訓練數據進行的足夠迭代,網絡可以輕松掌握訓練數據。

當一切順利的時候(例如,如果架構設置正確,并且沒有陷入學習的局部極小值),它還可以推廣到其他示例,這些示例在重要方面與所看到的示例相似。在“培訓分配范圍內”,例如:

| Test Input | Typical Test Output |

| 1110 | 1110 |

| 1100 | 1100 |

| 0110 | 0110 |

但是,在訓練分布之外進行泛化卻是完全不同的局面:

| Test Input |

Typical Human Response |

Typical Test Output |

| 0011 | 0011 | 0010 |

| 1001 | 1001 | 1000 |

| 1101 | 1101 | 1110 |

| 1111 | 1111 | 1110 |

這樣的例子表明,盡管在訓練分布范圍內的案例表現良好,多層感知器神經網絡畢竟還沒有學習到身份關系。如果同一系統僅針對偶數在f(x)=x上進行訓練,則不會將身份函數擴展到奇數,這不在訓練分布范圍內(Marcus,1998)。舉幾個例子,每個輸出節點,包括最右邊的代表“ 1”位的節點,都應以類似的方式處理:我們采用了最左邊的位抽象為最右邊的位的抽象概念。經過反向傳播訓練的多層感知器對不同的東西有反應。最右邊的節點始終為零,因此網絡將繼續預測最右邊的節點將始終為零,而不管輸入的性質如何,例如,得出f(1111)=1110。網絡以其自己獨特的方式進行了概括,但并未概括人類自然會發生的身份關系。

添加隱藏層不會改變網絡的行為(Marcus,1998);添加具有更多節點的隱藏層也不會改變(Marcus,1998)。當然,可以將任意數量的解決方案組合在一起來解決特定的問題(僅從偶數、二進制示例中學習身份),我在這里僅使用簡單的身份示例,僅用于說明目的,但是在訓練分布之外進行外推的問題很普遍,并且越來越得到認可。JoelGrus在這里給出了一個類似的例子,游戲fizz buzz和Lake and Baroni(Lake&Baroni,2017)展示了一些現代自然語言系統如何容易受到類似問題的影響,無法以各種方式將抽象模式概括為新單詞。Bengio在最近的NeurIPS演講(Bengio,2019)中對現存的中樞神經網絡的能力進行了限制。在規范的神經網絡架構中,廣泛的共性(如同一性)的非均勻擴展是非常普遍的,在我看來,它仍然是進展的主要障礙。

§

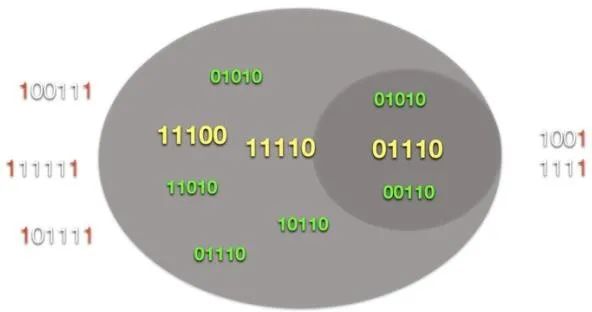

從本質上講,某些種類的現存神經網絡(例如此處討論過的反向傳播訓練的多層感知器)在兩方面表現出色:記憶訓練示例,以及在圍繞這些示例的點云內插點,這些點圍繞超維空間的某些簇(我稱之為在培訓空間中進行概括),但在培訓空間之外(在Bengio的措辭中,即培訓分布)中,它們的推廣效果很差。

多層感知器:善于在訓練樣本空間內推廣,而不善于在訓練樣本空間外推廣同一性函數。

結果是出現了兩個密切相關的問題:

1.特質:在開放式領域中,如果系統缺乏可靠的方法來概括超出訓練示例空間的內容,則不能信任這些系統。如果你把每個單獨的系統看作一個函數逼近器,那么目前流行的系統往往擅長于記憶示例,并且擅長于訓練示例附近的許多(盡管不是全部)示例,這使得它們對于圍繞分類的許多應用程序很有用。但是,如果超出培訓范圍,他們就很窮了。例如,最近的一個數學學習系統擅長于1+1=2;1+1+1=3到1+1+1+1+1=6,但在1+1+1+1+1+1+1=7和所有更大的例子中都失敗了。(想象一下,在一個計算機程序中編寫一個FOR循環,其中只有小于7的計數器值才能信任執行)。(相比之下,微軟Excel的Flash-fill是一種基于歸納程序綜合的符號系統,在許多情況下更有效(Polozov&Gulwani,2015)。

2.過分依賴訓練制度的具體細節:盡管所有正常的人類學習者都掌握了他們的母語和對世界的理解,但盡管環境千差萬別,神經網絡往往對確切的細節非常敏感,例如訓練項目的呈現順序(因此有一篇關于神經網絡“課程”的文獻)。同樣地,三十年來人們已經知道,它們容易受到災難性干擾的影響,即早期的關聯被后來的關聯覆蓋(McCloskey&Cohen,1989),這使得它們對項目呈現的順序非常敏感。潛在的解決方案仍在定期提出(McClelland,2019年),但問題仍然存在。同樣,正如最近的一篇論文(Hillet al.,2019)所說,“網絡表現出的泛化程度在很大程度上取決于給定任務實例化的環境細節。”

§

特質和無法推斷超出訓練分布范圍與我們許多常識性知識的普遍性相矛盾。這也使因果關系難以估量;另見Pearl和Mackenzie(Pearl&Mackenzie,2018)。

從引言中擴展一個例子,大多數普通的成年人和兒童將認識到(大概是從特定的經驗中得出的)以下抽象的因果歸納是正確的:如果您打破了一個盛裝液體的瓶子,一些液體將會(其他事情正在發生)相等)可能會越過瓶子。

這樣的真理是抽象的,因為它們不僅適用于某些特定項目,而且適用于大型的,不限成員名額的實體類別,而與瓶子的顏色或形狀或瓶子的大小無關,無論瓶子是否裝有水,咖啡,或不尋常的軟飲料。我們希望對于裝有滾珠軸承或游戲骰子的瓶子也能有類似的概括,即使我們以前對破碎瓶子的經驗幾乎只涉及盛裝液體的瓶子。

幾乎每個人也都會意識到以下概括是不切實際的:如果您打破了一個盛裝液體的瓶子,那么一些液體(其他東西將相等)可能會卷走300米。

同樣,無論個人經驗如何,我們都可以通過多種方式擴展此知識,因為對于大小不一的瓶子,甚至比以前遇到的瓶子大或小的瓶子,這種主張都不太可能成立。

在這種意義上,我們如何代表和操縱并獲得抽象的知識,不僅涉及特定實體,還涉及整個事物類?

外推的挑戰意味著像反向傳播訓練的多層感知器這樣的通用工具本身并不是適合該工作的工具。相反,我們必須找到一種替代的機制來學習,表示和擴展抽象知識。

2.1混合架構

2.1.1變量上的符號運算提供了唯一的已知解決方案,但解決方案是局限的

解決方案變量上的符號運算提供了一個潛在的答案-每天幾乎每秒使用數萬億次的解決方案,幾乎是世界上所有軟件的基礎。特別是,實際上,每個計算程序都包含四個基本概念:變量,實例,將變量綁定到實例的綁定以及對變量的操作。

這些想法中的每一個都是小學代數所熟悉的,其中像x和y這樣的實體是變量。特定數字(2、3.5等)是這些變量可能綁定的實例(例如,x當前可能等于3)。操作包括加法和乘法。這些使得可以表示諸如y = x + 2之類的關系,這些關系自動擴展到某個類中的所有值(例如,所有數字)。將變量連接到實例的過程有時也稱為變量綁定。

當然,計算機程序是建立在同一根基石上的。算法主要是根據對變量執行的操作來指定的。將變量綁定到實例,調用算法,執行操作,并返回值。

重要的是,核心操作的指定方式通常適用于某個類的所有實例(例如所有整數、所有字符串或所有浮點數)。核心操作通常包括一些基本操作,如算術運算(加法、乘法等)、比較(x的值是否大于y的值)和控制結構(對變量n當前綁定到的任何值執行n次操作;如果x的值超過y的值,則選擇備選方案a),否則選擇備選方案b等)。一級近似(忽略bug、程序員邏輯中的錯誤等),這意味著正確實現的函數適用于某個類中的所有輸入,完全獨立于它們可能暴露于或不暴露于的輸入。

值得注意的是,這種根據操作定義的功能定義事物的方法是與標準機器學習完全不同的范例。機器學習系統通常通過Judea Pearl將其比作曲線擬合的過程來學習將輸入變量與輸出變量相關的函數,而程序員通常根據變量的運算來獨立于訓練數據來定義其算法。不用說,它已經很好地服務于傳統的計算機程序員,支持從操作系統到Web瀏覽器到視頻游戲再到電子表格等的所有內容。

至關重要的是,通常將系統對變量的核心操作構建為獨立于經驗而系統地工作。例如,微處理器中的循環移位操作的機制是由一組并行的子操作定義的,每個子操作一個位,直到微處理器字的寬度。不管以前是否使用過該操作,其操作都相同,因此無需學習。程序員可以放心地預期,無論經驗如何,換檔操作都將起作用,并且無論經驗如何,將來都將以此方式繼續進行。所有這些機制(變量,實例,綁定和操作)的優點在于,它允許程序員以某種抽象級別指定事物,并以某種可靠性作為副產品。

總的來說,關于變量,綁定,實例和對變量的操作的這四個假設構成了符號操縱的核心(Newell,1980; Marcus,2001)。(符號本身只是對其他系統使用的事物進行編碼的簡單方式,例如用于表示ASCII代碼中的字母的二進制數字模式,或允許神經網絡中的輸出節點表示特定單詞的編碼據我所知,目前所有的系統都使用它們;請參閱Marcus 2001,第2章。某些符號處理系統可能只有少量的操作,例如加法,連接和比較,而另一些符號可能具有更豐富的操作(例如,復雜邏輯公式的統一),就像微處理器的大小可能有所不同一樣。他們的核心指令集。可以在符號處理體系結構上構建遞歸,但這并不是絕對的邏輯要求。

正如我所說(Marcus,2001;Marcus,1998;Marcus,Vijayan,Bandi Rao,&Vishton,1999;Berent,Marcus,Shimron,&Gafos,2002;Berent,Vaknin,&Marcus,2007),某種形式的符號操縱似乎對人類認知是必不可少的,比如當一個孩子學會了一種抽象的語言模式,或者一個像姐妹這樣的詞的含義可以被理解應用于無限多的家庭,或者當一個成年人以一種新穎的方式擴展了一種熟悉的語言模式,這種方式超越了訓練分布(Berent et al.,2002;Berent et al.,2007)。一些最有力的證據來自1999年的一項研究(Marcus等人。,1999年),我的同事和我展示了7個月大的嬰兒能夠識別簡單的抽象模式,比如拉塔塔中的ABB模式,并將它們從一組訓練樣本中推斷出完全由不同音節組成的新字符串,這些音節在語音上與他們的訓練集沒有重疊。隨后的研究表明,即使是新生兒似乎也有能力進行這種推斷。Gallistel和King(Gallistel和King,2010)認為變量的存儲和檢索對于動物認知至關重要。例如,蜜蜂似乎能夠將太陽方位角功能擴展到它們未曾接觸過的光照條件。(Dyer和Dickinson,1994年)。

符號處理的通用機制也為結構化表示提供了基礎(Marcus,2001)。例如,計算機程序通常使用由符號構成的樹形結構,這些符號通過對變量的操作組合而成,以表示各種各樣的事物(例如層次結構文件夾或目錄)。

同樣,符號操縱的機制允許跟蹤個體隨時間變化的屬性(例如,以數據庫記錄的形式)。這些能力似乎對于人類語言(如遞歸句子結構)以及隨著時間的變化而對個體和對象的了解至關重要(Marcus,2001)。【《代數思維》的第5章提供了一些示例,這些示例在消除連接主義模型的范圍之外,其中許多示例依賴于實體隨著時間的推移而存在。)這種機制非常強大。世界上所有的Web瀏覽器,世界上所有的操作系統,世界上所有的應用程序等都建立在它們之上。 (具有諷刺意味的是,幾乎在世界上所有神經網絡的規范和執行中都使用了相同的工具)。】

§

然而,在歷史上,主流的深度學習在很大程度上試圖擺脫符號操縱機制,而這種機制往往是有意回避的,這是為什么神經網絡提供了一種替代經典范式的號召的一部分。魯梅爾哈特和麥克萊蘭(1986,#39979;)在著名的PDP書籍中,將符號操縱視為一種邊緣現象,而不是人類計算的本質。2015年,辛頓將符號比作“發光的以太”,認為將符號邏輯作為人工智能的一個組成部分的追求是,

認為光波只能通過在發光的以太中造成干擾而在太空中傳播的信念,這是不正確的……與科學家……被令人信服的但不正確的類比誤導了,他們只知道他們知道具有所需特性的系統。

令人驚訝的是,在神經網絡上的大量工作中也缺少個人的數據庫式記錄之類的想法,而僅在很小的研究中發現了諸如層次結構化句子之類的復雜結構化表示形式,而這兩者的規范輸入和輸出是簡單的矢量或二維位圖,而巧妙地避免了針對個人的分層數據結構和記錄。(DeepMind有趣的新MEMO架構(Banino等人,2020年)幾乎代表了一個記錄數據庫。)

并非一定要這樣。例如,原則上,人們可以嘗試構建與符號操縱兼容的神經網絡采用的術語中的“實現連接主義”,也可以嘗試建立與之兼容的神經網絡。無需依靠符號操縱原理(“消除聯系主義”)或兩者之間的某種混合,就可以進行操作。到目前為止,絕大多數工作都是消除主義的,但這種優勢反映了社會學事實,而不是邏輯上的必要性。

我預計,幾年內,許多人會想,為什么這么長時間以來,深度學習在很大程度上沒有使用符號操縱這一極具價值的工具;實際上,人類所有偉大的工程成就都依賴于某種符號推理,人類在日常認知中利用它們的證據是巨大的。事實上,正如我將在下面討論的,隨著一種新的、更廣泛的實用主義的暗示,事情終于開始改變了,我希望這種實用主義能夠克服先前的教條。

本文的第一個主要主張是:要建立一種強大的,知識驅動的AI方法,我們必須在工具包中使用符號處理機制。太多有用的知識是抽象的,如果沒有表示和操縱抽象的工具就無法做到,并且迄今為止,我們知道的唯一可以可靠地操縱這種抽象知識的機器就是符號操縱的設備。

遺憾的是,就變量本身而言,運算的手段對學習沒有任何幫助。【歸納邏輯編程(Cropper,Morel和Muggleton,2019年)是一種純粹基于規則的學習方法,值得一些考慮,盡管不在本文的討論范圍之內。】

正是從那里,混合架構的基本需求,結合符號操作和其他技術,如深度學習,最根本的東西出現了。深度學習提高了學習的門檻,特別是在大型數據集上,符號操作為表示和操作抽象設置標準。很明顯,我們需要把兩者(或類似的東西【雖然我很有信心,強大的智能將依賴于某種混合,將符號運算與機器學習機制相結合,但目前尚不清楚深度學習(如目前實踐的)是否會在其作為主導機器學習機制的角色中發揮最后的作用,或者這種角色是否會在某種繼承者身上發揮,e、例如,在數據和能源使用方面更易處理或更高效。諸如統計關系學習(Raedt,Kersting,Natarajan,&Poole,2016)和概率規劃(Bingham et al.,2019)等受到較少關注的方法非常值得考慮;有關概述,請參見van den Broeck(van den Broeck,2019)。】)結合起來。

2.1.2混合動力通常是有效的

混合動力并不是什么新鮮事物:Pinker和我在三年前(Marcus等,1992)提出,關于兒童如何學習英語過去時的最好解釋是混合動力:一條規則(添加到動詞詞干)形成規則動詞的過去式,以及類似神經網絡的系統來獲取和檢索不規則動詞。長期以來,明顯需要將符號知識與感知知識相結合(例如,人們希望能夠通過將對馬的外觀的感知知識與將斑馬比作有條紋的馬相類似的語言定義相結合來識別斑馬【現有的零射擊學習文獻試圖整合各種形式的多模態知識,但據我所知,目前沒有一個系統能夠利用字典定義中的精確信息。】)。

像Ron Sun(Sun,1996)這樣的計算機科學家在整個1990年代都倡導混合模型。 Shavlik(Shavlik,1994)表明,有可能將(有限的)邏輯子集轉換為神經網絡。 D’AvilaGarcez,Lamb和Gabbay(D’Avila Garcez,Lamb和Gabbay,2009年)是有關神經符號方法的重要早期工作。

壞消息是這些早期的混合方法從來沒有受到太大的關注。當時的結果并不令人信服(可能部分是因為在TPU之前的日子里,神經網絡本身的能力不足)。而且神經網絡社區經常不屑一顧混合動力(以及涉及符號操縱的任何事物)。直到最近,混合符號在歷史上一直被困在符號方法和神經方法之間的交火中。

好消息是,符號操縱世界和深度學習領域之間的早就應該融化了。例如,Yoshua Bengio在我們2019年12月的辯論中談到了合并可以按名稱傳遞變量的技術,這是一些早期計算機語言中使用的標準符號操作技術。越來越多的努力正在積極嘗試將符號和神經網絡更緊密地構建在一起,有時出于實際需要,有時出于研究工作以開發新方法。

世界上一些最龐大、最活躍的商業人工智能系統,比如谷歌搜索,實際上是混合了符號操作和深度學習的混合體。雖然Google搜索并不是我們心目中強大的人工智能,但它是一個高效的人工智能信息檢索系統,能夠以高精度、大容量的方式工作。它的設計者以高度數據驅動的方式對其進行了廣泛的優化,目前(根據多種來源)通過混合經典的、符號操作的人工智能技術(例如,表示和查詢谷歌知識圖的工具,它使用經典的符號圖結構表示知識,這些符號圖結構使用神經網絡社區的工具(例如,BERT和RankBrain)。谷歌做了大量的實證實驗,看看什么在大范圍內運作良好,而事實上,即使在深度學習的時代,他們仍然使用谷歌知識圖,這既說明了符號的價值,也說明了混合動力車的價值。(不幸的是,我知道沒有詳細的公開討論各個組成部分的相對優勢和劣勢。)

OpenAI的Rubik求解器(OpenAI等人,2019)(盡管它并未如此推銷)是用于解決Rubik立方體的認知方面的符號算法與針對手動操作方面的深度強化學習的混合體。

Mao等人(Mao,Gan,Kohli,Tenenbaum,&Wu,2019)最近提出了一種用于視覺問答的混合神經網絡符號系統,稱為NS-CL(神經符號概念學習者的縮寫),該系統超過了他們研究的深度學習方案。Janner等人的相關工作(Janner等人,2018年)。通過對單個對象的顯式記錄進行深度學習,以便做出預測和基于物理的計劃,遠遠超過可比的純黑盒深度學習方法。Evans和Grefenstette(Evans和Grefenstette,2017)展示了混合模型如何更好地捕捉各種學習挑戰,例如挑戰multlayer感知機的游戲fizzbuzz。Smolensky和Schmidhuber等團隊將BERT與張量積(Smolensky et al.,2016)相結合,形成了一個表示符號變量及其綁定的正式系統(Schlag et al.,2019),創建了一個稱為TP Transformer的新系統,從而在一個數學問題集上取得了更好的結果。

神經符號模型的基礎工作是(D\\\\\\'Avila Garcez,Lamb,&Gabbay,2009),它檢驗了符號系統和神經網絡之間的映射,并顯示了傳統神經網絡中可以表示的知識種類的重要限制,并從表征和推理能力的角度論證了符號和神經網絡在構建混合系統中的價值。在一級近似下,傳統的神經網絡可以被認為是命題邏輯的引擎,并且缺乏表示量化語句的好方法,就像在謂詞演算中使用諸如every和some之類的量詞一樣。邏輯張量網絡(Serafini&Garcez,2016)旨在在深度張量神經網絡中實現形式邏輯。

統計關系學習(Raedtet al.,2016)代表了另一種有趣的方法,旨在將邏輯抽象和關系與概率和統計結合起來,正如Vergari et al.最近關于概率電路的工作一樣(Vergari,Di Mauro,&Vanden Broek,2019)。Domingo的Markov邏輯網絡試圖將符號操作與機器學習的優勢結合起來(Richardson&Domingo,2006)。Uber的Pyro(Bingham等人,2019年)

Arabshahi等人(Arabshahi,Lu,Singh,&Anandkumar,2019)展示了如何通過用作堆棧的外部內存來擴充樹LSTM。Fawzi等人(Fawzi,Malinowski,Fawzi,&Fawzi,2019)最近提出了一個用于搜索多項式不等式證明的混合系統。Minervini等人(Minervini、Bo?njak、Rockt?schel、Riedel和Grefenstette,2019)最近提出了一種混合神經符號推理系統,稱為貪婪神經定理證明器(GNTP),可用于大規模數據庫;Gupta等人(Gupta、Lin、Roth、Singh和Gardner,2019)也在推理方面取得了進展。艾倫人工智能研究所(Allen Institute for AI)的亞里士多德(ARISTO)是一個復雜的多部分混合系統,在八年級科學考試中顯著優于其他系統(Clark et al.,2019)。Battaglia已經發表了許多關于物理推理系統的有趣論文,這些系統集成了符號圖和深度學習(例如,Cranmer,Xu,Battaglia,&Ho,2019)

所有這些只是一個快速發展領域的幾個例子。現在阻礙勝利者還為時過早,但要構建將符號方法的優勢與機器學習的見解相結合的體系結構,還有很多第一步,以便開發更好的技術,從大型、通常是嘈雜的數據集中提取和概括抽象知識。2.1.3對混合模型和符號操縱的普遍反對意見

盡管人們對研究混合模型的興趣日益濃厚,并且有多種考慮,但是在機器學習社區的某些地方,人們對符號操縱的厭惡情緒日益高漲。如前所述,例如,杰弗里·欣頓(Geoffrey Hinton)認為,歐洲對混合動力汽車的投資將是“巨大的錯誤”,并將混合動力汽車的研究比作電動汽車時代使用過時的汽油發動機。

但是據我所知,Hinton近年來沒有寫過多篇有關他為何反對部分象征性混合模型的文章。

以下是我從其他人那里聽到的一些常見異議,并對每個異議都做出了簡短回應:

?符號在生物學上不合理。對此異議至少存在四個問題(關于相似的觀點,另請參見Gallistel和King(Gallistel&King,2010年))。

首先,僅僅因為我們還沒有確定支持符號操縱的神經機制并不意味著我們永遠不會。已經確定了一些有希望的可能的神經基質(Frankland&Greene JD,2019;Marcus,Marblestone,&Dean,2014;Legenstein,Papadimitriou,Vempala,&Maass,2016),其他文獻指出了理論上合理的神經基質(Marcus,2001)。沒有令人信服的證據表明,沒有這樣的機制根本不可能存在于大腦的濕部。今年我們已經看到樹突中的一個小隔間可以計算XOR(Gidon etal.,2020),這增加了單個神經元可能比通常假設的復雜得多的可能性。例如,對符號操作至關重要的變量值的存儲和檢索可能在單個神經元內起作用(Gallistel&King,2010)。

第二,大量心理學證據(見上文第2.1.1節)支持這樣一種觀點,即符號操作在大腦中是具體化的,比如嬰兒將新的抽象模式擴展到新項目的能力,成年人將抽象的語言模式概括為他們沒有直接數據的非本族語的能力,蜜蜂將太陽方位角函數概括為他們沒有直接觀察到的光照條件的能力。人類還可以學習在外部表示的符號上應用形式邏輯,并編程和調試符號表示的計算機程序,所有這些都表明,至少在某些配置中,神經軟件確實可以(在某種程度上,部分受內存限制)操縱符號。我們可以理解語言本質上是無限多樣的,從無數的句子中推斷出無數的意義。在整個認知過程中,作為變量運算特征的自由概括是普遍存在的。

第三,現有的神經認知證據的缺乏幾乎沒有告訴我們什么。我們目前還沒有詳細了解加里·卡斯帕羅夫水平的象棋是如何在大腦中實現的,但這并不意味著加里·卡斯帕羅夫的象棋在某種程度上依賴于非神經機制。

最后,即使結果表明大腦沒有使用符號操縱機制,對于人工智能為什么不能使用這些機制,也沒有原則性的論據。人類沒有浮點運算芯片,但這并不意味著他們在人工智能中應該是多余的。人類顯然有寫一次的機制,可以立即檢索短期記憶,這是某種形式變量綁定的前提,但我們不知道相關機制是什么。這并不意味著我們不應該在人工智能中使用這種機制。

?過去,符號系統/混合系統運行不佳。我經常聽到這種說法,但是在我看來,這是一個奇怪的說法。將混合模型描述為明顯無效或過時的混合體,這并不是現實的準確描述,而實際上已經對其進行了積極有效的研究,如2.1.2.10節中所述。

?符號操縱/混合系統無法縮放。盡管這里有一些真正的問題需要解決,而且必須花大量的精力來約束符號搜索,以便能夠實時處理復雜的問題,Google說

知識圖似乎至少是這一異議的部分反例,最近在軟件和硬件驗證方面取得的大規模成功也是如此。Minervini等人(Minervini等人,2019年)和Yang等人(Yang,Yang,&Cohen,2017年)等論文在構建端到端可區分的混合神經符號系統方面取得了實際進展,這些系統在規模上起作用。與此同時。沒有正式的證據證明不可能充分縮放,給予適當的啟發,存在。

在過去的三十年中,我看到了很多對符號的偏見,但是我還沒有看到對它們的有說服力的論據。

2.1.4確定給定系統是否為混合系統并不總是一件容易的事

一種常見的(雖然不是普遍的)對符號的偏見產生了一個特殊的社會學事實:研究人員偶爾會建立包含符號操縱裝置的系統,卻不承認(甚至不考慮事實)他們已經這樣做了;我在馬庫斯,2001中給出了一些具體的例子。例如,如上所述,OpenAI Rubik的立方體解算器(OpenAIet al.,2019)包含了一個被稱為Kociemba算法的符號組件,但只有非常細心和成熟的讀者才會認識到這一點。“混合”和“象征”這兩個詞從未被提及。而“神經”這個詞出現了13次。

因為你不能總是通過粗略的檢查來告訴我們一個給定的系統是如何工作的,所以從邏輯上講,有可能無意中構建一臺有效地執行符號操作的機器,而沒有意識到這樣做。事實上,一個網絡設計師可能會無意中發現一些與符號FPGA同構的東西,而從來沒有意識到它。

正如本吉奧在我們最近的辯論后對話中所建議的那樣,深度學習系統可以為符號操縱提供一個真正的替代方案,這是可以想象的:

我敢打賭,深度學習變體可以實現人類可能實際執行的類似符號的計算形式,但使用的基底與GOFAI非常不同,限制與人類經歷的類似(例如,只有很少的遞歸級別),在GOFAI推理中,除了能夠學習和處理不確定性之外,還避免了與搜索問題相關的主要效率問題。

我們不能想當然地認為任何給定的神經網絡都提供了一種替代方法。

評估一個系統是執行“類似符號的計算”的替代方案,還是使用真正的符號操縱操作進行計算的唯一方法是探索映射:考慮該體系結構及其組件是否映射到符號操縱的組件(在某種意義上,化學映射到物理學)。Marr(Marr,1982)的計算水平清楚地表明了這一點:任何給定的計算都可以以多種方式實現,并且不是每個實現都是透明的。化學映射到物理上,但這并不意味著映射很容易被發現。“正確”的神經網絡可能映射到符號操縱機器上,也可能映射到符號操縱機器上;真相可能很難辨別。

我堅信,任何健壯的系統都會有某種機制來綁定變量,并在綁定后對這些變量執行操作。但我們看不出來。

§

為了避免這聽起來很奇怪,回想一下映射對于理解神經科學以及它與計算的關系同樣重要。無論我們的大腦中實現了什么樣的計算,都是在沒有任何有意識的決策的情況下實現的;它們是進化的。其中很少有透明的。這是神經科學家和那些致力于以大腦為靈感的人工智能方法的人工智能研究人員的工作,他們對大腦進行逆向工程,以找出存在哪些計算。任何驅動大腦的東西都可能會或不會映射到我們目前的理論。當我們評估大腦如何工作的一些理論時,我們正在評估大腦的機制是否符合這個理論。有些理論將包含與大腦中發生的實際過程同構的結構,而另一些則不會。Knudsen和Konishi(Knudsen和Konishi,1979)對谷倉貓頭鷹聲音定位的仔細研究是一個很好的例子,說明了一個神經回路最終是如何被破譯并映射到基礎計算上的;很少有研究項目能與之相媲美。

人工智能中也出現了類似的問題:當一個系統工作時,理解是什么驅動了它的性能是有價值的,但往往是不重要的。

一個系統將所有的經驗存儲在一個單獨的內存中,而不是可以檢索和計算出來的,可以用“神經”的術語來描述,但是它的組件可以識別地起到維護變量、綁定、實例和變量操作(如檢索)的作用。

如果我們通過某種搜索過程(無論是隨機的、試錯的、進化的、AutoML的或其他方法)來創建適當的綜合系統,我們將解決部分工程問題,但不一定科學地理解是什么使這些模型起作用。后者是逆向工程的工作,是發現和拒絕可能的映射,就像神經科學一樣。

如果完美的神經網絡降臨到我們身上,我們可能會通過廣泛的測試發現它是有效的;要理解它是如何工作的,還需要另一個科學發現階段。如果我們發現一些成功的神經網絡,結果發現它的組成部分恰好完美地映射到符號操作上,那么這將不僅是神經網絡的勝利,而且也是符號操作的勝利——不管系統設計者的意圖是什么。相應地,如果沒有一個系統的組成部分映射到符號操縱上,這將是符號操縱的失敗。

任何一個通情達理的人都會認識到,到目前為止,理解人類大腦是如何工作的是多么的困難,而當神經網絡變得越來越復雜時,同樣的道理也會變成現實。人類大腦本身就是一個令人印象深刻的神經網絡的例子,它有效地(通過進化)降臨到我們身上;它似乎工作得很好,但我們不知道為什么【尋求實現細節和算法描述之間的映射(如果它們存在的話)也可能具有實際價值,因為,例如,一旦發現了那些映射,一些低級的神經網絡類計算可能會更有效地在純符號級別上進行計算。相反,一些被稱為神經網絡的模型,如Lample和Charton最近關于符號集成的研究(Lample和Charton,2019),經過仔細檢查,結果發現有嚴重的局限性,并且嚴重依賴于符號處理器(Davis,2019)。對符號和神經成分如何協同工作有一個清晰的、有原則的理解可能是非常有價值的。】

2.1.5總結

符號操作,特別是對變量的操作機制,提供了一個自然但不完整的解決方案,來解決在訓練機制之外進行外推的挑戰:用對變量的操作來表示一個算法,并且它固有地被定義為擴展到某類的所有實例。它還提供了一個清晰的基礎來表示結構化的表示(例如在生成語言學中被視為基礎的樹結構)和記錄個人及其行為屬性。

它所缺乏的是一個令人滿意的學習框架。混合可以是兩個世界的最佳結合的一種方式:從大規模數據集學習的能力,如深度學習所示,以及表示抽象表示的能力,這些抽象表示是世界上所有計算機編程語言的語法和語義貨幣。我猜想它們是安全獲得可靠情報的先決條件。

用于研究混合模型的資源遠遠少于用于避免符號操縱的“純”深度學習系統的資源,但第2.1.2節中回顧的來自廣泛研究實驗室的越來越多的工作,更不用說谷歌搜索的成功,所有這些都表明了對混合體系結構進行更深入研究的價值。

遺憾的是,我們還沒有走出困境。將強大的數據驅動學習技術與符號操作的表示和計算資源相結合的混合模型可能是魯棒智能所必需的,但它們肯定是不夠的。接下來我將描述三個進一步的研究挑戰。

2.2大規模的、抽象的、有因果關系的知識

符號操作允許抽象知識的表示,但是積累和表示抽象知識的經典方法,一個稱為知識表示的領域,一直是殘酷的艱苦工作,遠遠不能令人滿意。在人工智能的歷史上,Doug Lenat于1984年發起的以機器可解釋的形式創造常識知識的最大努力是被稱為CYC的系統(Lenat等人,1985)。它需要數千人-年的時間,幾乎是巨大的努力,以精確的邏輯形式捕捉心理學、政治學、經濟學、生物學和許多其他領域的事實。

到目前為止,回報并不令人信服。關于CYC的報道相對較少(這使得評估變得很有挑戰性,盡管你可以看到這個有趣的黑客新聞線索),商業應用程序看起來很溫和,而不是勢不可擋。大多數人,如果他們了解CYC的話,都認為它是一種失敗,而目前很少有研究人員廣泛使用它。似乎很少有人愿意嘗試建立具有可比廣度的競爭體系。(像googleknowledgegraph、Freebase和YAGO這樣的大型數據庫主要關注事實,而不是常識。)

考慮到CYC需要付出的努力,以及它對整個領域的影響是多么的小,很難不被GPT-2這樣的Transformers所激發。當他們工作得很好時,他們看起來幾乎是神奇的,好像他們自動地、幾乎毫不費力地吸收了世界上大量的常識知識。從某種程度上說,Transformers給人的感覺是,它將自己所吸收的任何知識與對人類語言看似復雜的理解無縫地結合在一起。

這對比鮮明。然而,知識表示社區幾十年來一直在努力用精確的方式來描述容器及其內容之間的關系,而自然語言理解社區幾十年來一直在努力進行語義分析,而GPT2這樣的Transformers似乎是在不借助于語法的情況下解決了棘手的問題任何明確的知識工程(或語義分析)-無論如何。

例如,在GPT-2中沒有知識工程規則,沒有相對于容器的液體規格,也沒有關于水甚至是液體的規格。在前面的示例中

如果打破玻璃瓶裝的水,裝滿的水可能會流出,會發出飛濺的聲音。

從概念H20(化學中水的表達)到單詞water都沒有映射,也沒有動詞語義的任何顯式表示形式,例如中斷和流動。

再舉一個例子,GPT-2似乎也對火進行了編碼:

點火的一個好方法是使用打火機。

點燃火的一個好方法是使用火柴

與Lenat數十年的以機器可解釋的形式對人類知識進行手工編碼的項目相比,乍看之下,這既代表了一夜的成功,也代表了驚人的勞動力節省。

§

問題在于GPT-2的解決方案只是對知識的近似,不能替代知識本身。特別是,它所獲得的是近似的統計數據,即單詞在大型語料庫中是如何共存的,而不是概念本身的清晰表述。換句話說,它是單詞用法的模型,而不是思想的模型,前者是后者的近似模型。

這樣的近似值就像是一個復雜的三維世界的陰影。通過使用與瓶子相關的單詞,瓶子和打破的概念在語料庫上投射了陰影,這些陰影編碼了人類互動的一個子集。 Transformers分析單詞留下的陰影,就像柏拉圖的洞穴寓言中的囚徒一樣。麻煩的是,對陰影的分析(即在這些語料庫中如何使用單詞的共現統計分析)并不一定能揭示瓶的真正含義或破碎含義。

事實是,GPT-2幾乎不了解與它所分析的單詞相關的概念的相關性(無關緊要)。考慮一下發生了什么情況,例如,按照弗蘭克·基爾(Frank Keil,1992)的經典實驗,如果您將感知功能與更深的概念理解相對立:

如果您在浣熊上穿上服裝使它看起來像臭鼬,那將是臭鼬。

如果將飛機噴漆成看起來像龍,那將是龍。

顯然,僅了解某個概念中如何使用單詞的某些統計屬性不足以理解基礎概念的本質,例如使飛機變成飛機而不是龍的原因(反之亦然)。這份最近匿名的,正在審查的手稿也提出了類似的觀點。

我想起了像Nigel Richards這樣的Scrabble冠軍,他們在不懂法語的情況下贏得了法國Scrabble比賽;各個單詞僅用作游戲代幣,而與它們的含義無關。本質上,GPT-2可以預測單詞序列作為游戲代幣的屬性,而不會暗示所引用的基本概念。

它做得如此之好,以至于有時會引起“伊麗莎效應”,在這種效應中,幼稚的人對機器的歸屬要比對機器的實際歸屬更多,但是除了表面的概念理解之外,別無所求。

如果我們繼續探究起火的例子,我們會得到類似的結果

點火的一個好方法是用干燥的棉球遮蓋保險絲!

點燃火的一個好方法是使用一品脫大小的爐子

“火”,“融合”,“光”等詞都是相互關聯的; GPT-2能夠做到這一點,但這還不足以讓GPT-2引發對火的性質的概念性理解;結果參差不齊。換句話說,就像朱迪亞·珀爾(Judea Pearl)所說的那樣,這種異常行為是您試圖通過近似統計單詞用法的統計曲線來誘導世界如何運轉時得到的結果,而不是歸納出對世界的更抽象,因果的理解。【在深度學習社區的某些部分中,有一種積極的努力試圖整合因果方法;我的猜測是,如果不在因果知識的表示和操作上增加一些固有的約束,這就不可能成功,很可能導致某種混合網絡。】有時行得通,有時卻行不通。

一個人不可能用如此缺乏可靠性保證的零件來設計一個健壯的系統。

§

用如此低的可靠性試圖用零件構建系統的一個問題是,下游推理將不可避免地受到影響。擁有知識的全部目的是將其用于行動,解釋和決策中。如果您不知道會引起火災的原因,或者瓶子破裂時會發生什么,則很難推斷周圍的情況。同樣,您不能可靠地進行計劃。想象一下,一個家用機器人無法點燃頑固的爐灶,用干燥的棉球花了幾個小時,一個又一個地覆蓋了一個保險絲。

語言理解也不可避免地會受到影響,因為我們經常根據話語的真實性和語境來消除話語的歧義(Tanenhaus,Spivey-Knowlton,Eberhard和Sedivy,1995)。像GPT這樣的系統具有一定程度的詞語用法語境,但缺乏對認知語境和合理性的可靠表示。

在充滿了如此淺薄的概念理解的系統中,可解釋性和可解釋性也將變得難以捉摸。將棉球和打火機凝結成同等有效的點火方式的系統可能沒有內部一致性來滿足可解釋性的需求。

如果對基本概念沒有連貫的因果理解,則可能沒有辦法在復雜的實際環境中設計魯棒性。 Pearl是對的:如果我們的系統僅依賴于曲線擬合和統計近似,則它們的推論必然會很膚淺。

這使我想到了本論文的第二個主要主張:歸結,表示和操縱通常具有因果關系的結構化,抽象知識的大型數據庫的系統方法是強大情報的先決條件。

2.2.1強大的人工智能將需要什么樣的知識?

以下是一些基本注意事項:

?大部分(但重要但并非全部)知識(請參閱下文)都可以學習。沒有人生來就知道打火機會著火,干燥的棉球不會起火,玻璃瓶破裂時可能會做什么。可以想象,可以像CYC那樣,將這些知識硬連接到AI系統中,對每個事實進行手工硬連接,但是現代機器學習愛好者顯然不愿意這樣做。而且由于總是有新知識要收集,因此有必要學習新的抽象機制(通常是因果知識)。

??一個健壯的系統可能利用的知識中,有相當一部分是象征性地表現出來的外部文化知識。例如,維基百科的絕大多數內容都是口頭表達的,一個強大的情報機構應該能夠利用這種知識。(目前的深度學習系統只能在非常有限的范圍內做到這一點。)大部分知識都是根據變量之間的量化關系進行有效編碼的(例如,對于所有x、y和z,x、y和z都是人,如果有一個人y是x的父母和z的孩子,那么x就是z的孫子;對于所有x,x是一個物種,x物種的生物體產生的后代也是x物種的后代,等等)。

?健壯的系統需要的知識中有很大一部分可能是抽象的。當前的系統擅長表示特定事實,例如BORN(ABRAHAMLINCOLN,KENTUCKY)和CAPITAL(KENTUCKY,FRANKFORT),但缺少表示和有效處理信息的方式,例如如果瓶子壞了,其他條件相等時,瓶子中的內容物可以逃逸。

?規則和例外必須并存。規則動詞(walk-walked)與不規則動詞(sing-sang)共存。不會飛的企鵝和其他很多會飛的鳥類共存。機器必須能夠以某種方式來表示知識,就像語言學家所說的泛型:知識通常是真實的,但也有例外(飛機會飛,但我們認識到,一架特定的飛機可能會被停飛),甚至不必在統計上準確地反映病例(蚊子攜帶瘧疾是重要的知識,但只有一小部分蚊子實際攜帶瘧疾)。只能獲取規則而不能獲取例外的系統(例如Evans和Grefenstette(Evans和Grefenstette,2017))是構建能夠獲取抽象知識但還不夠的系統的一個有趣步驟。 ?一個健壯的系統可能是因果關系,并支持反事實的知識的一個重要部分。例如,封閉的人并不知道國家有首都,他們知道這些首都在政治上是由人民的行動決定的,而且這些決定有時會被改變。奧爾巴尼是紐約州目前的首府,但如果首府(事實上)被燒毀,我們認識到該州可能會選擇一個新的首府。孩子們知道,當玻璃瓶落在堅硬的地板上時,那些瓶子可能會碎。

?盡管在網上搜集諸如首都和出生地等事實知識相對容易,但我們掌握的許多抽象知識很難通過網絡搜集;例如,很少有人會寫關于破碎瓶子及其內容的文章。大多數情況下,正如列納特曾經指出的,作家不會寫下常識,因為他們的讀者已經知道了。(盲目拉網也有其他問題;例如,歷史偏見,比如醫生是男性,往往會被天真的拉網系統自動延續下去。)

?相關知識的范圍必須非常廣泛。例如,理解一部小說可能需要技術、政治實體、金錢、天氣、人際交往、禮儀、性、暴力、貪婪等方面的知識。例如,約翰·格里沙姆(johngrisham)的第一部暢銷小說《公司》(TheFirm)中的關鍵情節轉折就建立在對影印機能做什么、能做多快的理解上,與對人類動機和時間推理的深刻理解并列。

?很難將知識付諸實踐。擁有一個龐大的知識數據庫是一回事,其中包括有關復印機及其運行速度的事實,另一種方法是將這些知識(在大量其他不太相關的信息庫中)整合到關鍵任務的時間推理中,即英雄律師在陷入秘密但高尚的信息收集行為之前所處的狹窄時間窗口。以一種有效的方式將抽象的知識與現實世界中的具體情況聯系起來,本質上是一個尚未解決的問題。

??人類知識的一些小而重要的子集可能是天生的;健壯的人工智能也應該從一些重要的先驗知識開始。在當代的ML中,人們常常強烈地希望將知識和天賦最小化;正如下面第2.2.3節所討論的,我認為這是一個錯誤。

2.2.2案例研究:容器

讓我們更詳細地考慮一個案例研究-一個事實(在通常情況下),帶蓋的茶壺中的水只能從壺嘴出來。

正如讀者現在所期望的那樣,GPT-2有時會做到這一點。

原則上,我們也許可以通過眾包獲得這一特定事實,但由于人們很少陳述如此明顯的事實,而且更不經常精確地陳述,我們不應該指望它。盡管我們可能需要在我們的數據庫中有這樣一個事實,例如,如果我們正在構建人工智能來支持一個仿人的老年人機器人的決策,我們可能不會提前預料到這種需要。

如果我們能從更一般的知識中得出這樣的事實就更好了,例如,如果我們遇到一個外表陌生的茶壺,我們就會知道它是什么,以及如何與它互動。

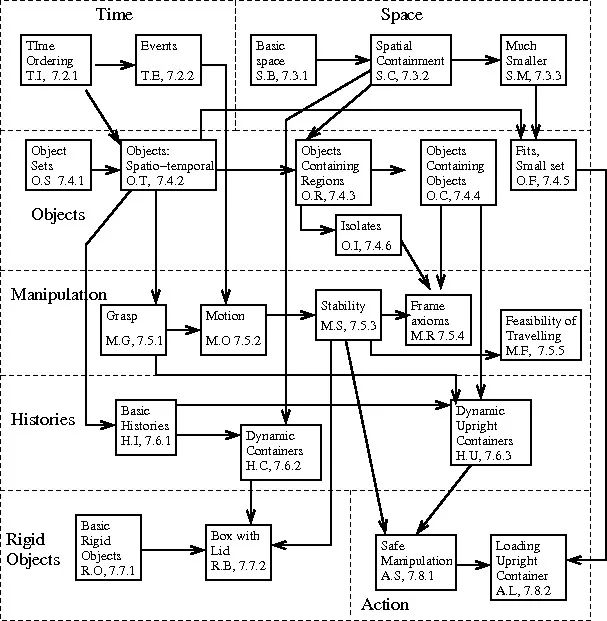

Ernest Davis、NoahFrazier Logue和我提出了一個框架(Davis、Marcus和Frazier Logue,2017),可以幫助解決這類挑戰:一大套獨立動機的邏輯公理,這些公理不是茶壺特有的,都是通用的,主要由大多數普通人在思考后認識到的抽象組成是真的,從中可以對容器做出正確的推斷。

總的來說,公理所處的框架是相當普遍的:關于時間、空間、操縱、歷史、行動等的公理。這些公理包括如下陳述(這里有一些稍微簡化的解釋):

?物理世界由一系列物體組成,這些物體在時間和空間上移動。

?對象是不同的;也就是說,一個對象不能是另一個對象的一部分,也不能在空間上與另一個對象重疊。

?物體占據某個三維范圍的區域;它不能是一維的曲線或二維曲面。

?特定數量的液體可以占據特定體積的任何區域。

?封閉容器是完全包裹內腔的一個物體或一組物體。

?直立開口容器是頂部開口的開口容器。

配備了此類知識的探索性機器人(以及將知識與感知模型和認知模型聯系起來的其他機械)也許可以推斷出帶有幾乎隱藏的壺嘴的形狀異常的水壺的使用和功能:

經過一定的擴展,這樣一個系統可以提供一個系統的基礎,這個系統可以推理出送紗器的用途,即使人們以前從未見過送紗器;最終,人們希望,這些基礎可以作為機器人系統的一個組成部分,可以在一個動作過程中應用這些知識,比如編織。

并推斷出新的供料器(或與用戶進行交流),甚至是完全不同的供料器:

這種情況在目前的神經網絡方法中并沒有自然地表現出來。首先,這樣做可能需要一個對象的先驗概念,而這個對象本身在大多數當前的神經網絡中并不容易表示。然而,這些知識需要成為健壯的人工智能的核心部分,我們必須擁有獲取這些知識的策略和能夠獲取、表示和操作這些知識的體系結構——其中一些在本質上似乎是象征性的。

原則上,也許我們提出的公理中有一小部分是天生的,其他人是學來的,盡管到目前為止我還不知道有哪個系統能夠學習這類公理。(這里再次強調,具有嵌入式知識的神經符號系統可能會有所幫助。)

重要的是,這組框架本身會聚集到一組相當容易識別的域中,例如關于空間、時間和因果關系的知識,如這里所示:

容器知識框架,摘自(Davis et al。,2017)

2.2.3固有的知識框架

把我們帶到本土主義。雖然沒有人可能認為所有的抽象知識都是與生俱來的,但其中一些可能是與生俱來的,而讓某些知識與生俱來的論點最終非常簡單:你一開始知道的越多,其他知識就越容易學習;如果你能縮小自己的范圍,你就可以限制你試圖尋找的假設空間尋找。

LeCun關于卷積的開創性工作(LeCun,1989)事實上是對這一點的一個有力的實證證明,表明在數字識別任務中學習,在一個預連線的層次結構配備了平移不變特征檢測器(使用卷積)的系統中,準確度更好,相對于一個更簡單的體系結構來說。唯一的先天優勢,卷積,已經被證明是非常有價值的。

然而(許多,并非所有)機器學習研究者反對在他們的系統中加入更多的固有約束,畫出一條看似任意的線,這樣網絡參數(有多少層,損失函數是什么,使用什么輸入節點編碼方案等等)對于先天性來說是公平的游戲,但大多數其他事情通常是公平的預計將被學習(馬庫斯,2020年)。有些人甚至認為這是一個值得驕傲的地方;正如一位研究人員在一封電子郵件中告訴我的那樣,“如果你主要對理解‘學習’感興趣,那自然會導致你貶低‘手工編碼’。”

我在2019年12月與Yoshua Bengio的辯論同樣具有啟發性。他說,預先指定卷積是可以接受的,因為它只需要“三行代碼”,但擔心將先驗知識(先天/先驗知識的位)的集合遠遠擴展到卷積之外,特別是如果這些先驗知識需要指定多于幾位的信息

正如我在那里向他表達的那樣,我不會太擔心那些零碎的東西。超過90%的基因組在大腦發育過程中表達(Miller et al.,2014;Bakkenet al.,2016),其中相當數量的基因在特定區域選擇性表達,從而產生詳細的初始結構。有許多機制可以通過使用少量的基因來指定復雜的結構;本質上,基因組是以半自主的方式構建結構的壓縮方式(Marcus,2004);沒有理由認為生物大腦僅限于幾個“小”先驗。凱文·米切爾最近在辯論后的一次跟進中很好地總結了形勢。

的確,基因組中沒有足夠的信息來說明神經發育的確切結果,即大腦中每個神經元的數量、位置和連通性。基因組只編碼一組無意識的生化規則,當這些規則在發育中的胚胎的動態自組織系統中發揮作用時,會導致在自然選擇定義的操作參數范圍內的結果。但這些操作參數有很大的空間,包括我們認為是先天的各種因素。在許多物種中有大量證據表明,根據基因組中的指令,許多不同的先天前驅確實預先連接到神經系統中。

如果基因組有足夠的先天先兆的空間,那么現代人工智能系統可能還有更大的空間;我們生活在一個計算機內存以千兆字節和兆字節來衡量的時代,而不是以字節或千字節來衡量的時代。對于人工智能來說,真正的問題不應該是,我們的先驗知識庫有多小?但是什么樣的先驗知識能最有效地為學習創造條件呢?就其本身而言,最小化比特數并不是目標。

§

如果有三個關于先天性的建議反復出現,它們就是時間、空間和因果關系的框架。

例如,康德強調從時間、空間和因果關系的“流形”開始的價值。斯皮爾克長期以來一直認為,一些基本的,核心的知識,對象,集合和地點可能是先決條件,以獲得其他知識。正如她所說(斯佩爾克,1994年),

如果兒童天生具有感知物體、人、場景和地點的能力,那么他們可能會利用自己的感知經驗來了解這些實體的屬性和行為……然而,如果他們不能在他們的環境中挑出那些實體。兒童如何才能了解某個領域中的實體,這還很不清楚.

戴維斯和我在我們對容器的分析(見上圖(Davis等人,2017))和我們最近的書(Marcus&Davis,2019)中都同樣強調了先前的空間,時間和因果關系框架的價值。 ; 多年來,許多其他發展心理學家也指出了類似的方向(Landau,Gleitman和Landau,2009;Carey,2009;Leslie,1982;Mandler,1992)。

正如斯佩爾克(Spelke)和康德(Kant)都強調的那樣,一旦您了解了物體及其在時間中的傳播方式,就可以了。您可以開始填寫其屬性,并開始獲得環游世界所需的知識。

殘酷的事實是,相反的方法(從近乎空白的板塊開始,然后在海量數據集上對其進行訓練)到目前為止還沒有成功(Marcus 2020)。一些大型公司(例如Google,Facebook,Microsoft等)對由大數據集訓練的相對空白的模型進行了全面的測試,并提供了幾乎無限的時間,金錢,計算人員和研究人員,但他們仍然無法可靠地推理出時間,空間或因果關系。如果沒有這樣的能力,我們的系統將永遠不會足夠強大以應付現實世界的變化。

肯定是時候考慮一種更自然的方法了。

§

好消息是,盡管在深度學習社區中人們常常不贊成本土主義,但從歷史上看,越來越多的跡象表明對``先驗者\\\\\\'\\\\\\'更加開放(例如Burgess等人,2019年; Rabinowitz等人,2018年) ; Maier等人,2017)。

當然,每個神經網絡實際上都是先驗的,其形式是先天(即預先建立,而不是通過相關系統學習)對特定層數,特定學習規則,特定連通性模式,特定表示方案的承諾(例如輸入和輸出節點代表什么),等等。但是,這些先驗本質上很少是概念性的。

真正的問題可能是關于可以代表什么樣的先驗,以及我們所需要的先驗是否可以自然地用我們已經擁有的工具來代表,或者我們是否需要新的工具來代表更廣泛的先驗。深度學習社區似乎可以將卷積(自然適合神經網絡框架)用作先驗,但是到目前為止,該社區對具有更復雜先驗的模型的關注程度大大降低,例如關于對事物永恒性的先天認知【參見Marcus(2001),第5章中有關為什么估計對象的軌跡本身不足以進行討論的討論】,或用于理解隨時間變化的事件的時間演算。

我們應該問的不是我能去掉的的最起碼的內在結構是什么?而是我需要什么樣的先驗呢?以及我現有的體系結構能否有效地將它們合并?我們是否可以建立一個更豐富的具有深層學習基礎的內在基礎,或者在這個框架中可以方便地內在地表達的東西是否有限制?我們是否需要顯式的符號操縱機制來表示其他類型的抽象,比如因果抽象?事實證明,深度學習擅長表達關于物體外觀的知識,但不太擅長獲取和表達關于物理世界如何運作的知識(Zhang,Wu,Zhang,Freeman&Tenenbaum,2016),關于人類如何相互作用,以及更普遍的因果關系。

其他方法,如概率規劃,允許顯式表示的符號約束,同時努力學習微妙的統計信息,值得認真考慮。

§

退一步說,人類對世界的絕大多數了解都是從中學到的:

事實上,船只傾向于漂浮而不是沉沒

事實上,如果船只在水線以下形成洞,它們確實會下沉。

打火機比棉球更適合點火

破碎的瓶子會泄漏

一次又一次,幾乎沒完沒了。無論我們擁有什么樣的核心知識,都必須有大量的知識來補充。

認為普通人可能知道(或立即承認是真的)數百萬或數千萬這樣的事實并非沒有道理;其中絕大多數必須通過經驗、明確的指示或其他方式來學習。重要的是,幾乎所有這些知識都可以付諸實踐,指導行動和決策(例如,如果我們發現船在水線以下有一個洞,我們會選擇不上船)。

但重要的是,我們所學到的知識中有相當一部分是因果性和抽象性的,根據上一節的討論,這可能需要使用某種混合體系結構。

同時,純粹的預先連線永遠不夠,因為世界本身在不斷變化;例如,總會有新的因果原理與新的技術聯系在一起。如果有人介紹一個流行的新玩意兒叫花花公子,我們很快就會知道虛擬機是做什么的,如何打開和關閉它,以及如何讓它做自己的事情。正如Gopnik和Sobel(Gopnik和Sobel,2000)優雅地展示的那樣,孩子們很自然地做到了這一點;我們需要能夠做到這一點的機器。

但是我們可能不能也不應該僅僅從經驗中學習我們所有的抽象和因果知識。當這么多的知識已經被編成法典的時候,這樣做將是極其低效的;例如,為什么要讓每個系統重新認識到,即使物體被遮擋,它們仍然存在于空間和時間中,而這是一個普遍的真理?此外,正如我們所看到的,例如在GPT-2的討論中,從無到有的學習到目前為止是不可靠的。如果沒有一些先驗知識,例如生理和心理推理的基礎知識,我們可以稱之為常識的東西幾乎都學不好。我們需要一些核心知識來指導剩下的學習。

妥協和創新的必要性再次顯現出來。我們顯然需要能夠獲得新的因果知識的系統(可能是神經符號的雜種),但為了獲得這種知識,我們可能需要比我們迄今使用的更強大的先驗知識。

因此,我的第三個主要主張是:我們不應該把每一個新的人工智能系統從零開始,當作一張白板,對世界知之甚少,而應該尋求建立從時間、空間和因果關系等領域的初始框架開始的學習系統,以加快學習速度并大量限制假設空間。

無論這些框架是用形式邏輯(la-Cyc)表示還是用其他方法表示,也許還沒有發明出來,我強烈懷疑它們是朝著健壯智能方向取得任何重大進展的先決條件。再多的天賦也不能代替學習,但不專注的學習是不夠的。這個游戲的名字是找到一組先天的先驗知識,無論是小的還是大的,這將最有利于學習我們系統最終需要的巨大知識庫。

盡管如此,光靠知識是不夠的。這些知識必須用推理工具付諸實踐,在認知模型的背景下,我接下來要談到的兩個主題。

2.3.推理

在一個著名的軼事,可能更好地在復述,但顯然是基于一個核心的真相,傳奇演員勞倫斯奧利弗是在現場與年輕的達斯汀霍夫曼,誰放棄了一些睡眠,以使他的角色可能會出現疲憊不堪。奧利弗對霍夫曼說:“親愛的孩子,你看起來真糟糕。你為什么不試著演戲呢?這樣容易多了。”

我對記憶和推理的看法是一樣的。目前的人工智能方法主要是試圖通過記憶(或至少是近似地記憶)整個世界的概率密度函數來應對世界的復雜性,代價是無法滿足地需要越來越多的數據。考慮到世界的指數級復雜性,這一策略不太可能奏效。

推理提供了另一種選擇;你不需要記住所有的東西,也不需要在你以前可能遇到的近鄰之間進行插值,而是進行推理。你沒有記住柏拉圖、亞里士多德、歐里庇得斯和我們前面的其他數十億人都是凡人的事實,而是學到了一個普遍的真理,所有的人都是凡人,并根據需要將這個普遍的真理應用到這個范疇的具體實例中。

正如我們所看到的,神經網絡,如Transformers(至少像目前通常使用的那樣,在端到端的方式中,與符號操作工具隔離)太不可靠,不適合合理的推理。它們可能在某些時候起作用,但不太可靠;只要有足夠的知識可用,符號操縱至少提供了朝著正確方向前進的希望。

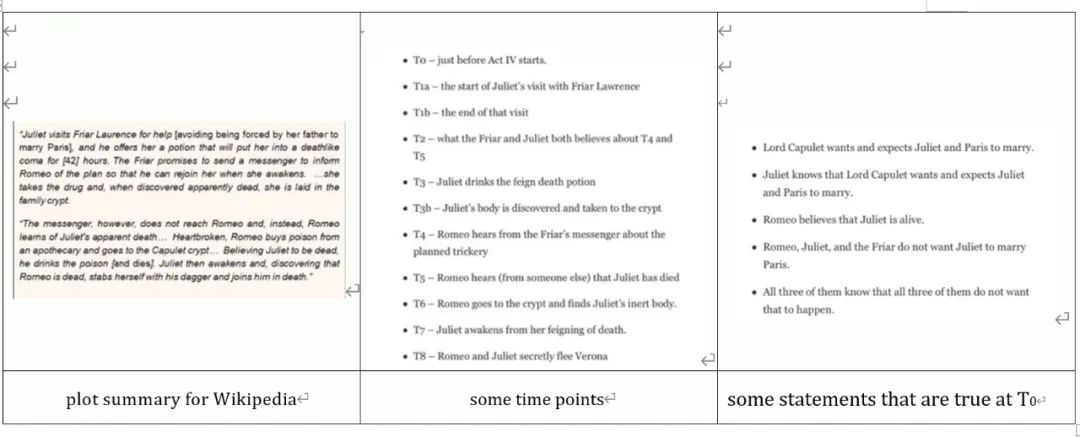

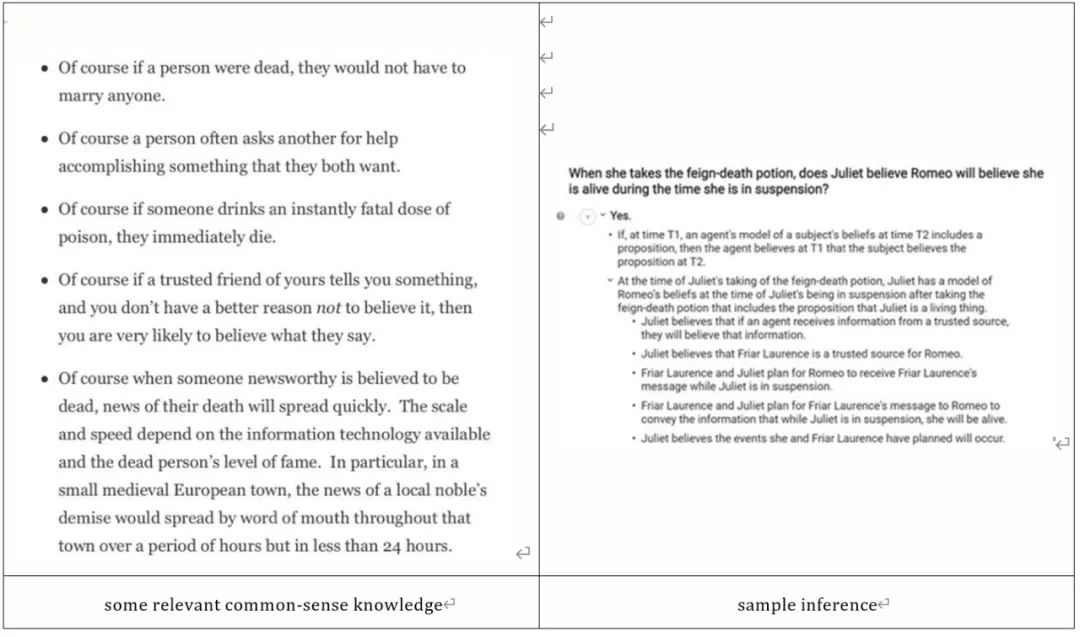

在經典模型中,推理引擎的最佳例子是CYC(相當于一個符號系統)能夠在最佳情況下執行的那種推理。舉個例子,CYC的創始人Doug Lenat(Lenat,2019,#3132},re Romeoand Juliet)最近的一次討論,在這里用兩個圖抽象出來,提供了故事的概要,一些與故事相關的知識,一些常識知識,以及CYC推理的一個例子(復雜推理者和大規模知識的結合)在最佳情況下可以得出

圖2羅密歐與朱麗葉,以及一些與故事相關的知識樣本,例如故事中的特定時刻和特定時間點的知識;摘自Lenat 2019。正如后面所討論的,中間和右邊的面板反映了CYC對情節的認知模式的一部分。

圖3相關常識知識樣本,以及CYC得出的復雜推論;Lenat 2019

上圖中間和右面板的詳細程度——列出了時間點和在這些時間點上保持正確的陳述——是我將稱之為豐富認知模型的一個例子。它是一個認知模型,因為它是一個復雜場景的內在升華,它的豐富之處在于它充滿了關于特定主人公在特定時間點做什么、知道什么、打算什么和期望什么的微妙信息。

同樣地,我們可以認為下圖左半部分所示的常識知識相當豐富,因為它所編碼的行為、后果和人類互動的信息錯綜復雜。其中一些知識可能被明確地表示出來(例如,飲用某種毒物的后果可能是立即死亡),一些可以想象的知識可能是從更一般的事實在網上衍生出來的。(例如,“如果一個人死了,他們就不必和任何人結婚”可能是從一個更普遍的觀察中得出的,即義務往往只適用于活著的人。)無論哪種方式,擁有如此廣泛的知識儲備的回報來自于可以得出的推論的復雜程度(下圖右側),以及在他們的可解釋性水平上,這兩者與迄今為止通過深度學習產生的任何東西都處于完全不同的水平。

一些觀察結果:

?如果不廣泛使用結構化表示、變量操作和個人記錄,這種方法是不可能的。

?這是一個最好的概念證明,表明擁有豐富的認知模型和豐富的生物學、心理理論等知識的潛在價值。

?然而,它在很大程度上依賴于知識工程師手工完成的大量前期工作,這些工程師已將《羅密歐與朱麗葉》手工翻譯成形式邏輯;一個能夠在可比水平上自動生成此類表示和推理的系統將是一個重大突破。

?推理本身不一定是通往強大人工智能的瓶頸;真正的瓶頸可能在于在現實世界推理的上下文中獲得正確的信息。

當然,CYC遠非完美。世界上有太少的東西是以充分的預先包裝的形式提供給CYC的。CYC沒有太多的自然語言前端,也沒有遠見;要讓它變得合理,你需要把你的問題用邏輯的形式表示出來。由于很少有問題是以這種方式預先包裝的,因此直接的商業應用相對較少。但是,在一個將大規模抽象知識與以各種形式邏輯實現的高階推理相結合的系統中,精細推理是可能的,這是一個存在的證明。

即便是CYC的推理能力,無疑也有很大的提升空間。它的表示主要是(或者完全是)高階邏輯的東西;不清楚它能在多大程度上表示不確定性,以及對統計分布的推理,等等。正如伯特蘭·羅素曾經說過的,“人類所有的知識都是不確定的、不精確的和部分的”,現在還不清楚CYC能處理多少不確定性、不完整性和不精確性。【另一個問題是人類在推理中面臨的諸多限制,如確認偏差、動機推理、語境效應、連接謬誤等。在一個理想的世界里,我們會從人類做得好的事情中學到東西,但把這些異常現象拋在腦后。關于為什么人類可能進化出這種認知效率低下的討論,即使這種認知錯誤在功能上可能不是最優的,參見Marcus(Marcus,2008)】

有人懷疑,就像經典人工智能和神經人工智能中的許多其他東西一樣,它很可能是脆弱的,高度依賴于數據庫中的特定知識以及復雜場景映射到其內部邏輯的精確方式。

盡管如此,它——或者其他能夠做類似工作的東西,也許使用不同的方法——似乎是通往穩健推理的必經之路。一個不能理解羅密歐和朱麗葉的情節摘要的人工智能不太可能勝任現實世界的復雜性。一個人工智能,可以推理的動機交互人類作為復雜的事件,因為他們隨著時間的推移展開有戰斗的機會。

樂觀的可能性是,一旦混合架構(architecture)知識的先決條件得到更好的發展,推理可能會自行解決;悲觀的可能性是,我們可能需要在推理本身方面進行重大改進,至少在可伸縮性和處理不完整知識的能力方面是如此。在我們把前兩個房子——建筑學和知識表示——整理好之前,我們可能真的無法分辨。

但我們已經知道:由于世界的復雜性,我們需要這樣的東西。很明顯,我們需要新的基準來推動我們的系統進行羅密歐與朱麗葉場景所體現的那種復雜的推理。由于我們既不能預先對每一個場景進行編碼,也不希望總是在已知的場景之間進行插值,因此一個能夠有效地利用大規模背景知識的推理系統,即使在可用信息不完整的情況下,也是魯棒性的先決條件。

Minervini等人最近的研究(Minervini等人,2019年)給了我希望,一種神經符號混合的方法可以開辟新的領域。Besold等人(Besold、Garcez、Stenning、van der Torre和van Lambalgen,2017)提供了另一個起點。人們在努力這一事實給了我更多的希望;如果我們要前進,推理和知識需要成為一流的公民,看到人們在努力是件好事。

2.4認知模型

一種特殊的知識是隨著時間的推移積累起來的關于特定事務狀態的知識,例如我們在談話過程中可能了解到的關于一個朋友的信息,在閱讀新聞過程中了解到的關于一個國家的信息,或者在讀一本書時了解到的關于一群人的信息。在認知心理學中,我們稱這種累積表征為認知模型。你的認知模式可能和我的不同;你的可能更詳細,我的可能不太詳細,但我們都經常使用它們。但最起碼,認知模型可能包括一些實體的知識(例如,故事中的人物和他們擁有的物品),一些屬性的知識(例如,物品的大小和顏色,人物的目標等),以及關于時間和事件的信息(角色x在什么時候遇到角色y,以及x在時間t知道什么)。

CYC/羅密歐和朱麗葉插圖中的命題和時間標記,例如關于相信什么和什么時候相信的復雜事實的顯式表示,是豐富的認知模型在人工智能系統中可能編碼的一個例子。人們還可以想到Johnson Laird(Johnson Laird,1983)關于心理模型的工作。如果我告訴你有一個空書架,然后解釋說我把兩本書放在書架上,你就構建了一個包含兩本書的書架的內部表示。如果我告訴你我在書架上又加了一本書,你就更新你的表示,這樣你就有了一個包含三本書的書架的內部表示。理解事物在很大程度上就是推斷出它是什么的模型,并最終能夠推斷出它是如何運作的,以及接下來會發生什么。

這絕不是一個微不足道的過程。任何一個GOFAI研究者都可以描述,原則上,一個人如何手動構建(一些)復雜的認知模型,但在特定場合推斷正確的認知模型可能是一個復雜的過程,在給定的情況下,往往有一個以上的似是而非的答案,而且目前還不可能自動化。

CYC的例子羅密歐和朱麗葉是令人信服的,因為系統得出的推論是復雜和明智的,但令人失望的是,基本模型是手工編碼的,而不是從劇本中歸納出來的。這使得該系統可以很好地用于演示目的,但在現實世界中,為了讓認知模型為強大的人工智能鋪平道路,我們需要找到從數據流(如視頻或文本)中自動推斷它們的方法。

這是一個如此困難的問題(在下面討論的場景理解領域之外)大多數人轉而從事其他的工作,并在令人驚訝的程度上嘗試完全不使用認知模型。

例如,DeepMind的Atari游戲系統DQN幾乎完全缺乏明確的認知模型。當DQN學會玩突圍游戲時,它并沒有將單個棋盤的位置抽象成表示單個棋盤的位置和范圍的場景圖;也沒有直接表示劃槳的位置、球的速度或游戲的基本物理,也沒有任何抽象的實現彈跳的動力使游戲如此引人入勝。在強化學習語言中,系統是無模型的。【頭發分裂者(不知道怎么翻譯hair-splitters)可能會爭辯說,存在某種自我生成的內部模型,指出系統的內部狀態在某種程度上與經典認知狀態相關,而MuZero這樣的系統更是如此(Schrittwieser et al.,2019)。在我看來,這種系統轉移到新環境的能力有限(見正文)破壞了這類強有力的主張。】然而超人的成就已經實現了。(值得注意的是,在一些游戲中,如Pong,在已知的起始條件下是嚴格確定的,完全不看屏幕就可以成功地玩(Koul,Greydanus,Fern-arXiv預印本)附件十四:1811.12530, & 2018, ).

但是,像DQN這樣的系統的成功有什么教訓呢?在我看來,這個領域過于籠統了。在像Breakout這樣的封閉領域中,只要有足夠的數據(通常遠遠超過人類在類似情況下所需的數據),無模型強化學習通常效果非常好。但這并不意味著無模型強化學習是解決智力問題的一個好方法。

問題在于,無模型解在誘導它們的精確環境之外,泛化能力很差。Kansky等人(Kansky等人,2017年)通過修補Breakout以令人信服的方式展示了這一點;即使是將撥片向上移動幾個像素之類的微小變化也會導致性能大幅下降。人類通過內部認知模型進行工作,可以很快得到補償;無模型的深度強化學習系統往往無法做到這一點,相反,經常需要大量的再培訓,正是因為它們缺乏豐富的環境認知模型。

GPT-2(見Marcus,2019,2020)等電流互感器在語言理解方面的失敗范圍反映了類似的情況:預測總體趨勢之間的分歧(如短語mom\\\\\\'s house出現在單詞附近的可能性,以及語料庫GPT-2中的短語drop、off、pick、up和clothing)以及表達、更新和操縱認知模型的能力。當BERT和GPT-2未能跟蹤干洗將在何處時,這直接反映了GPT和BERT不能代表單個實體隨時間演化的特性。如果沒有認知模型,這樣的系統就會消失。

有時他們從統計學中得到好運,但是缺乏認知模型,他們沒有可靠的基礎來推理。

認知模型的缺乏對于任何希望使用Transformers作為下游推理系統輸入的人來說也是一個慘淡的消息。語言理解的全部本質是從語篇中導出認知模型;然后我們可以對我們導出的模型進行推理。Transformers,至少在他們目前的形式,只是沒有做到預測詞類是令人印象深刻的,但就其本身而言,預測并不等于理解。

§

正如我們在第4.3節中看到的羅密歐和朱麗葉的例子,CYC是非常好的,因為它可以(至少在一些非瑣碎的程度上)超過認知模型的推理(例如它的時間點列表和關于在不同時間點已知的人物和地點的事實,節選于圖2),與背景(常識知識)相關,但仍然存在著可悲的缺陷,因為它無法單獨推導出相關的認知模型。任何一個系統,如果能夠將自然語言維基百科的繪圖摘要(如圖2左面板中的一個)作為輸入,并自動導出自己的詳細認知模型(類似于CYC的程序員手工構建的模型),這樣下游的推理者就可以對其進行推理,這將是相對于傳統推理的一個重大進步當前AI。

不幸的是,很少有人致力于從描述隨時間發展的事件的文本(更不用說視頻)中推導出豐富的認知模型。Pasupat和Liang的一篇論文(Pasupat和Liang,2015)試圖將句子解析成可在表上運行的可編程查詢,但該系統并不試圖隨著時間積累模型。Facebook人工智能研究的一些論文,例如記憶網絡(Bordes,Usunier,Chopra,&Weston,2015)和循環實體網絡(Henaff,Weston,Szlam,Bordes,&LeCun,2016),可以將簡單的故事作為輸入并回答一些關于它們的基本問題。但是這些系統(a)需要大量的輸入,相對于他們回答的每個問題,(b)似乎范圍有限,很大程度上依賴于問答之間的語言重疊,(c)整合先前知識的能力非常有限。也許最重要的是,(d)他們沒有產生豐富的認知模型,可以傳遞給推理者作為他們的輸出。彼得·諾維格(Peter Norvig)關于故事理解的論文(Norvig,1986)試圖在一個經典的符號操縱框架中做類似的事情,就像沙克和阿貝爾森(Schank&Abelson,1977)的許多開創性工作一樣,但據我所知,故事理解不再是當前研究的活躍領域。這是一個被拋棄而不是解決的重要問題。(沙克和阿貝爾森,1977年)

據我所知,最活躍的文獻是關于場景理解的研究,其最終目的不僅是解釋視覺場景中存在的對象,而且還解釋對象之間的關系,例如,不僅僅是識別一個玻璃杯和一張桌子,而是注意到一個特定的玻璃杯在桌子上,在一個特定的房間里玻璃杯靠近桌子邊緣,由桌子支撐,依此類推。這已經超出了藝術的范疇【在我看來,目前的工作場景理解能力很差,部分原因是很多工作試圖將場景作為一個整體(“人做飯”)來識別,而不是根據一組個人(如人或物體)以及這些實體之間的關系來識別,部分原因是它的目的主要是在沒有推理的情況下進行,推理有時對于構建連貫的模型是必不可少的。因為可能性的數量是指數級的,適合于從有限的類別集合中對圖像進行分類的技術不太可能滿足需要;相反,推理本身必須(與對象分類一起)有助于從場景中歸納認知模型的過程。最近一個很有前途的概率生成模型GENESIS明確地建模了場景組件之間的依賴關系(Engelcke、Kosiorek、Jones和Posner,2019)。另見DeepMind的莫奈(Burgesset al.,2019)和梅林(Wayne et al.,2018)以及(Gregor et al.,2019)中的表達生成模型。e、 g.,inverse graphics papers by Vicarious(Kanskyet al.,2017;George et al.,2017)和Josh Tenenbaum的團隊(Mao et al.,2019;Veerapaneniet al.,2019)。】;最終,認知模型歸納需要更進一步;例如,我們還需要確定心理關系,這兩種關系都是在表面層面上的,例如,人1正在與人2交談,最終達到一個更復雜的水平(例如,人1與人2交談以欺騙人2,這樣人2就會給人1錢)。至少我們的一些符號必須以某種方式建立在我們的感知經驗中,如果我們要用符號來解釋場景,我們必須有從輸入中推斷符號(以及符號之間的結構化關系)的方法。建立適當的模型還需要能夠推斷時間邊界和時間關系的系統,等等。

場景理解只是一個更大問題的一個例子;每次我們理解一個故事或閱讀一篇文章時,我們都需要做同樣的事情,在這種情況下,是從文字而不是直接的視覺體驗。

在我們第一次對強大智能的探索中,我們不能期望制造出能理解莎士比亞的機器,但我們可以追求比我們所擁有的多得多的東西。我5.5歲和7歲的孩子可能不會自發地理解莎士比亞,但他們所擁有的智力在很大程度上是強大的;他們了解很多關于日常事物的物理相互作用的知識,以及足夠了解人類的目標和動機,以理解大量的兒童書籍;已經,早在小學階段,他們就掌握了欺騙、誤解和動機等概念,這些概念在《羅密歐與朱麗葉》的故事中非常關鍵。他們可以在各種各樣的操場上攀爬和機動,還可以談論各種各樣的話題。

最終,推理和認知模型可以以幾乎無限的方式結合起來。例如,假設在中午12點,一個孩子被單獨留在一個房間里,房間里有一個裝有餅干的封閉餅干罐。中午12:05,人們注意到罐子是關著的,但餅干卻不見蹤影。其間發生了什么?結合時間和空間推理,你可以很容易地推斷出(a)孩子打開了罐子(b)孩子拿走了餅干,(c)孩子吃了餅干,(d)孩子關上了罐子。對于加分,你可以推斷(b)一定發生在(c)和(d)之前,但是(c)和(d)的順序是未知的。結合生物學理論,你可以把孩子理解為一個容器,并意識到餅干現在被包含(部分消化)在里面,已經從一個開口(一張嘴)進入另一個容器(胃)。沒有任何理由認為,如果沒有內部的認知模型和推理機制,人工智能將能夠有力地做出這種推論。沒有這一點,就不可能可靠地理解一個偵探小說,一個超越閑聊的對話,或者幾乎任何人類互動的敘述。

我有兩個猜想

?如果沒有混合體系結構、豐富的先驗知識和復雜的推理技術,我們就無法以適當、自動化的方式構建豐富的認知模型。舉一個例子,如果我們看到水體中的漣漪隱約讓人想起汽車,在一般情況下,我們應該假設這些漣漪只是漣漪,例如,基于汽車不會漂浮的知識。但我們可能會在黑幫電影的背景下改變我們的前科,在這部電影中,汽車可能會被故意推入水中。場景理解最終不僅僅是標記對象,而是使用最好的可用數據進行連貫的解釋,這需要對數據進行一定程度的推理,并結合先驗知識。任何單純依靠標記圖像的自下而上方法都可能在各種異常情況下失敗,正如我們迄今所看到的,即使是在地圖清晰的公共道路上進行自主駕駛的狹窄領域,盡管付出了巨大的努力和數十億美元的投資。

?如果沒有歸納和表現豐富認知模型的能力,我們就無法獲得強健的智力。例如,閱讀在某種程度上可以被認為是一種以句子為輸入,以產生為輸出(內部)認知模式的功能。當我們發現羅密歐自殺時,基于對事實的誤解,我們更新了我們的模型。一旦我們更新了我們的模型,我們就會對它們進行推理(考慮到朱麗葉的明顯死亡,羅密歐會自殺有意義嗎?)。我們的情緒反應也來自于我們對所發生事情的內部認知模式的相對判斷。(角色剛才表演的動作是否合乎道德?安全嗎?愚蠢?悲劇?)。純粹的共現統計并沒有可靠地得出這一點。Cyc有能力表示豐富的認知模型,但由于它沒有感知成分,缺乏足夠的自然語言前端,因此不能從數據中歸納模型。Transformers,如果他們成功了,就跳過了歸納和表現豐富認知模型的步驟,但這樣做是有風險的,因為他們能夠做的推理因此是相當有限的。同樣,家用機器人最終也會被限制在他們能夠安全參與的行動范圍內,因為他們能夠通過豐富的認知模型進行歸納、表示和推理。

§

單靠更多的數據可能無法解決這個問題。在我編輯這篇手稿的時候,谷歌發布了Meena(Adiwardana et al.,2020),在341GB的海量語料庫上進行訓練,幾乎是GPT-2訓練的10倍,相當于大約341000本書,遠遠超過大多數人一輩子的閱讀量。

根據谷歌的博客“走向一個可以談論……任何事情的對話代理”,Meena“可以進行比現有最先進的聊天機器人更明智和具體的對話。”像GPT-2一樣,Meena創作的散文既非常流暢,也非常有主題性。它最好的對話是驚人的,該報報道說,它設置了一個新的藝術狀態,在新的衡量標準“感性和特異性”。但同樣的核心基礎——世界內部認知模式仍然缺失。

考慮一下這個片段

你最喜歡的樂隊是什么?Avengedsevenfold。

人類:哦,這是個好答案!你最不喜歡哪個樂隊?Avengedsevenfold。

哦,我以為你喜歡Avengedsevenfold?米娜:是的。那是我最喜歡的樂隊。

每個答案都是連貫的,但從一個答案到下一個答案卻沒有連貫性。Meena抓住了這樣一個事實,即某些短語,如樂隊名稱,往往與短語,如“最喜愛的樂隊”;但沒有持久的記錄,Meena的喜好,即使是一個簡短的對話長度,因此完全不一致。

在第77次對話中也可以看到大致相同的情況。Meena在自稱“學習”廣東話和已經母語流利的廣東話之間搖擺不定:

人類:你的新年決心是什么?米娜:減掉60磅學廣東話學法語人類:你不覺得,那很牽強嗎?

米娜:不是真的。我現在瘦了35磅,我已經能說廣東話到一個基本的水平,而且我已經在學校學法語了。

人類:哇!真令人印象深刻!

米娜:我在一邊學法語,這對我來說真的很容易,因為我的母語是粵語。

沒有認識到你不能學習一門你已經知道的語言(缺少背景知識),也沒有內在的模式來判斷米娜是否會說廣東話。一句一句的預測很突出;總體上是不連貫的。

§

當我在修改這篇論文的初稿時,我開始用“貓在墊子上”這句話起草一個圖表。我的計劃是展示如何解釋這個句子,從語法到語義,再到可更新的認知模型,跟蹤實體(如貓和墊子)及其屬性和彼此之間的關系;目標是展示GPT-2是如何試圖縮短這條路徑,從而得到混合的結果。

我還沒來得及畫完這幅圖,我5.5歲和7歲的孩子們就從我身后望過去,咯咯地笑著大聲念著“貓在墊子上”這句話。我轉向年長的那個,問他:“你能把一頭大象放在墊子上嗎?”他回答說,這要看情況;如果這是一個真正的大墊子,你可以,如果這是一個小墊子,你不能。他立即形成了一個虛構的世界和實體的模型,填充了這個世界,并應用他的一般常識知識的理論世界,完全沒有標簽的例子。

當他離開房間時,我問了他妹妹,我5.5歲的女兒。她很好地理解了前面的談話,并對我的問題給出了一個同樣恰當的答案。當我問她一座房子是否能放在墊子上時,她證明了自己同樣擅長構建一個模型,并對其未指明的參數進行推理,從而得出合理的結論。

我們不可能建立可靠、健壯的人工智能系統,因為這些系統無法與小孩子通常做的基本推理和模型構建相匹配。等待認知模型和推理從越來越大的訓練語料庫中神奇地出現,就像等待奇跡。

底線是:目前針對建立認知模型系統的研究太少。強調端到端的學習和大量的訓練集已經從核心的更高層次的認知轉移。大多數研究人員甚至沒有試圖構建圍繞認知模型的系統,而且(除了在像自動駕駛這樣的狹隘領域之外)越來越少的研究人員專注于發現相對于輸入流(如文本或視頻)導出和更新認知模型的一般方法這一相關挑戰。很少有人把重點放在結合先前的常識來推理這些模型上,例如大象相對于貓的大小,以及這與各種大小的墊子的關系。

在我看來,構建能夠將語言和感知輸入映射到豐富的、不斷發展的認知模型的系統應該是該領域最優先考慮的問題之一。

換言之,更緊迫的是,花在改進大規模單詞級預測模型上的每一刻,即lagpt-2和Meena,都是一個可以更好地用于開發派生、更新和推理認知模型的技術的時機。

如果我們想建立健壯的人工智能,我們就不能再等了。

3.討論

3.1.一種圍繞著持久的抽象知識的智慧

沒有我們,或者像我們這樣的生物,世界將繼續存在,但它將無法被描述、提煉或理解。鳥可以拍打翅膀,也可以帶著它飛行。有關聯,但沒有因果關系的描述。人類生活充滿了抽象和因果描述。我們的孩子大部分時間都在問為什么;科學家問這樣的問題是為了產生理論。我們的力量很大一部分來自于我們以科學、文化和技術的形式理解和描述世界的努力。

大部分的努力都以知識的形式達到高潮,有些是具體的,有些是一般的,有些是口頭的,有些不是。經典人工智能的很大一部分目標是以機器可解釋的形式提取這些知識;CYC是這方面最大的項目。

一路上的某個地方,人工智能領域走了一個不同的方向。大多數研究人員,如果他們了解CYC的話,會認為這是一個失敗,而目前很少有研究人員會將他們的目標描述為積累知識,就像Lenat所描述的那樣。【也許Google知識圖(Google Knowledge Graph)最接近,但據我所知,知識圖的目標是積累有助于消除搜索查詢歧義的具體事實,比如法國有一個叫巴黎的城市,而不是抽象的常識。】

像Transformers這樣的系統的部分成功導致了一種虛幻的感覺,即CYC規模的機器可解釋的人類知識表示是不必要的,但我認為這是一個錯誤。然而,正如我們所看到的,盡管Transformers作為統計推斷引擎給人留下了深刻的印象,但它們離成為強大智能的堅實基礎還有很長的路要走。他們不可靠,他們的知識參差不齊。

他們的推理能力很差,而且隨著時間的推移,他們無法建立事件的認知模型;沒有明顯的方法將它們與更復雜的推理和認知模型建立系統聯系起來,也沒有辦法將它們用作可解釋、可調試的智能的框架。

這篇論文的重擔是主張研究重點的轉變,轉向構建健壯人工智能的四個認知前提:混合架構,將大規模學習與符號操作的表征和計算能力相結合,大規模知識庫可能利用固有的框架,這些框架將符號知識與其他形式的知識結合起來,推理機制能夠以可處理的方式利用這些知識庫,豐富的認知模型與這些機制和知識庫協同工作。

隨之而來的是對可能更加異構的體系結構的需求。到目前為止,許多機器學習都集中在相對同質的體系結構上,其中單個神經元的能力僅限于求和和和集成,通常不超過少數預先指定的模塊。正如最近的研究所表明的,這是一種過分簡單化的說法;在宏觀層面上,僅大腦皮層就有數百個解剖和可能的功能區域(Van Essen、Donahue、Dierker和Glasser,2016);在微觀層面上,如前所述,即使是單個神經元的單個樹突室也可以計算XOR的非線性(Gidon等人,2020)。Adam Marblestone、Tom Dean和我認為(Marcus et al.,2014),大腦皮層不太可能用一個標準電路來計算它的所有功能;神經計算中可能存在一個重要的多樣性,這在計算神經科學或人工智能中還沒有被捕捉到。

兩個數字以定性的方式反映了我認為我們近年來一直在做的事情,以及我們應該做的事情。這些數據的第一點也是最重要的一點很簡單:潛在的人工智能(和機器學習)模型的空間是巨大的,而且只有一小部分可能存在的東西被探索過。空白板巖經驗主義模型已經得到了很好的研究,并且得到了很好的資助,沉迷于人工智能早期難以想象的計算資源和數據庫;已經有了一些真正的進展,但如此多種形式的脆性仍然是一個嚴重的問題;是時候探索具有類似活力的其他方法了。

向前發展至少需要我們建立一個模型,原則上能夠代表和學習我們在語言和更高層次認知方面所需要的各種東西。

目前大多數系統甚至都不在正確的范圍內。至少,充分的知識框架要求我們能夠通過變量運算,以代數的方式表示和操作我們的知識的一部分;很可能這些知識的一些(大的)子集是按照結構化表示進行編碼和維護的,這些知識中的大部分必須與特定的個體有關,并允許對其進行追蹤。

Transformer體系結構有解決所有這些問題的方法,但如果不加以補充,最終不太可能成功;同時,我們絕對不能期望所有相關知識都是預先固定的。

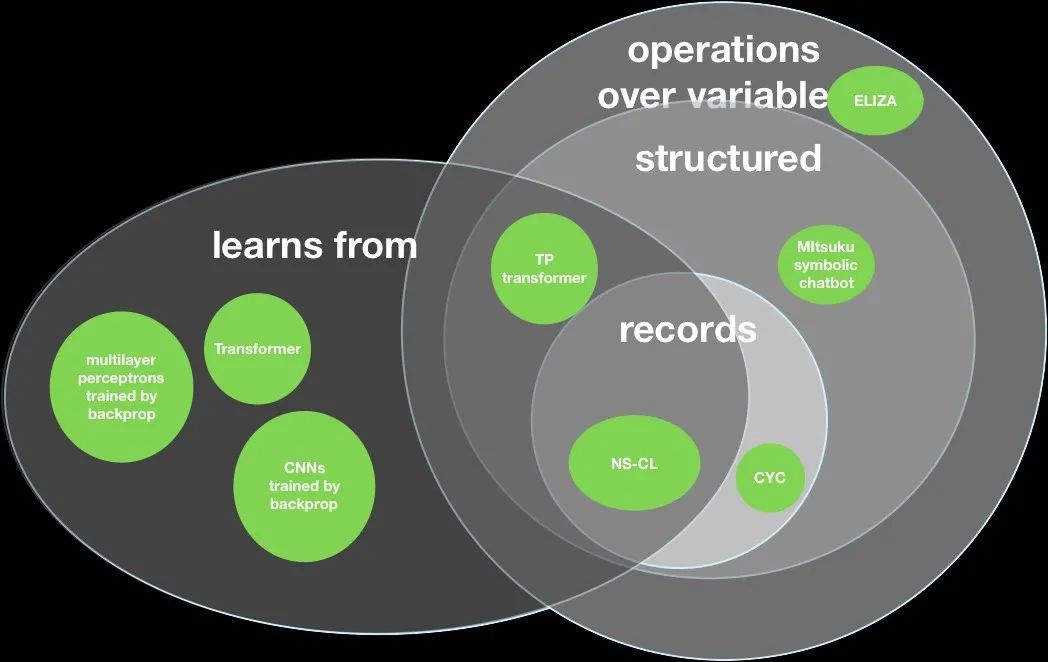

本文的有力預測是,健壯的人工智能必然存在于圖4所示的交叉點。

圖4:Venn圖在廣闊的智能模型空間中勾勒出了一些模型和架構,重點關注學習和符號操作的維度。代數思維的假設(馬庫斯,2001),以及目前猜想的核心是,成功的智力模型需要對變量、結構表征和個體記錄進行運算。NS-CL[第2.1.2節中提到的神經符號概念學習者(Mao et al 2019)]代表了許多此類可能的混合模型之一,其中許多尚待發明。本文認為,在新的十年里,這一交叉區域應該成為通用智能研究的中心。

同時,這個交叉點內可能模型的空間是巨大的,甚至可能是無限的;說正確的架構是有一個開始,但只是一個開始,就像說一個網絡瀏覽器可能應該用一種語言來編寫,那就是圖靈等價物。很好,很真實,而且。。。現在怎么辦?擁有一套合適的基本體只是一個開始。

這里有一種方法來思考這個問題:有無限多的可能的計算機程序,其中只有一些例示應用程序,如(例如)web瀏覽器或電子表格,并且只有一個子集表示健壯的web瀏覽器或電子表格。類似地,有無限多的系統包含結構化表示、個人記錄、對變量的操作,所有這些都在允許學習的框架內,但只有其中一些系統會實例化健壯的智能。如果本文的主旨是正確的,那么結合學習和符號操作的混合體系結構對于健壯的智能是必要的,但還不夠。

例如,還需要正確的宏觀結構,包括多個領域的豐富知識,如圖5所示:

圖5:Venn圖強調系統的需要,包括空間、物理、心理、時間和因果推理的機制。大多數當前的神經網絡缺乏明確的機制來進行這些形式的推理,也缺乏對這些領域進行表示和推理的自然方式(但參見Cranmer et al.,2019)

將這兩個數字的要點與當前的趨勢相比較。大多數(并非全部)深度學習的當前工作都回避了對變量、結構化表示和個人記錄的操作;同樣地,深度學習在很大程度上沒有大規模抽象知識、豐富的認知模型和明確的推理模塊。總的來說,關于合成認知的原語應該是什么的討論還不夠。深度學習在很大程度上取得了它所取得的成就,沒有了這種傳統的計算精確性,也沒有任何看起來像是物理推理、心理推理等明確模塊的東西。

但是,如果認為在諸如語音識別和對象標記等主要圍繞分類的領域中,效果相當好的東西,必然會可靠地用于語言理解和更高層次的推理,這是一種謬誤。可以肯定的是,一些語言基準已經被打破,但一些深刻的東西仍然缺失。當前的深度學習系統可以學習任意一點信息之間無盡的關聯,但仍然無法深入;它們無法代表世界的豐富性,甚至根本不了解外部世界的存在。

那不是我們想去的地方。

在重新啟動人工智能即將結束時,我和歐內斯特·戴維斯敦促

簡言之,我們實現常識和最終的一般智力的方法是:首先開發能夠代表人類知識核心框架的系統:時間、空間、因果關系、物理對象及其相互作用的基本知識、人類及其相互作用的基本知識。將這些嵌入到一個可以自由擴展到各種知識的體系結構中,始終牢記抽象性、組合性和個體跟蹤的中心原則。

開發強大的推理技術,能夠處理復雜的知識,

不確定,不完整,可以自上而下和自下而上自由工作。將這些與感知、操縱和語言聯系起來。用這些來建立豐富的世界認知模型。最后一個重點是:構建一種人類啟發的學習系統,使用人工智能擁有的所有知識和認知能力;將所學知識融入其先前的知識;像孩子一樣,貪婪地從各種可能的信息來源學習:與世界互動,與人互動,閱讀,看視頻,甚至被明確教導。把這些放在一起,你就可以得到深刻的理解。(馬庫斯和戴維斯,2019年)。

我們的結論是“這是一個很高的要求,但這是必須要做的。”即使在GPT-2這樣的Transformers在我們付印之后出現了戲劇性的增長,我認為沒有理由改變我們的要求。

Weconcluded "It’s a tall order, but it’s what has to be done."Even after the dramatic rise of Transformers such GPT-2,which came out after we went to press, Isee no reason to change ourorder.

3.2我們還能做些什么嗎?

很顯然,是的。

3.2.1工程實踐

首先,實現穩健性不僅僅是發展正確的認知前提,也是發展正確的工程實踐。戴維斯和我在第十章“重新啟動人工智能”中簡要討論了這一點,而湯姆·迪特里希在他的AAAI Presidential Address 演講(迪特里希,2017)中有一個非常好的討論,我在《重新啟動人工智能》問世后才發現這一點。Davis和我強調了冗余和指定公差等技術,這些技術長期以來一直適用于其他形式的工程。Dieterich提出了八條建議,非常值得一讀,比如構造對獎勵敏感的優化函數和直接構造檢測模型故障的機器;和我們一樣,他也強調了因果模型的必要性和冗余的價值。Joelle Pineau關于可復制性的觀點也很重要(Henderson et al.,2017)。

3.2.2.文化

還有一件事需要解決,既與認知前提有關,也與良好的工程實踐無關,那就是文化:某些東西與深度學習社區的某些元素嚴重不符,不利于進步。這是一個房間里的大象,必須承認和解決,如果我們要向前邁進。

尤其是外界的觀點,尤其是批評的觀點,往往被視為一種極端的侵略(雙方幾十年的敵對行動所導致的)【第二個文化問題,正如這篇手稿的一位讀者所指出的,是深度學習的倡導者經常過于看重大數據,常常假設(有時是錯誤的)復雜問題的答案基本上可以在越來越大的數據集和越來越大的計算集群中找到。整個領域,如語言學,在很大程度上都被忽視了。這不可能是好事。】,這種侵略不應在知識論述中占有一席之地,特別是在一個幾乎肯定需要成為跨學科的領域,如果要取得進展。

學生們并不是對這種動態視而不見,他們逐漸認識到,公開宣稱符號操縱是人工智能的一個組成部分,可能會對他們的職業生涯造成損害。例如,在我與Bengio辯論之后,一位來自著名深度學習實驗室的年輕研究人員私下給我寫信,說“其實我兩年來一直想寫一些……關于符號人工智能的東西,每次都不想寫,因為擔心它會對我未來的職業道路產生這樣或那樣的影響。”

這是一種適得其反的狀態。正如辛頓本人曾經說過的那樣,“馬克斯·普朗克說過,‘科學跨過此次葬禮而前進。’未來取決于某個對我所說的一切深表懷疑的研究生。”進步往往取決于學生認識到長輩理論的局限性;如果學生不敢說話,那就是一個嚴重的問題。

3.3.一點一點地看清整個大象(事物)

好消息是,如果我們能夠開始共同努力,進展可能并不遙遠。如果健壯智能的問題已經解決了,就完全沒有必要寫這篇文章了。但是,也許,只是也許已經足夠了,如果我們瞇著眼睛,看看周圍的碎片,如果我們把它們放在一起的話,我們也許能夠想象大象的樣子。

一些想法:

?深度學習向我們展示了從海量數據中可以學到多少。同現統計等可能只是可靠知識的影子,但確實有很多影子,只要我們敏銳地意識到它們的優點和局限性,也許我們可以利用這些影子,使用更復雜的技術。

?在豐富的知識基礎和豐富的認知模型存在的情況下,CYC顯示了復雜推理的潛在能力,即使它本身不能直接從語言或知覺輸入中推導出這些模型。

?像NS-CL(Mao等人,2019年)這樣的系統向我們表明,符號操縱和深度學習至少在原則上可以整合成一個無縫的整體,既能感知又能推理。

這樣的例子太多了。如果我們能夠打破僵局,停止60年來阻礙進展的敵對行動,轉而集中精力,努力在這些世界之間架起橋梁,前景就是好的。稍微混合一些比喻,也許避開下一個可能的人工智能冬天的最好方法可能是讓我們的帳篷不是在一根柱子上休息,而是在許多柱子上休息。

3.4結論、前景和影響

沒有什么要求我們放棄深度學習,也不放棄正在進行的專注于新硬件、學習規則、評估指標和培訓制度等主題的工作,但它促使我們從學習或多或少是唯一一等公民的觀點轉變為學習是更廣泛的聯盟的核心成員的觀點歡迎使用變量、先驗知識、推理和豐富的認知模型。

我提倡一個四步計劃:首先開發混合的神經-符號結構,然后構建豐富的、部分先天的認知框架和大規模知識數據庫,然后進一步開發對這些框架進行抽象推理的工具,最終開發出更為復雜的認知機制認知模型的表征與歸納。綜上所述,朝著這四個先決條件取得進展,可能會為比目前更豐富、更智能的系統提供基礎。最終,我認為這將重新定義我們所說的學習的含義,導致一種(也許是新的)學習形式,它通過抽象的、類似語言的概括,從數據中,相對于知識和認知模型,將推理作為學習過程的一部分。

如果我所描述的沒有一個是單獨的或者甚至是集體的,我相信,它至少足以讓我們更接近一個我們可以信任的人工智能框架。

把事情說得稍微不同一點:我呼吁的一種研究方法是,首先確定一組動機良好的初始原語(可能包括對變量的操作、注意機制等),然后學習如何在之后重新組合這些原語,考慮到這些原語,從本質上說,學習什么是良好的實踐。直到后來,一旦這些優秀軟件工程的原則被確定,我們才有可能進入極其復雜的現實世界能力。大多數機器學習工作基本上都試圖跳過開頭的步驟,以經驗的方式處理復雜的問題,而從未試圖建立一個關于語言和更高層次認知真正需要什么初始原語的堅定理解。跳過這些最初的步驟,到目前為止還沒有使我們獲得語言理解和可靠的、可信賴的、能夠應對意外情況的系統;現在是重新考慮的時候了。

在我看來,如果我們不改變方向,我們就不可能解決我們對人工智能最直接的擔憂。當前的范式長期依賴數據,但缺乏知識、推理和認知模型,根本無法讓我們獲得可以信任的人工智能(Marcus&Davis,2019)。無論我們想建造與我們一起生活在家中的通用機器人,還是在不可預知的地方駕駛我們四處走動的自動車輛,或是對罕見疾病和普通疾病同樣有效的醫療診斷系統,我們需要的系統不僅僅是挖掘大量數據集以獲得更微妙的關聯。為了做得更好,實現安全性和可靠性,我們需要對世界有豐富的因果理解的系統,這需要從更加注重如何用抽象的因果知識和詳細的內部認知模型來表示、獲取和推理開始。

§

羅馬不是一天建成的。孩子們有大量的常識,能夠推理,并學習復雜的知識,但他們仍然需要數年的時間才能擁有(大多數)成年人的成熟度、廣度和能力。他們已經開始獲得一些知識,具體的方面,在這里和現在,但仍然要學習,特別是有關微妙的領域,如政治,經濟,社會學,生物學和日常人際交往。

通過利用混合體系結構中的創新,弄清楚如何利用認知模型和大規模背景知識可靠地構建、表示和推理,如第2.1.2節所述,將是一個重要的步驟,并可能在未來十年中占據大部分時間,但不會是整個過程。

重要的是,這些關鍵認知前提的進步可能會使人工智能成為一個自給自足的學習者,就像一個聰明的學童一樣,但它們本身并不能保證產生一個完整的認知存在。也就是說,它們可能會導致自我教育的機器,在某些方面就像一個孩子,對世界有著不完全的了解,但卻有著獲取新思想的強大天賦。這當然只是一個開始,但它將使已經發生的事情看起來只是序幕,一些我們還不能完全預見的新事物。

4.致謝

為了紀念雅克·梅勒,1936-2020,科學家,《認知》雜志的創始人,跨學科認知科學的偉大倡導者,我們需要將人工智能提升到一個新的水平。

這篇文章的一部分是對我與Yoshua Bengio于2019年12月23日在加拿大蒙特利爾,由蒙特利爾AI的Vince Boucher組織的AI辯論的反思。我感謝約書亞和文斯使這成為可能我也感謝迪恩阿比奧拉,道格貝米斯,艾米莉本德,文斯鮑徹,厄尼戴維斯,湯姆迪特里奇,佩德羅多明戈斯,查茲費爾斯通,阿圖爾達維拉加塞茲,丹尼爾卡尼曼,卡蒂婭卡彭科,克里斯蒂安克斯汀,路易斯蘭姆,亞當馬布爾斯通,梅蘭妮米切爾,艾亞德納瓦爾,巴尼佩爾,Jean-Louis Villecroze和Brad Wyble,他們閱讀并評論了本手稿的早期草稿,Mohamed Amer和Dylan Bourgeous進行了有益的討論。最重要的是,要特別感謝厄尼戴維斯,我在人工智能這么多的共鳴板;這篇論文很大程度上歸功于我們的對話,和我們的聯合研究。

-

電路板

+關注

關注

140文章

4968瀏覽量

98211 -

人工智能

+關注

關注

1792文章

47425瀏覽量

238957 -

機器學習

+關注

關注

66文章

8425瀏覽量

132770

原文標題:下一代人工智能

文章出處:【微信號:CloudBrain-TT,微信公眾號:云腦智庫】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

相關推薦

中科創達發布智能體方案,重塑企業數智化新境界

微軟大手筆采購英偉達AI芯片

xMEMS XMC-2400 μCooling?芯片:開創性全硅微型氣冷散熱技術獲獎

韓國無晶圓廠初創公司Panmnesia展示第一個支持CXL的AI集群

谷歌計劃12月發布Gemini 2.0模型

英偉達AI芯片推遲出貨,股價跌破100美元

Kiwi Talks | 傳統以太網、UEC超以太網、超節點-Ethernet RDMA 打響進階賽

亞馬遜云科技與德勤聯合啟動人工智能與數據加速器計劃 目標直指下一代人工智能

西部數據發布AI數據周期框架,推動人工智能革新

西部數據發布全新人工智能數據周期存儲框架,助力用戶發掘人工智能價值

英特爾、AMD和高通競爭下一代人工智能電腦領導地位

一PCB行業企業擬取代臺灣對手供貨英偉達

SK海力士與臺積電合作構建AI芯片聯盟

韓國AI芯片創企Rebellions完成億級融資

扎克伯格的Meta斥資數十億美元購買35萬塊Nvidia H100 GPU

下一代人工智能

下一代人工智能

評論