是否擔心高頻率爬蟲導致網站癱瘓?

別擔心,現在有一個Python寫的神器——crawlerdetect,幫助你檢測爬蟲,保障網站的正常運轉。

1.準備

開始之前,你要確保Python和pip已經成功安裝在電腦上噢,如果沒有,請訪問這篇文章:超詳細Python安裝指南 進行安裝。如果你用Python的目的是數據分析,可以直接安裝Anaconda:Python數據分析與挖掘好幫手—Anaconda

Windows環境下打開Cmd(開始—運行—CMD),蘋果系統環境下請打開Terminal(command+空格輸入Terminal),準備開始輸入命令安裝依賴。

當然,我更推薦大家用VSCode編輯器,把本文代碼Copy下來,在編輯器下方的終端運行命令安裝依賴模塊,多舒服的一件事啊:Python 編程的最好搭檔—VSCode 詳細指南。

在終端輸入以下命令安裝我們所需要的依賴模塊:

pip install crawlerdetect

看到 Successfully installed xxx 則說明安裝成功。

2.使用方法

它可以通過user-agent、headers等請求頭識別爬蟲或機器人。

因此,你可以傳遞兩種參數。第一種,使用user-agent檢測機器人:

from crawlerdetect import CrawlerDetect

crawler_detect = CrawlerDetect(user_agent='Mozilla/5.0 (iPhone; CPU iPhone OS 7_1 like Mac OS X) AppleWebKit (KHTML, like Gecko) Mobile (compatible; Yahoo Ad monitoring; https://help.yahoo.com/kb/yahoo-ad-monitoring-SLN24857.html)')

crawler_detect.isCrawler()

# 如果是機器人,這條語句返回True

第二種識別方式會用上全部headers參數,這種方式比單純用user-agent精準,因為它判斷的依據更加全面。

from crawlerdetect import CrawlerDetect

crawler_detect = CrawlerDetect(headers={'DOCUMENT_ROOT': '/home/test/public_html', 'GATEWAY_INTERFACE': 'CGI/1.1', 'HTTP_ACCEPT': '*/*', 'HTTP_ACCEPT_ENCODING': 'gzip, deflate', 'HTTP_CACHE_CONTROL': 'no-cache', 'HTTP_CONNECTION': 'Keep-Alive', 'HTTP_FROM': 'googlebot(at)googlebot.com', 'HTTP_HOST': 'www.test.com', 'HTTP_PRAGMA': 'no-cache', 'HTTP_USER_AGENT': 'Mozilla/5.0 (Macintosh; Intel Mac OS X 10_8_4) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/28.0.1500.71 Safari/537.36', 'PATH': '/bin:/usr/bin', 'QUERY_STRING': 'order=closingDate', 'REDIRECT_STATUS': '200', 'REMOTE_ADDR': '127.0.0.1', 'REMOTE_PORT': '3360', 'REQUEST_METHOD': 'GET', 'REQUEST_URI': '/?test=testing', 'SCRIPT_FILENAME': '/home/test/public_html/index.php', 'SCRIPT_NAME': '/index.php', 'SERVER_ADDR': '127.0.0.1', 'SERVER_ADMIN': 'webmaster@test.com', 'SERVER_NAME': 'www.test.com', 'SERVER_PORT': '80', 'SERVER_PROTOCOL': 'HTTP/1.1', 'SERVER_SIGNATURE': '', 'SERVER_SOFTWARE': 'Apache', 'UNIQUE_ID': 'Vx6MENRxerBUSDEQgFLAAAAAS', 'PHP_SELF': '/index.php', 'REQUEST_TIME_FLOAT': 1461619728.0705, 'REQUEST_TIME': 1461619728})

crawler_detect.isCrawler()

# 如果是機器人,這條語句返回True

你還可以識別相應爬蟲的名字(如果有的話),通過這種方式,你能給一些著名的爬蟲(如baiduspider、googlebot)添加白名單,不進行攔截。

from crawlerdetect import CrawlerDetect

crawler_detect = CrawlerDetect()

crawler_detect.isCrawler('Mozilla/5.0 (compatible; Sosospider/2.0; +http://help.soso.com/webspider.htm)')

# 如果是機器人,這條語句返回True

crawler_detect.getMatches()

# Sosospider

有了這個工具,我們就可以實現實時的爬蟲封禁:

**1. **實時監控網站上的http請求,檢測其對應的headers.

**2. **如果識別到該請求是機器人(爬蟲)發出的,就可將其IP記錄下來。

**3. ** 將IP加入到Nginx或Apache的動態黑名單中,實現實時的爬蟲封禁。

這一套流程我還沒有試驗過,大家有興趣可以試試,理論上可行。

-

代碼

+關注

關注

30文章

4808瀏覽量

68808 -

編輯器

+關注

關注

1文章

806瀏覽量

31228 -

python

+關注

關注

56文章

4801瀏覽量

84857 -

爬蟲

+關注

關注

0文章

82瀏覽量

6949

發布評論請先 登錄

相關推薦

Python數據爬蟲學習內容

請問前三行是什么意思?

請問這三行代碼是固定這樣寫的嗎?

0基礎入門Python爬蟲實戰課

三行搞定獨立按鍵

Python爬蟲簡介與軟件配置

什么是三行按鍵?有什么用

python爬蟲入門教程之python爬蟲視頻教程分布式爬蟲打造搜索引擎

如何實現計算機視覺的目標檢測10行Python代碼幫你實現

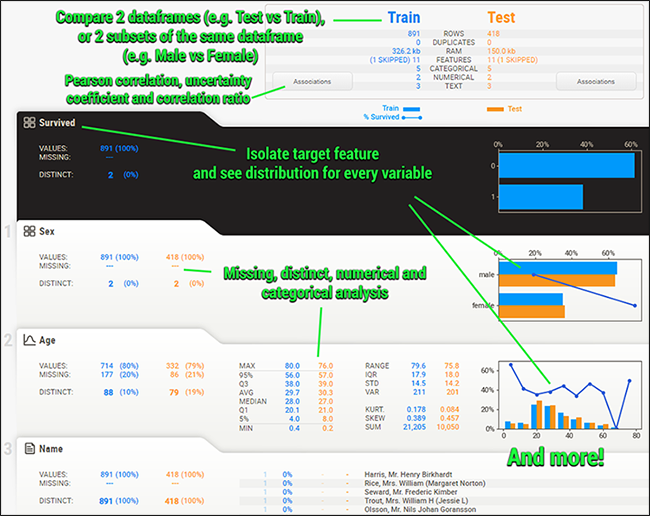

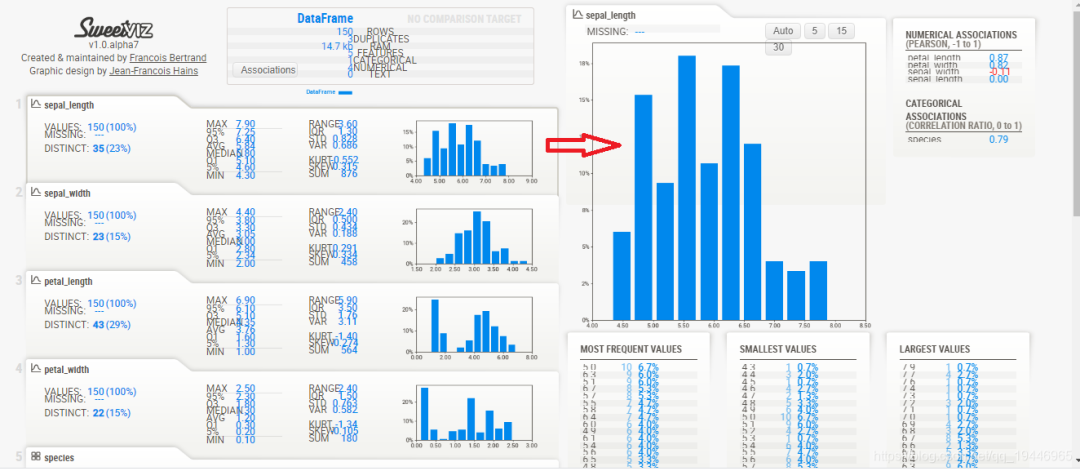

Sweetviz讓你三行代碼實現探索性數據分析

Sweetviz: 讓你三行代碼實現探索性數據分析

crawlerdetect:Python 三行代碼檢測爬蟲

crawlerdetect:Python 三行代碼檢測爬蟲

評論